我们都知道数据方法离不开统计学,统计学也是大数据方法的基础,只有明白其中意义、方法和使用先决条件,在使用数据时,才算有了基本的行动指南。前面我们谈过:企业数据分析的目的有追责归因、监控波动、洞察规律、挖掘商机、指导实践。通过这段时间学习,再回过头来复盘过往经历。尽管现在平台数据可视化做得很不错,我们也能从简单的时间先后,及不同产品对比去发现问题,但往往得出来的结论质疑声很高,甚至很多时候是拍脑袋做决定的,在我从事过那么多公司,高管或老板从流认为数据分析很重要,可惜真正懂统计学的我是一个都没遇到。所以不管是业务人员还是领导层,不擅长甚至不懂使用数据决策,离开了统计学基础,得到的结论就不足以说服人。我大学专业是物流类的,和数据分析基本上八竿子打不到一起,而且也是个文科生,阴差阳错进入商品分析这个职位开始接触数据,当时线上平台才刚刚发展,大部分业务都是线下经销商模式。让我印象最深刻的是每次订货会那些经销商根据个人经验下单,这让我非常疑惑,虽然个人体感很重要,但这决策应该不够科学,果然直到去年过去7、8年了都还在清库存。当然其中缘由非常复杂,肯定不止没有用好数据分析这么简单。所以我果断跳槽去了电商公司,让我能有更多的数据量帮我去理解业务,可惜电商太浮躁焦虑,沉迷刷单沉迷一夜暴富。

说远了,回来!统计学研究的目的,通常是从大量数据寻找规律性,不同因素之间的相关性,以及可能存在的因果关系。不过,后一种关系,即因果关系通常未必能找到。在找到相应的规律之后,我们就可以利用它来建立数学模型,预估未来数据的发展和变化。根据大数定律和中心极限定理,我们知道了数学期望平均数和正态分布,特别是为了衡量现实与理想的误差差距-方差,方差自始至终都贯穿整个统计学,为了避免方差导致结论准确度下降,总需要进行显著性检验。我们可以通过比较性和关联性分析去挖掘规律,前面也详细讲解了。

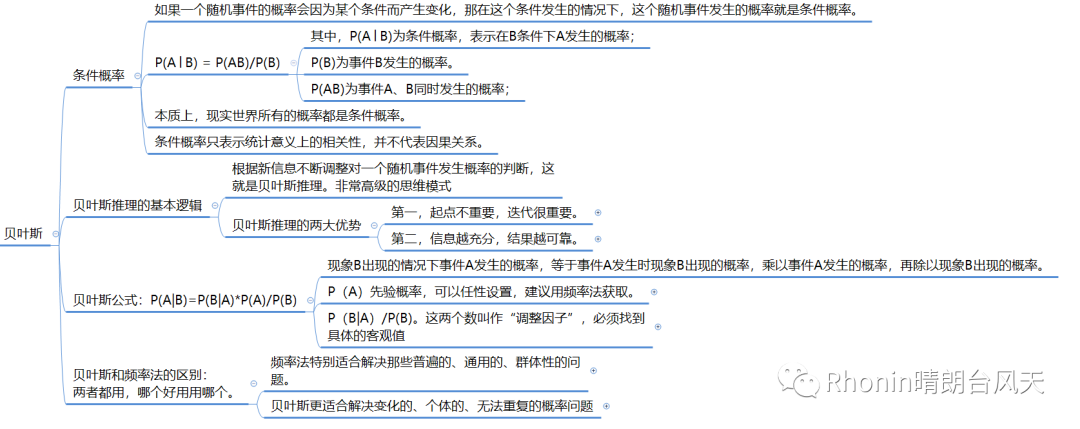

一切概率皆条件概率

世界上很多随机事件的发生是彼此相关的,比如条件概率。一个随机事件发生的条件概率,取决于两个因素,一个是这个条件本身出现的次数,另一个是,这个条件和这个随机事件一同出现的次数。对于几乎所有的随机事件来讲,条件概率由于条件的存在,它通常不等于本身的概率。本质上,现实世界所有的概率都是条件概率。条件概率只表示统计意义上的相关性,并不代表因果关系。

概率问题分为两种:

知道了“原因”,要去推测“现象”。这类概率问题叫作“正向概率”。已知现象求原因,这就是“逆概率”问题。逆概率问题,没法研究因果,只能给因果的研究提供线索。频率法无法通过零散的现象猜测背后的原因,贝叶斯推理可以。

贝叶斯推理与公式

1、根据新信息不断调整对一个随机事件发生概率的判断,这就是贝叶斯推理。生活里,为什么我们总是寻找新信息,争取信息完备?其实就是为了运用尽可能多的信息,提高自己判断的准确率,本质上还是贝叶斯推理。

贝叶斯不是推理一次就完了,它是个反复的过程。每找到一个新信息,就进行一次推理,得到一个新判断。而下一个信息,要么进一步证实我们的判断,要么削弱我们的判断,就要对之前的判断进行调整。这样不断微调、不断微调,慢慢的,结果一定会和真实状况越来越接近。毫不夸张的说,贝叶斯最后一定会无穷逼近于真理。这其实是一种非常高级的思维模式。起点不重要,迭代很重要,就需要保持充分的开放和积累;而信息越充分,结果越可靠,又要求随时调整、不断逼近真相。这样每次精进一点,每次精进一点,这样的人可不就越活越通透,越活越聪明吗?应用在机器学习,像机器翻译、图像识别。

2、贝叶斯公式是推导出来,不是创建出来的。

条件概率:P(A|B)=P(AB)/P(B)→P(AB)=P(A|B)*P(B)。

同理,P(B|A)=P(AB)/P(A)→P(AB)=P(B|A)*P(A)

由以上P(AB)相等,则P(A|B)*P(B)=P(B|A)*P(A)

贝叶斯公式:P(A|B)=P(B|A)*P(A)/P(B)

现象B出现的情况下事件A发生的概率,等于事件A发生时现象B出现的概率,乘以事件A发生的概率,再除以现象B出现的概率。其中,P(A)先验概率(“先验概率”就是在看到新现象、重新计算之前,基于经验甚至主观猜测得到的概率。),可以任性设置,建议用频率法获取。P(B|A)/P(B)。这两个数叫作“调整因子”,一定要注意,P(B|A)和P(B)这两个数一定是客观的,必须找到具体的客观值,而不能拍脑袋随便设定,查询真实数据,如果无法获取就不能用贝叶斯公式。

3、哪个好用用哪个。

频率法,更像是做题,必须有明确的、严格的前提约束,严格界定好所有的条件。它假设信息是全知的,每道题都有一个对所有人而言都正确的答案。所以会通过反复的试验,不断逼近最终那个客观概率。过程不重要,达到最终那个客观的结果才重要。特别适合解决那些普遍的、通用的、群体性的问题。而贝叶斯,是个动态的、反复的过程。每个新信息的加入都要重新进行一遍计算,获得一个新概率。贝叶斯没有什么限制条件,只是在这一次次获得新信息、重新计算的过程中迭代自己的判断。它甚至不认为现实的事儿都有正确答案,因为所谓答案,也是在不断变化的。更适合解决变化的、个体的、无法重复的概率问题

(以上引用来自刘嘉老师精确描述)

到这里,统计与概率基本上学完了,接下来进击数据库SQL,这块我之前大概地过了一遍,算比较简单的,应该不需要花费太多时间,学完SQL应该可以算是个小小的数据分析师了。但是Python还是要花点时间练练,之前学习都是比较浅层的。

朝数据分析师又迈进一大步,我们一起加油呀~