今天来分享一个高效率的数据清洗的方法,毕竟我们平常在工作和生活当中经常会遇到需要去处理杂七杂八的数据集,有一些数据集中有缺失值、有些数据集中有极值、重复值等等。这次用到的数据集样本在文末有获取的办法。

我们首先导入所需要用到的库,并且读取数据

import pandas as pdimport numpy as npdf = pd.read_csv("DirectMarketing.csv")

我们先来大致地看一下数据集中各个特征值的情况,通过info()这个方法

df.info()

我们看到上面的“History”这一列,只有697条数据不是空值,那就意味着还有另外3条数据是空值,与之对应的方式有将含有缺失值的数据删掉,或者将缺失值的部分替换为是中位数或者是平均数,

# 将缺失值给移除掉df.dropna(axis = 0, inplace = True)

def fill_missing_values_num(df, col_name):val = df[col_name].median()df[col_name].fillna(val, inplace = True)return df

def fill_missing_values_cate(df, col_name):val = df[col_name].value_counts().index.tolist()[0]df[col_name].fillna(val, inplace = True)return df

df.drop_duplicates(inplace = True)

最后我们封装成一个函数,对于缺失值的处理小编这里选择用中位数填充的方式来处理

def fill_missing_values_and_drop_duplicates(df, col_name):val = df[col_name].value_counts().index.tolist()[0]df[col_name].fillna(val, inplace = True)return df.drop_duplicates()

经常使用pandas的人可能都有这种体验,它经常会将数据集中的变量类型直接变成object,这里我们可以直接使用“convert_dtypes”来进行批量的转换,它会自动推断数据原来的类型,并实现转换,并且打印出来里面各列的数据类型,封装成一个函数

def convert_dtypes(df):print(df.dtypes)return df.convert_dtypes()

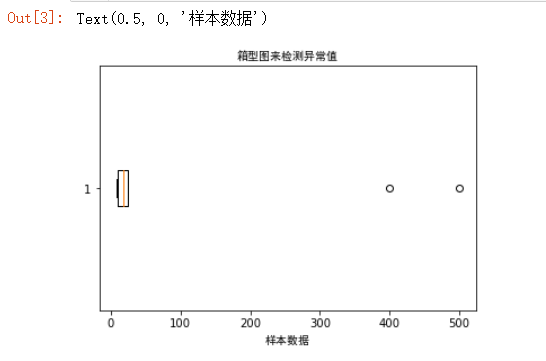

sample = [11, 500, 20, 24, 400, 25, 10, 21, 13, 8, 15, 10]plt.boxplot(sample, vert=False)plt.title("箱型图来检测异常值",fontproperties="SimHei")plt.xlabel('样本数据',fontproperties="SimHei")

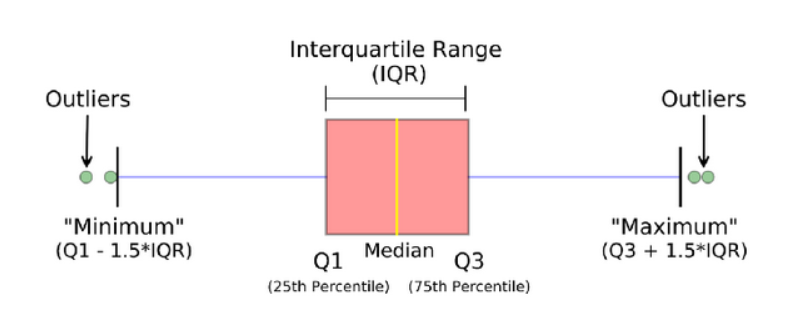

我们可以通过箱型图来明显的看出当中有两个异常值,也就是400和500这两个,箱型图由最大值、上四分位数(Q3)、中位数(Q2)、下四分位数和最小值五个统计量组成,其中Q1和Q3之间的间距称为是四分位间距(interquartile range,IQR),而通常若是样本中的数据大于Q3+1.5IQR和小于Q1-1.5IQR定义为异常值

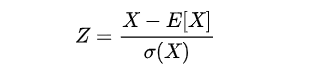

当然了除此之外,还可以通过z-score的方法来检测,Z-score是以标准差为单位去度量某个数据偏离平均数的距离,计算公式为

outliers = []def detect_outliers_zscore(data, threshold):mean = np.mean(data)std = np.std(data)for i in data:z_score = (i-mean)/stdif (np.abs(z_score) > threshold):outliers.append(i)return outliers# Driver code

而对待异常值的方式,首先最直接的就是将异常值给去掉,我们检测到异常值所在的行数,然后删掉该行,当然当数据集当中的异常值数量很多的时候,移除掉必然会影响数据集的完整性,从而影响建模最后的效果

def remove_outliers1(df, col_name):low = np.quantile(df[col_name], 0.05)high = np.quantile(df[col_name], 0.95)return df[df[col_name].between(low, high, inclusive=True)]

def remove_outliers2(df, col_name):low_num = np.quantile(df[col_name], 0.05)high_num = np.quantile(df[col_name], 0.95)df.loc[df[col_name] > high_num, col_name] = high_numdf.loc[df[col_name] < low_num , col_name] = low_numreturn df

def fill_missing_values_and_drop_duplicates(df, col_name):val = df[col_name].value_counts().index.tolist()[0]df[col_name].fillna(val, inplace = True)return df.drop_duplicates()def remove_outliers2(df, col_name):low_num = np.quantile(df[col_name], 0.05)high_num = np.quantile(df[col_name], 0.95)df.loc[df[col_name] > float(high_num), col_name] = high_numreturn dfdef convert_dtypes(df):print(df.dtypes)return df.convert_dtypes()df_cleaned = (df.pipe(fill_missing_values_and_drop_duplicates, 'History').pipe(remove_outliers2, 'Salary').pipe(convert_dtypes))

文章转载自关于数据分析与可视化,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。