1 实验环境介绍

内容概述

环境准备

Kerberos环境和非Kerberos集群

测试环境

Kerberos集群CDH5.11.2,OS为Redhat7.2

非Kerberos集群CDH5.13,OS为CentOS6.5

前置条件

CDH集群运行正常

本地开发环境与集群网络互通且端口放通

2 示例

这里使用的代码是没有加载CDH集群的xml配置的,因为使用hadoop命令提交时会加载集群的配置信息(如hdfs-site.xml/yarn-site.xlm/core-sitem.xml等)。

package com.cloudera.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

/**

* package: com.cloudera.mr

* describe: 打包jar到集群使用hadoop命令提交作业示例

* creat_user: Fayson

* email: htechinfo@163.com

* creat_date: 2017/12/6

* creat_time: 下午11:30

* 公众号:Hadoop实操

*/

public class WordCount {

private static Logger logger = LoggerFactory.getLogger(WordCount.class);

public static void main(String[] args) {

logger.info(args[0] + "-----" + args[1]);

try {

Configuration conf = new Configuration();

Job wcjob = Job.getInstance(conf);

wcjob.setJobName("MyWordCount");

wcjob.setJarByClass(WordCount.class);

wcjob.setJarByClass(InitMapReduceJob.class);

wcjob.setMapperClass(WordCountMapper.class);

wcjob.setReducerClass(WordCountReducer.class);

wcjob.setMapOutputKeyClass(Text.class);

wcjob.setMapOutputValueClass(LongWritable.class);

wcjob.setOutputKeyClass(Text.class);

wcjob.setOutputValueClass(LongWritable.class);

FileInputFormat.setInputPaths(wcjob, args[0]);

FileOutputFormat.setOutputPath(wcjob, new Path(args[1]));

//调用job对象的waitForCompletion()方法,提交作业。

boolean res = wcjob.waitForCompletion(true);

System.exit(res ? 0 : 1);

} catch (Exception e) {

e.printStackTrace();

}

}

}

3 编译打包MapReduce作业

使用Maven命令进行编译打包,该命令运行需要在工程所在目录下运行

cd Volumes/Transcend/work/cdhproject

mvn clean package

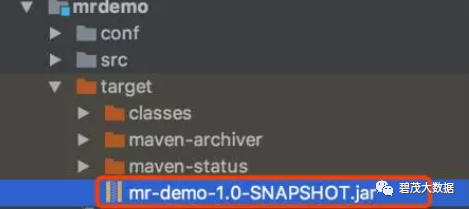

编译成功后,在工程的target目录下可以看到mr-demo-1.0-SNAPSHOT.jar包

将mr-demo-1.0-SNAPSHOT.jar包上传到CDH集群的任意节点

注意:这里是将jar包上传至CDH集群的任意节点且hadoop命令可以正常运行。

4 非Kerberos集群提交作业

在命令行执行如下命令提交MR作业

hadoop jar mr-demo-1.0-SNAPSHOT.jar com.cloudera.mr.WordCount fayson/test_table wordcount/

Yarn界面查看,作业收费执行成功

查看HDFS输出目录

5 Kerberos集群提交作业

在Kerberos集群init Kerberos账号

[ec2-user@ip-172-31-22-86 ~]$ kdestroy

[ec2-user@ip-172-31-22-86 ~]$ kinit -kt fayson.keytab fayson

[ec2-user@ip-172-31-22-86 ~]$ klist

Ticket cache: FILE:/tmp/krb5cc_1000

Default principal: fayson@CLOUDERA.COM

Valid starting Expires Service principal

12/06/2017 11:02:53 12/07/2017 11:02:53 krbtgt/CLOUDERA.COM@CLOUDERA.COM

renew until 12/13/2017 11:02:53

[ec2-user@ip-172-31-22-86 ~]$

在命令行使用hadoop提交作业

[ec2-user@ip-172-31-22-86 ~]$ hadoop jar mr-demo-1.0-SNAPSHOT.jar com.cloudera.mr.WordCount fayson /wordcount/out

Yarn界面查看作业是否执行成功

查看HDFS目录输出的结果

6 总结

在本地环境开发MapReduce作业的时候,需要加载集群的xml配置,将打包好的MR jar包提交到集群使用hadoop命令运行时,代码里面的Configuration在初始化的时候不需要加载xml的配置即可。

关注公众号:领取精彩视频课程&海量免费语音课程

文章转载自碧茂大数据,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。