Table of Contents

第 4 章 shell 学习第四天----华丽的 printf 输出

第 5 章 shell 学习第五天----基本的 I/O 重定向

第 7 章 shell 学习第七天----基础正则表达式 (BRE)

第 8 章 shell 学习第八天----扩展正则表达式 (ERE)

第 10 章 shell 学习第十天----sed 查找与替换

第 11 章 shell 学习第十一天----sed 正则的精确控制

第 13 章 shell 学习第十三天----sed 案例分析

第 14 章 shell 学习第十五天----使用 cut 选定字段

第 15 章 shell 学习第十五天----join 连接字段

第 16 章 shell 学习第十六天----join 练习

第 20 章 shell 学习第二十天----sort 的其他内容以及 uniq 命令

第 21 章 shell 学习第二十一天----重新格式化段落

第 22 章 shell 学习第二十二天----计算行数, 字数以及字符数

第 24 章 shell 学习第二十四天----提取开头或结尾数行

第 25 章 shell 学习第二十五天----神器的管道符

第 27 章 shell 学习第二十七天----退出状态和 if 语句

第 28 章 shell 学习第二十八天----case 语句

第 30 章 shell 学习第三十天----break,continue,shift,getopts

第 33 章 shell 学习第三十二天----read 读取一行

第 35 章 shell 学习三十四天----printf 详解

第 36 章 shell 学习三十五天----波浪号展开与通配符

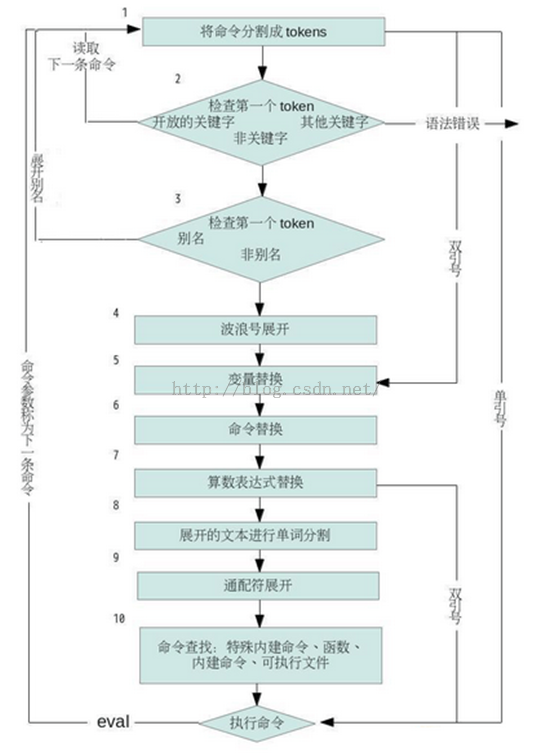

第 39 章 shell 学习三十八天----执行顺序和 eval

第 42 章 shell 学习四十天----awk 的惊人表现

第 43 章 shell 学习四十一天----列出文件 ls 和 od 命令

第 44 章 shell 学习四十二天----使用 touch 更新文件时间

第 45 章 shell 学习四十三天----临时性文件的建立与使用

第 48 章 shell 学习四十六天----文件系统的空间信息 df 和 du 命令

第 49 章 shell 学习四十七天----文件比较 cmp,diff,patch

第 50 章 shell 学习四十八天----文件校验和匹配

第 54 章 shell 学习五十一天----top 命令查看进程列表

第 55 章 shell 学习五十二天----删除进程 kill 命令

第 56 章 shell 学习五十三天----捕获信号 trap

第 57 章 shell 学习五十四天----进程系统调用的追踪 strace

第 60 章 shell 学习五十七天 ----linux 任务管理,针对上一讲的总结和扩展

第 61 章 shell 学习五十八天----/proc 文件系统

前言

Shell 脚本常用于系统管理工作,或者用于结合现有的程序以完成特定的工作。一旦你写出了一个完成工作的办法,就可以把用到的命令串在一起,放进一个单独的程序或者脚本里,以后只要执行改程序就能完成工作。本书是作者自己的学习经历总结,通过一个完整的学习过程介绍,给读者展示 Shell 学习是如何从入门到精通的。

适用人群

重点人群 Linux 系统工程师,但也是每个程序员都需要掌握的技能之一。

学习前提

学习本书前,你需要了解一些基础的 shell 命令,如果你使用过 Linux 操作系统,那么学起来会容易些。

http://blog.csdn.net/shanyongxu/article/category/5568209

1

shell 学习第一天

在开始学习 shell 以前我觉得应该具备的基础有以下几点:

- 如何登陆 linux 系统

- 如何在命令行上执行程序

- 如何做一个简单的命令管道,与使用简单的输入 / 出重定向,例如 < 和 >

- 如何以 & 将程序放在后台执行

- 使用 chmod,将脚本设置为可执行权限

当我们需要计算机帮我们做点什么的是,最好是选对工具。就像你不会用文本编辑器来做支票簿的核对, 不会用计算器来写策划方案一样,所以说程序语言用于不同的需求,本身没有好坏之分。

shell 脚本常用于系统管理工作,或者用于结合现有的程序以完成特定的工作。一旦你写出了一个完成工作的办法,就可以吧用到的命令串在一起, 放进一个单独的程序或者脚本里,以后只要执行改程序就能完成工作。如果写的程序很有用,那么别人可以一用该程序当做一个黑盒来使用,他是一个可以完成工作的成虚,但是我们不必知道他是如何完成的 (面向对象的封装特性)。

首先来看看脚本语言和编译语言的差异

大型的程序一般都是由编译语言写成,例如:C++,Java,C 等。这些程序只要从源代码 (socure code) 转换为目标代码 (object code),便能直接通过计算机来执行。

变异性语言的有点事: 效率高,因为他们多半是运作与底层,所处理的是子节,整数,浮点数或者其他的及其层级的对象。例如: 在 C++ 里,很难首先目录的整体移动或者复制。

而脚本编程语言通常是解释型的。这类程序的执行,是由解释器度日程序代码,并将其转换成内部的形式,再执行。注意,解释器本身是一般的编译型程序。

通俗一点: 编译语言需要编译器,脚本语言需要解释器,例如编写 C++ 程序需要使用 VS,而编写 HTML 代码有网页就行,因为网页中有自带的解释器。

使用脚本编程语言的好处是,脚本语言多半运行在比编译语言还高得层级,能够情已处理文件与目录之类的对象。缺点: 一般情况下,效率比较低。不过权衡之下,脚本的执行速度已经很快,快到足以让人感觉不到性能不高了。常用的脚本编程语言有:shelll,Ruby,javascript等。 shell 似乎是不同版本的 linux 系统之间的通用功能。shell 脚本只要用心写,就能应用到很多系统上。

- 简单性: shell 是高级语言

- 可移植性: 通过 POSIX (可移植操作系统接口,是 IEEE 为要在各种 UNIX 操作系统上运行的软件,而定义 API 的一系列互相关联的标准的总称) 所定义的功能,可以在不同的系统上执行,无需需改。

- 开发容易: 短时间即可完成一个功能强大又好用的脚本 (字啊以后的学习中就能看到)

说了那么多,接下来就是一个简单的脚本。在 shell 交互界面输入 who,得到以下信息 (这是我的电脑):

root pts/0 2015-06-07 18:37 (192.168.199.114)

这行信息代表系统上有多少人登陆。类似于 QQ 在线人数

每个字段的含义分别是登入帐号 (root),使用的终端机 (pts/0),登入时间以及从何处登入。在大型的,多用户的系统上 (服务器的运维上),所列出的列表可能很长 (一个页面不够显示),你需要的信息或许可能滚出画面,这是让用户查询的困难。而这正是进行自动化的好时机。使用 wc(字数计算) 程序,特可以计算出行数 (line),字符数 (character),字数 (word)。使用 wc -l: 只列出行数。

who | wc -l

计算用户个数 -----> 我的电脑是一个 1

|(管道) 符号可以在两个程序之间建立管道 (pipeline):who 的输出,成了 wc 的输入。

将此管道转成一个独立的命令。方法是把这条命令输入一个一般的文件中,然后使用 chmod 为该文件设置执行的权限。

#cat > nusers cat

是输出文件内容的命令,>nusers

表示把内容送到文件 nusers 里而不是默认的屏幕。但是这里 cat 后面没有参数,意味着 cat 将从键盘读取数据输入到 nusers 中,以 CTRL+D 结束。

- ^D Ctrl+D

表示 end-of-file - #chmod +x nusers

让文件拥有执行的权限 - #./nusers

输出我们需要的结果。

易尚展示了一个小型 Shell 脚本的典型开发周期,首先,直接在命令行上测试。然后,一旦找到能够完成工作的适当语法,再将他们放进一个单独的脚本里,并未该脚本设置执行的权限。之后就能直接使用该脚本了。

2

shell 学习第二天

脚本位于第一行的 #!

当 shell 执行一个程序时,会要求 linux 内核启动一个新的进程,以便在该进程里执行所指定的程序。 内核知道如何为编译性程序做这件事。 但是我们的nusers Shell 脚本并非编译性程序; 当 shell 要求内核执行它的时候,内核无法处理,并且回应“not executable format file”,接着会启动一个新的 /bin/sh

(标准 shell) 副本来执行该程序。

当系统只有一个 shell 是,“退回到 /bin/sh” 的机制很方便。 但是现在的 linux 都拥有好几个 shell,因此需要通过一宗方式,告知 linux 内核用哪个 shell 来执行所指定的 shell 及哦啊本。

linux 有多个 shell 带来的好处是有助于执行机制通用化,让用户得以直接引用任何程序语言解释器,而非只是一个命令 shell。

例如:文件开头存在 \#!/bin/csh

则说明执行的是 csh 脚本,相同的,例如我们可以这样引用独立的 awk 程序:

\#! /bin/awk -f

此处是 awk 程序

shell 脚本的第一行通常是 #!/bin/sh

。如果不这样是不符合标准的,自觉修改这个路径,将其改为符合 POSIX 标准的 shell。

以下是几个初级的陷阱:

- 对 #!

这一行的长度尽量不要超过 64 个字符 - 脚本的可移植性取决于是否有完整的路径名称

- 不要在选项之后放置任何空白,因为空白也会跟着选项一起传递给被引用的程序

- 需要知道解释器的完成路径的名称。 这样可以规避可移植性的问题, 厂商不同,同样的东西可能放在不同的地方

- 一些较久的系统,内核不具备 #!

的能力,有些 shell 会自行处理,这些 shell 对于 #!

与紧随其后的解释器名称之间是否可以有空白,可能有不同的解释

查看当前发行版本可以使用的 shell;cat/etc/shells

查看系统默认的 shell;echo $SHELL;

一般情况下是输出 /bin/bash

。如果想切换 shell 的版本,只需要直接输入 shell 的版本。 例如想使用 csh,直接输入 csh 即可,使用 exit 退出当前 shell 回到原 shell。

3

sheel 学习第三天

shell 的基本元素

shell 最基本的工作就是执行命令。以互动的方式使用 shell 很容易了解这一点:没敲入一个命令,shell 就会执行。像这样:

cd /tmp:ll -d sh

drwxr-xr-x 2 root root 4096 6 月 7 18:56 sh

以上是在我电脑上运行的程序。

以上的例子很简单,展示了 linux 命令寒的原理。

- 首先,格式简单,尽量以空格隔开命令中的各个组成部分。

- 其次,命令名称是命令行的第一个项目。通常后面有选项,任何额外的参数都放在选项之后。两个命令可以使用分号分割。

第三选项的开头是一个破折号(或减号)。选项既然叫做选项,就代表选项可有可无。如需要多个选项,只需要输入一个剑豪后面加选项即可,例如,ls -l -t /tmp/sh

可以写成 ls -lt /tmp/sh

如果多个命令之间使用的是 & 符号,而不是分号,则 shell 将在后台执行其前面的命令,这意味着 shell 不用等到该命令的完成,就可以继续执行下一个命令。

- 内建命令:就是 linux 的命令,例如 cd,ls,mkdir 等,这些命令是由于其必要性才内建的,内外一种命令的村子啊是为了效率,其中最典型的就是 test,

- shell 函数: 功能健全的一系列程序代码,用 shell 语言写成,可以像使用命令一样使用,就是在 C++ 中调用函数。

- a.外部命令:是由 shell 的副本(新的进程)所执行的命令,还是命令。

- 似乎任何一种编程语言都有变量,shell 也不例外,每一个变量都有一个值。值是配给变量的内容或者信息。在 shell 中,变量值可以是(通常是)空值,也就是不含有任何字符。这是合理的,也是常见的,好用的特性。空值就是 null 。

- 在 shell 中变量名的长度无限制,所能保存的字符数同样没有限制。

- 变量的赋值方式: 变量名 = 值,中间不能有任何的空格,如果想去除 shell 变量的值时,需要在变量名钱加上 $ 字符。当所赋予的值包含空格的时候,需要将值用单引号或者双引号包起来,用单引号包起来的后果是单引号里面的所有特殊符号都不具备特殊含义,用双引号包起来代表特殊符号有特殊含义。

例如:

name=syx;

echo ‘$name’ 输出 $name

echo “$name” 输出 syx

如果想将 name1=syx

,name2=zsf

合并,成 syxzsf

则 name=${name1}${name2}

,echo $name name=syxzsf

,貌似还有其他的合并方法,个人觉得这一种最好。至于变量的四种类型什么的,暂时不搞。

echo 的作用就是产生输出,可以提示用户,或者用来产生数据提供用户,或者产生数据进一步处理。

早起的 echo 只能将参数打印到 shell 交互界面上,参数之间以一个空格隔开,并以换行符号结尾。但是,这么强大的语言,怎么可能不进一步的发展?后来又衍生出了 -n 选项,省略结尾的换行符号。

etho [string......]

用途是产生 shell 脚本的输出,没有什么主要选项。行为模式是将参数打印到标准输出,参数之间用空格隔开,并以换行符结尾。转义序列用来表示特殊字符,以及控制其行为模式。

常用的转移序列:

\a:

\b:

\c:

\f:

\n: 换行

\r: 回车

\t: 水平制表符

\v: 垂直制表符

\\: 反斜杠字符

\0ddd:

在实际编写 shell 脚本的时候,\a

序列通常用来引起用户的注意,\0ddd

序列最有用的地方就是通过送出终端转移序列进行 (非常) 原始的光标操作,但是不建议这么做。很少使用 \0ddd

序列。

4

shell 学习第四天----华丽的 printf 输出

printf 命令模仿 C 程序库里的 printf() 库程序。几乎复制了该函数的所有功能,如同 echo 命令,printf 命令可以输出简单的字符串:

printf “hello world\n”

通过观察 echo 和 printf 的输出的不同,可以发现 echo 会提供自动换行,printf 不会提供自动换行,所以那些转移序列在 printf 发挥的很好。

printf

命令的完整语法分为两部分:

printf format-string [arguments....]

分析:printf

是命令,不解释。format-string

为格式控制字符串,arguments

为参数列表。

printf 命令不用加括号。 format-string 可以没有引号,但是最好加上,单双引号均可。参数多于格式控制符(%)时,format-string 可以重用,可以将所有参数都转换 arguments:使用空格分割,不用逗号。 printf “%d,%s\n” 1 abc

这里输出的是 1, abc。有没有引号都可以。

如果没有 arguments %s

用 NULL

表示,%d

用 0 表示

例如 :printf “%s , %d\n”

输出结果为 0

format-string 的可重用性:printf “%s” abc def==>abcdef

如果以 %d 来显示字符串,会有警告,提示无效的数字,此时的默认值为 0。 例如:printf "%d\n" abc==>bash: printf: abc: invalid number 0;

既然 shell 的 printf

和 C 的 printf

差不多,那么他们也都支持 %。例如:printf “%s\n” hello

输出 hello 换行。因为各种版本的 liunx 的各种版本对 echo 的移植性不好,所以引入了 printf,printf 可以说是 echo 的加强版,是由 POSIX 标准定义。

5

shell 学习第五天----基本的 I/O 重定向

基本的 I/O 重定向

在了解重定向之前,需要先了解一下标准的输入输出,总的来说,所有的数据都有来源,也都应该都重点,默认的标准输入输出就是终端。

例如:

我们只是输入 cat 命令,并不指定任何参数,接着我们输入 hello world,就是打印 helloworld 到终端。

所谓的 I/O 重定向就是通过与终端交互,或是在 shell 脚本里设置,重新安排从哪里输入或者输出到哪里。

使用 <

改变标准输入

program<file

可将 program 的标准输入修改为 file

tr

使用 >

改变标准输出

program>file

可将 program 的标准输出修改为 file

>

重定向符号在墓地文件不存在的时候会新建一个,如果目的文件存在,目的文件的内容会被覆盖,原本的数据会丢失。

以 >>

附加到文件

program>>file

可以将 program 的标准输出追加到 file 的结尾处。

如同 >

,open or create 文件,但是 >>

会追加到文件的结尾而不是覆盖原文件内容。

以 | 符号建立管道

program1 | program2 可将 program 的标准输出修改为 program2 的标准输入。这样做的好处是执行速度较快,不会产生临时文件。一般情况下,越复杂越强大的管道往往是高效的。

例如:tr -d ‘\r’ dos-file.txt | sort >Linux-file.txt

这条管道会先删除输入文件内的回车符号,在完成数据的排序之后,将结果输出到目的文件。

r 是 translate 的简写,通过这个单词,你大概也能猜到它是干什么的了吧!没错,它可以用一个字符串来替换另一个字符串,或者可以完全除去一些字符。您也可以用它来除去重复字符。tr 用来从标准输入中通过替换或删除操作进行字符转换。tr 主要用于删除文件中控制字符或进行字符转换。

tr [options] cource-char-file replace-char-list

例如:

- 去除 oops.txt 里面的重复的小写字符 tr -s "[a-z]"<oops.txt>result.txt

- 删除空行 tr -s "[\012]" < plan.txt 或 tr -s ["\n"] < plan.txt

- 有时需要删除文件中的 ^M

,并代之以换行 tr -s "[\015]" "[\n]" < file 或 tr -s "[\r]" "[\n]" < file - 大写到小写 cat a.txt |tr "[a-z]" "[A-Z]" >b.txt

- -c: 取 source-char-list

的反义,tr 要转换的字符编程位列在 source-char-list

中的字符,通常与选项 -d.-s 配合使用。 - -d: 删除标准输入里的字符,不是转换他们

- -s: 产出重复的字符,如果标准输入里出现了重复多次的 source-char-list

里所列的字符,将其浓缩成一个。

如同过滤器一般,自标准输入读取字符,再将结果写到标准输出,任何输入字符只要出现在 source-char-list

中,就会置换成 replace-char-list

里相应的字符。

在使用 linux 的工具程序是,不妨将数据想想成谁管理的谁,未经处理的水,流向净水厂,经过各种过滤器的处理,最后变成适合人类饮用的水。可以把 < 和 > 想象成数据的漏斗---- 数据会从大的一头进入,从小的一头出来。

在构造管道的时候,应该试着让每个阶段的数据量变少,也就是说,吧会让数据变少的命令放在前边,为后面的命令提供搞笑的执行效率。例如,shiyongsort 排序之前,先用 grep 找出相关的行,这样可以让 sort 少做些事。

6

shell 学习第六天----小结

shell 中的两个特殊文件 “/dev/null” 和 “/dev/tty”

- /dev/null

当被用作重定向输出时,程序的输出被直接丢弃。该文件用在哪些不关心程序输出的地方。 当被用作重定向输入时,输入则是文件结束。 - /dev/tty

当被用作重定向时,表示重定向到终端。

shell 会沿着 $PATH

来寻找命令。$PATH

是一个以冒号分割的目录列表,你可以在列表所指定的目录下找到所要执行的命令。命令可能是 shell 脚本,也可能是编译后的可执行文件,从用户角度来看,二者并无不同。默认路径至少包含 /bin

和 /usr/bin

,或许还包含其他的。名称为 bin 的目录用来保存可执行文件。

如果要编写自己的脚本,最好准备一个自己的 bin 目录来存放他们,并且让 shell 能够自动找到他们。

$cd

$mkdir bin

$mv nusers bin

$PATH+$PATH:$HOME/bin // 将个人的 bin 目录附加到 PATH(暂时生效,系统重启后失效)

nusers

要想永久生效,在 /etc/profile

文件中把你的 bin 目录加入到 $PATH

,而每次登陆时 Shell 都将读取.profile 文件。

PATH=$PATH:$HOME/bin

$PATH 里的空项目表示当前项目。空项目位于路径中间时,可以用两个连续的冒号来表示,如果将冒号直接置于最前端或尾端,分别表示查找的时候最先查找或最后查找当前目录。

$PATH=:/bin:/usr/bin 先找当前目录

$PATH=/bin::/usr/bin 当前目录居中

$PATH=/bin:/usr/bin: 最后找当前目录

不应该在查找路径中放进当前项目。

访问 shell 脚本的参数

定义参数关键字 $: 例如 echo frist argumentsis $1

,大于等于 10 的参数需要用{}包起来,echo tenth argumentsis ${10}

例如我们想查找名字为 syx 用户是否登陆

who | grep syx

syx pts/1 2015-06-09 11:00 (192.168.199.114)

知道了如何寻找特定的用户后,我们可以经命令放在脚本里,这段脚本的第一个参数就是我们要找的用户名称

vi findname 建立新文件

#!/bin/sh

#查看指定用户是否登录

who | grep $1

./findname syx

syx pts/1 2015-06-09 11:00 (192.168.199.114)

但是这是在理想情况下,如果用户不按套路出牌,即不指定参数,则会报错。

编译性语言和脚本语言本身并无优劣之分,只有适合不适合;当对性能要求不高,希望尽快开发出程序并以较高的方式工作是,脚本语言完全可以胜任。所有的 shell 脚本都应该以#!为第一行,这一机制可让你的脚本更有灵活性,你可以选择使用 shell 或其他的语言来编写脚本。

shell 是一个完整的程序设计语言,我们已经说明过基本的命令,选项,参数与变量,以及 echo

与 printf

的基本输出,也稍微说了一下基本的 I/O 重定向符:<,>,>> 以及 |。shell 会在 $PATH 变量所列举的各个目录中寻找命令。$PATH

常会包含个人的 bin 目录 (永爱存储用户个人的程序与脚本),可以在 /etc/profile

文件中将目录列入到 PATH

里。

7

shell 学习第七天----基础正则表达式 (BRE)

查找文本

用到的关键字 grep,最简单的用法就是使用固定字符串。

比如使用 who 命令查找当前多少人登陆系统

- who |grep syx,就可以查看名字叫 syx 的用户登录于何处。

- grep 的语法:

- grep [options pattern-spec [files...]

用途: 显示匹配一个或者多个模式的文本行。时常为作为管道的第一步,以便对匹配的数据进一步处理。

- -i: 模式匹配时忽略大小写

- -V: 显示不匹配的行

- -l: 列出匹配模式的文件名称,而不是打印匹配的行

- -n: 列出检索目标所在的行号

- -c: 统计匹配的行总数,不显示航信息

读取命令行上致命的每个文件,发现匹配查找迷失的行时,将它显示出来,当指名多个文件时,grep 会在每一行前面加上文件名与一个冒号。

- grep: 最常用,可以检索目标 (一个活多个单词或正则表达式)。

- fgrep: 不能使用正则表达式,可以检索多个目标,等同于 grep -f

- egrep: 支持丰富的正则表达式,而且支持多目标检索,等同于 grep -e。

一般情况下没有使用 fgrep 的,我们也不建议使用。

说起文本检索就不得不提到正则表达式,正则表达式十一中表示方法,可以查找匹配特定准则的文本。例如,查找以”a” 字母开头的文本。茨表示法可以写一个表达式,选定或匹配多个数据字符串。

从根本上来看,正则表达式是由两个基本组成部分所建立:一般字符与特殊字符。一般字符指的是任何没有特殊意义的字符。在某些情况下,特殊特殊字符也可以视为一般字符。特殊字符称为元字符(metacharacter)。

- BRE: 基本正则表达式(Basic Regular Expression)

- ERE: 扩展的正则表达式(Extended Regular Expression)

先来看一些简单的匹配返利

- tolstoy: 匹配一行上任意位置的 7 个字母:tolstoy

- ^tolstoy: 7 个字母 tolstoy,出现在一行的开头

- tolstoy$: 出现在一行的结尾

- ^tolstoy$: 正好包含这 7 个字母的一行,没有其他的任何字符。

- [tT]olstoy: 在一行的任意位居中,含有 Tolstoy 或者 tolstoy

- tol.toy: 在一行的任意位居中,含有 tol 这三个字母,加上一个特殊字符,在接着 toy 这三个字母

- tol.*toy: 在一行的任意位居中,含有 tol 这三个字母,加上任意的 0 或者多个字符,再继续 toy 这三个字母 (例如:toltoy,tolstoy,tolWHOtoy 都是满足要求的)。

shell 中的通配符: *: 代表 0 个或者多个任意字符 ?: 代表一定有一个的任意字符 []: 代表一定有一个在括号内的字符 (非任意字符)。例如 [abcd] 代表一定有一个字符,可能是 abcd 这四个选项的任意一个。 [-]: 若邮件韩在括号内时,代表在编码顺序内的所有自负。例如:[0-9] 代表 0 到 9 之间的所有数字,因为数字的语系编码是连续的。 [^]: 若括号内的第一个字符为指数字符 (^),那表示反向选择,例如:[^abc] 代表一定有一个字符,只要是非 abc 的其他字符就可以。

- #: 注释字符

- : 将特殊字符或者通配符还原成一般字符

- |: 管道符,分割两个管线命令的界定

- ;: 连续命令下达分隔符

- ~: 用户的家目录

- $: 放在变量前面,正确使用变量

- &: 工作控制,将命令编程背景下工作

- !: 非 (!) 的意思,逻辑运算符

- >,>>: 输出重定向,分别是覆盖和追加

- <,<<: 输入重定向

- ‘’: 单引号,不具有变量置换的功能

- “”: 双引号,具有变量置换的功能

- (): 在中间的为子 shell 的起始与结束

- {]: 在中间为命令块的组合

- ^: 匹配行首位置

- $: 匹配行尾位置

- .: 匹配任意祖父

- *: 对 * 之前的匹配整体或字符匹配任意次 (包括 0 次)

- \?: 对 \? 之前的匹配整体或字符匹配 0 次或 1 次

- {n}: 对 \ { 之前的匹配整体或字符匹配 n 次

- {m,}: 对 \ { 之前的匹配整体或字符匹配至少 m 次

- {m,n}: 对 \ { 之前的匹配整体或字符匹配 m 到 n 次

- [abcdef]: 对单字符而言匹配 [] 中的字符

- [a-z]; 对单字符而言,匹配任意一个小写字母

- [^a-z]: 不匹配括号中的内容

匹配单个字符

- 匹配一般字符: 一般字符是指无特殊含义的字符,包括所有文本和数字字符,绝大多数的空白字符以及标点符号字符,因此,正则 a,匹配 a。

- 如果相匹配 *,因为 * 是特殊字符,所以需要用 \ 转义,正则 *,匹配 *。

- (点号) 字符意即” 任意字符”,例如 a.c 匹配于 abc,aac。

- 使用方括号表达式。例如 x[abcdefg]z,可以匹配 xaz,xbz,等,方括号里如果存在 (^),表示取反的意思,就是说不匹配列表里的任意字符。

[0123456789] 表示所数字,但是这样写太麻烦,我们可以用 [0-9] 来表示,[abcdefg] 同样可以用 [a-g]

最简单的办法就是把它们一一列出来: 正则 abc 匹配于 abc。虽然 (.)meta 字符与方括号表达式都提供了依次匹配一个字符的很好方式,单正则真正强大而有力地功能是修饰符 meta 字符的使用上。最常用的修饰符是 (),表示匹配 0 个或多个前面的单个字符。因此 abc 表示” 匹配一个 a,0 个或多个 b 字符以及 a 空 c”。这个正则匹配的有 ac,abc,abbcabbbbc。匹配 0 或多个,不表示匹配其他的某一个。例如正则 ab*c,文本 aQc 是不匹配的。但是 ac 是匹配的。

- (*) 修饰符虽然好用,但是他没有限制,如要只要指定次数,使用一个复杂的方括号表达式虽然也能指定次数,但是太过麻烦。我们就引入了区间表达式。所谓的区间表达式有三种变化

- {n} 前置正则表达式所得结果重现 n 次

- {n,} 前置正则表达式所得结果至少出现 n 次

- {n,m} 出现 n 到 m 次

例如我们想要表达” 重现 5 个 a” =>a{5},” 重现 10 到 42 个 q”=>q{10,42};

两个 meta 字符是脱节符号 (^),与货币字符 (&),他们叫做锚点,因为其用途在限制正则表达式匹配时,针对要被匹配字符的开始或者结尾处进行匹配,假定有一串字符串:abcABCdefDEF

正则表达式锚点的范例

模式 | 是否匹配 | 理由 |

ABC | 是 | 居中的 4,5,6 字符匹配 |

^ABC | 否 | 起始处不是 ABC |

def$ | 是 | 结尾处不是 def |

[[:upper:]]{3} | 是 | 居中的大写 ABC 匹配 |

[[:upper:]]{3}$ | 是 | 结尾的大写 DEF 匹配 |

^[[:alpha:]]{3} | 是 | 起始处的 abc 匹配 |

^ 和 $ 当然能同时使用,这种情况将括起来的正则表达式匹配整个字符串 (或行)。有时 ^$ 这样简易的正则很好用,可以用来匹配空的字符串或行列。例如加上 grep -v 选项用来显示所有不匹配模式的行们使用上面的做法,便能过滤掉文件里的空号。 ^$ 尽在起始与结尾具有特殊用处。例如 ab^cd 里的 ^ 表示的就是自身 (^)。

- BRE 运算符哟普先机,由高到低

- [..] [==] [::] 用于字符拍的方括号符号

- \metacharacter 转移的 meta 字符

- [] 方括号表达式

- {} 子表达式

- {} 前置单个字符重现的正则表达式

- 无符号 连续

- ^$ 锚点

8

shell 学习第八天----扩展正则表达式 (ERE)

扩展正则表达式 (ERE)

拥有笔记本正则表达式更多的功能。BRE 与 ERE 在大多数的 meta 字符与功能应用上几乎是完全一致,单 ERE 理由写 meta 字符看起来与 BRE 类似,却具有完全不同的类型。

扩展正则表达式与基础正则表达式的唯一区别在于:? + () {} 这几个字符。基础正则表达式中,如果你想? + () {} 表示特殊含义,你需要将他们转义。而扩展正则表达式中,如果你想? + () {} 不表示特殊含义,你需要将他们转义。转义符号,都是一样的,\ 符号。

所谓特殊含义,就是正则表达式中的含义。非特殊含义,就是这个符号本身。

例如

- [root@shellcn.net ~#] echo aaa|grep 'a?';[root@shellcn.net ~#] echo aaa|grep 'a\?';aaa#egrep

使用的是扩展正则表达式 - [root@shellcn.net ~#] echo aaa|egrep 'a?';aaa[root@shellcn.net ~#] echo aaa|egrep 'a\?';

可见,扩展正则表达式与基础正则表达式的区别,就是它们加不加转义符号,代表的意思刚好相反。

ERE 历史没有后向引用的。圆括号在 ERE 里具有特殊含义,但和 BRE 里使用的又有所不同。在 ERE 里,\ ( 与 \ ) 匹配的是字面上的左括号与右括号。

ERE 在匹配多字符这方面,与 BRE 有明显的不同,不过在 (*) 的处理上和 BRE 是相同的。

注意:

- 有一个例外,* 作为 ERE 的第一个字符是” 未定义的”,而在 BRE 中它是指” 符合字面的”。

- 一般情况下使用 grep 控制 BRE,使用 egrep 控制 ERE。

- 使用 ERE 匹配我们之前介绍过的离子” 要刚好重现 5 个 a” 以及” 重现 10 个至 42 个 q”,写法分别为:a{5},q{10,42}。而 {与 } 则可以匹配字面上的花括号。当在 ERE 里 {找不到匹配} 时,POSIX 特意保留其含义为” 未定义状态”。

ERE 另有两个 meta 字符,可更细腻的处理匹配控制:

- ?

匹配于 0 个或一个前置正则表达式 - +

匹配于一个或多个前置正则表达式

可以把? 想象成是” 可选用的”,也就是说,匹配前置正则表达式的文本,要么出现,要么没出现。例如: 与 ab?c 匹配的有 ac 与 abc,就这两者 ! (与 ab*c 相较之下,后者匹配于中间有人一个 b)。

+ 字符在概念上与 *meta

字符类似,不过前置正则表达式要匹配的文本在这里至少得出现一次。例如 ab+c 匹配于 abc,abbc,abbbc,但是不匹配于 ac。ab+c 的正则表达式等价于 abbc; 无论如何,当前值正则表达式很复杂时,使用 + 可以少打一点字,这就减少了打错字的几率。

方括号运算符一宇表示” 匹配于次祖父,或其他字符,或...”,但不能指定” 匹配于这个序列,或其他序列”。要达到后者的目的,可以使用管道运算符 (|)。例如 read | write 匹配于 read 与 write 两者,fast|slow 匹配于 fast 与 slow。| 字符是 ERE 运算符;i 优先级最低的。

9

shell 学习第九天----分组

分组

基本正则表达式中支持分组,而在扩展正则表达式中,分组的功能更加强大,也可以说才是真正的分组,用法如下:

():分组,后面可以使用 \1 \2 \3... 引用前面的分组,除了方便后面引用外,分组还非常方便的可以使用上述次数匹配方法进行匹配具有相同条件的数据。

如:grep '^(barlow).*\1' /etc/passwd

搜索 /etc/passwd 中以 barlow

开头,而后面还存在 barlow 的行。

在 BRE 中,我们使用一些 meta 字符修饰前置字符,匹配重复的情况。但是这样的操作仅仅针对单个字符。在 ERE 中,分组功能能够计 meta 字符修饰前置字符串。一个针对字符,一个针对字符串。

在 ERE 里,我么已经提到运算符是被应用到” 前置的正则表达式”。这是因为有圆方括号 ({...}) 提供分组功能,让接下来的运算符可以应用。例如 (why)+ 匹配于一个或连续重复的多个 why。再例如:[Tt]he (CPU|computer) is

指的是: 在 the(The) 与 is 之间,含有 CPU 或 computer 的句子。特别注意: 圆括号里的是 meta 字符,而非要匹配的输入文本。由此看出用到交替的时候,分组特别有用。

例如 (read|write)+

指的是: 有一个或重现多个 read,或者一个或重现多个 write.(read|write)+

所指的字符串中间,不允许有空白。当将交替操作结合 ^ 与 $ 锚点字符使用时,分组就非常好用了。由于 | 为所有运算符中优先级最低的,因此正则表达式 ^abcd|efgh$

意思是” 匹配字符串的起始处是否具有 a b c d 或者字符串结尾是否具有 e f g h”(表示查找字符),这和 ^(abcd)|(efgh)$

不一样,后者的意思是” 找一个正好是 abcd 或正好是 efgh 的字符串”

- “^” 与”$” 在 ERE 和 BRE 表示的含义是相同的,需要注意的是他们在方括号表达式中将会失去他们的特殊意义;

- 组合使用,例如 this is ^(one|two)$

匹配 one 或者 two。在 ERE 里,^

和 $

永远是 meta 字符。所以,像 ab^cd

与 ef$gh

这样的正则表达式仍然是有效的,只是无法匹配到任何东西,因为 ^ 前面有其他的字符串,$ 后面也有字符串,失去了他们的特殊含义。

运算符

含义

[..] [= =] [: :]

用于字符对应的方括号符号

\metacharacter

转移的 meta 字符

[]

方括号表达式

()

分组

* + ? {}

重复潜质的正则表达式

无符号 (no symbol)

连续字符

^ $

锚点

|

交替

最常见的扩展为 \<

与 \>

运算符, 分别匹配” 单词 (word)” 的开头与结尾, 单词是由字母, 数字及下划线组成的。我们称这类字符为单词组成。

例如:\<chop

匹配于 use chopsticks

,但是 eat a lambchop

则不匹配;同样的 chop>\

匹配与第二个字符串,第一个则不匹配。特别注意:\<chop>\

的表达式下,两个字符串都不匹配。

运算符

含义

\w

匹配任何单词组成字符

\W

匹配任何非单词组成字符

\<\>

匹配单词的起始和结尾

\b

匹配单的起始或结尾处所找到的空字符串 / 这是 \< 与 >\ 运算符的结合. 注意: 由于 awk 使用 \b 表示后退运算符, 因此 GNU awk(gawk) 使用 \y 表示此功能。

\B

匹配两个单词组成字符之间的空字符串

\’ \ `

分别匹配 emacs 缓冲区的开始与结尾.GNU 程序 (wmacs) 通常将他们是位 ^ 和 $ 同义。

例子:'<!-\?[^-]\+'#<

后面是 ! 然后是 0~1 个-,最后是一个非-字符。

10

shell 学习第十天----sed 查找与替换

在文本文件离进行替换

在很多 shell 脚本的工作都从通过 grep 或 egrep 去除所需的文本开始。 正则表达式查找的最初结果,往往就成了要拿来作进一步处理的” 原始数据”。 通常,文本替换至少需要做一件事,就是讲一些字以另一些字取代,或者删除匹配行的某个部分。执行文本替换的正确程序应该是 sed----流编辑器。

sed 的设计就是用来批处理而不是交互的方式编辑文件。 当药做好几个变化的时候,不管是对一个还是对数个文件,比较简单的方式就是将这些变更部分写到一个编辑的脚本里,再将此脚本应用到所有必须修改的文件,sed 的存在目的就在这里。

在 shell 里,sed 主要用于一些简单的文本替换,所以我们先从他开始。

基本用法:

我们经常在管道中间使用 sed,用来执行替换操作,做法是使用 s 命令 ---- 要求正则表达式寻找,用替换文本替换匹配的文本呢,以及可选的标志:

- sed ‘s’:.*//’ /etcpasswd |

删除第一个冒号之后所有的东西 - sort -u

排序列表并删除重复部分

sed 的语法:

- sed [-n] ‘editing command’ [file...]

- sed [-n] -e ‘editing command’ [file...]

- sed [-n] -f script-file... [file...]

用途:

sed 可删除 (delete)、改变 (change)、添加 (append)、插入 (insert)、合、交换文件中的资料行,或读入其它档的资料到文 > 件中,也可替换 (substuite) 它们其中的字串、或转换 (tranfer) 其中的字母等等。例如将文件中的连续空白行删成一行、"local" 字串替换成 "remote"、"t" 字母转换成 "T"、将第 10 行资料与第 11 资料合等。

总合上述所言,当 sed 由标准输入读入一行资料并放入 pattern space

时,sed 依照 sed script

的编辑指令逐一对 pattern space

内的资料执行编辑,之後,再由 pattern space

内的结果送到标准输出,接着再将下一行资料读入。 如此重执行上述动作,直至读完所有资料行为止。

记住:

- sed 总是以行对输入进行处理

- sed 处理的不是原文件而是原文件的拷贝

主要参数:

- -e: 执行命令行中的指令,例如:sed -e 'command' file(s)

- -f: 执行一个 sed 脚本文件中的指令,例如: sed -f scriptfile file(s)

- -i: 与 -e 的区别在于:当使用 -e 时,sed 执行指令并不会修改原输入文件的内容,只会显示在 bash 中,而使用 -i 选项时,sed 执行的指令会直接修改原输入文件。

- -n: 读取下一行到 pattern space

。

行为模式:

读取输入文件的每一行。 假如没有文件的话,则是标准输入。 以每一行来说,sed 会执行每一个应用倒数入行的 esiting command

。 结果会写到标准输出 (默认情况下,或是显式的使用 p 命令及 -n 选项)。 若无 -e 或 -f 选项,则 sed 会把第一个参数看做是要使用的 editing command

。

- find /home/tolstoy -type -d -print

// 寻找所有目录 - sed ‘s;/home/tolstor;/home/lt/;’

// 修改名称; 注意: 这里使用分号作为定界符 - sed ‘s/^/mkdir /’

// 插入 mkdir 命令 - sh -x

// 以 shell 跟踪模式执行

上述脚本是说将 /home/tolstoy

目录结构建立一份副本在 /home.lt

下 (可能是为备份) 而做的准备

替换案例:

Sed 可替换文件中的字串、资料行、甚至资料区。其中,表示替换字串的指令中的函数参数为 s; 表示替换资料行、或资料区 > 的指令中的函数参数为 c。上述情况以下面三个例子说明。

* 行的替换

sed -e '1c/#!/bin/more' file (把第一行替换成#!/bin/more)

思考: 把第 n 行替换成 just do it

sed -e 'nc/just do it' file

sed -e '1,10c/I can do it' file (把 1 到 10 行替换成一行:I can do it)

思考: 换成两行 (I can do it! Let's start)

sed -e '1,10c/I can do it!/nLet'"/'"'s start' file

* 字符的替换

- $ sed 's/test/mytest/g' example

----- 在整行范围内把 test 替换为 mytest。如果没有 g 标记,则只有每行第一个匹配的 test 被替换成 mytest。 - $ sed -n 's/^test/mytest/p' example

-----(-n) 选项和 p 标志一起使用表示只打印那些发生替换的行。也就是说,如果某一行开头的 test 被替换成 mytest,就打印它。 - $ sed 's/^192.168.0.1/&localhost/' example

-----& 符号表示替换换字符串中被找到的部份。所有以 192.168.0.1 开头的行都会被替换成它自已加 localhost,变成 192.168.0.1localhost。 - $ sed -n 's/loveable/\1rs/p' example-----love

被标记为 1,所有 loveable 会被替换成 lovers,而且替换的行会被打印出来。 - $ sed 's#10#100#g' example

----- 不论什么字符,紧跟着 s 命令的都被认为是新的分隔符,所以,“#” 在这里是分隔符,代替了默认的 “/” 分隔符。表示把所有 10 替换成 100。

替换与查找

在 s 命令里以 g 结尾表示的是: 全局性,意即” 替代文本取代正则表达式中每一个匹配的”。 如果没有设置 gsed 指挥取代第一个匹配的。

鲜为人知的是: 可以在结尾指定数字,只是第 n 个匹配出现才要被取代:

- sed ‘s/Tom/Lisy/2’ < Test.txt

仅匹配第二个 Tom 通过给 sed 增加一个 -e 选项的方式能让 sed 接受多个命令。 - sed -e ‘s/foo/bar/g’ -e ‘s/chicken/cow/g’ myfile.txt 1>myfile2.txt

用 shell 命令将 test.log 文件中第 3-5 行的第 2 个“filter” 替换成“haha” - sed -i '3,5s/filter/haha/2' test.log

11

shell 学习第十一天----sed 正则的精确控制

有多少文本会改动,在使用 sed 的时候我们来看这么两个问题: 第一个问题是有多少人文本会匹配,第二个问题是从哪里开始匹配。

回答是: 正则表达式可以匹配整个表达式的输入文本中最长的,最左边的子字符串。除此之外,匹配的空 (null) 字符串,则被认为是比完全不匹配的还长。

- echo syx is a good body | sed 's/syx/zsf/'

使用固定字符串 - sed

可以使用完整的正则表达式。但是应该知道” 从最长的最左边” 规则的重要性。 - echo Tolstoy is worldly | sed 's/T.*y/Camus/'

- Camus

很明显,我们只想要匹配 Tolstoy,但是由于匹配会扩展到可能的最长长度的文本量,所以出现了这样的结果。

这就需要我们精确定义:

echo Tolstoy is worldly | sed 's/T[[:alpha:]]*y/Camus/'

Camus is worldly

在文本查找中,有事喊可能会匹配到 null 字符串,而在执行文本替代时,也允许插入文本。

ehco abc | sed 's/b*/l/'

labc

ehco abc | sed 's/b*/l/g'

lalcl

请留意,b*shi 如何匹配 abc 的前面与结尾的 null 字符串。

12

shell 学习第十二天----行与字符串

行 V.S. 字符串

大部分建议等程序都是处理输入数据的行,在这些情况下,不会有内嵌的换行字符出现在将要匹配的数据中,^ 与 $ 则分别表示行的开头与结尾。

很多应用程序会将数据是位记录与字段的结合。一条记录指的是相关信息的翻个集合,例如以企业来说,记录可能含有顾客,供应商以及员工等数据,以学校来说,则可能有学生数据。而字段指的就是记录的组成部分,例如姓名或者街道地址。

linux 鼓励使用文本类型数据,因此系统上最常见的数据存储类型就是文本了,在文本下,一行表示一天记录。一行内分割字段的两种惯例是:

- 第一种: 空格或者 tab 键 (制表符)。

name sex

syx M

- 第二种是使用特定的定界符来分割字段,例如冒号

name:sex

syx:M

两种方式各有优缺点。最明显的不同时是在处理多个连续重复的戒定福之时。使用空白分隔时,通常多个连续出现的空格或制表字符都看做一个定界符。濡染。若使用的特殊字符分隔,则每个定界符都会隔开一个字段。

以定界符分割字段最好的例子就是 /etc/passwd,在这个文件里,一行标识系统的一个用户,每个字段都是以冒号分隔。

syx5:x:511:513::/home/syx5:/bin/bash

该文件含有七个字段,含义分别如下:

- 用户名称

- 加密后的密码 (如账号为停用状态,此处为一个星号,或者若加密后的密码文件存储于另外的 /etc/shadow 里,则这里可能是其他字符)

- 用户的 ID 编号

- 用户组的 ID 编号

- 用户的姓名,有时恢复其他的相关数据 (电话号,办公室号码)

- 根目录

- 登陆的 shell

13

shell 学习第十三天----sed 案例分析

sed 的使用案例

使用 sed

操作 /etc/passwd

,最好复制一份 (cp /etc/passwd /tmp

),操作 tmp

下的 passwd

(其实不用,因为在一般情况下 sed

只是修改了输出结果,不会改变文件本身,除非要求这么做)。

- 要求: 将 /etc/passwd

的内容列出并且列印行号,同时删除 2~5 行。 - 做法:cat /etc/passwd | sed '2,5d'

sed 的动作是'2,5d'

(动作需要放在单引号之间)。nl 命令在 linux 系统中用来计算文件中行号。nl 可以将输出的文件内容自动的加上行号!其默认的结果与 cat -n

有点不太一样,nl 可以将行号做比较多的显示设计,包括位数与是否自动补齐 0 等等的功能。

只删除第二行

nl /etc/passwd | sed '2d'

删除第 3 行到最后一行

cat -n /etc/passwd | sed '3,$d'

在第二行后 (就是在第三行) 加上"i am fine" 字样

cat -n /etc/passwd | sed '2a i am fine'

如果要在第二行前面

nl /etc/passwd | sed '2i i am fine'

如果是要增加两行以上,在第二行后面加入两行字,例如[hello]与[how are you]

nl /etc/passwd | sed '2a hello\

\>how are you’

每一行之间都必须要以反斜杠 () 来进行新行的添加,所以上面的例子,我们可以发现在第一行的最后面就有 \ 存在。(再输入的是会需要注意,单引号不要一起输完)。

以行为单位的替换与现实

将第 2-5 行的内容替换成"hahaha" nl /etc/passwd | sed '2,5c hahaha'

,通过这个方法,我们就可以替换整行数据了。

仅列出 /etc/passwd

文件的 5-7 行 cat -n /etc/passwd | sed -n '5,7p'

,可以透过这个 sed 的以行为单位的显示功能, 就能够将某一个文件内的某些行号选择出来显示。

搜索 /etc/passwd

中有关 /root 关键字的行

nl /etc/passwd | sed '/root/p'

思考: 为什么会输出所有行的情况?

使用 -n 的时候将只打印包含模板的行。

nl /etc/passwd | sed -n '/root/p'

删除 /etc/passwd

所有包含 root 的行,其他行输出

nl /etc/passwd | sed '/root/d'

搜索 /etc/passwd

,找到 root 对应的行,执行后面花括号中的一组命令,每个命令之间用分号分隔,这里把 bash 替换为 blueshell,再输出这行:

nl /etc/passwd | sed -n '/root/{s/bash/blueshell/;p}'

如果只替换 /etc/passwd 的第一个 bash 关键字为 blueshell,就退出

nl /etc/passwd | sed -n '/bash/{s/bash/blueshell/;p;q}' 1

最后的 q 是退出。

除了整行的处理模式之外,sed 还可以用行为单位进行部分数据的搜寻并替换。 基本上 sed 的搜寻与替换与 vi 相当的类似。 sed 's/ 要被取代的字符串 / 新的字符串 /g'

先通过 /sbin/ifconfig eth0

查看本机的 IP 地址,我的是 (192.168.199.5)

将 IP 前面部分予以删除

/sbin/ifconfig eth0 | grep 'inet addr'|sed 's/^.*addr://g'

将 IP 后面部分予以删除

/sbin/ifconfig eth0 | grep 'inet addr'|sed 's/^.*addr://g' | sed 's/Bcast.*$//g'

即可得到 IP

一条 sed 命令,删除 /etc/passwd

第三行到末尾的数据,并把 bash 替换成 hahaha。

nl /etc/passwd | sed -e '3,$d' -e 's/bash/hahaha/g'

注意: 每天命令前面都加入了 -e 选项

最好别使用,如果使用需要加入一个 -i 选项

例如在最后一行插入 hahaha,nl /etc/passwd | sed -i '$i hahaha'

14

shell 学习第十五天----使用 cut 选定字段

使用 cut 选定字段

通过名字我们就能差不多猜测出该命令是个干嘛地,是用来剪下文本文件的数据,文本文件可以是字段类型或者是字符类型。后一种数据类型在遇到需要从文件里剪下特定的列时,很方便。注意: 一个制表符在此被视为单个字符。

案例: 显示系统上每个用户登录名称和全名

- cut -d : -f 1,5 /etc/passwd

cut 的语法:

- cut -d'

分隔字符' -f fields

<== 用于有特定分隔字符 - cut -c

字符区间 <== 用于排列整齐的信息

选项与参数:

- -d

:后面接分隔字符。与 -f

一起使用; - -f

:依据 -d 的分隔字符将一段信息分割成为数段,用 -f

取出第几段的意思; - -c

:以字符 (characters) 的单位取出固定字符区间;

实用例子: 只显示 /etc/passwd

的用户和 shell

- cat /etc/passwd | cut -d ':' -f 1,7

冒号是分割符,比如说。etc/passwd 中的每一行是一条绳子,每个冒号就是这条绳子上的一个标志,这些标志将绳子分成不同的部分。 - -c

选项的案例: echo "hello,world" | cut -c 8-12

输出第 8 到 12 个字符

提示:

在 /etc/passwd

中如果需要输出第 3-5 列:

- cat /etc/passwd | cut -d ':' -f 3-5

想要输出 3 到最后一列 - cat /etc/passwd | cut -d ':' -f 3-

15

shell 学习第十五天----join 连接字段

使用 join 连接字段

join 命令将多个文件结合起来,每个人建立的每条记录,都共享一个键值,键值指的是记录中的珠子段,通常会是用户名称,个人形式,员工编号之类的数据。

语法:

join [options...] file1 file2

主要选项

- -1 field1

- -2 field2

标明要结合的字段。 -1 field 指的是从 file1 取出 field1,而 -2field2 指的则为从 file2 取出 field2。 字段编号自 1 开始,而非 0。 - -o file.field

输出 file 文件中的 field 字段。 一般的字段则不打印。 除非使用多个 -o 选项,即可显示多个输出字段。 - -t separator

使用 separator 作为输入字段分割字符,而非使用空白。 次字符也为输出的字段分割字符。

读取 file1 与 file2,并根据共同键值结合多笔记录。默认以空白分隔字段。输出结果则包括共同键值,来自 file1 的其余记录,接着 file2 的其余记录 (指除了键值外的记录)。若 file1 位 -,则 join 会读取标准输入,每个文件的第一个字段是用来结合的默认键值; 可以使用 -1 与 -2 更改键值。默认情况下,在两个文件中未含键值的行将不打印。

Linux join 命令用于将两个文件中,指定栏位内容相同的行连接起来。

找出两个文件中,指定栏位内容相同的行,并加以合并,再输出到标准输出设备。

例如:

我有两个文件: 文件 aa 和文件 bb

aa 的内容为:

joe 100

jane 200

herman 300

chris 400

bb 的内容为:

joe 20

jane 10

herman 30

chris 98

每条记录都有两个字段:业务员的名字和销售量。为了让 join 运行得到正确结果,输入文件必须先完成排序.

编写下列脚本:

\#!/bin/sh

\#jointest.sh

\#删除注释并排序数据文件

sed ‘/^#/d’ aa | sort > aa.sorted

sed ‘/^#/d’ bb | sort > bb.sorted

\#以第一个键值做结合,将结果产生至标准输出

join aa.sorted bb.sorted

\#删除缓存文件

rm aa.sorted bb.sorted

保存退出

chmod +x jointest.sh

./jointest.sh

输出结果如下所示:

chris 400 98

herman 300 30

jane 200 10

joe 100 20

首先使用 sed 删除注释,然后再排序个别文件。排序后的缓存缓存文件称为 join 命令的输入数据,最后删除缓存文件.sed 的删除还记得吗?

sed '/^#/d' bb

这里的意思是说把 bb 文件里以#开头的行删除

16

shell 学习第十六天----join 练习

join 练习

两文件如下:t1.txt(tab 隔开每一列)

学号 姓名

001 xiaoming

002 zhangsan

t2.txt

科目号 学号 分数

0001 001 90

0002 001 80

0001 002 90

0002 002 100

合并为:

0001 001 xiaoming 90

0002 001 xiaoming 80

0001 002 zhangsan 90

0002 002 lisi 100

做法是:join -2 2 t1.txt t2.txt

(但是不明觉厉)

例如有文件 aa 和 bb

aa 的内容为:

joe 100

jane 200

herman 300

chris 400

bb 的内容为:

joe 20

jane 10

syx 90

chris 98

如果使用命令 join aa bb,则输出结果为:

我们默认合并两个文件,它们将以行开头相同的内容为对照,如果一样,则抵消,把不同的合并为同一行。

chris 400 98

jane 200 10

joe 100 20

如果使用命令 join -a1 aa bb,则输出结果为:

chris 400 98

herman 300

jane 200 10

joe 100 20

使用 -a1 选项的意义是: 以第一个文件为主要内容合并,显示第一个文件的所有内容,不显示第二个文件不匹配规则的内容,(匹配规则为:行头一样,则允许合并,每行后续不同内容合并一起,相同的抵消)

如果使用命令 join -a2 aa bb,则输出结果为

chris 400 98

jane 200 10

joe 100 20

syx 90

使用 -a2 选项的意义: 以第二个文件为主要内容合并,显示第二个文件的所有内容,不显示第一个文件不匹配规则的内容,(匹配规则为:行头一样,则允许合并,每行后续不同内容合并一起,相同的抵消)

如果使用 join -a1 -a2 aa bb

chris 400 98

herman 300

jane 200 10

joe 100 20

syx 90

使用 -a1 -a2 选项的意义是: 合并两个文件的所有内容,但不符合规则的,则各自为一行。

如果使用命令 join -o 1.1 2.2,输出结果为:

chris 98

jane 10

joe 20

使用该选项的意义是: 使用自定义合并队列选项,1.1 代表第一个文件的第一列,2.2 代表第二个文件的第二列

如果输入命令 join -t ’ ’ -o 1.1 2.2 aa bb,输出结果为:

chris 98

jane 10

joe 20

使用该选项的意义是:使用分隔符,将会更加精确的定位合并内容。

最后针对一下 join 各个选项的意义给出一定的解释:

语法:

join [-i][-a<1 或 2>][-e< 字符串 >][-o< 格式 >][-t< 字符 >][-v<1 或 2>][-1< 栏位 >][-2< 栏位 >][--help][--version][文件 1][文件 2]

补充说明:找出两个文件中,指定栏位内容相同的行,并加以合并,再输出到标准输出设备。

参数:

- -a<1 或 2> 除了显示原来的输出内容之外,还显示指令文件中没有相同栏位的行。

- -e< 字符串 > 若 [文件 1] 与 [文件 2] 中找不到指定的栏位,则在输出中填入选项中的字符串。

- -i

或 --igore-case

比较栏位内容时,忽略大小写的差异。 - -o

< 格式 > 按照指定的格式来显示结果。 - -t

< 字符 > 使用栏位的分隔字符。 - -v

<1 或 2> 跟 -a 相同,但是只显示文件中没有相同栏位的行。 - -1

< 栏位 > 连接 [文件 1] 指定的栏位。 - -2

< 栏位 > 连接 [文件 2] 指定的栏位。 - --help

显示帮助。 - --version

显示版本信息。

有没有发现一个问题,就是只能按照我写的来,稍微换换命令的参数就会出现说文件没有进行排序的提示?

需要注意的是,使用 join 连接两个文件的相关字段,都需要先进行排序。如果连接的主字段有重复,则会导致两个文件相关行的排列组合,请确保这是你需要的结果。

另外如果你想使用 -e

选项,需要使用 -o

选项来格式化列,否则 -e

是没有效果的。还有一点就是你会发现使用 -e -o

进行全连接的话,两个文件的关键列都必须使用上,负责 -e

会把缺失的关键列那也填补上相应的字符,有时候这并非我们期望的,具体的请自己行试验测试。

个人认为这是 join 命令的一点瑕疵,他应该两个文件如果全连接或者左连接右连接出现单独的关键键都应该是关键键名称而不是 -e

补充。不过这个瑕疵可以用 awk

来弥补一下,倒是挺容易。

join 命令,对文件格式的要求非常强,如果想要更灵活的使用,可用 AWK 命令,参加 AWK 实例。

有时我们需要将多个格式相同的文件 join 到一起,而 join 接受的是两个文件的指令,此时我们可以使用管道和字符 “-",来实现 join file1 file2 | join - file3 | join - file4

这样就可以将四个文件 连接到 一起了。

大体介绍了一下 join,然后介绍一下和 join 非常类似的一个命令:paste

- paste

将几个文件的相应行用制表符连接起来,并输出到标准输出。 - paste

[选项] file1 file2 - -d

指定不同于空格或 tab 键的域分隔符。例如用#分隔域, 使用 -d# - -s

将每个文件合并成行而不是按行粘

代码示例:

[root@jbxue ~]# cat names

Tony

Emanuel

Lucy

Ralph

Fred

[root@jbxue ~]# cat numbers

(307) 555-5356

(212) 555-3456

(212) 555-9959

(212) 555-7741

(212) 555-0040

将两个文件合并,中间用 tab 键分隔开

代码示例:

paste names numbers

Tony (307) 555-5356

Emanuel (212) 555-3456

Lucy (212) 555-9959

Ralph (212) 555-7741

Fred (212) 555-0040

cat addresses

55-23 Vine Street,Miami

39 University Place,New York

17 E. 25th Street,New York

38 Chauncey St.,Bensonhurst

17 E. 25th Street,New York

将 三个文件合并

代码示例:

paste names addresses numbers

Tony 55-23 Vine Street,Miami (307) 555-5356

Emanuel 39 University Place,New York (212)

555-3456

Lucy 17 E. 25th Street,New York (212) 555-9959

Ralph 38 Chauncey St.,Bensonhurst (212) 555-7741

Fred 17 E. 25th Street,New York (212) 555-0040

感觉 paste 没什么难度。

paste 练习

文件 aa 的内容为:

123

aaa

文件 bb 的内容为:

456

bbb

bbb

使用命令 paste -s aa bb,输出结果为

123 aaa

456 bbb bbb

使用 paste -d ”#” aa bb,输出结果为:

123#456

aaa#bbb

#bbb

详解:

paste 是 linux 命令

用途:

从一个或多个文件中连接行。

语法:

paste [-s] [-d List] File1 ...

描述:

paste 命令从在命令行上指定的文件中读取输入。如果出现 -(减号)作为文件名,此命令从标准输入中读取。此命令连接给定的文件中的行并把结果行写到标准输出中。

缺省情况下,paste 命令把每个文件当作栏,并用制表符水平连接它们(并行合并)。可以把 paste 命令看作为 cat 命令(垂直连接,也就是一个接一个)的相对命令。

使用 -s

标志,paste

命令合并同一输入文件的后继行(串行合并)。缺省情况下,这些行用制表符连接。

下列特殊字符也可用在 List 参数中:

- \n

换行符 - \t

制表符 - \\

反斜杠 - \0

空字符串(不是空字符)

shell 学习第十七天----awk 命令

使用 awk 重新编排字段

awk 非常擅长处理结构化数据和生成表单。和 sed 和 grep 很相似。由于 awk 具备各种及哦啊本语言的特点,所以可以把它看做是一种脚本语言。

先来看个案例,只查看 /etc/passwd/ 目录下的用户名和组名

awk -F: ‘{print $1,$5}’ /etc/passwd

意思是: 使用: 来分割这一行,把这一行的第一和第五个字段打印出来。

调用 awk

- 第一种方式:awk [-F 分隔符] 'commands' input-file(s)

这里的 commands

是真正的 awk

命令,[-F 分隔符] 适可选的,awk

默认使用空格分隔,因此如果要浏览域间有空格的文本,不必指定这个选项,但如果浏览如 passwd 文件,此文件各域使用冒号作为分隔符,则必须使用 -F

选项: awk -F : 'commands' input-file - 第二种方式:将所有 awk

命令插入一个文件,并使 awk

程序可执行,然后用 awk

命令解释器作为脚本的首行,以便通过键入脚本名称来调用它 - 第三种方式:将所有 awk

命令插入一个单独文件,然后调用,如: awk -f awk-script-file input-file-f

选项指明在文件 awk-script-file

的 awk

脚本,input-file

是使用 awk

进行浏览的文件名

任何 awk

语句都是由模式和动作组成,在一个 awk

脚本中可能有许多语句。模式部分决定动作语句何时触发及触发事件。动作即对数据进行的操作,如果省去模式部分,动作将时刻保持执行状态。

模式可以是任何条件语句或复合语句或正则表达式,模式包含两个特殊字段 BEGIN

和 END

,使用 BEGIN 语句设置计数和打印头,BEGIN

语句使用在任何文本浏览动作之前,之后文本浏览动作依据输入文件开始执行;END

语句用来在 awk

完成文本浏览动作后打印输出文本总数和结尾状态标志,有动作必须使用 {} 括起来

实际动作在大括号 {} 内指明,常用来做打印动作,但是还有更长的代码如 if

和循环 looping

语句及循环退出等,如果不指明采取什么动作,awk

默认打印出所有浏览出的记录

awk

执行时,其浏览标记为 $1,$2...$n

,这种方法称为域标记。使用 $1,$3

表示参照第 1 和第 3 域,注意这里使用逗号分隔域,使用 $0

表示使用所有域。例

- awk -F :‘{print $0}’ /etc/passwd

// 表示打印所有域并把结果重定向到 /etc/passwd 中 (所谓的域就是某一行中的字段) - awk -F : ‘{print $0}’ /etc/passwd

/// 在屏幕上显示出来 - awk ‘{print $1,$4}’ /etc/passwd

// 只打印第一和第四域 (第一和第四字段) - awk -F: ‘BRGIN{print”hahaha\n---”}{print $1 “\t” $4}’ /etc/passwd

// 表示打印头信息,在输入的内容的第一行前加上”hahaha”,同时内容之间用 tab 键分开。 - awk -F: 'BEGIN{print"hahaha\n---"}{print $1"\t"$4}END{print"end\n"}' /etc/passwd

// 这个代表的意思是说打印开头结尾

awk 的条件匹配符

<、<=、==、!=、>=、~ 匹配正则表达式、!~ 不匹配正则表达式

- 匹配:awk -F: '{if($1~/root/)print $0}' /etc/passwd

// 在 /etc/passwd 这个文件中,如果某条记录的第一个字段含有 root 就打印整条记录到屏幕上,注意,只要包含就行。 - 精确匹配 :awk -F: '$1=="root"{print $0}' /etc/passwd

// 某行中的第一个字段必须等于 root 才打印。 - 不匹配 : awk -F: '$0!~"root"{print $0}' /etc/passwd

打印整条不包含 root 的记录,使用双引号或者反斜杠都是一样的。

其他的操作符具体不在介绍。

awk 的设计目的就是操作记录与字段:awk 读取输入记录 (通常是一些行),然后自动将各个记录且分为字段。awk 将每条记录内的字段树木,存储到内建变量 NF。通过上面的例子,差不多已经总体上有了一定得了解:awk '{print $NF}'

打印最后一行,比较特殊的字段是编号 0,表示整条记录。

awk 内置变量

ARGC 命令行参数个数

ARGV 命令行参数排列

ENVIRON 支持队列中系统环境变量的使用

FILENAME awk 浏览的文件名

FNR 浏览文件的记录数

FS 设置输入域分隔符,等价于命令行 -F 选项

NF 浏览记录的域的个数

NR 已读的记录数

OFS 输出域分隔符

ORS 输出记录分隔符

RS 控制记录分隔符

案例

统计 /etc/passwd

: 文件名,每行的行号,每行的列数,对应的完整行内容:

awk -F ':' '{print"filename:"FILENAME",linenumber:"NR",columns:"NF",linecontent:"$0}' /etc/passwd

除了 awk 的内置变量,awk 还可以自定义变量。

例如:

统计 /etc/passwd

的行数

awk '{count++}END{print count}' /etc/passwd

count 是自定义变量,这里没有初始化 count,虽然默认是 0,但是妥当的做法还是初始化为 0。

awk 'BEGIN{count=0}{count=count+1}END{print count}' /etc/passwd

例如:

统计某个文件夹下的文件占用的字节数

ls -l |awk 'BEGIN {size=0;} {size=size+$5;} END{print"[end]size is ",size}'

如果按照 M 为单位显示

ls -l |awk 'BEGIN {size=0;} {size=size+$5;} END{print"[end]size is ",size/1024/1024,"M"}'

小结:

- 如果需要从输入的数据文件夹中取出特定的文本行,主要的工具为 grep 程序。

- sed

是处理简单字符串替换的主要工具。大部分 shell 脚本在使用 sed

时几乎都是用来做替换的操作。 - “从最左边开始,扩展至最长” 这个法则描述了匹配的文本在何处匹配以及匹配扩展到多长。在使用 sed,awk

或其他交互式文本编辑程序时,这个法则相当重要。 - cut 命令用以剪下选定的字符范围或字段。join 则是用来结合记录中具有共同键值的字段的文件。

- awk

多半用于简单的“单命令行程序”,当你想要只显示选定的字段,或是重新安排行内的字段顺序时,就是 awk

排上用场的时候了。由于 awk

还是编程语言,即使在尖端的程序里,他也能发挥强大的作用。

18

shell 学习第十八天----文本排序

排序文本

行的排序,使用的命令 sort

,该命令的语法是: sort [option] [files...].sort

将文件 / 文本的每一行作为一个单位,相互比较,比较原则是从首字符向后,依次按 ASCII 码值进行比较,最后将他们按升序输出。

入门案例:

有一个文件 temp.txt,内容为:

aaa:10:1.1ccc:30:3.3ddd:40:4.4bbb:20:2.2eee:50:5.5eee:50:5.5

使用 sort temp.txt 输出结果为:

aaa:10:1.1bbb:20:2.2ccc:30:3.3ddd:40:4.4eee:50:5.5eee:50:5.5

再来看 sort 的各个选项的使用:

- -b

:忽略每行前面开始处的空格字符; - -c

:检查文件是否已经按照顺序排序,排序过为真; - -d

:排序时,处理英文字母、数字和空格字符,以字典顺序排序。忽略其他所有字符; - -f

:排序时,将小写字母视为大写字母; - -i

:排序时,处理 040~176 之间的 ASCII 字符,忽略其他所有字符; - -m

:将几个排序好的文件进行合并; - -M

:将前面 3 个字母按月份的缩写进行排序; - -n

:按照数值大小进行排序; - -o

outfile.txt:将排序后的结果存入 outfile.txt; - -r

:以相反的顺序进行排序; - -k

:指定需要排序的列数(栏数); - -t

分隔符:指定排序时所用到的栏位分隔符; - +

起始栏位 - 结束栏位:以指定的栏位来排序,范围从起始栏位到结束栏位的前一栏位。(古老的用法)

案例:

使用 -u

选项的输出,还是针对文件 temp.txt

aaa:10:1.1

bbb:20:2.2

ccc:30:3.3

ddd:40:4.4

eee:50:5.5

例如:

有一个文件 sort.txt,内容为:

AA:BB:CC

aaa:30:1.6

ccc:50:3.3

ddd:20:4.2

bbb:10:2.5

eee:40:5.4

eee:60:5.1

使用 sort -nk 2 -t: sort.txt

排序后的结果为:

AA:BB:CC

bbb:10:2.5

ddd:20:4.2

aaa:30:1.6

eee:40:5.4

ccc:50:3.3

eee:60:5.1

上述命令的意思是说,将第二列按照数字从小到大排列

使用 sort -nrk 3 -t: sort.txt

,该命令的意思是说,将第三列数字从大到小排列,所以输出的结果为:

eee:40:5.4

eee:60:5.1

ddd:20:4.2

ccc:50:3.3

bbb:10:2.5

aaa:30:1.6

AA:BB:CC

备注: -n

是按照数字大小排序,-r

是以相反顺序,-k

是指定需要排序的栏位,-t

指定栏位分隔符为冒号。

问题: 有一个文件,内容为:

banana:30:5.5

apple:10:2.5

pear:90:2.3

orange:20:3.4

第一列表示水果名称,第二列表示水果数量,第三列表式水果价格。我想按照水果的数量进行排序,怎么办?

- sort -nk 2 -t : fruit.txt

(从小到大排序) - sort -nrk 2 -t : fruit.txt

(从大到小排序,注意选项的位置)

如果我想给 /etc/passwd

按照第三行排序,应该是这样:

- sort -t':' -k 3 /etc/passwd

,但是细心的你一定会发现其中的问题,貌似不对啊? 不应该啊? 那是因为 -k 选项默认是按照字典数排列,如果想按照数字排列需要指定 sort -t':' -k 3n /etc/passwd

,也就是需要加上 -n

选项。

如果想逆序排列呢?

- sort -t':' -k 3nr /etc/passwd

如果要对 /etc/passwd

文件中第六列的第二个字符到第四个字符正序排列,再基于第一列进行反向排序。

- sort -t':' -k 6.2,6.4 -k 1r /etc/passwd

引入一个关于 -k

选项的新知识。

-k 选项的语法格式:

FStart.CStart Modifie,FEnd.CEnd Modifier-------Start--------,-------End-------- FStart.CStart 选项,FEnd.CEnd 选项

这个语法格式可以被其中的逗号(“,”)分为两大部分,Start 部分和 End 部分。Start 部分也由三部分组成,其中的 Modifier 部分就是我们之前说过的类似 n 和 r 的选项部分。我们重点说说 Start 部分的 FStart 和 C.Start

。C.Start

也是可以省略的,省略的话就表示从本域的开头部分开始。FStart.CStart,其中 FStart 就是表示使用的域,而 CStart 则表示在 FStart 域中从第几个字符开始算 “排序首字符”。同理,在 End 部分中,你可以设定 FEnd.CEnd

,如果你省略.CEnd

,则表示结尾到 “域尾”,即本域的最后一个字符。或者,如果你将 CEnd 设定为 0(零),也是表示结尾到 “域尾”。

那么很显然 -k 6.2,6.4

的意思很明确,第六个字段的第二个字符到第六个字段的第四个字符. 按照正序排列。

案例:

查看 /etc/passwd

有多少个 shell: 对 /etc/passwd

的第七个域进行排序,然后去掉重复的行:

cat /etc/passwd | sort -t':' -k 7 -u

sort 的行为模式: 它会读取指定的文件,如果文件未给出,则读取标准输入,再将排序好的数据写至标准输出。

总结:

- 如果按照行排序,使用 -k 6

; 按照字段排序,使用 -k 6.2 6.4

这样的书写格式。字段以及字段里的字符是有 1 开始。如果进指定一个字段编号,则排序键值会自该字段的起始处开始,一直继续到记录的结尾 (而非字段的结尾)。 - 使用逗号 (或者空格) 隔开的字段,是由逗号 (或者空格) 左边开始,逗号 (或者空格) 右边结束。例如:-k 6.2,6.4

表示从第六个字段的第二个字符到第六个字段的第四个字符。 - 当出现多个 -k

选项的时候,会先从第一个键值字段开始排序,找出匹配该键值的记录后,再进行第二个键值字段的排序,以此列推。

19

shell 学习第十九天----文本块排序

文本块排序

文本快排序出现的原因: 有时,你会需要将多行记录组合而成的数据排序。 地址清单就是一个很好的例子,为了方便阅读,地址记录经常会切断,以一个或数个空行批次隔开,像这种数据,没有一定的排序键值位置可供 -k

选项使用,所以就引入了文本快排序。

案例:

我有一个文件 adress.txt,内容为:

J Luo

Southeast University

Nanjing,China

\

Y Zhang

Victory University

Melbourne,Australia

\

D Hou

Beijing University

Beijing,China

\

B Liu

Shanghai Jiaotong University

Shanghai,China

\

C Lin

University of Toronto

Toronto,Canada

要求:对文本块根据学校的名字 (每个文本块的第二行) 进行排序,结果仍然能以文本块的格式输出。

awk '{a[$2]=$0}END{for(i=1;i<=asorti(a,b);i++)print a[b[i]]}' ORS='\n\n' RS= FS='\n' adress.txt

这一种方法效率高,各种牛逼,看不明白十格什么 JB 意思。

第二种方式:awk 'BEGIN{FS="\n";RS=""}{print $1":"$2":"$3":"}' adress.txt|sort -t ":" -k2|tr ":" "\n"

,这种方式貌似比较平民,适合屌丝玩家。 那到底是什么意思呢?

首先使用 awk

命令将文本块转化成以下这样:

J Luo:Southeast University:Nanjing,China

Y Zhang:Victory University:Melbourne,Australia

D Hou:Beijing University:Beijing,China

B Liu:Shanghai Jiaotong University:Shanghai,China

C Lin:University of Toronto:Toronto,Canada

然后使用 sort

命令按照学校 (也就是原文本的第二行) 排序。 排序后的结果为:

D Hou:Beijing University:Beijing,China

B Liu:Shanghai Jiaotong University:Shanghai,China

J Luo:Southeast University:Nanjing,China

C Lin:University of Toronto:Toronto,Canada

Y Zhang:Victory University:Melbourne,Australia

最后使用 tr “:” “\n”

命令,将排序后的文本转化回来。

awk

的 FS

: 输入字段分隔符(缺省为space

),相当于 -F

选项

awk -F ':' '{print}' shcool.txt

和 awk 'BEGIN{FS=":"}{print}' shcool.txt

是一样的

RS:输入记录分隔符,缺省为 "\n"

缺省情况下,awk

把一行看作一个记录;如果设置了 RS,那么 awk

按照RS

来分割记录,此处的意思是说将原文本看成是一条记录。

例如,如果文件 c,cat c 为

hello world; I want to go swimming tomorrow;hiahia

运行 awk 'BEGIN{RS =";"} {print}' c

的结果为

hello world

I want to go swimming tomorrow

hiahia

合理的使用 RS

和 FS

可以使得 awk

处理更多模式的文档,例如可以一次处理多行,例如文档 d ,cat d

的输出为

1 2

3 4 5

\

6 7

8 9 10

11 12

\

hello

每个记录使用空行分割,每个字段使用换行符分割,这样的 awk

也很好写

awk 'BEGIN{FS ="\n"; RS =""} {print NF}' d

输出

2

3

1

而 tr

的意思是替换,将":"

替换成"\n"

。

20

shell 学习第二十天----sort 的其他内容以及 uniq 命令

sort 的其他内容以及 uniq 命令

在排序算法里有个重要的问题: 是否稳定? 这个问题指的是: 相同的记录输入顺序是否在输出时也可保持原状? 当你以多键值为记录进行排序,或是以管道处理时,排序稳定性就非常重要了。我们先来验证一下。

sort -t_ -k1,1 -k2,2 <<EOF

\> one_two

\> one_two_three

\> one_two_four

\> one_two_five

\>EOF

输出为:

one_two

one_two_five

one_two_four

one_two_three

每条记录内的排序字段都相同,但是输出与输入不一致,所以我们说 sort 不是稳定的排序。幸好: 我们可以通过--stable 选项补救这个问题,设置此选项,就会稳定了。

sort --stable -t_ -k1,1 -k2,2 << EOF

输出为:

one_two

one_two_three

one_two_four

one_two_five

sort

命令的重要性绝对能在 linux 中拍到前十。

有时,将数据流里连续重复的记录删除是必要的。使用 sort -u

的消除操作十一局匹配的键值,而非匹配的记录。

uniq

命令提供了另外一种过滤数据的方式: 常用于管道中,用来删除已使用 sort 排序完成的重复记录。

sort ... | uniq | ...

uniq [OPTION]… [INPUT [OUTPUT]]

从文件中去除或删除重复的行,在功能上和 sort -u

类似。

常用选项:

- -u

: 只显示不重复的行 - -d

: 只显示重复的行 - -c

: 打印每一行出现的次数 - -fn

: 忽略前 n 个域

例如: 我有一个文件:unip.txt

tres

unus

duo

tres

duo

tres

使用 sort uniq.txt |uniq

命令显示唯一的,排序后的记录,重复则仅取唯一行。

输出为:

duo

tres

unus

使用 sort uniq.txt | uniq -c

命令计数唯一的,排序后的记录,说白了就是统计各行文本出现的次数

2 duo

3 tres

1 unus

代表的意思是说 duo 出现了两次,tres 出现了三次,unus 出现了一次。

使用 sort uniq.txt | uniq -d

命令仅显示重复的记录

输出结果为:

duo

tres

使用 sort uniq.txt | uniq -u

命令仅显示未重复的记录

输出结果为:unus

- 并集:cat file1.txt file2.txt | sort | uniq > file.txt

- 交集:cat file1.txt file2.txt | sort | uniq -d >file.txt

- 差集:求 file1.txt 相对于 file2.txt 的差集,可先求出两者的交集 temp.txt,然后在 file1.txt 中除去 temp.txt 即可。

cat file1.txt file2.txt | sort | uniq -d >temp.txt

cat file1.txt temp.txt | sort | uniq -u >file.txt

文本中的重复行,基本上不是我们所要的,所以就要去除掉。linux 下有其他命令可以去除重复行,但是我觉得 uniq 还是比较方便的一个。使用 uniq 的时候要注意以下二点

- 对文本操作时,它一般会和 sort

命令进行组合使用,因为 uniq 不会检查重复的行,除非它们是相邻的行。如果您想先对输入排序,使用 sort -u

。 - 对文本操作时,若域中为先空字符 (通常包括空格以及制表符),然后非空字符,域中字符前的空字符将被跳过

uniq 的所有选项:

- -c

, --count // 在每行前加上表示相应行目出现次数的前缀编号 - -d

, --repeated // 只输出重复的行 - -D

, --all-repeated // 只输出重复的行,不过有几行输出几行 - -f

, --skip-fields=N //-f 忽略的段数,-f 1 忽略第一段 - -i

, --ignore-case // 不区分大小写 - -s

, --skip-chars=N // 根 -f 有点像,不过 -s 是忽略,后面多少个字符 -s 5 就忽略后面 5 个字符 - -u

, --unique // 去除重复的后,全部显示出来,根 mysql 的 distinct 功能上有点像 - -z

, --zero-terminated end lines with 0 byte, not newline - -w

, --check-chars=N // 对每行第 N 个字符以后的内容不作对照 - --help

// 显示此帮助信息并退出 - --version

// 显示版本信息并退出

21

shell 学习第二十一天----重新格式化段落

重新格式化段落

大部分功能强大的文本编辑器都提供重新格式化段落的命令;供用户切分段落,使文本行数不要超出我们看到的屏幕范围。这样我们就引入了 fmt

命令,虽然一些 fmt

的实现有较多的选项可用,但其实只用:-s

仅切割较长的行,但不会将短行结合成较长的行,而 -w n

则设置输出行宽度为 n 个字符 (默认通常是 75 个)。

fmt 命令的语法:

fmt [option] [file-list]

fmt 通过将所有非空白的长度设置为几乎相同,来进行简单的文本格式化。

- -s

截断长行,但不合并 - -t

除每个段落的第 1 行外都缩进 - -u

改变格式化,使字之间出现一个空格,句子之间出现两个空格 - -w n

将输出的行宽改为 n 个字符。不带该选项时,fmt 输出的行宽度为 75 个字符

例如,我有一个文件 demo,内容为:

A long time ago, there was a huge apple tree.A little boy loved to come and play around it every day. He climbed to the tree top, ate the apples, took a nap under the shadow… He loved the tree and the tree loved to play with him.

使用命令 fmt -s demo

,输出为:

A long time ago, there was a huge apple tree.A little boy loved

to come and play around it every day. He climbed to the tree top, ate

the apples, took a nap under the shadow… He loved the tree and the

tree loved to play with him.

该命令的含义是节段 2 长行。

使用 fmt -t demo

命令的意思是说排除首行的缩进,结果为:

A long time ago, there was a huge apple tree. A little boy loved

to come and play around it every day. He climbed to the tree top,

ate the apples, took a nap under the shadow… He loved the tree and

the tree loved to play with him.

使用 fmt -u demo

命令的意思是说格式化单词和句子的间隔。输出为:

A long time ago, there was a huge apple tree. A little boy loved to come

and play around it every day. He climbed to the tree top, ate the apples,

took a nap under the shadow… He loved the tree and the tree loved to

play with him.

显然 A little boy 前面的多个空格变成了两个。

使用命令 fmt -w 40 demo

意思是说指定行的宽度,这里的行宽为 40 个字符。所以输出为:

A long time ago, there was a huge

apple tree. A little boy

loved to come and play around it

every day. He climbed to the tree top,

ate the apples, took a nap under the

shadow… He loved the tree and the

tree loved to play with him.

仅作切割的选项: -s

,在你想将长的行绕回,短的行保持不动时很好用,这么做也能使结果与原始版本间的差异达到最小,例如:

fmt -s -w 10 << EOF

one two three four five

six

seven

eight

输出为:

one two

three

four five

six

seven

eight

fmt 的小案例:

下面以拼音字典为例:

字典文件:/usr/dict/words

或者 /usr/share/dict/words

。

- sed -n -e 9991,10010p /usr/share/dict/words | fmt

- sed -n -e 9991,10010p /usr/share/dict/words | fmt -w 30

观察上面两行命令的输出。

复习一下 sed

命令:

sed 是一个很好的文件处理工具,本身是一个管道命令,主要是以行为单位进行处理,可以将数据行进行替换、删除、新增、选取等特定工作。假设我们有一个文件 demo

sed '1d' demo 删除第一行

sed -n '1p' 显示第一行

sed -n '/root/p' demo 查询包括关键字 root 所在所有行

sed '1a hahaha' demo 第一行后增加字符串 hahaha

sed '1,3a hahaha' demo 第一行到第三行后增加字符串 hahaha

sed '1c hihihi' demo 第一行代替为 hihihi

sed '1,2c hihihi' demo 第一行和第二行替换为 hihihi

替换一行中的某部分

格式:sed 's/ 要替换的字符串 / 新的字符串 /g' (要替换的字符串可以用正则表达式),案例:

sed 's/root/hahaha/g' 替换 root 为 hahaha

sed 's/root//g' 删除 root

sed -i '$a bye' ab #在文件 ab 中最后一行直接输入 "bye"

22

shell 学习第二十二天----计算行数, 字数以及字符数

计算行数,字数以及字符数

wc 命令可能是 linux 工具集里最古老也最简单的工具程序。wc 的默认输出是一行报告,包括行数,字数以及字节数:

echo this is a test of the emergency broadcast system | wc

1 9 49

如果要求仅输出部分结果,可以使用的选项有:-c

(字节数),-l

(行数),-w

(字数);

echo test one two three | wc -c

19

echo test one two three | wc -l

1

echo test one two three | wc -w

4

-c

选项原本是表示字符数,但因为有多字节字符集的编码存在----像是 UTF-8,因此在当前系统上,字节数已不再等同于字符数了,也因此,posix 出现了 -m

选项,用以计算多字节字符,对 8 位字符数据而言,它是等同于 -c

的。

虽然 wc 最长处理的是来自于管道的输入数据,但它也接受命令行的文件参数,可以生成一行一个结果,再附上报告:计算两个文件里的数据

输入命令:wc /etc/passwd /etc/group

输出结果:

40 61 1804 /etc/passwd

64 64 874 /etc/group

104 125 2678 总用量

wc 的现代版会随 locale 而有不同结果: 将环境变量 LC_CTYPE

设为想用的 locale

,会影响 wc 把字节序列解释为字符或单词分隔器。

做一个操作,需要把一个文件的行数存在另一个文件里。可是这个 wc 还会同时输出文件名。咋办?简单,用管道处理一下

wc -l demo.txt | awk -F""'{print$1}'

这样,我们就把想要的文件行数给取到了,至于存在另一个文件里,我们可以把 awk 的 print 结果重定向到文件啊。

补充:wc 所有选项

- -c

:统计字节数 - -l

:统计行数 - -m

:统计字符数。 这个标志不能与 -c 标志一起使用 - -w

:统计字数。 一个字被定义为由空白,挑个或换行字符分隔的字符串。 - -L

:打印最常行的长度 - -help

:显示帮助信息 - --version

:显示版本信息

23

shell 学习第二十三天----打印

如果希望打印文件,最好预先处理一下,包括调整边距,设置行高,设置标题等,这样打印出来的文件更加美观。当然,不处理也能打印,但是可能会比较丑陋。

pr 命令

pr 命令就是转换文件格式的,可以把较大的文件分割成多个页面进行打印,并未每个页面添加标题。

语法:

pr option(s) filename(s)

pr

命令仅仅改变在屏幕上的输出样式,不改变文件本身,和 sed 有点类似。常见选项如下:

- -k

:分成激烈打印,默认为 1。 - -d

:两倍行距 (并不是所有版本的 pr 都有效)。 - -h

:“title” 设置每个文件的标题。 - -l

:PAGE_LENGTH :每页显示多少行。默认是每个页面一共 66 行。 - -o

:MARGIN:每行缩进的空格数。 - -w

:PAGE_WIDTH:多列输出时,设置页面宽度,默认是 72 个字符。

例如我有一个文件 food,里面的内容为:

Sweet Tooth

Bangkok Wok

Mandalay

Afghani Cuisine

Isle of Java

Big Apple Deli

Sushi and Sashimi

Tio Pepe's Peppers

使用命令:pr -2 -h "food" food

输出结果为:

2015-06-22 12:27 food 第 1 页

weet Tooth Isle of Java

Bangkok Wok Big Apple Deli

Mandalay Sushi and Sashimi

Afghani Cuisine Tio Pepe's Peppers'

解释:pr

会以文件的修改时间作为页面标题的时间戳;如果输入时自管道而来,则使用当前的时间,接上文件名称 (如果输入的数据内容在管道中,则为空) 以及页码。

lp

和 lpr

命令将文件传送到打印机进行打印。使用 pr 命令将文件格式化后就可以使用这两个命令来打印。例如:

pr -2 -h "food" food | lpr

命令成功执行会返回一个表示打印任务的 ID,通过这个 ID 可以取消打印或者查看打印状态。

如果你希望打印多份文件,可以使用 lp

的 -nNum

选项,或者 lpr

命令的 -Num

选项。Num 是一个数字,可以随意设置。

如果系统连接了多台打印机,可以使用 lp

命令的 -dprinter

选项,或者 lpr

命令的 -Pprinter

选项来选择打印机。printer 为打印机名称。

lpstat

和 lpq

命令

lpstat

命令可以查看打印机的缓存队列(有多少个文件等待打印),包括任务 ID、所有者、文件大小、请求时间和请求状态。

提示:等待打印的文件会被放到打印机的的缓存队列中。

使用 lpstat -o

命令查看打印机中所有等待打印的文件,lpstat -o

命令按照打印顺序输出队列中的文件。

cancel

和 lprm

分别用来终止 lp

和 lpr

的打印请求。使用这两个命令,需要指定 ID(由 lp

或 lpq

返回)或打印机名称。

lprm

命令用来取消当前用户的正在等待打印的文件,使用任务号作为参数可以取消指定文件,使用横线 (-) 作为参数可以取消所有文件。lprm

会返回被取消的文件名。

24

shell 学习第二十四天----提取开头或结尾数行

提取开头或结尾数行

有时,会需要从文本文件里把几行字----多半是靠近开头或结尾的几行,提取出来;或者,有时只要瞧瞧工作日志的后面几行,就可以了解最近工作活动的大概情况。可以用下面的方式显示标准钱 n 条记录,或是命令行文件列表中的每一个前 n 条记录。

head -n n [file(s)]

head -n [file(s)]

awk 'FNR<= n' [file(s)]

sed -e nq [file(s)]

sed nq [file(s)]

个人觉得最好用的显示文本文件的头几行最好用的是 head -n [file(s)]

head 的常用选项:

- -q

:隐藏文件名 - -v

:显示文件名 - -c<字节>

:显示字节数 - -n<行数>

:显式的行数

在交互式 shell 通信期中,有时需要监控某个文件的输出----如日志这类持续写入状态的文件。-f

选项这时就派上用场了,他可以要求 tail 显示指定的文件结尾行数,接着进入无止境的循环中----休息一秒后又再度醒来并检查是否需要显示更多的输出结果。再设置 -f

的状态下,tail 只有当你中断它时才会停止----通常是输入 Ctrl+C

来中断:

tail -n 25 -f /var/log/messages 观察此选项不可用于 shell 脚本

直到按了 ctrl+c

选项后才停止。

由于 tail 加上 -f

选项之后便不会自己中断,所以此选项不能用于 shell 脚本。使用 -f

选项有实时监听的效果。

head 案例:

使用命令:head -n 3 /etc/passwd

结果是显示文件的头三行,如果命令为:head -n -3 /etc/passwd

结果是显示除了最后三行都显示,注意到区别没有?

相似的,显示文件的前 n 个字节,以及除了最后 n 个字节以外的内容也没问题了。

head

和 tail

如果组合使用:

head -n 5 /etc/passwd | tail -n 3

输出 /etc/passwd

的第三道第五行。

25

shell 学习第二十五天----神器的管道符

神器的管道符

一、 从结构化文本文件中提取数据

1.sed -e 's=/.*==' 去掉第一个 / 和后面的所有字符

jones:*:32713:899:Adrian W. Jones/OSD211/555-0123:/home/jones:/bin/ksh

输出为 jones:*:32713:899:Adrian W. Jones

| -e 's=^[:]∗:.∗ []∗=\1:\3, \2='

- ^[:]∗ 匹配用户名称字段

- :.∗ 匹配文字到空白处 () 后面有个空格)

- []∗ 匹配记录里剩下的非空白文字

输出 jones:Jones, *:32713:899:Adrian W.

sed -e 's=^[:]∗:[^/]*/[/]∗.*$=\1:\2=' passwd1

得到 jones:OSD211

sed -e 's=^[:]∗:[^/]*/[/]∗.*$=\1:\2=' passwd1

得到 jones:OSD211

二、 字解谜

cat file | tr A-Z a-z | tr -c a-z\''\n' | sort -u

- tr A-Z a-z

转换成小写 - tr -c a-z\''\n'

- sort -u

去除重复的

三、 标签列表

- sed -e 's#systemitem *role="url"#URL#g'

- tr '(){}[]' '\n\n\n\n\n\n\n'

26

shell 学习第二十六天----变量与算数

变量与算数

shell 脚本与函数还有位置参数的功能;传统的说法应该是“命令行参数”;

shell 为内嵌算数提供了一种标记法,称为算数展开。shell 回对 $((...))

里的算符表达式进行计算,再将计算后的结构放回到命令的文本内。

有两个相似的命令提供变量的管理,一个是 readonly,它可以使变量称为只读模式;而赋值给它们是被禁止的。在 shell 程序中,这是创建符号常量的一个好方法:

days_per_week=7 赋值

readonly days_per_week 设为只读模式

export,readonly

语法:

export name[=word]...

export -p

readonly name[=word]...

readonly =p

用途:

export 用于修改或打印环境变量,readonly 则使得变量不得修改。

主要选项:

- -p

: 打印命令的名称以及所有被到处 (只读) 变量的名称与值,这种方式可使得 shell 重新读取输出以便重新建立环境 (只读设置)。

使用 -p

选项,这两条命令都会分别打印他们的名称以及被到处的或只读的所有变量。

较常见的命令是 export,用法是将变量放进环境变量里。环境是一个名称与值的简单列表,可供所有执行中的程序使用。新的进程会从父进程继承环境,也可以在建立新的紫禁城之前修改它。export 命令可将新变量添加到环境中:

PATH=$PATH:/usr/local/bin 更新 PATH

export PATH 导出它

使用 export -p

命令可以显示当前环境

变量可以添加到程序环境中,但是对 shell 或接下来的命令不会一直有效: 将该变量赋值,置于命令名称与参数前即可:

PATH=/bin:/usr/bin awk '...' file1 file2

这个 PATH 值只对后面 awk 起作用,其他命令将使用系统 PATH。使用 env

命令显示所有环境变量。unset 命令从执行中的 shell 中删除变量与函数。

案例:

清除环境变量的值使用 unset

命令。如果未定义指定值,则该变量值将被设为 NULL。

首先使用命令 export TEST="test"

来增加一个环境变量

接着使用命令 env | grep TEST

,得到结果 TEST=test

然后使用命令 unset $TEST

删除环境变量 TEST

最后使用命令 env | grep TEST

命令,该命令不会有输出,说明成功的删除了。

其中 unset 还可以通过添加 -f 选项删除指定的函数。

unset 的行为模式

如果没有提供选项,则参数将视为变量名称,并告知变量已删除,如果使用 -f

选项,参数则被视为函数名称,并删除函数。

注意:myvar=

赋值并不会将 myvar

删除,只不过试讲其设为 null 字符串。相对的:unset myvar 则会完全删除它。这一差异在于”是变量设置” 以为”是变量设置,但非 null” 展开。

参数展开

var ="hello,world"

echo ${var}

hello,world

其实这里说的参数 (parameter) 不就是我们通常说的变量 (variable) 么? 嗯。。其实大部分时候这俩名词的意思基本等同。只不过在 Shell 中 parameter(参数) 是 variable(变量) 的超集: 变量名不能以数字开头,而参数名可以。比如说 $1

就表示命令行传入的第一个参数。参数展开是 shell 提供变量值在程序中使用的过程: 例如,作为新变量的值,或是作为命令行的部分或全部参数。最简单的形式如下所示:

reminder ="Time to go to the dentist" 将值存储在 reminder 中

sleep 120 等待两分钟

echo $reminder 显示信息

在 shell 下,有更复杂的形式可用于更特殊的情况。这些形式都是将变量名称括在花括号里 (${variable}

),然后再增加额外的语法以告诉 shell 该做些什么。花括号本身也是很好用的,当你需要在变量名称之后马上跟着一个可能会解释为名称一部分的字符时,他就派上用场了:

reminder ="Time to go to the dentist" 将值存储在 reminder 中

sleep 120 等待两分钟

echo ${reminder} 显示信息

警告: 默认情况下,未定义的变量会展开为 null(空的) 字符串。程序随便乱写,就可能会导致灾难发生

rm -rf /$MYPROGRAM 如果未设置 MYPROGRAM,就会有大灾难发生了,所以在写 程序时一定要小心。

展开运算符

第一组字符串处理运算符用来测试变量的存在状态,且为在某种情况下的允许默认值的替换。

替换运算符

运算符

替换

${varname:=word}

如果 varname 存在且不是 null,则返回它的值;否则,设置它为 word,并返回其值

用途: 如果变量未定义,则返回默认值。

范例: 如果 count 未定义,则 echo ${count:-0} 的值为 0

${varname:word}

如果 varname 存在且不是 null,则返回它的值;否则,设置它为 word,并返回其值。

用途: 如果变量未定义,则设置变量为默认值。

范例: 如果 count 未定义,echo${count:=0} 输出为 0

${varname:?message}

如果 varname 存在且非 null,则返回它的值;否则,显示 varname:message,并退出当前的命令或脚本。省略 message 会出现默认信息 parameter null or not set。注意,在交互式 shell 下不需要退出 (在不同的 shell 间会有不同的行为,用户需自行注意)。

用途: 为了捕捉由于变量未定义所导致的错误。

范例:${count:?"undefined"} 将显示:count:undefined!,且如果 count 未定义,则退出

${varname:+word}

如果 varname 存在且非 null,则返回 word;否则,返回 null。

用途: 未测试变量的存在。

如果: 如果 count 已定义,则 ${count:+1} 返回 1(也就是真)

该表中每个运算符内的冒号 (:) 都是可选的。如果省略冒号,则将每个定义的“存在且非 null” 部分改为“存在”,也就是说,运算符仅用于测试变量是否存在。

模式匹配运算符

运算符

替换

例:${path#/*/}

结果:tolstoy/mem/long.file.name

例:${variable##pattern}

如果模式匹配于变量值的开头处,则删除匹配的最长部分,并返回剩下的部分。

例:${path##/*/}

结果:long.file.name

例:${path%.*}

结果:/home/tolstoy/mem/long.file

例:${variable%pattern}

如果模式匹配于变量值的结尾处,则删除匹配的最短部分,并返回剩下的部分。

例:${variable%%pattern}

如果模式匹配于变量值的结尾处,则删除匹配的最长部分,并返回省下的部分

例:${path%%.*}

结果:/home/tolstoy/mem/long

案例分析:${parameter#word}

或 {parameter##word}

作用: 从 parameter 头部开始匹配 word,并删除成功匹配的部分。在构造 word 时可以使用 “*” 表示任意长度的字符,“?” 表示单位长度字符,并可用形如 “[a-c]” 的方式制定匹配 “abc” 中的任意字符。

另外,“#” 和 “##” 的区别在于前置是匹配最短,而后者是最长匹配;实际上就是正则表达式中的 “懒惰” 和 “贪婪” 的概念。

var=br1br2ead

echo ${var$$*br}

输出:2ead

echo ${var#*br}

输出:1br2ead

案例:

${parameter%word}

或 ${parameter%%word}

作用: 与前例相似,唯一不同的是从 $parameter 的为不开始匹配。

var="La.Maison.en.Petits.Cubes.avi"

echo ${var%.*}

输出:La.Maison.en.Petits.Cubes

echo ${var%%.*}

输出:La

分析: 匹配案例中的”.” 时,shell 会从 $var

的尾部开始查找 “.”,如果是最短匹配 (echo ${var%.*}

),则会找到第一个”.” 就停止,否则 (echo ${var%%.*}

) 会一直找到最后一个 “.” 才停止。可以看到,这种用法可以分方便的去掉文件后缀,从而得到文件名。

使用 ${#variable}

可以获得 variable 的长度:

案例:variable=qwertyuiop;

echo ${#variable}

输出:10

记忆:

# 匹配的是前面,因为数字正负号总是置于数字之前;% 匹配的是后面,因为百分比符号总是更在数字的后面。这里用到了两种匹配模式://,匹配任何位于两个斜杠之间的元素;.,匹配点号之后接着的任何元素。

位置参数

所谓的位置参数,指的是 shell 脚本的命令行参数;同时也表示 zaishell 函数内的函数参数,他们的名称是以单个的整数来命名。当整数大于 9 时,就应该以花括号括起来:

echo frist arg is $1

echo tenth arg is ${10}

也可以将其与模式匹配运算符结合,应用到位置参数:

filename=${1:-/dev/tty}

如果给定参数则使用它,如无参数则使用 /dev/tty

接下来的特殊 “变量” 提供了对传递的参数的总数的访问,以及一次对所有参数的访问:

- $# : 提供传递到 shell 脚本或函数的参数总是。当你是为了处理选项和参数而建立循环时,它会很有用。

举例:

while [$# !=0] 以 shift 逐渐减少 $#,循环将会终止

do

case $1 in

... 处理第一个参数

esac

shift 已开第一个参数

done

- $*,$@ : 以此表示所有的命令行参数。着两个参数可用来把命令行参数传递给脚本或函数所执行的程序。

- “$*” : 将所有命令行参数视为单个字符串。等同于 “$1 $2 ...” $IFS 的第一个字符用来作为分隔符,衣服个不同的值来建立字符串。

案例:

printf ”他和 arguments were %s\n” ”$*”

- “$@” : 将所有的命令韩参数视为单独的而个体,就业就单独字符串。等同于 “$1” “$2” .... 这是将参数传递给其他程序的最佳凡是,因为他会保留所有的内嵌在每个参数里的任何空白。

案例:

lpr “$@” 现实每一个文件 shift 命令是用来” 截去” 来自列表的位置参数,由左开始。一旦执行 shift,$1 的初值会永远消失,取而代之的是 $2 的旧值。$2 的值变成 $3 的旧值,依次类推。$#的值会逐次减一。shift 也可使用一个可选的参数,也就是要位移的参数的计数。单纯的 shift 等同于 shift 1。

案例:

set -- hello “hi there” greetings 结束选项部分,自 hello 开始新的参数 echo $# 显示计数值

for i in $* 循环处理每一个参数

\> do echo i is $i

\> done

输出:

i is hello i is hi i is there i is greeting

注意,内嵌的空白已消失

使用命令:for i in $@

在没有双引号的额情况下,$@和 $* 得到的结果一样

\> do echo i is $i

\> done

加了双引号 for i in ”$*” $*

表示一个字符串

\> do echo i in $i

\> done

输出:

i in hello hi there greeting

加了双引号 for i in “$@”

$@保留真正的参数值

输出:

i in hello

i in hi there

i in greeting

使用命令 shift

截去第一个参数

echo there are now $# arguments

输出:there are now 2arguments 证明第一个参数已经消失

使用命令:

for i in ”$@”

输出为:

i in hi there

i in greeting

特殊变量

POSIX 中的内置变量

变量

意义

\#

表示变量的个数,常用于循环

@

当前命令行所有参数,置于双引号中,表示个别命令

*

当前命令行所有参数。置于双引号中,表示将命令行所有参数当做一个单独参数

-(连字号)

在引用数给予 shell 的选项

?

表示上一个命令退出的状态

$

表示当前进程编号

0

表示当前进程名称

!

表示最近一个后台命令的进程编号

HOME

表示当前用户的根目录

IFS

表示内部的字符分隔符

LANG

当前 locale 默认名称

PATH

环境变量

PPID

父进程编号

PWD

当前工作目录

特殊变量 $$ 可在编写脚本时用来建立具有唯一性的文件名 (多半是临时的),这是根据 shell 的进程编号建立文件名。不过系统中还有一个 mktemp 也能做同样的事情。

算数展开

shell 的算数运算符与 C 语言里的差不多,优先级与顺序也相同。

运算符

意义

顺序

++ --

增加以减少,可前置也可放在结尾

由左至右

+ - ! ~

一元的正好与符号;逻辑与位的取反

由右至左

* / %

乘 除 取余

由左至右

+ -

加 减

由左至右

<<>>

向左位移,向右位移

由左至右

<<=> >=

比较

由左至右

== !=

相等不相等

由左至右

&

位的 AND

由左至右

^

韦德 Exclusive OR

由左至右

|

位的 OR

由左至右

&&

逻辑的 AND

由左至右

||

逻辑的 OR

由左至右

?:

条件表达式

由右至左

= += -= *= /=&= ^= <<=>>= |=

赋值运算符

由右至左

该表的运算符的优先级由高排列至最低。可利用圆括号将子表达式语句括起来。像 C 一样:关系运算符 (<,<=,>,>=,== 与!=) 产生数字结果中,1 为真,0 为假。

例如:

$((3>2))

的值为 1;echo $(((3>2)||(4<=1)))

也为 1,因为着两个子表达式里有一个为真。 对逻辑的 AND 与 OR 运算符而言,任何非 0 值函数都为真:echo $((3&&4))

3 与 4 都为 “真” ++ 和 -- 运算符不用说了。++ 与 -- 运算符是可选的;实际上,所有支持 ${{...}}

的 shell,都可以让用户在提供变量名称时,无须前置 $ 符号。

27

shell 学习第二十七天----退出状态和 if 语句

退出状态

每一条命令;不管是内置的,shell 函数,还是外部的,当它退出时,都会返回一个小的整数值给引用它的程序,这就是大家所熟知的程序的退出状态。在 shell 下执行进程是,有很多方式可取用程序的退出状态。

以管理来说,退出状态为 0 表示 “成功”,也就是,程序执行完成且为遭遇到任何问题。其他任何的退出退出状态都为失败。内置变量?(使用命令 echo $?

) 查看上一条命令的退出状态。

案例:当你输入 ls -l /dev/null

时。

输出:crw-rw-rw- 1 root root 1,3 6 月 25 15:41 /dev/null

接着使用命令:echo $?

输出为 0

接着使用命令:ls foo

输出:ls:无法访问 foo:没有那个文件或目录

echo $?

输出:2

表示没有成功的执行。

POSIX 的结束状态

值

意义

0

命令成功地退出

\>0

在重定向或单词展开期间 (~,变量,命令,算数展开,以及单词切割) 失败

1-125

命令不成功的退出。特定的退出值的含义,是由各个单独的命令定义的。

126

命令找到了,但文件无法执行

127

命令没找到

\>128

命令因受到信号而死亡

POSIX 留下退出状态 128 未定义,仅要求他表示某种失败。因为只有低位的 8 个位会返回给父进程,所以大于 255 的退出状态都会替换成该值除以 256 之后的余数。

在 shell 脚本可以使用 exit 命令传递一个退出之给踏的调用者。只要将一个数字传递给它,作为一个参数即可。脚本会立即退出,并且调用者会受到该数字且作为脚本的退出值。

说白了 exit 就是退出当前的 shell,在 shell 脚本中可以终止当前脚本执行。

exit

语法:

exit [exit-value]

用途: 目的是从 shell 脚本返回一个退出状态给脚本的调用者。

主要选项:

无

行为模式: 如果没有提供,则以最后一个执行命令的退出状态作为默认的退出状态。如果这就是你要的,则最好明白的在 shell 脚本里这么写:exit $?

案例一:exit

输出为 logout,表示退出当前 shell

案例二:脚本代码 cd $(dirname $0) || exit 1

进入脚本所在目录,否则退出

案例三:脚本中判断参数数量,不匹配就打印使用方式,退出

代码:

if ["$#" -ne "2"]; then

echo "usage:$0 <area> <hours>"

exit 2

fi

案例四:在脚本里,退出时删除临时文件

代码:trap “入门 -rf tempfile;echo Bye.” exit

案例五:检查上一行的退出码 代码:

EXCODE=$?

if ["$EXCODE" == "0"]; then

echo "O.K"

fi

if-elif-else-fi 语句

if 语法:

- 单分支的 if 语句 if 条件测试命令 then 命令序列 fi

- 双分支的 if 语句 if 条件测试命令 then 命令序列 1 else 命令序列 2 fi

- 多分支的 if 语句 (elif 可以嵌套多个,一般多了用 case 表达) if 条件测试命令 1 then 命令序列 1 elif 条件测试命令 2 then 命令序列 2 ......... else 命令序列 n fi

if pipeline

[pipeline...]

then

statement-if-true-1

elif pipeline

[pipeline...]

then

statement-iftrue2

else

statement-if-all-else-fails

if

使用方括号作为开始与结束的关键字将语句组织起来。

案例 1:提示用户指定备份目录的路径,若目录存在则显示信息跳过,否则显示相应提示信息,并创建该目录。 bash 代码:

\#!/bin/bash

read -p "what is your backup directoy :" BakDir

if [-d $BakDir];then

echo "$BakDir alerdy exist"

else

echo "$BakDir is not exist,will make it"

mkdir $BakDir

fi

案例 2:统计当前登录到系统中的用户数量,若判断是否超过三个,若是则显示实际数量并给出警告信息,否则列出登录的用户账户名称及所在终端

bash 代码:

UserNum='who | wc -l'

if [$UserNum -gt 3];

then

echo "Alert, too many login users (Total:$UserNum)."

else

echo "Login Users:"

who | awk '{print $1,$2}'

fi

注意:

- if 与 [ 之间必须有空格

- [ ] 与判断条件之间也必须有空格

- ] 与; 之间不能有空格

逻辑的 not,and 与 or

“如果 john 不在家,则...” ,在 shell 下这种情况的做法是: 将惊叹号放在管道前:

if ! grep pattern myfile > /dev/null

then

模式不在这里

fi

“如果 john 在家,且他不忙,则....”,使用逻辑 and。

if grep pattern1 myfile && grep pattern2 myfile

then

myfile 包含两种模式

fi

相对的,|| 运算符则用来测试两个条件中是否有一个为真。:

if grep pattern1 myfile || grep pattern2 myfile

then

myfile 包含两种模式之一

fi

逻辑 and 和 or 都是快捷运算符,即当判断出整个语句块的真伪时,shell 会立即停止执行命令。举例来说,在 command1&&command2

下,如果 aommand1

失败,则整个结果不可能为真,所以 command2 也不会被执行;以此类推,command1||command2

指的是: 如果 command1

成功,那么也没有理由执行 command2

。

不要尝试过度” 简练” 未使用 && 和 || 来取代 if 语句。我们不反对简短且简单的事情,例如:

命令:who | grep root > /dev/null && echo root is login on root is login on

输出:root is login on

分析:上面的命令实际做法是: 执行 who | grep...

且如果成功,就显示信息。而我们曾见过厂商提供 shell 脚本,所使用的是这样的结构:

some_command &&{

one command

a decond command

and a third command

}

这个命令的意思是说将所有的语句块放在一块,只有在 some_command

成功时他们才被执行。使用 if 可以让他更简洁:

if some_command

then

one command

a second command

and a third command

fi

最后在判断语句中常用的运算符:

1、字符串判断

str1 = str2 当两个串有相同内容、长度时为真

str1 != str2 当串 str1 和 str2 不等时为真

-n str1 当串的长度大于 0 时为真 (串非空)

-z str1 当串的长度为 0 时为真 (空串)

str1 当串 str1 为非空时为真

2、数字的判断

int1 -eq int2 两数相等为真

int1 -ne int2 两数不等为真

int1 -gt int2int1 大于 int2 为真

int1 -ge int2int1 大于等于 int2 为真

int1 -lt int2int1 小于 int2 为真

int1 -le int2int1 小于等于 int2 为真

3、文件的判断

-r file 用户可读为真

-w file 用户可写为真

-x file 用户可执行为真

-f file 文件为正规文件为真

-d file 文件为目录为真

-c file 文件为字符特殊文件为真

-b file 文件为块特殊文件为真

-s file 文件大小非 0 时为真

-t file 当文件描述符 (默认为 1) 指定的设备为终端时为真

4、复杂逻辑判断

-a 与

-o 或

! 非

test 命令

test 命令可以处理 shell 脚本里的各类工作。它产生的不是一般输出,而是可使用的退出状态。test 接受各种不同的参数,可控制它要执行哪一种测试。

test 命令有另一种形式:[...],这种永福的作用完全与 test 命令一样。因此,下面这两个案例表达的意思相同

if test "$str1"="$str2"

then

...

fi

和

if ["$str1" = "$str2" ]

then

...

fi

一样

test 的语法:

test [expression] [[expression] ]

用途:

为了测试 shell 脚本里的条件,通过退出状态返回其结果。要特别注意的是:这个命令的第二种形式,方括号根据字面意义逐字的输入,且必须与括起来的 expression 以空白隔开。

主要选项: 和使用用于 if 的选项一致。 其中

选项

含义

string

如果... 则为真

-b file

file 是块设备文件

-d file

file 是目录

-c file

file 是字符设备文件

-e file

file 存在

-f file

file 为一般文件

-g file

file 有设置他的 setgid 位

-h file

file 是一符号链接

-L file

file 是一符号链接 (等同于 -h)

-n string

string 是非 null

-p file

file 是一命名的管道 (FIGO 文件)

-r file

file 是可读的

-S file

file 是 socket

-s file

file 不是空的

-t n

文件描述符 n 指向一终端

-u file

file 有设置它的 setuid 位

-w file

file 是可写入的

-x file

file 是可执行的,或 file 是可被查找的目录

-z string

string 为 null

s1=s2 或者 s1!=s2

字符串相不相等

n1 -eq n2

整数 n1 等于 n2

n1 -ne n2

整数 n1 不等于 n2

n1 -lt n2

n1 小于 n2

n1 -gt n2

n1 大于 n2

n1 -le n2

n1 小于或等于 n2

n1 -ge n2

n1 大于或等于 n2

案例:

bash 代码:

\#!/bin/bash

cd /bin

if test -e ./bash // 其实这里相当于 if [-e ./bahs]

then

echo 'the file already exist!'

else

echo 'the file not exist!'

fi

输出结果为:the file already exist!

另外,shell 还提供了 -a

(逻辑 AND),-o

(逻辑 OR),-a

的优先级高于 -o

,而 = 与!= 优先级则高于其他的二元运算符。

注意:在使用 -a

和 -o

(这两个事 test 运算符) 与 &&

和 ||

(这两个事 shell 运算符) 之间有一个差异:

- if [-n "$str" -a -f "$file" ]

一个 test 命令,两种条件 - if [-n "str"] && [-f "$file" ]

两个命令,一块接方式计算 - if [-n "$str" && -f "$file"]

语法错误

第一个案例,test 会计算两种条件。而第二个案例,shell 执行第一个 test 命令,且只有在第一个命令是成功的情况下,才会执行第二个命令。最后一个案例,&&

为 shell 运算符,所以它会终止第一个 test 命令,然后这个命令会抱怨它找不到结束的] 字符,且以失败的值退出。即使 test 可以成功的退出,接下来的检查还会失败,因为 shell(最有可能) 找不到一个名为 -f

的命令

精简表达式:

使用命令:[1 eq1] &&echo'OK'

输出:ok

使用命令:[2 < 1] &&echo 'OK'

输出:-bash:1:No such file or directory

使用命令:[2 \< 1] &&echo 'OK'

这样就可以了

使用命令:[2 -gt 1 -a 3 -lt 4]&&echo 'Ok'

输出:Ok

使用命令:[2 -gt 1 && 3 -lt 4]&&echo 'Ok'

输出:-bash:[:missing `]'

注意:在 []

表达式中,常见的 >

,<

需要加转义字符,表示字符串大小比较,以 acill 码位置作为比较。不直接支持 <>

运算符,还有逻辑运算符 ||

和 &&

它需要用 -a[and] –o[or]

表示。

刚才使用的 []

,现在再来看使用 [[]]

案例:

使用命令:[[2 < 3]]&&echo 'OK'

输出 OK。

使用命令:[[2 < 3 && 4 < 5]] && echo 'ok'

输出:ok

注意:[[]]

运算符只是 []

运算符的扩充。能够支持 <

,>

符号运算不需要转义符,它还是以字符串比较大小。里面支持逻辑运算符 ||

和 &&

。 bash 的条件表达式中有三个几乎等效的符号和命令:test

,[]

和 [[]]

。通常,大家习惯用 if []

;then

这样的形式。而 [[]]

的出现,根据 ABS 所说,是为了兼容 ><

之类的运算符。

不考虑对低版本 bash 和对 sh 的兼容的情况下,用 [[]]

是兼容性强,而且性能比较快,在做条件运算时候,可以使用该运算符。

28

shell 学习第二十八天----case 语句

case 语句

case $1 in

-f)

... 针对 -f 玄子昂的程序代码

;;

-d | --directory) #允许长选项

... 针对 -d 选项的程序代码

;;

*)

echo $1:unkonw option >$2

exit 1

、#在 esac 之前的;; 形式是一个好习惯, 不过并非必要

esac

这里我们看到,要测试的值出现在 case 和 in 之间。将值以双引号括起来并非必要,但也无妨。要测试的值,根据 shell 模式的列别一次测试,返现匹配的时候,便执行相对应的程序代码,直至;;

为止。可以使用多个模式,只要|字符加以分割即可。这种情况称为 “or(或)”。模式里会包含任何的 shell 统配字符,且变量,命令与算数替换会在它用作模式匹配之前在此值上被终止。

可能会觉得每个模式列表之后的部队称的右圆括号有点奇怪,不过这也是 shell 于艳丽部队称定界符的位移实例。

最后的 * 模式视窗通用发,但是非必须的,他作为一个默认的情况。这通常实在你要现实诊断信息并退出时使用。最后一个情况不再需要结尾的 ;;

,不过加上他,会是比较好的形式

案例一:提示输入 1 到 4,与每一种模式进行匹配

bash 代码:

echo 'input your a number 1 to4'

echo 'your number is : \n'

read aNum

case $aNum in

1)echo 'number 1'

;;

2)echo 'number 2'

;;

3)echo 'number 3'

;;

4)echo 'number 4'

;;

*)echo 'number default'

;;

esac

案例二:判断输入文件是文件还是目录

option="${1}"

case ${option} in

-f) file="${2}"

echo "file name is $file"

;;

-d) dir="${2}"

echo "dir name is $dir"

;;

*)echo "basename ${0} :usage:[-f file]| [-d directory]"

exit 1

;;

esac

案例三:

bash 代码:

\#!/bin/bash

name='basename $0.sh'

case $1 in

s|start) echo "start..."

;;

stop) echo "stop ..."

;;

reload)echo "reload..."

;;

*)echo "Usage: $name [start|stop|reload]"

exit 1

;;

esac

注意:

- *)

相当于其他语言中的 default。 - 除了 *)

模式,各个分支中;;是必须的,;;相当于其他语言中的 break - |

分割多个模式,相当于 or

复习一下变量说明:

变量

作用

$$

shell 本身的 PID(ProcessID)

$!

sehll 最后运行运行的后台 Process 的 PID

$?

最后运行的命令的结束代码 (返回值)

$-

使用 set 命令设定的 Flag 一览

$*

所有参数列表. 如”$*” 用圆括号括起来, 以”$1 $2 ...$n” 的行为输出所有参数

$@

所有参数列表, 如果”$@” 用圆括号括起来, 以”$1” “$2” “$n” 的形式输出所有参数

$#

添加到 shell 的参数个数

$0

shell 本身的文件名

$1~$n

添加到 sehll 的各参数值.$1 是第一个参数,$2 是第二个参数, 以此类推

案例:

printf "The complete list is %s\n" "$$"

结果:The complete list is 1567

29

shell 学习第二十九天----循环

循环

bash shell 中主要提供了三种循环:for,while,until

for 循环

for 循环的运作方式是将串行的元素取出, 依次放入指定的变量中, 然后重复执行在 do 和 done 之间的命令, 知道所有元素取尽为止.其中, 串行是一些字符串的组合, 彼此使用 $IFS 所定义的分隔符 (如空格符) 隔开, 这些字符串成为为字段.

语法:

for 变量 in 串行 // 将串行中的字段迭代放入变量中

do

执行命令 // 重复执行, 知道串行中的每一个字段处理过为止.

done

案例:用 for 循环在 tmp 目录下创建 aaa1-aaa10,然后在 aaa1-aaa10 创建 bbb1-bbb10 的目录

\#!/bin/bash

mkdir hahaha

for k in $(seq 1 10)

do

mkdir /tmp/hahaha/aaa${k}

cd /tmp/hahaha/aaa${k}

for j in $(seq 1 10)

do

mkdir bbb${j}

cd /tmp/hahaha/aaa${k}

done

cd ..

done

说明:

- 行 3,seq 用于产生从某个数到另外一个数之间的所有整数。

- 行 5,在 tmp 目录下创建文件夹。

- 行 7,在使用一个 for 循环创建文件夹

案例二:列出 var 目录下各子目录占用磁盘空间的大小。

\#!/bin/bash

dir="/var"

cd $dir

for k in $(ls $dir)

do

if [-d $k]

then

du -sh $k

fi

done

说明:

- 行 4,对 /var 目录中每一个文件,进行 for 循环处理。

- 行 6,如果 /var 下的文件是目录,则使用 du -sh 计算该目录占用磁盘空间的大小。

while 循环

语法:

while 条件测试

do

执行命令

done

说明:

- 行 1 , 首先进行条件测试, 如果传回值为 0(条件测试为真), 则进入循环, 执行命令区域, 否则不进入循环

- 行 3, 执行命令区域, 这些命令中, 应该要有改变天剑测试的命令, 这样, 才有机会在有限步骤后结束之星 while 循环.

- 行 4, 回到行 1, 执行 while 命令.

案例:求 1 到 100 的和

\#!/bin/bash

sum=0

i=1

while ["$i" -le "100"]

do

sum=$(($sum+$i))

i=$(($i+1))

done

echo "sum(1-100):" $sum

until 循环

语法:

until 条件测试

do

执行命令

done

说明:

- 行 1, 如果条件测试结果为假 (传回值不为 0), 则进入循环

- 行 3, 执行命令区域. 这些命令中, 应该有改变条件测试的内容, 这样才不会出现死循环.

- 行 4, 会到行 1, 执行 until 命令

案例:计算 1-100 的和

\#!/bin/bash

sum=0

i=1

until ((i>100))

do

sum=$(($sum+$i))

i=$(($i+1))

done

echo $sum

分析:只要条件测试未超过 100,就进入循环,其他的和 while 类似。

其实 for 循环还有一种方式:

for((初始值; 条件; 执行步长))

do 程序段

done

注意细节:for((初始值; 条件; 执行步长)) 里面的预压和 c 语言一样了,但是一点不同双括号。

for 循环案例:列出指定目录下的所有文件

\#!bin/bash

read -p "Please enter the dir name:" dirname

for file in $(ls $dirname)

do

echo $file

done

复习一下 seq 命令

seq 选项 参数

主要选项:

- -s

指定分隔符,默认是换行 - -w

等位补全,就是宽度相等,不足的前面补 0 - -f

格式化输出,就是指定打印的格式

案例:

使用命令:seq 2

输出:

1

2

使用: seq -s “--” 2

输出 :1--2

案例:

[root@localhost tmp]# seq -f %05g 1 10

00001

00002

00003

00004

00005

00006

00007

00008

00009

00010

30

shell 学习第三十天----break,continue,shift,getopts

break 和 continue

这两个命令分别用来退出循环,或跳到循环体的其他地方。使用 while 与 break,等待用户登录。

bash 代码:

printf “Enter username:”

read user

while true

do

if who | grep “$user” >/dev/null

then

break;

fi

sleep 30

done

等待特定用户,每 30 秒确认一次

true 命令什么事也不必做,只是成功的退出。这用于编写无限循环,即会永久的执行循环。在编写无限循环时,必须放置一个退出条件在循环体内,正如这里所作的。另有一个 false 命令和它有点相似,只是很少的用到,也不做人和事,仅表示不成功的状态.false 命令常见于无线的 until false..循环中。

continue 命令则用于提早的开始下一段重复动作,也就是在到大循环体的底部之前。

break 与 continue 命令都可以接受可选的数值参数,可分别用来之处要中断 (break) 或继续多少个被包含的循环 (如果循环技术需要的是一个在运行时可被计算的表达式时,可以使用 $((...)) )。

案例:

while condition1 // 外循环

do...

while condition2 // 内循环

do..

break; 外循环的终端

done

done

break 与 continue 特别具备终端或继续多个循环层的能力。从而以简洁的形式弥补了 shell 语言里缺乏 goto 关键字的不足。

使用 continue 的案例:

\#!/bin/bash

limit=19

echo "printing Number 1 throught 20"

a=0

while [$a -le"$limit"]

do

let a++

#let a+=1

#a=$(($a+1))

if ["$a" -eq 3] || ["$a" -eq 11]

then

continue

fi

echo -n "$a"

done

输出结果:

printing Number 1 throught 20

1 2 4 5 6 7 8 9 10 12 13 14 15 16 17 18 19 20

由此可见 continue 的作用是结束本次循环,执行下一次循环

使用 break 的案例:

\#!/bin/bash

limit=19

echo "printing Number 1 throught 20"

a=0

while [$a -le"$limit"]

do

let a++

#let a+=1

#a=$(($a+1))

if ["$a" -eq 3] || ["$a" -eq 11]

then

break

fi

echo -n "$a"

done

输出结果:

printing Number 1 throught 20

1 2

由此可见,break 的作用是退出当前循环。

shift

我们知道,对于位置变量或命令行参数,其个数必须是确定的,或者当 Shell 程序不知道其个数时,可以把所有参数一起赋值给变量 $*

。若用户要求 Shell 在不知道位置变量个数的情况下,还能逐个的把参数一一处理,也就是在 $1

后为 $2

,在 $2

后面为 $

3 等。在 shift 命令执行前变量 $1

的值在 shift 命令执行后就不可用了。

案例:

\#!/bin/bash

until [$# -eq 0]

do

echo " 第一个参数为:$1 参数个数为:$#"

shift

done

执行命令:./shift.sh 1 2 3 4

输出为:

第一个参数为:1 参数个数为:4

第一个参数为:2 参数个数为:3

第一个参数为:3 参数个数为:2

第一个参数为:4 参数个数为:1

分析:

- 从上可知 shift 命令每执行一次,变量的个数 ($#) 减一,而变量值提前一位。

- shift 可以用来向左移动位置参数。

- Shell 的名字 $0

第一个参数 $1

第二个参数 $2

第 n 个参数 $n

所有参数 $@ 或 $*

参数个数 $#

案例:

bash 代码:

until [-z"$1"] # Until all parameters used up

do

echo "$@"

shift

done

命令:./shift1.sh 1 2 3 4 5 6 7 8 9 10

输出:

1 2 3 4 5 6 7 8 9 10

2 3 4 5 6 7 8 9 10

3 4 5 6 7 8 9 10

4 5 6 7 8 9 10

5 6 7 8 9 10

6 7 8 9 10

7 8 9 10

8 9 10

9 10

10

getopts 命令

语法:

getopts option_spec variable [arguments...]

现在来看一个简单的例子:

\#!/bin/bash

echo $*

while getopts ":a:bc:" opt

do

case $opt in

a)

echo $OPTARG

echo $OPTIND

;;

b)

echo "b $OPTIND"

;;

c)

echo "c $OPTIND"

;;

?)

echo "error"

exit 1

esac

done

echo $OPTIND

shift $(($OPTIND-1))

echo $0

echo $*

如果执行命令:./getopts.sh -a 11 -b -c 6

结果为:

-a 11 -b -c 6

11

3

b 4

c 6

6

./getopts.sh

看分析:

getopts

后面的字符串就是可以使用的选项列表,每个字母代表一个选项,后面带:的意味着选项除了定义本身之外,还会带上一个参数作为选项的值,比如 a:在实际的使用中就会对应 -a 11

,选项的值就是 11;getopts

字符串中没有跟随:的是开关型选项,不需要再指定值,相当于 true/false,只要带了这个参数就是 true。如果命令行中包含了没有在 getopts

列表中的选项,会有警告信息,如果在整个 getopts 字符串前面也加上个:,就能消除警告信息了。使用 getopts

识别出各个选项之后,就可以配合 case 来进行相应的操作了。optarg

这个变变,getopts

修改了这个变量。这里变量 $optarg

存储相应选项的参数,而 $optind

总是存储原始 $*

中下一个要处理的元素 (不是参数,而是选项,此处值得的是 a,b,c 这三个选线,而不是那些数字,当然数字也是会占有位置的) 位置。

while getopts ":a:bc:" opt

# 第一个冒号表示忽略错误;字符后面的冒号表示该选项必须有自己的参数。

使用 getopts

处理参数虽然是方便,但仍然有两个小小的局限:

- 选项参数的格式必须是 -d val

,而不能是中间没有空格的 -dval

。 - 所有选项参数必须写在其它参数的前面,因为 getopts

是从命令行前面开始处理,遇到非 -

开头的参数,或者选项参数结束标记 --

就中止了,如果中间遇到非选项的命令行参数,后面的选项参数就都取不到了。 - 不支持长选项,也就是 --debug

之类的选项

案例:

\#!/bin/bash

while getopts "ab:cd:" opt

do

case $opt in

a)

echo $OPTIND

;;

b)

echo $OPTIND

echo $OPTARG

;;

c)

echo $OPTIND

;;

d)

echo $OPTIND

echo $OPTARG

esac

done

shift $(($OPTIND-1))

使用命令:./getopts1.sh -a -b foo -c -d haha

得到结果:

2

4