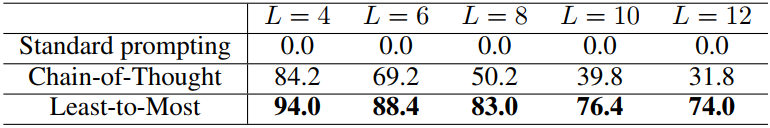

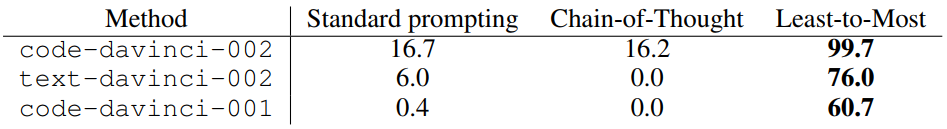

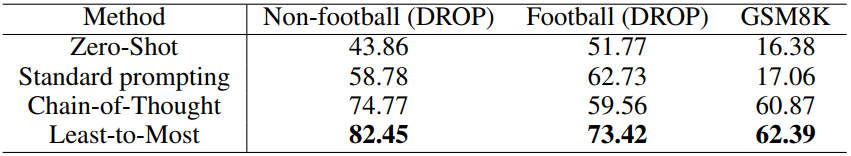

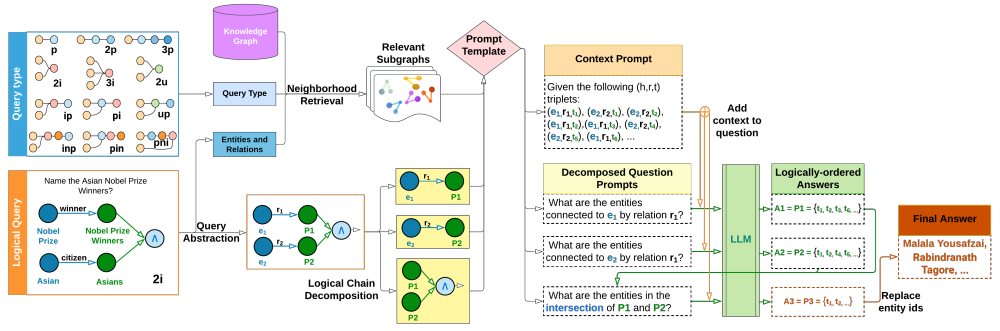

大语言模型,尤其是基于思维链提示词(Chain-of Thought Prompting)[1]的方法,在多种自然语言推理任务上取得了出色的表现,但不擅长解决比示例问题更难的推理问题上。本文首先介绍复杂推理的两个分解提示词方法,再进一步介绍将提示词方法应用于知识图谱复杂逻辑推理的工作。

让大模型学会处理更复杂的推理

本文首先提出了Least-to-Most Prompting方法的动机,是人类智慧与机器学习之间的三个差异:

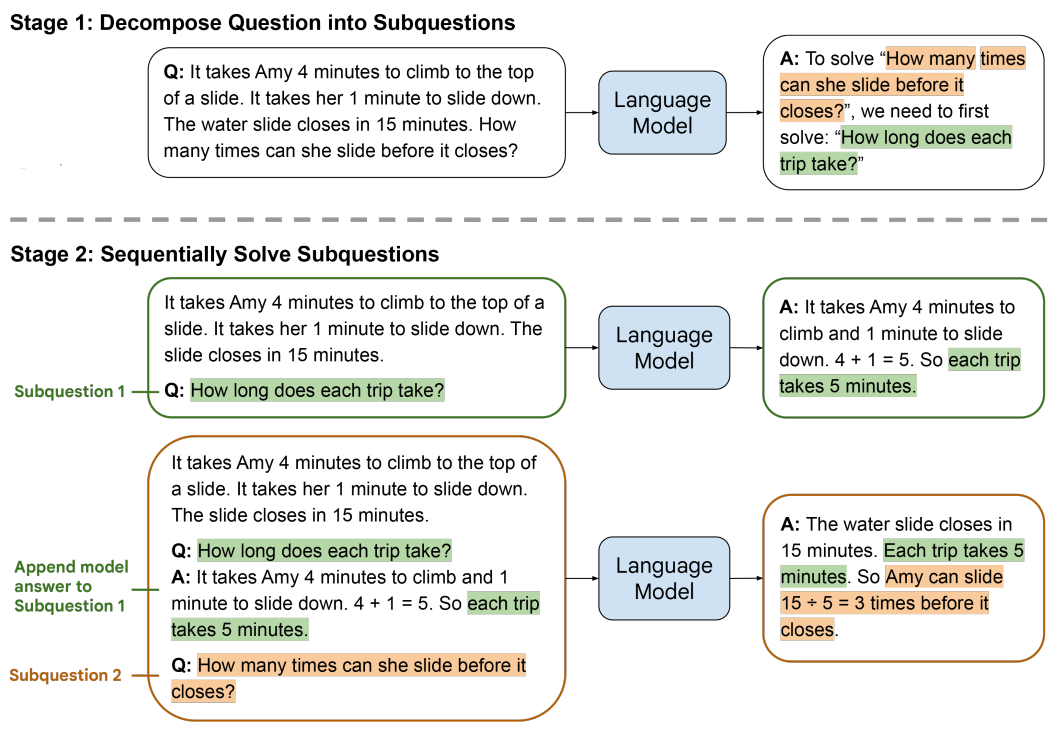

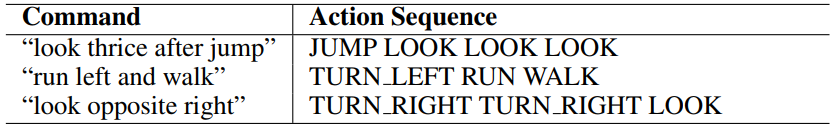

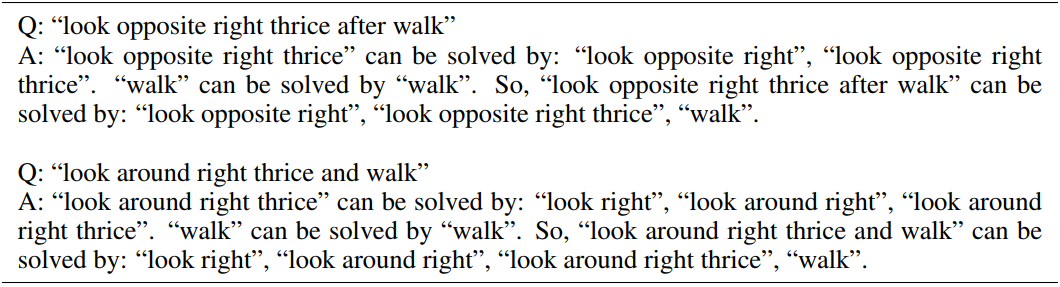

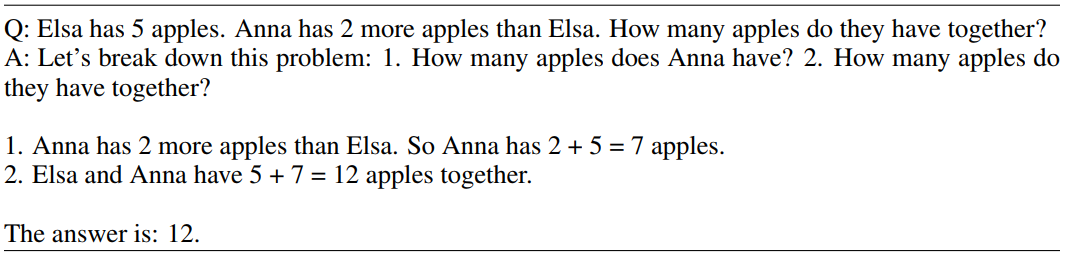

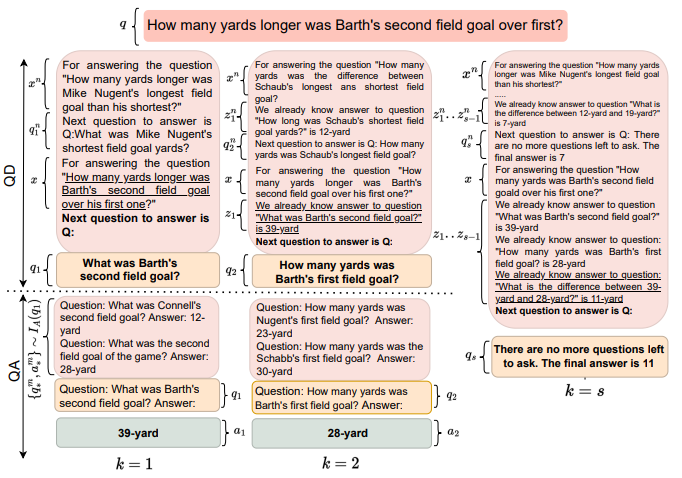

下图给出了Least-to-Most Prompting方法解决一个数学问题的示例:

(1)将复杂问题分解为简单子问题;

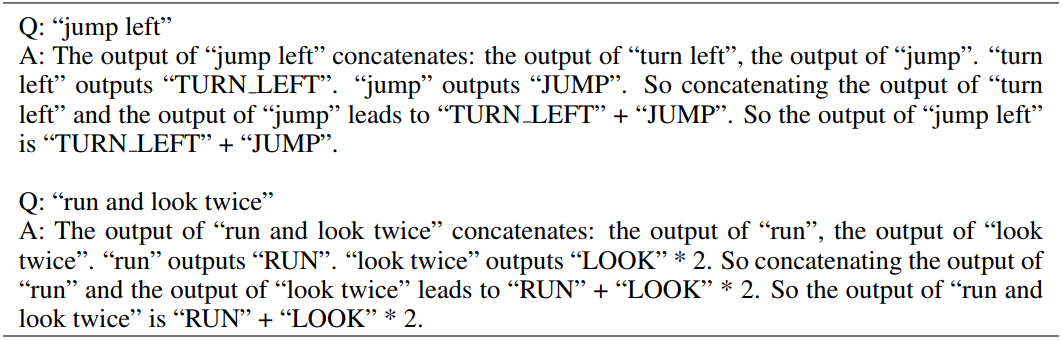

(2)按序解决子问题,其中,回答第二个子问题时使用了第一个子问题的答案。

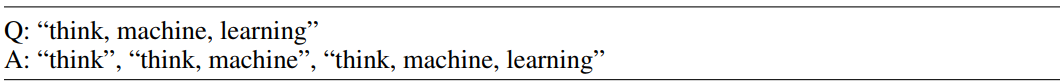

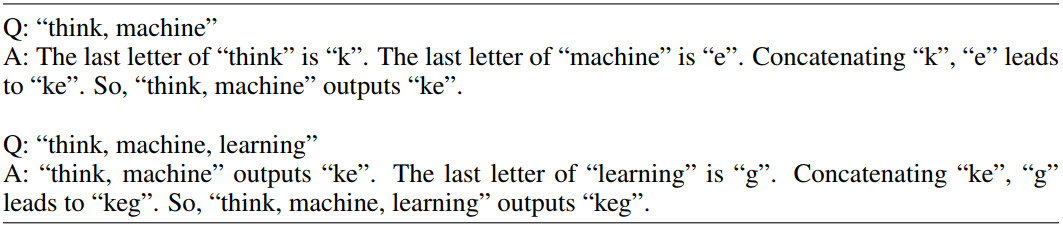

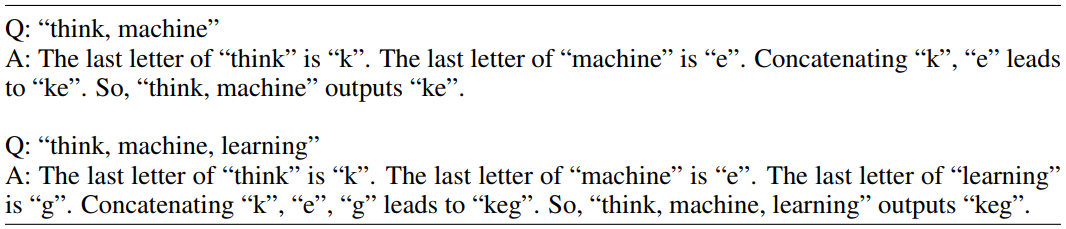

再逐步解决每个子序列最后一个字母的连接问题,并且在解决更复杂的问题时,会根据前序简单问题的答案(如已知“think, machine” outputs “ke”)得到后序问题的结果。

再逐步解决每个子序列最后一个字母的连接问题,并且在解决更复杂的问题时,会根据前序简单问题的答案(如已知“think, machine” outputs “ke”)得到后序问题的结果。

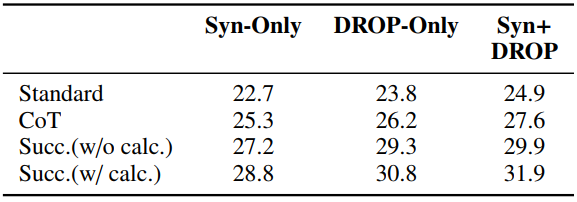

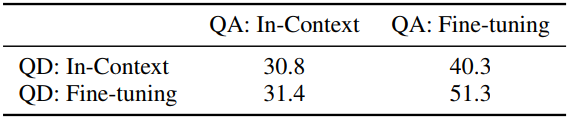

连续提示词解决复杂任务

文章转载自图谱学苑,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。