鉴于大型语言模型的训练,充斥着广泛且未经过滤的互联网信息,在教学环境中使用 AI 生成内容,其核心问题在于如何保护学生免受大型语言模型输出的潜在有害影响。

如今,借助 Azure AI Content Safety——一个用于帮助组织创建更安全在线环境的 AI 平台,南澳教育部已经完成了 AI 聊天机器人 EdChat 的试点工作。8所中学近1500名学生和150名教师测试了 EdChat 的能力,测试涵盖了从细胞分裂到约翰·斯坦贝克《人鼠之间》等各学科内容。

EdChat 内置的安全功能可以阻止不当的输入查询,并过滤有害回答。让教师不再忧心于 AI 时代的内容监管,而能够专注于技术所带来的教育优势。Chapman 表示:“若非从一开始就提供 Content Safety功能,我们将无法以如此快的速度开展工作。在使用 AOAI 时,内容安全是必不可少的。”

#1

Azure AI Content Safety

独立、定制、可集成

Azure AI Content Safety 现已在 Azure AI 平台上正式发布。它使用先进的语言和视觉模型来帮助检测不当内容,并标记“严重程度评分”。企业和组织可以根据自身策略来定制内容安全检测服务,以过滤有害响应或标记不当内容。

Azure AI Content Safety 最初作为 Azure OpenAI 服务的一部分推出,现在则发展为一个独立系统。这意味着,客户可以将其用于开源模型和其他公司模型的 AI 生成内容,并将用户生成内容作为其内容系统的一部分,大大扩展了实用性。

微软的目标是为企业提供更安全地部署 AI 所需的工具,微软人工智能平台副总裁 Eric Boyd 表示:“将 Azure AI Content Safety 作为独立产品发布,意味着我们可以为具有更广泛业务需求的众多客户提供服务。”

Azure AI Content Safety 是微软将其负责任地创建 AI 的原则付诸实践的一个示例。在微软,有近350名员工致力于负责任的 AI。过去的几年里,微软一直倡导负责任的 AI 治理,支持负责任的 AI 产品开发,发布了用于设计、构建和测试 AI 系统的负责任 AI 标准;并将诸如 Azure Machine Learning 的负责任 AI 仪表板等工具交付给用户使用。

内容安全,并非事后的补救,而是微软 AI 创新叙事的重要组成部分。Azure AI Content Safety 是微软向更多用户交付 AI 应用程序的基础。

—— Sarah Bird

微软合作伙伴集团产品经理

#2

各行各业

定制自己的 Content Safety

在微软内部,Azure AI Content Safety 正在保护微软自有的 AI 驱动的产品。Bird 表示,对于诸如 Bing、GitHub Copilot、Microsoft 365 Copilot 和 Azure Machine Learning 等基于 Chat 的产品创新,Azure AI Content Safety 至关重要。

Bird 还指出,在内容领域,负责任的 AI 问题涉足各个企业和行业。这就是为什么 Azure AI Content Safety 的一个关键优势在于可配置性,可根据每个客户的具体环境和用例定制策略。例如,一个游戏平台和一个课堂教育平台,可能会对暴力语言等内容设定不同的标准。

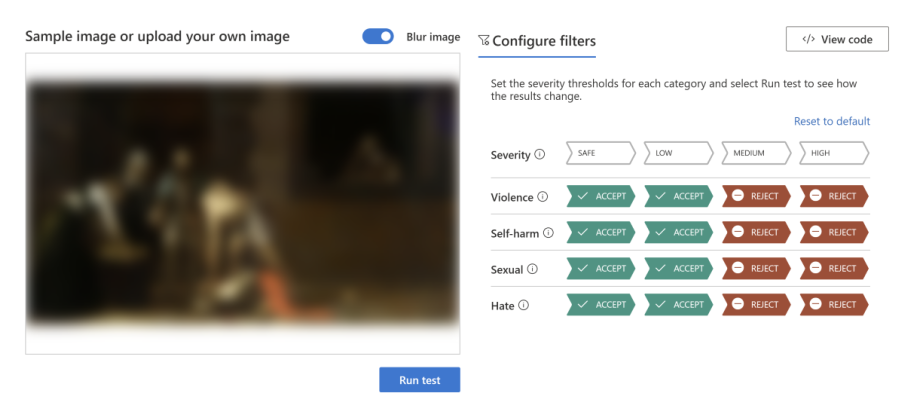

■ 借助 Azure AI Content Safety 的图像审核工具,客户可以轻松运行图像检测,以确保其符合内容标准。

能源公司壳牌开发了 Shell E,该 AI 平台基于开源和其他大型语言模型构建和部署应用程序,使员工能够提问和检索信息,更高效地访问和使用公司知识库,包括草拟、总结和翻译内容;代码生成和测试;以及跨技术领域的知识管理。壳牌团队还在探索更复杂的用例,如分子生成。

Azure AI Content Safety 在 Shell E 平台治理中发挥了关键作用,它支持文本和图像检测,同时能够限制有害内容的输出。壳牌 AI 系统高级技术经理 Siva Chamarti 表示:“我们现在还处于 AI 应用的早期阶段,但同事们正在围绕自己的业务创想 AI 的更多创造性用途,可以想见,我们积累的用例会越来越多。”

为了在新一代人工智能时代保持领先,Bird 表示,微软将基于研究和客户反馈不断改进 Content Safety 技术。例如,目前正在进行的多模态模型将加强对图像和文本组合的潜在不良检测,比如“表情包”(memes),这些可能会在单独的文本检测中被遗漏。

Boyd 指出,几十年来,微软一直专注解决内容管理问题,并创建了一系列工具,以保护从 Xbox 论坛到 Bing 等各领域用户。Azure AI Content Safety 正是建立在这一长久的经验积淀,以及强大的内容检测功能 Azure Content Moderator 的基础之上,同时利用了新的强大的语言和视觉模型。

通过对安全性的全方位考量,微软希望能够推动备受用户信任的人工智能的广泛采用。