大家好,我是皇子

Transformer 模型架构论文《Attention Is All You Need》发表在 NeurIPS 会议上,同时受到论文模板的影响,论文篇幅极致压缩为 8 页的精华,所以我接下来打算分为几部分来讲清<上一篇请看:讲清 Transformer 模型架构论文(一)>,论文地址放在底部链接。

NeurIPS,全称是Conference on Neural Information Processing Systems,中文名为神经信息处理系统大会。这是全球范围内最大、最重要的人工智能和机器学习领域的学术会议之一。会议每年举办一次,吸引了全球范围内的研究者提交他们在人工智能、机器学习、深度学习、神经网络等领域的最新研究成果。会议的形式包括主题演讲、研讨会、论文发表等。是人工智能和机器学习领域的重要风向标,很多重要的研究成果和新的研究方向都会在这个会议上首次公开。

快速了解

Transformer 模型架构(简称:Transformer 模型)在人工智能领域,特别是在自然语言处理(NLP)领域,起到了革命性的作用。

1、自注意力机制:Transformer模型引入了多头自注意力(Multi-Self Attention)机制,这使得模型能够处理长距离的依赖关系和多通道输出的问题,即模型可以更好地理解句子中的各个部分如何相互关联。这对于理解和生成自然语言非常重要。

2、并行计算:与传统的循环神经网络(RNN)相比,Transformer模型的另一个优点是它可以进行并行计算。因为在Transformer模型中,所有的词都是同时处理的,而不是像在RNN中那样一个接一个地处理。这使得Transformer模型在处理大量数据时更加高效。

3、预训练模型:基于Transformer的预训练模型,如BERT、GPT-2、GPT-3等,已经在各种NLP任务中取得了最先进的结果。这些模型首先在大量的文本数据上进行预训练,学习语言的一般特性,然后在特定任务上进行微调。这种方法已经成为NLP领域的标准做法。

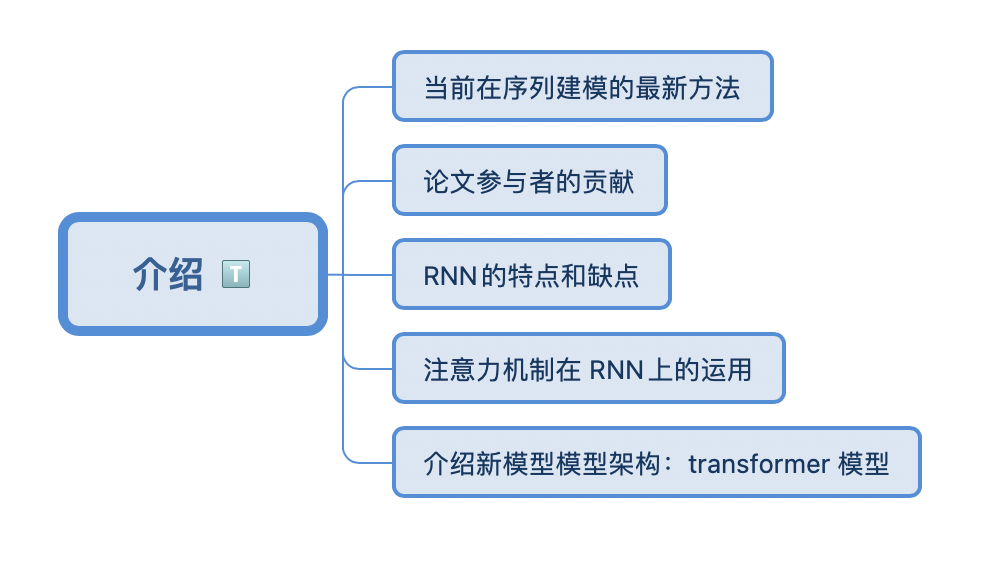

介绍

一图顶千言

当前在序列建模的最新方法

介绍 RNN(循环神经网络),包括LSTM(长短期记忆),与GRU(门控循环单元)网络是目前序列建模和翻译问题公认的最新方法,人们也一直在尝试寻求突破循环语言模型和 encoder-decoder(编码器-解码器)结构的界限。

ps: 当输出结构化信息比较多的时候,大家通常都会用一个叫做 encoder-decoer(编码器-解码器)的结构。

论文参与者的贡献

1、提出把 RNN(卷积神经网络)换成 self-attention(自注意力机制)的想法,并开始评估。

2、设计和实现了第一个 Transfomer 模型。

3、提出点积注意力机制、Multi-Header Attention(多头注意力机制)和无参数位置表示法。

4、进行关于 Transfomer 模型的设计、实现、调整和评估,并进行一些试验和 tensor2tensor 项目的代码的重构。

ps: 指出论文的结果是多人分工合作,贡献的排名是随机的。

RNN的特点和缺点

1、RNN 模型通常沿着输入和输出序列的符号位置来考虑计算(假设你的序列是一个句子的话,它就是一个词一个词的看)。将位置与计算时间中的步骤对齐,对于第t个词,他会计算一个输出叫做 ht,也叫位置t的隐藏状态,它是由前面一个词的隐藏状态 ht-1和当前第 t个词本身所决定的。

2、这种固有的顺序性使得训练示例中无法进行并行化,这在长序列长度时变得至关重要,因为内存约束限制了示例之间的批处理。

3、最近的工作通过因子分解技巧和条件计算显著提高了计算效率,同时也提高了后者的模型性能。然而,本质上时序计算的基本限制仍然存在。

ps: 对于RNN的问题来自于这种处理时序信息的方式:

1、一个时序信息它就是一步一步计算的过程,比如一个序列信息是 100 个词的话就得计算 100 步,它比较难于并行(这就直接导致该模型无法充分地利用现有的硬件资源提高运算能力,性能也会大打折扣)。2、 历史信息同样是一步一步的往后传递的,如果时序比较长,那么在很早期的历史信息很可能在后面的时候出现丢掉(梯度丢失问题),如果不想丢掉的话可能要做一个比较大的ht,而这个大的 ht同样会引发一个问题就是每一步都得保存下来(梯度爆炸问题),导致内存开小很大。

注意力机制在 RNN上的运用

注意力机制已成为各种任务中令人信服的序列建模和转换模型的一个组成部分,允许对依赖关系进行建模,而不考虑它们在输入或输出序列中的距离。然而,在除少数情况外的所有情况下,这种注意力机制都与循环网络结合使用

ps: 这篇文章之前注意力机制已经被成功地运用在编码器-解码器里面了,注意力机制主要是解决如何把编码器的东西很有效的传给解码器。

介绍新模型架构:transformer 模型

在这项工作中,我们提出了 Transformer 模型,这是一种避免循环模型架构,而是完全依赖于注意力机制来绘制输入和输出之间的全局依赖关系。Transformer 允许更多的并行化,在八个 P100 GPU 上训练12小时后,可以达到最先进的内部存储质量。

论文地址:

https://proceedings.neurips.cc/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf

“关注我,一起成长”

有启发,点个赞或在看再走呀