在去年的 Build 大会上,微软首席技术官凯文-斯科特(Kevin Scott)提出了 Copilot Stack,为人工智能应用提出了解决问题的新思路。基于 Copilot Stack,社区在过去一年中开发了许多框架,如 Semantic Kernel、AutoGen 和 LangChain。这些框架更偏重于前端应用,在后端,企业也需要更好的工程解决方案。本系列将基于微软云和相关框架和工具,为大家提供一些思路。

2024 年将是人工智能应用爆发的一年,企业不仅要在应用层面进行投入,还要在基础设施方面进行变革。以下四个方面对企业至关重要,也是企业向人工智能转型的关键。

除了使用 Azure OpenAI 服务建立人工智能模型外,更多企业希望使用开源模型结合自己的数据来构建专属模型。

开源模型的微调和引用都需要算力。混合算力的结合非常重要,它贯穿从开发、测试到生产环境的各个方面。

将更好的业务提示集成到企业业务逻辑中,并评估提示对业务的有效性也非常关键。

快速部署应用程序以应对业务变化。

01

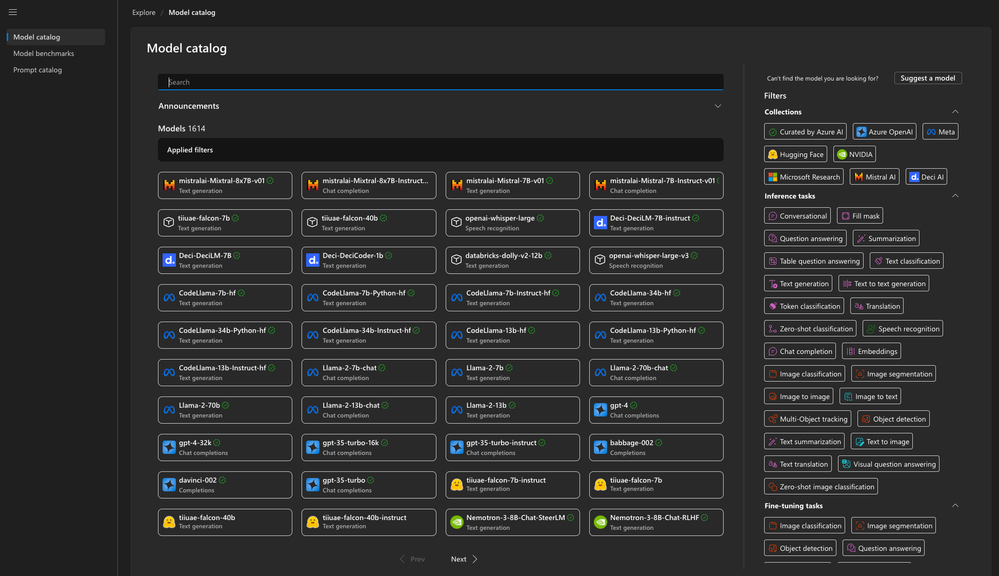

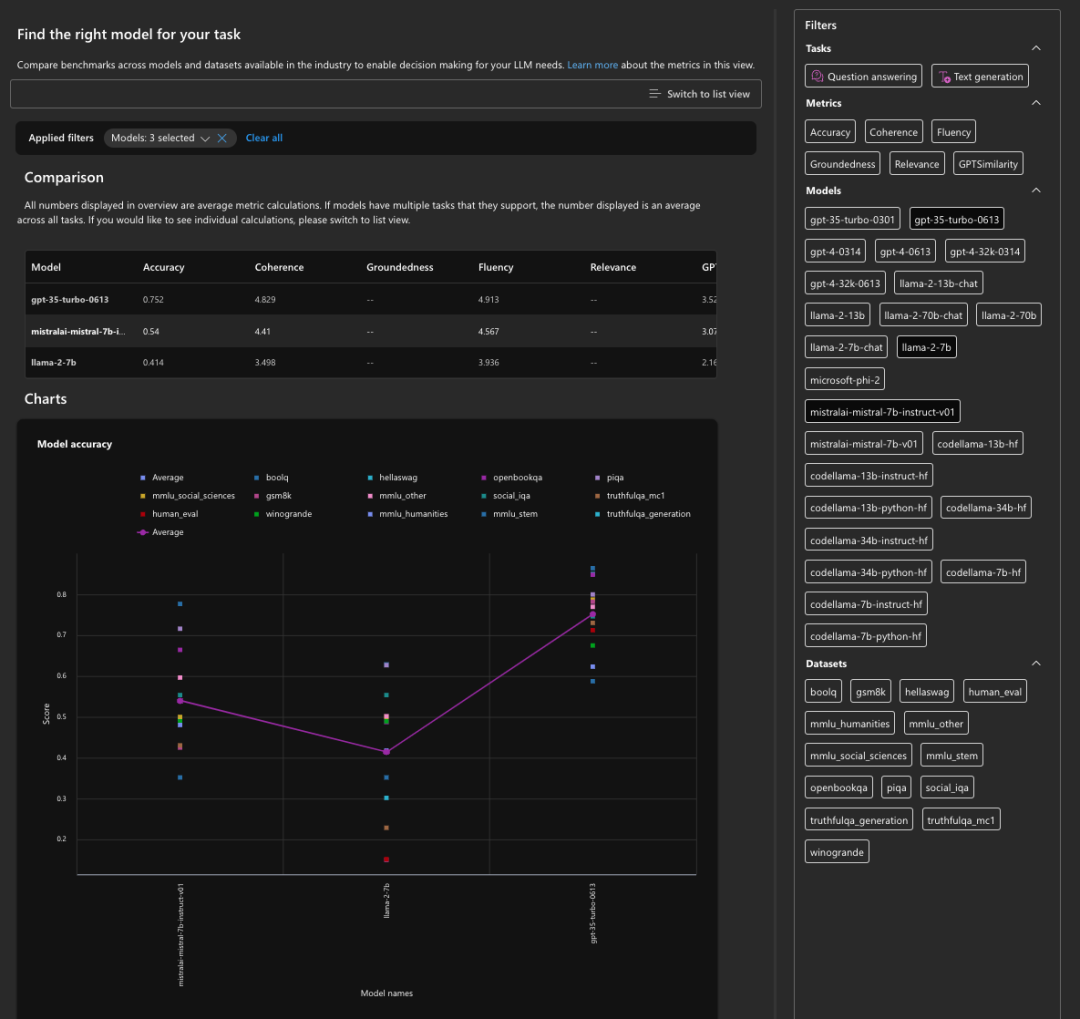

在企业内部,不可能只选择一种模型作为解决方案,通常是多种模型共同配合。Azure OpenAI 服务因其提供最强大的智能模型,通常被企业作为首选模型。一些开源模型,比如:LLama、Mistral、Nemotron 和 Phi-2 等也深受企业喜爱。此外,在 Azure 上通过 Azure AI Studio 还提供了更多模型选择。

通过 Azure AI Studio,您可以比较模型之间的功能,从而根据您的业务做出最佳决策。

从开源模型的使用场景来看,我们可以将其分为微调和引用。

场景 1

微调

企业数据是非常重要的。通常企业会将一些自有数据和业务流程导入到开源模型中进行微调。您可以通过 Microsoft Fabric 或 Azure Data 上的数据作为支撑引入,然后通过 LoRA 或 QLoRA 的方式对开源模型进行微调。此过程非常漫长,您可以通过云端或本地的算力实例完成。

场景 2

引用

经过微调,开源模型就可以部署在 Azure AI Studio 或本地计算实例上。由于企业需要评估微调后模型的性能,特别是其低延迟、高并发性和业务准确性,因此提示流等框架在模型引用中非常关键。

推理指的是在微调之后,将开源模型部署到 Azure AI Studio 或本地计算实例上,使企业能够微调模型以支持业务工作。由于企业需要评估微调模型的性能,特别是其低延迟、高并发和业务准确性,因此像Prompt flow 这样的框架在模型引用中非常关键。

02

微调和引用是非常关键的步骤。基于这两种情况,我们将介绍一些云端和本地相结合的工具和框架。

工具 1

Azure AI Studio

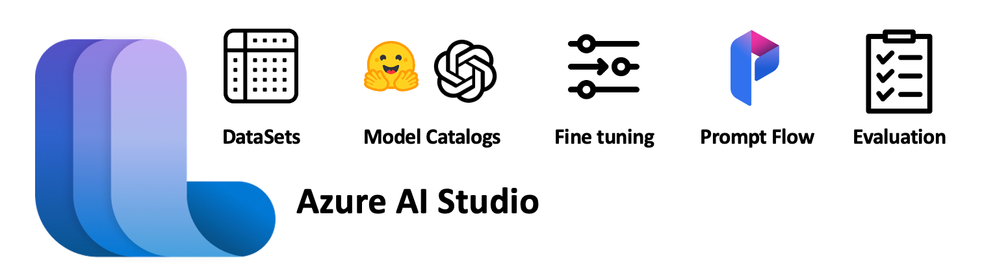

Azure AI Studio 是面向企业构建人工智能的云平台,提供贯穿企业团队开发整个 LLMOps 的闭环。通过 Azure AI SDK 和 Azure AI CLI,结合人工智能开发应用场景,覆盖从数据、模型选择、模型微调、测试、应用部署、内容安全等流程。

工具 2

Windows AI Studio

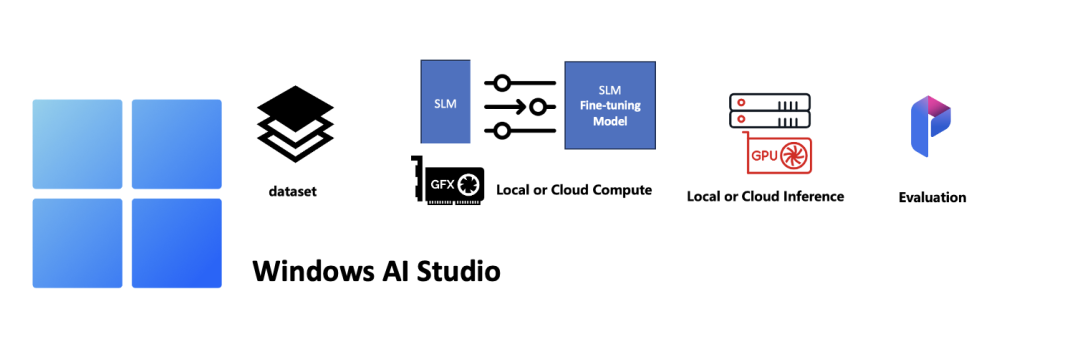

Windows AI Studio 的特点是允许开发者,尤其是个人开发者,通过本地环境(Windows+WSL)对开源小型语言模型(如 Phi2、Llama 2、Mistral 等)进行微调、引用和部署,它也可以与 Azure AI Studio 结合使用。Windows AI Studio 有一个基于 Visual Studio Code 的扩展,开发人员或开发团队可以借助它很好地管理整个应用程序的开发过程。

工具 3

Microsoft Olive

Microsoft Olive 是一款非常易于使用的开源模型优化工具,可用于微调和引用。它只需要简单的配置,结合使用的开源小型语言模型和相关运行环境(AzureML 本地 GPU、CPU、DirectML),就可以通过自动优化的方式完成模型的微调或引用,帮助您找到将模型部署到云端或边缘设备的最佳方案。Microsoft Olive 已集成到 Windows AI Studio 中。

工具 4

提示流程

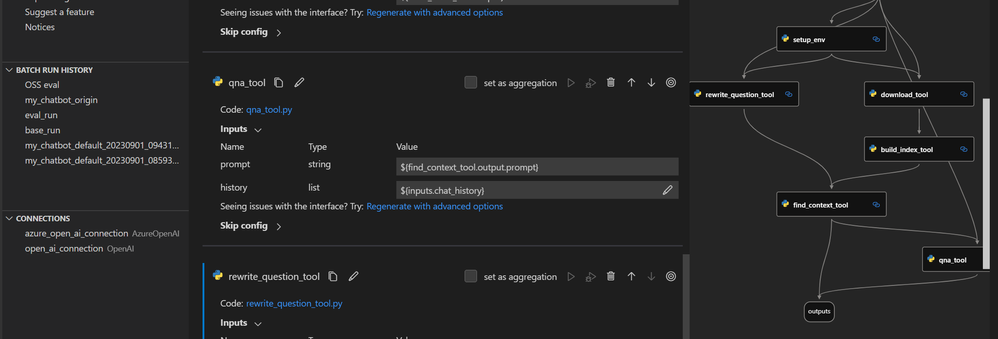

在人工智能应用开发过程中,我们需要提示语来与模型进行交互。提示流的目标是简化人工智能应用的端到端开发周期,从构思、原型设计、测试、评估到生产部署和监控。它使提示工程与业务的整合更加便捷,并可根据业务提示工程进行评估。

03

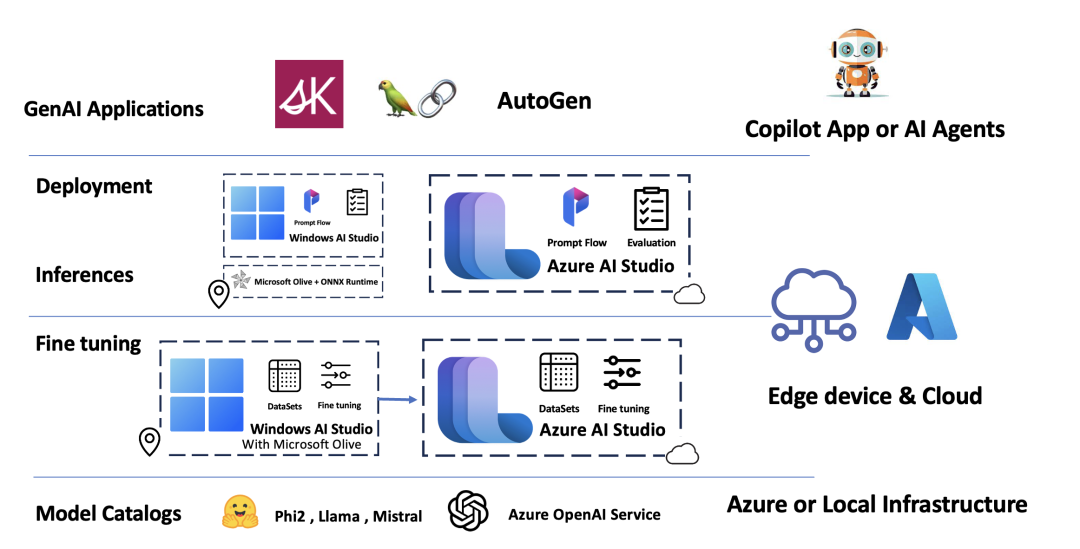

正如开头提到的,如果我们想基于人工智能进行工程设计,就需要从底层开始思考。结合上述提到的工具,再加上Copilot Stack,我认为人工智能架构的过程包含:

1

最底层是模型。可以有多种模型供选择,包括 Azure OpenAI 服务,Azure AI Studio 或 Huggingface 提供的开源小型模型。

2

我们可以使用 Microsoft Olive 结合 Windows AI Studio 来完成开源小语种模型在本地的微调。当参数相对复杂时,我们也可以将微调迁移到 Azure AI Studio。

3

我们可以使用 ONNX Runtime 和 Microsoft Olive 在引用层运行模型,也可以通过 Windows AI Studio 和 Azure AI Studio 直接引用和部署模型。

4

利用提示流评估提示项目和模型在企业应用场景中的有效性,以改进人工智能应用。

5

结合不同的需求和框架,快速构建应用程序,并将其部署到不同的终端。

架构图

人工智能每天都在发生变化,每个人都深度参与其中。对于需要快速转型的公司来说,拥有一个良好的架构将事半功倍。本系列还将有更多内容,还请您持续关注。

# 更多资源

⇲ 了解 Microsoft Olive

https://microsoft.github.io/Olive/

⇲ 了解 Azure AI Studio

https://learn.microsoft.com/azure/ai-studio/what-is-ai-studio

⇲ 了解 Windows AI Studio

https://learn.microsoft.com/windows/ai/studio/

⇲ 了解 Prompt flow 提示流

https://learn.microsoft.com/azure/ai-studio/how-to/prompt-flow

⇲ 阅读 "Hugging Face Collaborates with Microsoft to launch Hugging Face Model Catalog on Azure"

https://huggingface.co/blog/hugging-face-endpoints-on-azure