Prompt engineering是一种扩展大型语言模型(LLM)和视觉-语言模型(VLM)能力的重要技术。通过提供上下文来引导模型的自然语言指令,或者通过学习的向量表示激活相关知识,prompt能够将预训练模型无缝集成到下游任务中,从而实现期望的模型行为。

对于prompt engineering方法和技术的多样性,目前缺乏系统性的组织和理解。本文通过按应用领域进行分类,提供了最近在prompt engineering方面的进展的概述。

https://arxiv.org/pdf/2402.07927.pdf

Zero-Shot Prompting

Zero-Shot Prompting是利用大型LLMs的一种范式转变,这种技术消除了对大量训练数据的需求,而是依靠精心设计的Prompt来引导模型进行新任务。

将文本分类为中性、负面或正面。

文本:我认为这次假期还可以。

情感:

Few-Shot Prompting

Few-Shot Prompting是为模型提供了一些输入-输出示例,以诱导其对给定任务的理解,与零样本Prompt不同,后者不提供任何示例。即使提供了少量高质量的示例,相比没有示例,模型在复杂任务上的表现也有所改善。

将文本分类为中性、负面或正面。

样例1:我今天很开心,情感:正面

样例2:我今天不开心,情感:负面

文本:我认为这次假期还可以。

情感:

少样本Prompt需要额外的标记来包含这些示例,对于较长的文本输入可能会变得不可行。此外,Prompt示例的选择和组合可以显著影响模型的行为,而像偏爱常见词汇之类的偏见仍可能影响到少样本结果。

Chain-of-Thought (CoT) Prompting

Chain-of-Thought (CoT) Prompting的技术,旨在弥合LLMs在面对复杂推理时的局限性。CoT能够引导LLMs进行逻辑推理链,从而产生更具结构性和深思熟虑的回答。这样得到的回答反映了对给定Prompt的更深层次理解。

这组数中的奇数加起来是偶数:4、8、9、15、12、2、1。

A:将所有奇数相加(9、15、1)得到25。答案为False。

这组数中的奇数加起来是偶数:17、10、19、4、8、12、24。

A:将所有奇数相加(17、19)得到36。答案为True。

这组数中的奇数加起来是偶数:16、11、14、4、8、13、24。

A:将所有奇数相加(11、13)得到24。答案为True。

这组数中的奇数加起来是偶数:17、9、10、12、13、4、2。

A:将所有奇数相加(17、9、13)得到39。答案为False。

这组数中的奇数加起来是偶数:15、32、5、13、82、7、1。

A:

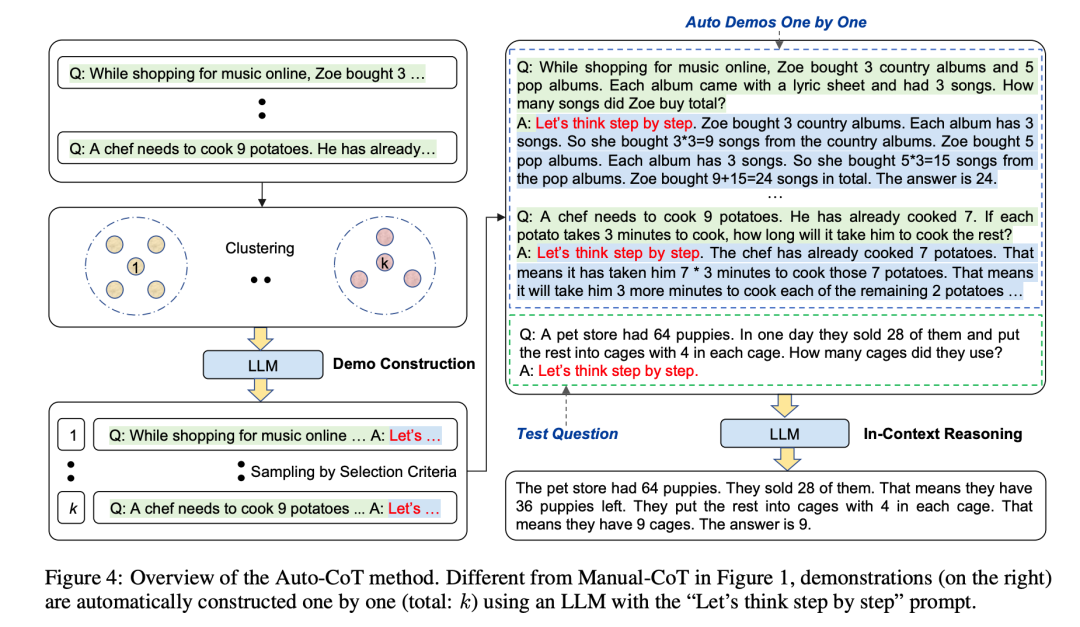

Chain-of-Thought (Auto-CoT) Prompting

Chain-of-Thought (Auto-CoT) Prompting用于自动指导LLMs生成推理链的"让我们逐步思考"提示。手动创建高质量的CoT示例既耗时又不够优化。

Auto-CoT通过多样化采样增强了鲁棒性,以应对个别生成的推理链可能存在的错误。它对各种问题进行采样,并为每个问题生成多个不同的推理链,形成最终的示范集。

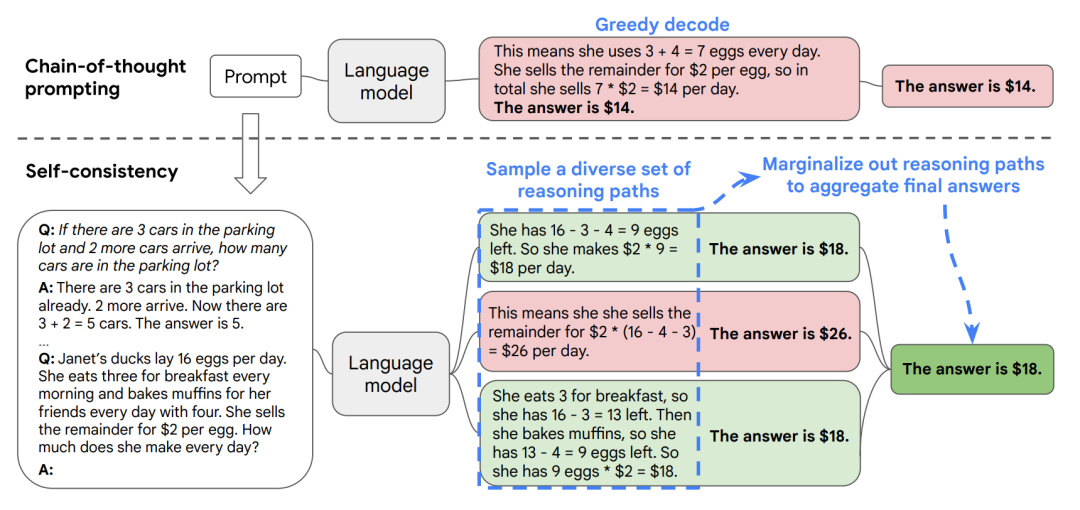

Self-Consistency

Self-Consistency相比CoT Prompting中的贪婪解码,可以提高推理性能。对于存在多个有效路径的复杂推理任务,Self-Consistency进行采样来生成多样化的推理链。

通过少样本CoT采样多个不同的推理路径,并使用生成结果选择最一致的答案。这有助于提高CoT提示在涉及算术和常识推理的任务中的性能。

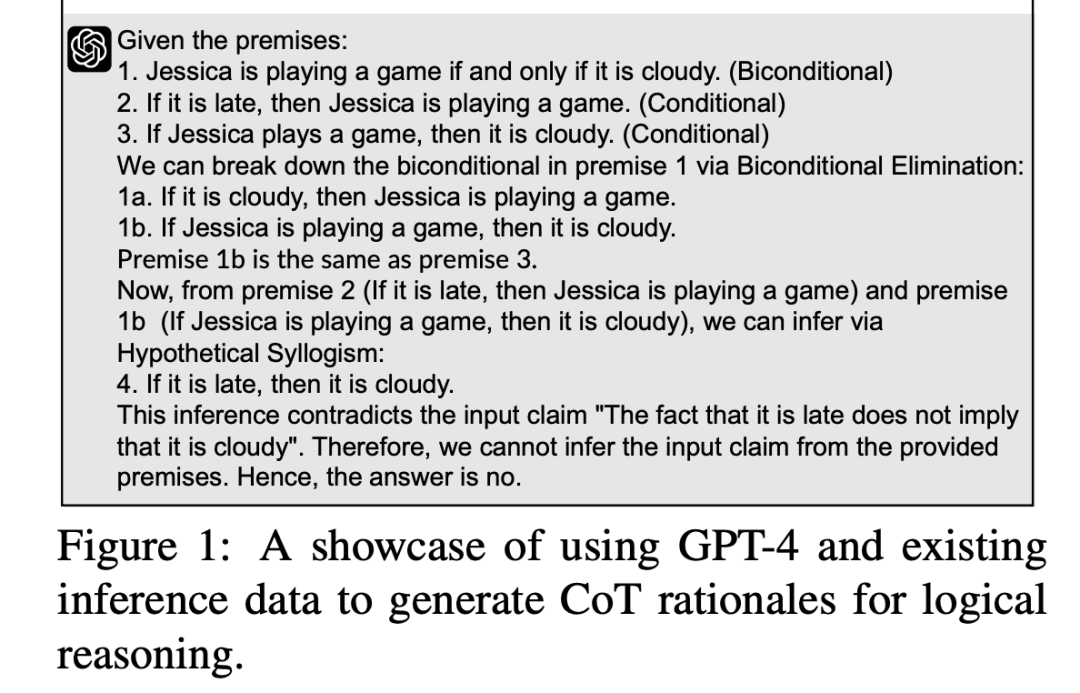

Chain-of-Thought (LogiCoT) Prompting

Chain-of-Thought (LogiCoT) Prompting借鉴了符号逻辑的原理,以一种连贯和结构化的方式增强推理能力。

LogiCoT将反证法的概念应用于验证模型生成的每个推理步骤,并提供有针对性的反馈来修正错误的步骤。

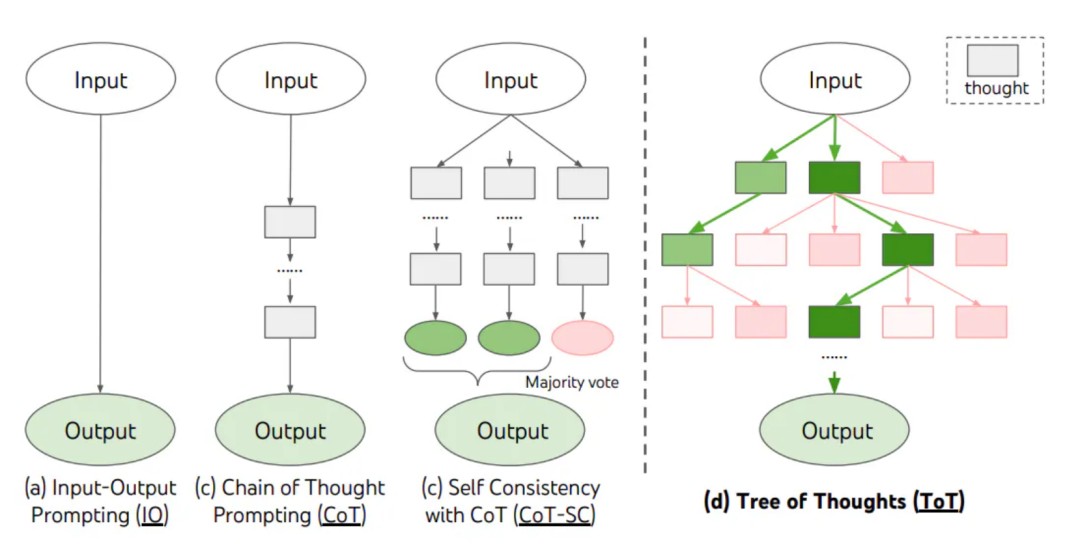

Tree-of-Thoughts (ToT)

Tree-of-Thoughts (ToT) 通过管理一棵中间推理步骤的树状结构,即"思路",扩展了CoT Prompting。每个思路代表着朝着最终解决方案前进的一系列连贯的语言序列。这种结构使语言模型能够通过评估思路在解决问题中的进展来有意识地推理。

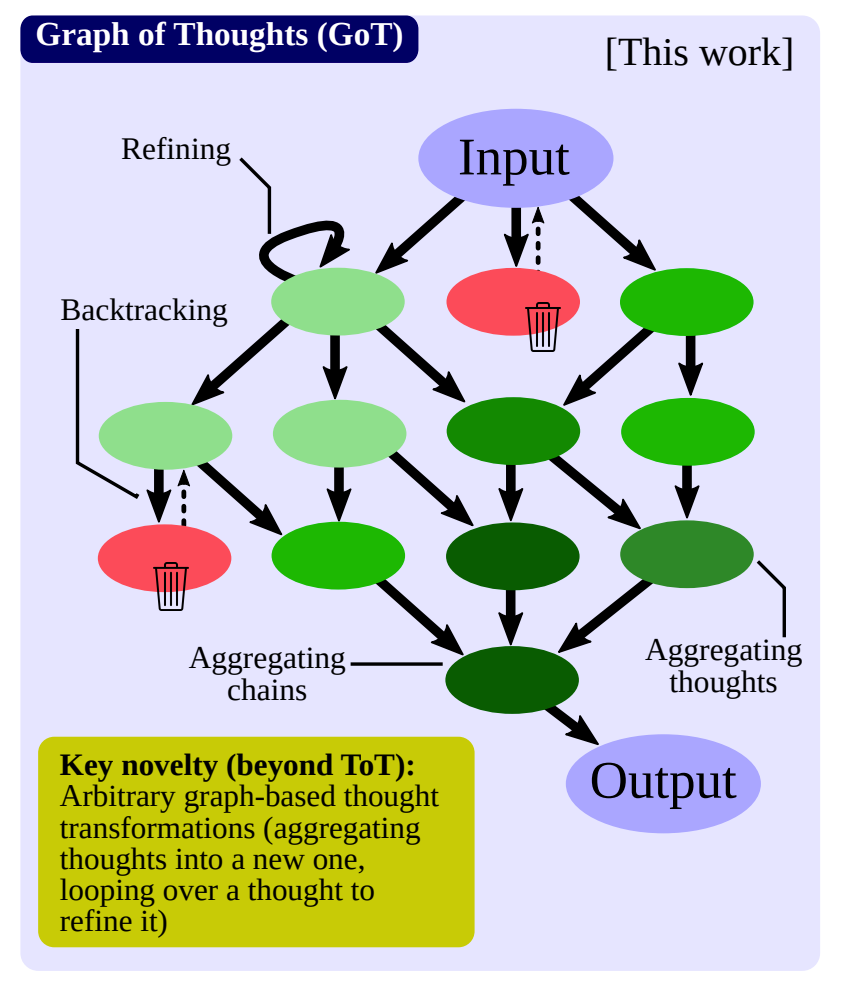

Graph of Thoughts (GoT)

Graph of Thoughts (GoT) 是一个基于图的框架,推动了传统的顺序方法以更好地与人类思维的非线性特征相吻合。Graph of Thoughts (GoT) 框架允许动态的相互作用、回溯和思路评估,允许从各个分支聚合和组合思路,摆脱了树状思路的线性结构。该框架的关键贡献包括将推理过程建模为一个有向图,并提供具有多种转换操作的模块化架构。

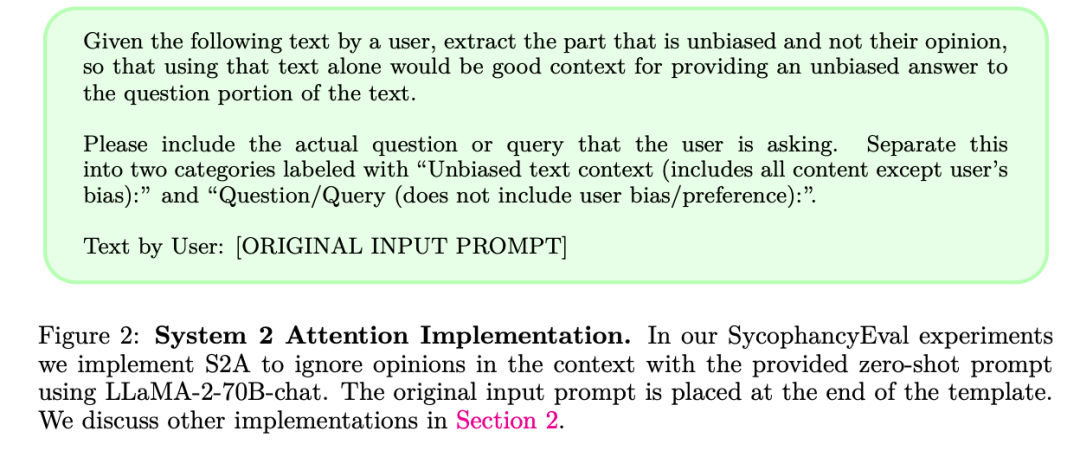

System 2 Attention (S2A)

System 2 Attention (S2A)用于解决基于Transformer的LLMs中软注意机制容易融入无关上下文信息的问题,从而对令牌生成产生负面影响。为了解决这个问题,S2A利用LLMs的推理能力通过重新生成输入上下文来选择性地关注相关部分。S2A采用两步过程,通过上下文重建和生成具有精细上下文的响应,以增强注意力和响应质量。

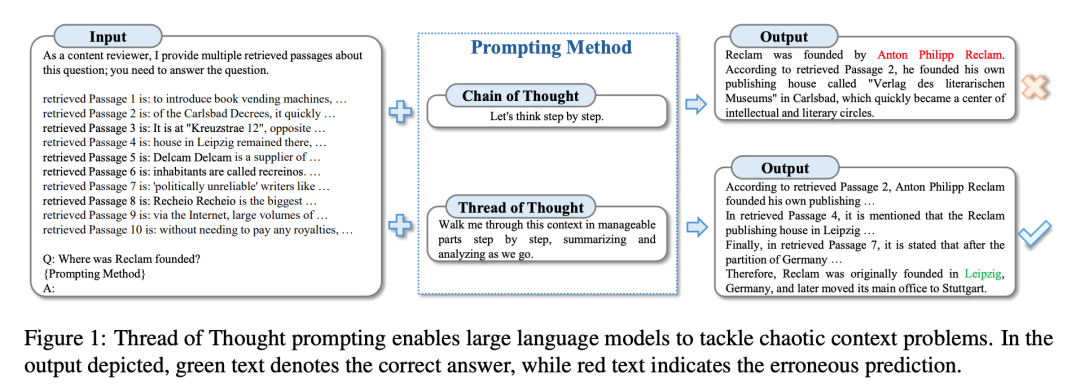

Thread of Thought (ThoT)

Thread of Thought (ThoT)是一种旨在增强LLMs在混乱环境中推理能力的提示技术。ThoT受人类认知启发,将广泛的上下文系统地划分为可管理的片段进行递增式分析,采用两阶段方法,LLM首先对每个片段进行总结和检查,然后对信息进行进一步优化以得出最终的响应。

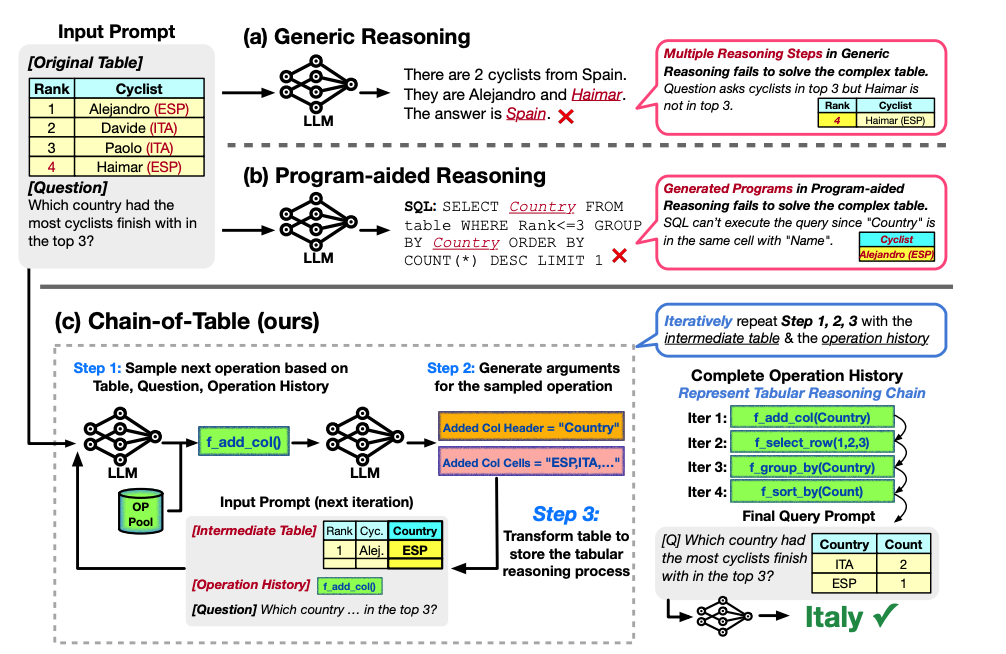

Chain-of-Table

Chain-of-Table通过在表格上动态生成和执行常见的SQL/DataFrame操作,使用逐步的表格推理来处理表格场景。这个过程的迭代性增强了中间结果,使LLMs能够通过逻辑可视化的推理链进行预测。

Retrieval Augmented Generation

检索增强生成(Retrieval Augmented Generation,RAG)将信息检索无缝地融入提示过程中。RAG分析用户输入,构建有针对性的查询,并在预构建的知识库中搜索相关资源。检索到的片段被合并到原始提示中,丰富了上下文背景。增强的提示使LLM能够生成创造性且事实准确的响应。RAG的灵活性克服了静态限制,使其成为需要最新知识的任务的改变者。

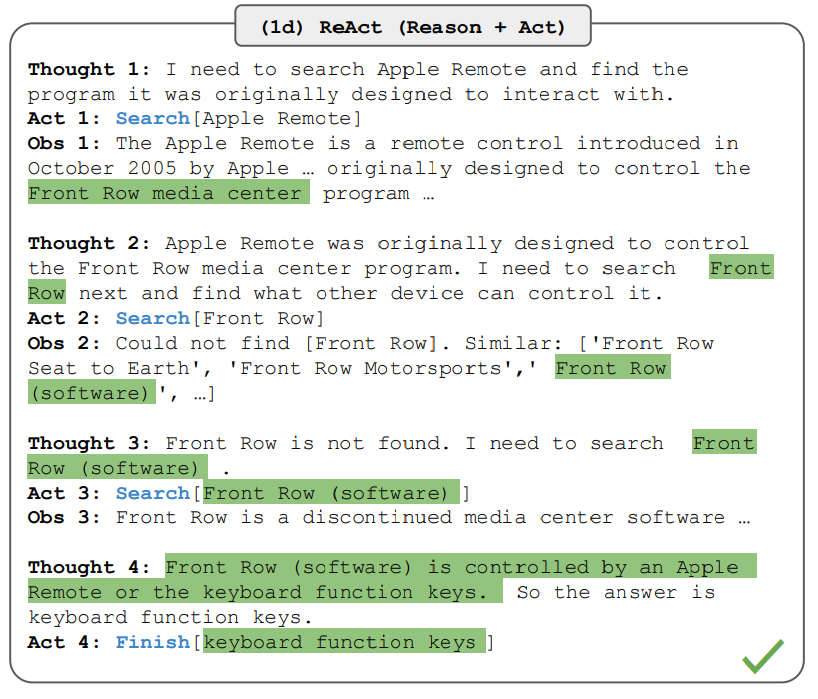

ReAct

ReAct使LLMs能够同时生成推理轨迹和任务特定的行动。这种交错的过程增强了推理和行动之间的协同作用,使模型能够在处理异常情况时诱导、跟踪和更新行动计划。ReAct应用于多样化的语言和决策任务,并展示出其相对于最先进基准的有效性。

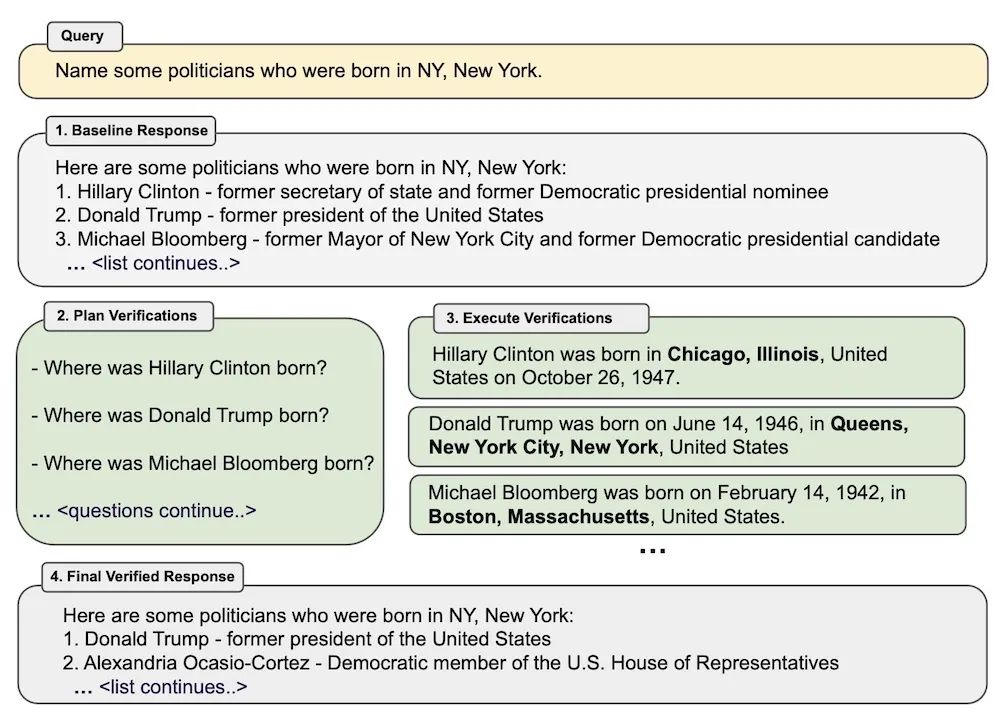

Chain-of-Verification (CoVe)

Chain-of-Verification (CoVe)包括一个系统的四步过程,包括模型生成基准响应,规划验证问题以检查其工作,独立回答这些问题,并生成包含验证的修订响应。通过通过这种有意识的多步骤方法验证其工作,LLM增强了逻辑推理能力,即使在存在矛盾信息的情况下也能减少错误。

CoVe模拟人类验证,增强了LLM输出的一致性和精确性。在列表问题、问答和长篇生成的实验中,CoVe减少了幻觉的出现,同时保持了事实的准确性。

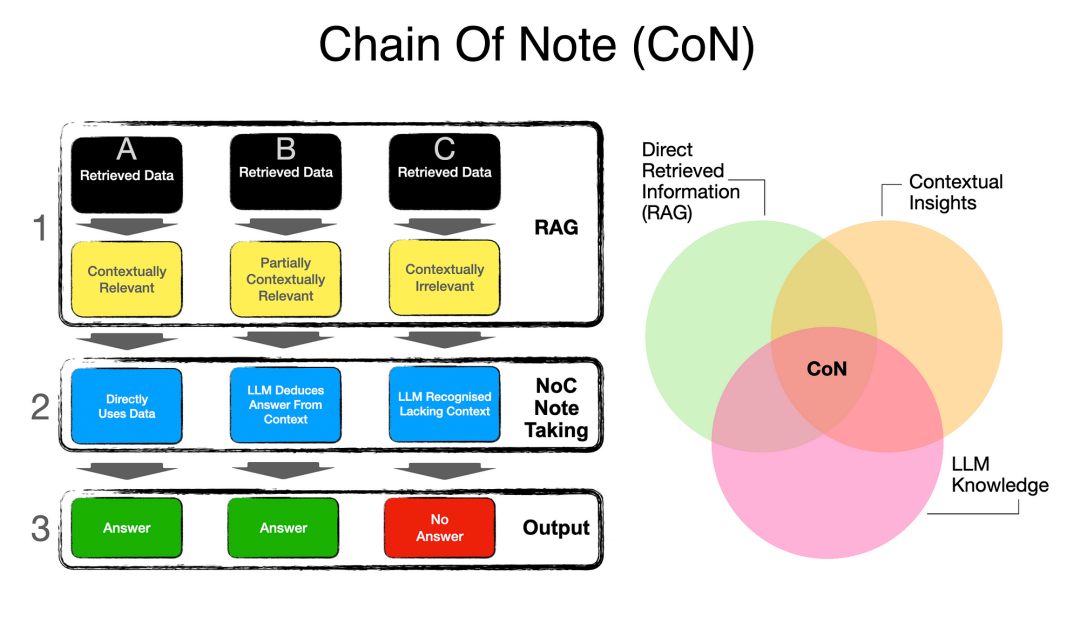

Chain-of-Note (CoN)

Chain-of-Note (CoN) 是一种旨在增强检索增强语言模型(Retrieval-augmented language models,RALMs)的方法,它通过引入外部知识来减少事实幻觉。

CoN通过处理嘈杂的、不相关的文档并准确处理未知情景来提高RALMs的鲁棒性。CoN系统地评估文档的相关性,强调关键和可靠的信息,过滤掉不相关的内容,从而产生更精确和与上下文相关的响应。

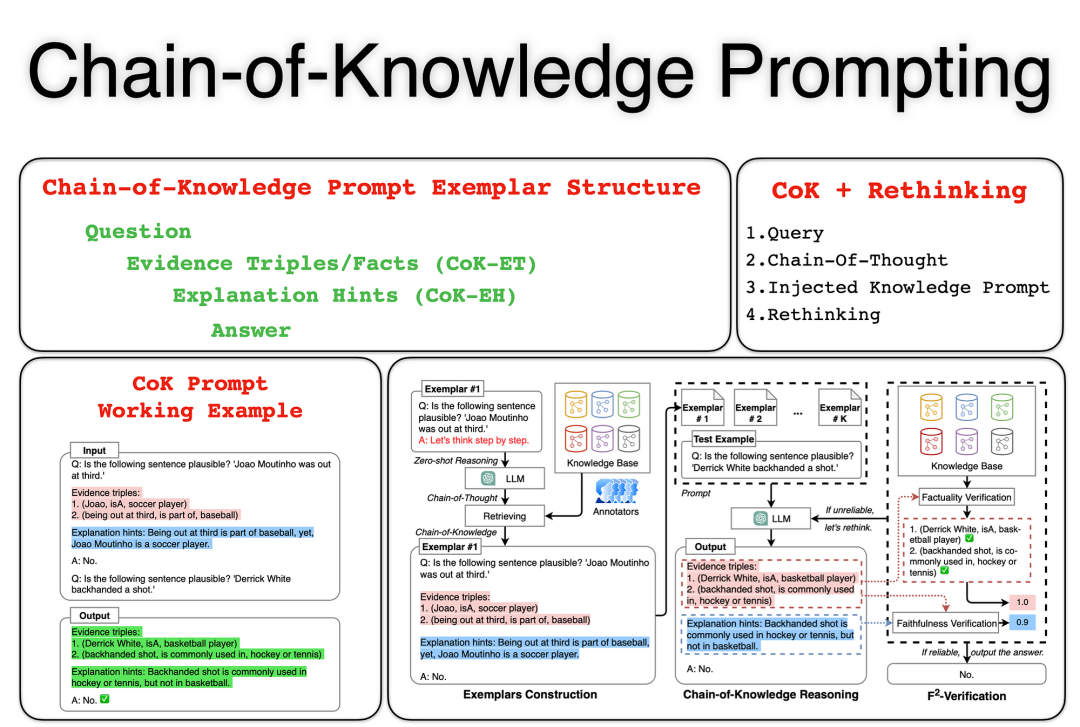

Chain-of-Knowledge (CoK)

Chain-of-Knowledge (CoK) 是一种用于LLMs的传统提示技术,已经在处理基本任务方面证明了其强大的能力。受人类问题解决的启发,CoK系统地将复杂任务分解为协调一致的步骤。

该过程从全面的推理准备阶段开始,建立上下文并确定问题的框架。随后,它进入动态的知识适应阶段,从各种来源(例如内部知识库、外部数据库和给定的提示)中细致地收集证据。

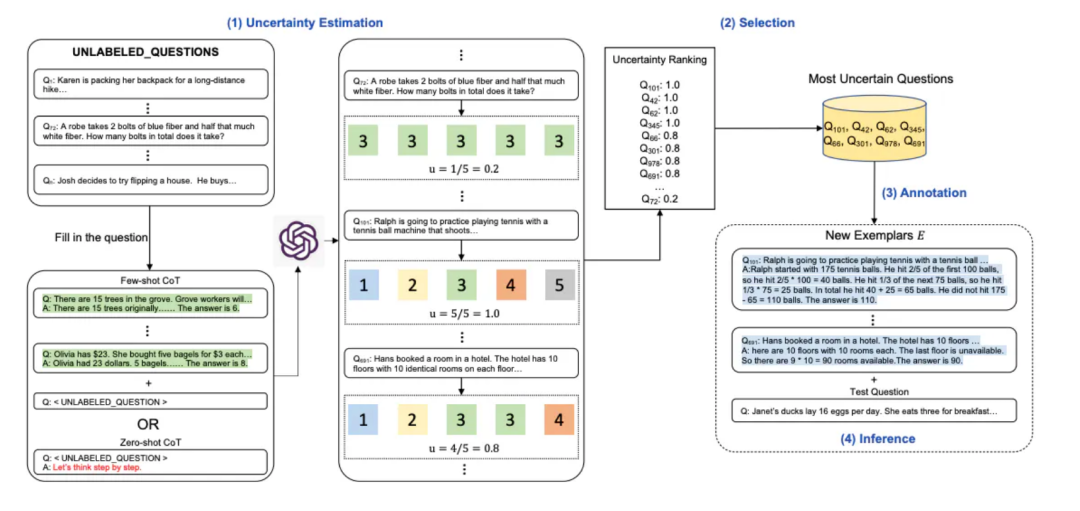

Active-Prompt

Active-Prompt通过具有思维链(CoT)推理的任务特定示例提示来提高LLMs在复杂问答任务中的性能。

Active-Prompt引入了一种确定对注释最具影响力问题的机制。该方法借鉴了基于不确定性的主动学习,利用各种度量标准来描述不确定性,并选择最不确定的问题进行注释。

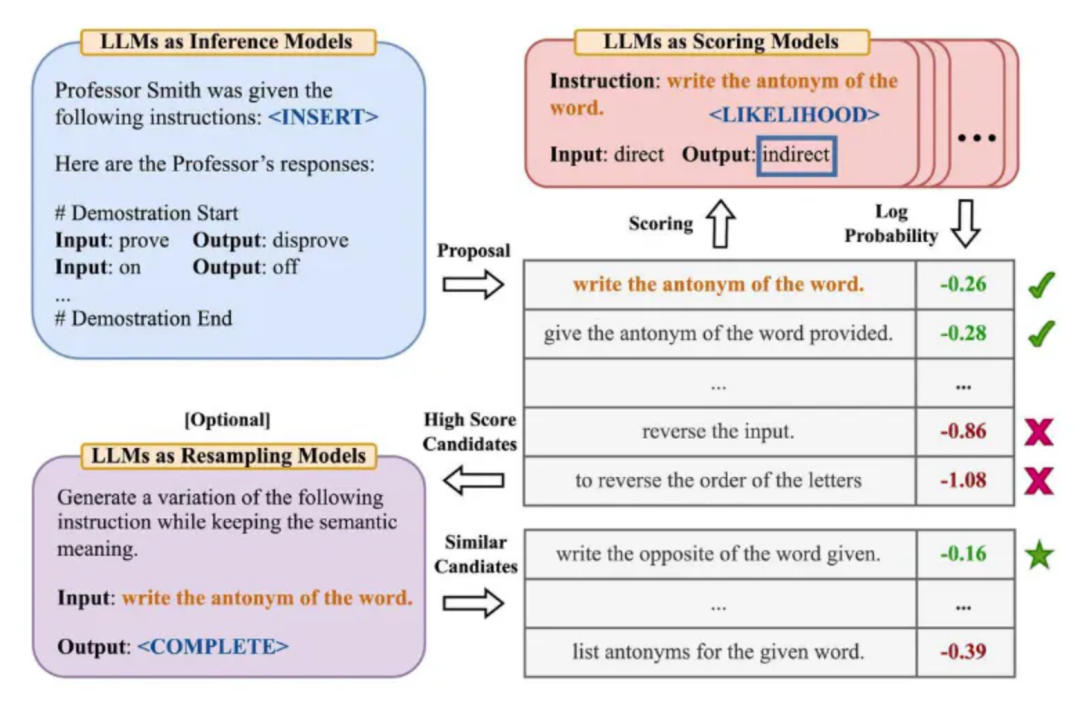

Automatic Prompt Engineer (APE)

Automatic Prompt Engineer (APE)是用于LLMs的自动指令生成和选择,旨在解决为LLMs构建有效提示的传统繁琐任务。APE通过动态生成和选择特定任务的最具影响力的提示,摆脱了静态的手工设计提示的限制。

图书推荐

随着大语言模型的快速发展,语言AI已经进入了新的阶段。这种新型的语言AI模型具有强大的自然语言处理能力,能够理解和生成人类语言,从而在许多领域中都有广泛的应用前景。大语言模型的出现将深刻影响人类的生产和生活方式。本书将介绍提示工程的基本概念和实践,旨在帮助读者了解如何构建高质量的提示内容,以便更高效地利用大语言模型进行工作和学习。

本书内容通俗易懂,案例丰富,适合所有对大语言模型和提示工程感兴趣的读者。无论是初学者还是进阶读者,都可以从本书中获得有价值的信息和实用技巧,帮助他们更好地应对各种挑战和问题。

# 转发本文集30个赞 免费领书 #

每天大模型、算法竞赛、干货资讯