(本文翻译自微软全球官方博客)

在 NVIDIA GTC 大会上,微软和 NVIDIA 宣布推出新产品,涵盖更广泛的领域,从领先的人工智能基础架构到新的平台集成,以及行业突破,提供全面解决方案。这一消息的发布不仅拓宽了两家公司长期合作的道路,也为客户实现革命性人工智能创新铺平了道路。

#01

微软与 NVIDIA 合作开发 Grace Blackwell 200超级芯片,用于构建下一代人工智能模型

微软和 NVIDIA 共同宣布,将 NVIDIA Grace Blackwell 200 (GB200) 超级芯片的强大能力引入到 Microsoft Azure。GB200 是一款专为大规模生成式人工智能工作负载、数据处理和高性能工作负载而设计的新型处理器,具有高达16 TB/s的超大内存带宽,与上一代 Hopper 服务器相比,万亿参数模型的推理能力预估提高了45倍。

微软与 NVIDIA 密切合作,以确保包括 GB200在内的 NVIDIA GPU 能够处理在 Azure AI 基础架构上训练的最新大语言模型(LLM)。这些模型的训练和运行需要大量的数据和计算资源,GB200 将使微软能够帮助客户将这些资源的性能和准确性提升到新的水平。

微软还将利用最新发布的 NVIDIA Quantum-X800 InfiniBand 网络平台,部署一个端到端的人工智能框架。NVIDIA Quantum-X800利用 SHARPv4的网内计算能力,以及对FP8的新增支持,将 GB200 的并行计算任务扩展到大规模 GPU 规模。

#02

NVIDIA 最新 GB200 GPU 将首批上线 Azure 全球服务云平台

微软致力于将基于 GB200 的实例引入 Azure,以支持客户和微软的人工智能服务。基于最新的 GB200和 NVIDIA Quantum-X800 InfiniBand网络(平台)的 Azure 实例,将有助于加速自然语言处理、计算机视觉、语音识别等前沿和基础模型的生成。Azure 客户将能够使用 GB200 超级芯片创建和部署最先进的人工智能解决方案,这些解决方案能够处理海量和复杂的数据,同时加速产品上市时间。

Microsoft Azure 全球云服务还提供一系列服务,帮助客户优化人工智能工作负载,如 Microsoft Azure CycleCloud、Azure Machine Learning、Microsoft Azure AI Studio、Microsoft Azure Synapse Analytics 和 Microsoft Azure Arc。这些全球云服务为客户提供了端到端的人工智能平台,可以处理混合云和多云环境中的数据摄取、处理、训练、推理和部署。

#03

向全球客户兑现人工智能承诺

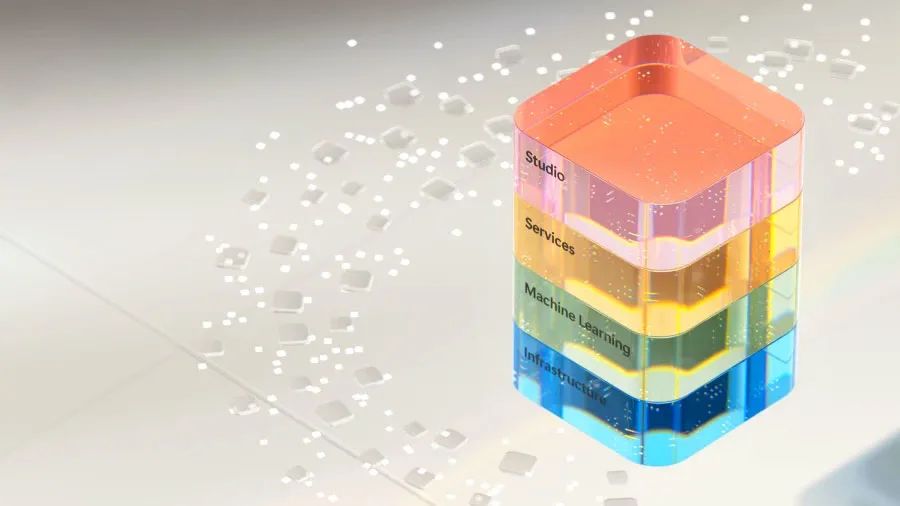

借助集成最新 NVIDIA GPU 算力的 Azure AI 基础架构,微软正在将人工智能渗透到技术栈的每一层,以帮助客户获得新的效益并提高生产力。目前,微软拥有超过53,000个 Azure AI 客户,为客户提供了基础模型和开源模型的最佳选择,包括大语言模型(LLMs)和小语言模型(SLMs),所有模型都与 Azure 上的基础架构数据和工具深度集成。

最近宣布的微软与 Mistral AI 建立合作关系的消息,就是一个很好的证明。表明微软可以帮助人工智能领先者访问 Azure 的前沿智能基础架构,以加快下一代大语言模型的开发和部署。Azure 不断增长的人工智能模型目录提供了超过 1,600个模型,其中包括 OpenAI、Mistral AI、Meta、Hugging Face、Deci AI、NVIDIA 和 Microsoft Research。Azure 客户可以根据其使用情况选择最佳的模型。

#04

Azure NC H100 v5 虚拟机系列正式发布,专为生成式推理和高性能计算进行优化

微软还宣布了 Azure NC H100 v5 虚拟机系列正式可用,该系列专为中端训练、推理和高性能计算(HPC)仿真而设计,具有高性能和高效率。

随着新一代智能应用以惊人的速度扩展,支持这些应用的基本语言模型也将扩展到 SLM 和 LLM。此外,人工狭义智能(ANI)模型也将持续发展,侧重于更精确预测,而非创建新数据,以持续增强其用例。它们的应用包括图像分类、物体检测和更广泛的自然语言处理等任务。

利用 Azure 的强大功能和可扩展性,我们提供的计算工具可增强各种规模组织的能力,无论其资源如何。今天正式发布的 Azure NC H100 v5 虚拟机也是这些计算工具中的一个,也同样可以实现增强各种规模组织的能力。

Azure NC H100 v5虚拟机系列基于 NVIDIA H100 NVL 平台,提供两种类型,一个或两个由 NVLink连接的 NVIDIA H100 94GB PCIe Tensor Core GPU,带宽为600 GB/s。该虚拟机系列支持 PCIe Gen5,可在主机处理器和 GPU 之间提供最高的通信速度(128GB/s 双向)。这降低了数据传输的延迟和开销,使人工智能和高性能计算应用的速度更快、可扩展性更高。

该虚拟机系列还支持 NVIDIA 多实例 GPU(MIG)技术,使客户能够将每个 GPU 最多划分为七个实例,为多样化的人工智能工作负载提供灵活性和可扩展性。该系列在全节点虚拟机上提供高达 80 Gbps 的网络带宽和高达 8 TB 的本地 NVMe 存储,是训练模型、运行推理任务和开发尖端应用的最佳选择。

#05

微软和 NVIDIA 为医疗保健和生命科学领域带来突破性进展

微软正在扩大与 NVIDIA 的合作,通过整合云、人工智能和超级计算,帮助医疗保健和生命科学领域实现转型。

通过利用 Azure 和 Azure AI 的全球规模、安全性和高级计算能力,以及 NVIDIA DGX Cloud 和 NVIDIA Clara 套件,医疗服务提供商、制药和生物技术公司、以及医疗设备开发商,现在可以在整个价值链中加速创新(从临床研究到护理交付),造福全球患者。

#06

新的 Omniverse API 使各行业客户能够嵌入大规模图形和可视化功能

今天,NVIDIA 用于开发 3D 应用的 Omniverse 平台将作为一套 API 在微软 Azure 上运行,使客户能够将先进的图形和可视化功能嵌入到微软和 ISV 合作伙伴的现有软件应用中。

Azure 上的 NVIDIA Omniverse Cloud API 基于通用数据交换 OpenUSD 构建,可为客户进行集成工作,在前端为客户提供基于物理的无缝渲染功能。为了展示这些 API 的价值,微软和 NVIDIA一直在与罗克韦尔自动化公司(Rockwell Automation)和海克斯康公司(Hexagon)合作,展示如何将物理世界和数字世界结合起来,以提高生产力和效率。

#07

微软和 NVIDIA 设想将 NVIDIA DGX Cloud 与 Microsoft Fabric 进行更深入的整合

两家公司还在合作,将 NVIDIA DGX Cloud 计算和 Microsoft Fabric 结合起来,为客户的最复杂的数据工作负载提供支持。这意味着 NVIDIA 的工作负载特定优化的运行时、大语言模型(LLMs)和机器学习将与 Fabric 无缝集成。

NVIDIA DGX Cloud 与 Fabric 的整合包括通过引入 NVIDIA DGX Cloud 的大语言模型定制功能来扩展 Fabric 的功能,以解决数字孪生和天气预报等数据密集型用例,并将 Fabric OneLake 作为底层数据存储。该集成还将为客户提供 DGX Cloud 选项,以加速其 Fabric 数据科学和数据工程工作负载。

#08

在人工智能时代加速创新

多年来,从硬件到系统再到虚拟机,微软和 NVIDIA 一直通力合作,共同打造创新的人工智能解决方案,以应对云计算领域的复杂挑战。微软将继续利用堆栈各层最前沿的技术扩展和增强其全球基础架构,为云计算和人工智能工作负载提供更高的性能和可扩展性,帮助客户在各个行业和领域取得更大的成就。

注:所有发布内容均为微软全球产品与服务。

落地各个国家/地区的时间视当地情况而定。