deepchecks介绍

https://docs.deepchecks.com/stable/getting-started/welcome.html

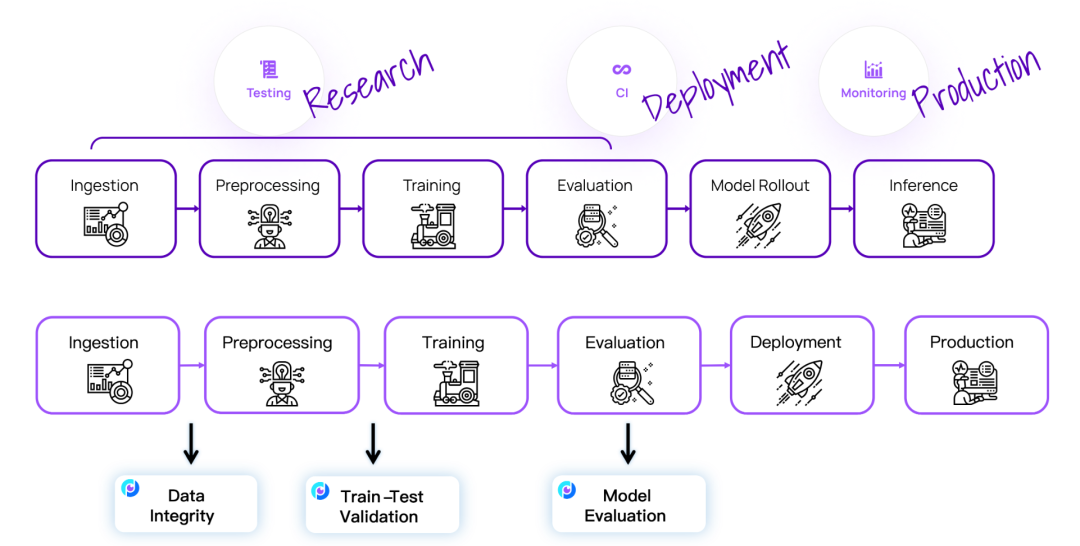

Deepchecks能够从研究到生产环境彻底测试您的数据和模型,提供从检查数据完整性和评估分布,到验证数据拆分,比较模型,并评估模型在整个开发过程中的性能。

Deepchecks的持续验证方法基于在整个生命周期中使用完全相同的检查来测试ML模型和数据,从而实现了简单、详细和无缝的配置和使用结果的体验。每个阶段都有其相关的界面(例如可视化输出、Python/JSON输出结果、警报配置、推送通知、根本原因分析等),用于与测试结果进行交互。

# 表格数据分析

pip install deepchecks --upgrade

# 视觉数据分析

pip install "deepchecks[vision]" --upgrade

# 文本数据分析

pip install "deepchecks[nlp]" --upgrade

deepchecks检测逻辑

数据完整性

| 检测项目 | 介绍 |

|---|---|

| Is Single Value | 检测数据列是否只包含单个数值。该检查用于确定某些列是否缺乏变化,可能导致模型无法有效地学习相关信息。 |

| Special Characters | 检测数据中是否存在特殊字符。特殊字符可能会干扰数据处理和模型训练,因此此检查可用于识别并处理包含非预期字符的数据。 |

| Mixed Nulls | 检测数据中是否存在混合的缺失值。统一处理缺失值是重要的,此检查有助于识别数据中缺失值处理不一致的情况。 |

| Mixed Data Types | 检测数据列中是否存在多种数据类型。统一数据类型有助于确保模型的稳定性和准确性,此检查有助于发现数据类型不一致的情况。 |

| String Mismatch | 检测字符串数据列中是否存在不匹配的模式。可能涉及到拼写错误、格式错误或其他类型的数据不一致,可能影响模型性能。 |

| Data Duplicates | 检测数据中是否存在重复的记录。重复数据可能会影响模型的训练和性能评估,此检查有助于识别并处理重复数据。 |

| String Length Out Of Bounds | 检测字符串数据列中是否存在超出预期长度范围的值。有助于捕获并处理异常情况。 |

| Conflicting Labels | 检测数据中是否存在标签之间的冲突。在监督学习任务中,确保标签之间的一致性和准确性非常重要,有助于发现并解决标签冲突问题。 |

| Outlier Sample Detection | 检测数据中是否存在异常值。异常值可能干扰模型的训练和预测,此检查有助于识别并处理异常值。 |

| Feature Label Correlation | 检测特征与标签之间的相关性。了解特征与标签之间的关系有助于选择有效的特征并优化模型的性能。 |

| Identifier Label Correlation | 检测标识符与标签之间的相关性。有助于确定标识符对于模型的预测是否有意义。 |

| Feature Feature Correlation | 检测特征之间的相关性。了解特征之间的相关性有助于避免多重共线性,并选择最具信息量的特征用于模型训练。 |

数据划分

| 检测项目 | 介绍 |

|---|---|

| String Mismatch Comparison | 检测字符串数据列中是否存在不匹配的模式。该检查比较训练集和测试集中的字符串数据,发现不一致之处。 |

| Train Test Samples Mix | 检测训练集和测试集中的样本混合程度。用于确保两个数据集的样本分布差异不会导致模型性能的偏差。 |

| New Label | 检测是否存在训练集中没有出现过的标签。新标签可能会导致模型预测出现偏差,此检查有助于识别并处理新标签。 |

| Datasets Size Comparison | 检测不同数据集之间的大小差异。数据集大小的不同可能会影响模型的训练和性能评估,此检查有助于比较数据集的大小。 |

| New Category | 检测是否存在训练集中没有出现过的类别。新类别可能会导致模型预测出现偏差,此检查有助于识别并处理新类别。 |

| Index Leakage | 检测索引是否泄漏到训练或测试数据中。索引泄漏可能会导致模型在评估时出现偏差,此检查有助于识别并处理索引泄漏问题。 |

| Feature Label Correlation Change | 检测特征与标签之间的相关性是否发生变化。了解相关性变化有助于识别数据漂移和模型性能变化的原因。 |

| Multivariate Drift | 检测多个特征之间的分布是否发生变化。多变量漂移可能会导致模型性能下降,此检查有助于识别并处理多变量漂移问题。 |

| Label Drift | 检测标签分布是否随时间发生变化。标签漂移可能会导致模型性能下降,此检查有助于识别并处理标签漂移问题。 |

| Date Train Test Leakage Overlap | 检测训练集和测试集之间日期的重叠情况。日期重叠可能会导致信息泄漏,此检查有助于识别并处理日期泄漏问题。 |

| Date Train Test Leakage Duplicates | 检测日期在训练集和测试集中是否存在重复。重复的日期可能会导致模型性能偏差,此检查有助于识别并处理日期重复问题。 |

| Feature Drift | 检测特征分布是否随时间或其他因素发生变化。特征漂移可能会导致模型性能下降,此检查有助于识别并处理特征漂移问题。 |

评估模型

| 检测项目 | 介绍 |

|---|---|

| Model Info | 提供模型的相关信息,如参数设置、训练过程等。 |

| Segment Performance | 分析模型在不同分段(例如不同类别、不同特征范围)上的性能。 |

| Unused Features | 检测未被模型使用的特征。 |

| Performance Bias | 检测模型在不同条件下的性能偏差。 |

| Simple Model Comparison | 比较不同简单模型的性能。 |

| Weak Segments Performance | 分析模型在性能较差的分段上的表现。 |

| Model Inference Time | 测量模型推断时间。 |

| Regression Systematic Error | 分析回归模型的系统误差。 |

| Single Dataset Performance | 分析模型在单个数据集上的性能。 |

| Train Test Performance | 比较模型在训练集和测试集上的性能。 |

| ROC Report | 提供模型的ROC曲线和AUC值。 |

| Regression Error Distribution | 分析回归模型的误差分布。 |

| Confusion Matrix Report | 提供模型的混淆矩阵报告。 |

| Boosting Overfit | 检测模型是否存在过拟合问题。 |

| Prediction Drift | 检测模型预测是否出现漂移。 |

| Calibration Score | 提供模型的校准分数。 |

| Multi Model Performance Report | 提供多个模型性能的综合报告。 |

# 学习大模型 & 讨论Kaggle #

每天大模型、算法竞赛、干货资讯

文章转载自Coggle数据科学,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。