BigQuant 量化教程

来源:https://bigquant.com/tutorial/

宽客学院

宽客学前

【

宽客学院】BigQuant 宽客成长攻略

欢迎您来到BigQuant。BigQuant的使命是将人工智能的能力赋予每一个投资者 (Democratize AI to empower investors)。

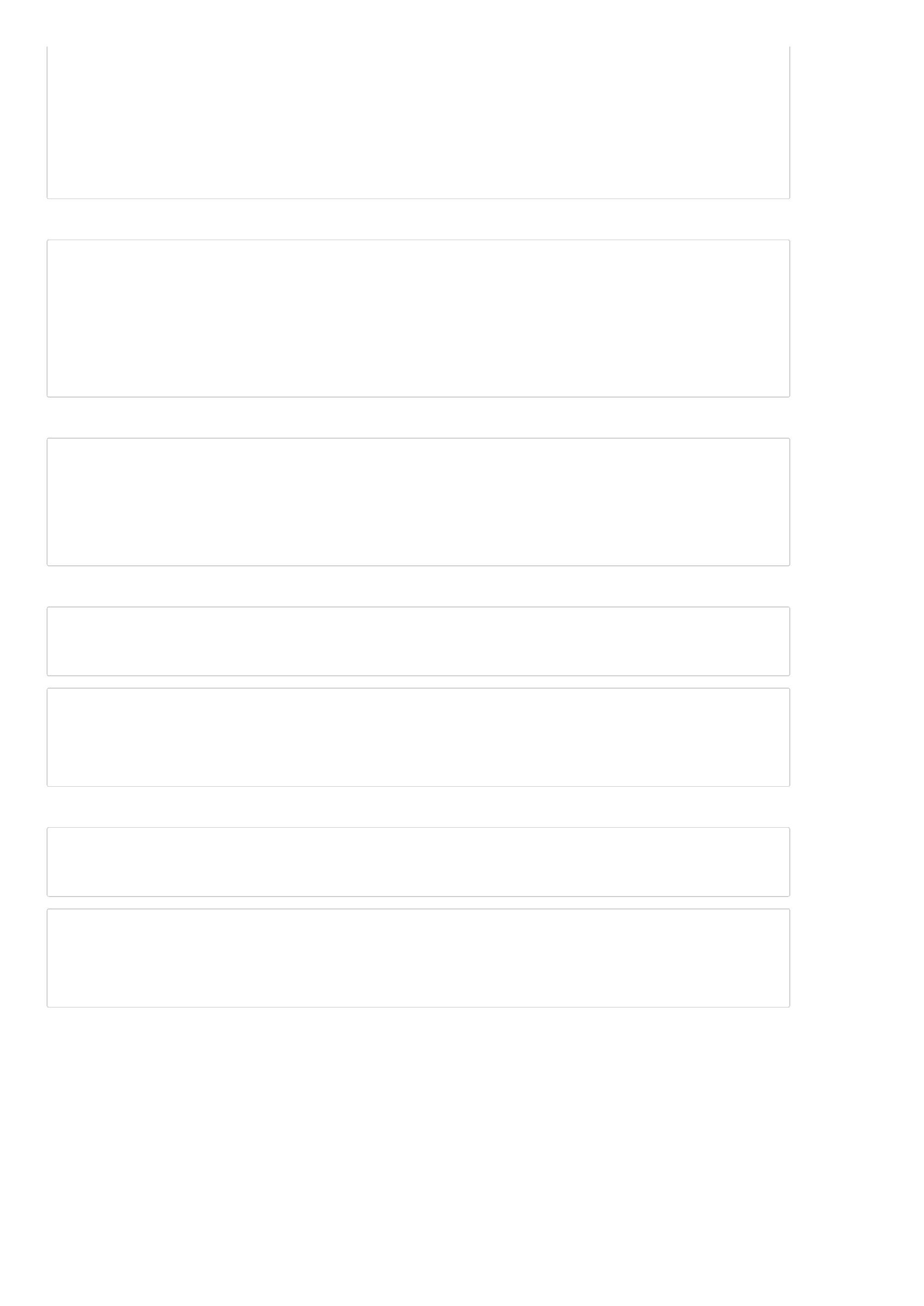

我们制定了一个宽客成长路径,包含如下四个阶段的教程,帮助大家一步一步的学习和深入量化,一步一步的使用并驾驭AI来开发策略,在宽客之路上走的

更快更远。

无论您是金融/量化投资从业者,还是对量化有兴趣的工程师,或者是未来希望参与量化投资的学生,本教程都将对您的成长和发展有所帮助。

下一页:您的第一个人工智能量化投资策略

目录:BigQuant学院

您的第一个人工智能量化投资策略

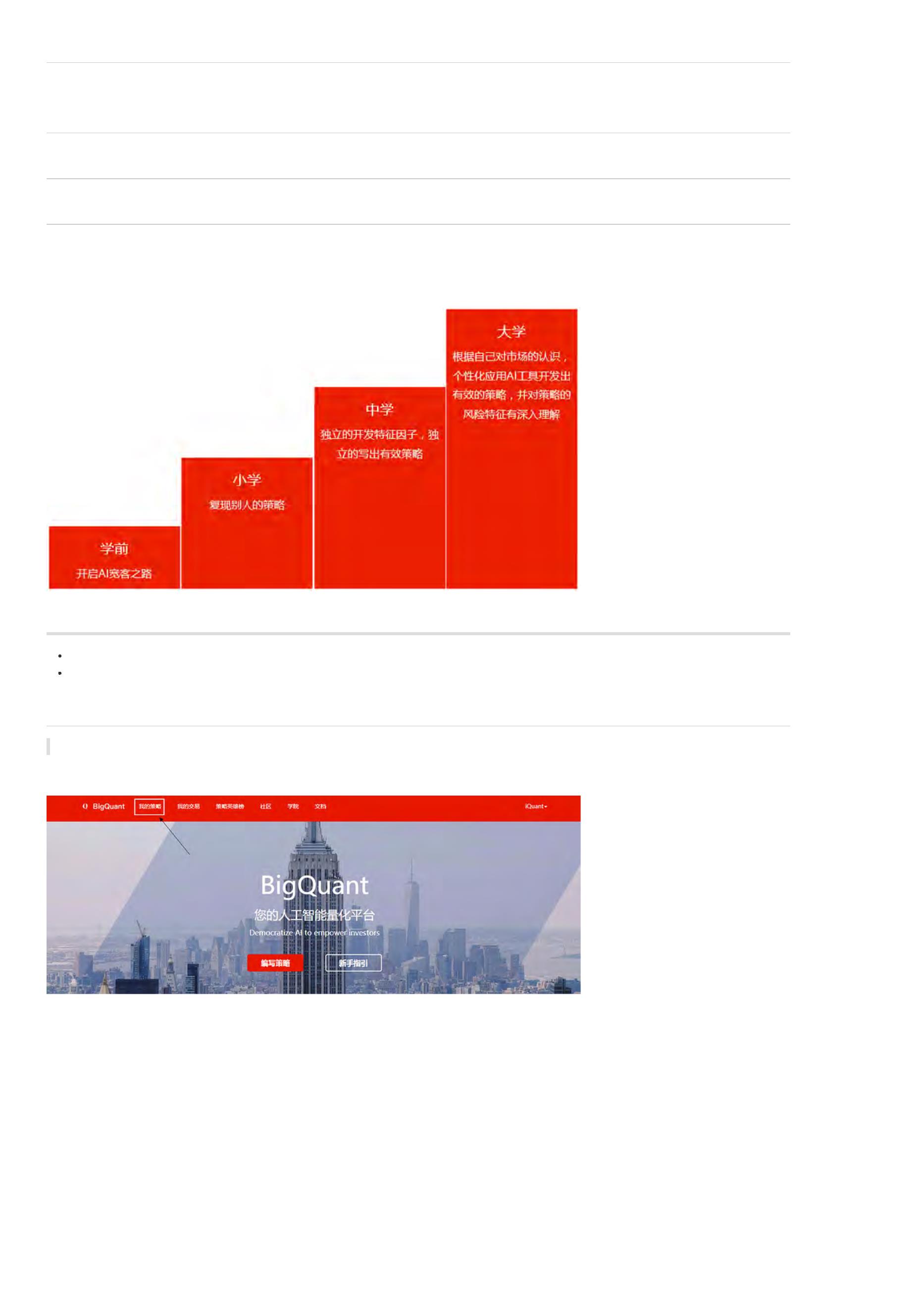

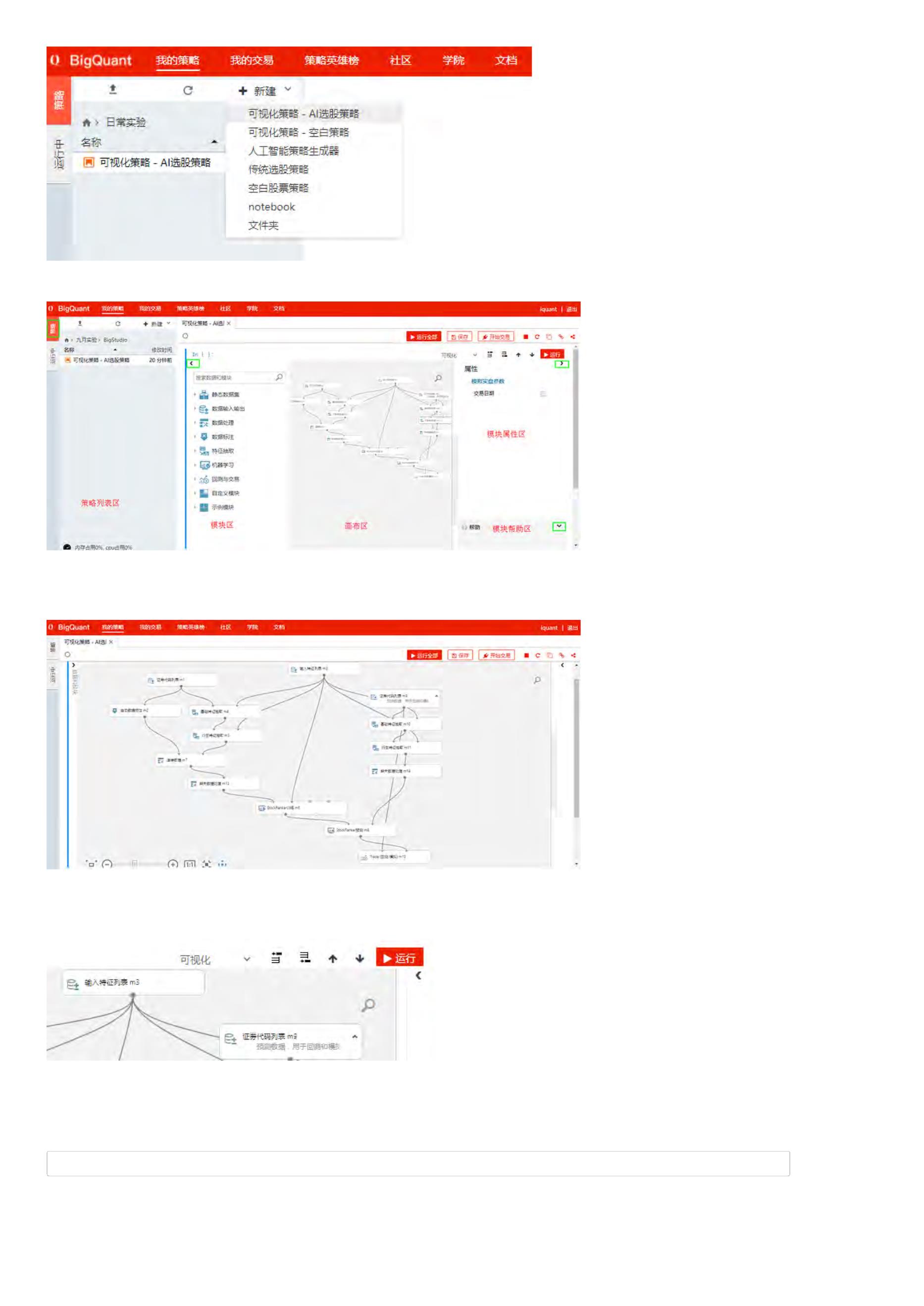

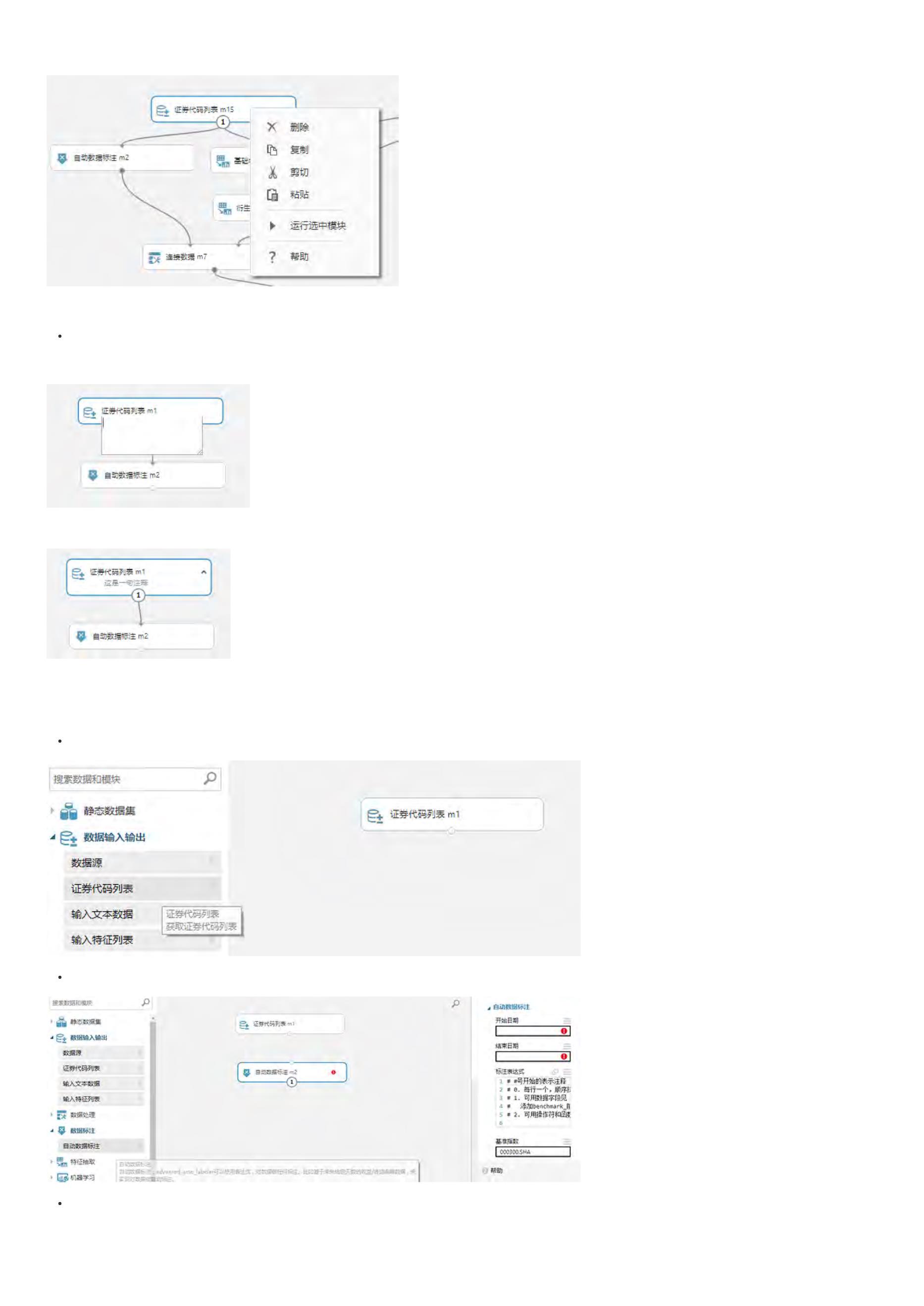

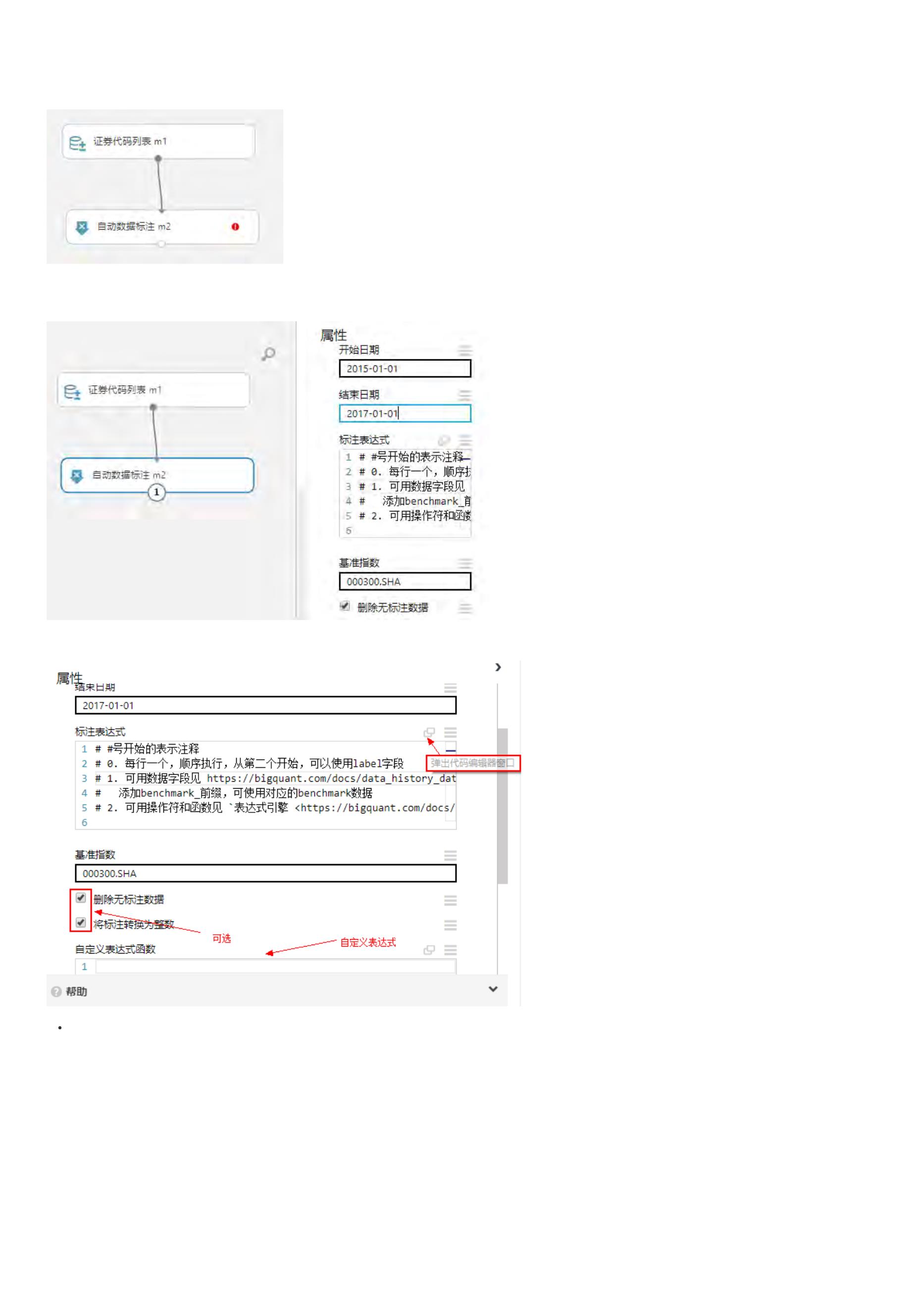

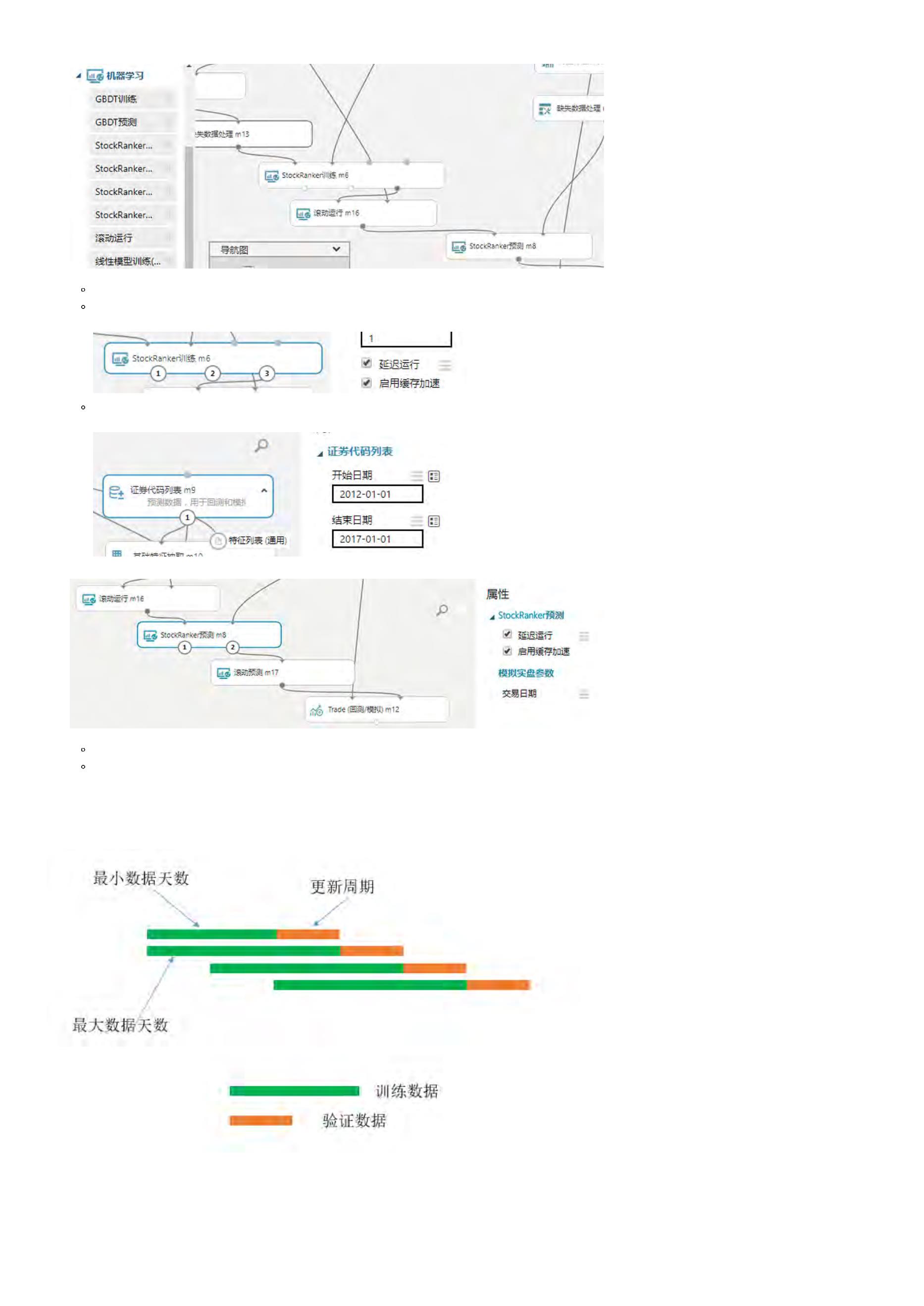

BigQuant平台支持可视化开发人工智能(AI)量化策略,你可以根据本文的引导,新建您的第一个AI量化策略。

1

. 在网站首页,登录账户并点击 我的策略,进入策略研究界面

2

. 进入 我的策略界面以后,新建 > 可视化策略-AI选股策略

3

. 输入策略 名称,完成策略新建

新建的策略如下:

4

. 点击 运行全部 或 运行 ,运行策略

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

上一页:BigQuant宽客成长攻略

下一页:通过策略生成器新建AI策略

目录:宽客学院

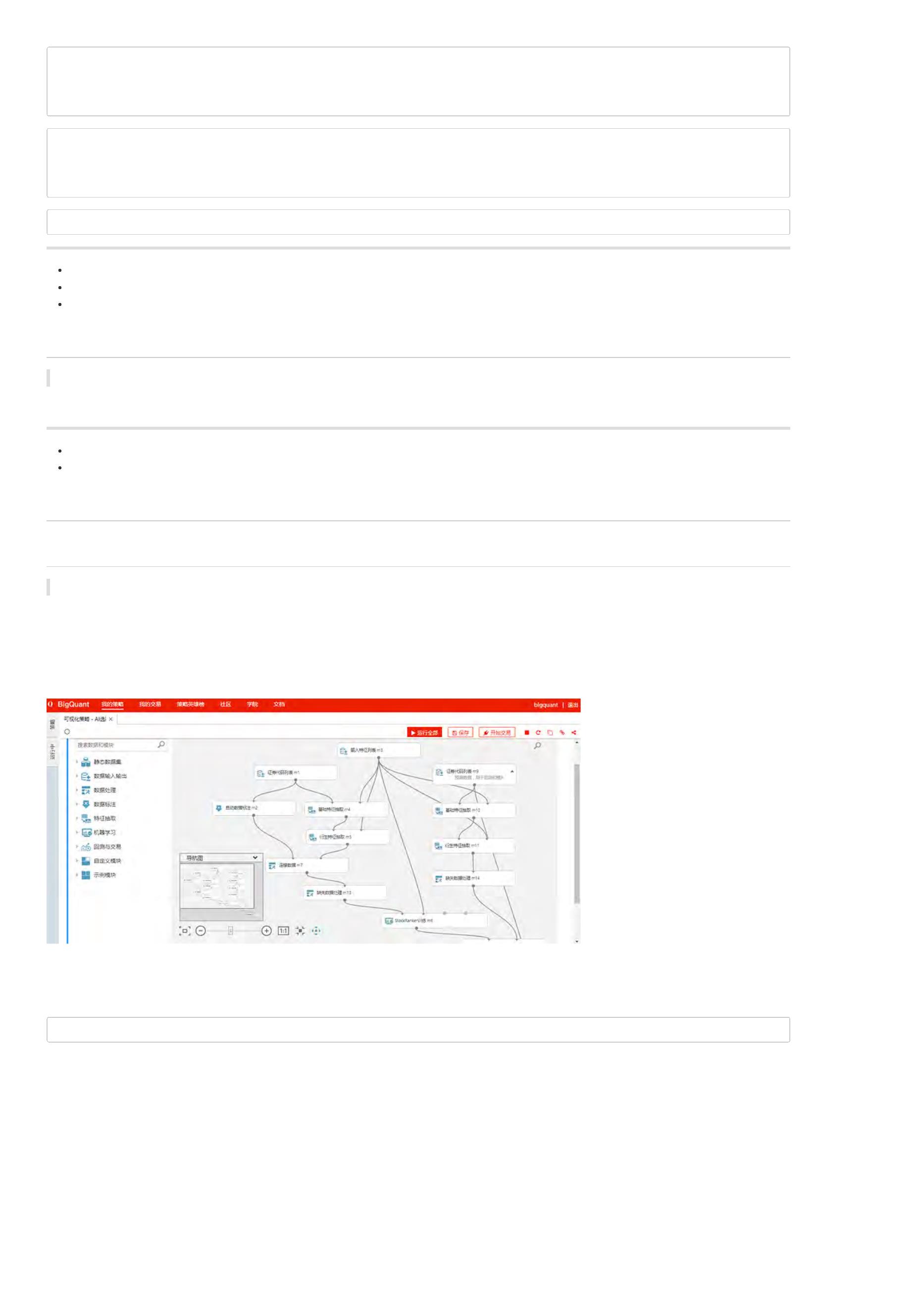

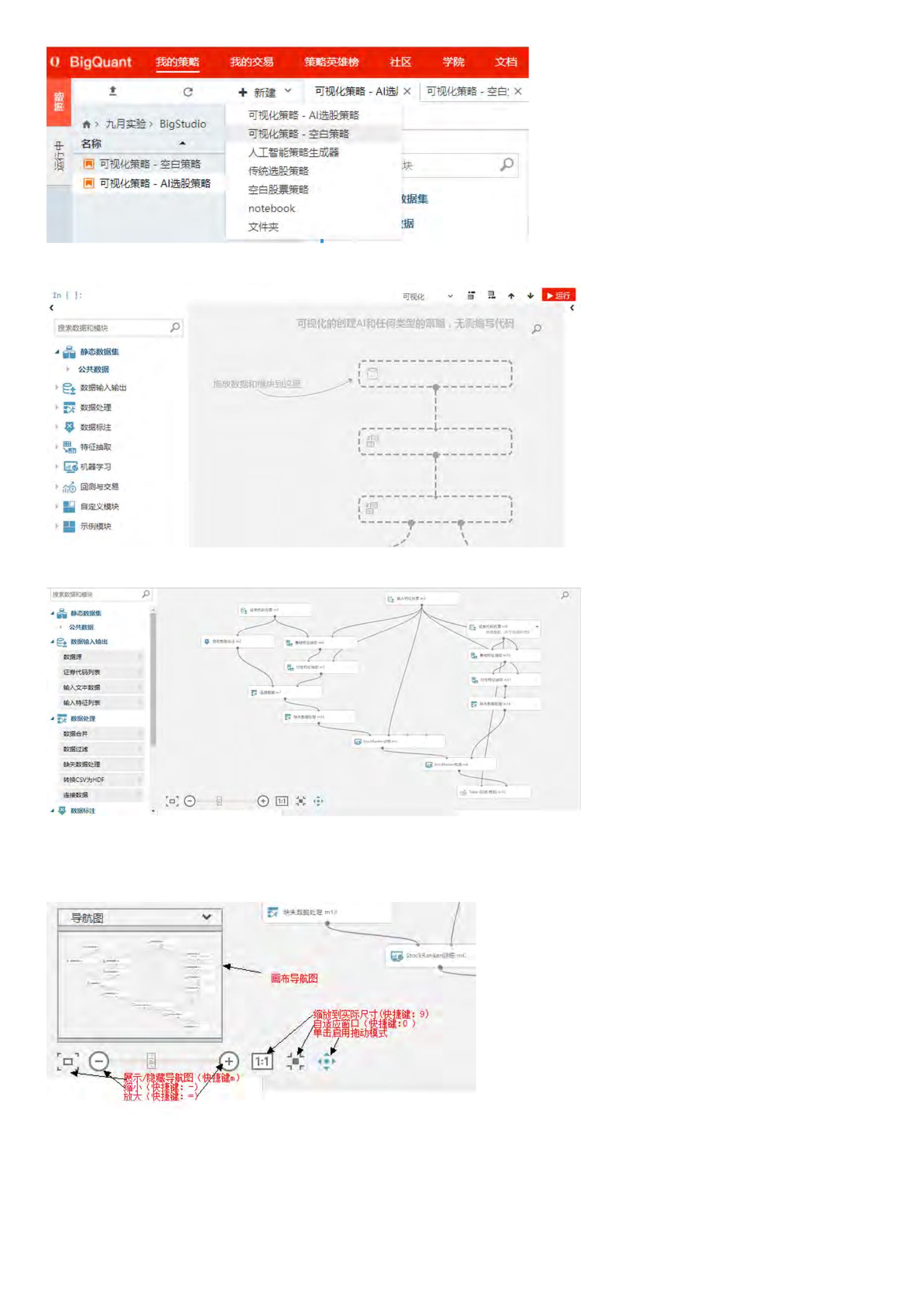

通过策略生成器新建AI策略

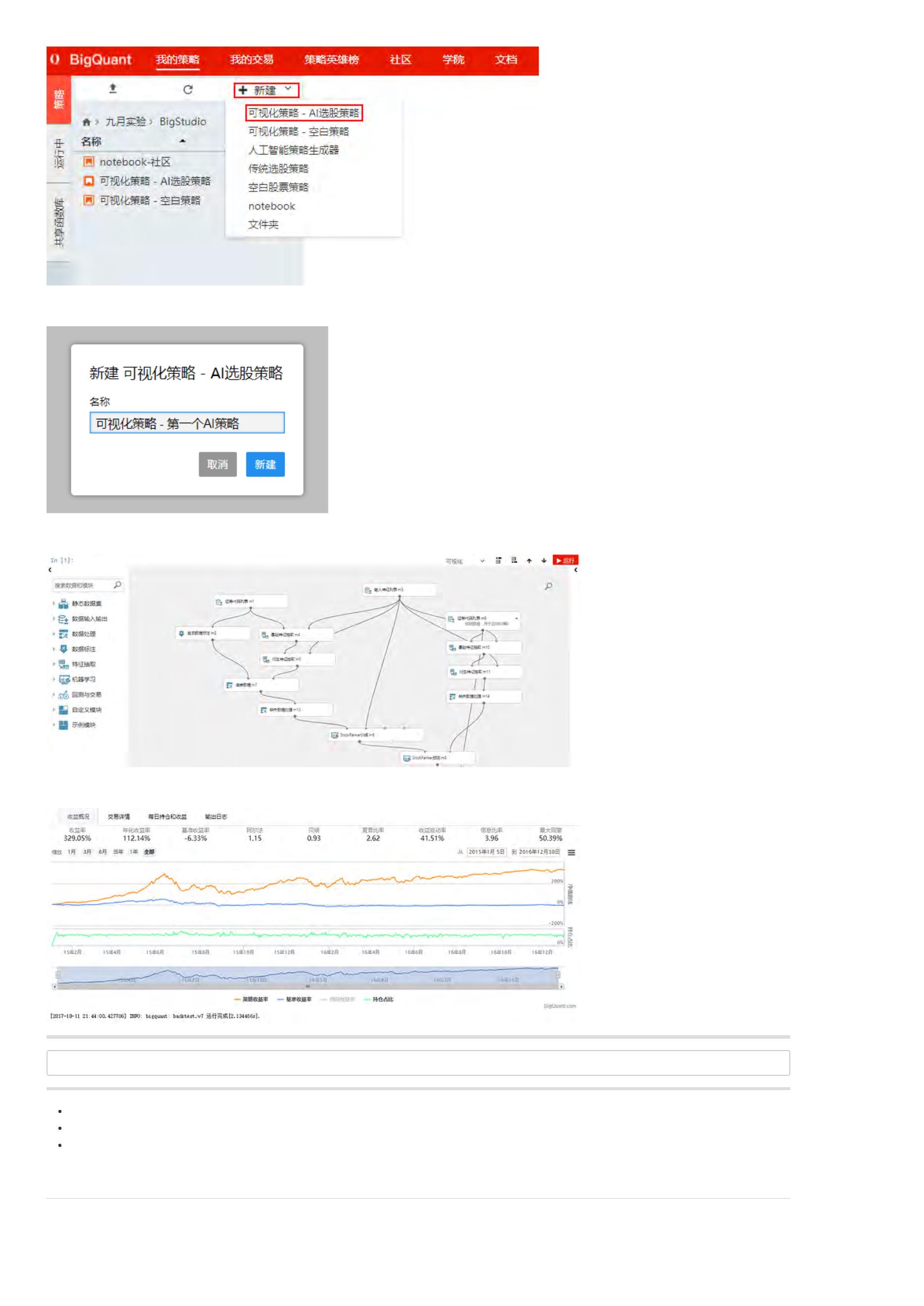

当您第一次进入 “我的策略” 时,即使您不会编程,您也可以根据 用户引导 一步一步的创造您的AI策略:

下面部分是这个引导的每步介绍,如果您已经熟悉,可以跳过下面部分。

1

. 新建策略 > 人工智能策略生成器

点击 新建策略,然后 人工智能策略生成器

2

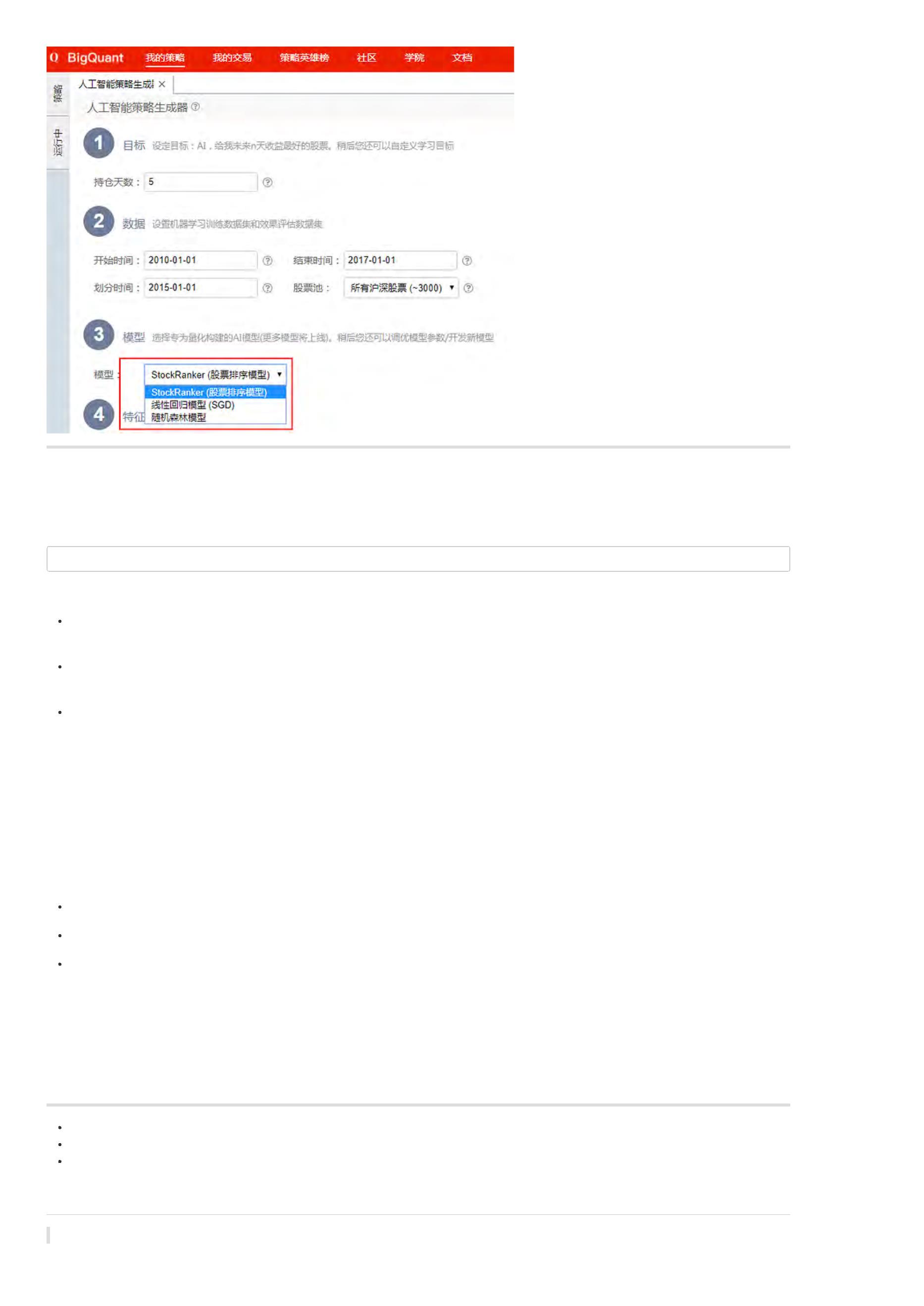

. 策略生成器

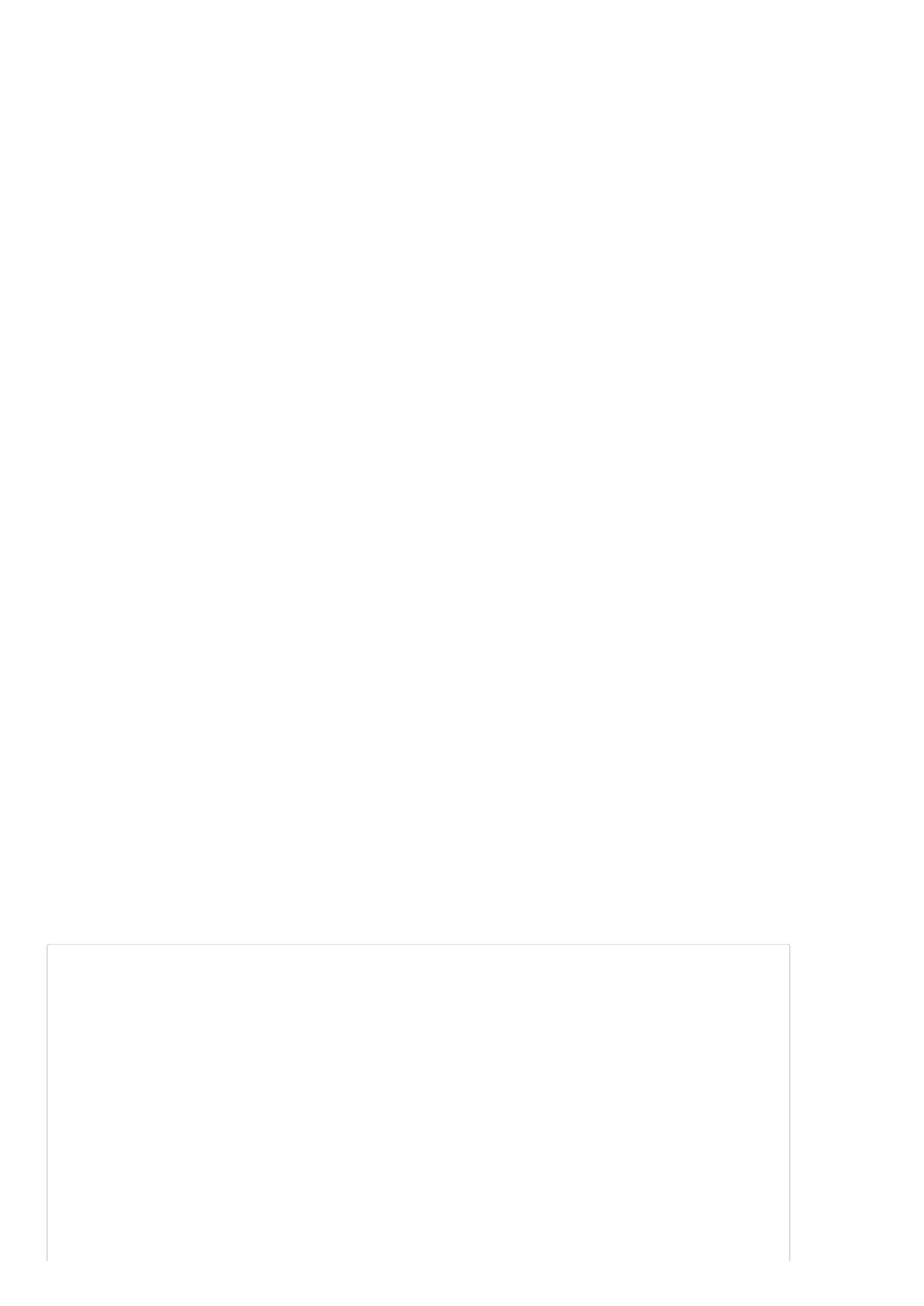

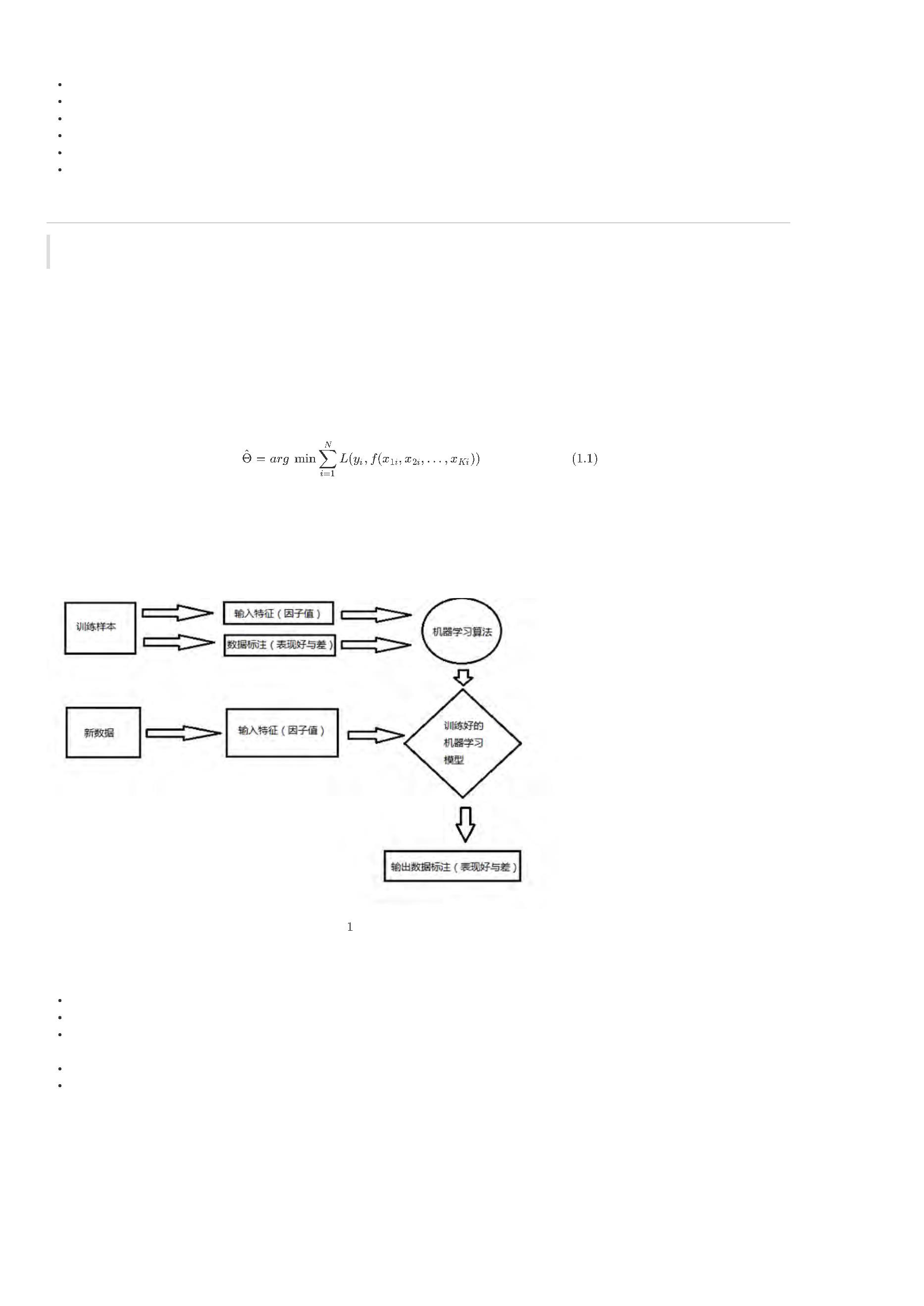

策略生成器如下图:左边是配置界面,右边代码预览。我们通过可以配置 目标、数据、模型和特征等4个方面,来生成不同的策略。

在新手任务里,我们都使用默认参数。

3

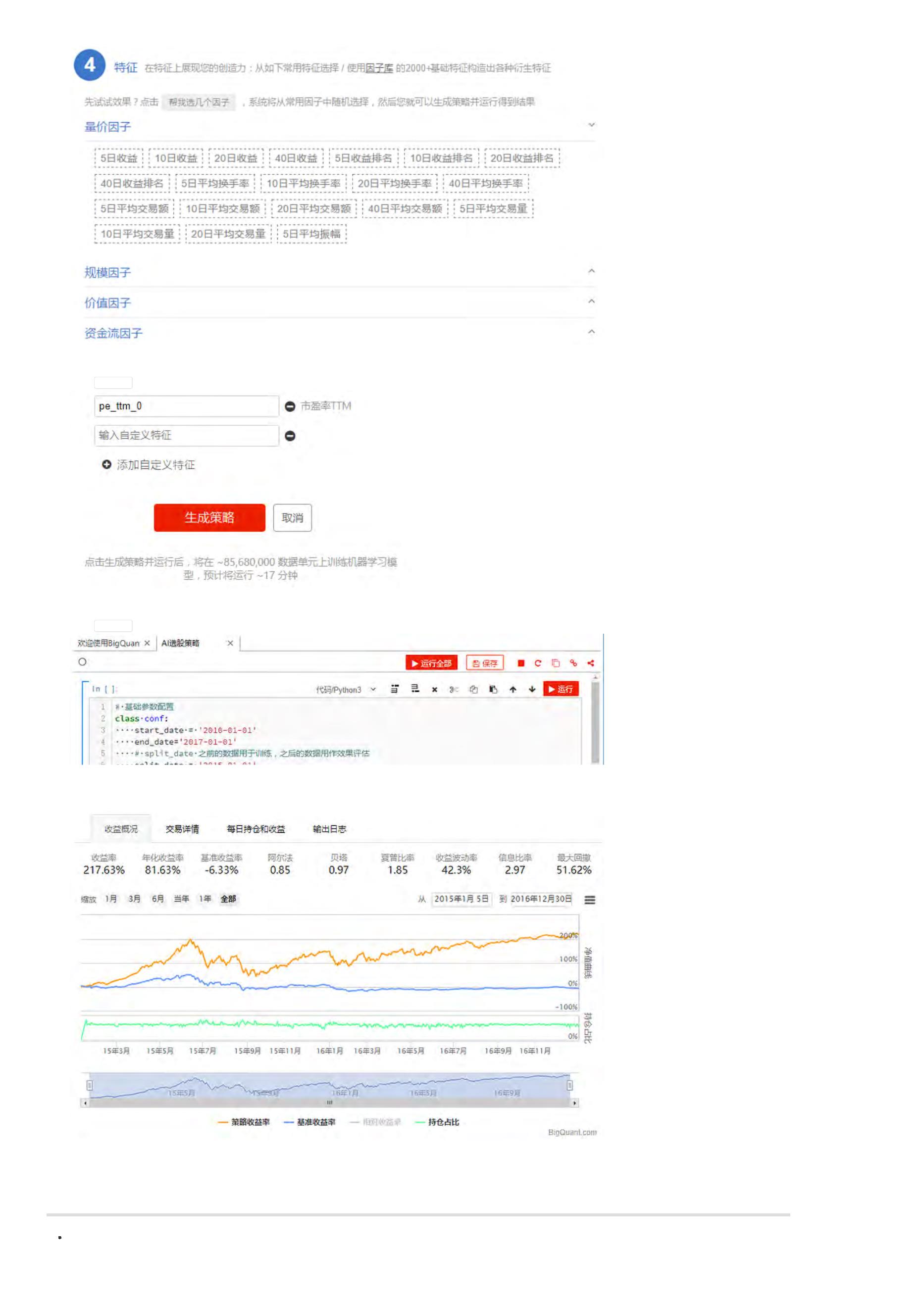

. 选择因子

在 4.特征 里,点击 帮我选几个因子,让系统随机选几个常用因子。

4

. 生成策略

点击 生成策略,自动生成策略代码

5

. 运行策略

点击 运行全部,运行刚才生成的策略代码。等待策略运行完成(这可能要~10分钟)。新手任务数据已经缓存,应该很快就看到结果。

6

. 查看结果

策略最后的回测效果

您的一个人工智能策略 已经创建好了。是不是很简单,而且看起来收益还不错,在2015-2016的总收益达到了 217.63%。除了收益,我们还要看风险,因为

1

5年的股灾,这个策略的回撤也是很大的。这只是一个示例策略,对实际交易不具有指导价值。随着研究的深入,您将会用BigQuant开发出有实盘价值的策

略。

上一页:您的第一个人工智能量化投资策略

下一页:BigQuant人工智能量化平台 vs. 传统量化平台

目录:BigQuant学院

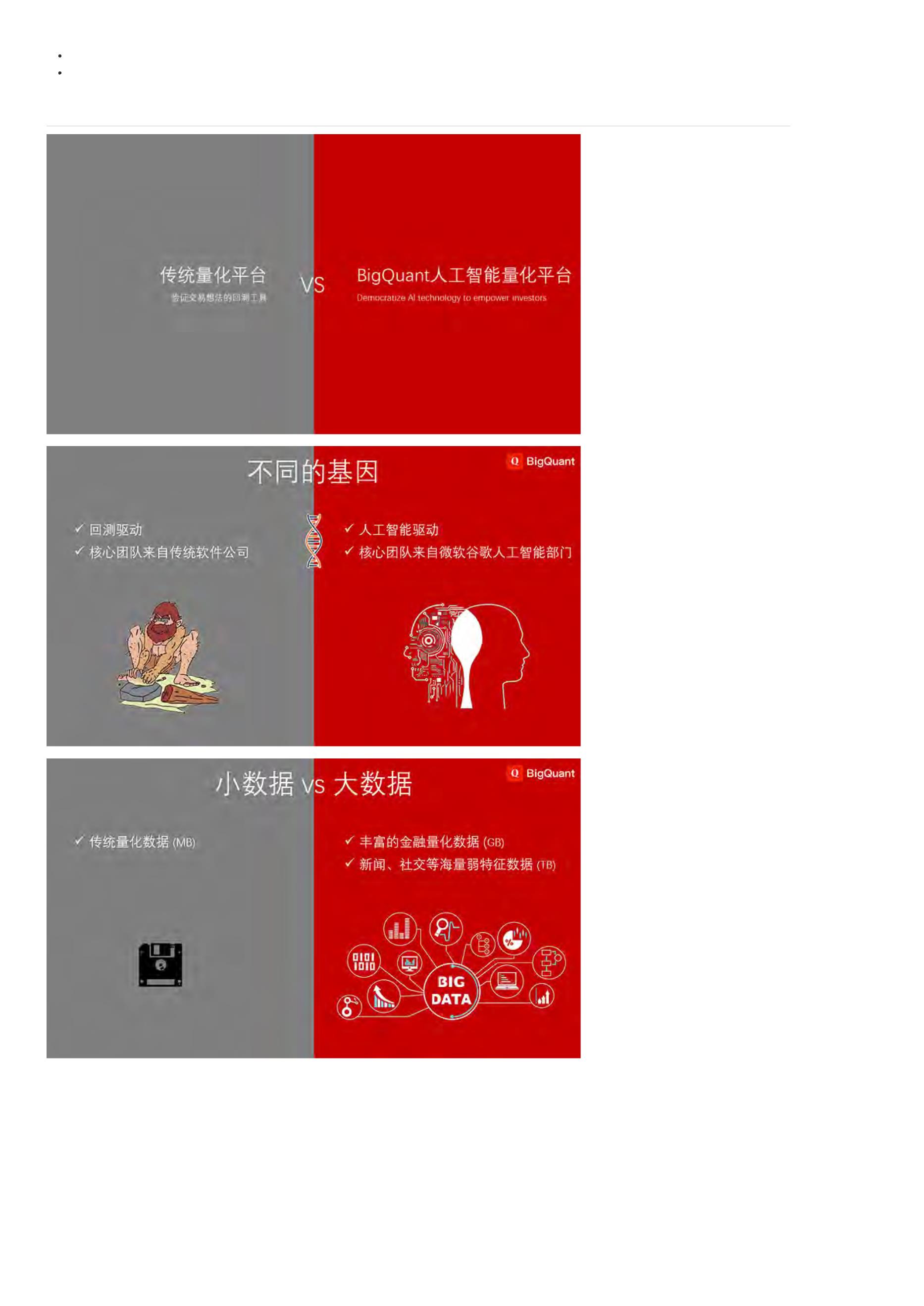

[

量化学堂-新手专区]BigQuant 人工智能量化平台 vs. 传统量化平台

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

上一页:您的第一个人工智能量化投资策略

下一页:什么是人工智能?

目录:BigQuant学院

宽客小学

[

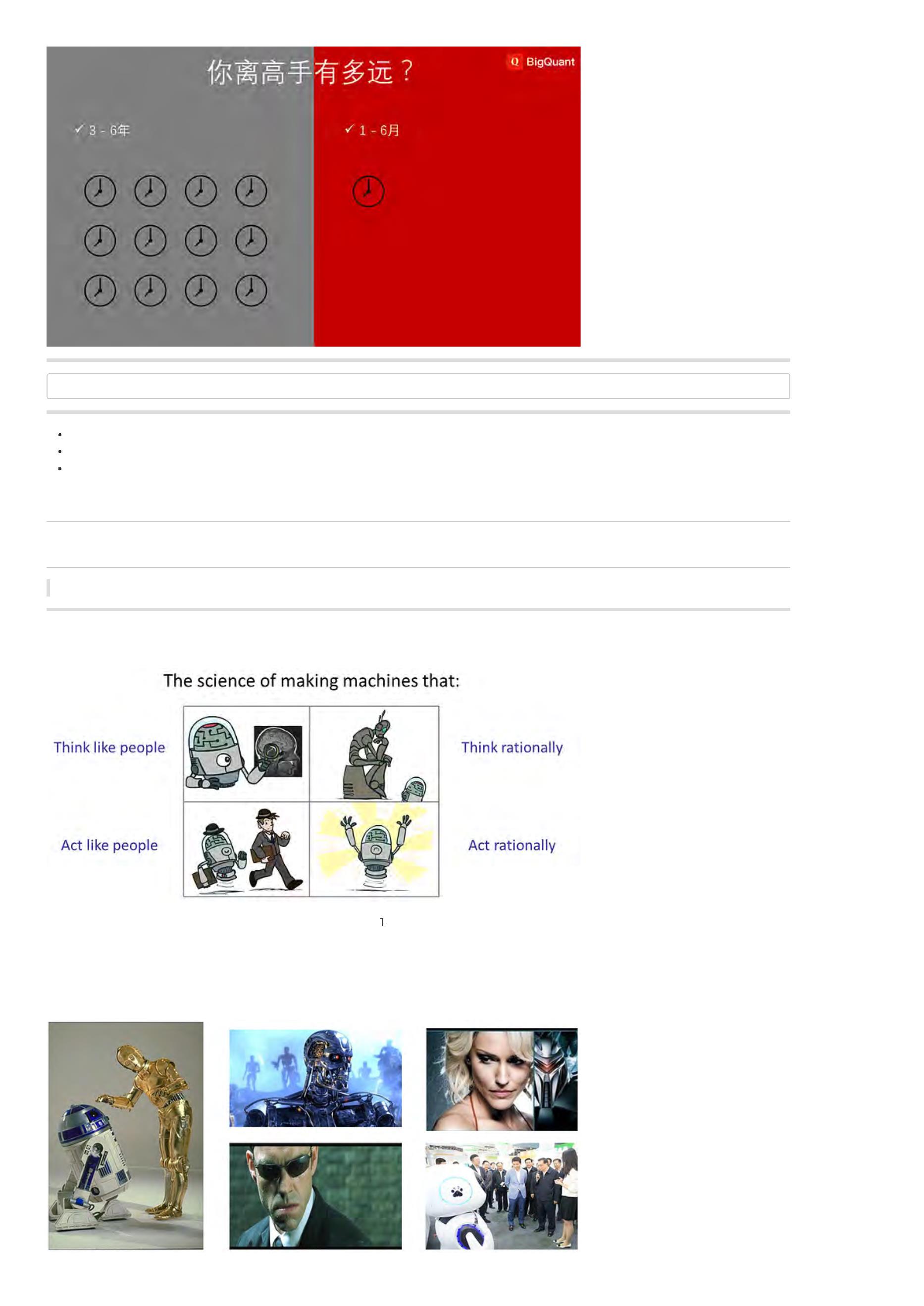

量化学堂-新手专区]什么是人工智能?

导语:谷歌围棋程序AlphaGo全面碾压专业选手,人工智能时代已经来临。

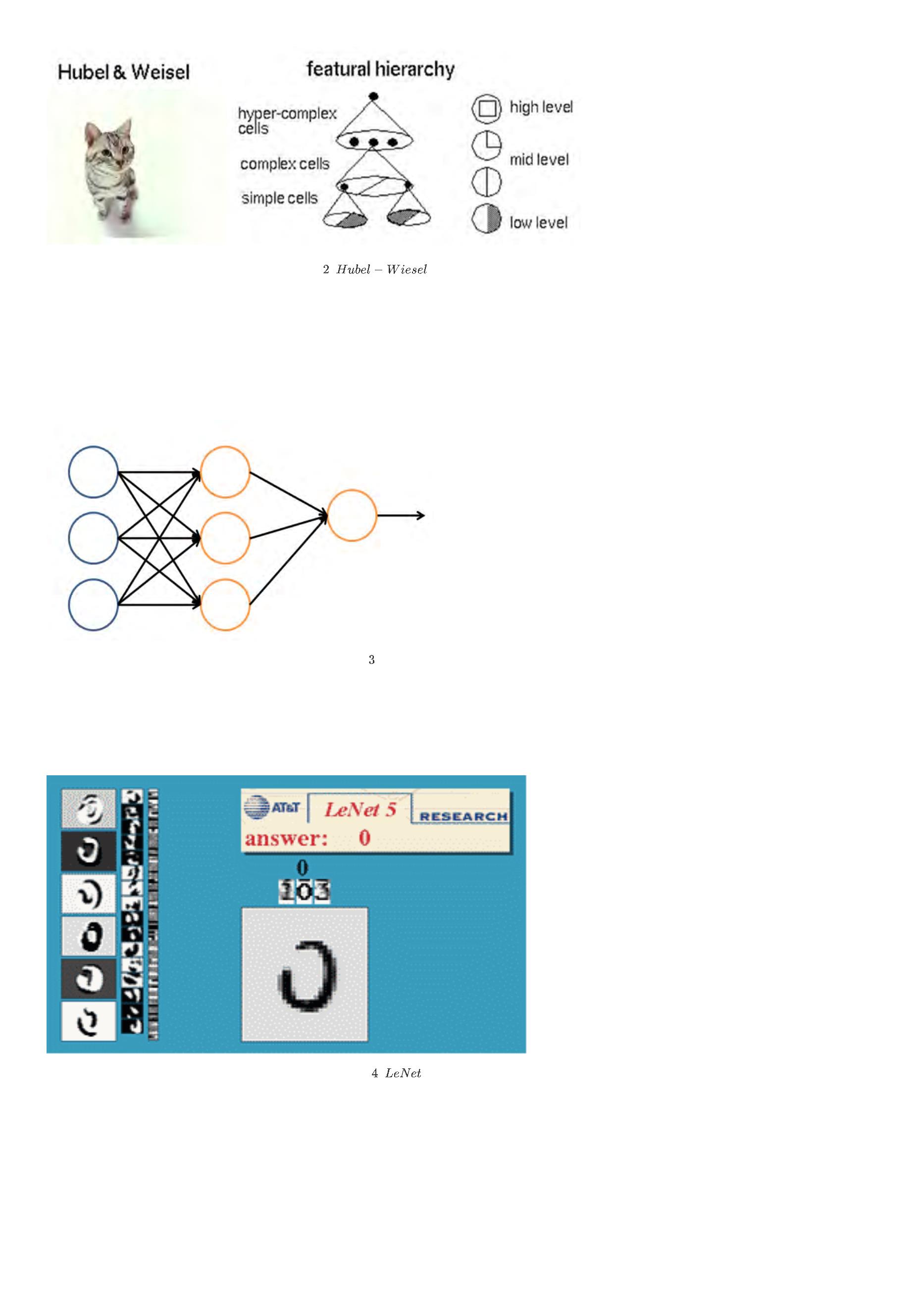

人工智能(英语:Artificial Intelligence, AI)亦称机器智能,是指由人工制造出来的系统所表现出来的智能,可以概括为:研究智能程序的科学 。这门科学

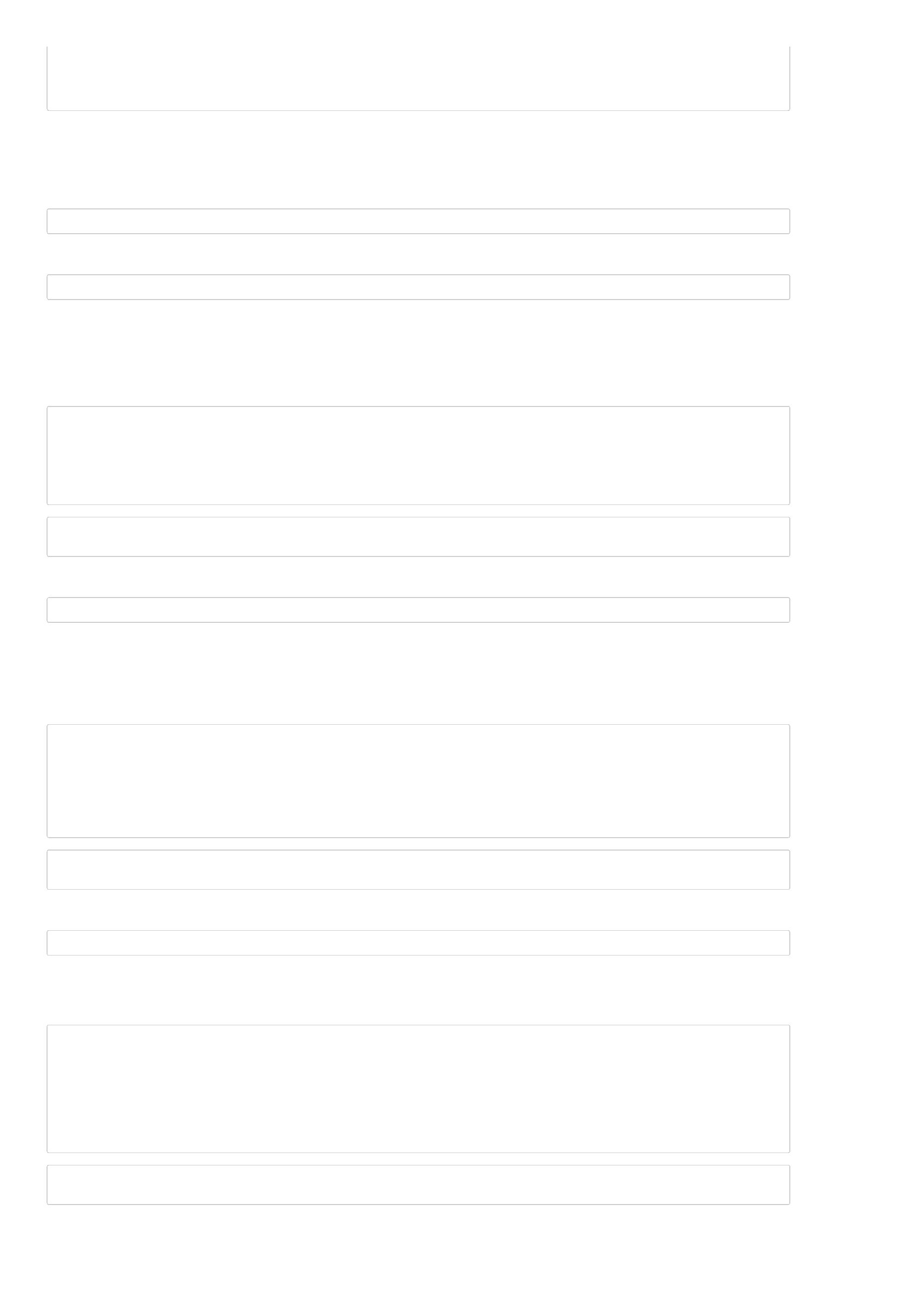

的出发点是 研究如何使程序能够像人一样思考、行为,以及如何保持理性(如图1),这里的理性可以理解为效用最大化。

图

智能程序的科学

人工智能技术(AI)已经渗透到我们日常生活的方方面面,涉及的行业更是不胜枚举,包括游戏、新闻媒体、金融,并运用到了各种领先的研究领域,例如

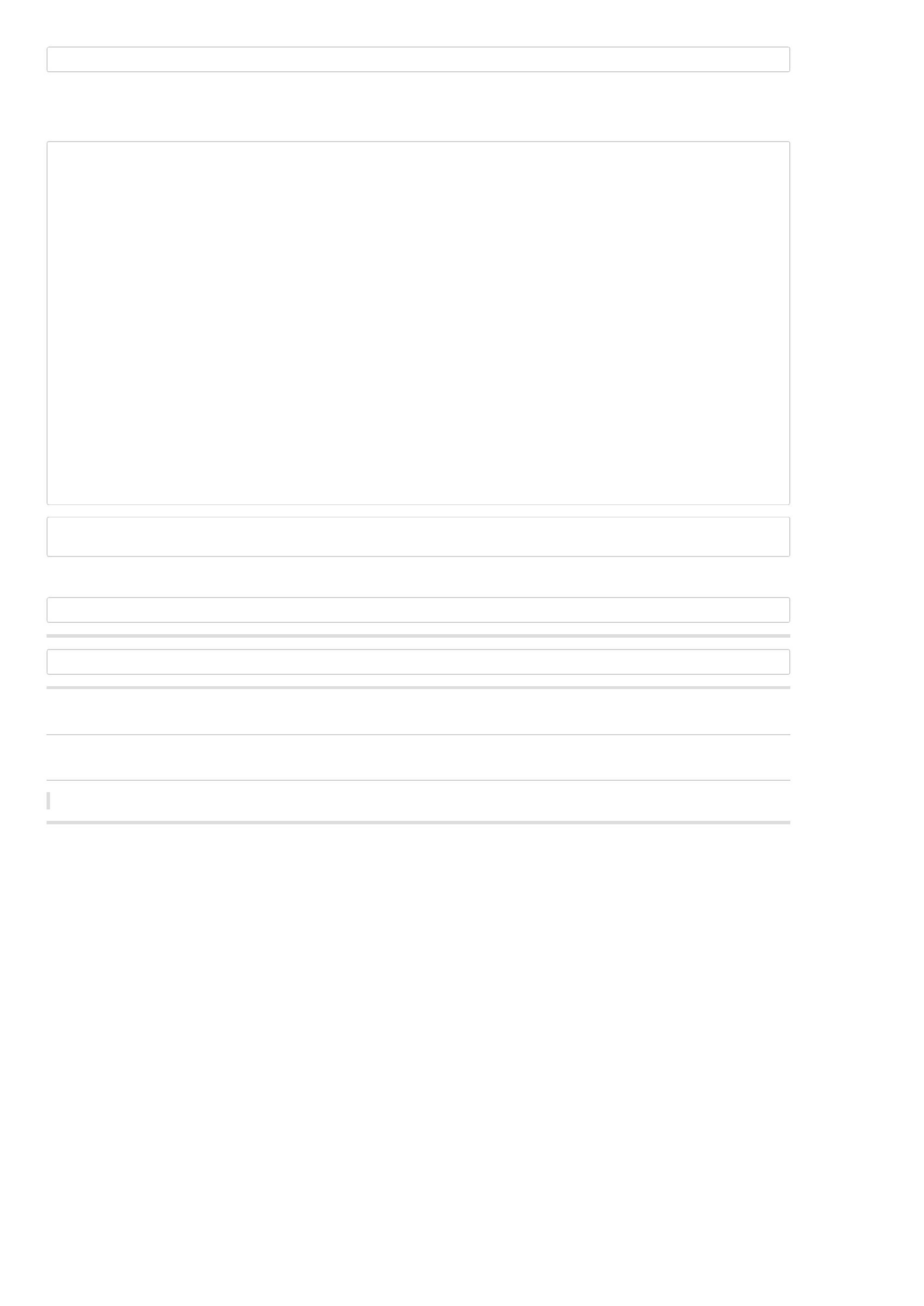

机器人技术、医学诊断和量子科学。人工智能的基本知识和应用领域,主要有机器学习、概率推理、机器人技术、计算机视觉和自然语言处理。图2便展示了

其中的一些基本的应用。

图

人工智能在日常生活中的应用

当今社会的复杂活动,包括图像识别、医学诊断、预测机器故障时间或衡量某些股票的价格,这些行为中往往涉及数千种数据集和大量变量之间的非线性关

系。例如,我们该如何通过编写一系列规则,使得程序能在任何情况下描述出一只狗的外观?如果能将做出各种复杂预测的困难工作,即数据优化和特征

(

Feature)规范,从程序员身上转嫁给程序,从交易员身上转嫁给程序,情况又会怎样?这正是现代化人工智能带给我们的承诺。

AI时代即将来临,正如90年代的互联网时代,只有拥抱变化,顺应趋势,才能跟上时代的步伐。

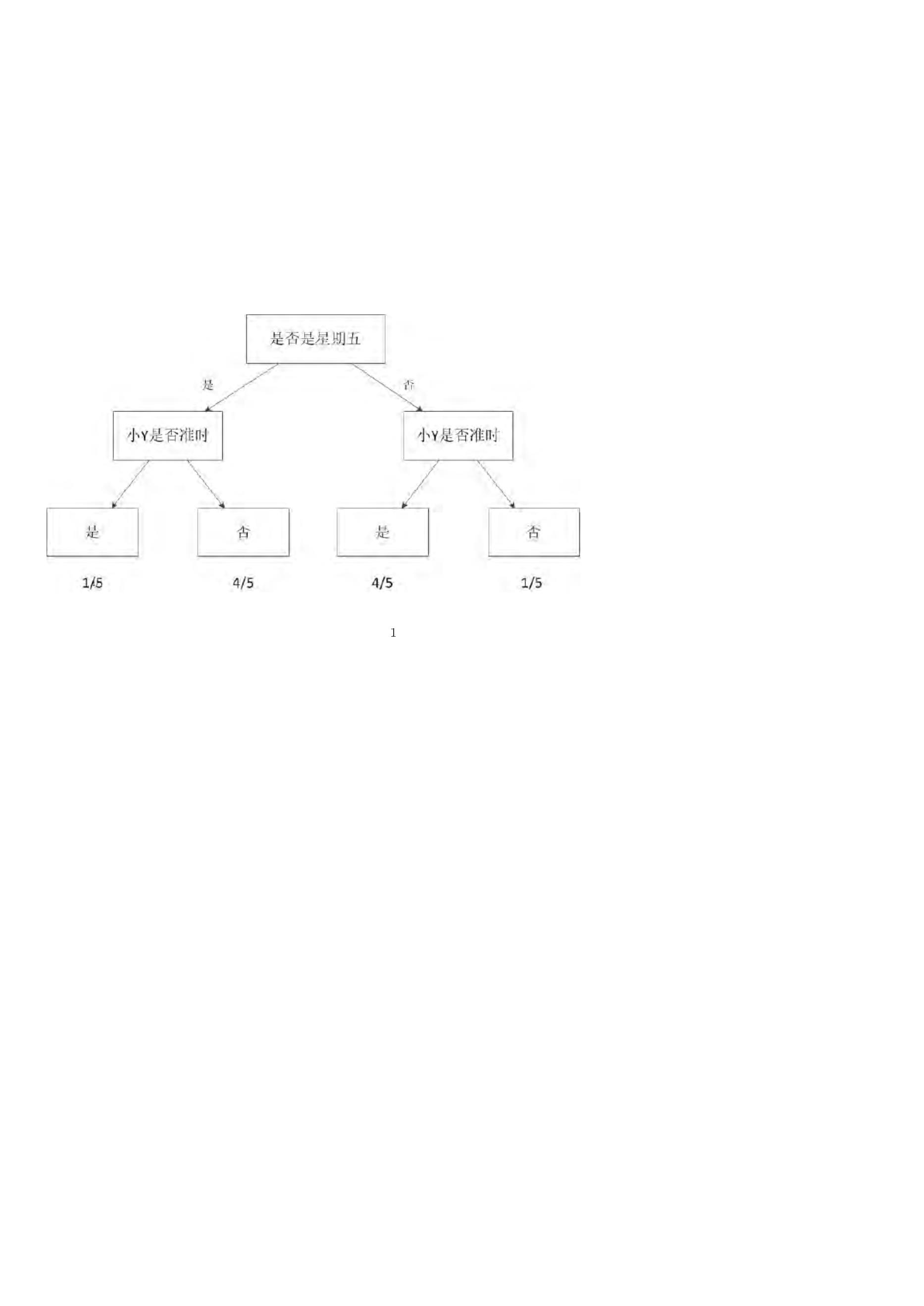

图

人工智能正在进入我们的生活

小结:人工智能是研究如何使程序能够像人一样思考、行为,以及如何保持理性的学科,并以非常迅猛的速度发展,已经渗透到生活的方方面面,只有

拥抱AI,才能跟上时代趋势。

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

扩展阅读

图灵奖设立50年,Raj Reddy & Jeff Dean谈人工智能的发展与未来

上一页:BigQuant人工智能量化平台 vs. 传统量化平台

下一页:什么是量化投资?

目录:BigQuant学院

[

量化学堂-新手专区]什么是量化投资?

导语:了解什么是量化投资,是成为宽客道路上的一块重要的敲门砖。本文为大家初步介绍了量化投资的相关知识,希望在阅读后能帮助新手宽客们更

快起步。

什么是量化投资?

量化投资是指通过数量化模型建立科学投资体系,以获取稳定收益。 在海外的发展已有30多年的历史,其投资业绩稳定,市场规模和份额不断扩大、得到了

越来越多投资者认可。在国内,量化投资不再是一个陌生的词汇,近几年得到了迅猛的发展。

提起量化投资,就不得不提量化投资的标杆——华尔街传奇人物詹姆斯·西蒙斯(James Simons)。视频地址:“横扫华尔街的数学家”

通过将数学理论巧妙融合到投资的实战之中,西蒙斯成为了投资界中首屈一指的“模型先生”。由其运作的大奖章基金(Medallion)在1989-2009的二十年间,平

均年收益率为35%,若算上44%的收益提成,则该基金实际的年化收益率可高达60%,比同期标普500指数年均回报率高出20多个百分点,即使相较金融大

鳄索罗斯和股神巴菲特的操盘表现,也要遥遥领先十几个百分点。最为难能可贵的是,纵然是在次贷危机全面爆发的2008年,该基金的投资回报率仍可稳稳

保持在80%左右的惊人水准。西蒙斯通过将数学模型和投资策略相结合,逐步走上神坛,开创了由他扛旗的量化时代。

价值投资和 趋势投资(技术分析)是引领过去一个世纪的投资方法,随着计算机技术的发展,已有的投资方法和计算机技术相融合,产生了量化投资。

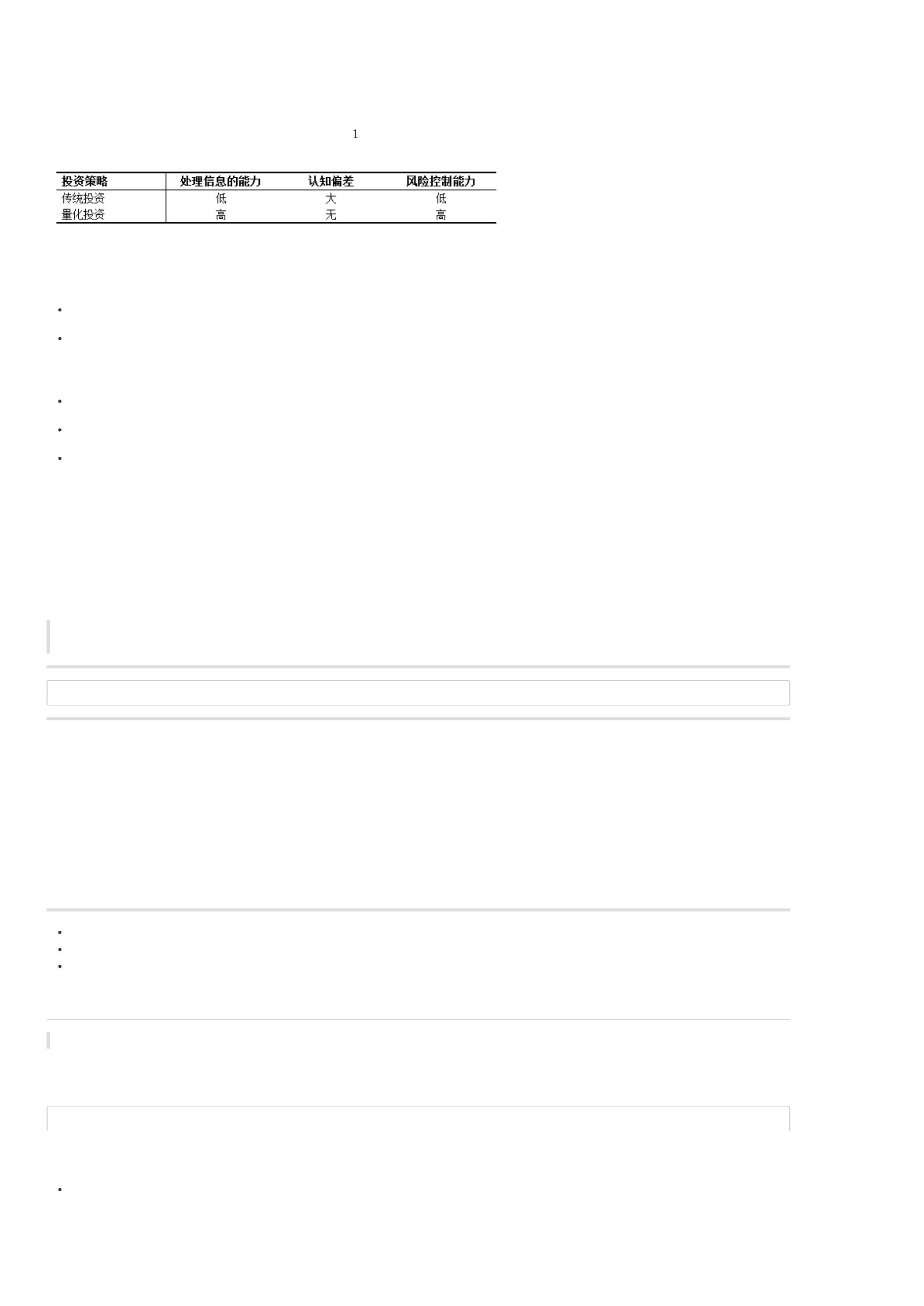

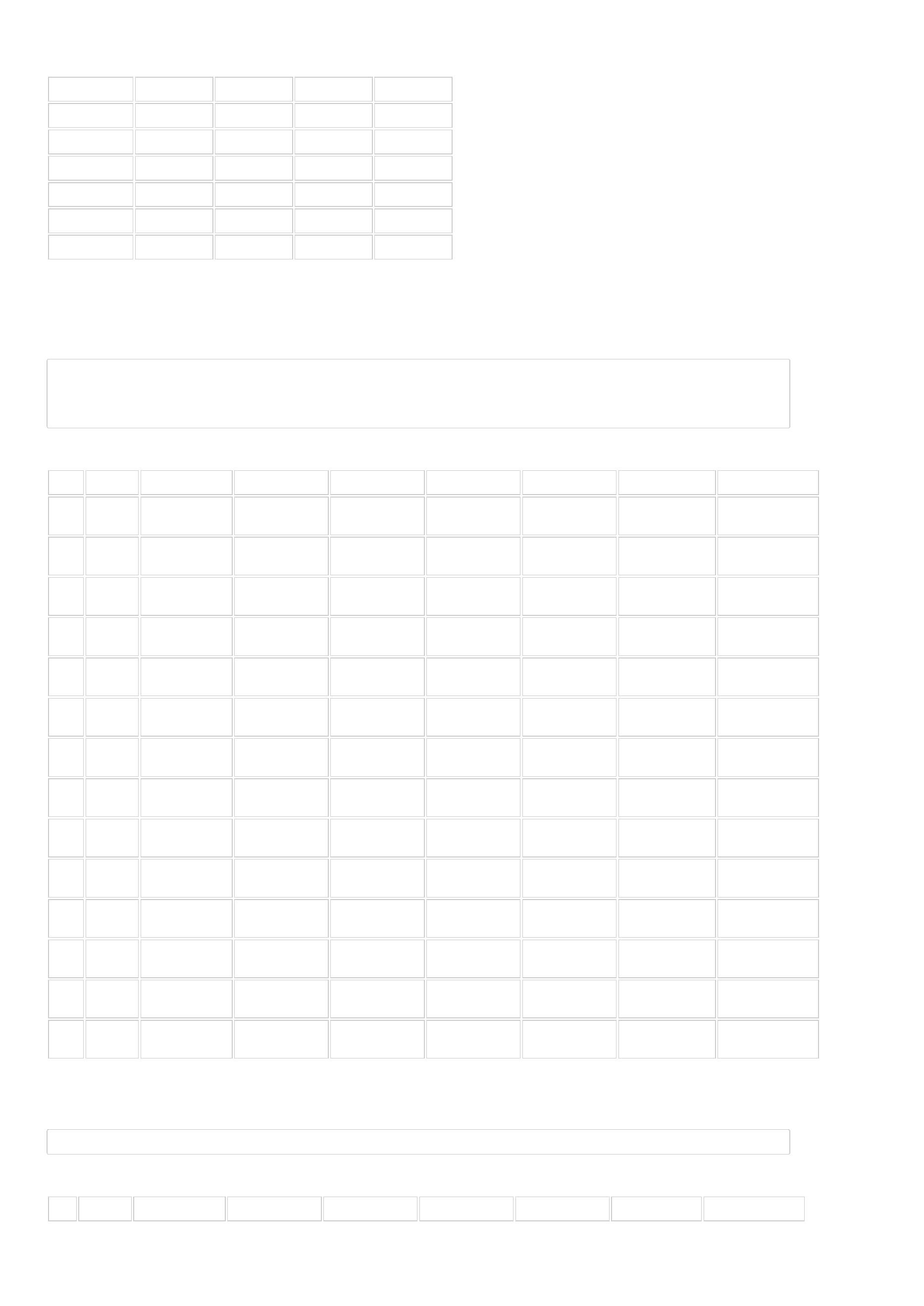

量化投资和传统投资有啥区别?

简单来说,量化投资与传统投资方法之间的关系比较类似于中医和西医的关系。量化投资与传统投资最鲜明的区别就是模型的应用,这就类似于医学上对仪

器的应用。中医主要通过望、闻、问、切等医疗手段,很大程度上借助中医长期积累的经验进行诊断,定性的程度大一些。而西医则不同,西医主要借助于

现代仪器,首要病人去拍片子、打B超、化验等,这些都要依托于医学仪器进行检验,对于各项检查结果有详细的数据评价标准,最后判断症结所在,进而

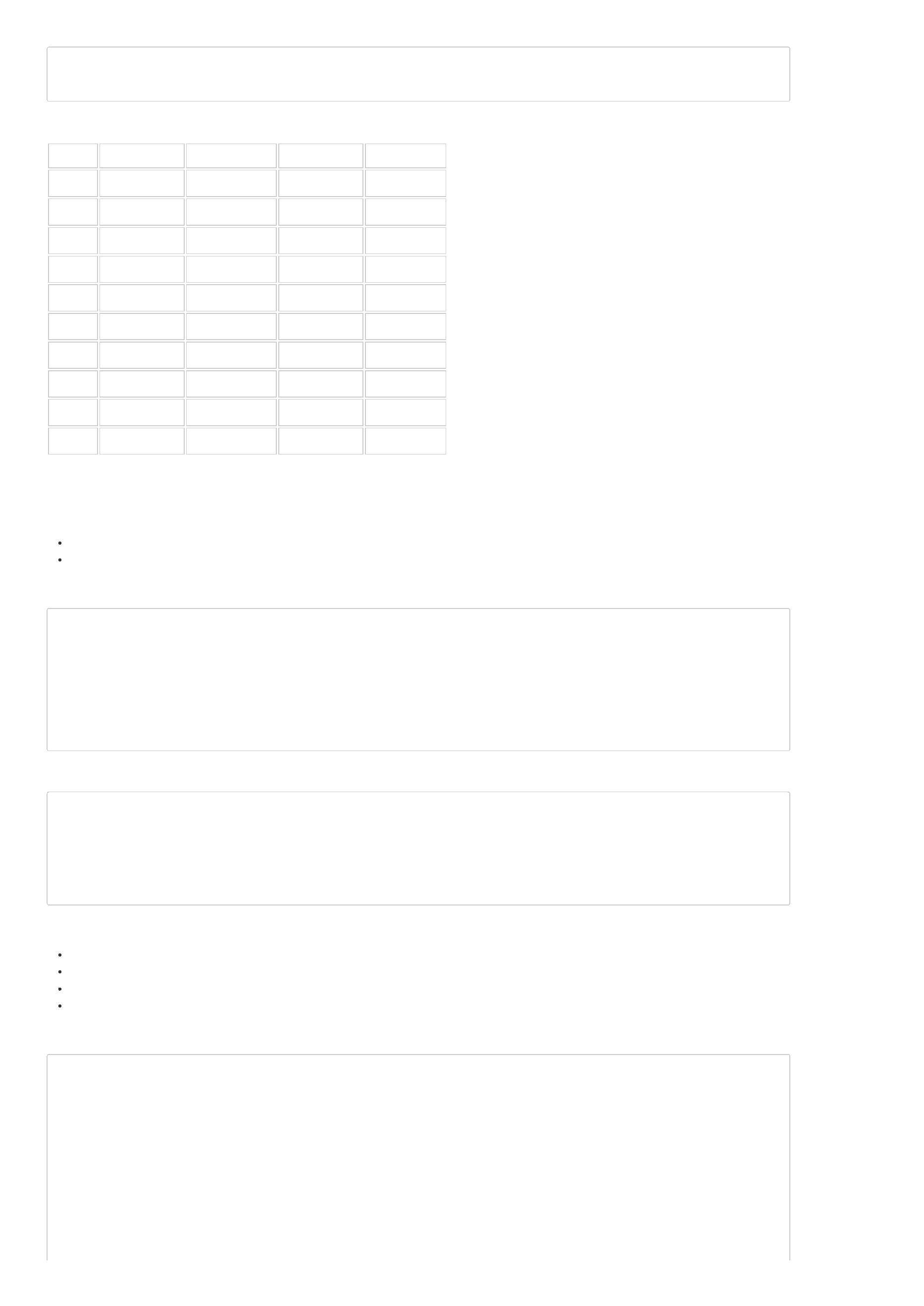

对症下药。具体的比较见表1:

表

传统投资和量化投资的区别

量化投资的有哪些优势?

量化投资的优势在于纪律性、系统性、及时性、准确性和分散化。

纪律性:严格执行投资策略,不是投资者情绪的变化而随意更改。这样可以克服人性的弱点,如贪婪、恐惧、侥幸心理,也可以克服认知偏差。

系统性:量化投资的系统性特征包括多层次的量化模型、多角度的观察及海量数据的观察等。多层次模型包括大类资产配置模型、行业选择模型、精选

个股模型等。多角度观察主要包括对宏观周期、市场结构、估值、成长、盈利质量、市场情绪等多个角度分析。此外,海量数据的处理能力能够更好地

在广大的资本市场捕捉到更多的投资机会,拓展更大的投资机会。

及时性:及时快速地跟踪市场变化,不断发现能够提供超额收益的新的统计模型,寻找新的交易机会。

准确性:准确客观评价交易机会,克服主观情绪偏差,从而盈利。

分散化:在控制风险的条件下,量化投资可以充当分散化投资的工具。表现为两个方面:一是量化投资不断地从历史中挖掘有望在未来重复的历史规律

并且加以利用,这些历史规律都是较大概率取胜的策略;二是依靠筛选出股票组合来取胜,而不是一只或几只股票取胜,从投资组合的理念来看也是捕

捉大概率获胜的股票,而不是押宝到单个股票。

如何进行量化投资呢?

使用量化策略是进行量化投资的有效方式。

通过客观准确的交易规则构建策略,并在历史数据上进行回测,当回测结果通过评估审核后才可以称得上是一个可进行实盘交易的量化策略,许多私募在实

盘之前还有一个模拟交易阶段。

小结:量化投资是指通过数量化模型建立科学投资体系,以获取稳定收益。与传统投资方式不同的是,量化投资更加注重模型的应用,其优势在于纪律

性、系统性、及时性、准确性和分散化。使用量化策略是进行量化投资的有效方式。

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

扩展阅读

量化小课堂-Python&Pandas系列第一讲:当量化投资邂逅Python

上一页:什么是人工智能?

下一页:关于BigQuant

目录:BigQuant学院

[

量化学堂-新手专区]关于BigQuant

欢迎来到BigQuant人工智能量化平台!

BigQuant的目标是成为每一个宽客(Quant)的人工智能量化投资平台和社区。我们是首个专注量化投资的人工智能/机器学习平台。在这里,量化投资者可

以无门槛的使用最领先的人工智能技术。我们致力于用人工智能助力宽客,让投资变得更有效更简单。

We are democratizing AI technology to empower investors

BigQuant 有哪些特点?

领先的人工智能技术

首个专注量化投资的人工智能/机器学习平台,在这里,用户可以自由使用全球最受欢迎的Tensorflow、Keras、Theano、XGBoost、Sklearn等人工智能相关

模块,无门槛的使用最领先的人工智能技术开发策略

便利的云端研究平台

高性能的云计算服务器集群,提供在线的Notebook云端研究平台,采用Docker技术隔离,资源独立、安全性更高、性能更好

高质量的数据

我们拥有2005年至今完整的行情数据、上市公司财务数据及1600个以上的特色因子数据,每年投入百万用于数据购买、加工和存储上

顶尖的回测体验

支持全市场所有类型策略进行回测,回测速度超快,展示结果特别丰富,界面友好

精准的实时模拟交易

策略由实时行情驱动,运行结果和实盘结果高度吻合,除了不是真钱在跑,其他都和实盘一样,大大提高策略验证效率,让您的策略上线时成竹在胸

量化交流社区

我们为量化爱好者提供线上交流社区,便于用户交流量化策略、学习量化知识,一起成长

众包基金

如果你是学生,参加平台量化策略大赛,赢取奖金、实习和工作机会

如果你是宽客,我们会定期选拔好的策略和宽客进入我们的基金管理项目进行孵化

如果你是机构,可以通过我们的平台对接好的策略,帮你实现多策略布局

我们的团队

BigQuant核心团队主要毕业于清华、北大、中科大等,10+年微软、腾讯、小米和国内知名量化私募等工作经历,拥有丰富的互联网大数据/机器学习从业经

验和资深的量化投资经验。

常见问题

知识产权和安全保护

BigQuant 收费吗?

BigQuant量化交易平台是为量化爱好者、宽客量身打造的云平台,我们提供的服务均免费。 我们免费为您提供高质量数据、顶级回测服务、顶尖模拟交易、

量化交流社区、IPython Notebook研究平台,便于您快速实现、使用自己的量化交易策略。

策略归谁所有?

策略是每个宽客最宝贵的财富,您全权拥有在BigQuant中研究成果的知识产权。BigQuant不会也无法查看、公布您的策略、代码、数据,但您可以主动在社

区公布分享。

我的策略是否安全?

我们非常严肃对待用户的策略安全问题。我们提供业界最高的安全保护,通过https传输、加密存储、沙箱保护保障您的策略安全,除了您本人,任何人无法

获取您的策略。

联系我们

欢迎 社区内 私信 @bigquant 和我们交流

如果您有任何疑问,请发邮件到 i@bigquant.com 或者加QQ群 625326167告诉我们,谢谢。

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

上一页:什么是量化投资?

下一页:聊一聊策略生成器

目录:BigQuant学院

[

量化学堂-新手专区]聊一聊策略生成器

导语:一个好的策略是量化投资成功的关键,本文介绍了BigQuant平台的策略生成器,帮助编程基础薄弱的用户生成策略。

什么是策略生成器?

量化策略的开发一般离不开编写代码,BigQuant平台使用的策略开发语言为Python,如果会写代码,那么策略开发上手就比较快。为了满足一些编程基础薄

弱的用户能够快速上手,因此推出了策略生成器这一大“神器”。通过策略生成器,你可以通过菜单化操作来一键生成策略代码。

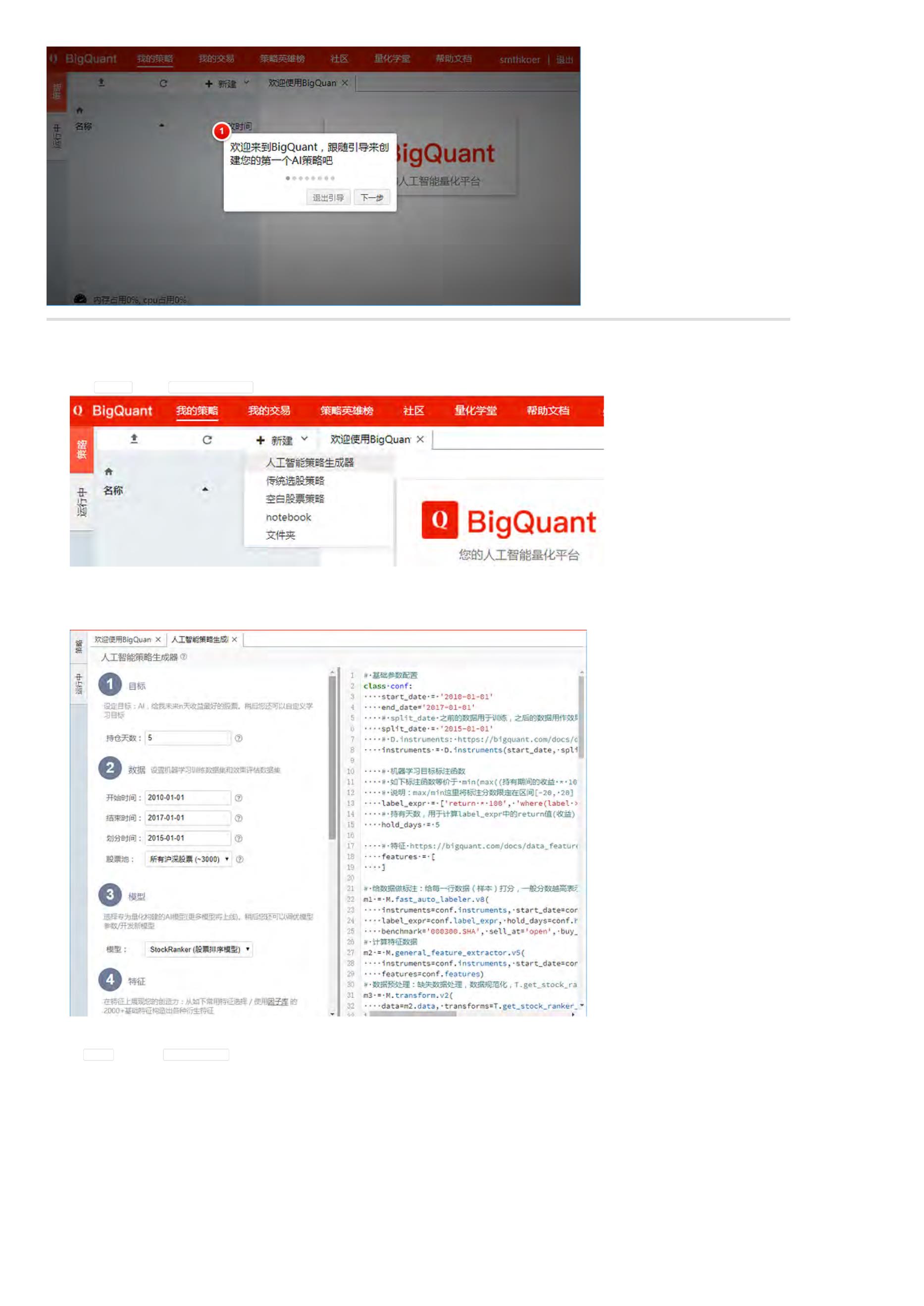

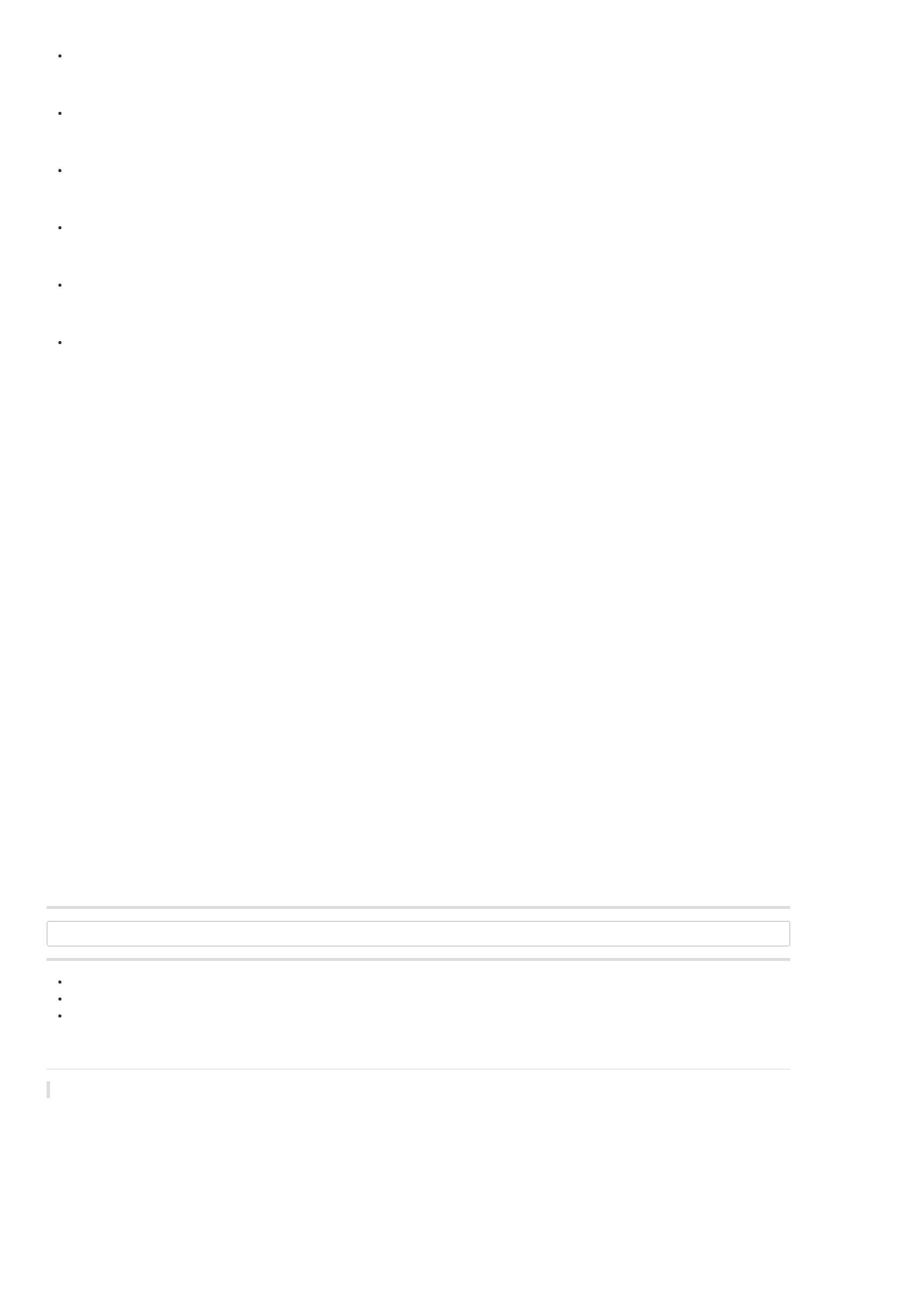

在BigQuant策略平台点击 新建 按钮,就可以打开 人工智能策略生成器 界面(如图1):

图

策略平台生成人工智能策略

策略生成器的界面如图2:

图

策略生成器界面

可以看出,左侧是菜单操作页面,右侧是代码生成页面。你可以在左侧页面,通过菜单化的方式构建你的策略思想,比如勾选特征 上市板(list_board_0),

一旦勾选该特征以后,我们发现,右侧的代码里,变量 features 中会增加 list_board_0 ,于是我们就可以很方便地使用菜单化的方式来形成策略代码。

点击 生成策略 以后,完整的策略代码如图3:

图

生成器默认策略

策略生成器的定位是什么?

策略生成器的目标是引导编程薄弱的用户快速上手,因此定位就是 帮助其快速上手、快速开发AI策略,使用户对BigQuant的策略平台和AI策略有一个初步简

单的认识。当用户有一定的认识之后,策略生成器扮演的角色不再那么重要。

如何使用策略生成器?

通过一个例子来介绍,如何使用策略生成器开发AI策略。

1

. 进入 我的策略

在 BigQuant 首页,点击 我的策略(如图4)

图

我的策略

2

. 新建策略 > 人工智能策略生成器

点击 新建策略,然后 人工智能策略生成器(如图5)

图

人工智能策略生成器

3

. 策略生成器

策略生成器如图6:左边是配置界面,右边代码预览。我们通过可以配置 目标、数据、模型和特征等4个方面,来生成不同的策略。

这里使用默认参数。

图

策略生成器默认参数

4

. 选择因子

在 4.特征 里,点击 帮我选几个因子,让系统随机选几个常用因子。(如图7)

图

选择因子

5

. 生成策略

点击 生成策略,自动生成策略代码。(如图8)

图

生成策略

6

. 运行策略

点击 运行全部,运行刚才生成的策略代码。等待策略运行完成(这可能要~10分钟)。新手任务数据已经缓存,应该很快就看到结果。(如图9)

图

运行策略

7

. 查看结果

效果如图10

图

结果查看

会用策略生成器,做量化还差什么?

要开发好的策略光会使用策略生成器还远远不够,还需要以下几块知识。

、了解 AI

1

因为要开发AI策略肯定要对AI、机器学习、深度学习有一定的了解,比如,必须要知道AI算法的逻辑是什么?什么是损失函数?如何避免过拟合?怎样提高算

法的预测能力?如何做特征工程?这些具体的问题直接关系到你的模型的预测性能。

2

、熟悉 平台回测

在BigQuant上开发策略需要进行回测验证,那肯定需要熟悉BigQuant的回测机制和回测函数,比如,我如何设置交易成本、如何下单、如何查询持仓和订

单,熟悉BigQuant回测才能得心应手的开发策略。

3

、会 python

很简单,策略平台采取python语言,把想法转化成代码离不开python编程基础。

、懂 量化

4

量化不仅仅包括选股,还涉及择时、仓位控制、资金管理、权重优化等知识,因此要得懂量化。

要成为策略高手,光会策略生成器还远远不够,你还得掌握上面这四大技能。路漫漫其修远兮,继续加油吧:relaxed:

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

上一页:关于BigQuant

下一页:BigQuant策略平台使用帮助

目录:BigQuant学院

[

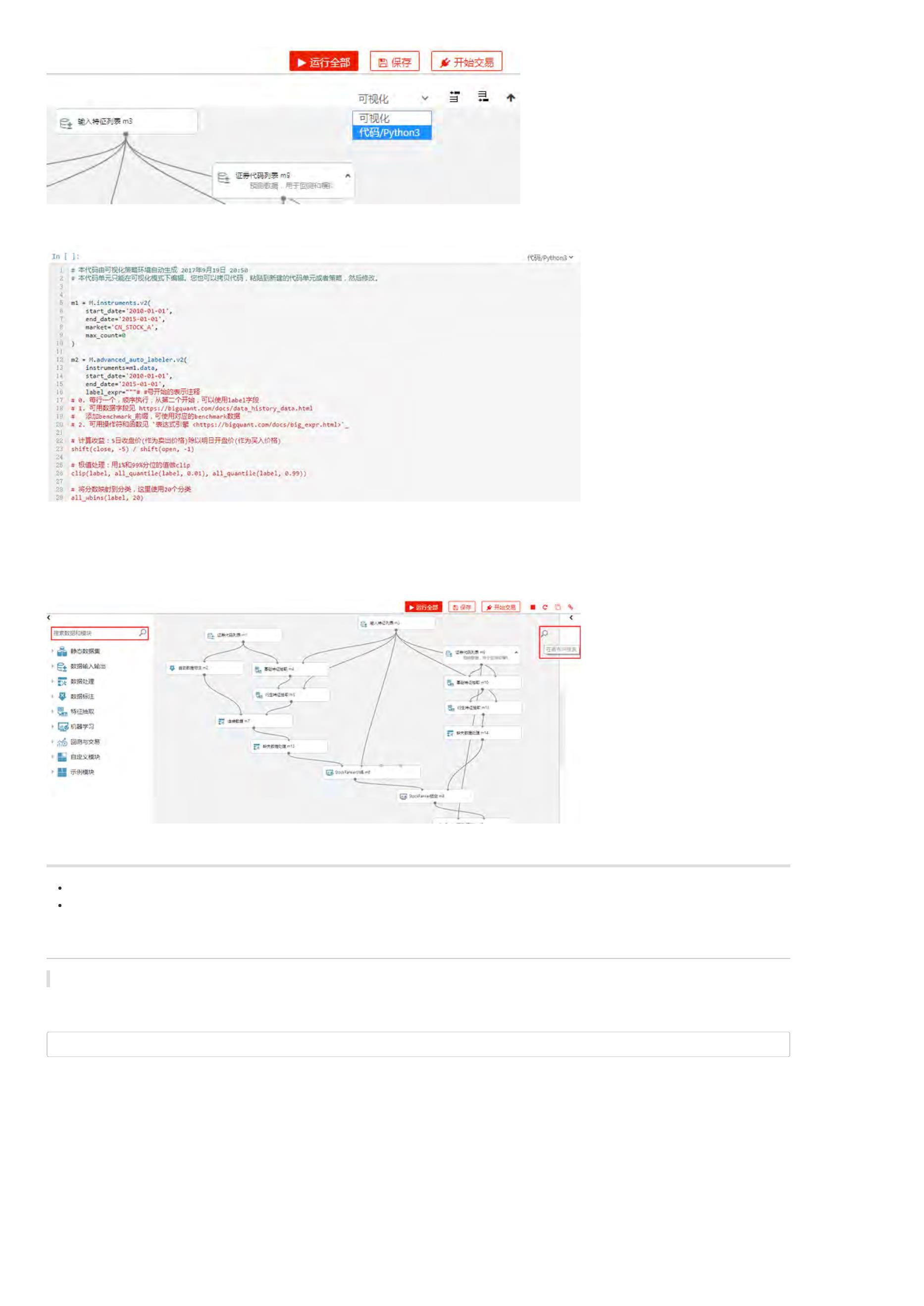

量化学堂-新手专区]BigQuant 策略平台使用帮助

导语:BigQuant策略平台是开发试验、研究策略的重要场地,了解平台使用帮助能更快速、更高效地进行试验研究!

策略平台简介

在主页点击 我的策略就直接进入BigQuant策略平台。

图

我的策略

BigQuant策略平台有多强大,从图2中就可以知道。

图

策略平台简介

BigQuant 策略平台基于IPython Notebook,Notebook 是您进行量化研究、策略开发、文档编写的集成开发环境。

注意,Notebook 这个术语既可以指研究环境,也可以代表具体的 Notebook 文件。

BIgQuant策略平台采用 Docker 技术隔离,资源独立、安全性更高、性能更好。

每一个 Notebook 由多个 Cell 单元格组成,Cell 单元格可以有2种不同的运行模式。采用输入与输出混排的交互方式,让您的研究过程 所见即所得。

代码/Python3 模式:您可以在这个模式下进行数据获取、统计分析、金融建模、定价分析等量化研究工作。

文档/Markdown 模式:您可以以 Markdown 格式编写文档,进行研究或策略的相关说明。

支持哪些Python 库

在量化研究中,需要进行很多数据操作或者科学计算,这就需要借助各种类型的 第三方库。研究功能支持导入第三方库,您可以根据需要引入。BigQuant提

供了丰富的金融计算类库,包括数据获取、策略回测、金融计算等功能。除此之外,还借助 Python 的强大库体系,为您提供全方位的研究服务。

我们支持所有Python标准库,您可以通过import的方式进行引入, 图3中列出了一些常用的库:

图

策略平台支持的

库

您可以在Notebook中输入下方代码引入相关模块,比如引入 Pandas DataFrame 模块的方法:

from pandas import DataFrame

data = DataFrame()

如果您需要列表之外的 Python库,请发送邮件到 i@BigQuant.com 联系我们,为您进行扩展。

如何编写策略

策略算法具体描述了进行量化交易的信号生成条件和订单委托方法,是进行量化研究和量化交易的基础。

BigQuant提供了完整的策略框架,包括获取历史数据、订单委托、订单撮合等基础策略功能,方便您进行策略的编写。

关于BigQuant策略编写API,请查看 策略开发文档

您可以在 Notebook 中进行策略回测,对策略的历史表现进行细致的考察,相关的帮助您可以查看:

关于BigQuant回测框架的原理与机制,请查看 BigQuant回测机制。

如何编写文档(Markdown )

您可以在 Notebook 中创建文档类型的单元,该单元格支持使用 Markdown 语法进行文档写作。

您可以使用 Markdown 文档、LaTeX方程或者代码等丰富的形式自由编写文档内容。

Markdown 是一种轻量级的标记语言,由于它简单的语法、少量的标记符号,学习成本非常低,被越来越多的文档编写人员、写作爱好者所广泛使用。一单

掌握了它的语法规则,会有一劳永逸的效果。

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

上一页:聊一聊策略生成器

下一页:BigQuant AI策略详解

目录:BigQuant学院

BigQuant AI 策略详解

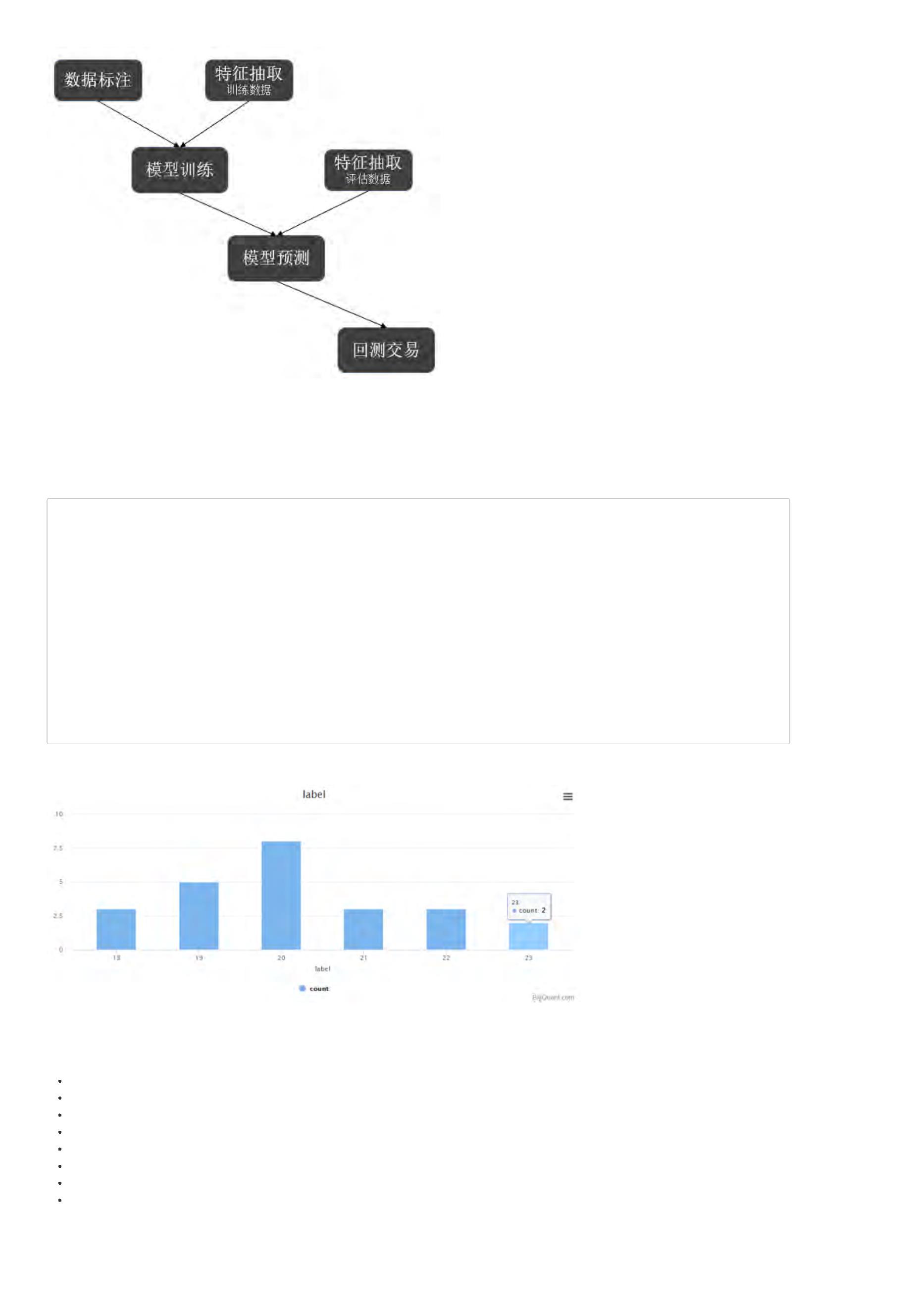

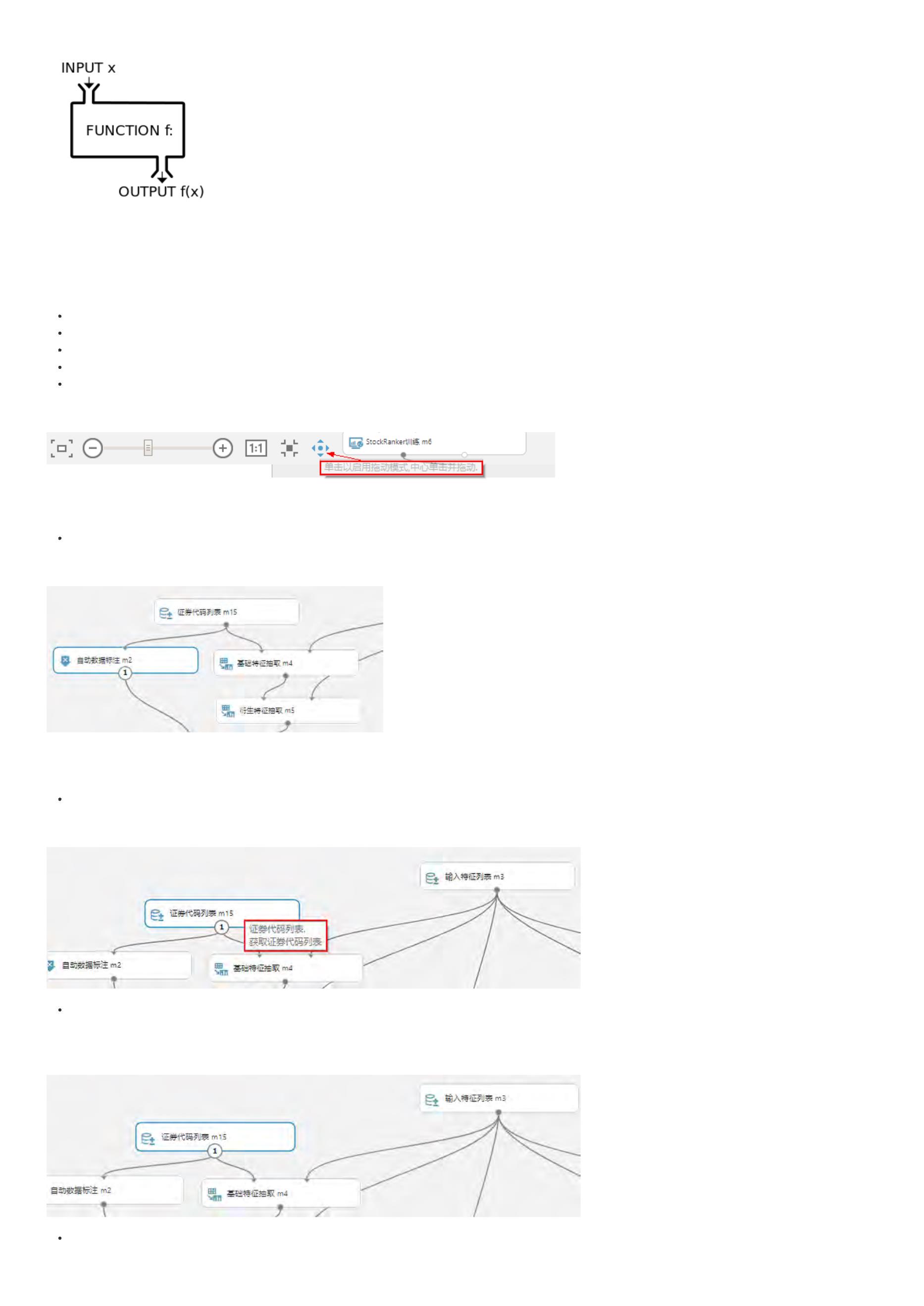

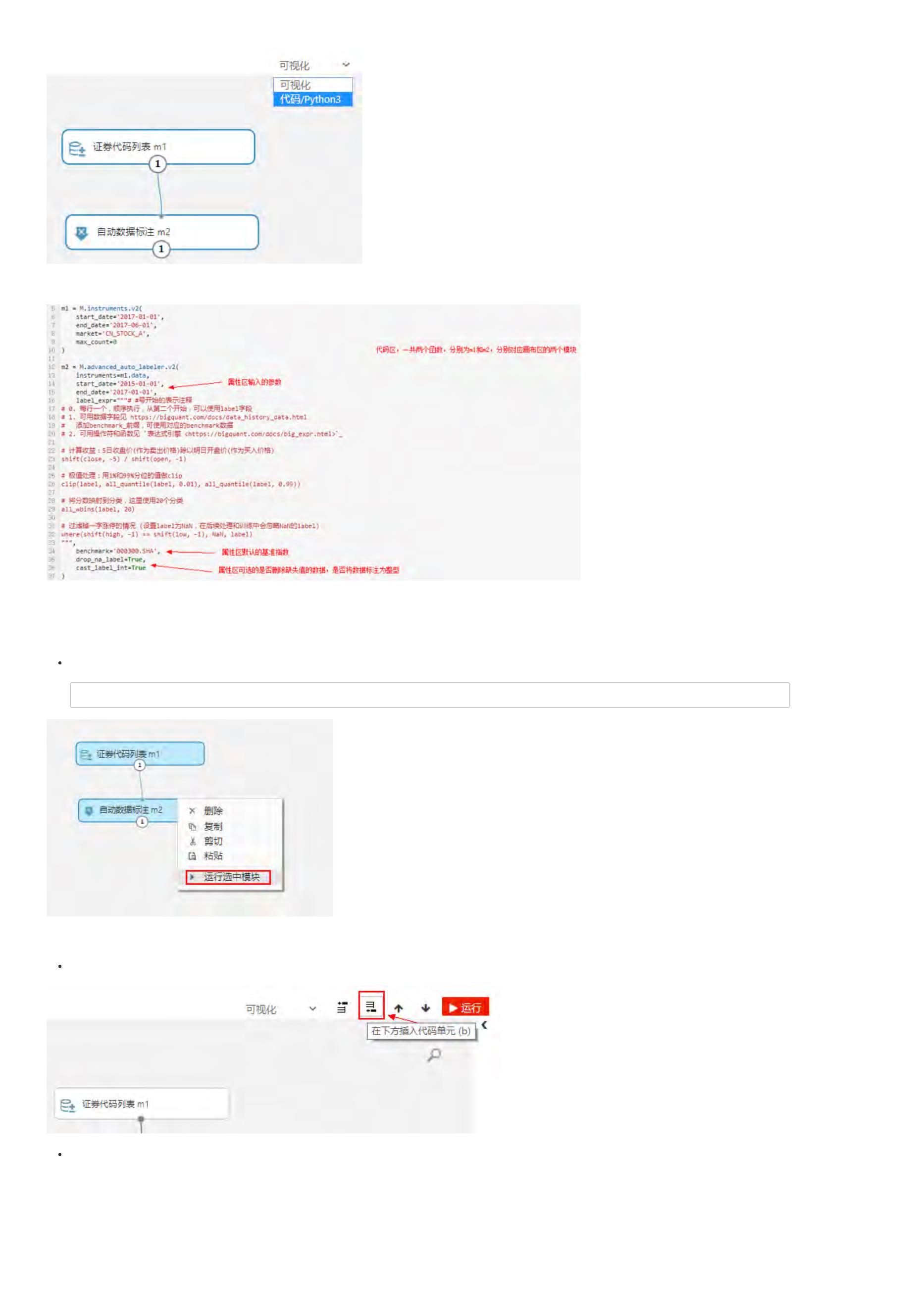

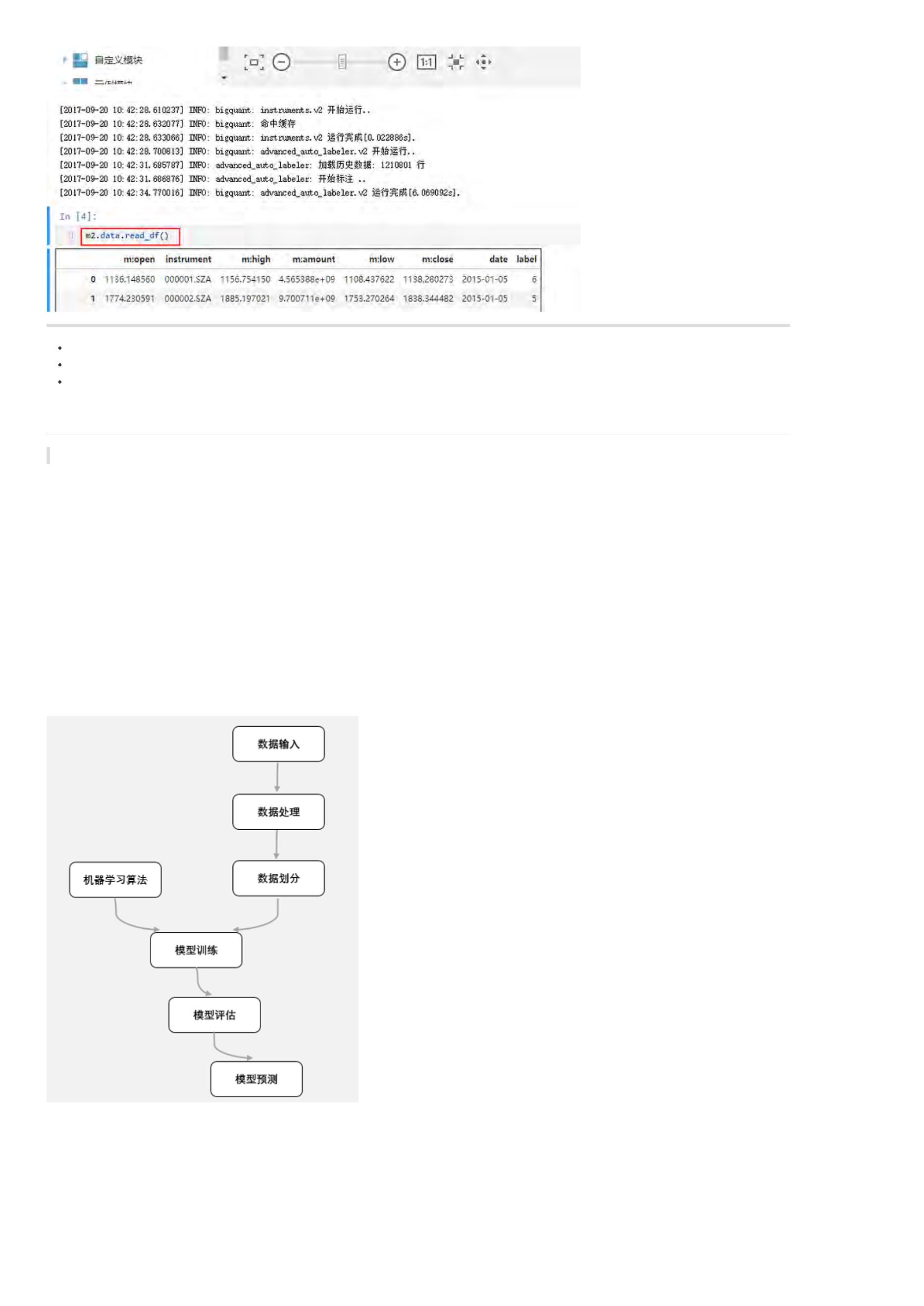

前面我们通过策略生成器,得到了一个AI策略,我们来详细解读一下生成的代码。

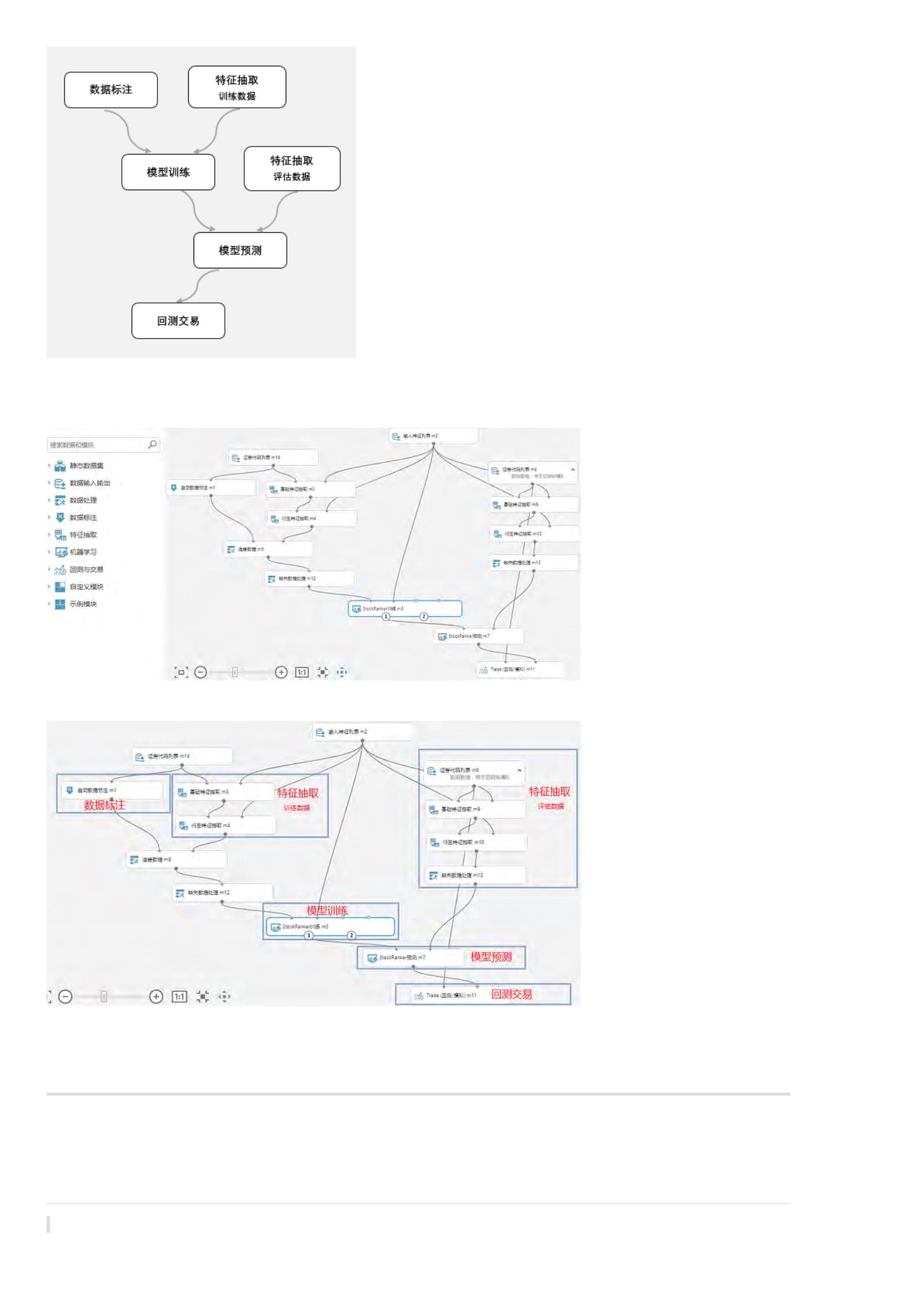

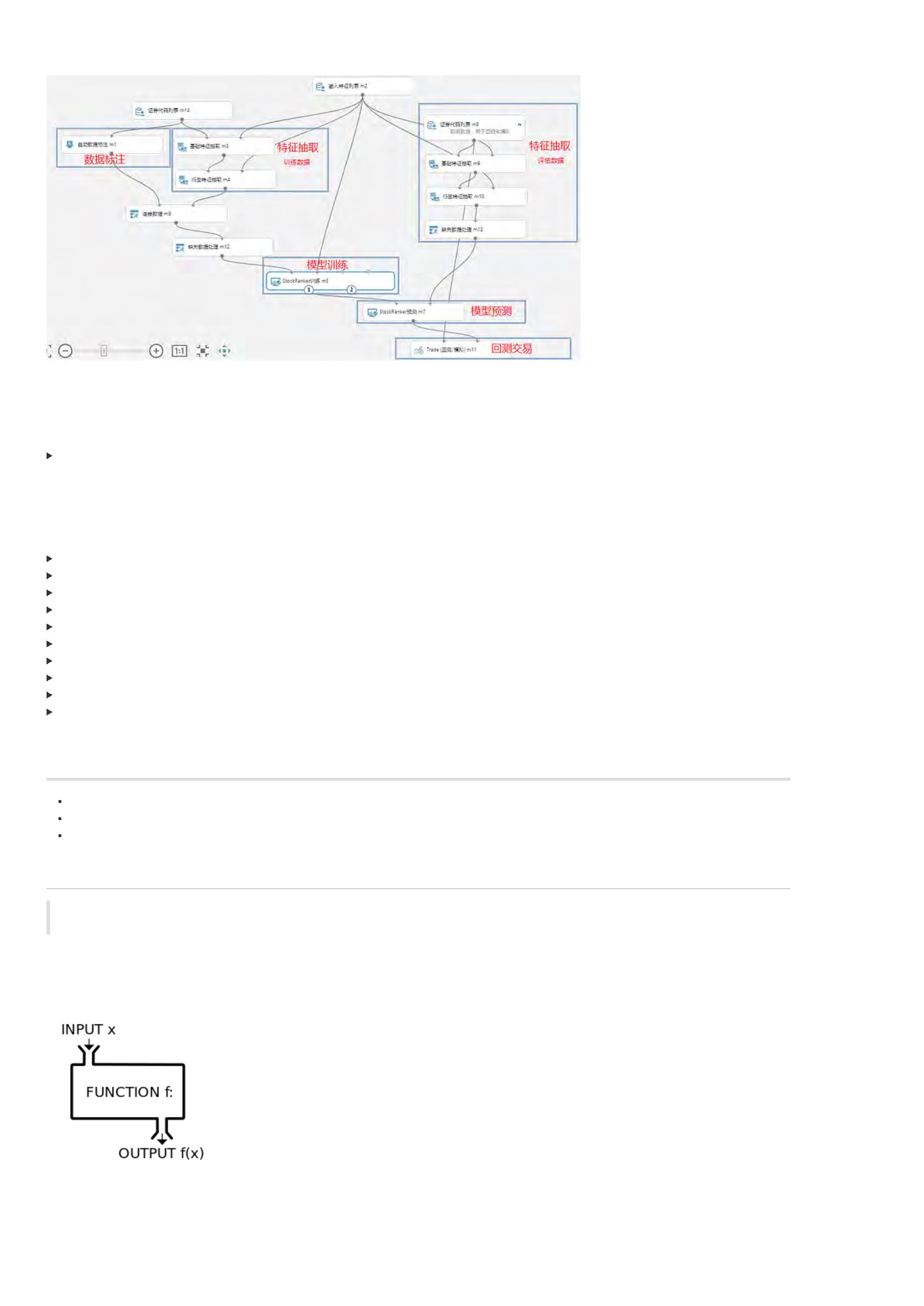

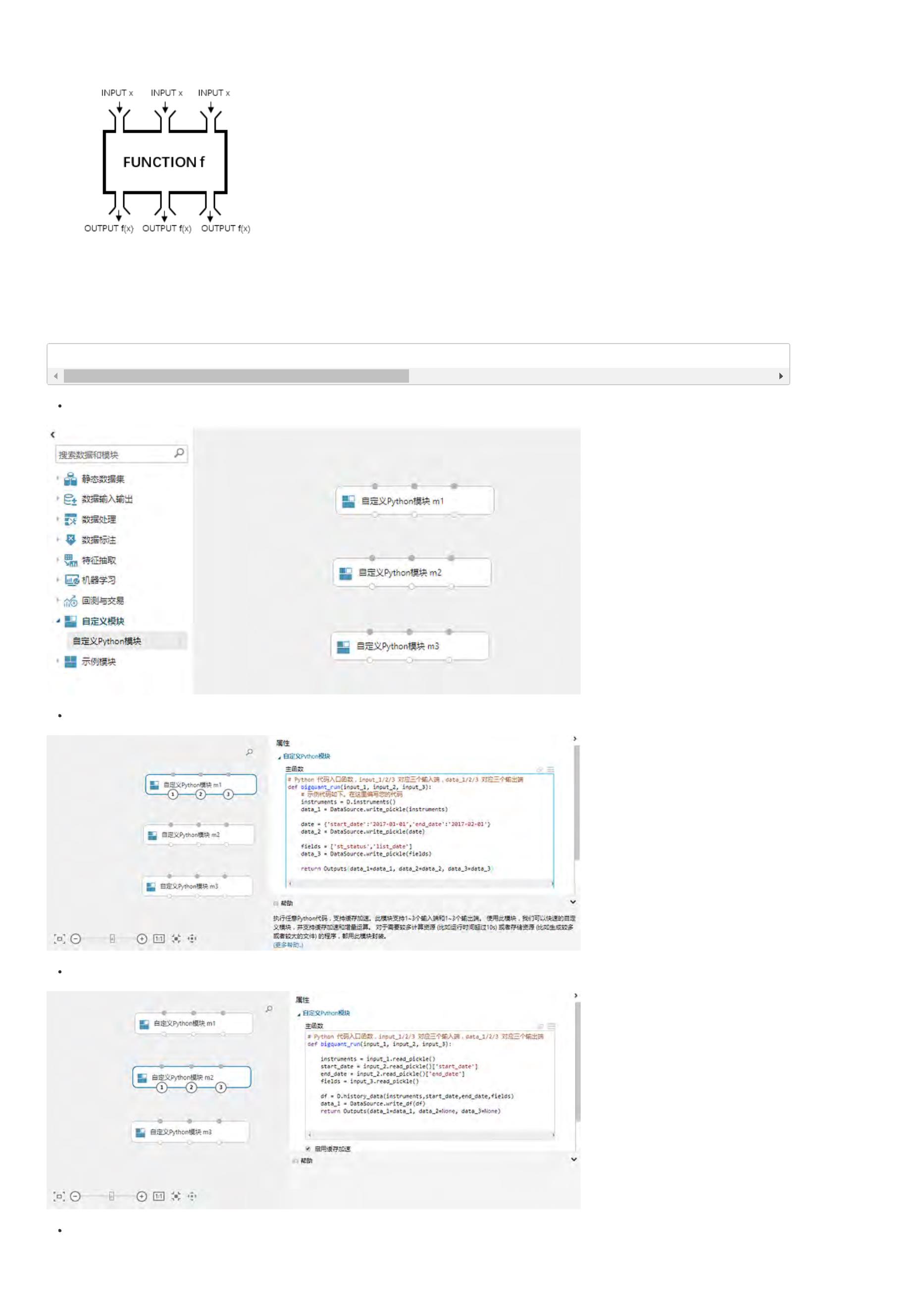

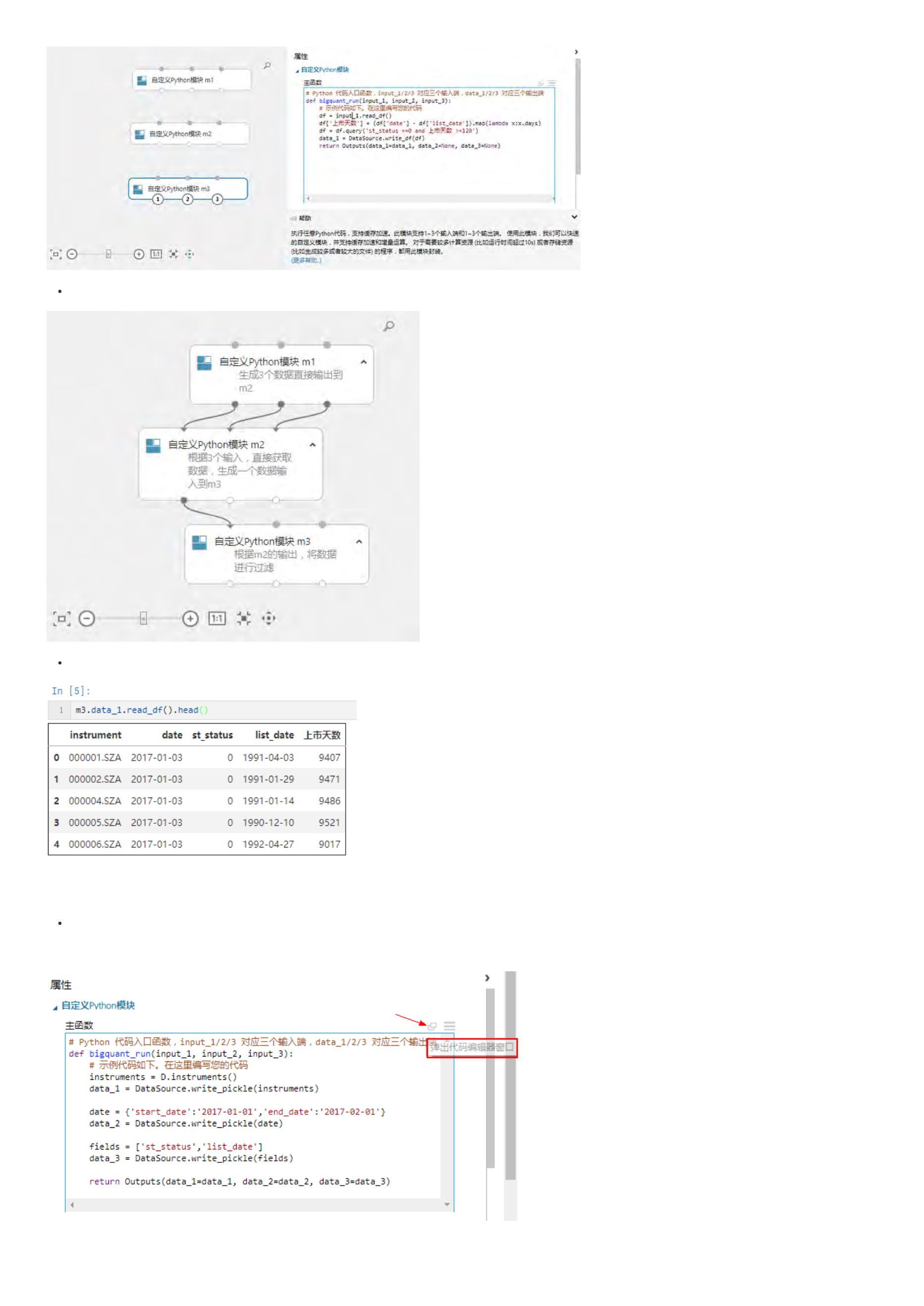

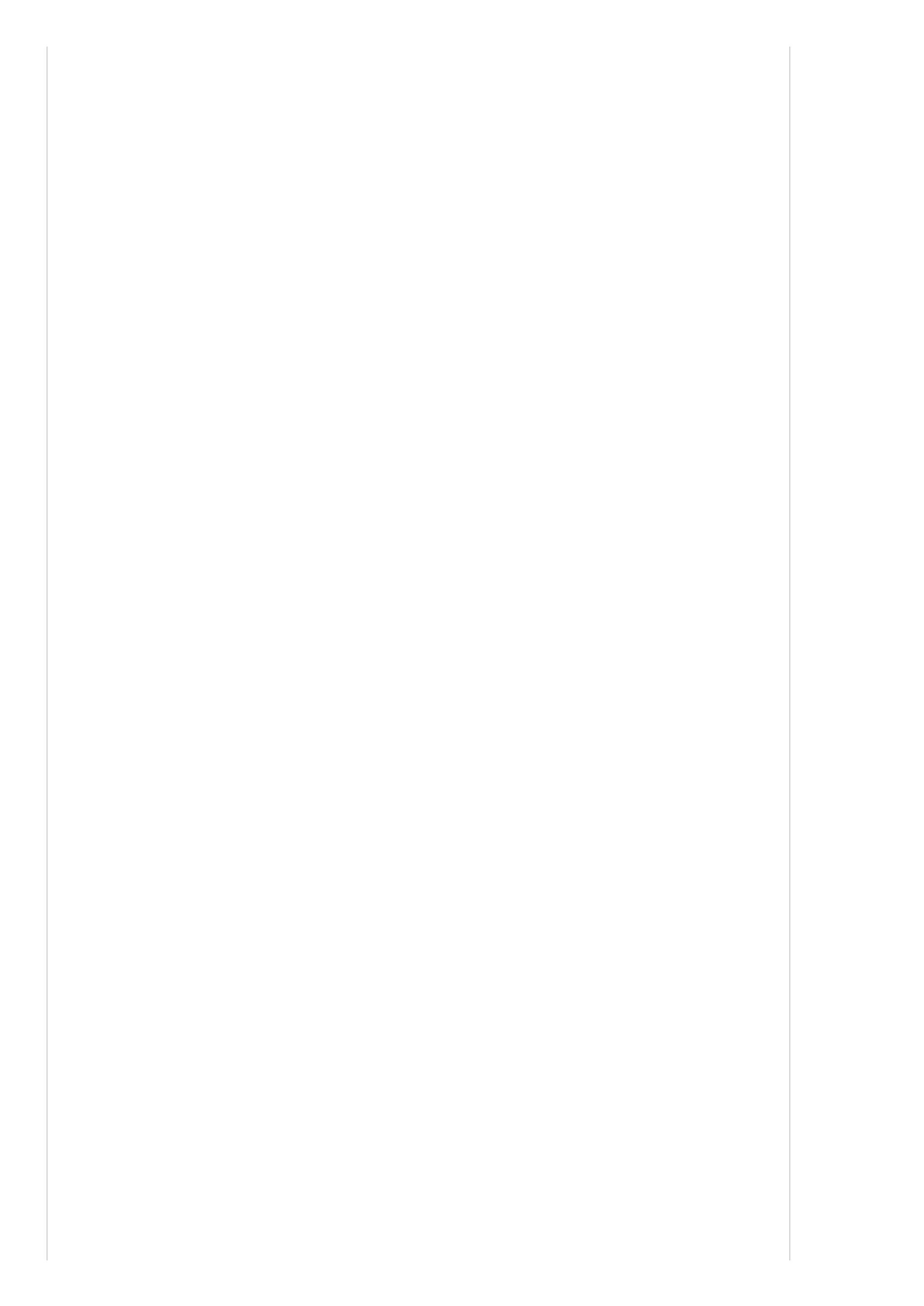

看看下面这个简单的AI策略抽象流程示意图,将帮助我们来理解AI策略代码。

基础配置

这些配置将在后续用到:

1

. start_date 和 end_date 确定了我们要用数据段

其中 [start_date, split_date) 区间的数据,用于模型训练

split_date, end_date] 区间的数据,用户模型回测

[

2

. instruments:股票池,D.instruments(start_date, split_date) 取A股给定时间段内所有出现过的股票。

. label_expr,用户标注的函数,更多说明见下面关于 M.advanced_auto_labeler的介绍。

. hold_days:持仓时间,用于数据标注和回测,具体见下面相关模块使用

. features:特征 (因子),具体见下面相关模块使用

3

4

5

class conf:

start_date = '2014-01-01'

end_date='2017-07-17'

split_date = '2015-01-01'

instruments = D.instruments(start_date, end_date)

hold_days = 5

features = [

'

'

'

'

'

'

'

'

'

'

'

'

'

close_5/close_0', # 5日收益

close_10/close_0', # 10日收益

close_20/close_0', # 20日收益

avg_amount_0/avg_amount_5', # 当日/5日平均交易额

avg_amount_5/avg_amount_20', # 5日/20日平均交易额

rank_avg_amount_0/rank_avg_amount_5', # 当日/5日平均交易额排名

rank_avg_amount_5/rank_avg_amount_10', # 5日/10日平均交易额排名

rank_return_0', # 当日收益

rank_return_5', # 5日收益

rank_return_10', # 10日收益

rank_return_0/rank_return_5', # 当日/5日收益排名

rank_return_5/rank_return_10', # 5日/10日收益排名

pe_ttm_0', # 市盈率TTM

]

#

数据标注标注

label_expr = [

#

'

#

'

#

'

#

'

]

计算未来一段时间(hold_days)的相对收益

shift(close, -5) / shift(open, -1) - shift(benchmark_close, -5) / shift(benchmark_open, -1)',

极值处理:用1%和99%分位的值做clip

clip(label, all_quantile(label, 0.01), all_quantile(label, 0.99))',

将分数映射到分类,这里使用20个分类,这里采取等宽离散化

all_wbins(label, 20)',

过滤掉一字涨停的情况 (设置label为NaN,在后续处理和训练中会忽略NaN的label)

where(shift(high, -1) == shift(low, -1), NaN, label)'

示例解读:

1

. shift(close, -5) / shift(open, -1) - shift(benchmark_close, -5) / shift(benchmark_open, -1):未来5天的相对收益率(股票收益率减去基准收益率),其中

shift(close,-5)为未来5天的收盘价,shift(open,-1)为明天的开盘价,基准同理。

. clip:clip用于极值处理,上面的例子就是将1%分位数和99%分位数以外的数据进行裁剪

. all_wbins:对连续性的标注数据进行离散化,上面的例子是将标注数据分为20类。详情请参考:表达式引擎

. where(shift(high, -1) == shift(low, -1), NaN, label):过滤掉一字涨停的情形

2

3

4

数据标注

之前采取的是M.fast_auto_labeler进行数据标注,但如果要使用表达式引擎构建因子、数据标注,建议使用功能更为强大的M.advanced_auto_labeler进行数

据标注。

#

给数据做标注:给每一行数据(样本)打分,一般分数越高表示越好

m1 = M.advanced_auto_labeler.v1(

instruments=conf.instruments, start_date=conf.start_date, end_date=conf.split_date,

label_expr=conf.label_expr, benchmark='000300.SHA', cast_label_int=True)

示例解读:

1

. label_expr:表示通过conf类中的标注语句进行数据标注

. benchmark:对数据进行标注的时候,偶尔会用到基准数据,因此需要制定基准

. cast_label_int:标注结果是否转换为整数;默认值是True

2

3

基础特征抽取

机器学习算法很大程度上依赖于特征工程,AI策略同样如此,特征抽取地好,对收益率的预测将更加准确。 有些因子的基础因子,直接可以抽取。

m2 = M.general_feature_extractor.v5(

instruments=conf.instruments, start_date=conf.start_date, end_date=conf.end_date,

features=conf.features)

详情请参考文档:基础特征抽取。

衍生特征抽取

很多AI策略的特征并不是简单的基础特征,而是由基础特征衍生计算出来的衍生特征。

#

计算衍生特征

m2_1 = M.derived_feature_extractor.v1(data=m2.data, features=conf.features)

详情请参考文档:衍生特征抽取。

数据转换

如果你采用的模型是StockRanker,该算法需要对输入的特征作相应转换。如果你使用的是随机森林、线性SGD模型等,这一步可以省略。

m3 = M.transform.v2(data=m2_1.data, transforms=None, drop_null=True)

当然,在之前我们的AI策略是采取的 M.fast_auto_labeler 进行数据标注,策略详解请点击展开。

点击查看代码

合并数据

通过数据标注和计算特征数据,我们获得了两个数据,只有同时包含这两部分数据的训练集才能完整地训练一个AI模型,因此需要进行数据合并。

#

合并标注和特征数据

m4 = M.join.v2(data1=m1.data, data2=m3.data, on=['date', 'instrument'], sort=True)

示例解读:

1

. 数据合并也成为数据连接,详情请参考 模块和API:数据连接。

. data1=m1.data 表示:第一个需要连接的数据,例如标注数据。

. data2=m3.data 表示:第二个需要连接的数据,例如计算完成的特征数据。

. on=[‘date’, ‘instrument’] 表示:数据合并时使用的主要列。一般使用日期和股票代码就可以对数据进行合并。

. sort=True 表示:是否对合并数据的结果按on指定的列进行排序。

2

3

4

5

模型训练

当我们将标注数据和经过数据预处理的特征数据合并以后,此时可以通过机器学习算法训练出一个AI模型。

#

StockRanker机器学习训练

m5=M.stock_ranker_train.v5(training_ds=m4.data, features=conf.features)

示例解读:

1

. 机器学习模型训练是必不可少的一步,训练时间依赖于数据量,如果是全市场股票多年数据,时间大概需要3-10分钟。详情请参考 模块和API概览:模

型训练。

. training_ds=m4.data 表示:训练模型时应以什么数据进行输入,输入的数据为上一步合并的数据。

. features=conf.features 表示:训练模型时以什么特征或因子参与模型进行训练。

. M.stock_ranker_train接口的其他参数一般采用默认值。

2

3

4

训练结果

通过上一步的训练模型,我们已经产生出了一个在训练集上表现不错的模型。我们可以这样查询训练结果:

print('模型ID:', m5.model_id)

print('模型因子得分:', m5.feature_gains)

print('模型可视化:', m5.plot_model())

示例解读:

1

. m5.model_id 表示:唯一的模型ID。

. m5.feature_gains 表示: 各个特征的得分情况,可以借此判断特征重要性程度。由于输出类型为DataSource,因此可以通过read_df方法查看——

m5.feature_gains.read_df()。

. m5.plot_model() 表示:可视化查看模型结果,这样就能打开AI算法的‘黑箱’,可以查看算法的每个细节。

2

3

模型预测

此时,我们已经产生出了一个在训练集上表现不错的模型。现在我们根据该模型来获取在测试集上的预测结果。

#

计算基础数据

n2 = M.general_feature_extractor.v5(

instruments=conf.instruments, start_date=conf.start_date, end_date=conf.end_date,

features=conf.features)

#

计算衍生特征

n2_1 = M.derived_feature_extractor.v1(data=n2.data, features=conf.features)

#

将特征数据转换机器学习算法能够接受的数据类型(只有StockRanker算法需要)

n3 = M.transform.v2(data=n2_1.data, transforms=None, drop_null=True)

#

进行预测

n4 = M.stock_ranker_predict.v5(model=m6.model, data=n3.data)

#

查看预测数据

prediction = n4.predictions.read_df()

示例解读:

1

. n1和n2和之前的特征抽取、特征转换完全一样,只是现在传入的时间是测试集的时间段。

. 机器学习算法通过模型和特征数据就可以进行预测,因此并不需要标注数据、合并数据。比如当你获得了一个回归模型后,此时传入新的自变量就可以

带入模型获得因变量。

. n3是模型预测,详情可参看 模块和API概览:模型预测

. model_id=context.options[‘model_id’] 表示:用哪个模型进行预测就传入哪个模型ID。

. data=n2.data 表示:在什么数据上进行预测就传入什么数据。一般为测试集的特征数据。

. n3.predictions.read_df() 表示:模型在测试集上的预测结果为n3.predictions,类型为DataSource,因此需要通过read_df方法查看。

2

3

4

5

6

策略回测

当我们获得测试集上的预测结果以后,我们就可以通过BigQuant回测机制进行策略回测,验证该策略是否有效。策略回测相关内容请参考 BigQuant回测机

制。

上一页:BigQuant策略平台使用帮助

下一页:适合小白的入门方式

目录:BigQuant学院

[

量化学堂-新手专区]适合小白的入门方式

导语:

BigQuant是一家人工智能量化平台,以下是BigQuant的正确打开方式:

1

.文档教程——2. 学院——3.干货贴——4.多交流,有问题随时提——5.实战

1

.文档教程

图

首页

图

文档教程

先过一遍,有一个整体的感觉,不用细究。文档教程好比一部字典,真正遇到什么需要查询的随用随查。

2

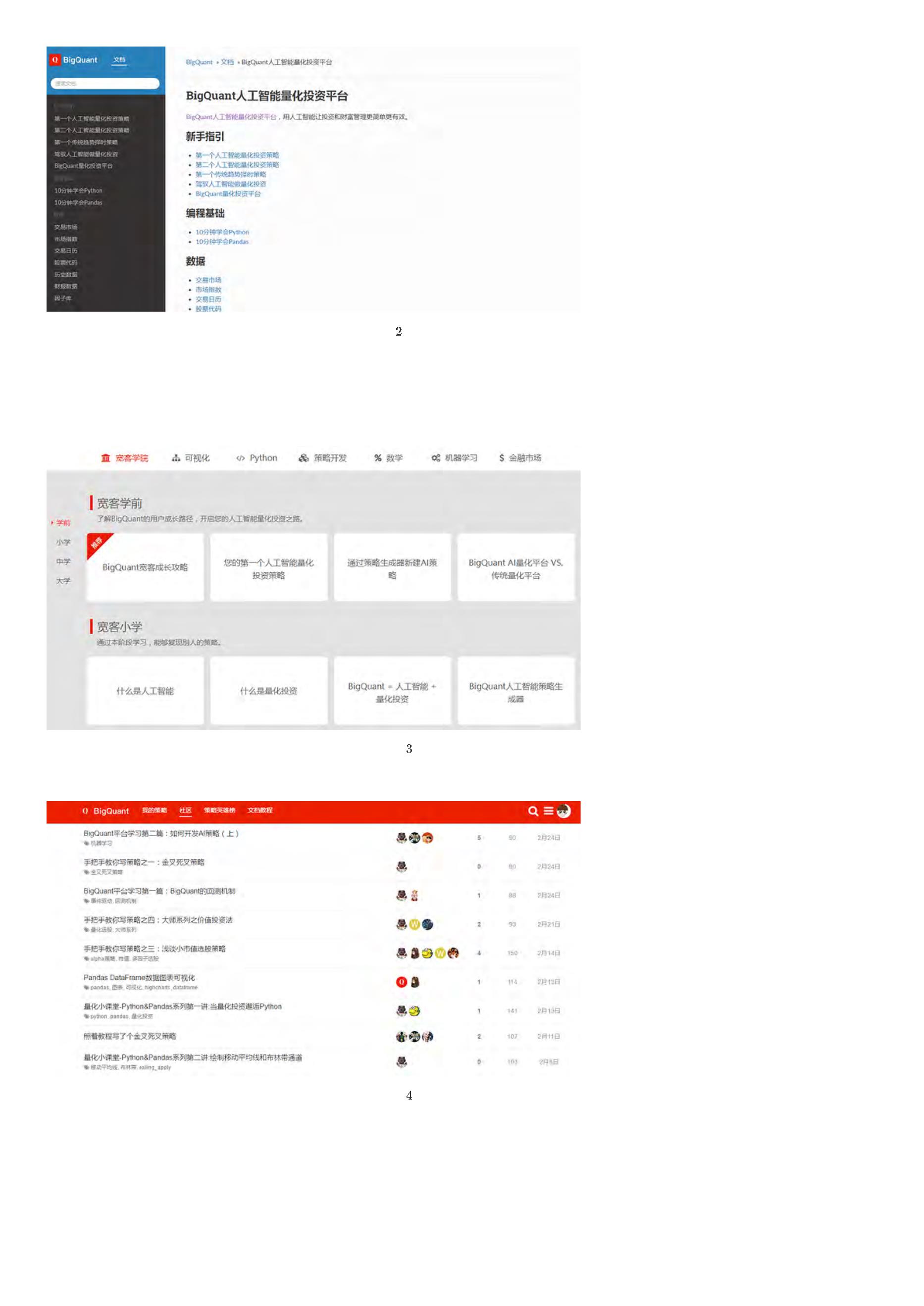

. 学院

学院主要包括:宽客学院、可视化、Python、策略开发、数学、机器学习、金融市场7块内容。目的是全方位介绍成为一名BigQuant上的宽客所具备的技

能。其中,宽客学院分为学前、小学、中学、大学四个阶段,帮助用户能够循序渐进成长起来。

图

学院

3

.干货贴

图

社区

从图4看出,社区里干货不少,这些帖子详细地介绍了策略思想、逻辑以及策略源码,最佳的方式就是点击 克隆策略将策略自动复制到个人私人研究平台

上,然后一行一行地弄明白每行代码的意义,不仅可以加深对平台的认识,而且多练习以后就可以自主开发策略,实现自己的策略想法。这种方式对新手而

言帮助最大。

4

.多交流,有问题随时提

提问

你可以直接在社区发帖提问,将你的问题描述出来,然后会有BigQuant平台工程师来回答你的问题,不仅如此,热情的宽友也会来解答你的问题。需要注意

的是:问题描述的越清楚,必要时贴上截图,问题越容易得到解答。

你也可以加入BigQuant的官方QQ群,直接在里面提问题,BigQuant的人和热心的群友会很快解答你的提问。

提需求

因为每个人可能会有各种需求,数据方面的、回测方面的、模拟交易方面的等等,BigQuant平台也是特别人性化,专门拟定了一个提需求的帖子,搬运过

5

.实战

这里的实战指根据一个机器学习算法或策略想法,不管是网上看到的还是自己构思的,将其转化成一个能够运行并输出回测曲线的一个完整策略,这是成为

BigQuant平台高手最重要的一步。

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

上一页:BigQuant AI策略详解

下一页:Python快速入门

目录:BigQuant学院

【

宽客学院】Python 快速入门

本课程帮助大家Python快速入门。

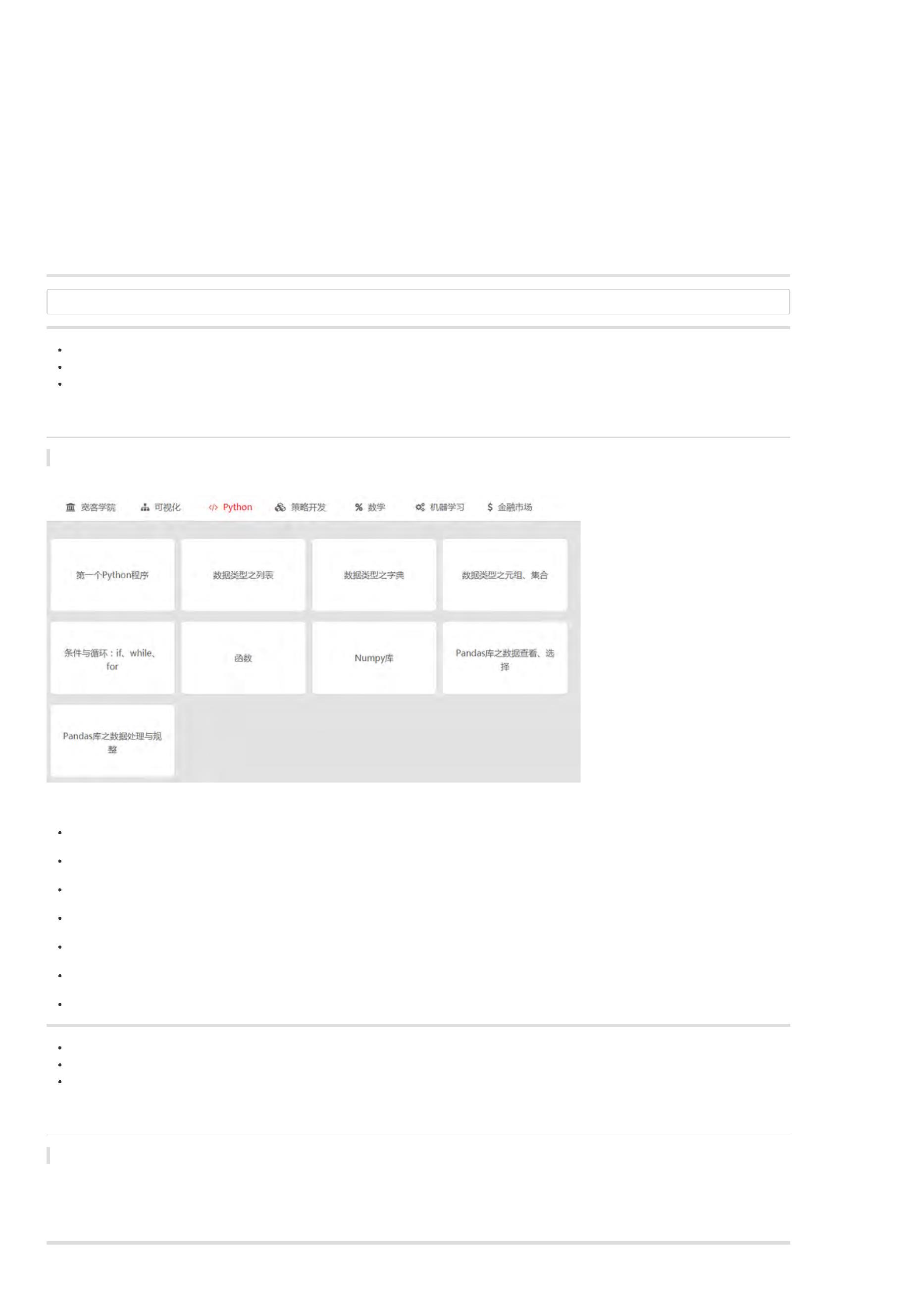

在学院页面,有一个栏目名叫Python,大家可以以次练手。

Python快速入门的学习资源如下:

上一页:适合小白的入门方式

下一页:做量化您需要知道的那些术语

目录:BigQuant学院

做量化你需要知道的那些术语!(持续更新)

本文介绍一些量化投资相关术语,帮助大家更好地了解该行业。

以下术语没有先后顺序,并将持续更新!

金融相关:

股票:股份公司发行的所有权凭证。

债券:承诺按一定利率支付利息并按约定条件偿还本金的债权债务凭证,风险较低。

固定收益:固定收益类投资指投资于银行定期存款、协议存款、国债、金融债、企业债、可转换债券、债券型基金等固定收益类资产。风险低。

利率互换:利率互换是指两笔货币相同、债务额相同(本金相同)、期限相同的资金,但交易双方分别以固定利率和浮动利率借款,为了降低资金成本和利率风险,双方做固定利率

外汇交易:外汇交易是以一种外币兑换另一种外币。报价即为汇率,通常用两种货币之间的兑换比例来表示,例如:USD/JPY、GBP/JPY。汇率是第一种货币(作为基础货币)以第二

黄金:贵金属,可用于储备和投资的特殊通货。

美元指数:综合反映美元在国际外汇市场的汇率情况的指标,用来衡量美元对一揽子货币的汇率变化程度。

基金: 从广义上说,基金是指为了某种目的而设立的具有一定数量的资金。主要包括信托投资基金、公积金、保险基金、退休基金,各种基金会的基金。

货币基金:投资于货币市场上短期有价证券的一种基金。风险较小。

封闭式基金:基金规模在发行前已确定、在发行完毕后的规定期限内固定不变并在证券市场上交易的投资基金。

开放式基金:开放式基金,是指基金规模不是固定不变的,而是可以随时根据市场供求情况发行新份额或被投资人赎回的投资基金。

期货:约定在未来某个时间以某个价格进行成交的合约。

期权:是一种衍生性金融工具,比如未来某个时间以某个价格交易的权利,这个选择权就是期权。

策略相关

Alpha:alpha一词主要来自于资本资产定价模型,模型中alpha表示来自于股票自身的收益。alpha策略表示通过股指期货对冲市场风险获取阿尔法收益的对冲策略。

Beta: 评估证券系统性风险的工具,用以度量一种证券或一个投资证券组合相对总体市场的波动性。

多因子选股: 应用最广泛的一种选股模型,基本原理是采用一系列与收益率相关的因子作为选股标准,满足这些因子的股票则被买入,不满足的则卖出。

价值投资:一种常见的投资方式。其重点是通过基本分析中的概念,例如高股息收益率、低市盈率和低股价/帐面比率,去寻找并投资股价被低估的股票。

日内策略:交易频率很高,持仓时间很短的交易,持仓不过夜。

高频交易:从那些人们无法利用的极为短暂的市场变化中寻求获利的交易,比如一分钟成交上千笔,持仓时间几秒钟。

算法交易:算法交易本质上不算一类策略,其目的更多是降低交易成本、提高执行效率、减少人力成本。常见的算法有:交易量加权平均价格算法(VWAP)和时间加权平均价格算法

程序化交易:程序化交易是指通过既定程序或特定软件,自动生成或执行交易指令的交易行为。

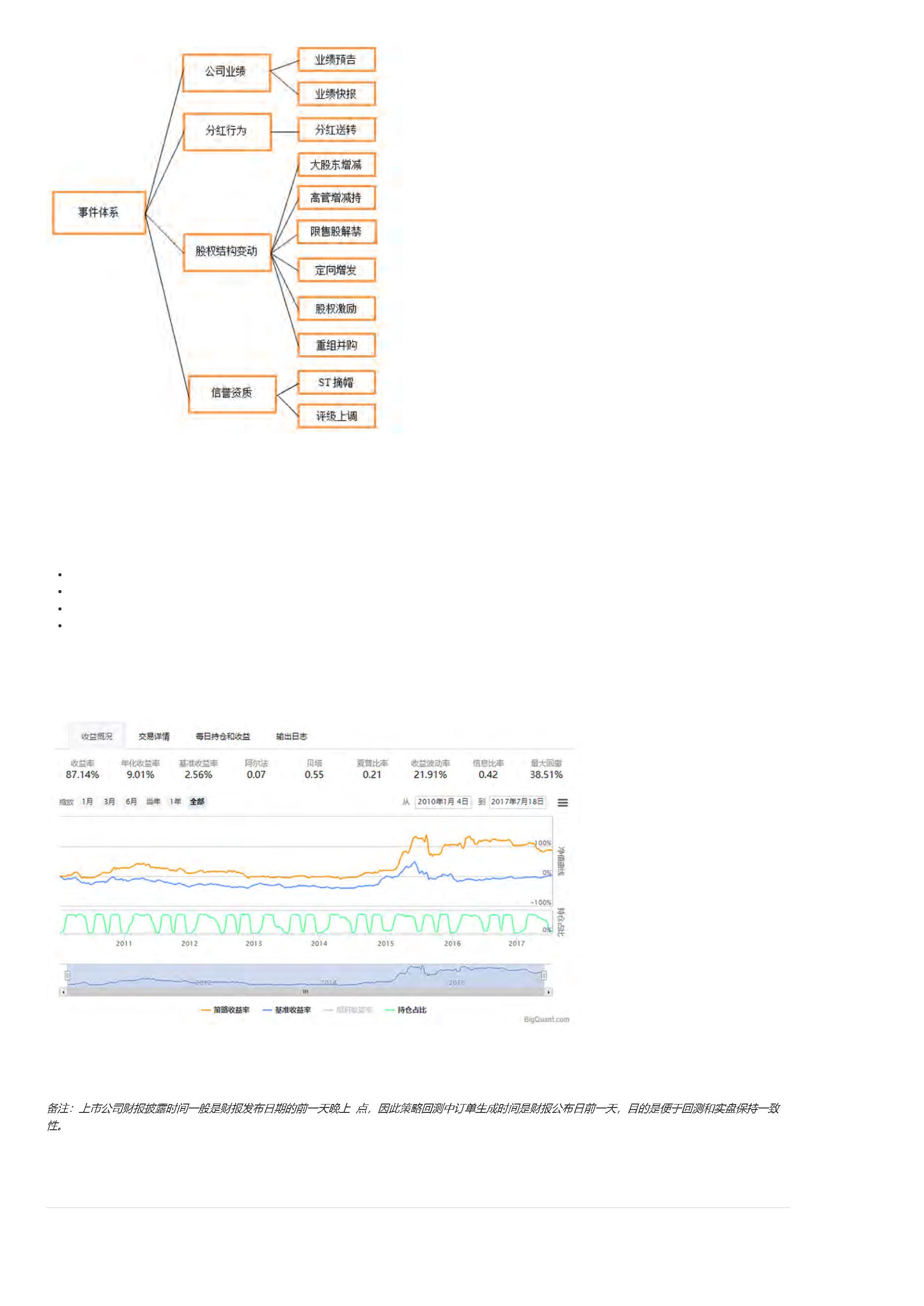

趋势跟踪:跟随市场价格变动的交易策略,最为常见的策略之一。

事件驱动: 包括企业分拆、企业收购、企业合并、破产重组、财务重组、资产重组以及股票回购等在内的事件可能会对股票价格有重大影响,事件驱动就是挖掘这类事件带来收益

行业轮动:利用市场趋势获利的一种主动交易策略,其本质是利用不同投资品种强势时间的错位对行业品种进行切换以达到投资收益最大化的目的。

套利:对相关性强的品种一买一卖,赚取差价。

统计套利:将套利建立对历史数据进行统计分析的基础之上,估计相关变量的概率分布,并结合基本面数据进行分析以用以指导套利交易。

协整:变量之间长期稳定的均衡关系的统计表示。

跨期套利:在同一期货品种的不同月份合约上建立数量相等、方向相反的交易头寸,最后以对冲或交割方式结束交易、获得收益的方式。

蝶式套利:套利的套利,利用不同交割月份的价差进行套期获利,由两个方向相反、共享居中交割月份合约的跨期套利组成。它是一种期权策略,风险有限,盈利有限,是由一手牛

跨产品套利:又称跨商品套利。根据套利商品之间的关系,跨品种套利可分为相关商品套利和产业链跨品种套利两种类型。

产业链套利:一般属于夸品种套利,在一个产业链条上对上游产品和下游产品进行一买一卖的操作,以期获得差价收益。

回归套利:套利的逻辑是坚信价差要回归。

对冲:一般对冲是同时进行两笔行情相关、方向相反、数量相当、盈亏相抵的交易。和跨品种套利思想一致。

市场相关

宽客:量化交易者的一个统称。

CTA基金:商品基金,该基金主要投资于商品期货,CTA是Commodity Trading Advisor的简称。

打新:就是用资金参与新股申购,如果中签的话,就买到了即将上市的股票。网下的只有机构能申购,网上的申购本人就可以申购。打新分为打新股票和打新基金。

沪深300: 全市场中具有代表性的300只股票。其指数能够反映市场走势,常用来作为各种策略的基准。

上证50:指数是根据科学客观的方法,挑选上海证券市场规模大、流动性好的最具代表性的50 只股票组成样本股,以便综合反映上海证券市场最具市场影响力的一批龙头企业的整体

创业板: 专为暂时无法在主板上市的创业型企业、中小企业和高科技产业企业等需要进行融资和发展的企业提供融资途径和成长空间的证券交易市场,是对主板市场的重要补充。在

漂亮50:原意指美国股票投资史上特定阶段出现的一个非正式术语,用来指上世纪六十和七十年代在纽约证券交易所交易的50只备受追捧的大盘股。现在更多的是指在2017年中国受

公募基金:是受政府主管部门监管的,向不特定投资者公开发行受益凭证的证券投资基金,这些基金在法律的严格监管下,有着信息披露,利润分配,运行限制等行业规范。

私募基金:一种非公开宣传的,私下向特定投资人募集资金进行的一种集合投资。

国债逆回购:个人通过国债回购市场把自己的资金借出去,获得固定的利息收益;而回购方(借款人)用自己的国债作为抵押获得这笔借款,到期后还本付息。本质上是一种短期贷

股指期货:以股价指数为标的物的标准化期货合约,交割方式为金额交割。

商品期货:标的物为实物商品的期货合约,交割方式为实物交割。

保证金:在期货市场和期权市场,交易时并不需要全部金额,只需部分金额就行,这部分金额就成为保证金。

权证:一种以约定的价格和时间(或在权证协议里列明的一系列期间内分别以相应价格)购买或者出售标的资产的期权。

杠杆比率:在期货交易中,实行的是保证金交易,交易金额和保证金的比值就称为杠杆比率。

爆仓:爆仓就是亏损大于你的账户中的保证金。

升贴水:期货市场价格和现货市场价格不一致导致升贴水存在。期货价格高于现货价格称为升水,期货价格小于现货价格称为贴水。

ETF:交易型开放式指数基金,是一种在交易所上市交易的、基金份额可变的一种开放式基金。

FOF:基金的基金(Fund Of Fund)。一种专门投资于其他投资基金的基金。FoF并不直接投资股票或债券,其投资范围仅限于其他基金。

MOM:管理人的管理人(Manager Of Manager)。是指该基金的基金经理不直接管理基金投资,而是将基金资产委托给其他的一些基金经理来进行管理。

分级基金:又叫“结构型基金”,是指在一个投资组合下,通过对基金收益或净资产的分解,形成两级(或多级)风险收益表现有一定差异化基金份额的基金品种。

量化相关

选股:选出好的股票。

择时:确定交易买卖时机。

仓位管理:在整个交易过程中,持仓比率的管理。

止盈:也称停利、止赚 ,即在目标价位挂单出货。

止损:在能够承受的风险损失的价位挂单出货。

凯利法则:用来决定每次下单手数的一种技术,属于资金管理。

风险平价理论:通过调整各类资产的权重以实现组合中各类资产的风险贡献基本均衡。

行业中性:构建投资组合,使得组合在各个行业上的暴露程度与基准指数 在各个行业上的暴露相等。

风格中性:构建投资组合,使得组合在各个风格因子上的暴露程度与基准指数在各个因子上的暴露相等。

CAPM模型:资本资产定价模型,研究的重点在于探求风险资产收益与风险的数量关系:即为了补偿某一特定程度的风险,投资者应该获得多少的报酬率。

Black-Scholes期权定价模型:由布莱克与斯科尔斯在20世纪70年代提出,为期权定价提供了理论基础。

MM理论:该理论由莫迪格利安尼(Modigliani)和默顿·米勒(Miller)提出。核心思想:公司价值与公司资本结构无关。

动量:认为股票价格走势强者越强、弱者越弱。

反转:股价朝原来趋势的相反方向移动分为向上反转和向下反转,股价由多头行情转为空头行情,或由空头行情转为多头行情。

参数调优:对策略中含有的参数进行优化。

过度拟合:模型对历史数据拟合地非常好,但是实际预测准确性很低,泛化能力不强。

未来函数:在当下的时间点运用了未来的信息。

幸存者偏差:另译为“生存者偏差”、“存活者偏差”,、“沉默的数据”等等,是指只能看到经过某种筛选而产生的结果,而没有意识到筛选的过程,因此忽略了被筛选掉的关键信息。

偷价漏价: 偷价是指以一个不切实际的价格去进行成交,往往会高估策略的收益。

夏普比率:表明投资组合每承受一单位总风险,会产生多少的超额报酬。它是市场上最常见的衡量比率:若为正值,代表基金报酬率高过波动风险;若为负值,代表基金操作风险大

最大回撤:在选定周期内任一历史时点往后推,产品净值走到最低点时的收益率回撤幅度的最大值。最大回撤用来描述买入产品后可能出现的最糟糕的情况。

年化收益:将收益折算为以年为单位的收益率。

数据挖掘:从大量的数据中通过算法搜索隐藏于其中信息的过程。

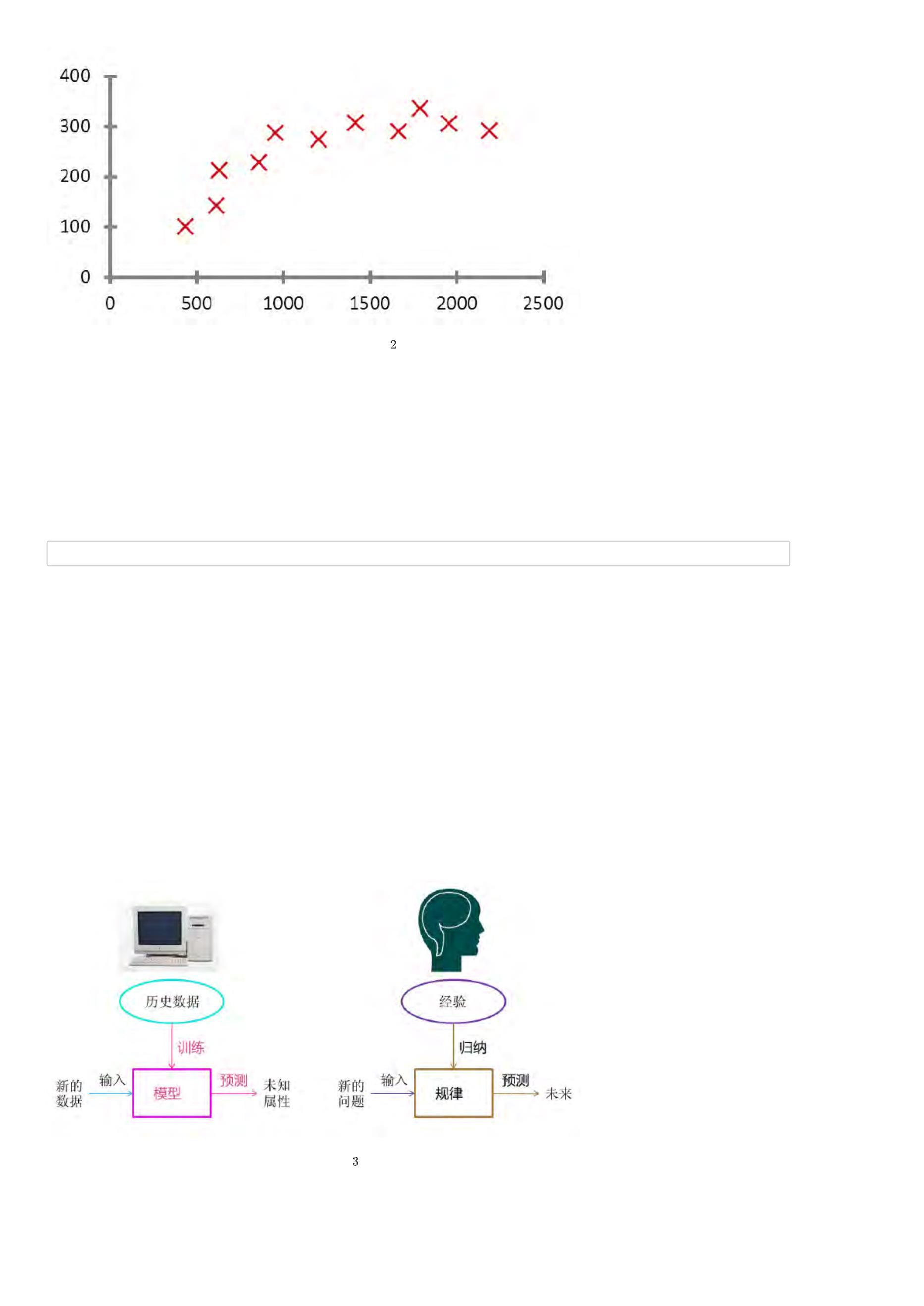

机器学习:从历史数据中发掘规律,并对未来数据进行预测的学习算法,属于人工智能一个子领域。

深度学习: 深度学习是机器学习的一个子集,包含多层感知器就是一种深度学习结构。

技术分析:以股票价格成交量为基础,计算出各种指标来指导交易的分析方法称为技术分析。

道氏理论: 它是根据价格模式的研究,推测未来价格行为的一种方法。由查尔斯·道创立。

海龟法则:一种经典的趋势跟踪策略。

指标相关

市盈率:也称“本益比”、“股价收益比率”或“市价盈利比率”,是最常用来评估股价水平是否合理的指标之一,由股价除以年度每股盈余(EPS)得出,市盈率常用来作为一个有效因子

流通市值:在某特定时间内当时可交易的流通股股数乘以当时股价得出的流通股票总价值。

每股收益:即每股盈利(EPS),又称每股税后利润、每股盈余,指税后利润与股本总数的比率。

ROE:净资产收益率。指标值越高,说明投资带来的收益越高。该指标体现了自有资本获得净收益的能力。

ROA: 总资产收益率,是用来衡量每单位资产创造多少净利润的指标。衡量的是每一美元资产所带来的利润。

市净率:每股市价与每股净资产之比,每股净资产为普通股股东权益与流通在外普通股股数之比。市净率反映普通股股东愿意为每1元净资产支付的价格。

市销率:每股市价与每股销售收入之比,每股销售收入为销售收入与流通在外普通股加权平均股数之比。市销率反映普通股股东愿意为每1元销售收入支付的价格。

布林带:根据统计学中的标准差原理设计出来的一种非常实用的技术指标。它由三条轨道线组成,其中上下两条线分别可以看成是价格的压力线和支撑线,在两条线之间是一条价格平

金叉:短期均线上穿长期均线,预示上涨。

死叉:短期均线下穿长期均线,预示下跌。

MA:以道·琼斯的“平均成本概念”为理论基础,采用统计学中“移动平均”的原理,将一段时期内的股票价格平均值连成曲线,用来显示股价的历史波动情况,进而反映股价指数未来发

RSI:相对强弱指数, 根据一定时期内上涨点数和涨跌点数之和的比率制作出的一种技术指标。

MACD:指数平滑移动平均线,是从双指数移动平均线发展而来的,由快的指数移动平均线(EMA12)减去慢的指数移动平均线(EMA26)得到快线DIF,再用2×(快线DIF-DIF的9日加

KDJ:又称随机指标,利用价格波动的真实波幅来反映价格走势的强弱和超买超卖现象,在价格尚未上升或下降之前发出买卖信号的一种技术工具。

威廉指标:表示当天的收盘价在过去一段日子的全部价格范围内所处的相对位置,是一种兼具超买超卖和强弱分界的指标。主要的作用在于辅助其他指标确认讯号。

交易相关

主力合约 :成交量最大的合约。因为它是市场上最活跃的合约,所有投机者基本上都在参与这个合约。也有说法是主力合约是持仓量最大的合约,通常来讲,持仓量最大的合约也是

连续合约:将主力合约拼接起来就成为连续合约。

合约单位:合约单位是指一张期权合约对应的标的资产(证券、股票或 ETF)数量,即买卖双方在约定的时间以约定的价格买入或卖出标的资产的数量。

夜盘交易:很多商品期货在晚上交易。

集合竞价:开盘之前的竞价属于集合竞价。按照价格优先和时间优先的原则计算出最大成交量的价格,这个价格就会是集合竞价的成交价格。

连续竞价:盘中的交易采取连续竞价。

撮合机制:指在投资者的委托指令传递到交易所后,交易所系统处理委托指令过程中的“逻辑程序”,包括不同交易时间的竞价原则、委托成交的优先顺序原则以及成交价的决定方法

股票T+1:T+1是一种股票交易制度,即当日买进的股票,要到下一个交易日才能卖出。

融券: 也称为出借证券,证券公司将自有股票或客户投资账户中的股票借给做空投资者。投资者借证券来出售,到期返还相同种类和数量的证券并支付利息,属于一种做空类型。

停牌:停牌是指股票由交易所暂停其在股票市场上进行交易。复牌之后才能在交易所挂牌交易。

涨跌停: 证券市场中为了防止交易价格的暴涨暴跌,抑制过度投机现象,对每只证券当天价格的涨跌幅度予以适当限制的一种交易制度,股票涨跌停幅度一般为10%。

熔断:熔断机制,也叫自动停盘机制,是指当股指波幅达到规定的熔断点时,交易所为控制风险采取的暂停交易措施。

乌龙指:指股票交易员、操盘手、股民等在交易的时候,不小心敲错了价格、数量、买卖方向等事件的统称。

自成交:以自己为交易对象,大量或者多次进行自买自卖。

ST股:被特别处理的股票,涨跌幅调整为5%。带ST帽子的股票风险较高。

大宗交易:又称为大宗买卖,是指达到规定的最低限额的证券单笔买卖申报,买卖双方经过协议达成一致并经交易所确定成交的证券交易。

K线:又称“蜡烛线”,起源于日本。K线记录的是某股票一天的价格变动情况,由实体、上影线、下影线等三部分组成,包含四个信息:开盘价,收盘价,全天最高价,全天最低价。

tick:参考:tick数据在技术上是什么东西?

level2:Level-2产品目前是由上海证券交易所最新推出的实时行情信息收费服务,主要提供在上海证券交易所上市交易的证券产品的实时交易数据,包括十档买卖盘,买一卖一委

前复权:在K线图上以除权后的价格为基准来测算除权前股票的市场成本价。

后复权:在K线图上以除权前的价格为基准来测算除权后股票的市场成本价。

成份指数:成份指数是通过科学客观的方法挑选出最具代表性的样本股票,建立一个反映整个证券市场的概貌和运行状况、能够作为投资评价尺度及金融衍生产品基础的基准指数。

换手率:也称“周转率”,指在一定时间内市场中股票转手买卖的频率,是反映股票流通性强弱的指标之一。

VWAP:成交量加权平均价,是将多笔交易的价格按各自的成交量加权而算出的平均价,若是计算某一证券在某交易日的VWAP,将当日成交总值除以总成交量即可。

TWAP:该算法的目标在于计算您的订单在提交之时至获得执行之间的时间加权平均价格。

其他

一价定律:即绝对购买力平价理论。是不同地区产品套利的基础。

文艺复兴科技:文艺复兴科技公司成立于1988年,创始人詹姆斯·西蒙斯。该公司旗舰产品——大奖章基金取得年化36%的回报,是最成功和著名的对冲基金之一。2005年,西蒙斯成立

长期资产管理公司:成立于1994年2月。LTCM掌门人是梅里韦瑟(Meriwehter),被誉为能"点石成金"的华尔街债务套利之父。成员有: 诺贝尔经济学奖得主默顿(Robert Merton

桥水对冲基金:成立于1975年,总部位于美国康奈迪克州,目前为世界前三对冲基金。

世坤基金:成立于2007年,创始人Igor Tulchinsky。该基金主要依靠数据挖掘进行投资。该公司在新兴市场(尤其是亚太的中国和印度)大量招募基层Quant、Data Scientist或

AQR基金:成立于1998年,由阿斯内斯与合伙人共同创办的一家量化对冲基金,主要通过算法和计算机模型来寻找市场暂时的无效性并从中获利,从名字可以看出基金的宗旨是金融应

巴林银行破产事件:英国老牌贵族银行因为一个交易员而走向破产的事件。

伊士顿股指盈利:在2015年,俄罗斯伊世顿公司通过高频程序化交易软件自动批量下单、快速下单,利用保证金杠杆比例等交易规则,以较小的资金投入反复开仓、平仓,使盈利在

上一页:Python快速入门

下一页:BigQuant数据API详解

目录:BigQuant学院

[

量化学堂-新手专区]BigQuant 数据API详解

导语:数据是开发策略的原料,知道怎么获取数据方能更为高效地开发策略!

数据为什么重要?

BigQuant是一个人工智能量化投资平台,类似于一个实验室,用户可以在实验室里发挥自己的聪明才智开发策略。计算机界有一个很有名的说法,叫

(Garbage In Garbage Out),翻译过来就是“垃圾进、垃圾出”。因此真实准确而全面的金融数据是开发优秀策略的重要前提。

BigQuant 有什么数据?

BigQuant有丰富并且高质量的金融数据,包括基础数据、历史数据、财报数据、特色因子数据等。详细可以参考 文档教程的 数据 部分

如何获取数据?

数据API是调用数据的接口,目的是快速、便捷、高效地获取数据。在BigQuant的策略平台上,通过数据API我们可以将服务器上的数据拉取到自己的策略平

台上,有了数据,相当于拿到“原料”,就可以自由发挥“厨艺”啦。

数据API举例

BigQuant数据API在设计之初就秉持对用户友好的理念,附件将详细介绍常用的数据API,欢迎大家 克隆研究 。

本文由BigQuant宽客大学推出,版权归BigQuant所有,转载请注明出处。

附件:BigQuant数据API举例

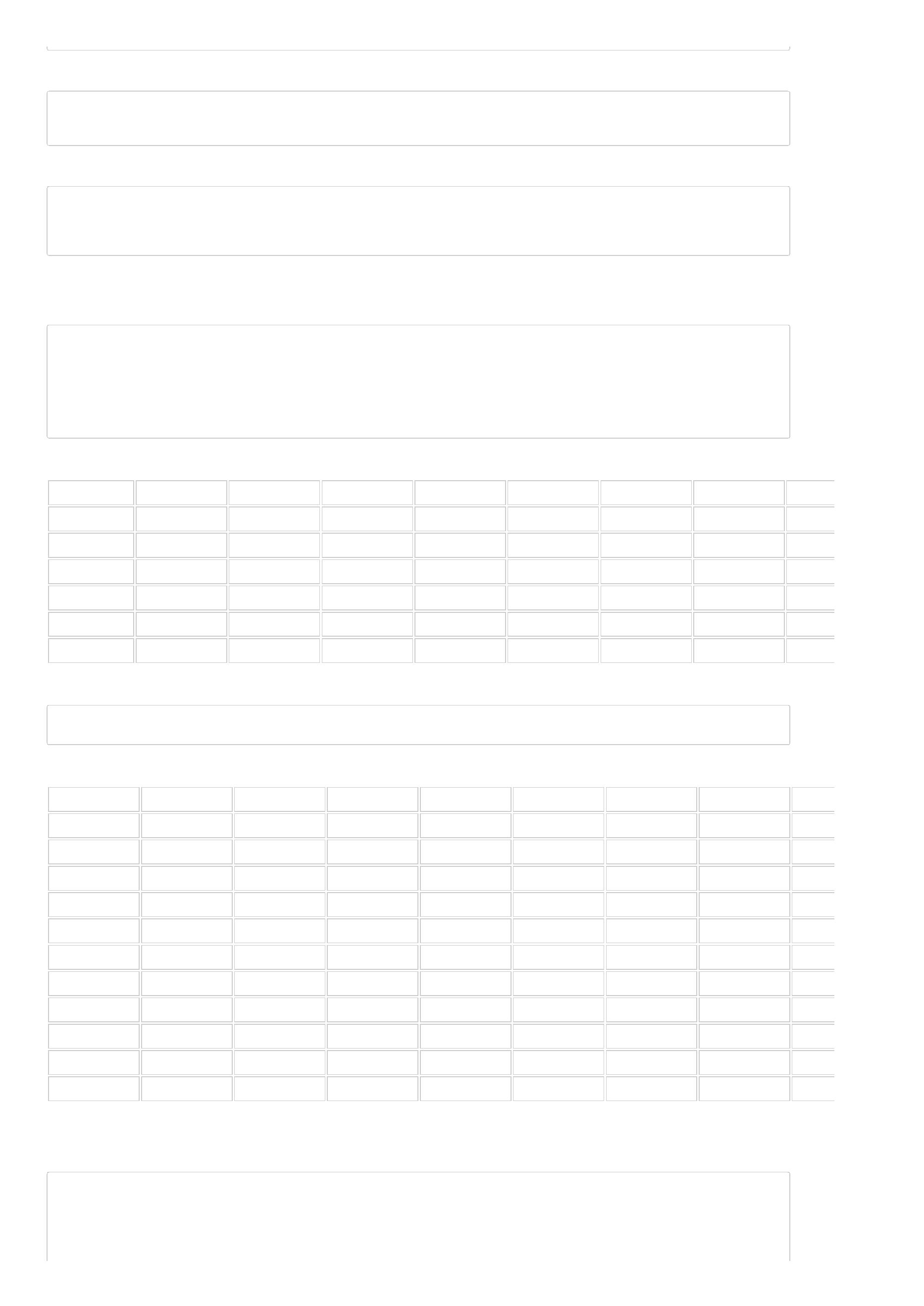

获取基础数据¶

获取指数数据——以沪深300举例

In [1]:

data = D.history_data(instruments=['000300.SHA'], start_date='2017-01-01', end_date='2017-04-07',

fields=['open', 'high', 'low', 'close', 'volume', 'amount'])

data.head() # 查看前6行数据

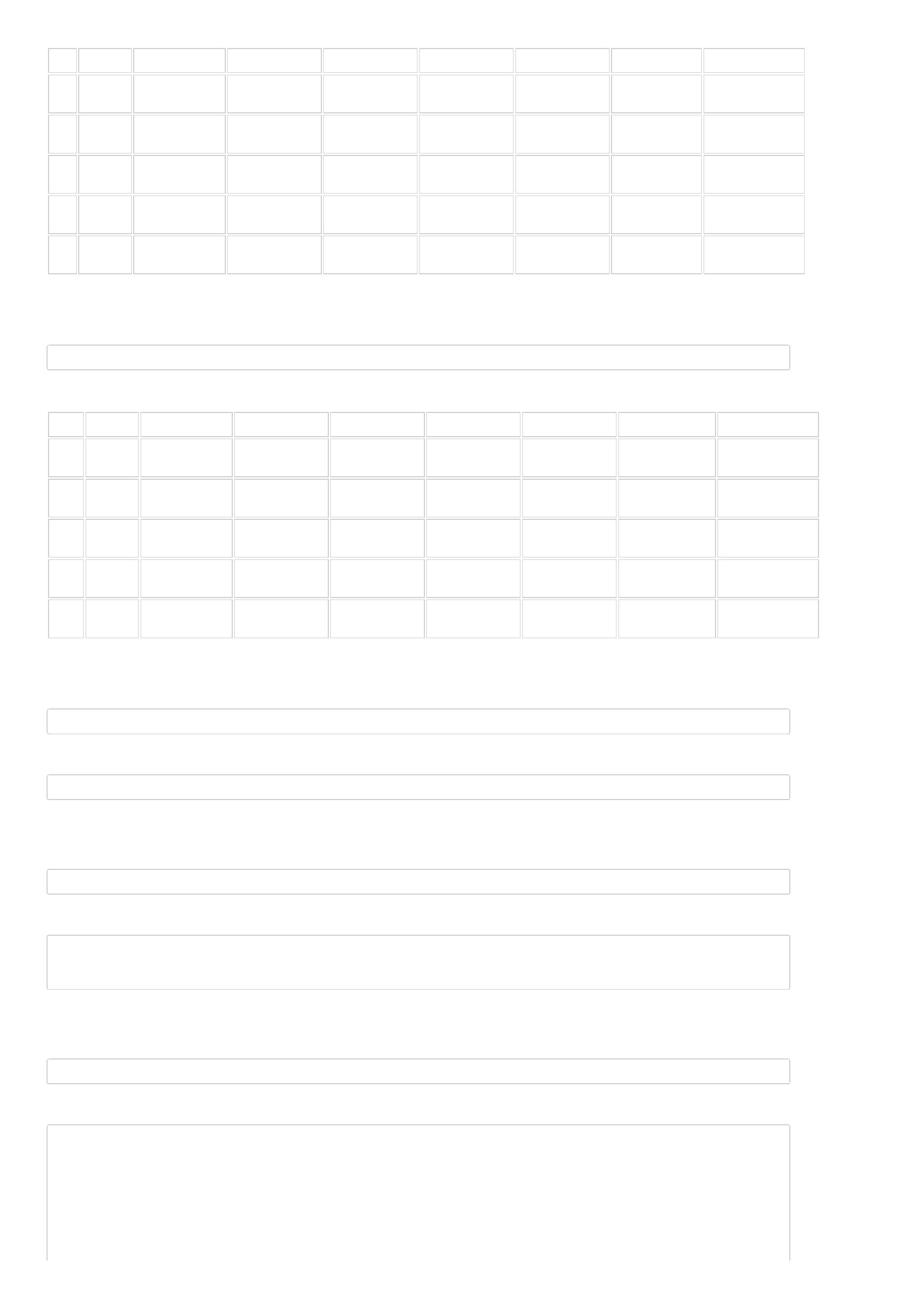

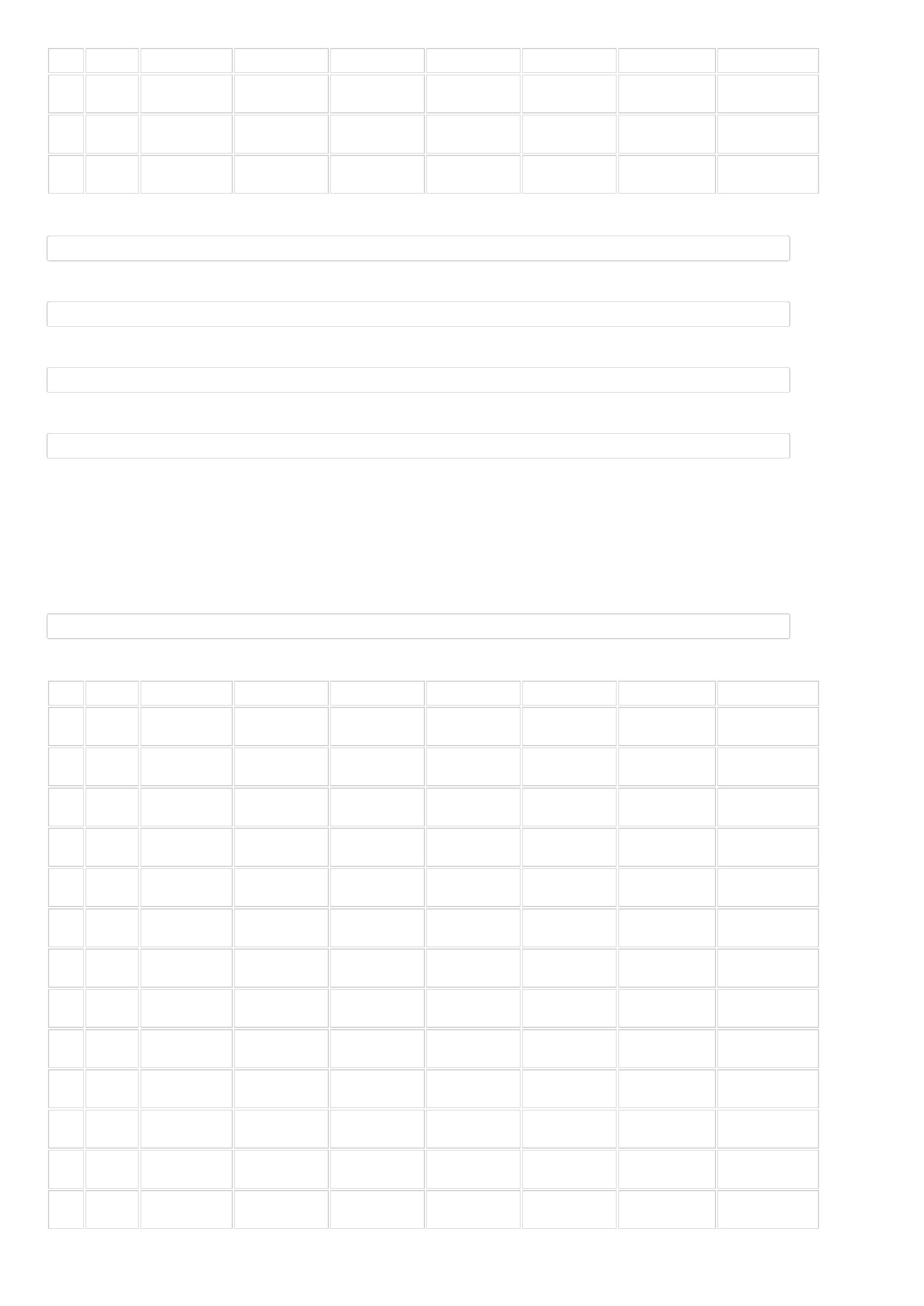

Out[1]:

date

instrument

open

high

low

close

volume

amount

2

017-

0

1

2

3

4

000300.SHA

3313.953369

3345.262939

3313.953369

3342.227295

8656789600

8.761277e+10

01-03

2

0

017-

1-04

000300.SHA

000300.SHA

000300.SHA

000300.SHA

3340.557617

3368.340088

3366.852295

3345.748291

3369.565918

3373.411865

3368.870605

3366.221924

3338.152588

3361.461914

3346.891357

3344.347168

3368.311768

3367.789307

3347.666504

3363.901367

9005082700

8833635700

8745911400

8370794200

9.801436e+10

9.118934e+10

9.107226e+10

8.791612e+10

2

0

017-

1-05

2

0

017-

1-06

2

0

017-

1-09

获取交易日历——获取一段日期内的交易日历

In [2]:

date = D.trading_days(start_date='2016-01-01', end_date='2016-12-01')

date[:10] # 只打印前10个

Out[2]:

date

date

6125

6126

6127

6128

6129

6130

6131

6132

6133

6134

2016-01-04

2016-01-05

2016-01-06

2016-01-07

2016-01-08

2016-01-11

2016-01-12

2016-01-13

2016-01-14

2016-01-15

获取股票代码——获取一段时间内上市股票的代码列表

In [3]:

symbols = D.instruments(start_date='2015-01-01', end_date='2016-01-01')

symbols[:10] # 只看前10个

Out[3]:

[

'000001.SZA',

'

'

'

'

'

'

'

'

'

000002.SZA',

000004.SZA',

000005.SZA',

000006.SZA',

000007.SZA',

000008.SZA',

000009.SZA',

000010.SZA',

000011.SZA']

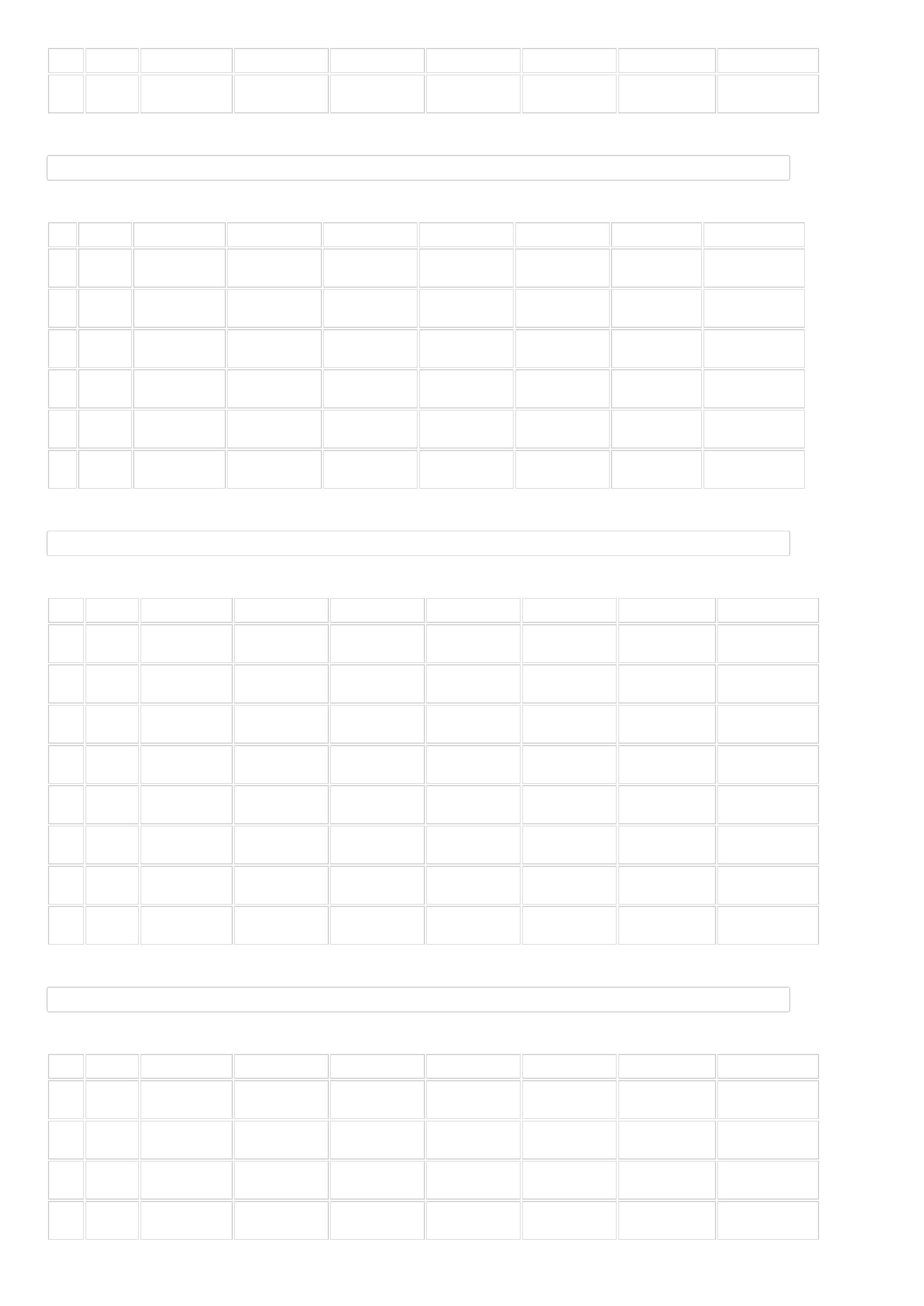

获取历史数据——以贵州茅台举例¶

获取贵州茅台代码、证券名称、上市日期、上市板、公司名称、公司成立日期、公司省份

In [4]:

D.history_data('600519.SHA', start_date='2016-01-01', end_date='2016-01-10', fields=['name','list_date','list_board','company_name','

Out[4]:

date

instrument

name

list_date

list_board

company_name

company_found_date

1999-11-20

company_province

2016-

贵州

茅台

2001-08-

27

贵州茅台酒股份

有限公司

0

1

2

3

4

600519.SHA

主板

贵州省

01-04

2

0

016-

1-05

贵州

茅台

2001-08-

27

贵州茅台酒股份

有限公司

600519.SHA

600519.SHA

600519.SHA

600519.SHA

主板

主板

主板

主板

1999-11-20

1999-11-20

1999-11-20

1999-11-20

贵州省

贵州省

贵州省

贵州省

2

0

016-

1-06

贵州

茅台

2001-08-

27

贵州茅台酒股份

有限公司

2

0

016-

1-07

贵州

茅台

2001-08-

27

贵州茅台酒股份

有限公司

2

0

016-

1-08

贵州

茅台

2001-08-

27

贵州茅台酒股份

有限公司

获取贵州茅台交易行情数据,包括开盘价、最低价、最高价、收盘价、复权因子、成交量、换手率

In [5]:

D.history_data('600519.SHA', start_date='2016-01-01', end_date='2016-01-10', fields=['open','low','high','close','adjust_factor','vol

Out[5]:

date

instrument

open

low

high

close

adjust_factor

6.856917

volume

turn

2016-

0

1

2

3

4

600519.SHA

1494.807861

1439.884033

1494.807861

1440.089722

1734968

0.13811

01-04

2

0

016-

1-05

600519.SHA

600519.SHA

600519.SHA

600519.SHA

1439.952515

1459.014771

1433.027100

1399.976685

1422.878906

1435.152710

1371.589111

1371.383423

1467.174561

1465.048828

1433.027100

1426.238770

1459.289062

1454.900635

1386.674316

1403.130981

6.856917

6.856917

6.856917

6.856917

3190891

2376090

814868

0.2540

2

0

016-

1-06

0.18914

0.06486

0.35432

2

0

016-

1-07

2

0

016-

1-08

4451009

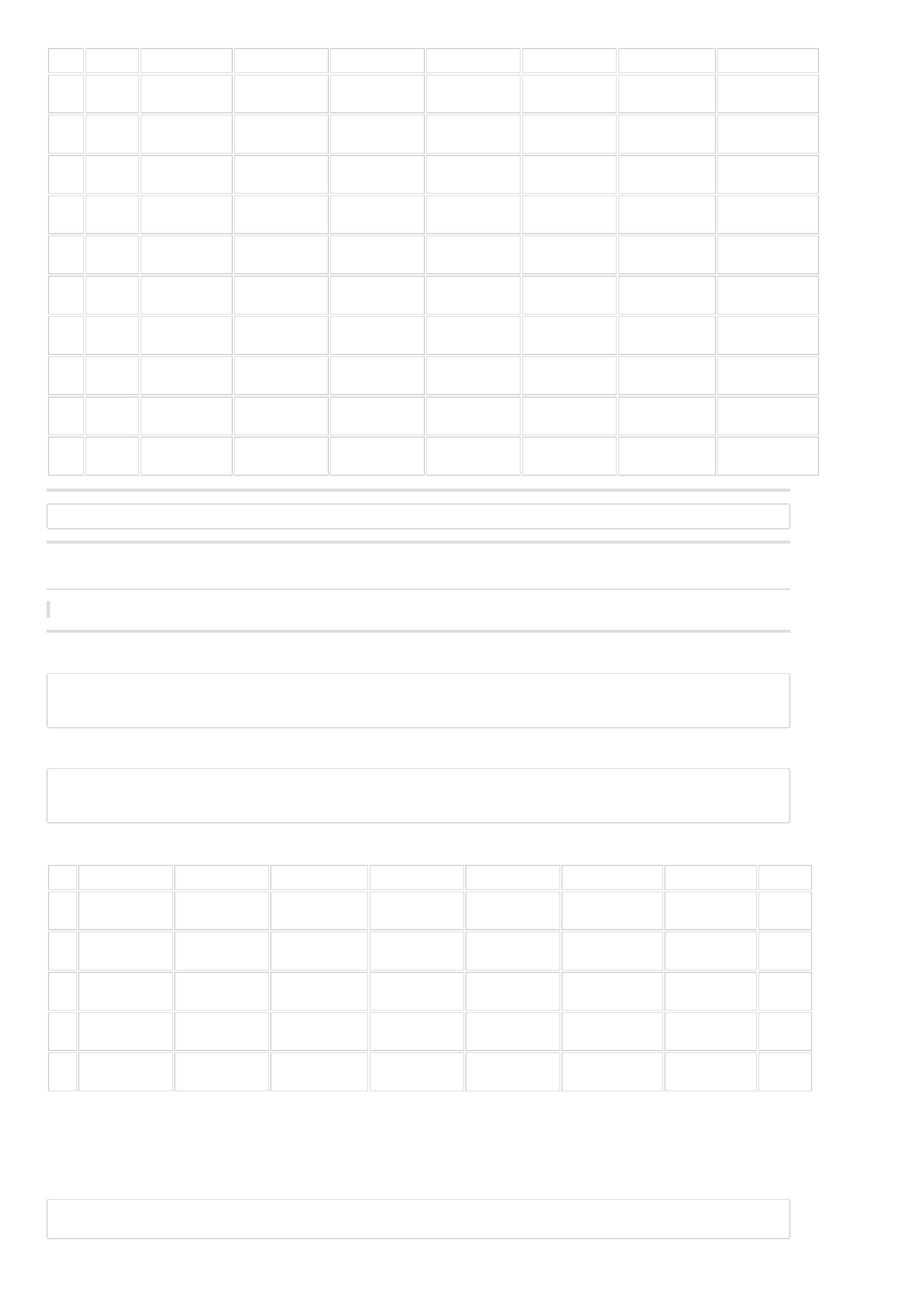

获取贵州茅台交易状态数据,比如是否停牌,停牌类型,停牌原因,ST状态,股价在收盘时的涨跌停状态

In [6]:

D.history_data('600519.SHA', start_date='2016-01-01', end_date='2016-01-10', fields=['suspended','suspend_type','suspend_reason','st_

Out[6]:

date

instrument

st_status

price_limit_status

suspended

False

suspend_type

suspend_reason

0

1

2

3

4

2016-01-04

2016-01-05

2016-01-06

2016-01-07

2016-01-08

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

0

0

0

0

0

2

2

2

2

2

False

False

False

False

获取贵州茅台估值数据,总市值、流通市值、市盈率、市销率.

注:ttm是trailing twelve month的简称,表示过去12个月,pe_ttm表示过去12个月以来的市盈率.

In [7]:

D.history_data('600519.SHA', start_date='2016-01-01', end_date='2016-01-10', fields=['market_cap','market_cap_float','pe_ttm','ps_ttm

Out[7]:

date

instrument

market_cap

market_cap_float

2.638267e+11

2.673440e+11

2.665401e+11

2.540409e+11

2.570558e+11

pe_ttm

ps_ttm

0

1

2

3

4

2016-01-04

2016-01-05

2016-01-06

2016-01-07

2016-01-08

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

2.638267e+11

2.673440e+11

2.665401e+11

2.540409e+11

2.570558e+11

16.405994

16.624722

16.574726

15.797469

15.984948

7.993675

8.100246

8.075888

7.697176

7.788523

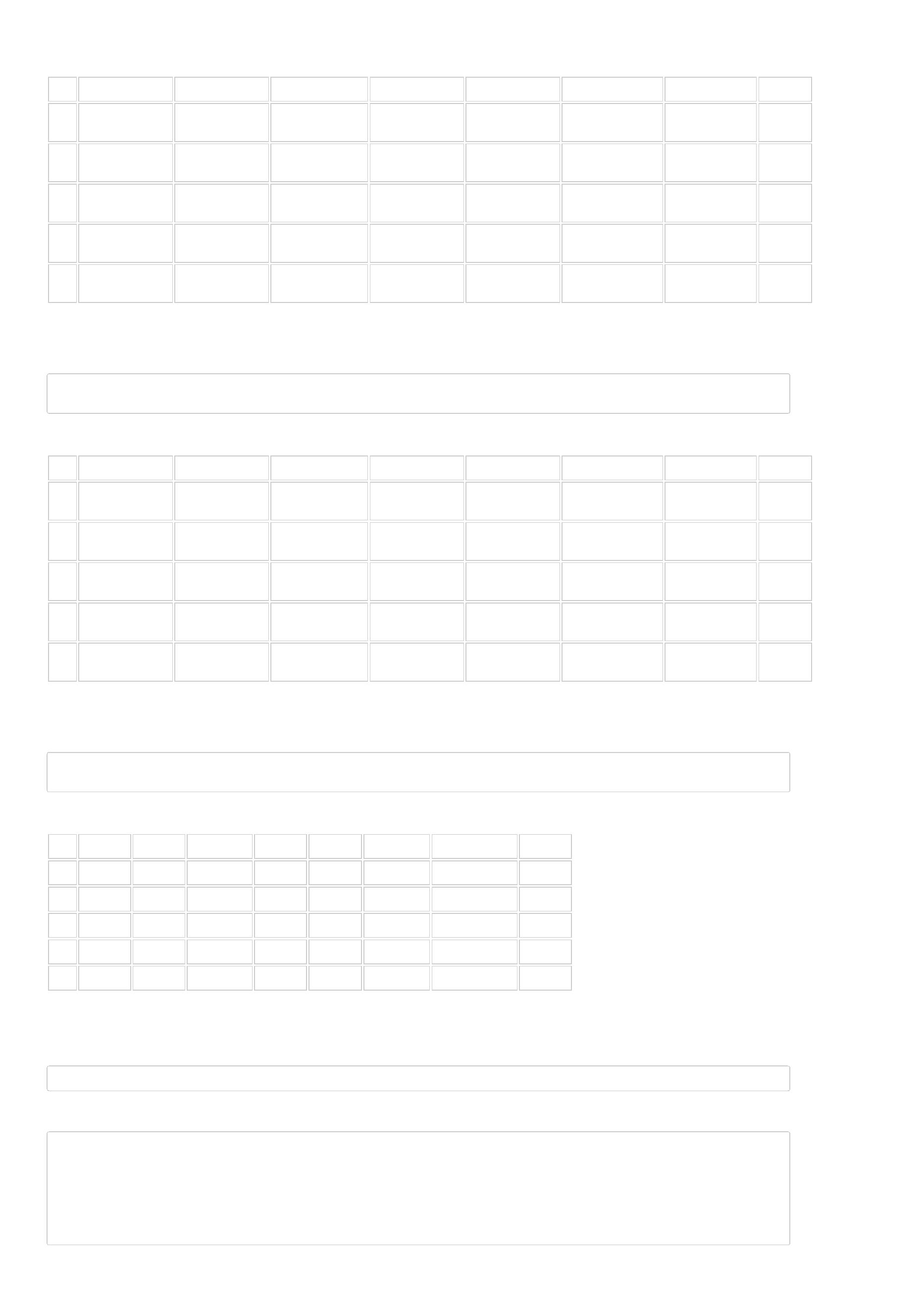

获取财报数据——以贵州茅台举例¶

获取财报发布时间信息数据,比如发布日期、财报类型、财报对应的年份、财报对应的季度

注:财报类型如果为20131231表示13年年报,20140331表示14年一季报

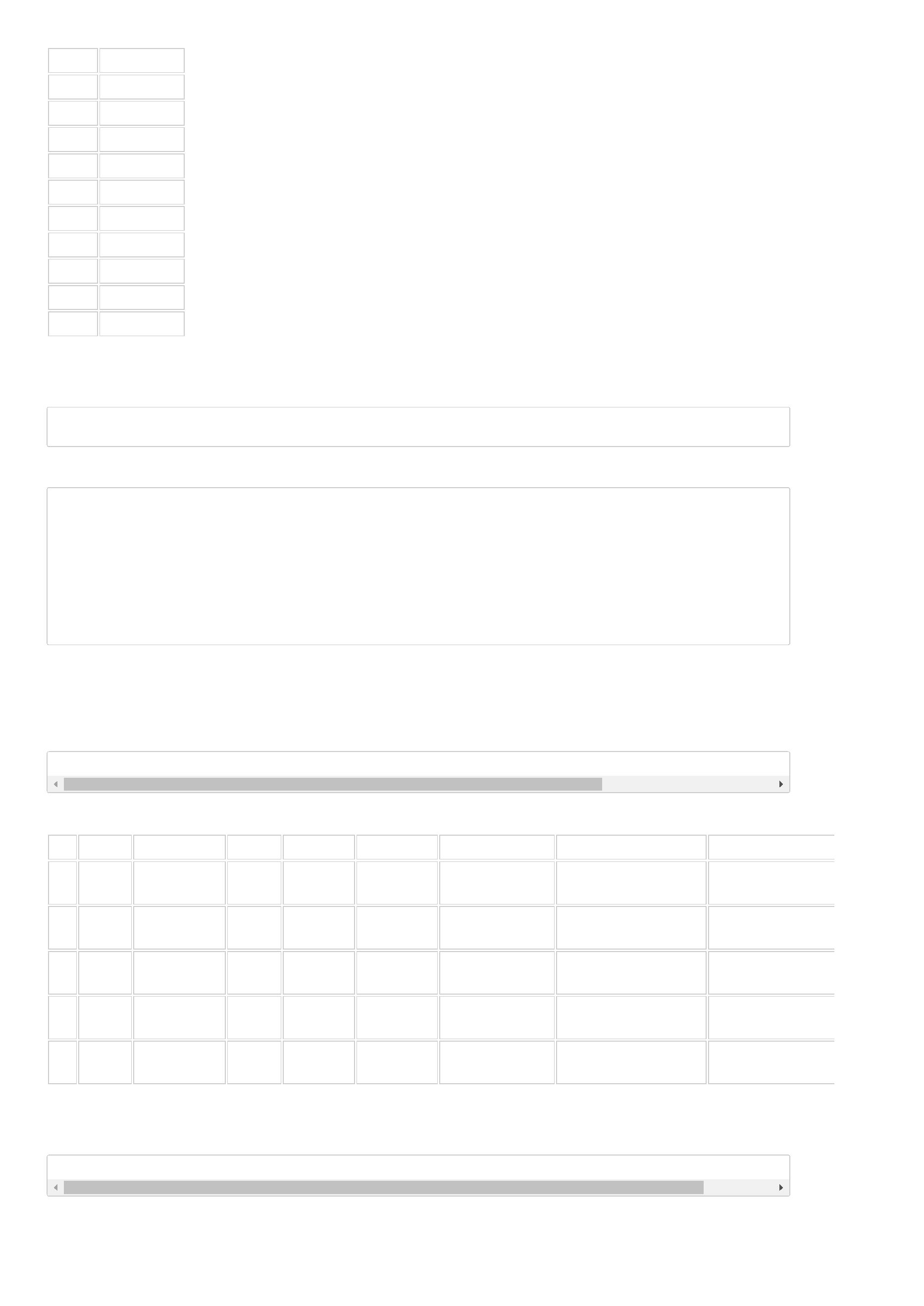

In [8]:

D.financial_statements('600519.SHA', start_date='2014-01-01', end_date='2016-01-01', fields=['fs_publish_date','fs_quarter','fs_quart

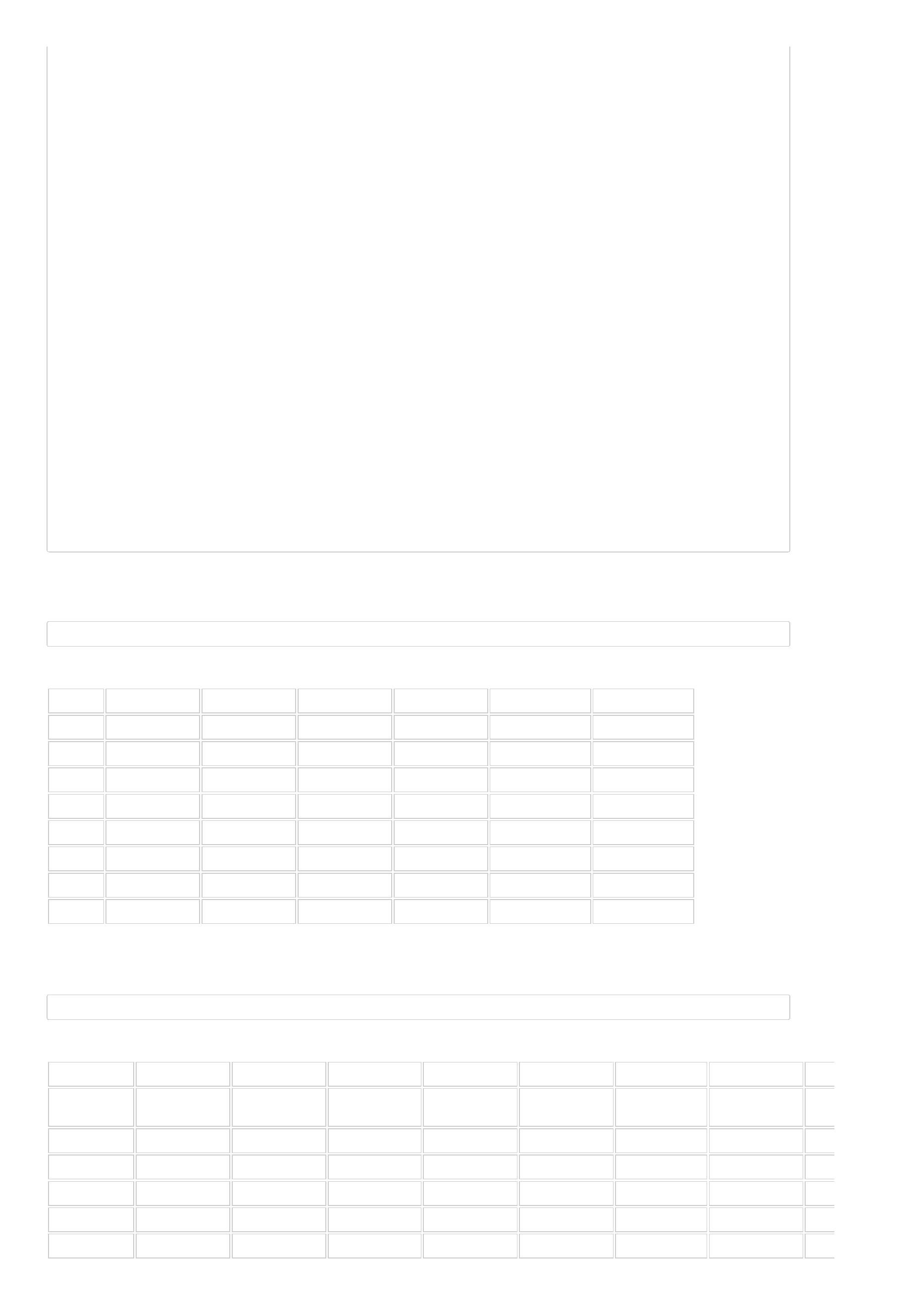

Out[8]:

fs_publish_date

2014-03-25

2014-04-25

2014-08-29

fs_quarter

20131231

20140331

20140630

fs_quarter_year

2013

fs_quarter_index

0

1

2

4

1

2

2014

2014

fs_publish_date

2014-10-30

2015-04-21

2015-04-21

2015-08-28

2015-10-23

fs_quarter

20140930

20141231

20150331

20150630

20150930

fs_quarter_year

2014

fs_quarter_index

3

4

5

6

7

3

4

1

2

3

2014

2015

2015

2015

获取贵州茅台财报类型、净资产收益率 (TTM)、总资产报酬率 (TTM)、销售净利率 (TTM)、销售毛利率 (TTM)

In [9]:

D.financial_statements('600519.SHA', start_date='2014-01-01', end_date='2016-01-01', fields=['fs_quarter','fs_roe_ttm','fs_roa_ttm','

Out[9]:

fs_quarter

20131231

20140331

20140630

20140930

20141231

20150331

20150630

20150930

fs_roe_ttm

35.513500

32.930901

33.391201

30.282301

28.728600

27.715099

26.112600

26.869900

fs_roa_ttm

37.874298

37.993698

38.548801

35.400101

33.030701

32.959099

31.407101

29.377600

fs_net_profit_margin_ttm

51.629902

fs_gross_profit_margin_ttm

92.904900

0

1

2

3

4

5

6

7

51.735401

92.886803

51.448601

92.772400

51.062599

92.358200

51.527901

92.593399

51.868999

92.618500

51.374100

92.380203

51.570301

92.448601

获取特色因子数据——以贵州茅台举例¶

获取量价因子

注:$open\_\$i$中的$\$$符号表示该因子可以回溯,没有$\$$符号表示该因子不能回溯。比如$open\_\$i$中指明了$i$取值范围是[0 .. 20],$i$为0表示当天

的因子值,$i=1$表示前1天的因子值,以此类推。

In [10]:

D.features('600519.SHA', start_date='2015-01-01', end_date='2015-01-12', fields=['close_0', 'close_1','volume_0','volume_2'])

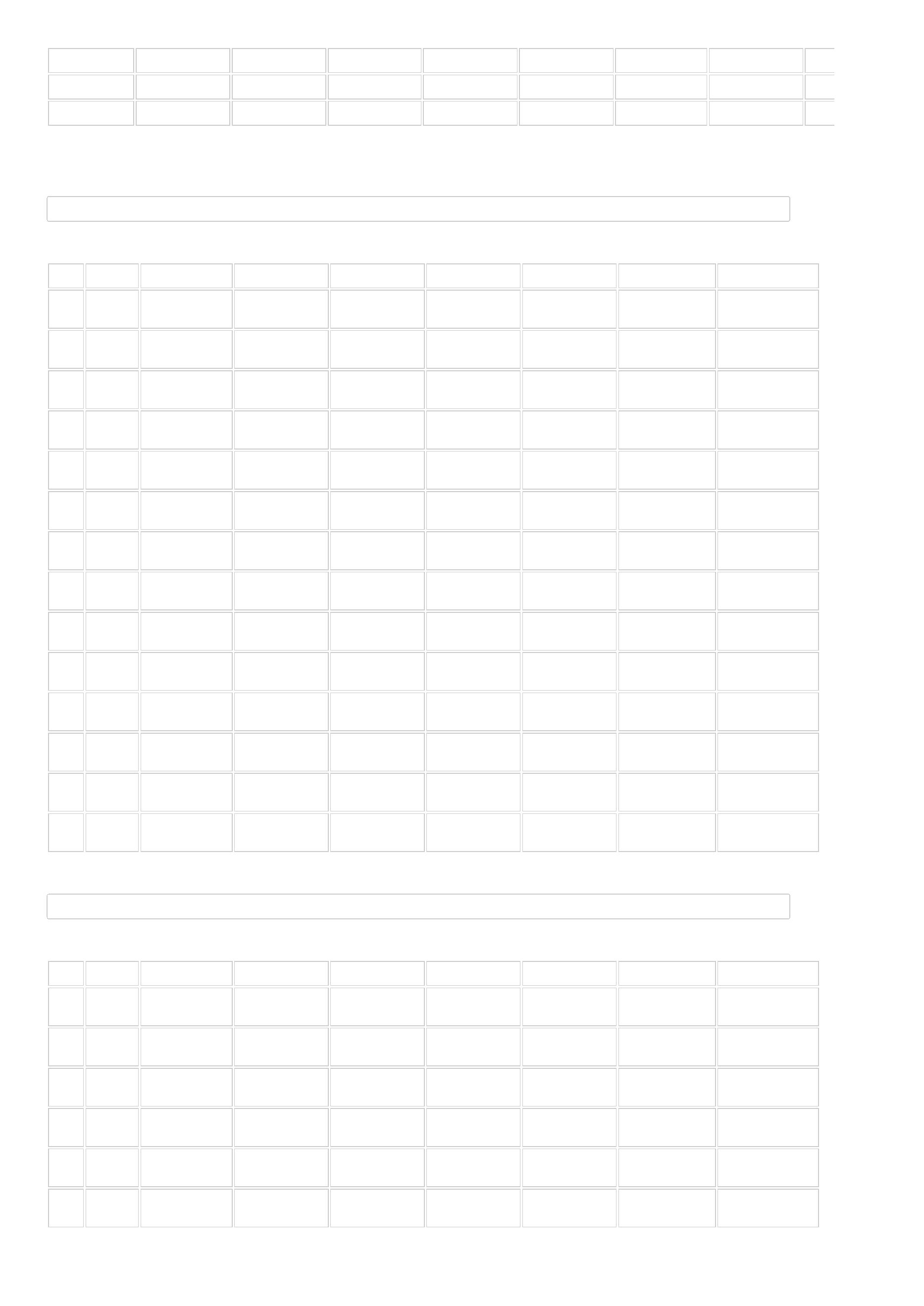

Out[10]:

date

instrument

close_0

close_1

volume_0

9451517

5502001

5479784

4052530

5398220

4991459

volume_2

5617110.0

4626936.0

9451517.0

5502001.0

5479784.0

4052530.0

0

1

2

3

4

5

2015-01-05

2015-01-06

2015-01-07

2015-01-08

2015-01-09

2015-01-12

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

1240.462891

1211.736084

1181.784180

1174.556519

1165.675049

1141.909424

1161.448608

1240.462891

1211.736084

1181.784180

1174.556519

1165.675049

获取排名因子,以收益率和平均交易额为例

注:涉及到排名的因子,将该因子在全市场所有股票进行升序排序,排名因子=从小到大排名序号/总数

In [11]:

D.features('600519.SHA', start_date='2015-01-01', end_date='2015-01-12', fields=['return_5', 'rank_return_5','avg_amount_5','rank_avg

Out[11]:

date

instrument

return_5

1.106304

1.064575

avg_amount_5

1.178067e+09

1.226070e+09

rank_return_5

0.889652

rank_avg_amount_5

0.957492

0

1

2015-01-05

2015-01-06

600519.SHA

600519.SHA

0.846220

0.955756

date

instrument

return_5

1.028629

1.045128

1.018572

0.983177

avg_amount_5

1.271168e+09

1.121106e+09

1.120563e+09

1.131073e+09

rank_return_5

0.722246

0.744854

0.421165

rank_avg_amount_5

0.955889

2

3

4

5

2015-01-07

2015-01-08

2015-01-09

2015-01-12

600519.SHA

600519.SHA

600519.SHA

600519.SHA

0.952463

0.952116

0.397002

0.951178

获取财报特色因子,以赢利因子为例

注:财报特色因子后缀为$\_0$,表明该因子不取回溯值,直接使用当期值进行实验

In [12]:

D.features('600519.SHA', start_date='2015-01-01', end_date='2015-01-12', fields=['fs_roe_ttm_0', 'rank_fs_roe_ttm_0'])

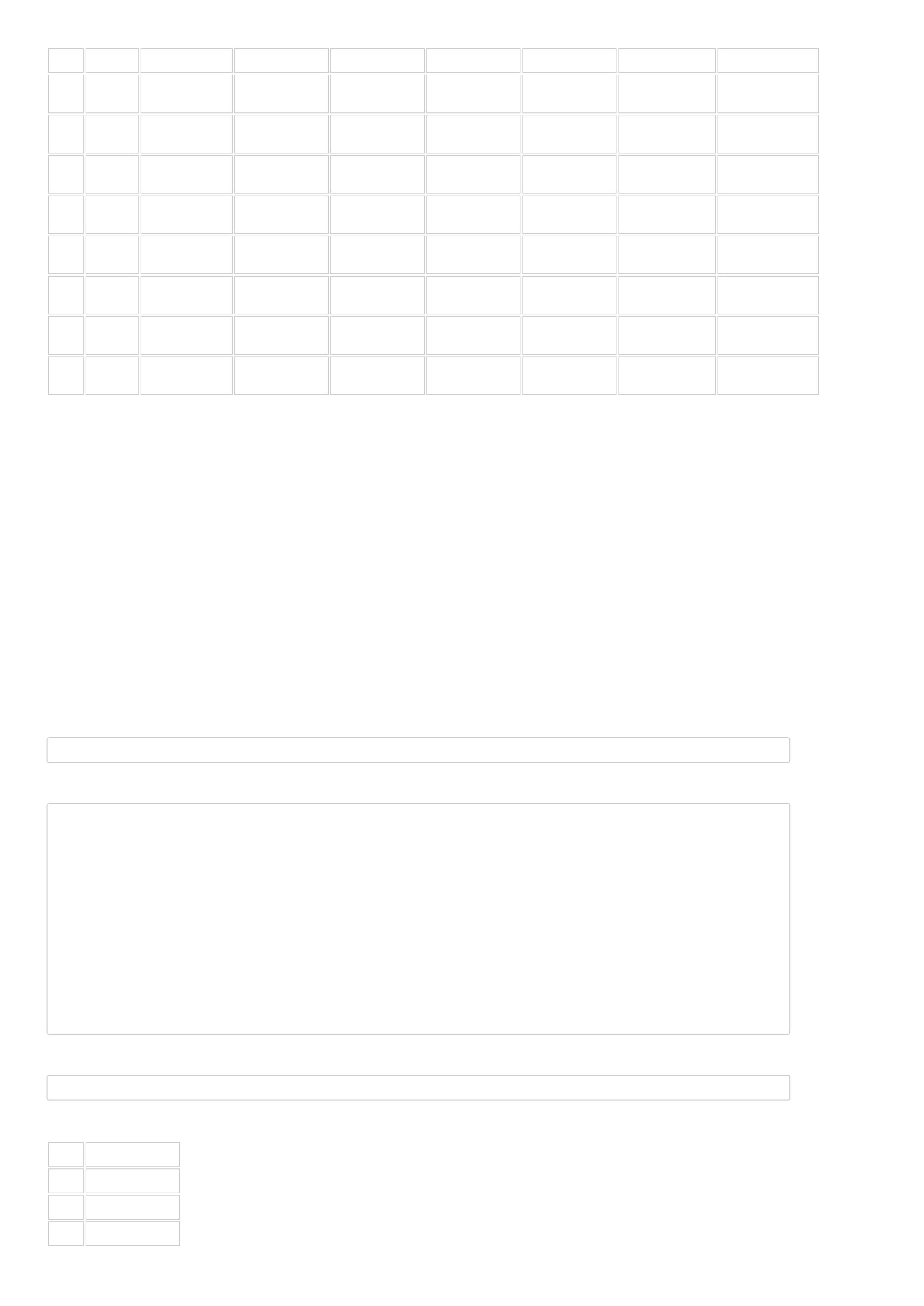

Out[12]:

date

instrument

fs_roe_ttm_0

30.282301

30.282301

30.282301

30.282301

30.282301

30.282301

rank_fs_roe_ttm_0

0.985127

0

1

2

3

4

5

2015-01-05

2015-01-06

2015-01-07

2015-01-08

2015-01-09

2015-01-12

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

0.985120

0.985153

0.986008

0.986002

0.985977

获取技术因子,以移动平均值为例

In [13]:

D.features('600519.SHA', start_date='2015-01-01', end_date='2015-01-12', fields=['ta_sma_5_0', 'ta_sma_20_0'])

Out[13]:

date

instrument

ta_sma_5_0

1163.812988

1176.381714

1187.970459

1193.997681

1194.842896

1175.132202

ta_sma_20_0

1116.284912

1124.526367

1130.642334

1136.430542

1139.612549

1142.840454

0

1

2

3

4

5

2015-01-05

2015-01-06

2015-01-07

2015-01-08

2015-01-09

2015-01-12

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

600519.SHA

上一页:做量化您需要知道的那些术语

下一页:BigQuant模块介绍

目录:BigQuant学院

null

【

宽客学院】如何选出符合一定条件的股票

在开发股票量化策略的时候,其中非常重要的一步就是选股。因此本文的目的是希望大家阅读以后,能够更为快速、高效、便捷地在BigQuant平台上

选出符合一定条件的股票。

符合一定条件的股票可以这样理解,这类股票具有同样的特征、属性,比如属于同一个板块,或者相似的财务指标,或者是存在相似的图表形态。

那么,怎样快速地选出符合一定条件的股票呢。主要因素为下面两点:

BigQuant数据以及数据API的了解

Pandas数据分析技巧

扩展阅读

1

2

3

4

完整代码如下:

参数

In [58]:

start_date = '2016-01-01'

end_date = '2017-09-14'

instrument = D.instruments(start_date=start_date, end_date=end_date)

1

.基本信息层面¶

获取指数成分股列表

In [59]:

#

沪深300指数成分

df = D.history_data(instrument, start_date, end_date, ['in_csi300'])

instruments = list(set(df[df['in_csi300']==1]['instrument']))

print('沪深300指数成分股预览10只股票:', instruments[:10])

沪深300指数成分股预览10只股票: ['601607.SHA', '600153.SHA', '600048.SHA', '002299.SZA', '601288.SHA', '000831.SZA', '600703.SHA', '6003

获取某个行业股票列表

In [60]:

#

(举例)获取国防军工行业股票列表

df = D.history_data(instrument, start_date, end_date, ['industry_sw_level1'])

instruments = list(set(df[df['industry_sw_level1'] == 650000]['instrument']))

D.history_data(instruments, '2017-07-27', '2017-07-27', ['company_name']).head()

Out[60]:

instrument

company_name

date

441666

441690

441833

441849

442030

000519.SZA

000547.SZA

000738.SZA

000768.SZA

002013.SZA

中兵红箭股份有限公司

2017-07-27

2017-07-27

2017-07-27

2017-07-27

2017-07-27

航天工业发展股份有限公司

中国航发动力控制股份有限公司

中航飞机股份有限公司

中航工业机电系统股份有限公司

获取某个概念、板块的股票列表

In [61]:

df = D.history_data(instrument, '2017-08-23', '2017-08-23', ['concept']).dropna()

# 'concept' 是股票的概念字段

df['is_ai'] = df['concept'].map(lambda x: '人工智能' in x) # 以人工智能为例,找到相关概念股票

st = list(df[df['is_ai'] == True]['instrument'])

D.history_data(st,'2017-08-23','2017-08-23',['name', 'concept']).head()

Out[61]:

instrument

name

date

concept

0

1

2

3

4

000977.SZA

002049.SZA

002073.SZA

002184.SZA

002226.SZA

浪潮信息

紫光国芯

软控股份

海得控制

江南化工

2017-08-23

2017-08-23

2017-08-23

2017-08-23

2017-08-23

云计算;IPV6;大数据;网络安全;去IOE;人工智能;雄安新区;融资融券;融资融券标的

物联网;重组;智能IC卡;芯片国产化;国家队;高校;人工智能;融资融券;融资融券标的

机器人;工业4.0;国家队;人工智能;融资融券;融资融券标的

智能电网;浦东新区;机器人;工业4.0;军民融合;人工智能

重组;人工智能;预增;并购阶段(需定增)

获取每日创业板次新股股票列表

次新股的定义为上市90天以内

In [62]:

df = D.history_data(instrument, start_date, end_date, ['list_date', 'list_board'])

from datetime import timedelta

df[(df['list_board']=='创业板')&(df['date']<=df['list_date']+timedelta(days=20))].head(10)

Out[62]:

date

instrument

list_date

list_board

创业板

创业板

创业板

创业板

创业板

创业板

创业板

创业板

创业板

创业板

1733

1734

1735

1737

1738

1740

4580

4581

4582

4584

2016-01-04

2016-01-04

2016-01-04

2016-01-04

2016-01-04

2016-01-04

2016-01-05

2016-01-05

2016-01-05

2016-01-05

300490.SZA

300491.SZA

300492.SZA

300494.SZA

300495.SZA

300497.SZA

300490.SZA

300491.SZA

300492.SZA

300494.SZA

2015-12-31

2015-12-31

2015-12-23

2015-12-31

2015-12-22

2015-12-22

2015-12-31

2015-12-31

2015-12-23

2015-12-31

2

.财务信息层面¶

选出满足以下条件的股票

市盈率小于15倍

市净率小于1.5倍

In [63]:

#

获取市盈率、市净率、成交额数据

history_data = D.history_data(instrument, start_date=start_date, end_date= end_date, fields=[ 'pb_lf', 'pe_ttm','amount'])

result = history_data[(history_data['pb_lf'] < 1.5)

&

&

&

&

(history_data['pe_ttm'] < 15)

(history_data['amount'] > 0)

(history_data['pb_lf'] > 0)

(history_data['pe_ttm'] > 0)]

daily_buy_stock = result.groupby('date').apply(lambda df:list(df.sort_values(['pe_ttm','pb_lf']).instrument)[:30])

daily_buy_stock.head()

Out[63]:

date

2

2

2

2

2

016-01-04

016-01-05

016-01-06

016-01-07

016-01-08

[601288.SHA, 601398.SHA, 601939.SHA, 601166.SH...

[601288.SHA, 601398.SHA, 601939.SHA, 601166.SH...

[601288.SHA, 601398.SHA, 601939.SHA, 601166.SH...

[601288.SHA, 601398.SHA, 601939.SHA, 600015.SH...

[601288.SHA, 601398.SHA, 601939.SHA, 600015.SH...

dtype: object

选出满足以下条件的股票

市净率小于8

市现率大于0.4

资产周转率大于0.4

市值最小的10只股票

In [64]:

stock_num = 10

#

通过history_data接口获取历史数据

history_data = D.history_data(instrument, start_date, end_date, ['pb_lf', 'ps_ttm', 'market_cap', 'amount'])

通过feature接口获取财务数据

financial = D.features(instrument, start_date=start_date, end_date=end_date,

fields=['fs_operating_revenue_ttm_0','fs_current_assets_0','fs_non_current_assets_0'])

总资产=流动资产+非流动资产

financial['total_assets'] = financial['fs_current_assets_0'] + financial['fs_non_current_assets_0']

资产周转率=营业收入/总资产

#

#

#

financial['asset_turnover'] = financial['fs_operating_revenue_ttm_0'] / financial['total_assets']

financial_data = financial[['date','instrument','asset_turnover']]

#

两个DataFrame:历史数据、财务数据 合并

result = history_data.merge(financial_data, on=['date','instrument'], how='outer')

#

按照选股法则选出股票

daily_buy_stock = result.groupby('date').apply(lambda df:list(df[(df['ps_ttm']>0.4) & (df['pb_lf']<8) & (df['asset_turnover']>0.4)

(df['amount']>100)].sort_values('market_cap')['instrument'])[:stock_num])

&

daily_buy_stock.head()

Out[64]:

date

2

2

2

2

2

016-01-04

016-01-05

016-01-06

016-01-07

016-01-08

[600099.SHA, 300176.SZA, 600719.SHA, 300106.SZ...

[600099.SHA, 300176.SZA, 300106.SZA, 600719.SH...

[600099.SHA, 300176.SZA, 600719.SHA, 300106.SZ...

[600099.SHA, 300176.SZA, 600719.SHA, 300106.SZ...

[600099.SHA, 002109.SZA, 600719.SHA, 300106.SZ...

dtype: object

3

.技术指标层面¶

选出满足以下条件的股票

7

日均线上穿63日均线

收盘价突破ATR上轨

In [65]:

df= D.history_data(instrument, start_date, end_date, ['open', 'high', 'low', 'close'])

import talib as ta

from numpy import float as f

def seek_stocks(df):

df['ma_7'] = ta.SMA(df.close.map(f).values, 7)

df['ma_63'] = ta.SMA(df.close.map(f).values, 63)

try:

df['atr'] = ta.ATR(df.high.map(f).values, df.low.map(f).values, df.close.map(f).values, 14)

except Exception as e:

df['atr'] = np.nan

df['upperline'] = df.close.rolling(14).mean() + df['atr']

return df[(df['ma_7']>df['ma_63'])&(df['close']>=df['upperline'])].drop('instrument', axis=1)

result = df.groupby('instrument').apply(seek_stocks).reset_index()

daily_buy_stock = result.groupby('date').apply(lambda df:list(df['instrument']))

daily_buy_stock.head()

Out[65]:

date

2

2

2

2

2

016-04-07

016-04-08

016-04-11

016-04-12

016-04-13

[000009.SZA, 000018.SZA, 000040.SZA, 000049.SZ...

[000009.SZA, 000018.SZA, 000036.SZA, 000040.SZ...

[000009.SZA, 000018.SZA, 000028.SZA, 000035.SZ...

[000028.SZA, 000035.SZA, 000036.SZA, 000040.SZ...

[000009.SZA, 000014.SZA, 000016.SZA, 000028.SZ...

dtype: object

选出满足以下条件的股票

股价创60日最高点

3

日线上穿5日均线,5日均线上穿10日均线

当日成交额是昨日成交额的1.4倍

macd柱状图处于红色区域

In [67]:

df =D.history_data(instrument, start_date, end_date, ['close', 'amount','high'])

def seek_stocks(df):

df['highest_60'] = df['high'].rolling(60).max() # 计算60天最高点

df['ma3_cross_ma5'] = df['close'].rolling(3).mean() - df['close'].rolling(5).mean() > 0 # 3日均线上穿5日均线

df['ma5_cross_ma10'] = df['close'].rolling(5).mean() - df['close'].rolling(10).mean() > 0 # 5日均线上穿10日均线

df['amount_cond'] = df['amount'] / df['amount'].shift(1) - 1 >= 0.4

# 当日成交量比前一日成交量大40%

prices = df['close'].map(np.float) # 转化成float格式

#

macd:diff线 信号线:dea 柱状图:diff-dea

macd, signal, hist = ta.MACD(np.array(prices), 12, 26, 9) # 计算macd各个指标

df['is_highest'] = df['close'] == df['highest_60'] # 该列是布尔型变量,表明是否是60日最高点

df['hist_is_red'] = hist > 0

return df

# macd柱状图是否在红色区域

managed_df = df.groupby('instrument').apply(seek_stocks).reset_index()

result= managed_df[

(managed_df['hist_is_red'])&

# macd在红色区域

(managed_df['is_highest'])&

# 是60日最高点

(managed_df['ma3_cross_ma5'])& # 3日均线上穿5日均线

(managed_df['ma5_cross_ma10'])&

(managed_df['amount_cond'])]

# 5日均线上穿10日均线

# 满足成交量条件

#

整理出每日符合买入条件的列表

daily_buy_stock = result.groupby('date').apply(lambda df:list(df.instrument)).reset_index().rename(columns={0:'stocks'})

daily_buy_stock.head()

Out[67]:

date

stocks

0

1

2

3

4

2016-04-01

2016-04-05

2016-04-06

2016-04-07

2016-04-08

[000059.SZA, 000657.SZA, 000913.SZA, 300419.SZA]

[000533.SZA, 000615.SZA, 002364.SZA, 002452.SZ...

[000670.SZA, 000799.SZA, 000995.SZA, 002134.SZ...

[002455.SZA, 300187.SZA, 600168.SHA, 600311.SH...

[000953.SZA, 002139.SZA, 002537.SZA, 300134.SZ...

上一页:BigQuant模块介绍

目录:BigQuant学院

宽客中学

BigQuant 平台高效使用指南

在这里分享如何高效的使用BigQuant平台开发策略。

上一页:BigQuant模块介绍

下一页:策略回测结果解读

目录:BigQuant学院

【

宽客学院】策略回测结果解读

本文主要介绍如何对策略回测结果进行解读。

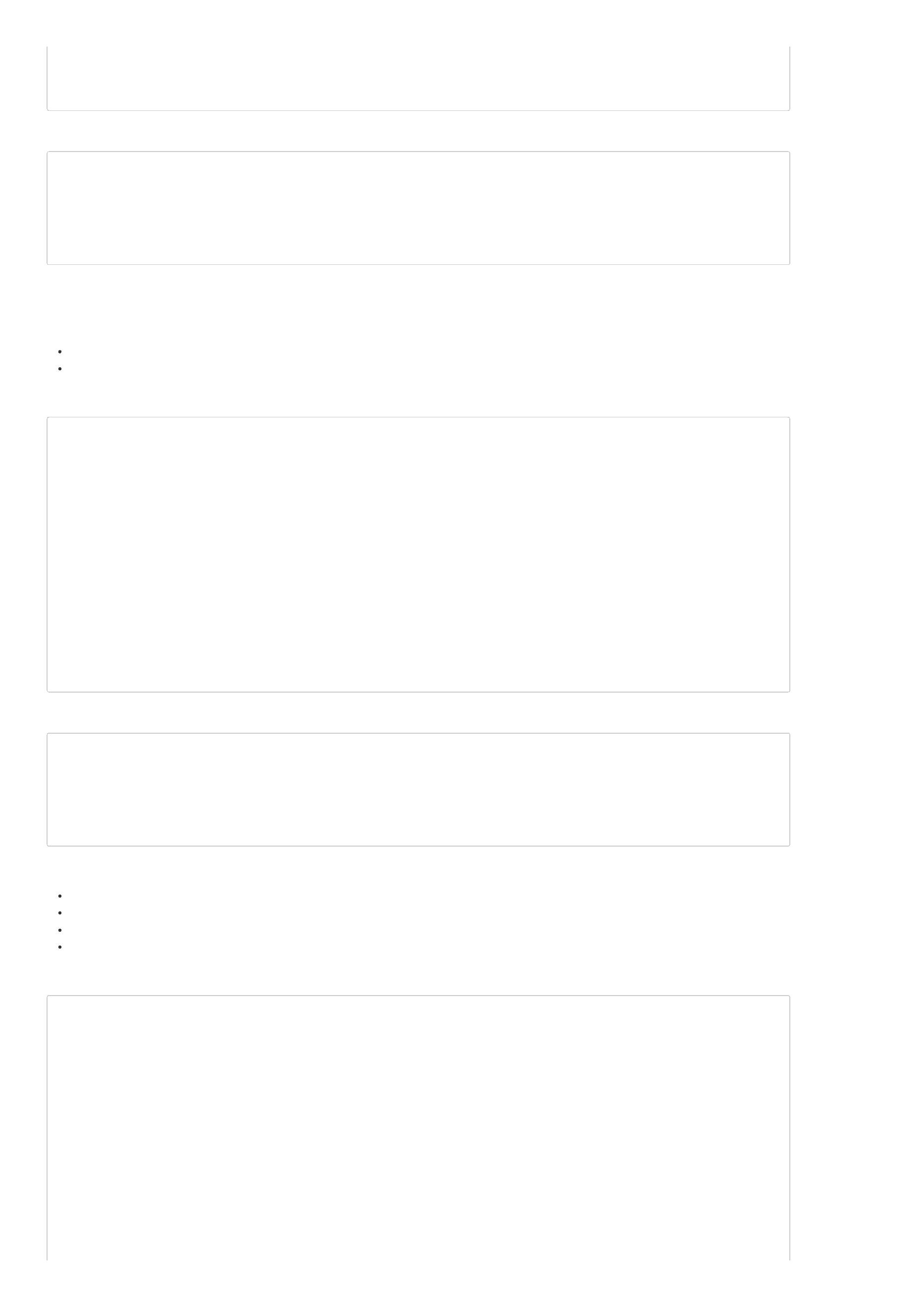

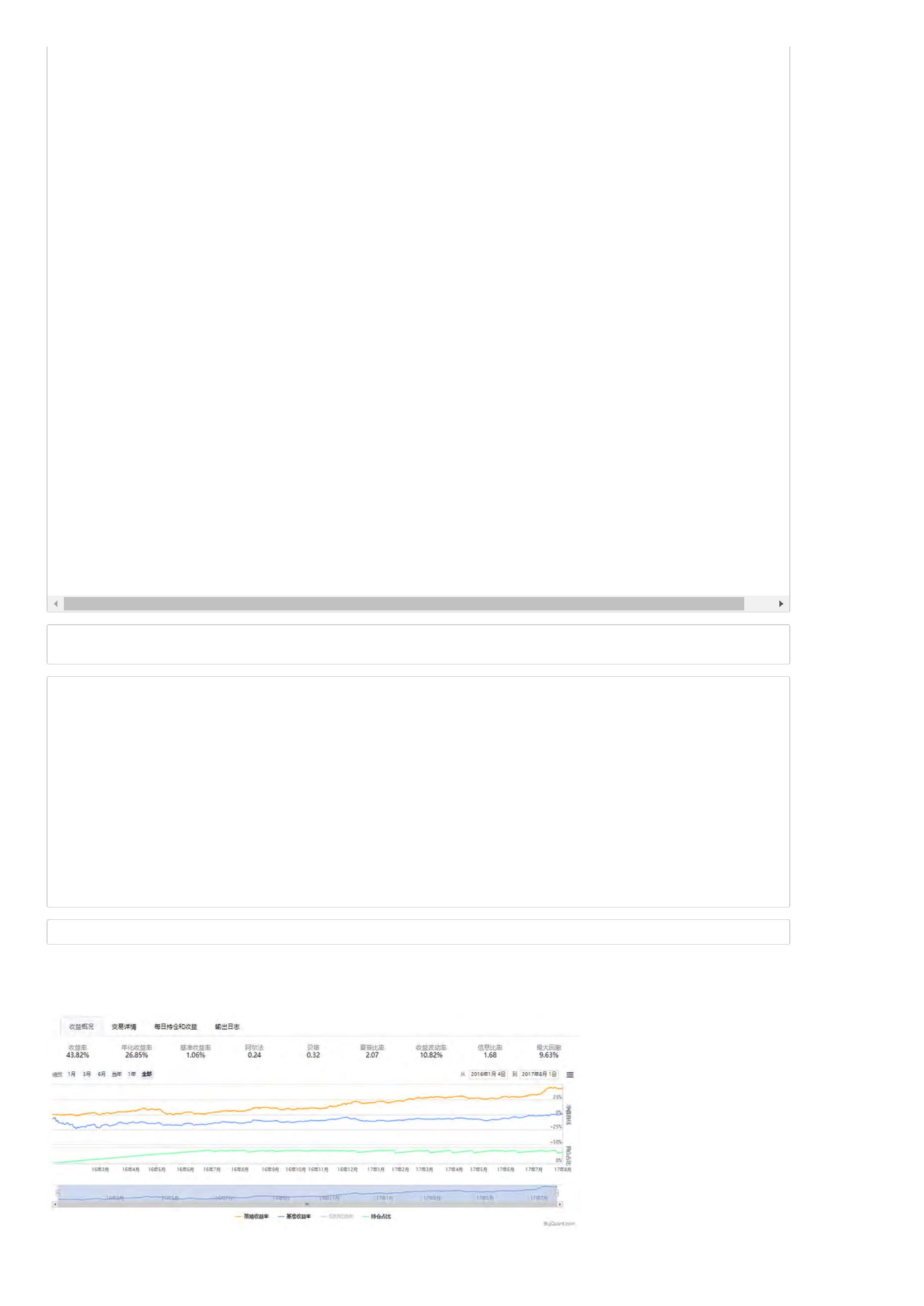

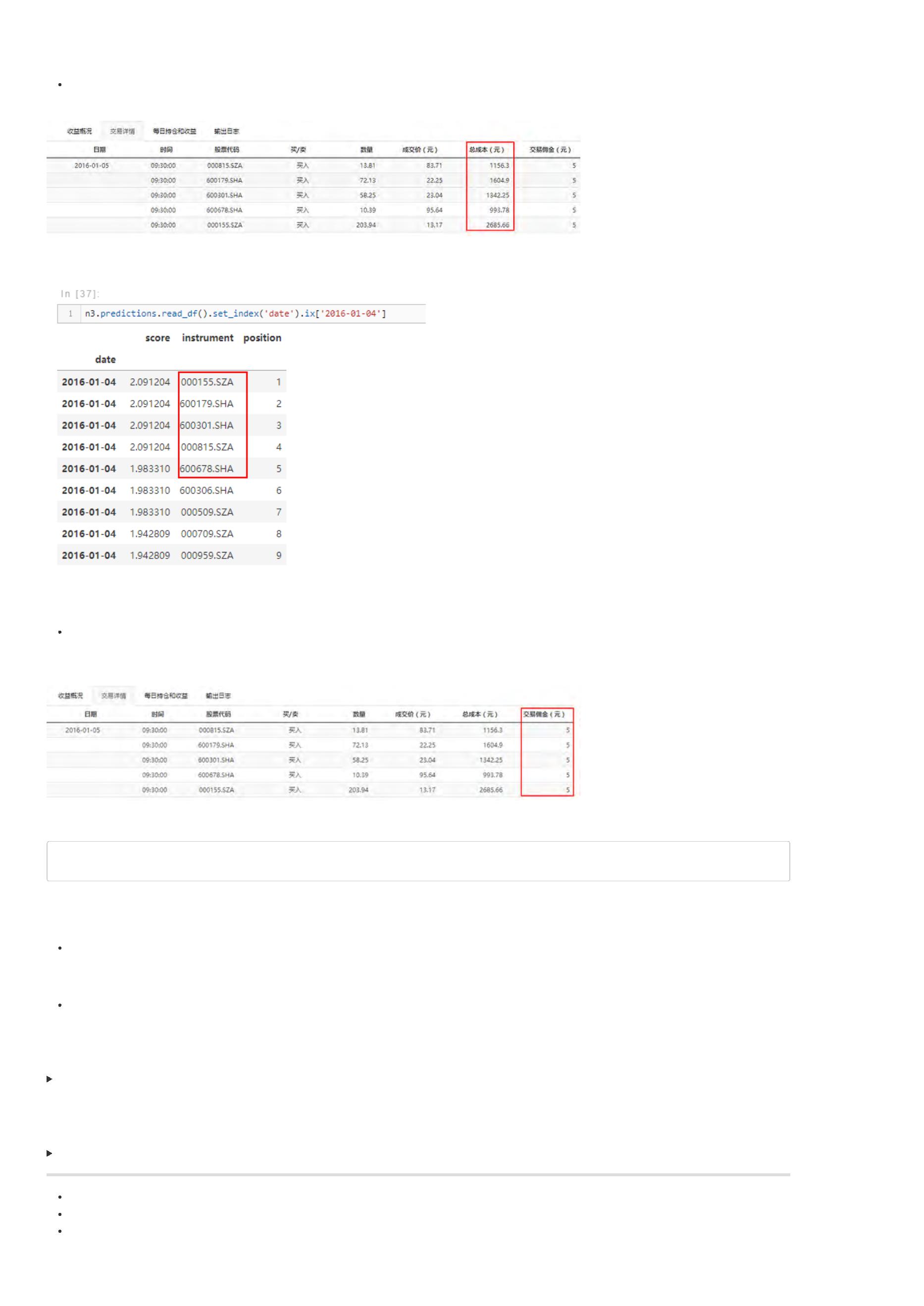

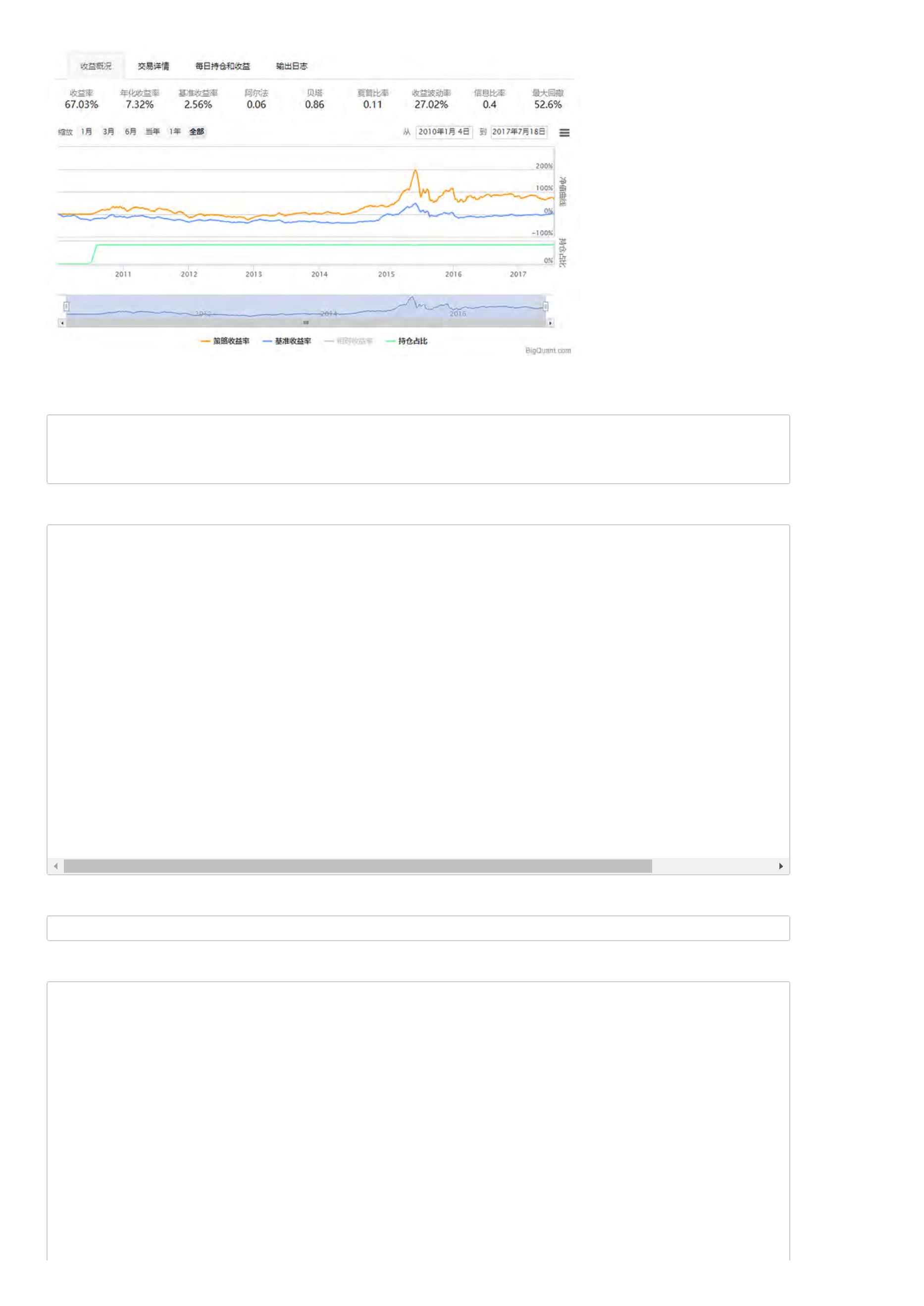

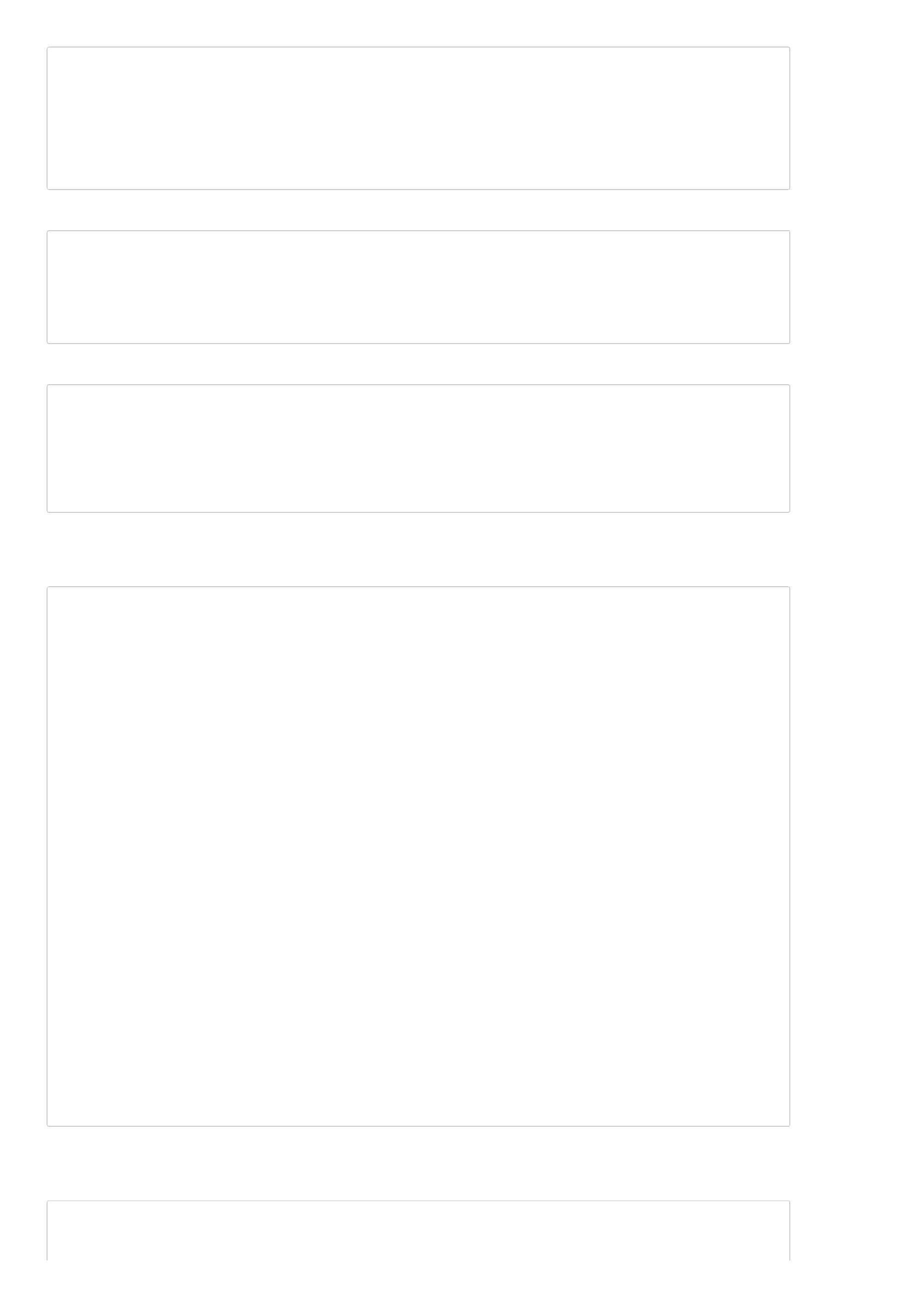

当我们完成一个策略回测时,我们会得到如下的一个图形:

上图为策略回测结果图,红色矩形标记部分包含了策略的主要信息,包括 收益概况、交易详情、每日持仓及收益、输出日志 。接下来,我们详细介绍这几个

部分。

收益概况

收益概况以折线图的方式显示了策略在时间序列上的收益率,黄色曲线为策略收益率。同时也显示了沪深300收益率曲线作为比较基准,蓝色曲线为基准收

益率。同时,最下面的绿色曲线为持仓占比,持仓占比即仓位,10%的持仓占比表示账户里股票价值只占10%。相对收益率的曲线并没有直接绘制在图上,

点击图例 相对收益率(如下图所示),就可以将其绘制出来。

不仅如此,衡量一个策略好坏的关键指标在收益概览页面也得到展示。

收益率:策略整个回测时间段上的总收益率。比如,如果收益率为30%,表明起始时间是1万的本金,结束时间本金就变成1.3万了,一共赚了3000元。

年化收益率:该策略每一年的收益率。比如,如果回测时间段为2年,总收益率为30%,那么每年的年化收益率就在15附近(不考虑复利)。

基准收益率:策略需要有一个比较基准,比较基准为沪深300。若基准收益率为15%,表明在整个回测时间段,大盘本身就上涨了15%,如果策略收益

率小于基准收益率,说明策略表现并不好,连大盘都没有跑赢。

阿尔法:衡量策略的一个重要指标,该值越大越好。

贝塔:衡量策略的一个重要指标,该值越小越好。

夏普比率:衡量策略最重要的一个指标,该指标的计算不仅考虑收益率,还考虑了风险,因此比较具有参考价值,可以理解为经过风险调整后的收益

率。

收益波动率:收益率的标准差,是风险的一个指标。

最大回撤:策略在整个时间段上亏损最严重的时候相比净值最高值下跌的百分比。如果最大回撤为20%,表明策略在某个时间点上,相比之前的净值最

高点下降了20%。最大回撤是策略评估时非常关键的一个指标,通常与风险承受能力相关。

信息比率:信息比率也是一个常用的策略评价指标。

关于策略回测结果指标的详细信息,包括指标定义及计算公式,可以参考 策略回测结果指标详解。

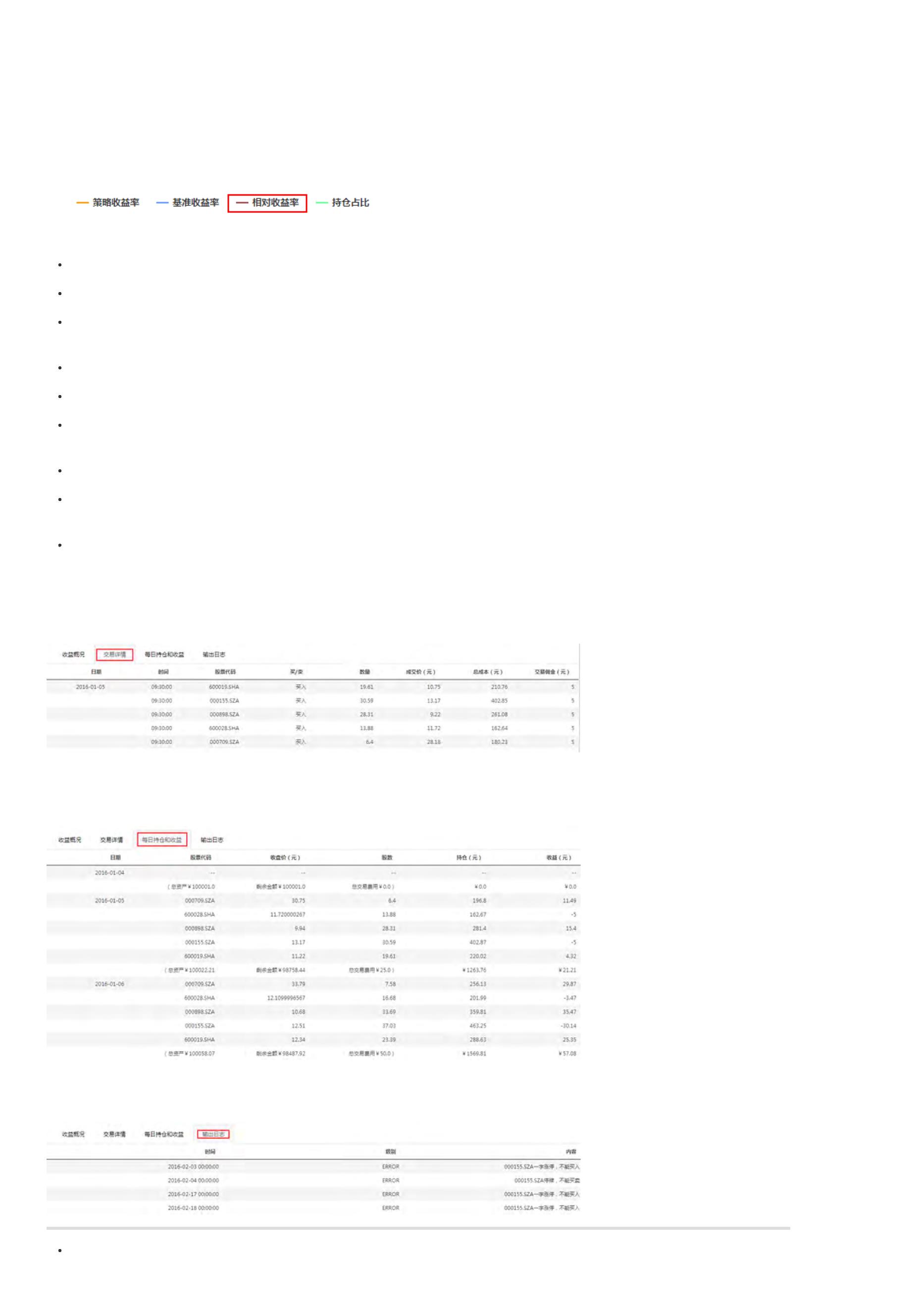

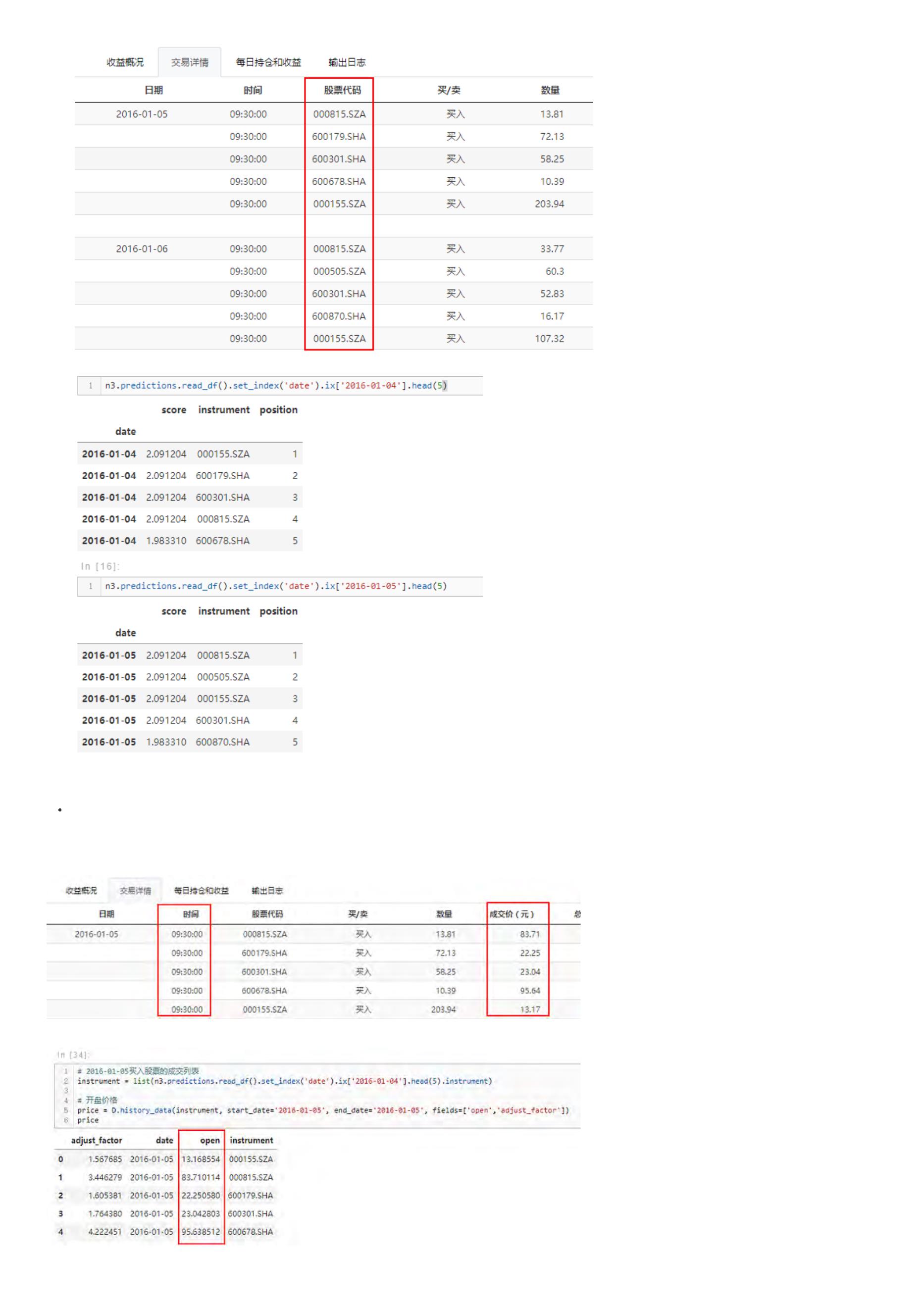

交易详情

交易详情主要显示了策略在整个回测过程中每个交易日的买卖信息。包括买卖时间、股票代码、交易方向、交易数量、成交价格、交易成本。具体见下图:

每日持仓及收益

每日持仓及收益主要呈现每日持有股票代码、当日收盘价、持仓股票数量、持仓金额、收益等指标。具体见下图:

输出日志

输出日志主要为策略运行过程中的一些日志。包括涨跌停股票不能交易、停牌估计不能交易等。该日志可以便于我们检查回测结果的正确性。

上一页:BigQuant平台高效使用指南

下一页:BigQuant回测机制

目录:BigQuant学院

[

量化学堂-新手专区]BigQuant 回测机制

导语:

刚接触BigQuant平台的小伙伴可能有点困惑,不熟悉BigQuant平台的回测机制,因此不知道怎么编写策略。当使用某一回测平台时,如果不能对其回

测处理机制了解清楚,我们很可能出现偷价漏价、未来函数等问题,这些问题对策略的影响是致命的。即使不出现这样的问题,很多时候,用户可能写

的策略并没有达到预期的目的,因此了解回测机制非常重要。

事件驱动机制

在策略回测中应用最为广泛的就是 事件驱动机制。先看定义:当某个新的事件被推送到程序中时,程序立即调用和这个事件相对应的处理函数进行相关的操

作。 举个“栗子”让大家更好理解。

比如开发一个股指策略,交易程序对股指TICK数据进行监听,当没有新的行情过来时,程序保持监听状态不进行任何操作;当收到新的数据时,数据处理函

数立即更新K线和其他技术指标,并检查是否满足策略的下单条件,如果满足条件就执行下单。

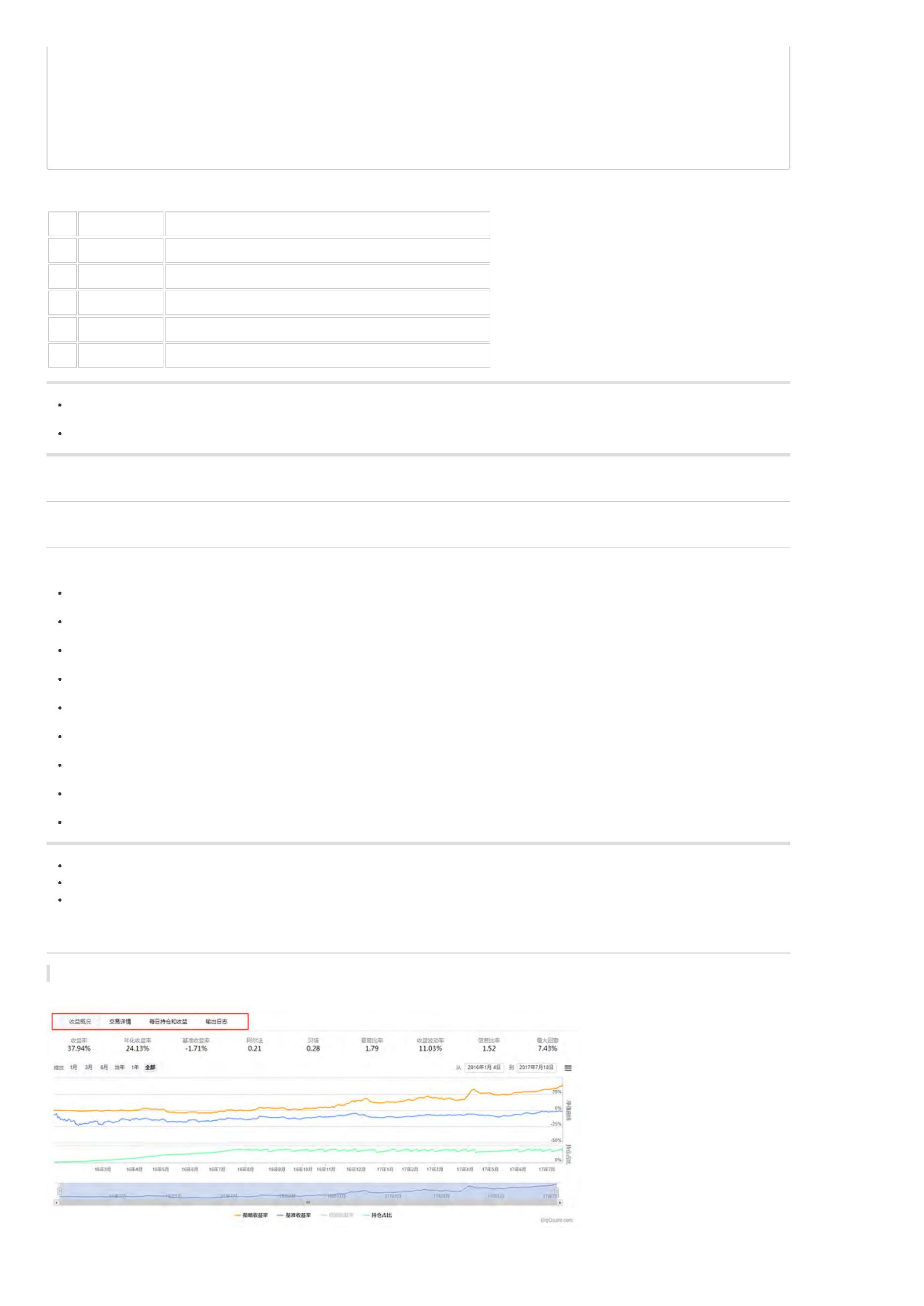

BigQuant平台的回测机制就是事件驱动机制。因为用户分析的数据是股票、期货等交易数据,这类数据的一个很大特点就是本身是标准化的时间序列数据,

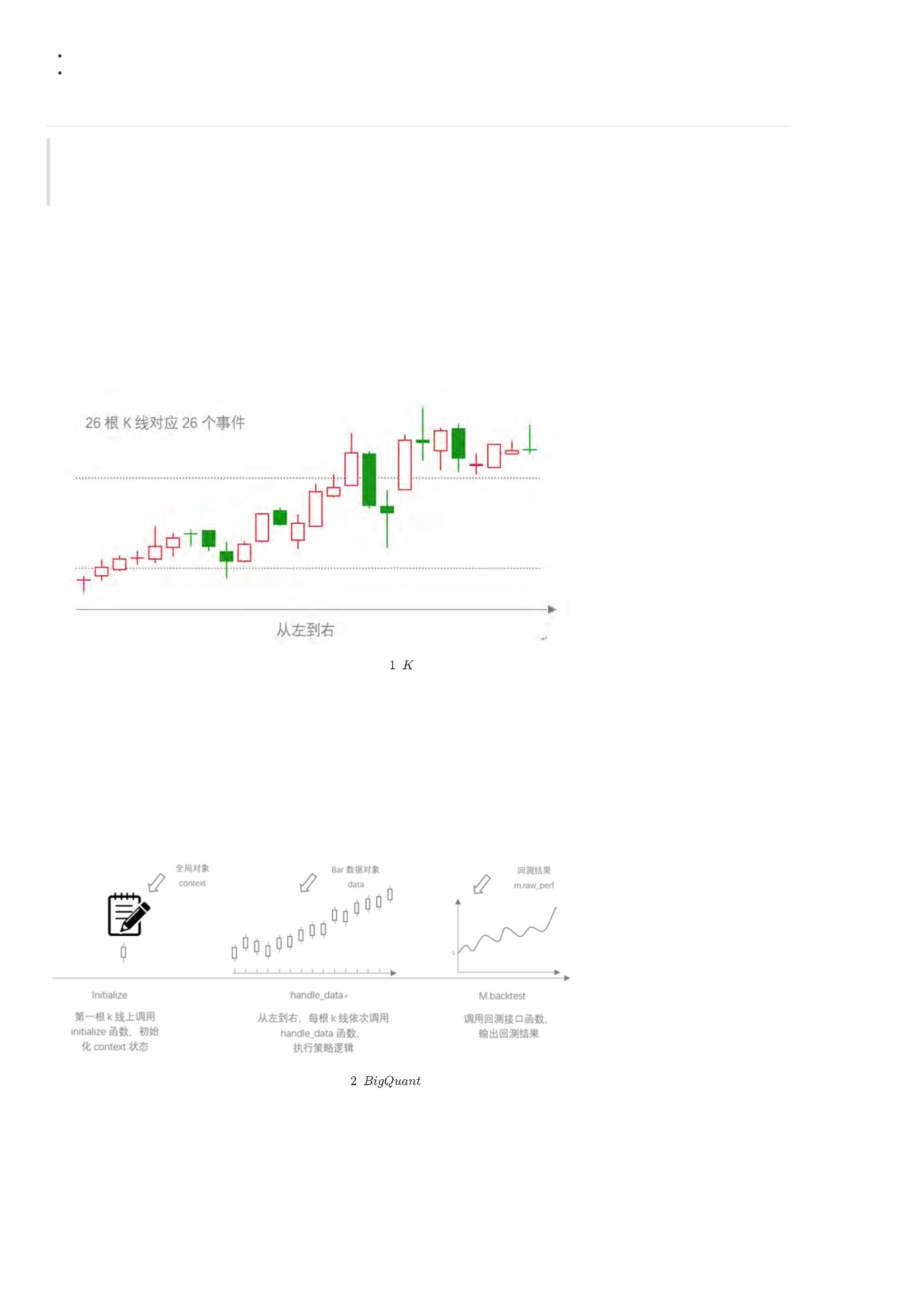

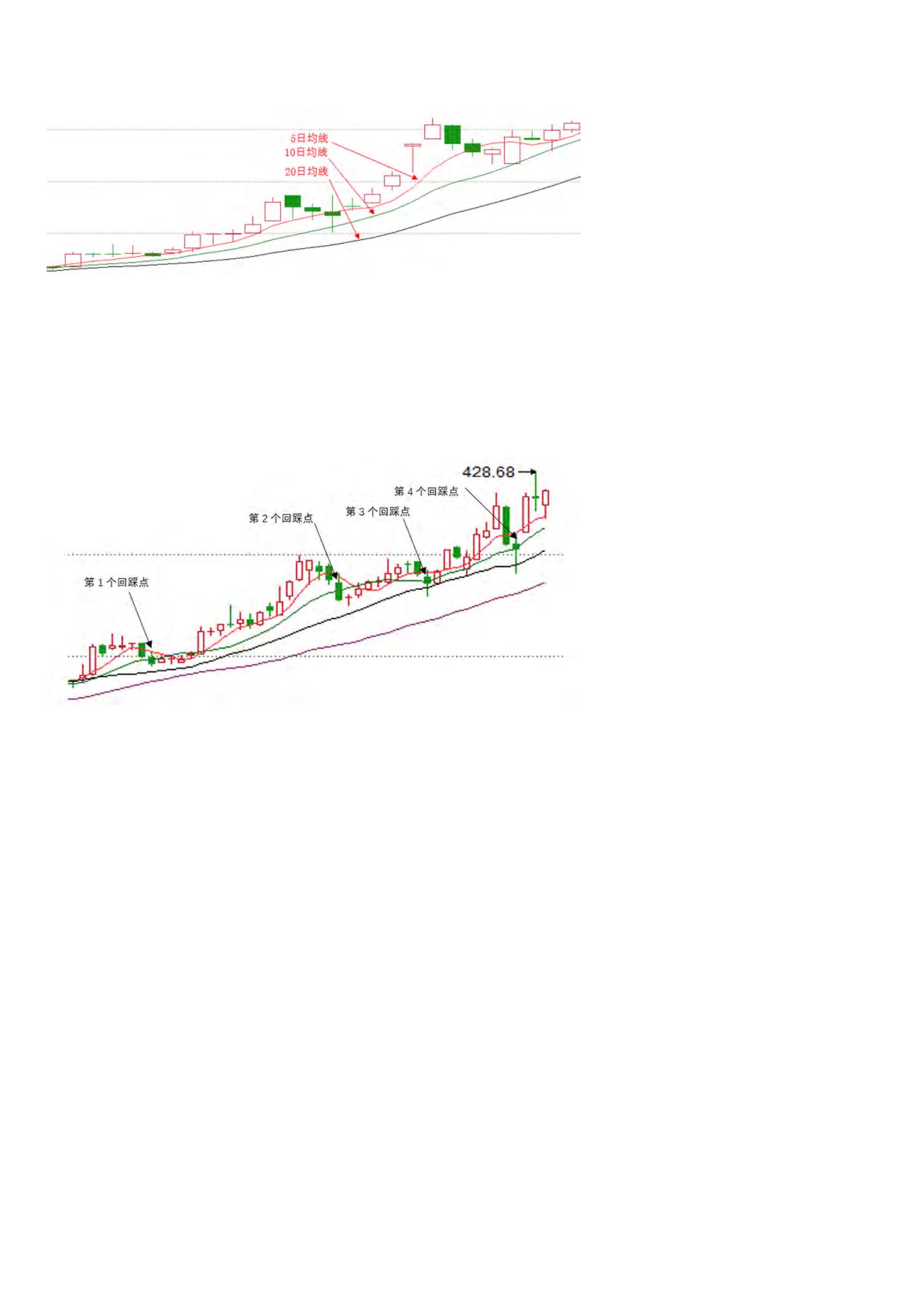

在各个交易软件上也是以K线的形式呈现,K线包含了交易的开盘价、最高价、最低价、收盘价。如图1所示:

图

线示意图

BigQuant平台回测机制是 把每一个K线当做一个事件,按照时间发生先后顺序,即从左往右依次运行。 在新的事件发生时,即出现了包含高开低收四个价格

的K线,回测程序会调用这个K线的数据,如果没有触发策略信号,就什么也不做,如果触发了交易信号,则产生订单。

为了避免未来函数,即在产生订单的时候不使用未来数据,只能使用当前能够获得的数据,BigQuant平台进行了如下处理:当产生订单时,只能在下一个K

线上完成订单成交,这样就能避免未来函数的问题,同时也能更加逼近现实真实情况,因为很多时候,当某根K线发出交易信号时,用户只能在下一个K线上

成交订单。不仅如此,为了控制订单以某个预期的价格成交,还可以设置成交价格,最为常见的就是设置订单价格是下一个K线的开盘价。

了解BigQuant 回测机制

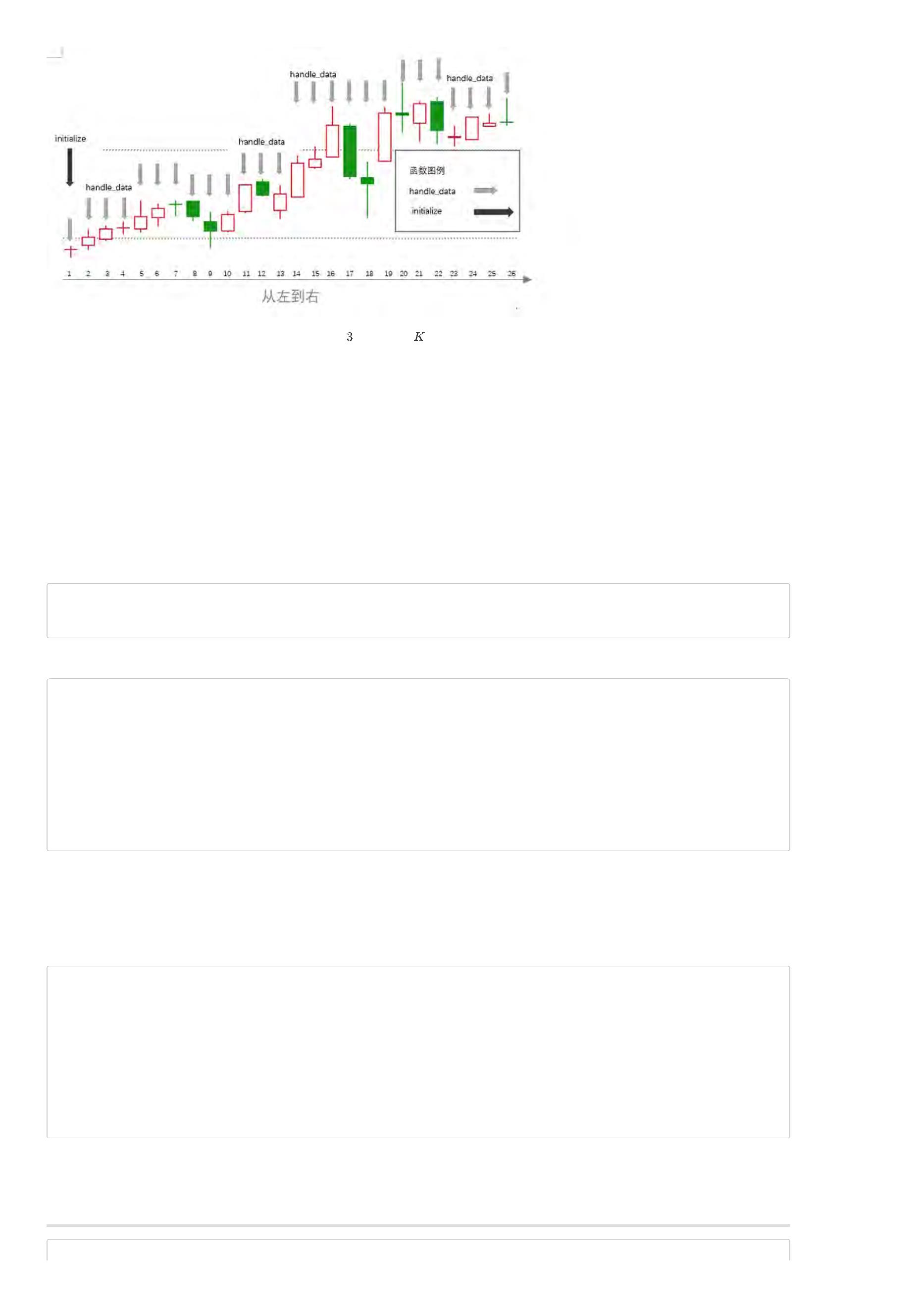

先看BigQuant回测机制的概览图(图2):

图

回测机制概览图

BigQuant平台回测主体有两个使用频率很高的函数:initialize 函数和handle_data 函数,理解了这两个函数开发策略就再也不是什么难事了,结合上面K线

图来理解这两个函数(如图3)。

图

两个函数与 线的关系示意图

从图中可以看出,其实一共有26个事件,即26根K线,第一根K线既对应黑色箭头,又对应灰色箭头,其余都只对应灰色箭头。回测主体函数的initialize函数

只在第一个事件上调用,即第一根K线,因此很多初始设置可以放在initialize函数里面。每个K线都对应灰色箭头,表示每个事件都会调用handle_data函数,

即从第一根K线到最后一根K线都会运行handle_data一次,于是很多策略逻辑部分就可以放在handle_data里。不知道这样解释大家是否能够更容易理解?

简单策略开发

由于BigQuant提供的是提供在线的Notebook云端研究平台,因此在首页点击“编写策略”按钮就进入个人账户页面,然后点击左上角的添加按钮(“+”)新建

notebook。

策略的编写主要包含三个步骤。回测文档参考:链接

1

.确定策略参数

在回测的时候,会面临选哪只股票,回测从什么日期开始,回测在哪天结束这样的问题,因此我们需要再回测前确定这几个策略参数

instrument = ['600519.SHA']

start_date = '2014-01-01'

end_date = '2017-07-18'

2

.编写策略主体函数

def initialize(context):

context.set_commission(PerDollar(0.0015))

def handle_data(context, data):

sid = context.symbol(instrument[0])

cur_position = context.portfolio.positions[sid].amount

if cur_position == 0:

order(sid, 100)

elif cur_position > 0:

order(sid, -100)

initialize函数里我们设置了手续费。handle_data函数里我们制定了策略逻辑:当没有持仓时,产生股票数量为100的买入订单;当持仓时,产生股票数量为

1

00的卖出订单。

3

.调用回测接口

两个主体函数构建完毕之后,再调用回测接口就完成策略开发了,回测接口如下:

m=M.trade.v2(

instruments=instrument,

start_date=start_date,

end_date=end_date,

initialize=initialize,

handle_data=handle_data,

order_price_field_buy='open', # 买入订单成交价格为开盘价

order_price_field_sell='open', # 卖出订单成交价格为开盘价

capital_base=200000, # 初始资金

benchmark='000300.INDX', # 基准是沪深300 指数

)

直接运行策略接口就可以让策略跑起来,回测速度非常快,直接输出回测结果,图表也是相当友好。当然了,这个简单策略没有一点实际价值,因此资金曲

线也是有的“惨”啊:joy:

不知道大家现在对BigQuant的回测机制是不是更了解一些了,快克隆下策略自己试试吧。

本文由BigQuant宽客学院推出,版权归BigQuant所有,转载请注明出处。

附件:一个简单的策略

In [39]:

instrument = ['600519.SHA']

start_date = '2016-01-01'

end_date = '2017-07-18'

def initialize(context):

context.set_commission(PerDollar(0.0015))

def handle_data(context, data):

sid = context.symbol(instrument[0])

cur_position = context.portfolio.positions[sid].amount

if cur_position == 0:

order(sid, 100)

elif cur_position > 0:

order(sid, -100)

In [40]:

m=M.trade.v2(

instruments=instrument,

start_date=start_date,

end_date=end_date,

initialize=initialize,

handle_data=handle_data,

order_price_field_buy='open', # 买入订单成交价格为开盘价

order_price_field_sell='open', # 卖出订单成交价格为开盘价

capital_base=200000, # 初始资金

benchmark='000300.INDX', # 基准是沪深300 指数

)

[

[

2017-07-19 18:40:48.077333] INFO: bigquant: backtest.v7 start ..

2017-07-19 18:40:48.079204] INFO: bigquant: hit cache

[

2017-07-19 18:40:48.766480] INFO: bigquant: backtest.v7 end [0.689119s].

上一页:策略回测结果解读

下一页:StockRanker结果解读

目录:BigQuant学院

【

宽客学院】StockRanker 结果解读

本文对StockRanker的结果做详细介绍,希望大家对StockRanker的了解更加深入。

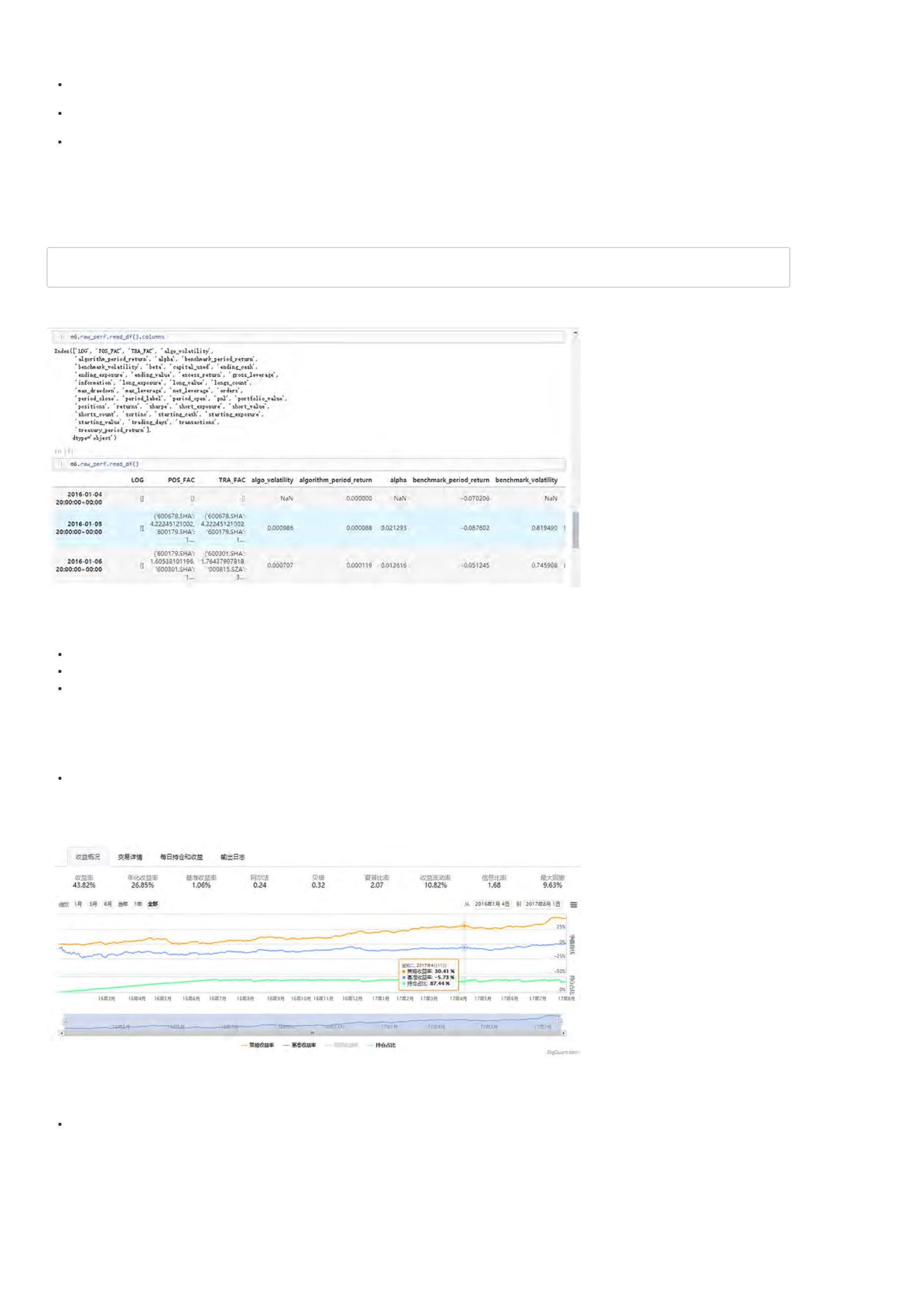

通过BigQuant AI策略详解,我们已经对StockRanker有了一个基本介绍。接下来我们在 模型训练和 模型预测 这两步详细介绍StockRanker模型的返回结

果,以便于能够更好地开发AI策略。

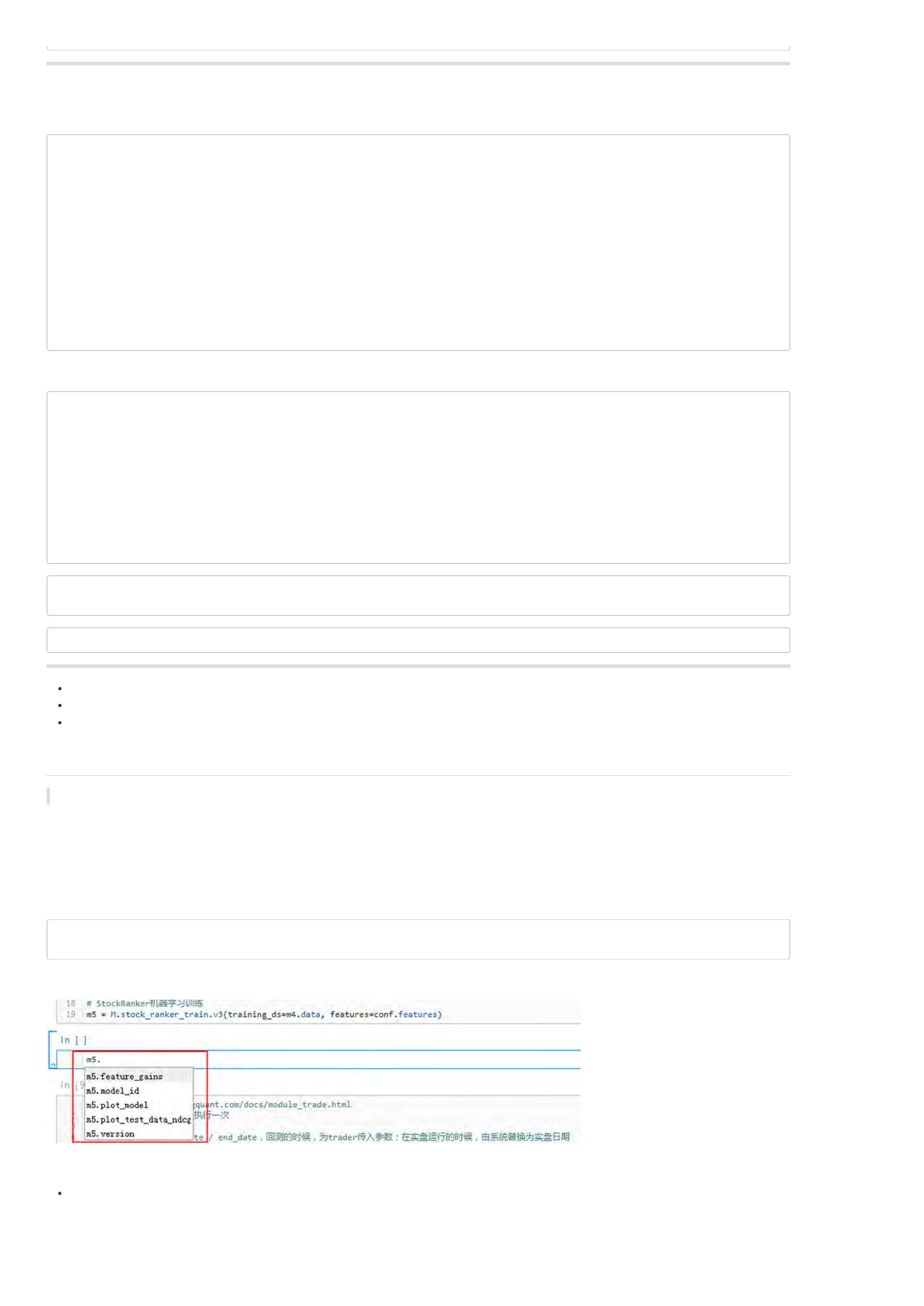

模型训练

代码部分:

#

StockRanker机器学习训练

m5=M.stock_ranker_train.v3(training_ds=m4.data, features=conf.features)

结果查看:

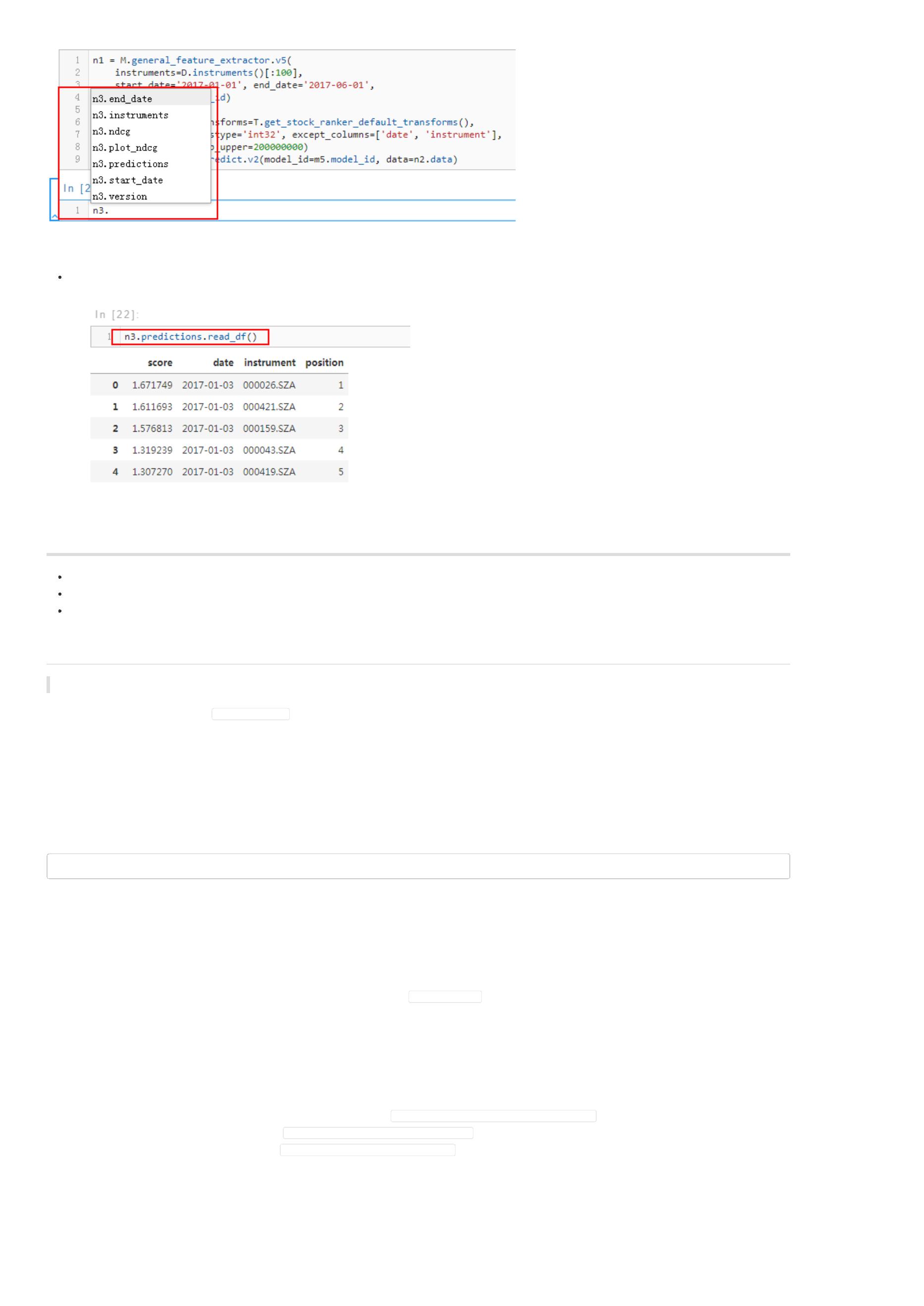

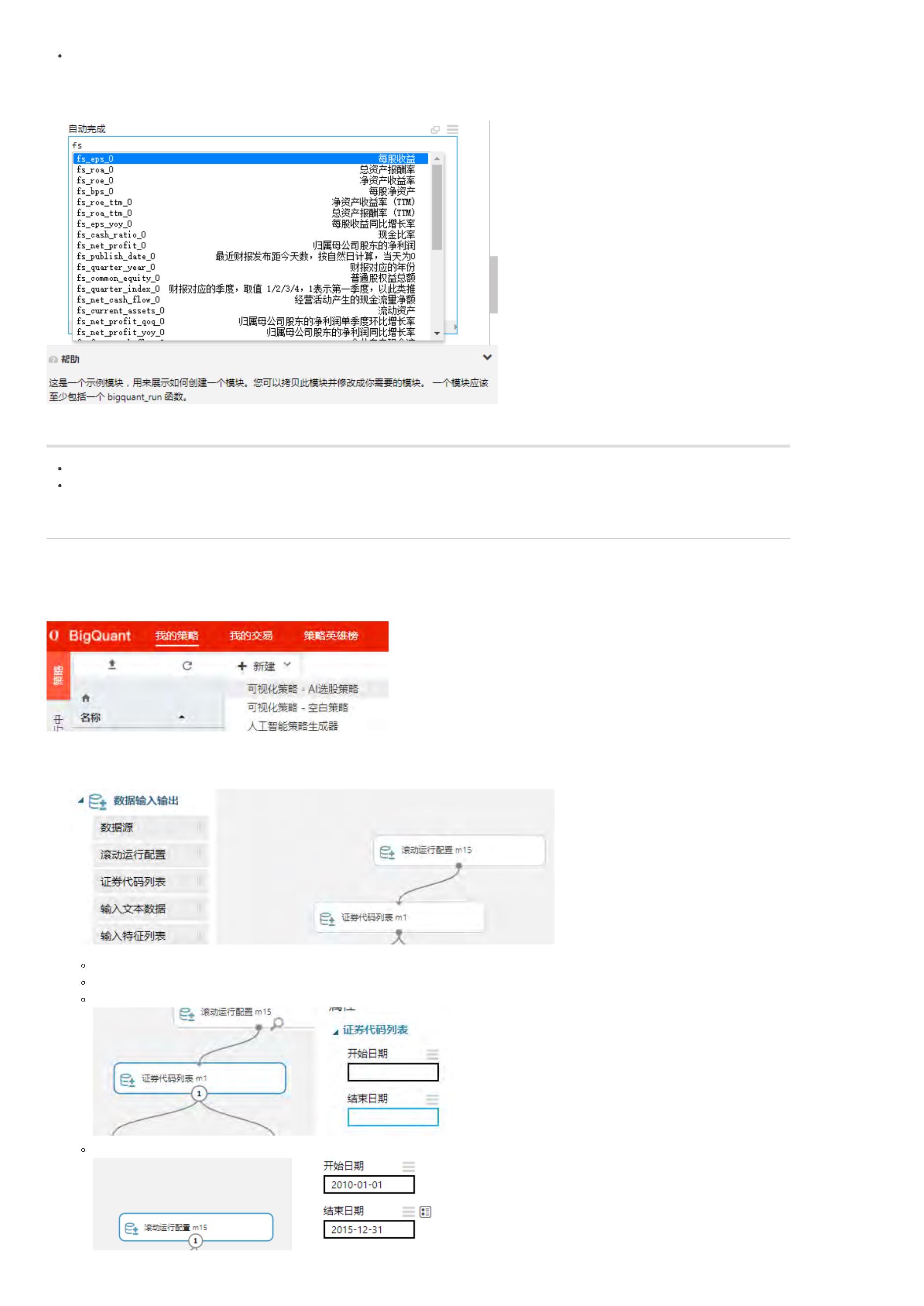

当我们完成模型训练以后,根据策略研究平台的自动补全功能,就可以查看模型的一些结果(属性和方法)。

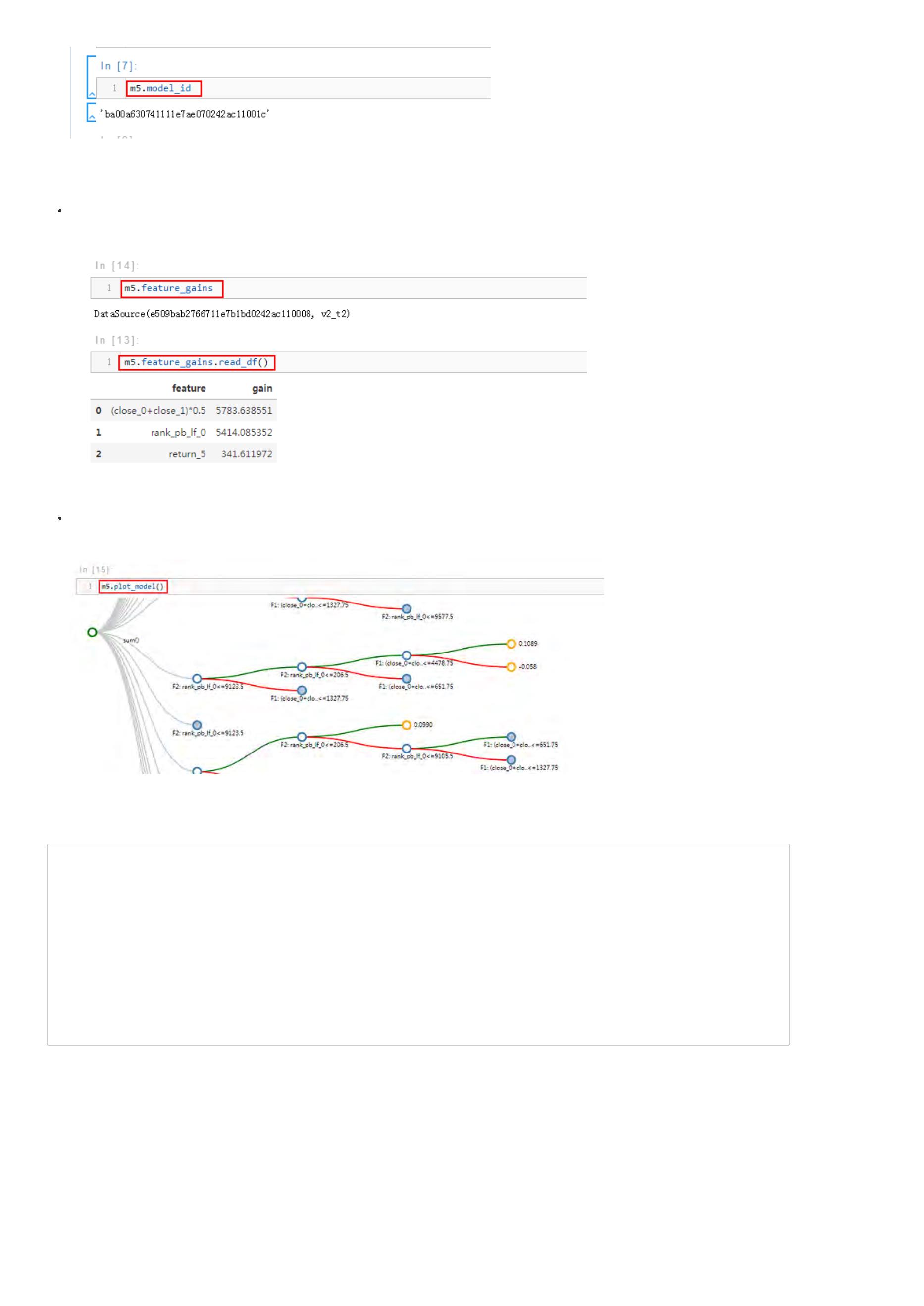

模型ID

直接输入 m5.model_id接可以输出模型的ID。这个ID在平台上具有唯一性和全局性,只要记住该ID就可以在其他策略里面正常使用,策略开发就非常灵

活。

特征得分

特征得分是StockRanker模型基于各个特征对模型贡献度的一个数量型评估指标,因此我们可以通过特征得分来进行特征的选择、组合、删除等工作。

如图所示,直接输入m5.features_gains可以得到特征得分结果,不过类型为内置的DataSource,因此需要通过read_df读出来,读出来的结果为

DataFrame格式。

可视化模型

这一步,我们可以将模型的各个细节绘制出来,便于查看。详情可以参考:StockRanker模型可视化

模型预测

代码部分:

#

#

测试集为17年1月到七月的100只股票数据

特征抽取

n1 = M.general_feature_extractor.v5(

instruments=D.instruments[:100],

start_date='2017-01-01', end_date='2017-07-31',

model_id=m5.model_id)

#

特征转换

n2 = M.transform.v2(

data=n1.data, transforms=T.get_stock_ranker_default_transforms(),

drop_null=True, astype='int32', except_columns=['date', 'instrument'],

clip_lower=0, clip_upper=200000000)

#

模型在测试集上进行预测

n3 = M.stock_ranker_predict.v2(model_id=m5.model_id, data=n2.data)

结果查看:

同模型训练一样,一旦我们完成模型预测以后,根据平台的代码自动补全功能,我们就可以查看模型预测结果。

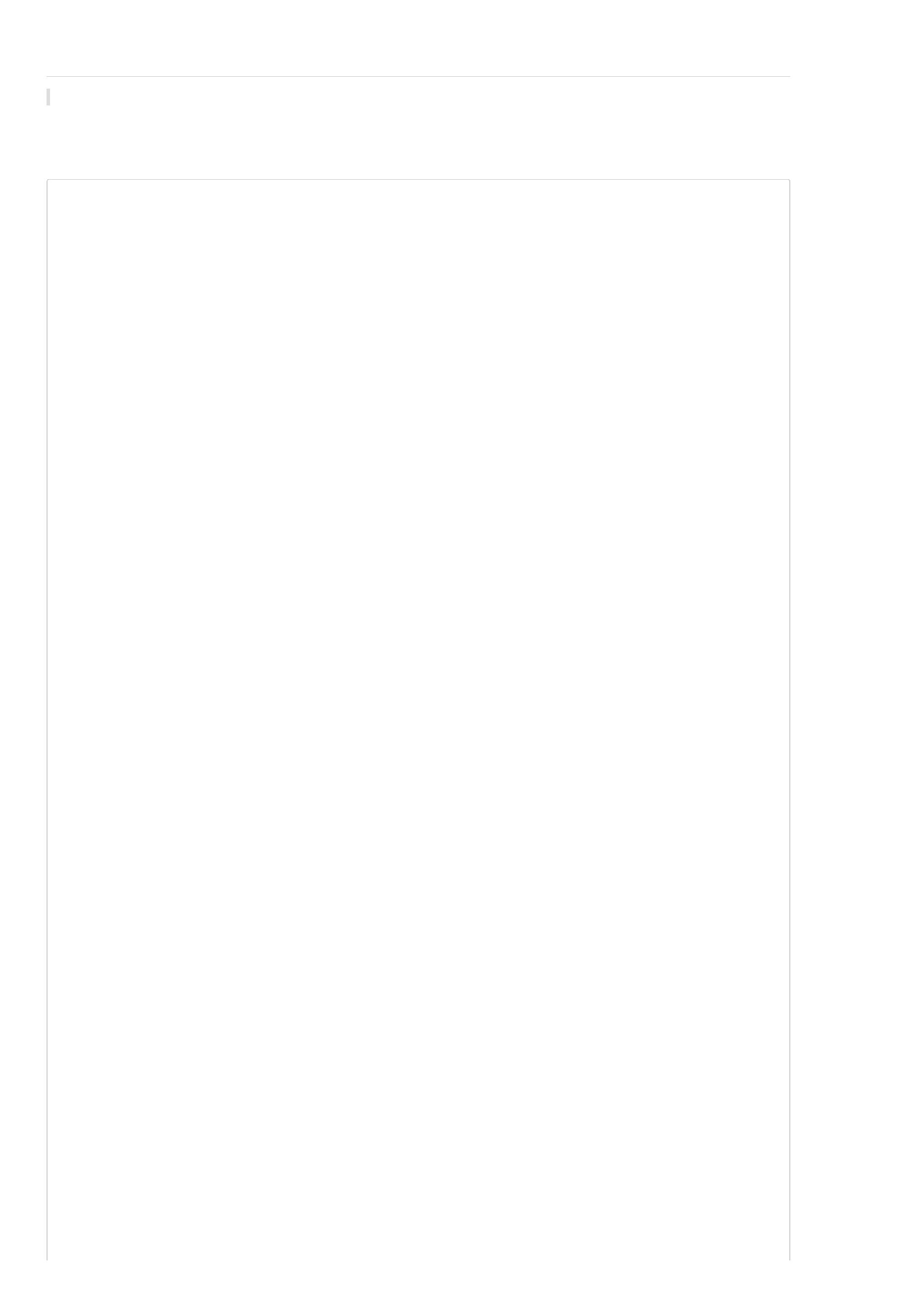

股票排序结果

股票排序结果直接用来开发交易策略,输出每个交易日股票的得分情况,股票得分越高,表明该股票越值得买入。从图中可以看出,2017年1月3日,最

值得买入的股票为‘000026.SZA’。

上一页:BigQuant回测机制

下一页:无需代码构造您自己的衍生因子

目录:BigQuant学院

无需代码构造您自己的衍生因子

因子是影响机器学习效果最重要的因素之一。特别是在股票等市场,高质量的因子直接影响策略收益。

在前面的例子中,你可以能看到像 close_1/close_0 这样的因子,这是通过运算符连接,重新定义的新的衍生因子。本文主要介绍如何通过运算符构建衍生

因子。

在 BigQuant 平台上,我们提供的因子库,包括2000+基础因子;同时,我们提供的因子计算引擎,让用户无需编程,通过表达式就可以用基础因子生成新的

衍生因子。

表达式

表达式使用的语法和我们常用的数据表达式一致。求三日平均收盘价,可以按如下写:

(close_1 + close_2 + close_3) / 3

支持的运算符:

1

2

3

4

5

6

7

8

9

1

.+:加

.-:减

.*:乘

./ :除

.==:等于。逻辑运算支持,如果为True,则为1,否则为0。例如,表达式 (10 == 10) + 1,这个值是 2

.>:大于

.>=:大于等于

.>:小于

.>=:小于等于

0.and:逻辑与

1

1.or:逻辑或

1

1

1

1

1

2.iif:使用 iff(判断条件,条件为True的值,条件为False的值),例如, iif(close_1 > close_0, close_1, close_0)

3.max:最大值,支持2个或者更多参数,例如,max(high_0, high_1, high_2) / close_0

4.min:最小值,支持2个或者更多参数,例如,min(low_0, low_1, low_2) / close_0

5.ln:取自然对数

6.log:取10为底的对数

示例

1

. 过去五日均价除以今日收盘价:

(close_0 + close_1 + close_2 + close_3 + close_4) / 5 / close_0

2

. 过去三日振幅:

max(high_0, high_1, high_2) / min(low_0, low_1, low_2)

上一页:StockRanker结果解读

目录:BigQuant学院

如何按自己需求实现自定义因子计算?

在平台的因子库上看到有许多因子,但是我想计算一些自定义的因子,比如,相对大盘的收益率,这个因子怎么构造呢?谢谢!

WorldQuant 101alpha 因子构建及因子测试

本文目的是介绍如何使用bigexpr表达式对WorldQuant公开的101个alpha进行因子构建,并进行因子测试。

背景介绍

根据WorldQuant发表的论文《101 Formulaic Alphas 》 ,其中公式化地给出了101个alpha因子。与传统方法不一样的是,他们根据数据挖掘的方法构建了

1

01个alpha,据说里面80%的因子仍然还行之有效并被运用在实盘项目中。

在BigQuant策略研究平台上,可通过表达式快速进行因子构建和数据标注,再也不需要自己手动编写冗长代码。

表达式简介

因为在机器学习和深度学习中,因子是一个很重要的概念,也被称为特征,开发AI算法的关键在于特征选择。如果是简单的基础因子,比如近5日收益率:

$

close\_5/close\_0-1$,因子构建比较简单,但是如果想构建近5日每日收益率和成交量的相关性这个因子就比较棘手,需要编写大量的代码来计算该因子。

因此,我们设计了bigexpr表达式引擎。

bigexpr是BigQuant开发的表达式计算引擎,通过编写简单的表达式,就可以对数据做任何运算,而无需编写代码。

bigexpr在平台上被广泛使用,M.advanced_auto_labeler 和 M.derived_feature_extractor 都已经由bigexpr驱动,您可以用表达式就可以定义标注目标和完成

后特征抽取。

正如刚刚提到的近5日每日收益率和成交量的相关性因子可以这样定义:

其中,$correlation$表示求相关系数,$close\_0$表示当天收盘价,$shift(close\_0,1)$表示前一日收盘价,$volume\_0$表示当天成交量。因此,可以看出,

并不需要编写大量代码计算该因子,通过表达式即可快速构建。

函数说明

表达式引擎中有不少简单函数,对其中的部分函数进行解释:

可分为横截面函数和时间序列函数两大类,其中时间序列函数名多为以$ts\_$开头

大部分函数命名方式较为直观

$

$

$

$

$

$

abs(x)$ 、$log(x)$分别表示$x$的绝对值和$x$的自然对数

rank(x)$表示某股票$x$值在横截面上的升序排名序号,并将排名归一到[0,1]的闭区间

delay(x,d)$表示$x$值在$d$天前的值

delta(x,d)$表示$x$值的最新值减去$x$值在$d$天前的值

correlation(x,y,d)$、$covariance(x,y,d)$分别表示$x$和$y$在长度为$d$的时间窗口上的皮尔逊相关系数和协方差

ts\_min(x,d)$、$ts\_max(x,d)$、$ts\_argmax(x,d)$、$ts\_argmin(x,d)$、$ts\_rank(x)$、$sum(x,d)$、$stddev(x,d)$等均可以通过函数名称了解其作

用

因子说明

BigQuant平台上系统因子超过2000个,包括了基本信息因子、量价因子、估值因子、财报因子、技术指标因子等。本文简单举若干因子进行介绍。

基本信息因子

点击查看部分因子

量价因子

点击查看部分因子

估值因子

点击查看部分因子

财报因子

点击查看部分因子

数据标注

和因子构建一样,数据标注也是机器学习算法中非常重要的一部分,更详细的文档为:自定义因子。

之前没有表达式的时候,数据标注主要通过fast_auto_label实现,自从有了表达式以后,数据标注主要是通过advanced_auto_label实现。数据标注的整体思

想和内容主要体现在label_expr上,label_expr是一个列表(list)。

具体实例代码,请点击下方 点击查看代码。

点击查看代码

接下来,我们对示例代码做解释:

label_expr为一个list,列表里四个元素决定了标注的具体操作,详细文档见:表达式引擎

计算未来一段时间的相对收益作为标注的原始依据,这里可以使用bigexpr表达式,快速完成数据标注

使用clip和all_quantile函数做极值处理

将原始数据离散化,这里可以采取等宽离散化或者等频离散化,两者各有优劣

通过where函数过滤掉一字涨停的样本数据

单因子测试

这里我们以’shift(close_0,15) / close_0’因子为例,介绍如何进行单因子测试,开发基于单因子的AI策略。

(补充:由于平台升级太快,下面的单因子测试代码可能会报错,建议参考三楼 Yoga 会飞的鱼的回答)

点击查看代码

1

01 Alphas 列表

点击查看完整列表

这里展示了WorldQuant公开的101个alpha及其表达式,感兴趣的朋友可以参考 单因子测试 的代码做实验,唯一需要修改的是将具体的因子变动下,希望大

家能开发出可以稳定盈利的策略,发掘出新的alpha。

注:部分因子可能是布尔型因子,因子值要么是1,要么是-1,这样的单因子在传入StockRanker的时候可能会出错,导致模型训练失败。

相关阅读

【

宽客学院】Pandas 快速入门

本课程帮助大家Pandas快速入门

下一页:因子预处理

目录:BigQuant学院

【

宽客学院】因子预处理

在机器学习中,很多因子数据必须经过预处理才能参与模型训练。本文简单介绍使用sklearn进行因子预处理。

参考文档:使用sklearn进行数据预处理

参考文档:标准化、规范化、二值化等多种机器学习数据预处理方法

In [39]:

#

导入包

from sklearn import preprocessing

In [40]:

#

基础设置

class conf:

start_date = '2015-01-01'

end_date='2017-08-10'

split_date = '2016-01-01'

instruments = D.instruments(start_date, split_date)

features = ['fs_current_assets_0','market_cap_0','close_0']

In [41]:

#

计算特征数据

m2 = M.general_feature_extractor.v5(

instruments=conf.instruments, start_date=conf.start_date, end_date=conf.split_date,

features=conf.features)

#

数据预处理:缺失数据处理,数据规范化,T.get_stock_ranker_default_transforms为StockRanker模型做数据预处理

m3 = M.transform.v2(

data=m2.data, transforms=T.get_stock_ranker_default_transforms(),

drop_null=True, astype='int32', except_columns=['date', 'instrument'],)

[

[

[

[

[

[

2017-10-16 16:05:47.926344] INFO: bigquant: general_feature_extractor.v5 开始运行..

2017-10-16 16:05:47.936684] INFO: bigquant: 命中缓存

2017-10-16 16:05:47.938360] INFO: bigquant: general_feature_extractor.v5 运行完成[0.012008s].

2017-10-16 16:05:47.972345] INFO: bigquant: transform.v2 开始运行..

2017-10-16 16:05:47.975012] INFO: bigquant: 命中缓存

2017-10-16 16:05:47.976093] INFO: bigquant: transform.v2 运行完成[0.003792s].

In [42]:

#

# 全部数据

all_data = m2.data.read_df()

# 某一天数据

df = all_data[all_data['date']=='2015-01-05']

#

#

# 某一天数据的直方图分析,可以发现数据很粗糙,极值存在,需要做一些处理和转化

df[df.dtypes[df.dtypes == 'float32'].index.values].hist(bins=50, figsize=[15,12])

In [43]:

#

# 1. 缺失值处理

for factor in ['close_0', 'market_cap_0', 'fs_current_assets_0']:

df[factor].fillna(np.nanmean(df[factor]), inplace=True)

In [44]:

#

# 2. 极值处理

for factor in ['close_0', 'market_cap_0', 'fs_current_assets_0']:

p_95 = np.percentile(df[factor], 95)

p_5 = np.percentile(df[factor], 5)

df[factor][df[factor] > p_95] = p_95

df[factor][df[factor] < p_5] = p_5

In [45]:

#

# 3. 标准化

df = all_data[all_data['date']=='2015-01-05'].dropna()

for factor in ['close_0', 'market_cap_0', 'fs_current_assets_0']:

df[factor] = (df[factor] - df[factor].mean()) / df[factor].std()

df[['close_0', 'market_cap_0', 'fs_current_assets_0']].values

Out[45]:

array([[ 1.01638317,

2.82943988, 14.47532082],

-0.05427583, -0.21515357, -0.21295929],

0.04300562, -0.06115698, 0.07691551],

..,

-0.08408548, -0.03219347, -0.11243575],

[

[

.

[

[

[

-0.06934822,

-0.08663286,

0.05156187, -0.11314245],

0.67376161, 0.04899734]], dtype=float32)

In [46]:

#

上述标准化结果与sklearn的scale处理结果是大致一样的(因为scale函数内部实现细节有点差异)

preprocessing.scale(df[['close_0', 'market_cap_0', 'fs_current_assets_0']])

Out[46]:

array([[ 1.01660847,

2.83006714, 14.47853436],

-0.05428803, -0.21520142, -0.2130065 ],

0.04301501, -0.06117069, 0.07693265],

..,

-0.08410428, -0.03220075, -0.11246065],

[

[

.

[

[

[

-0.06936376,

-0.08665223,

0.05157316, -0.11316751],

0.67391087, 0.04900828]])

In [47]:

#

# 4. 规范化

preprocessing.normalize(df[['close_0', 'market_cap_0', 'fs_current_assets_0']])

Out[47]:

array([[ 0.06874776, 0.1913822 , 0.979105 ],

[

[

.

[

[

[

-0.1764766 , -0.69956682, -0.69243215],

0.40093092, -0.57015163, 0.71706451],

..,

-0.58374982, -0.22349793, -0.78056699],

-0.48710097, 0.36216984, -0.79471105],

-0.12720051, 0.98926461, 0.07194138]])

In [48]:

#

因子预处理函数

def preprocess(df):

# 1. 缺失值处理

for factor in ['close_0', 'market_cap_0', 'fs_current_assets_0']:

缺失值处理

df[factor].fillna(np.nanmean(df[factor]), inplace=True)

极值处理

#

#

#

p_95 = np.percentile(df[factor], 95)

p_5 = np.percentile(df[factor], 5)

df[factor][df[factor] > p_95] = p_95

df[factor][df[factor] < p_5] = p_5

#

标准化处理

df[factor] = (df[factor] - df[factor].mean()) / df[factor].std()

return df

#

按每个交易日进行因子预处理,此时因子预处理完成,我们可以用预处理后的结果加入更多的机器学习算法中

all_data.groupby('date').apply(preprocess)

Out[48]:

close_0

3.052037

3.048802

3.049037

3.031636

3.007655

2.998902

3.000345

3.004525

3.012266

3.033375

2.985070

2.996415

2.993371

3.017199

3.004288

3.022293

3.000776

3.015631

3.001202

2.976087

2.972936

2.978402

2.966676

date

fs_current_assets_0

0.556457

0.556164

0.557937

0.557385

0.560743

0.570150

0.566009

0.565694

0.562824

0.566757

0.571762

0.571735

0.571391

0.571763

0.571596

0.571354

0.570767

0.570511

0.569341

0.569285

0.533049

0.528683

0.529062

instrument

market_cap_0

3.297253

3.257948

3.270279

3.231909

3.260432

3.236919

3.222543

3.216527

3.243954

3.231477

3.156042

3.171534

3.191233

3.176629

3.205649

3.194622

3.177091

3.173037

3.138286

3.153763

3.147219

3.137114

3.147889

0

1

2

3

4

5

6

7

8

9

2015-01-05

2015-01-06

2015-01-07

2015-01-08

2015-01-09

2015-01-12

2015-01-13

2015-01-14

2015-01-15

2015-01-16

2015-01-19

2015-01-20

2015-01-21

2015-01-22

2015-01-23

2015-01-26

2015-01-27

2015-01-28

2015-01-29

2015-01-30

2015-02-02

2015-02-03

2015-02-04

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

10

11

12

13

14

15

16

17

18

19

20

21

22

close_0

date

fs_current_assets_0

0.529196

0.529368

0.528575

0.528297

0.565610

0.565225

0.560827

...

instrument

market_cap_0

3.174509

3.144080

3.154410

3.160760

3.148416

3.159806

3.134854

...

23

24

25

26

27

28

29

2.957267

2.993339

2.971802

2.980456

2.991138

2.985317

2.968544

...

2015-02-05

2015-02-06

2015-02-09

2015-02-10

2015-02-11

2015-02-12

2015-02-13

...

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

000001.SZA

...

.

..

569668

569669

569670

569671

569672

569673

569674

569675

569676

569677

569678

569679

569680

569681

569682

569683

569684

569685

569686

569687

569688

569689

569690

569691

569692

569693

569694

569695

569696

569697

-0.364151

-0.393706

-0.378904

-0.388544

-0.402664

-0.383377

-0.388683

-0.381756

-0.378545

-0.358746

-0.358682

-0.332569

-0.332485

-0.343865

-0.982238

-0.978856

-0.965441

-0.945971

-0.926357

-0.914591

-0.885378

-0.858536

-0.827869

-0.784113

-0.742582

-0.698834

-0.632080

-0.583340

-0.530886

-0.444703

2015-12-14

2015-12-15

2015-12-16

2015-12-17

2015-12-18

2015-12-21

2015-12-22

2015-12-23

2015-12-24

2015-12-25

2015-12-28

2015-12-29

2015-12-30

2015-12-31

2015-12-10

2015-12-11

2015-12-14

2015-12-15

2015-12-16

2015-12-17

2015-12-18

2015-12-21

2015-12-22

2015-12-23

2015-12-24

2015-12-25

2015-12-28

2015-12-29

2015-12-30

2015-12-31

-0.612207

-0.613224

-0.613241

-0.613026

-0.610031

-0.610888

-0.612257

-0.611544

-0.612179

-0.612344

-0.612574

-0.611711

-0.613864

-0.616675

0.590867

0.586158

0.585241

0.585689

0.585801

0.585244

0.581989

0.552980

0.553608

0.549469

0.549022

0.547223

0.547461

0.547183

0.556995

0.557870

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603998.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

603999.SHA

-0.582843

-0.602110

-0.593836

-0.600101

-0.612462

-0.596951

-0.601776

-0.595081

-0.599207

-0.582991

-0.584567

-0.566934

-0.570732

-0.575315

-0.826569

-0.821680

-0.796086

-0.769995

-0.742622

-0.717395

-0.678198

-0.634116

-0.590174

-0.524914

-0.467260

-0.405524

-0.314254

-0.244122

-0.166064

-0.053904

569698 rows × 5 columns

【

宽客学院】机器学习模型(持续更新中)

BigQuant平台会不断封装机器学习算法策略,方便用户直接使用策略生成器开发策略,降低策略开发难度。本文对BigQuant平台上策略生成器已经支

持的机器学习模型进行简单介绍。

目前,在BigQuant策略研究平台,支持的机器学习模型有:

我们依次进行介绍:

StockRanker 模型

StockRanker 是 BigQuant为量化选股而设计,核心算法主要是排序学习和梯度提升树。

StockRanker = 选股 + 排序学习 + 梯度提升树

StockRanker有如下特点:

选股:股票市场和图像识别、机器翻译等机器学习场景有很大不同。StockRanker充分考虑股票市场的特殊性,可以同时对~3000只股票的数据进行学

习,并预测出股票排序

排序学习 (Learning to Rank):排序学习是一种广泛使用的监督学习方法 (Supervised Learning),比如推荐系统的候选产品、用户排序,搜索引擎的文

档排序,机器翻译中的候选结果排序等等。StockRanker 开创性的将排序学习和选股结合,并取得显著的效果。

梯度提升树 (GBDT):有多种算法可以用来完成排序学习任务,比如VSM、逻辑回归、概率模型等等。StockRanker使用了GBDT,GBDT是一种集成学

习算法,在行业里使用广泛。

StockRanker的领先效果还得益于优秀的工程实现,我们在学习速度、学习能力和泛化性等方面,都做了大量的优化,并且提供了参数配置,让用户可以进

一步根据需要调优。

随机森林模型

随机森林模型使用多棵树进行单独预测,最后的结论由这些树预测结果的组合共同来决定,这也是“森林”名字的来源。每个基分类器可以很弱,但最后组合

的结果通常能很强,这也类似于:“三个臭皮匠顶个诸葛亮”的思想。

随机森林模型有如下特点:

很少的数据预处理。随机森林继承决策树的全部优点,只需做很少的数据准备,其他算法往往需要数据归一化。

功能强大。随机森林模型能处理连续变量,还能处理离散变量,当然也能处理多分类问题 。

鲁棒性更强。随机森林解决了决策树的过拟合问题,使模型的稳定性增加,对噪声更加鲁棒,从而使得整体预测精度得以提升。

线性回归模型(SGD)

用回归方程定量地刻画一个因变量与多个自变量间的线性依存关系,称为多元线性回归分析。多元线性回归分析是多变量分析的基础,也是理解监督类分析

方法的入口!实际上大部分学习统计分析和市场研究的人的都会用回归分析,操作比较简单。

在BigQuant上的线性回归模型的独特之处在于,在最小化损失函数——均分误差的时候,采取的是随机梯度下降法(stochastic gradient descent),因此更

高效。

上一页:因子预处理

下一页:开发传统趋势策略

目录:BigQuant学院

【

宽客学院】开发传统趋势策略

本文将告诉大家,如何开发一个传统的趋势跟踪策略。

在BigQuant策略平台上,除了开发AI策略,还可以开发传统策略,比如趋势跟踪、套利、事件驱动策略、多因子选股策略。本文以趋势跟踪策略为例,帮助

大家更好地理解BigQuant回测机制。

新建空白策略

参考新手引导 ,我的策略 > 新建 > 空白股票策略

策略命名

策略完整代码

金叉死叉策略¶

当短期均线上穿长期均线,出现金叉,买入

当短期均线下穿长期均线,出现死叉,卖出

1

. 主要参数¶

In [4]:

#

股票选择

instruments = ['600519.SHA']

#

开始时间

start_date = '2012-05-29'

结束时间

#

end_date = '2017-07-18'

2

. 策略回测主体¶

In [5]:

#

初始化账户

def initialize(context):

context.set_commission(PerOrder(buy_cost=0.0003, sell_cost=0.0013, min_cost=5)) # 设置手续费,买入成本为万分之三,卖出为千分之1.3

context.short_period = 5 # 短期均线

context.long_period = 50 # 长期均线

def handle_data(context, data):

#

长期均线值要有意义,需要在50根k线之后

if context.trading_day_index < context.long_period:

return

k = instruments[0] # 标的为字符串格式

sid = context.symbol(k) # 将标的转化为equity格式

price = data.current(sid, 'price') # 最新价格

short_mavg = data.history(sid, 'price',context.short_period, '1d').mean() # 短期均线值

long_mavg = data.history(sid, 'price',context.long_period, '1d').mean() # 长期均线值

cash = context.portfolio.cash # 现金

cur_position = context.portfolio.positions[sid].amount # 持仓

#

#

交易逻辑

如果短期均线大于长期均线形成金叉,并且没有持仓,并且该股票可以交易

if short_mavg > long_mavg and cur_position == 0 and data.can_trade(sid):

context.order(sid, int(cash/price/100)*100) # 买入

#

如果短期均线小于长期均线形成死叉,并且有持仓,并且该股票可以交易

elif short_mavg < long_mavg and cur_position > 0 and data.can_trade(sid):

context.order_target_percent(sid, 0) # 全部卖出

3

.回测接口¶

In [6]:

m=M.trade.v2(

instruments=instruments,

start_date=start_date,

end_date=end_date,

initialize=initialize,

handle_data=handle_data,

order_price_field_buy='open', # 以开盘价买入

order_price_field_sell='open', # 以开盘价卖出

capital_base=1000000, # 本金

)

[

[

2017-08-01 14:15:36.232518] INFO: bigquant: backtest.v7 start ..

2017-08-01 14:15:36.234645] INFO: bigquant: hit cache

[

2017-08-01 14:15:37.774814] INFO: bigquant: backtest.v7 end [1.542292s].

上一页:机器学习模型(持续更新中)

下一页:自定义买入卖出策略

目录:BigQuant学院

【

宽客学院】自定义买入卖出策略

策略思想丰富多样,尤其是在买入和卖出方面,一千个投资者可能有一千个交易想法。因此,本文告诉大家怎样进行灵活地买入和卖出,以便于大家能

够更高效地开发量化策略。

BigQuant平台提供了很多策略生成器的模板策略,其买入和卖出的思想是确定了的。由于每个人交易的想法可能千差万别,因此如果能灵活地自定义买入和

卖出岂不是更好。BigQuant的策略编写语言是Python,策略的交易主要是通过策略回测机制完成,因此一方面需要了解Python语言,另一方面,也是最重要

的是需要熟悉BigQuant回测机制。

基础策略¶

In [1]:

#

基础参数配置

class conf:

start_date = '2014-01-01'

end_date='2017-07-18'

split_date 之前的数据用于训练,之后的数据用作效果评估

split_date = '2016-01-01'

D.instruments: https://bigquant.com/docs/data_instruments.html

instruments = D.instruments(start_date, split_date)

#

#

#

#

#

机器学习目标标注函数

如下标注函数等价于 min(max((持有期间的收益 * 100), -20), 20) + 20 (后面的M.fast_auto_labeler会做取整操作)

说明:max/min这里将标注分数限定在区间[-20, 20],+20将分数变为非负数 (StockRanker要求标注分数非负整数)

label_expr = ['return * 100', 'where(label > {0}, {0}, where(label < -{0}, -{0}, label)) + {0}'.format(20)]

持有天数,用于计算label_expr中的return值(收益)

hold_days = 5

#

#

特征 https://bigquant.com/docs/data_features.html,你可以通过表达式构造任何特征

features = [

rank_market_cap_0', # 总市值排名

'

]

#

给数据做标注:给每一行数据(样本)打分,一般分数越高表示越好

m1 = M.fast_auto_labeler.v8(

instruments=conf.instruments, start_date=conf.start_date, end_date=conf.split_date,

label_expr=conf.label_expr, hold_days=conf.hold_days,

benchmark='000300.SHA', sell_at='open', buy_at='open')

#

计算特征数据

m2 = M.general_feature_extractor.v5(

instruments=conf.instruments, start_date=conf.start_date, end_date=conf.split_date,

features=conf.features)

#

数据预处理:缺失数据处理,数据规范化,T.get_stock_ranker_default_transforms为StockRanker模型做数据预处理

m3 = M.transform.v2(

data=m2.data, transforms=T.get_stock_ranker_default_transforms(),

drop_null=True, astype='int32', except_columns=['date', 'instrument'],

clip_lower=0, clip_upper=200000000)

#

合并标注和特征数据

m4 = M.join.v2(data1=m1.data, data2=m3.data, on=['date', 'instrument'], sort=True)

StockRanker机器学习训练

m5 = M.stock_ranker_train.v3(training_ds=m4.data, features=conf.features)

#

#

#

# 量化回测 https://bigquant.com/docs/module_trade.html

回测引擎:准备数据,只执行一次

def prepare(context):

#

context.start_date / end_date,回测的时候,为trader传入参数;在实盘运行的时候,由系统替换为实盘日期

n1 = M.general_feature_extractor.v5(

instruments=D.instruments(),

start_date=context.start_date, end_date=context.end_date,

model_id=context.options['model_id'])

n2 = M.transform.v2(

data=n1.data, transforms=T.get_stock_ranker_default_transforms(),

drop_null=True, astype='int32', except_columns=['date', 'instrument'],

clip_lower=0, clip_upper=200000000)

n3 = M.stock_ranker_predict.v2(model_id=context.options['model_id'], data=n2.data)

context.instruments = n3.instruments

context.options['predictions'] = n3.predictions

#

回测引擎:初始化函数,只执行一次

def initialize(context):

加载预测数据

context.ranker_prediction = context.options['predictions'].read_df()

#

#

系统已经设置了默认的交易手续费和滑点,要修改手续费可使用如下函数

context.set_commission(PerOrder(buy_cost=0.0003, sell_cost=0.0013, min_cost=5))

#

#

预测数据,通过options传入进来,使用 read_df 函数,加载到内存 (DataFrame)

设置买入的股票数量,这里买入预测股票列表排名靠前的5只

stock_count = 5

每只的股票的权重,如下的权重分配会使得靠前的股票分配多一点的资金,[0.339160, 0.213986, 0.169580, ..]

context.stock_weights = T.norm([1 / math.log(i + 2) for i in range(0, stock_count)])

设置每只股票占用的最大资金比例

#

#

context.max_cash_per_instrument = 0.2

#

回测引擎:每日数据处理函数,每天执行一次

def handle_data(context, data):

#

按日期过滤得到今日的预测数据

ranker_prediction = context.ranker_prediction[

context.ranker_prediction.date == data.current_dt.strftime('%Y-%m-%d')]

#

#

#

1. 资金分配

平均持仓时间是hold_days,每日都将买入股票,每日预期使用 1/hold_days 的资金

实际操作中,会存在一定的买入误差,所以在前hold_days天,等量使用资金;之后,尽量使用剩余资金(这里设置最多用等量的1.5倍)

is_staging = context.trading_day_index < context.options['hold_days'] # 是否在建仓期间(前 hold_days 天)

cash_avg = context.portfolio.portfolio_value / context.options['hold_days']

cash_for_buy = min(context.portfolio.cash, (1 if is_staging else 1.5) * cash_avg)

cash_for_sell = cash_avg - (context.portfolio.cash - cash_for_buy)

positions = {e.symbol: p.amount * p.last_sale_price

for e, p in context.portfolio.positions.items()}

#

2. 生成卖出订单:hold_days天之后才开始卖出;对持仓的股票,按StockRanker预测的排序末位淘汰

if not is_staging and cash_for_sell > 0:

equities = {e.symbol: e for e, p in context.portfolio.positions.items()}

instruments = list(reversed(list(ranker_prediction.instrument[ranker_prediction.instrument.apply(

lambda x: x in equities and not context.has_unfinished_sell_order(equities[x]))])))

#

print('rank order for sell %s' % instruments)

for instrument in instruments:

context.order_target(context.symbol(instrument), 0)

cash_for_sell -= positions[instrument]

if cash_for_sell <= 0:

break

#

3. 生成买入订单:按StockRanker预测的排序,买入前面的stock_count只股票

buy_cash_weights = context.stock_weights

buy_instruments = list(ranker_prediction.instrument[:len(buy_cash_weights)])

max_cash_per_instrument = context.portfolio.portfolio_value * context.max_cash_per_instrument

for i, instrument in enumerate(buy_instruments):

cash = cash_for_buy * buy_cash_weights[i]

if cash > max_cash_per_instrument - positions.get(instrument, 0):

#

确保股票持仓量不会超过每次股票最大的占用资金量

cash = max_cash_per_instrument - positions.get(instrument, 0)

if cash > 0: