无论是服务器更新换代还是构建AI集群,都面临着一个不可忽视的挑战:尽管液冷技术备受关注,但高耗能始终是难以克服的难题。这一现象的背后,众多因素交织,同时也与服务器性能和容量的持续提升密不可分。

本文将聚焦于双路服务器CPU和NVIDIA SXM GPU,深入探讨其热设计功耗(TDP)随时间变化的趋势。

服务器CPU TDP迅猛增长

绘制CPU TDP随时间变化的图时,我们一度陷入选择困境:究竟应该涵盖哪些型号?产量较低的高端八路Xeon EX型号?还是面向工作站设计的型号?最终,聚焦于双路服务器中广泛应用的芯片类型,权衡取舍。这些图虽非完美无缺,但力求客观反映服务器CPU发展的趋势,其中难免包含一些主观判断。

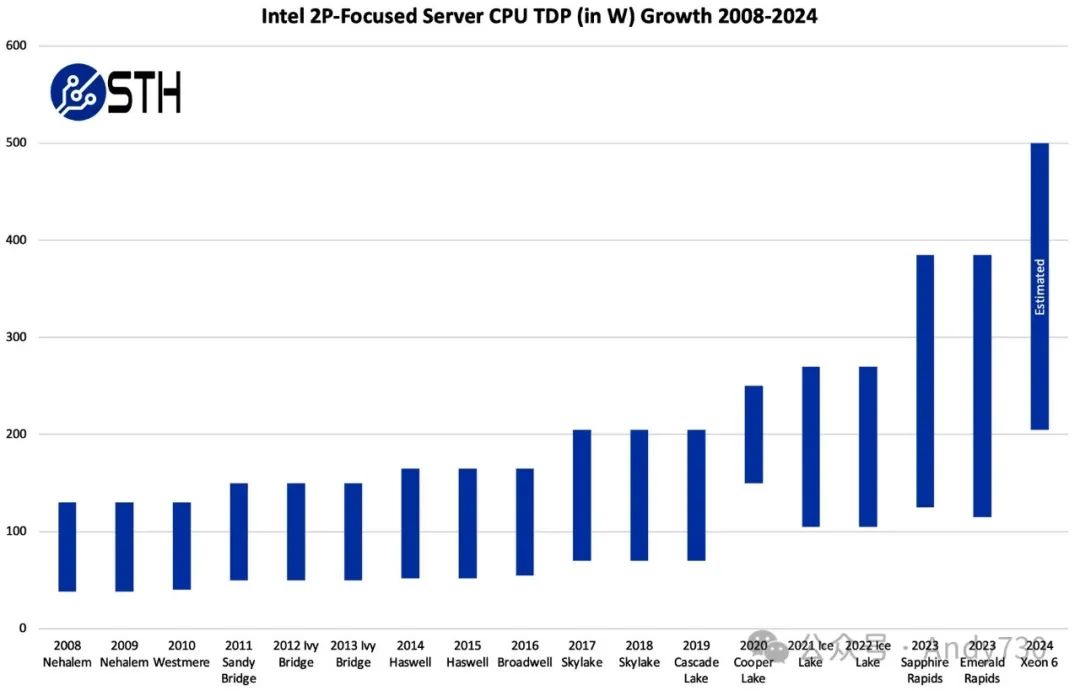

纵观双路Intel Xeon处理器的TDP演变历程,其增长速度愈发迅猛,尤其在过去十多年间体现得尤为明显。

Intel双路服务器处理器TDP范围(2008-2024年)

Intel双路服务器处理器TDP范围(2008-2024年)

从2008年至2016年,功耗水平总体保持平稳态势。然而,随着2017年首代Intel Xeon Scalable处理器Skylake的发布,TDP首次出现显著增长。2019年推出的Cascade Lake更是将这一趋势推向顶峰,无论高端还是低端产品,TDP都呈现出飙升态势。尽管基于Cascade Lake改进的Cooper Lake在Facebook等场景得到了部署,但更多地作为四路服务器的代表被纳入统计。剔除Cooper Lake数据,仅观察2017年至2020年的数据,不难发现TDP曾经历过一段短暂的停滞期。但自2021年Ice Lake发布以来,无论是高端还是低端的SKU,TDP都再度攀升。

需要注意的是,尽管我们已经提到本季度Granite Rapids-AP和Q4 AMD EPYC-Next(Turin)的最大TDP均达到了500W,但这些产品尚未正式发布,完整的产品线信息也尚未公布。因此,目前只能根据两家公司对高端500W产品的声明进行预估,未来这一数据或有变动。

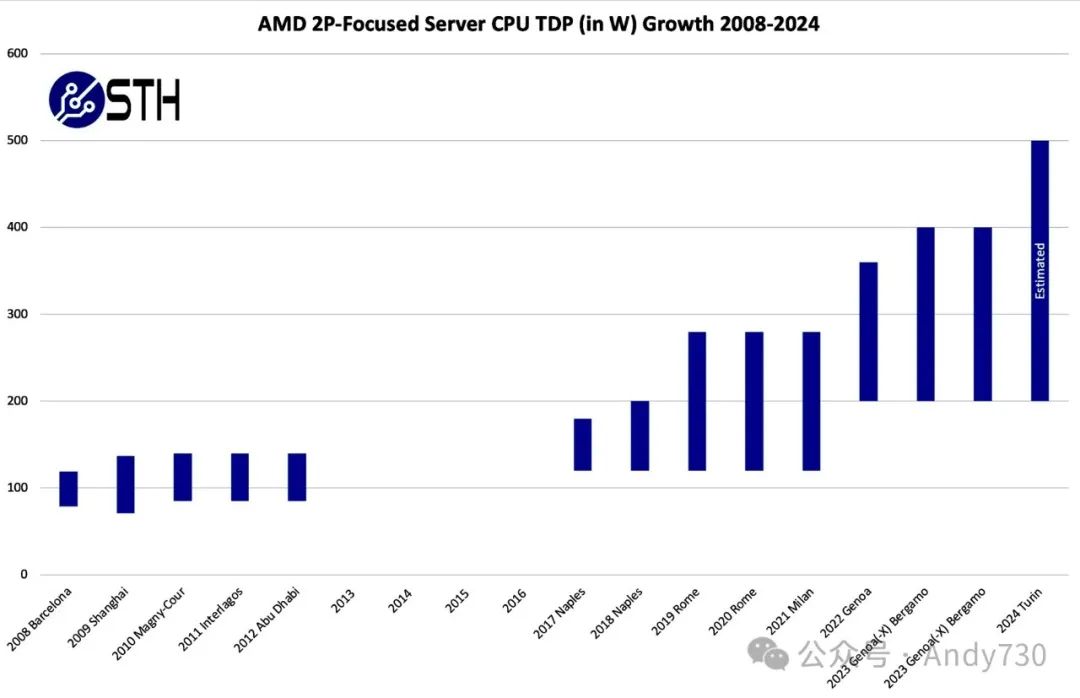

从AMD的角度来看,其CPU部件的TDP增长同样不容忽视。以昔日热门的Operton 6000系列为基准,回顾一下G34评估的过往数据。当Intel Xeon E5-2600系列于2011年问世时,业界普遍认为它将取代Operton 6000系列成为市场主流。

AMD双路服务器处理器TDP发展趋势(2008-2024年)

AMD双路服务器处理器TDP发展趋势(2008-2024年)

尽管Turin的低端TDP设定或许略显保守,但总体而言,TDP增长趋势依然清晰可见。对比Intel的图,不难发现AMD的TDP增长速度更为迅猛。在业界讨论中,有人认为在最新Xeon 6E发布之前,AMD在能效方面占据优势。这主要得益于AMD EPYC Rome至Genoa/Genoa-X/Bergamo系列在工艺上的显著进步,使其能够在更高的TDP下集成更多核心。例如,2019年高端Cascade Lake Xeon 8280以205W功耗提供28核性能,每核功耗约为7.3W;而面向高性能计算的AMD EPYC 7H12则是一款64核产品,其280W功耗下每核功耗仅为约4.4W。尽管功耗有所提升,但能效却实现了显著提升。

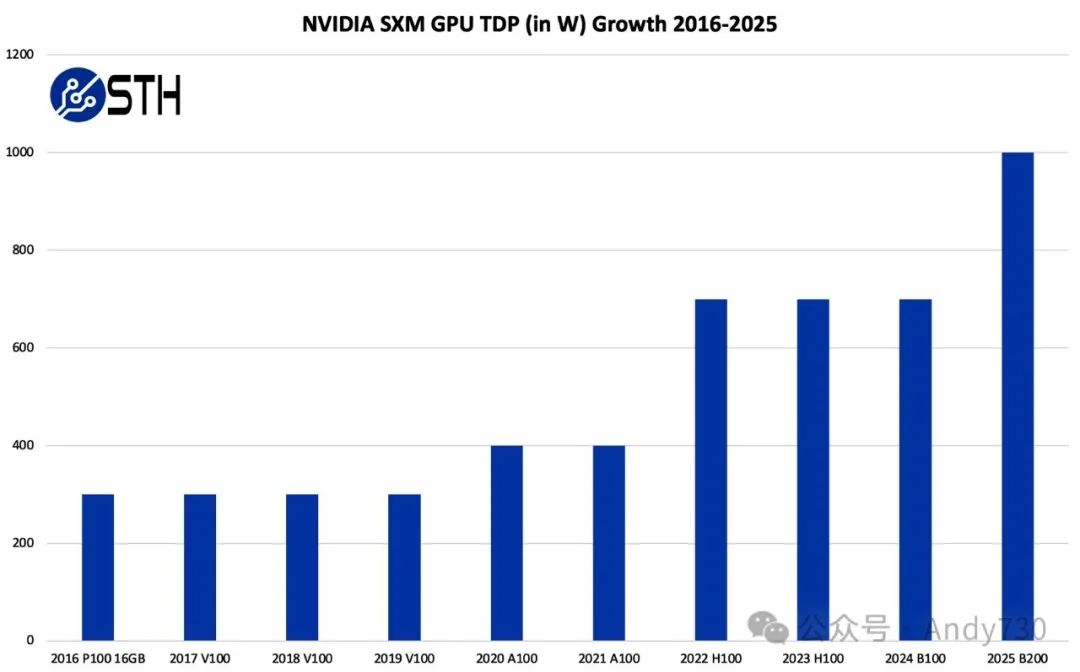

GPU同样面临TDP增长

GPU是另一个TDP显著增长的领域。尽管我们通常不提前透露性能数据,但为了验证我们手中SXM GPU的功耗数据与NVIDIA官方年度数据的一致性,我们发送了相关图并得到了确认。GPU的发布与推广往往跨越不同季度,且NVIDIA GPU常采用可配置的TDP设计,因此,我们此番验证旨在确保方向的正确性。

NVIDIA SXM GPU TDP增长趋势(2016-2025)

NVIDIA SXM GPU TDP增长趋势(2016-2025)

从300W到700W的TDP跨度,与CPU TDP的增长趋势相吻合。但值得注意的是,在SXM系统中,通常配置有八个GPU。回溯至2016年,当NVIDIA引入SXM技术时,典型的深度学习服务器采用的是8路或10路GeForce RTX 1080 Ti配置。随后,NVIDIA的EULA(最终用户许可协议)及硬件调整推动了市场向数据中心GPU的转变,这些系统的功耗普遍在2.4至3.1千瓦之间。

10片NVIDIA GTX 1080 TI FE显卡搭配Mellanox Top系统

10片NVIDIA GTX 1080 TI FE显卡搭配Mellanox Top系统

去年,在我们的NVIDIA L40S评估中,我们见证了这一设计理念的更新迭代。

现代AI服务器在速度上实现了飞跃,但功耗也随之攀升至8千瓦,甚至更高。这一现状促使企业纷纷采用液冷技术以降低功耗,并升级机架供电系统以应对挑战。

展望未来,我们预计到2025年,这些系统在每个机架上的功耗将超过10千瓦,因为每个包含八个加速器的系统都将接近1千瓦TDP的门槛。值得注意的是,在北美地区,仍有大量15A/20A 120V的机架存在,它们甚至无法为这些大型AI服务器的单个电源提供足够的电力支持。

尽管我们频繁讨论CPU和GPU的TDP,但实际上,背后还隐藏着更多复杂的因素。

服务器内存扩展的演变

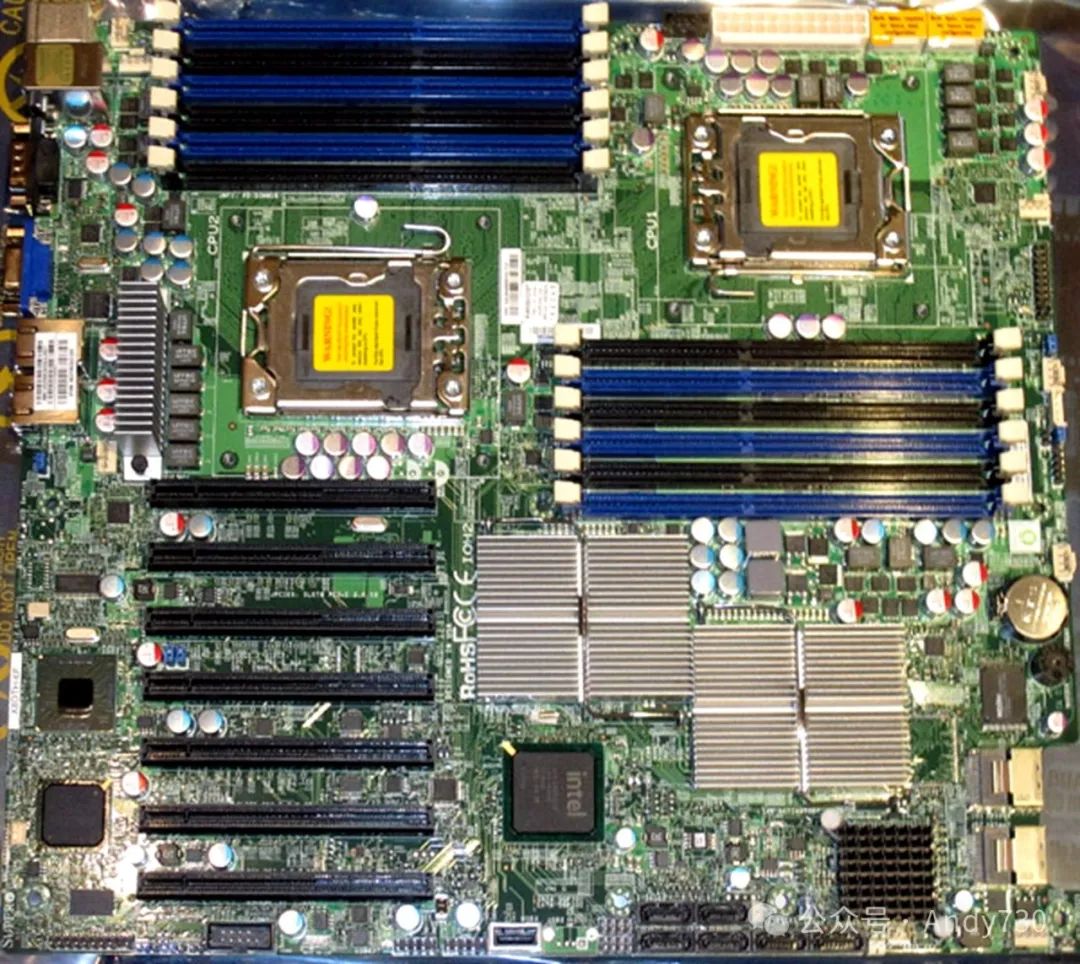

回顾历史资料,可以找到Nehalem-EP和Westmere-EP时代(2008-2010年,对应于本文开头Intel CPU TDP图)双路服务器的实例。当时,每个CPU配备3通道内存,每个通道拥有2个DIMM插槽,因此每个CPU拥有6个DIMM插槽,双路系统总计拥有12个DIMM插槽。

Supermicro X8DTH-6F Small Board

Supermicro X8DTH-6F Small Board

如今,服务器不仅采用了速度更快、容量更大的DIMM,还通过增加内存通道和DIMM插槽数量来进一步提升性能。以单个AMD EPYC Genoa CPU为例,其使用的DIMM数量是2008-2010年Xeon CPU的四倍,是2011-2016年Xeon CPU的三倍,也是2017-2020年Xeon CPU的两倍。

Supermicro AS 2015HS TNR主板(24个DIMM插槽,支持2DPC)

Supermicro AS 2015HS TNR主板(24个DIMM插槽,支持2DPC)

虽然CPU TDP通常是我们的关注焦点,但要实现现代插槽提供的完整内存容量和带宽,也意味着需要增加内存设备。目前,围绕CXL技术,正兴起一股通过增加更多内存插件设备来扩展内存容量的趋势。由于每个DIMM大约消耗5W的电力,现代服务器中的内存系统可能比Xeon E5时代整个插槽的内存消耗更多的电力。

TDP并非唯一考量

通过观察上面的图,有人可能会正确推断出每个节点的性能和功耗都随着时间而增长。然而,这可能存在误解,认为充分利用的服务器与前代产品相比,功耗效率更低。

Supermicro SYS 222H TN Xeon 6 Birch Stream平台展示(288核心)

Supermicro SYS 222H TN Xeon 6 Birch Stream平台展示(288核心)

通过制造更大容量的CPU、GPU、网卡及其他加速器,我们能够在单个节点上完成更多工作。这样做减少了完成任务所需的节点数量。每个额外的节点都伴随着额外的机箱、电源供应器、主板、启动驱动器、PDU端口、管理处理器、管理网络端口、网络端口等额外开销。通过将这些资源整合到更少但功能更强大的节点中,我们可以将大量成本节省下来,转而专注于优化节点间的通信效率。

Supermicro NVIDIA GB200 NVL72机架(大型)

Supermicro NVIDIA GB200 NVL72机架(大型)

这正是NVIDIA GB200 NVL72设计背后的一个关键驱动力,它旨在将尽可能多的计算和互连功能集成到单个机架内。在100-120kW功耗范围内,这种机架对于未针对高密度设计的数据中心而言,无疑构成了巨大挑战。

GB200 NVL72机架在运行一小时内消耗的电力,相当于一辆特斯拉Cybertruck整车电池的容量。这为我们审视机架功耗问题提供了另一视角。

总结

这不仅涉及功耗问题,还涉及数据中心基础设施的多个层面。尽管液冷技术备受关注,但能耗问题日益成为数据中心面临的首要挑战。几年前,企业仍在努力让服务器保持在热量和功耗限制内,以维持现有的机架基础设施;而如今,新的趋势是向机架提供更高的电力支持。这是行业发展的一个重要且必要的转变。

Source:Patrick Kennedy; Why Servers Are Using So Much Power TDP Growth Over Time; July 10, 2024

--【本文完】---

近期受欢迎的文章:

更多交流,可添加本人微信

(请附姓名/单位/关注领域)