摘要

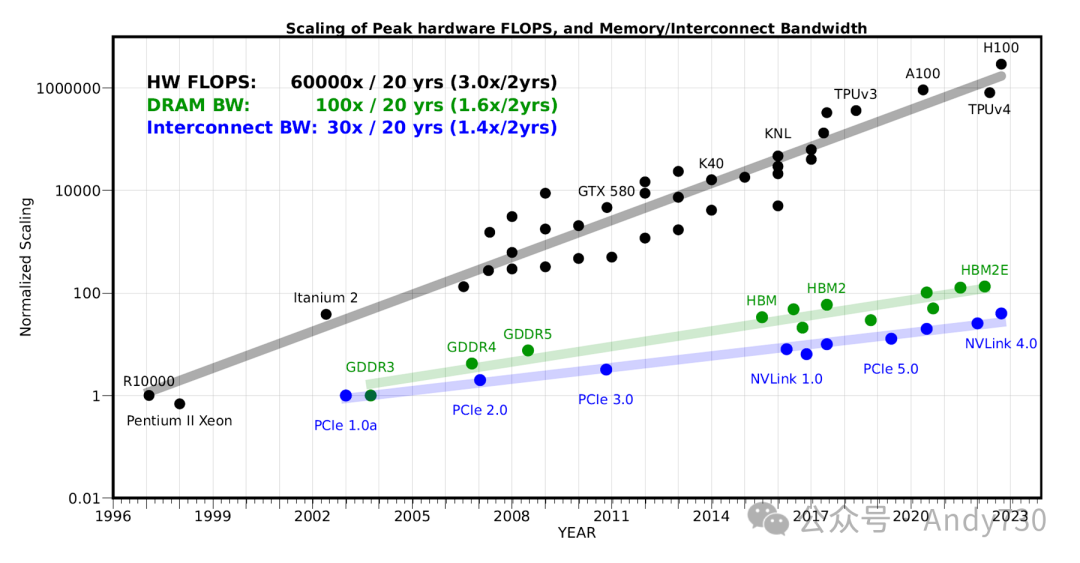

随着海量无监督训练数据的涌现以及神经网络规模定律的提出,大型语言模型(LLM)在模型规模和计算需求方面均呈现出爆发式增长。然而,内存带宽问题日益成为制约其进一步发展的关键瓶颈。过去二十年间,服务器硬件的峰值浮点运算性能(FLOPS)每两年增长约3.0倍,远超DRAM和互连带宽的增长速度,后者分别仅为每两年1.6倍和1.4倍。这一差距导致内存而非计算能力成为人工智能应用,特别是服务领域的主要瓶颈。

本文深入分析了编码器和解码器·模型,并揭示了内存带宽如何成为解码器模型的主要性能瓶颈。我们呼吁从模型架构、训练和部署策略等方面进行重新设计,以突破这一内存限制。

论文题目:AI and Memory Wall

作者:Amir Gholami, Zhewei Yao, Sehoon Kim, Coleman Hooper, Michael W. Mahoney, Kurt Keutzer1

I. 引言

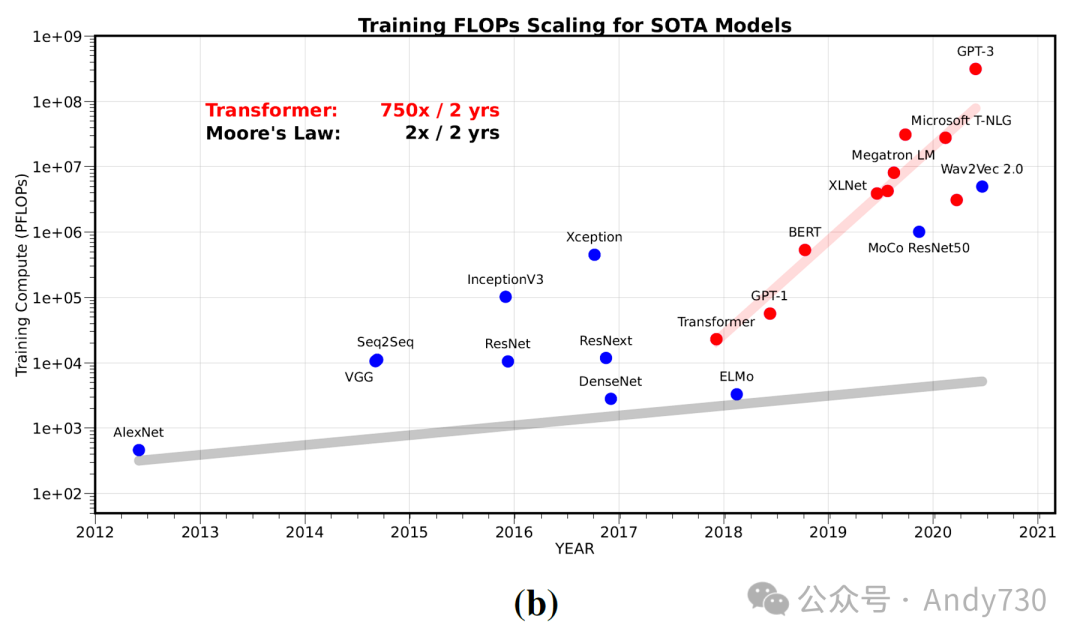

近年来,大型语言模型(LLM)的训练计算量呈现出惊人的增长趋势,每两年激增750倍。这一指数级增长催生了AI加速器的蓬勃发展,然而这些加速器往往只着眼于提升硬件的峰值计算能力,而忽略了内存层次结构其他方面的优化。然而,这种发展趋势却掩盖了一个日益严峻的挑战:内存和通信瓶颈。事实上,许多AI应用并非受限于计算能力,而是受到芯片内/芯片间以及与AI加速器之间通信带宽的制约。

这一现象并非新鲜事物,早在20世纪90年代,就有研究者对此发出过预警。1990年,Ousterhout在分析操作系统性能的影响因素后指出:

“首要的硬件相关问题是内存带宽:基准测试表明,它跟不上CPU速度的提升……如果未来机器的内存带宽不能得到显著提高,某些类型的应用程序可能会受到内存性能的限制。”

1995年,William Wulf和Sally McKee对前述预测进行了深入探讨,并提出了“内存墙”这一概念。他们的观点基于一个既简单又深刻的逻辑:完成一个操作所需的时间,不仅取决于执行算术运算的速度,还取决于向硬件算术单元提供数据的速度。在最简单的情况下,数据要么可以直接从缓存中获取,要么需要从DRAM中提取。假设80%的数据能在缓存中直接获取,而剩下的20%的数据需要从DRAM中检索。如果这20%的缓存未命中数据检索需要超过5个周期,那么整个操作的时间将完全受限于DRAM的带宽。这意味着,无论硬件的算术运算速度有多快,最终都会受到DRAM带宽的制约。他们预测,计算速度和数据提取速度之间的巨大差距将导致“内存墙”问题的出现。基于这一分析,他们得出结论:

“尽管所有方面都呈现指数级增长,但微处理器的增长速度远超过DRAM的增长速度。这种指数增长之间的差距,同样在呈现指数级增长。”

随后,多个研究也证实了类似的观察结果。

在本文中,我们基于更近期的数据,特别是用于训练AI模型的硬件及其训练/服务的计算特性,对这一趋势进行了重新审视。30年后的今天,上述观察和预测变得愈发准确。尽管内存技术有所创新,但趋势显示“内存墙”正逐渐演变为各种AI任务的主要瓶颈。

首先,我们回顾了自1998年Yann LeCun在MNIST数据集上训练着名的LeNet-5模型以来,服务器级AI硬件峰值计算能力的变化。在过去的20年里,硬件的峰值计算能力增长了6万倍,而DRAM仅增长了100倍,互连带宽仅增长了30倍。

内存墙问题涉及内存传输的容量、带宽以及延迟(延迟的改善相较于带宽更为困难)。这涵盖了不同级别的内存数据传输,如计算逻辑与片上内存之间的数据传输、计算逻辑与DRAM内存之间的数据传输,以及不同插槽上不同处理器之间的数据传输。在所有这些情况下,数据传输的容量和速度都明显落后于硬件的计算能力。

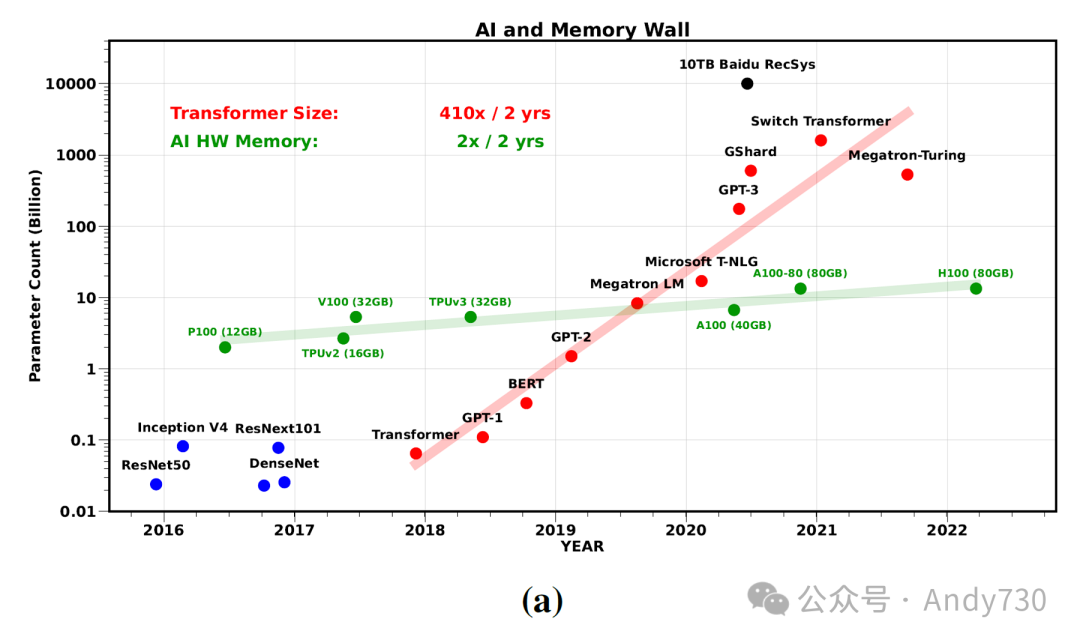

现在,如果我们审视近期的AI模型,特别是LLM,我们会发现研究人员受到神经网络规模定律的激励,在数据量、模型大小和训练所需的计算量上进行了前所未有的扩展。尽管在2018-2022年间训练这些模型所需的计算量(浮点运算,FLOPs)增加了750倍,但在模型服务方面,计算并非主要的瓶颈。

首先,在此期间,LLM的规模以每两年410倍的速度增长,远远超出了单个芯片的内存容量。人们可能希望通过将训练/服务扩展到多个加速器上,利用分布式内存并行性来避免单一硬件的内存容量和带宽限制。然而,将工作分配给多个进程也可能面临内存墙问题:神经网络(NN)加速器之间的数据移动通信瓶颈,这比片上数据移动更为缓慢且低效。类似于单系统内存的情况,我们尚未克服扩大网络带宽的技术挑战。

其次,即使模型能在单个芯片内适配,从/向寄存器、L2缓存、全局内存等片内内存传输也逐渐成为瓶颈。由于最近在专用计算单元(如Tensor核心)方面的进步,大量的算术操作可以在几个周期内完成。因此,为了持续保持这些算术单元的利用率,需要迅速向其提供大量数据,这正是芯片内存带宽成为瓶颈的原因。

图1:不同代际的互连和内存带宽扩展与峰值FLOPS的扩展对比图。可以明显看出,带宽的增长速度相对较慢。为了规范化硬件峰值FLOPS,我们采用了R10000系统,因为它曾被用于报告训练LeNet-5的成本[22]。

图1:不同代际的互连和内存带宽扩展与峰值FLOPS的扩展对比图。可以明显看出,带宽的增长速度相对较慢。为了规范化硬件峰值FLOPS,我们采用了R10000系统,因为它曾被用于报告训练LeNet-5的成本[22]。

如图1所示,在过去的20年里,服务器硬件的峰值浮点运算性能(FLOPS)以每两年3.0倍的速度迅猛增长,远远超过了DRAM和互联带宽的增长速度,后者每两年分别仅增长1.6倍和1.4倍。这种显著的差距使得内存,而非计算能力,日益成为瓶颈,即使在模型能够在单个芯片内运行的情况下亦是如此。

接下来,我们将通过一个详尽的Transformer案例研究,深入分析FLOPs(浮点运算次数)、内存操作(MOPs)以及端到端运行时间之间的相互作用,重点考察当今广泛使用的模型。

II. 案例研究

在本章中,我们将首先概述Transformer推理的运行时特性和性能瓶颈。我们将分析Transformer架构的两种不同变体:一种是并行处理所有token的编码器架构(如BERT [7]),另一种是自回归地处理和生成一个token的解码器架构(如GPT [3, 33])。

A. 算术强度(Arithmetic Intensity)

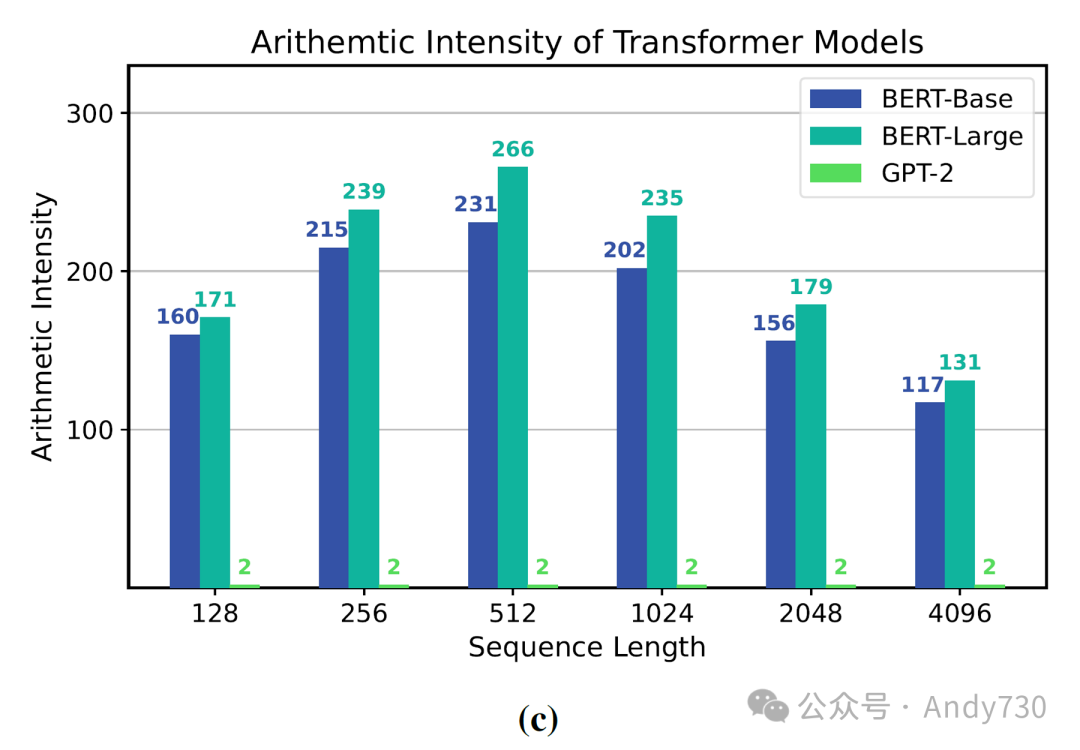

评估性能瓶颈的一个常用方法是计算Transformer模型的编码器和解码器部分所需的总FLOPs。然而,仅依赖这一指标可能会产生误导性结果。更准确的方法是深入研究涉及操作的算术强度。算术强度衡量的是每从内存加载一个字节数据时所能执行的FLOPs数量。其计算公式如下:

算术强度 = 总FLOPs数 总MOPs数

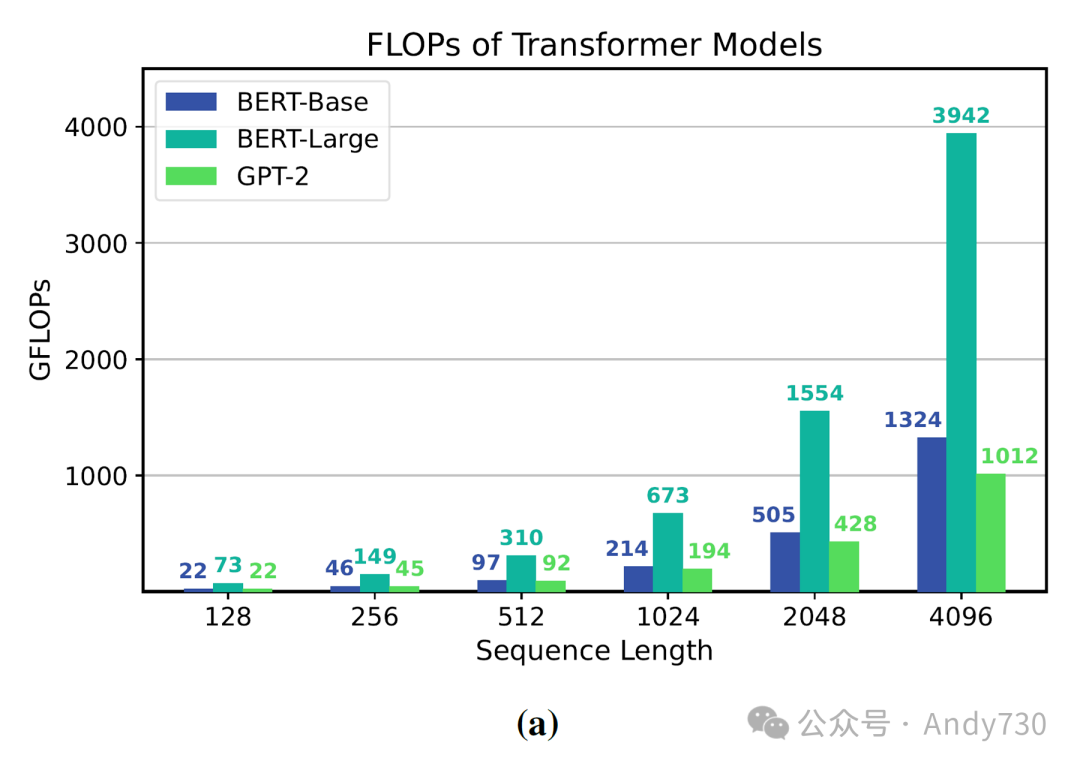

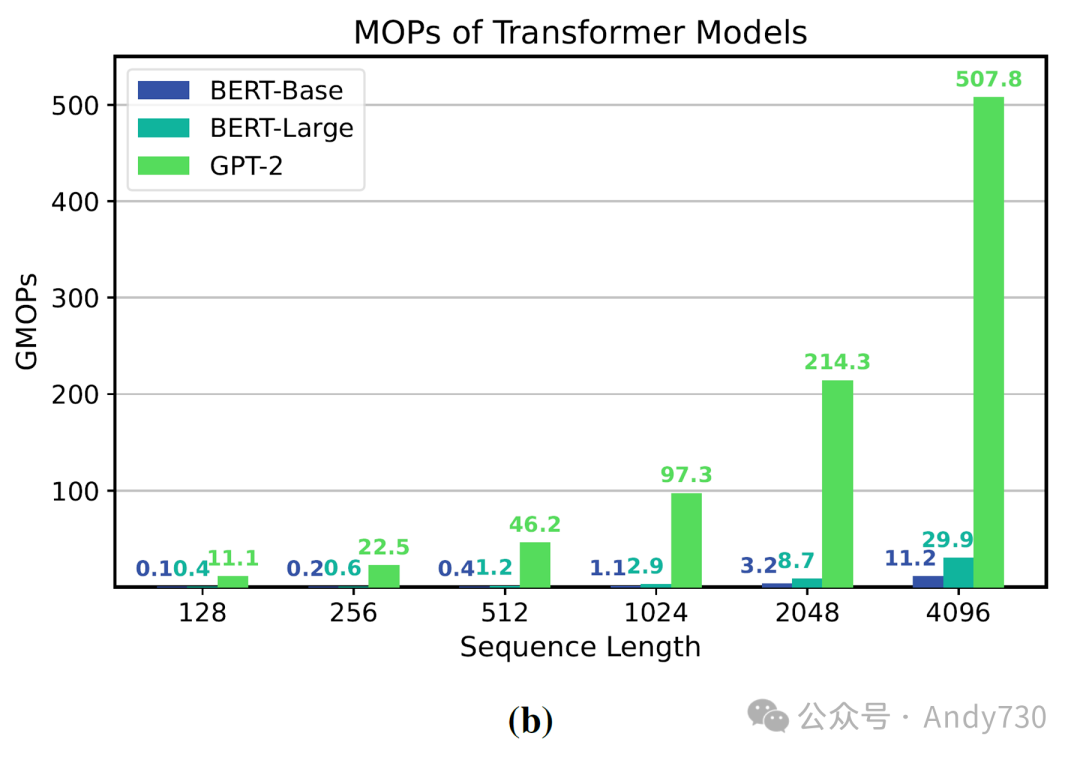

为了阐明考虑算术强度的重要性,我们以BERT-Base和BERT-Large [7]以及GPT-2 [33]为例进行了研究。前两个模型属于编码器类型,推理过程中主要涉及矩阵-矩阵运算;而后者为解码器/自回归模型,推理过程中涉及重复的矩阵-向量乘法。

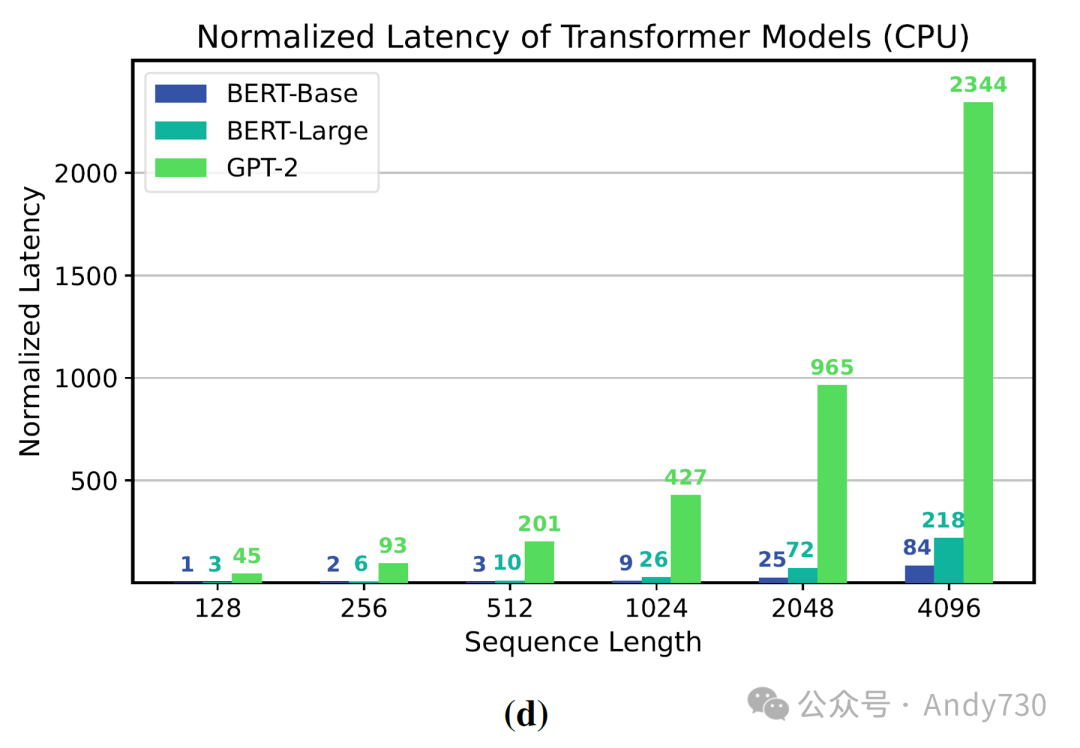

图3:针对BERT-Base、BERT-Large和GPT-2模型在处理/生成不同序列长度且批量大小为1的情况下的分析结果。(a) 总推理FLOPs:请注意,编码器模型具有更高的FLOPs;(b) 总推理内存操作(MOPs):请注意,解码器GPT模型由于其矩阵-向量类型操作相比编码器模型的矩阵-矩阵操作具有数量级更多的MOPs;(c) 算术强度:请注意,GPT-2具有数量级更小的算术强度,这使得它难以有效利用给定硬件的计算单元;(d) 处理输入序列长度为128的BERT-Base模型的不同模型端到端延迟归一化:请注意,尽管解码器模型的FLOPs较小,但其运行时间最慢。详见[18]。

图3:针对BERT-Base、BERT-Large和GPT-2模型在处理/生成不同序列长度且批量大小为1的情况下的分析结果。(a) 总推理FLOPs:请注意,编码器模型具有更高的FLOPs;(b) 总推理内存操作(MOPs):请注意,解码器GPT模型由于其矩阵-向量类型操作相比编码器模型的矩阵-矩阵操作具有数量级更多的MOPs;(c) 算术强度:请注意,GPT-2具有数量级更小的算术强度,这使得它难以有效利用给定硬件的计算单元;(d) 处理输入序列长度为128的BERT-Base模型的不同模型端到端延迟归一化:请注意,尽管解码器模型的FLOPs较小,但其运行时间最慢。详见[18]。

B. 分析

为了分析Transformer工作负载在商用硬件上的瓶颈,我们在Intel Gold 6242 CPU上进行了Transformer推理分析。图3展示了不同序列长度下这些模型的总FLOPs、MOPs、算术强度和最终延迟。结果表明,对于每个序列长度,GPT-2的延迟明显高于BERT-Base或BERT-Large,即使BERT-Base和GPT-2在模型配置和端到端FLOPs上基本相同(如图3a所示)。这主要是因为GPT的自回归推理过程中存在固有的更高内存操作和较低算术强度的矩阵-向量运算(如图3c所示)。具有更高算术强度的模型能够在相同甚至更多的FLOPs下运行得更快,而算术强度较低的模型则不能。这清楚地表明,对于解码器模型(尤其是在低批处理大小时),内存墙而非计算能力成为主要瓶颈。

III. 解决“内存墙”的潜在方案

“任何指数增长都不可能永远持续下去” [28]。即使对于大型超大规模公司来说,维持每两年410倍的指数级增长也是不可持续的。此外,计算能力和带宽能力之间的差距不断扩大,导致训练更大模型的成本呈指数级增长,这将使其变得极具挑战性。

为了继续创新并突破内存墙,我们需要重新思考AI模型的设计。以下是一些关键问题需要考虑:

当前的AI模型设计方法大多是临时的,或者仅涉及非常简单的扩展规则。例如,最近的大型Transformer模型[3, 16, 37]主要基于最初BERT模型[7]提出的基础架构的放大版本。

我们需要设计更高效的数据训练方法。当前的神经网络需要大量的训练数据和成千上万次迭代才能学习,这非常低效。值得注意的是,这与人类大脑的学习方式截然不同,后者通常每个概念/类别只需要很少的例子。

图2:(a) 多年来SOTA模型参数数量的演变趋势,以及AI加速器内存容量(绿色点)的变化情况。大型Transformer模型的参数数量以每两年410倍的速度呈指数增长,而单个GPU的内存容量每两年仅增长2倍。这里仅考虑了非推荐系统模型(红圈)来计算Transformer模型的增长率。GPU内存的扩展情况通过将相应的内存大小除以6来绘制,以此作为与相应容量一起训练的最大模型的近似上限。(b) 不同计算机视觉(CV)、自然语言处理(NLP)和语音模型训练SOTA模型所需的计算量(以Peta FLOPs为单位),以及Transformer模型的不同扩展速度(750倍/2年)。

图2:(a) 多年来SOTA模型参数数量的演变趋势,以及AI加速器内存容量(绿色点)的变化情况。大型Transformer模型的参数数量以每两年410倍的速度呈指数增长,而单个GPU的内存容量每两年仅增长2倍。这里仅考虑了非推荐系统模型(红圈)来计算Transformer模型的增长率。GPU内存的扩展情况通过将相应的内存大小除以6来绘制,以此作为与相应容量一起训练的最大模型的近似上限。(b) 不同计算机视觉(CV)、自然语言处理(NLP)和语音模型训练SOTA模型所需的计算量(以Peta FLOPs为单位),以及Transformer模型的不同扩展速度(750倍/2年)。

当前的优化和训练方法需要大量的超参数调优(如学习率、动量等)。这通常涉及数百次试验和错误筛选以找到合适的超参数设置来成功训练模型。因此,图2(b)中报告的训练成本仅是实际开销的下限,实际成本通常要高得多。

最先进模型的巨大规模使得其推理部署变得极具挑战性。这不仅仅局限于GPT-3这样的模型,事实上,部署超大规模公司使用的大型推荐系统也是一个重大挑战。

硬件加速器的设计主要侧重于增加峰值计算能力,而对提高内存受限工作负载的关注相对较少。这使得训练大模型以及探索其他模型(如图神经网络)变得困难,这些模型通常受带宽限制,无法高效利用当前的加速器。

上述问题均为机器学习中的基本问题。在这里,我们将简要探讨针对最后三项的最新研究(包括我们的一些研究成果)。

A. 高效训练算法

在训练神经网络模型时,一个显著的挑战在于超参数的精细调整。这包括确定学习率及其衰减策略、达到收敛所需的迭代次数等,这些无疑为训练最先进的模型增加了不小的额外开销。许多这样的挑战源自传统的一阶随机梯度下降(SGD)方法。尽管SGD的变体易于实现,但它们对超参数的调整并不十分稳健,且对于新模型而言,找到合适的超参数集尤为困难。

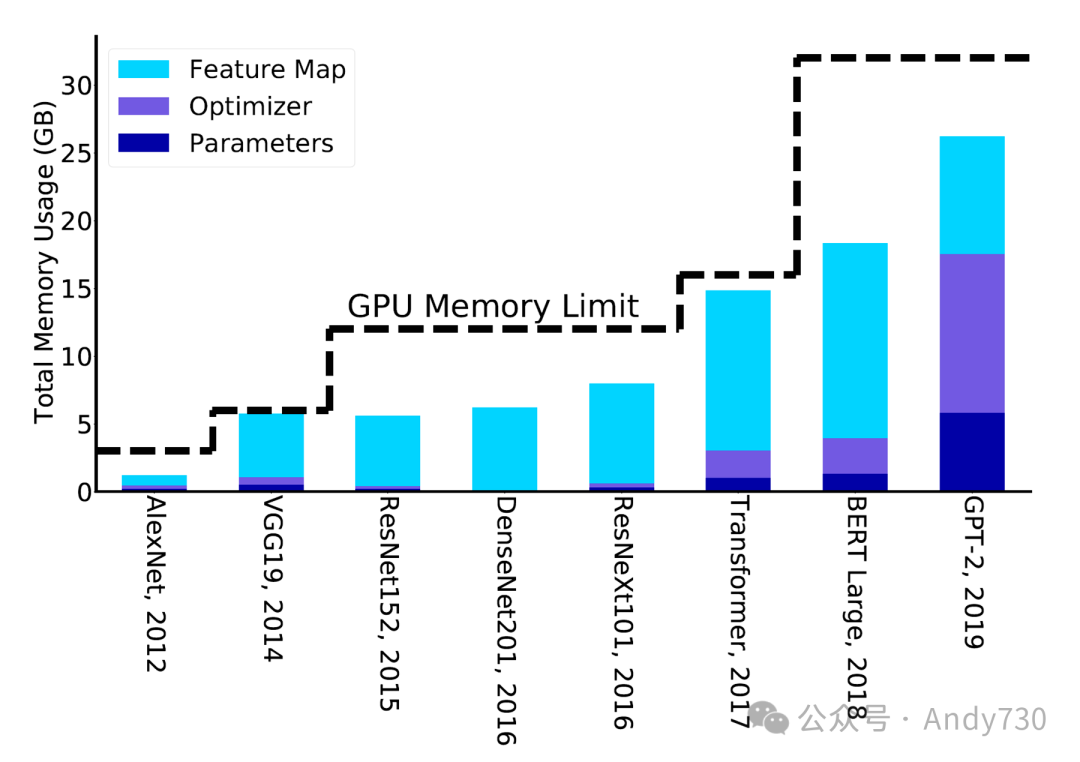

为了克服这一难题,二阶随机优化方法展现出了巨大的潜力[43]。这些方法通常对超参数调整更加稳健,并能够实现出色的性能[43]。然而,目前这些方法所需的内存是传统方法的3-4倍,这成为了一个亟待解决的问题[43]。值得一提的是,微软的Zero框架提供了一种可能的解决方案,它通过移除或分片冗余的优化状态变量,实现了在相同内存容量下训练规模扩大8倍的模型[2, 34]。如果能够成功解决这些高阶方法的开销问题,它们无疑将大幅度降低训练大型模型的总成本。

图4:训练不同NN模型所需的内存量。在此,CV模型使用的优化器是SGD+动量,NLP模型则使用ADAM。从图中可见,基于当前GPU的内存大小,数据科学家在发现/设计新模型方面展现出了一个有趣的趋势。每当GPU内存容量增加时,他们都会设计出更新的模型。因此,突破这一所谓的GPU内存墙可能会进一步推动新的技术创新。详见[15]中关于检查点的更多细节。

图4:训练不同NN模型所需的内存量。在此,CV模型使用的优化器是SGD+动量,NLP模型则使用ADAM。从图中可见,基于当前GPU的内存大小,数据科学家在发现/设计新模型方面展现出了一个有趣的趋势。每当GPU内存容量增加时,他们都会设计出更新的模型。因此,突破这一所谓的GPU内存墙可能会进一步推动新的技术创新。详见[15]中关于检查点的更多细节。

另一种有效的方法是减少内存占用并增强优化算法的数据局部性,尽管这可能会增加计算量。在数值线性代数中,“通信避免算法”(Communication-Avoiding Algorithms)家族便是一个显著的例子[1]。在优化神经网络训练内存方面,“再物质化”(rematerialization)技术便是一个典型的实践,即在前向传播过程中仅存储/检查部分激活,而非保存全部激活。这种方法减少了特征图的内存占用,如图4所示。当需要时,可以通过重新计算得到剩余的激活[15, 19]。尽管这样做会增加计算量,但研究显示,仅增加20%的计算量便能显著减少内存占用高达5倍[15]。这种策略允许研究人员在单芯片内存上训练大型模型,避免了复杂的分布式训练设置(这在大型超大规模公司之外通常难以实施)和调试困难(对于非专家开发者而言)。值得关注的是,传统趋势表明,新神经网络模型架构的开发往往基于研究人员在单芯片内存上的可操作性,而非复杂的分布式内存方法,如图4所示。当然,在拥有专门团队支持的大型超大规模公司中,确实存在许多反例,但纵观整个社区,这样的例子仍是有限的。事实上,即使是最新的大型语言模型,也经常需要付出大量努力来压缩模型以适应单一系统,以便更广泛的研究社区能够使用。

另一个重要的方法是设计对低精度训练具有鲁棒性的优化算法。AI加速器的一个关键进展便是使用半精度(FP16)计算而非单精度[11, 26],这大幅提升了硬件计算能力,提升了十倍以上。然而,进一步将精度从半精度降低到INT8,同时保持准确性,对当前的优化方法来说仍然是一个难题。最近,一个令人鼓舞的方向是使用FP8和FP16的混合使用(甚至包括最新的FP4格式)[27]。这一领域的算法创新无疑将让我们能够更有效地利用硬件资源,并可能允许更多芯片面积用于改善内存(通常称为“内存差距惩罚”(memory-gap penalty)[31])。

B. 高效部署

部署像GPT-3 [3]这样的最新SOTA模型[4, 5, 16, 37]或大型推荐系统[29]极具挑战性,因为它们依赖于分布式内存进行推理。为了应对这一挑战,一种有前景的解决方案是对这些模型进行推理压缩,具体方法包括降低精度(即量化)、去除冗余参数(即剪枝)或设计小型语言模型[35]。

量化

量化可以在训练和/或推理步骤中实施。尽管将训练精度降低到FP16以下极具挑战性,但在推理过程中使用超低精度却是可行的。使用当前技术,相对容易地将推理量化到INT4精度,且对准确性的影响微乎其微[6, 9, 17, 23, 44]。这种量化可以使模型占用空间和延迟减少多达8倍[10]。然而,使用低于INT4的精度进行推理则更具挑战性,目前已成为一个活跃的研究领域。

剪枝

剪枝技术旨在完全去除模型中的冗余参数。借助当前方法,可以在结构化稀疏情况下剪枝多达30%的神经元,而在非结构化稀疏情况下则高达80%,且对准确性的影响微乎其微[8, 13, 21]。然而,超过这一限度极具挑战性,通常会导致严重的准确性下降。因此,如何有效解决这一问题仍是一个开放性问题。

小型语言模型

小型语言模型为AI领域带来了新的发展契机,并推动了其广泛应用。值得注意的是,自2017年Transformer模型问世以来,尽管它在大型语言模型(LLM)中一直占据主导地位,但模型架构本身并未发生显著变化[38]。目前,扩大数据和模型的规模是实现模型性能提升的主要手段,这也赋予了这些模型“突现能力”[3, 39]。然而,近期关于小型语言模型的研究已展现出其强大的潜力[35]。特别是,如果一个模型能够完全适应单芯片,这将为AI应用带来显著的速度提升和能源节省。

C. 重新思考AI加速器的设计

在同时提升芯片的内存带宽和峰值计算能力方面,我们面临着基本的挑战[32]。然而,通过适当降低峰值计算能力,我们可以实现更好的计算与带宽之间的权衡。事实上,CPU架构已经具备了经过优化的缓存层次结构,这使得CPU在处理带宽受限问题(如大型推荐系统[29])时,其性能往往优于GPU。然而,目前CPU面临的主要挑战是其峰值计算能力(即FLOPS)远低于GPU或TPU等AI加速器。这主要是因为AI加速器主要设计用于追求最大峰值计算能力,这通常需要通过移除缓存层次结构等组件,以腾出空间放置更多的计算逻辑。因此,我们或许可以探索一种介于这两种极端之间的新架构,这种架构最好拥有更为高效的缓存系统,尤其是具有更大容量的DRAM(可能是具备不同带宽的DRAM层次结构)。这将对于缓解分布式内存通信瓶颈非常有帮助[20]。

IV. 结论

近年来,NLP领域中最先进的Transformer模型的训练计算成本正以每两年750倍的速度激增,而模型参数规模的增长速度更是高达每两年410倍。相比之下,硬件的峰值FLOPS增长速度相对较慢,仅为每两年3.0倍,而DRAM和互连带宽的增长速度更是远远落后,分别为每两年1.6倍和1.4倍。换句话说,在过去的20年里,硬件的峰值FLOPS增长了6万倍,而DRAM和互连带宽的增长却分别仅为100倍和30倍。根据这些趋势,内存——特别是芯片内和芯片间的内存传输——将很快成为制约大型AI模型服务能力的主要因素。因此,我们需要重新审视AI模型的训练、部署和设计,以及AI硬件的设计策略,以应对这一日益严重的“内存墙”问题。

REFERENCES

[1] G. Ballard, J. Demmel, O. Holtz, and O. Schwartz, “Minimizing communication in numerical linear algebra,” SIAM Journal on Matrix Analysis and Applications, vol. 32, no. 3, pp. 866–901, 2011.

[2] L. Bottou, F. E. Curtis, and J. Nocedal, “Optimization methods for large-scale machine learning,” SIAM Review, vol. 60, no. 2, pp. 223–311, 2018.

[3] T. Brown, B. Mann, N. Ryder, M. Subbiah, J. D. Kaplan, P. Dhariwal, A. Neelakantan, P. Shyam, G. Sastry, A. Askell et al., “Language models are few-shot learners,” Advances in neural information processing systems, vol. 33, pp. 1877–1901, 2020.

[4] A. Chowdhery, S. Narang, J. Devlin, M. Bosma,G. Mishra, A. Roberts, P. Barham, H. W. Chung, C. Sutton, S. Gehrmann et al., “Palm: Scaling language modeling with pathways,” Journal of Machine Learning Research, vol. 24, no. 240, pp. 1–113, 2023.

[5] H. W. Chung, L. Hou, S. Longpre, B. Zoph, Y. Tay,W. Fedus, Y. Li, X. Wang, M. Dehghani, S. Brahma et al., “Scaling instruction-finetuned language models,” arXiv preprint arXiv:2210.11416, 2022.

[6] T. Dettmers, R. Svirschevski, V. Egiazarian,D. Kuznedelev, E. Frantar, S. Ashkboos, A. Borzunov,T. Hoefler, and D. Alistarh, “Spqr: A sparse-quantized representation for near-lossless llm weight compression,” arXiv preprint arXiv:2306.03078, 2023.

[7] J. Devlin, M.-W. Chang, K. Lee, and K. Toutanova, “BERT: Pre-training of deep bidirectional transformers for language understanding,” in Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), 2019, pp. 4171–4186.

[8] E. Frantar and D. Alistarh, “Sparsegpt: Massive language models can be accurately pruned in one-shot,” 2023.

[9] E. Frantar, S. Ashkboos, T. Hoefler, and D. Alistarh, “OPTQ: Accurate quantization for generative pre-trained transformers,” in The Eleventh International Conference on Learning Representations, 2023.

[10] A. Gholami, S. Kim, Z. Dong, Z. Yao, M. W. Mahoney, and K. Keutzer, “A survey of quantization methods for efficient neural network inference,” in Low-Power Computer Vision. Chapman and Hall/CRC, 2022, pp. 291–326.

[11] B. Ginsburg, S. Nikolaev, A. Kiswani, H. Wu, A. Gholaminejad, S. Kierat, M. Houston, and A. Fit-Florea, “Tensor processing using low precision format,” Dec. 28 2017, uS Patent App. 15/624,577.

[12] J. L. Hennessy and D. A. Patterson, Computer architecture: a quantitative approach. Elsevier, 2011.

[13] T. Hoefler, D. Alistarh, T. Ben-Nun, N. Dryden, and A. Peste, “Sparsity in deep learning: Pruning and growth for efficient inference and training in neural networks,” The Journal of Machine Learning Research, vol. 22, no. 1, pp. 10882–11005, 2021.

[14] J. Hoffmann, S. Borgeaud, A. Mensch, E. Buchatskaya,T. Cai, E. Rutherford, D. de Las Casas, L. A. Hendricks, J. Welbl, A. Clark, T. Hennigan, E. Noland, K. Millican, G. van den Driessche, B. Damoc, A. Guy, S. Osindero, K. Simonyan, E. Elsen, O. Vinyals, J. Rae, and L. Sifre, “An empirical analysis of compute-optimal large language model training,” in Advances in Neural Information Processing Systems, vol. 35, 2022, pp. 30016– 30030.

[15] P. Jain, A. Jain, A. Nrusimha, A. Gholami, P. Abbeel, J. Gonzalez, K. Keutzer, and I. Stoica, “Checkmate: Breaking the memory wall with optimal tensor rematerialization,” Proceedings of Machine Learning and Systems, vol. 2, pp. 497–511, 2020.

[16] A. Q. Jiang, A. Sablayrolles, A. Mensch, C. Bamford,D. S. Chaplot, D. d. l. Casas, F. Bressand, G. Lengyel,G. Lample, L. Saulnier et al., “Mistral 7b,” arXiv preprint arXiv:2310.06825, 2023.

[17] S. Kim, C. Hooper, A. Gholami, Z. Dong, X. Li,S. Shen, M. W. Mahoney, and K. Keutzer, “Squeezellm:Dense-and-sparse quantization,” arXiv preprint arXiv:2306.07629, 2023.

[18] S. Kim, C. Hooper, T. Wattanawong, M. Kang, R. Yan, H. Genc, G. Dinh, Q. Huang, K. Keutzer, M. W. Mahoney, Y. S. Shao, and A. Gholami, “Full stack optimization of transformer inference: a survey,” Workshop on Architecture and System Support for Transformer Models (ASSYST) at ISCA, 2023.

[19] V. A. Korthikanti, J. Casper, S. Lym, L. McAfee, M. Andersch, M. Shoeybi, and B. Catanzaro, “Reducing activation recomputation in large transformer models,” Proceedings of Machine Learning and Systems, vol. 5, 2023.

[20] S. Krishna and R. Krishna, “Accelerating recommender systems via hardware scale-in,” arXiv preprint arXiv:2009.05230, 2020.

[21] W. Kwon, S. Kim, M. W. Mahoney, J. Hassoun,K. Keutzer, and A. Gholami, “A fast post-training pruning framework for transformers,” in Advances in Neural Information Processing Systems, vol. 35. Curran Associates, Inc., 2022, pp. 24101–24116.

[22] Y. LeCun, L. Bottou, Y. Bengio, P. Haffner et al., “Gradient-based learning applied to document recognition,” Proceedings of the IEEE, vol. 86, no. 11, pp. 2278– 2324, 1998.

[23] J. Lin, J. Tang, H. Tang, S. Yang, X. Dang, C. Gan, and S. Han, “Awq: Activation-aware weight quantization for llm compression and acceleration,” 2023.

[24] J. McCalpin, “Stream: Sustainable memory bandwidth in high performance computers,” http://www. cs. virginia. edu/stream/, 2006.

[25] S. A. McKee, “Reflections on the memory wall,” in Proceedings of the 1st Conference on Computing Frontiers, ser. CF ’04. New York, NY, USA: Association for Computing Machinery, 2004, p. 162.

[26] P. Micikevicius, S. Narang, J. Alben, G. Diamos,E. Elsen, D. Garcia, B. Ginsburg, M. Houston, O. Kuchaiev, G. Venkatesh, and H. Wu, “Mixed precision training,” in International Conference on Learning Representations, 2018.

[27] P. Micikevicius, D. Stosic, N. Burgess, M. Cornea,P. Dubey, R. Grisenthwaite, S. Ha, A. Heinecke, P. Judd, J. Kamalu et al., “Fp8 formats for deep learning,” arXiv preprint arXiv:2209.05433, 2022.

[28] G. Moore, “No exponential is forever: but ”forever” can be delayed! [semiconductor industry],” in 2003 IEEE International Solid-State Circuits Conference, 2003. Digest of Technical Papers. ISSCC., 2003, pp. 20–23 vol.1.

[29] M. Naumov, D. Mudigere, H.-J. M. Shi, J. Huang,N. Sundaraman, J. Park, X. Wang, U. Gupta, C.-J. Wu, A. G. Azzolini et al., “Deep learning recommendation model for personalization and recommendation systems,” arXiv preprint arXiv:1906.00091, 2019.

[30] J. Ousterhout, “Why aren’t operating systems getting faster as fast as hardware?” in USENIX Summer Conference, 1990, 1990.

[31] D. Patterson, T. Anderson, N. Cardwell, R. Fromm, K. Keeton, C. Kozyrakis, R. Thomas, and K. Yelick, “A case for intelligent ram,” IEEE micro, vol. 17, no. 2, pp. 34–44, 1997.

[32] D. A. Patterson, “Latency lags bandwith,” Communications of the ACM, vol. 47, no. 10, pp. 71–75, 2004.

[33] A. Radford, J. Wu, R. Child, D. Luan, D. Amodei, and I. Sutskever, “Language models are unsupervised multitask learners,” OpenAI blog, vol. 1, no. 8, p. 9, 2019.

[34] S. Rajbhandari, J. Rasley, O. Ruwase, and Y. He, “Zero: Memory optimizations toward training trillion parameter models,” in SC20: International Conference for High Performance Computing, Networking, Storage and Analysis. IEEE, 2020, pp. 1–16.

[35] T. Schick and H. Schutze, “It’s not just size that matters:¨ Small language models are also few-shot learners,” arXiv preprint arXiv:2009.07118, 2020.

[36] D. Sites, “It’s the memory, stupid!” Microprocessor Report, pp. 18–24, 1996.

[37] H. Touvron, L. Martin, K. Stone, P. Albert, A. Almahairi, Y. Babaei, N. Bashlykov, S. Batra, P. Bhargava, S. Bhosale et al., “Llama 2: Open foundation and fine-tuned chat models,” arXiv preprint arXiv:2307.09288, 2023.

[38] A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit,L. Jones, A. N. Gomez, Ł. Kaiser, and I. Polosukhin, “Attention is all you need,” in Advances in neural information processing systems, 2017, pp. 5998–6008.

[39] J. Wei, Y. Tay, R. Bommasani, C. Raffel, B. Zoph, S. Borgeaud, D. Yogatama, M. Bosma, D. Zhou, D. Metzler et al., “Emergent abilities of large language models,” arXiv preprint arXiv:2206.07682, 2022.

[40] M. V. Wilkes, “The memory wall and the cmos endpoint,” ACM SIGARCH Computer Architecture News, vol. 23, no. 4, pp. 4–6, 1995.

[41] S. Williams, A. Waterman, and D. Patterson, “Roofline: an insightful visual performance model for multicore architectures,” Communications of the ACM, vol. 52, no. 4, pp. 65–76, 2009.

[42] W. A. Wulf and S. A. McKee, “Hitting the memory wall: Implications of the obvious,” ACM SIGARCH computer architecture news, vol. 23, no. 1, pp. 20–24, 1995.

[43] Z. Yao, A. Gholami, S. Shen, M. Mustafa, K. Keutzer, and M. Mahoney, “Adahessian: An adaptive second order optimizer for machine learning,” in proceedings of the AAAI conference on artificial intelligence, vol. 35, no. 12, 2021, pp. 10665–10673.

[44] Z. Yao, R. Yazdani Aminabadi, M. Zhang, X. Wu, C. Li, and Y. He, “Zeroquant: Efficient and affordable post-training quantization for large-scale transformers,” in Advances in Neural Information Processing Systems, S. Koyejo, S. Mohamed, A. Agarwal, D. Belgrave, K. Cho, and A. Oh, Eds., vol. 35. Curran Associates, Inc., 2022, pp. 27168–27183.

--【本文完】---

近期受欢迎的文章:

更多交流,可添加本人微信

(请附姓名/单位/关注领域)