点击上方蓝字”运维笔谈”,对话回复 “阿里云k8s” 可以获取《阿里云Kubernetes项目实战手册》PDF

今天有一批次的CDN缓存需要刷新下,但是七牛云那边qshell一次只能刷新1000条,我需要把文件里的url按1000行逐个分成几个小文件来处理下。

今天有一批次的CDN缓存需要刷新下,但是七牛云那边qshell一次只能刷新1000条,我需要把文件里的url按1000行逐个分成几个小文件来处理下。

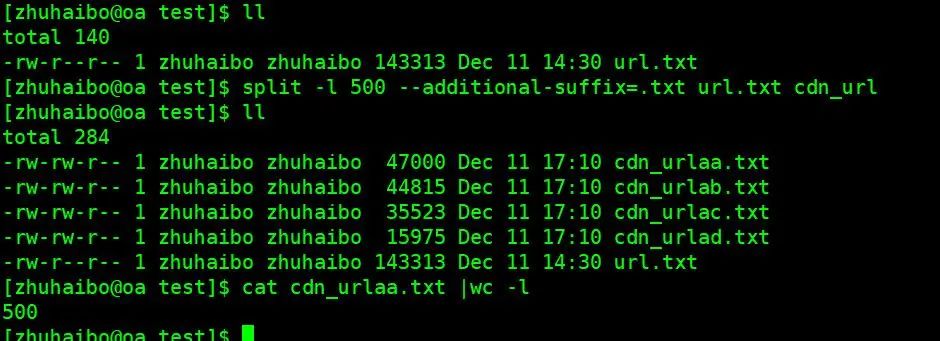

我们在Linux下进行切割文件比较常用的一个命令是 split 。假设我现在需要切割的文件名是url.txt,我们可以:

split-l 1000url.txturl_output_

这个命令会将 url.txt 文件按每1000行分割成多个文件,并且生成的文件名将以 url_output_ 开头,后跟字母或数字(例如 url_output_aa, url_output_ab, url_output_ac 等)。

我们也可以使用 --additional-suffix 选项来添加自定义的后缀。例如,生成的文件名以 cdn_url 结尾并带有编号:

split -l1000 --additional-suffix=.txt url.txt cdn_url

这样生成的文件名将会是 cdn_urlaa.txt, cdn_urlab.txt, cdn_urlac.txt 等。

文章转载自运维笔谈,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。