本期将分享近期全球知识图谱相关

行业动态、会议资讯、论文推荐

反欺诈+知识图谱

Bureau 的技术由 Graph Neural Networks 提供支持,可应对一系列挑战,从洗钱账户和深度伪造身份到账户接管和支付欺诈。与传统的基于规则的系统不同,该平台结合了设备智能、行为 AI 和预测模型,可提供实时、情境化的欺诈预防。该平台的专有身份知识图谱现已包含超过 5 亿个身份和行为模式,可为企业提供整个客户生命周期的实时洞察。

https://t.hk.uy/bMX2

GraphRAG-SDK

一个面向图数据检索增强生成(RAG)的开发工具包,提供自动化知识图谱构建和管理功能,支持OpenAI等LLM模型集成,具备本体管理、知识图谱构建、多智能体协作等特性,可用于高级数据查询和知识图谱应用开发。

详情请访问:https://github.com/FalkorDB/GraphRAG-SDK

Graph Learning是一个利用“图”(Graph)信息来进行机器学习的领域。这个领域在过去的20-25年里,经历过多次的重大革新。1998年,Google的创始人Larry Page和 Sergey Brin 发表的PageRank算法和Jon Kleinberg提出HITS algorithm,搜索引擎算法早期的辉煌就来自于对于图算法的突破。2000年代到2010年左右,图算法又有了很多新的革新,比如把Graph Laplacian的思路、比如把Modularity的思路引进到图算法,都为图算法的第二次腾飞打下了基础。目前基于Neural Networks的图学习可以算是图学习的第三次高速发展。

在ICML 2024上Adrián Arnaiz-Rodríguez和AmeyaVelingker做了一个叫“Graph Learning: Principles, Challenges, and Open Directions”的讲座。整个讲座可以说是把Graph Learning的重要前世今生,包括很多第一次和第二次浪潮中的重要概念,比如Random Walk、Spectral Graph Theory等都有比较深入浅出的讨论。同时,这个讲座对于GNN,以及最新的很多图学习的发展也是有很深入的探讨,对于图学习有兴趣的读者, 建议精读这个讲座内容。

本周推荐的是arxiv 2020上的论文:Linformer:Self-Attention with Linear Complexity,该文提出了一种新的自注意机制,将自注意复杂度从O(n2)降低到O(n),在记忆和时间效率上与标准Transformer模型持平。作者来自Facebook AI。

大型Transformer模型在许多自然语言处理应用中取得了非凡的成功。然而,对于长序列,训练和部署这些模型可能成本过高,因为Transformer的标准自注意力机制随着序列长度使用O(n^2)的时间和空间。作者展示了自注意力机制可以通过低秩矩阵来近似。作者进一步利用这一发现提出了一种新的自注意力机制,将自注意力的总体复杂度从O(n^2)降低到O(n),在时间和空间上都更加高效。这个线性Transformer,即Linformer,在性能上与标准Transformer模型相当,同时更加节约内存和时间。

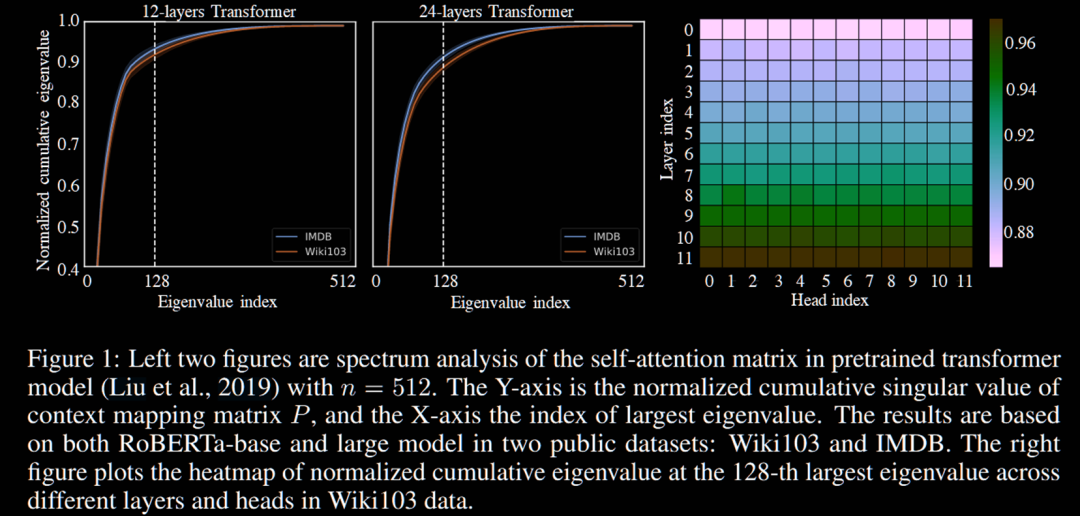

文章发现注意力矩阵是低秩的:

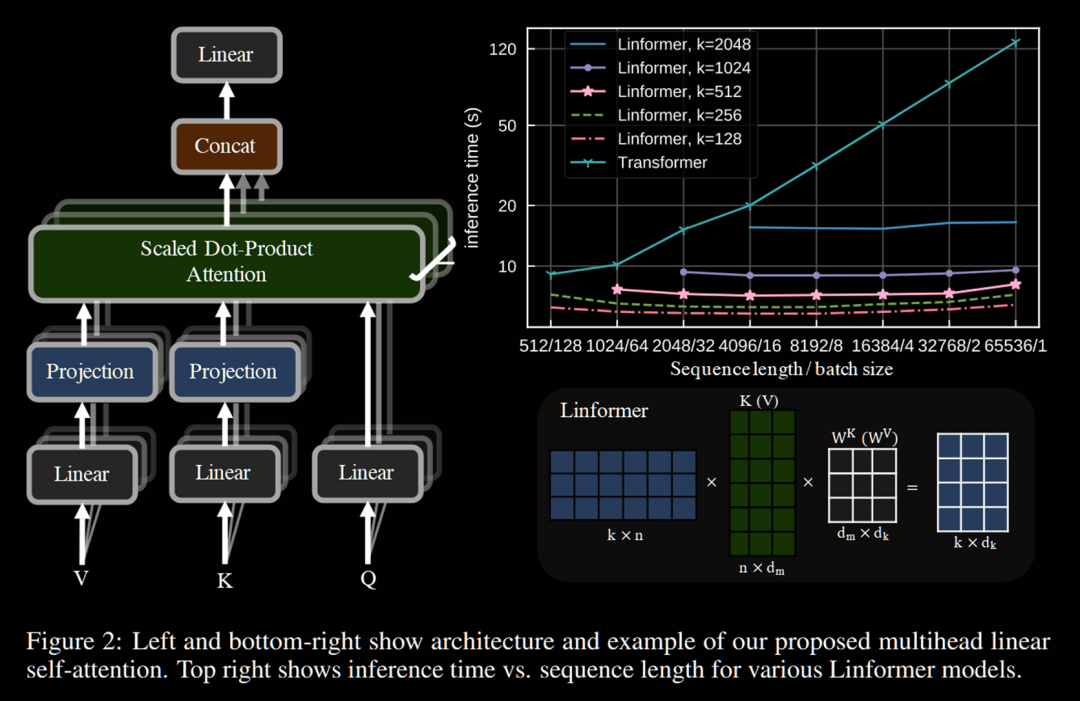

文章提出的注意力机制如下图所示:

更多链接

内容:袁知秋、程湘婷、王图图

诚邀您加入我们的gStore社区,我们将在群内解决使用问题,分享最新成果~

请在微信公众号图谱学苑发送“社区”入群~

微信社区群:请回复“社区”获取