今天给大家分享一篇论文。

题目是:HybGRAG:基于文本和关系型知识库的混合检索增强生成

论文链接:https://arxiv.org/abs/2412.16311

01

论文概述

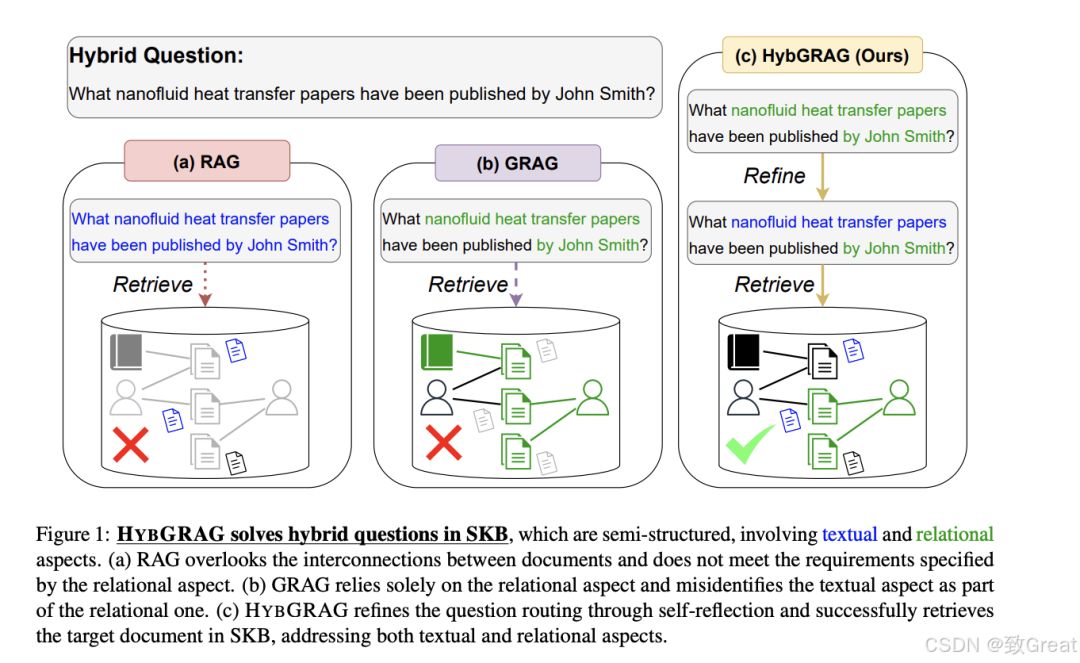

混合源问题(Hybrid-Sourcing Question):有些问题需要同时利用文本和关系信息来解答,而现有的方法往往只专注于检索单一类型的信息(要么只检索文本信息,要么只检索关系信息)。 需要细化的问题(Refinement-Required Question):在混合问题中,大型语言模型(Large Language Models, LLMs)在首次尝试时很难区分问题的文本和关系方面,需要进一步细化。

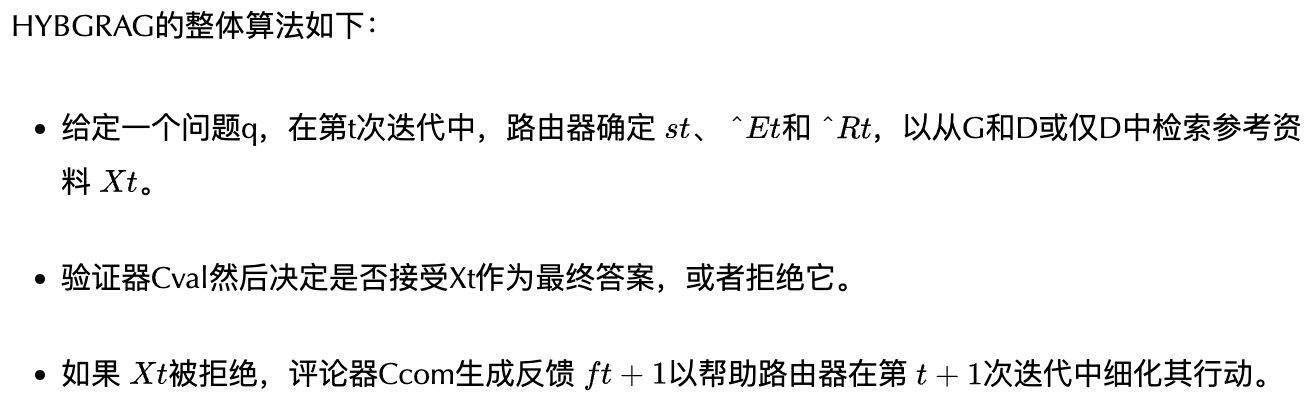

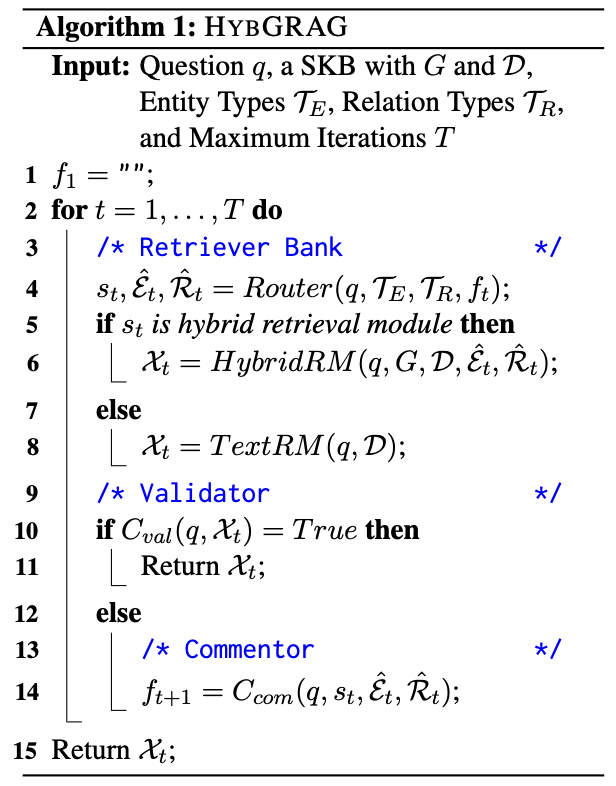

为了解决这些挑战,论文提出了HYBGRAG(Hybrid Retrieval-Augmented Generation)方法,该方法包括一个检索器库(retriever bank)和判断器模块(critic module),旨在通过自反思(self-reflection)和细化问题路由(question routing)来提高混合问题回答的性能。

02

相关工作

根据提供的论文内容,相关研究可以分为以下几个方向:

QA-GNN:利用LLMs和知识图谱进行问答的系统。

Think-on-Graph:使LLMs能够在知识图谱上进行深入和负责任的推理。

AVATAR:通过对比推理优化LLM代理的工具辅助知识检索。

03

核心内容

文本检索模块:使用向量相似性搜索(VSS)基于给定问题从文档集合D中检索文档。 混合检索模块:基于识别出的主题实体和有用关系,使用图检索器从知识图谱G中提取实体,并与文档关联。

验证器(Validator):验证器的任务是确认检索到的顶部参考资料是否满足问题的要求。为此,它使用主题实体和提取的 ego-graph 之间的推理路径作为验证上下文。 评论器(Commentor):当检索结果不正确时,评论器提供反馈以帮助路由器细化其行动。反馈是基于预先收集的成功案例,通过上下文学习(ICL)提供。

04

论文实验

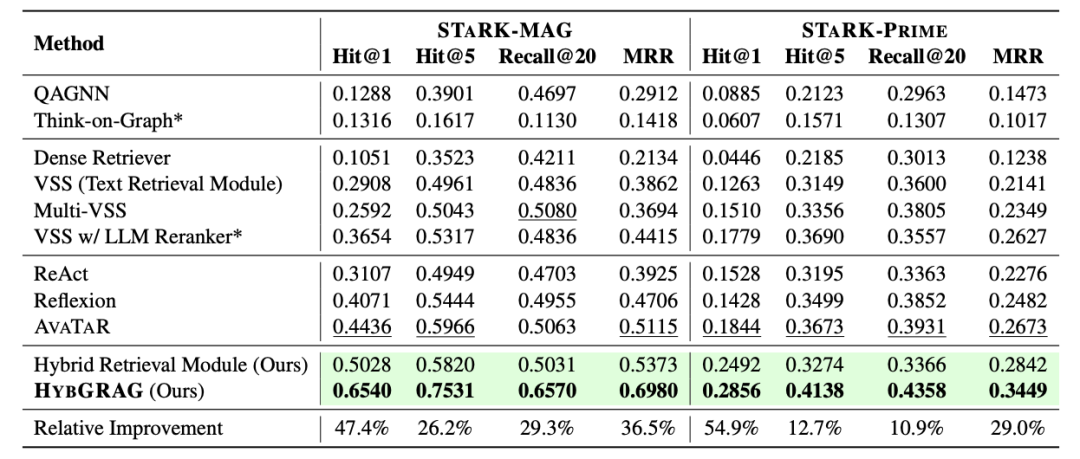

1. 实验在GRAG基准测试上(RQ1:有效性)

STARK基准测试:使用STARK基准测试中的两个数据集(STARK-MAG和STARK-PRIME)来评估HYBGRAG模型。这个基准测试专注于检索任务,并提供了默认的评估指标,包括Hit@1、Hit@5、Recall@20和平均倒数排名(MRR)。 比较基线方法:HYBGRAG与多种基线方法进行比较,包括最近的GRAG方法(如QAGNN和Think-on-Graph)、传统的RAG方法和自反思的大型语言模型(如ReAct、Reflexion和AVATAR)。

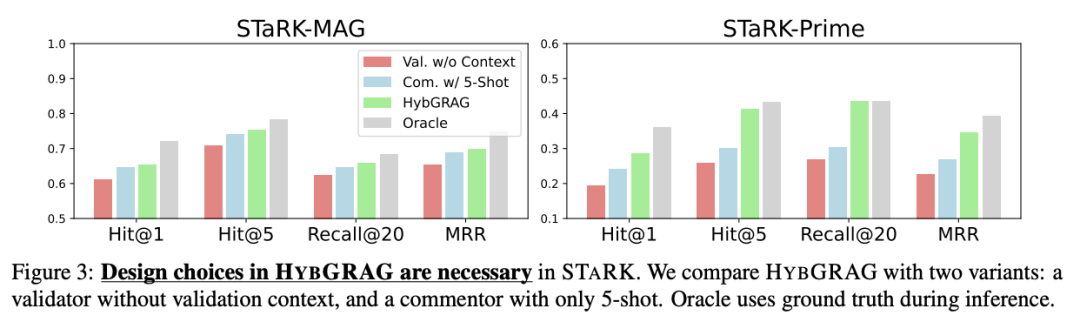

2. 消融研究(RQ2:设计选择的必要性)

评论器模块:比较了HYBGRAG的不同变体,包括没有验证上下文的验证器、只有5-shot的评论器,以及使用oracle(拥有地面真实情况的访问权限)的变体。 自我反思:展示了通过增加自我反思迭代次数,HYBGRAG的性能如何进一步提升。

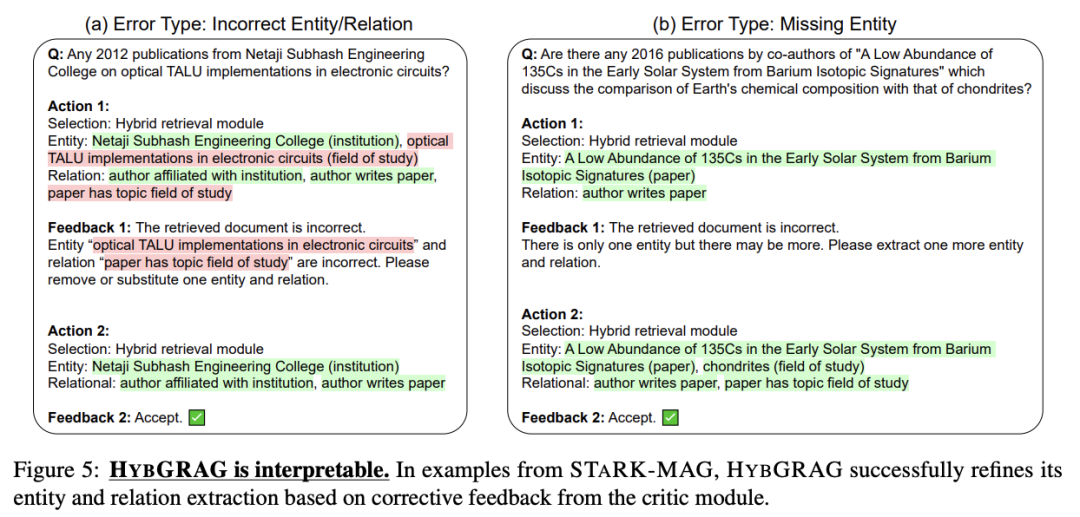

3. 解释性(RQ3:基于反馈的问题路由细化)

STARK中的解释性:通过STARK-MAG和STARK-PRIME中的例子,展示了HYBGRAG如何根据评论家模块的校正反馈细化其实体和关系提取。

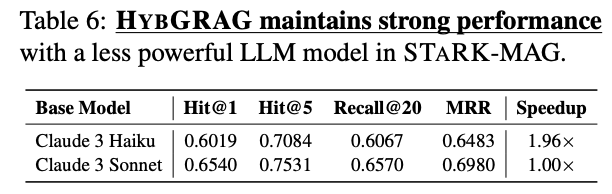

模型大小的影响:测试了HYBGRAG在不同大小的LLM模型上的表现,包括更经济但功能较弱的Claude 3 Haiku模型。

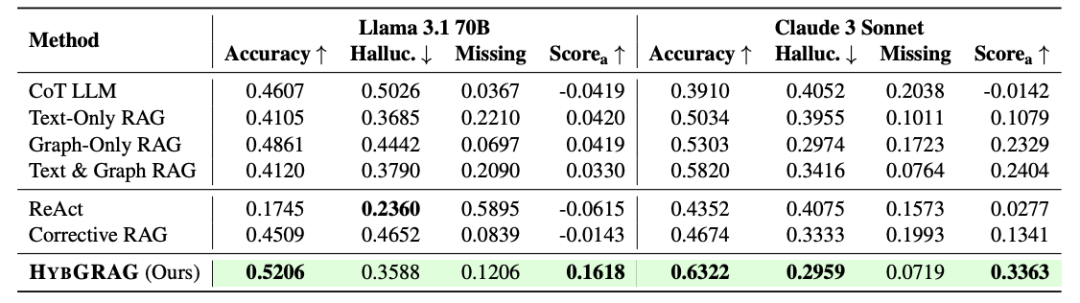

4. 端到端RAG评估在CRAG上

CRAG基准测试:在CRAG基准测试上适应HYBGRAG,并使用默认评估指标进行评估,其中LLM评估器用于确定预测答案的准确性、错误(幻觉)或缺失。

比较基线方法:HYBGRAG与CoT LLM、仅文本RAG、仅图RAG以及连接文本和图参考的RAG进行比较。

5. 模型成本分析

API调用和令牌消耗:报告了HYBGRAG在STARK和CRAG中每个步骤的API调用和令牌消耗情况,以评估模型的成本效益。

这些实验旨在全面评估HYBGRAG模型在混合问题回答任务上的有效性、设计选择的必要性、解释性以及成本效益,并与现有的基线方法进行比较。通过这些实验,论文展示了HYBGRAG在处理半结构化知识库上的混合问题时的优势。

05

编者简介