论文链接: https://arxiv.org/pdf/2410.23875

代码链接: https://github.com/liyichen-cly/PoG

摘要

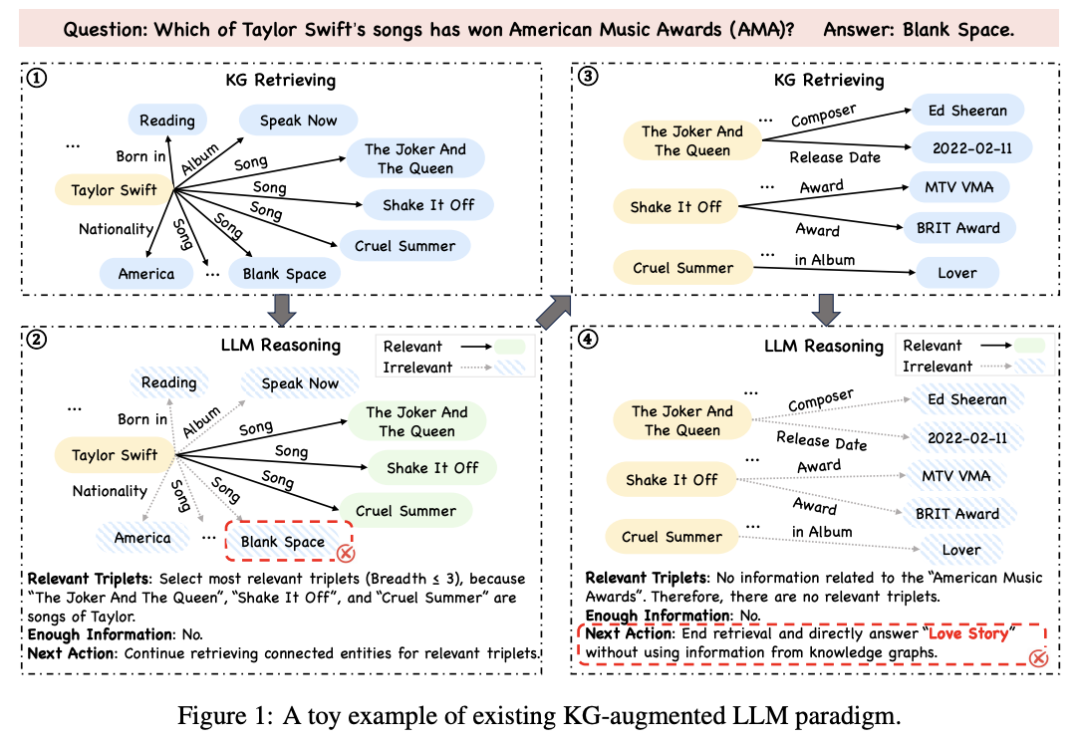

主要内容

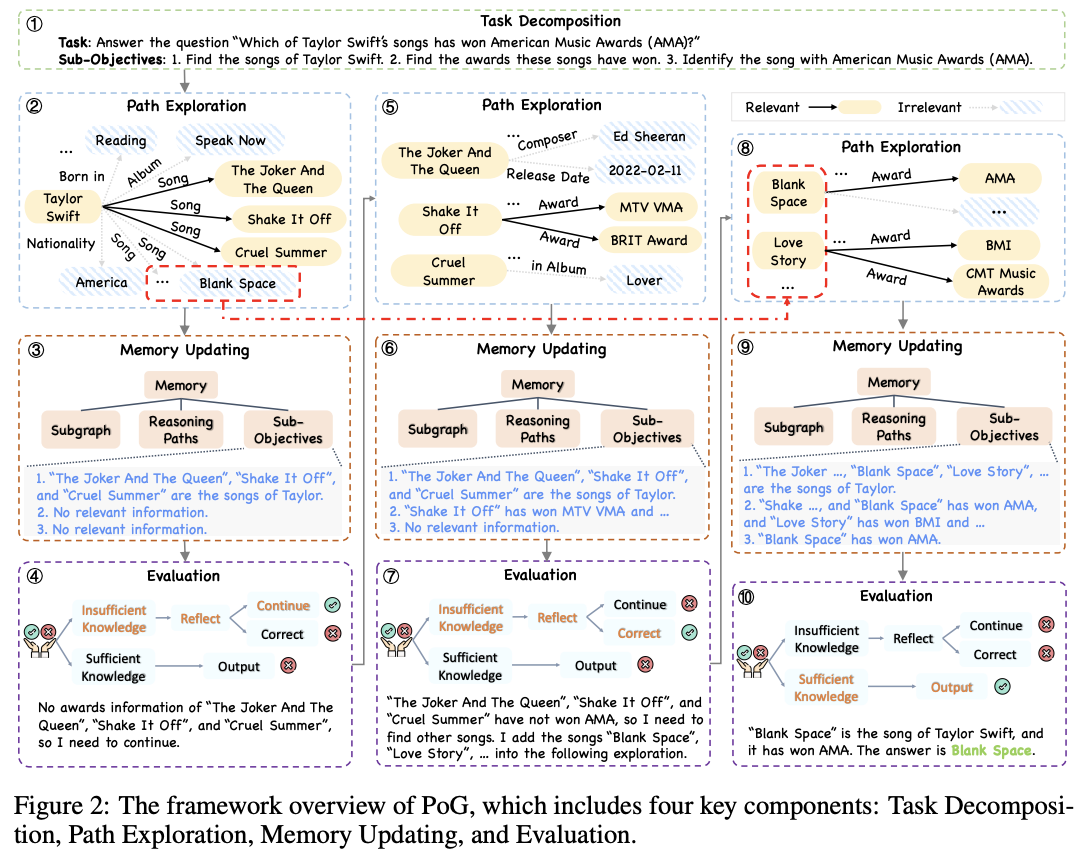

1. 任务分解

PoG 首先将问题分解为多个包含条件的子目标,以便更好地指导自适应探索过程。这些子目标可以作为路径探索的指导,帮助识别与问题中每个条件相关的相关路径,并具有灵活的探索范围。2. 路径探索

PoG 通过在 KG 中探索推理路径来获取相关信息。路径探索分为两个阶段: 关系探索: 从当前实体的邻居关系中检索所有关系,并识别与问题 q 和子目标 o 最相关的推理路径。 实体探索: 使用选定的关系探索邻居实体,并检测与问题 q 最相关的实体。 每次迭代后,PoG 会更新推理路径,并将其添加到内存中,以便 LLM 可以理解实体之间的关系并允许在反思阶段进行路径修正。3. 记忆更新

PoG 将检索到的子图、推理路径和子目标状态存储在Memory中,以提供历史检索和推理信息,供反思阶段使用。 子图包含从 KG 中检索到的所有关系和实体,可以帮助 LLM 在反思阶段确定回溯到哪个实体以进行自我修正。 推理路径的更新确保 LLM 可以理解实体之间的关系,并允许在反思阶段进行路径修正。 子目标状态包含每个子目标当前已知的信息,可以帮助 LLM 记住每个条件已知的信息,并在反思阶段确定是否需要修正探索方向。4. 评估

PoG 使用 LLM 来评估当前获取的信息(包括内存中记录的子目标状态和推理路径)是否足以推断出答案。 如果 LLM 认为信息不足,PoG 会进入反思阶段,以确定是否需要修正当前的探索方向。5. 反思

PoG 使用 LLM 来反思是否需要修正当前的探索方向,并决定是否需要将其他实体纳入新的探索中,以及回溯到哪个实体以进行自我修正。 反思机制基于内存中的信息进行推理,以确定是否需要修正推理路径,并指导 LLM 进行自我修正。6. 自我修正

如果 LLM 认为当前路径是错误的,PoG 会进行自我修正,回溯到之前的实体,并根据反思结果探索新的路径。7. 迭代

PoG 会重复步骤 2-6,直到找到答案或达到最大迭代次数。

实验

数据集

CWQ: 包含 404 个复杂推理问题的大规模数据集。 WebQSP: 包含 1,743 个小型 KGQA 问题。 GrailQA: 包含 2,000 个问题的大型 KGQA 数据集。

实验设置

LLMs: 使用 GPT-3.5 和 GPT-4 作为基础模型。 评价指标: 使用精确匹配准确率(Hits@1)。

对比方法

LLM-only 方法: 标准提示词 思维链提示词(CoT) 自一致性方法(SC) KG-augmented LLM 方法: 微调方法 提示词方法

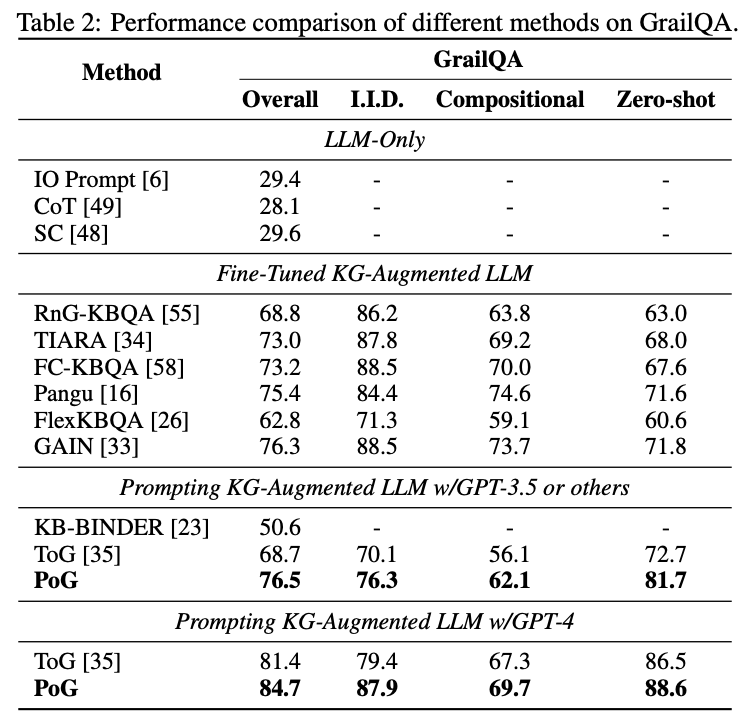

实验结果

PoG 在所有数据集上均取得最佳性能:准确率高于 KG-augmented LLM 方法 和 LLM-only 方法。能处理更复杂的推理任务。 消融实验: 证明 PoG 的引导、记忆和反思机制对性能提升均有重要贡献。

效率分析

PoG 的运行速度比 ToG 提升 4 倍以上,得益于自适应探索与自我纠正机制。

编者简介

李剑楠:华东师范大学硕士研究生,研究方向为向量检索。曾作为核心研发工程师参与向量数据库、RAG 等产品研发,代表公司参加 DTCC、WAIM 等会议进行主题分享。

文章转载自AI 搜索引擎,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。