春节前, Deepseek 在各大自媒体平台爆火,对于大A的子民来说,deepseek 的前身也不是什么新鲜玩意, 臭名昭著的量化工具(幻方量化出品)

简单的的说就是用AI机器学习的算法模型来收割人世间各种贪念的韭菜们。

Deepseek 团队汇聚了 国内顶尖院校的顶尖人才,清华大学为班底的研发团队.而且大部分都是竞赛特招生。

说明只有在私募这种大资本的加持下,才能众筹到国内最优秀的人在一起做事情。

既然deepseek就这么火了,我们就顺势而为,看看deepseek 蒸馏大模型的本地部署。

为什么要选择蒸馏之后的大模型?

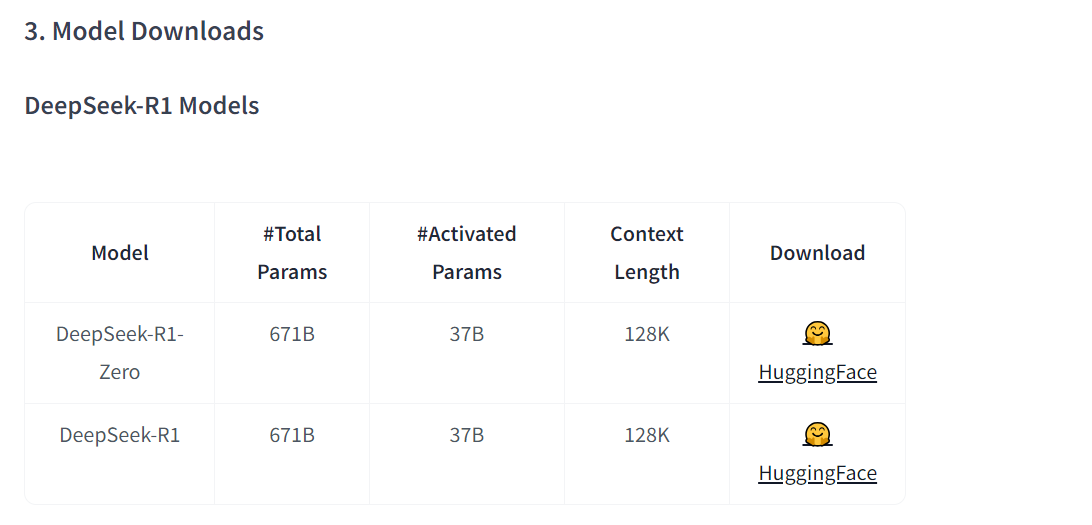

原始的deepseek R1 版本的模型参数是 671B的, 模型的大小在 600GB+ 以上,显卡要求还是比较高的 ,比较适合企业用户的而非个人。

https://huggingface.co/deepseek-ai/DeepSeek-R1

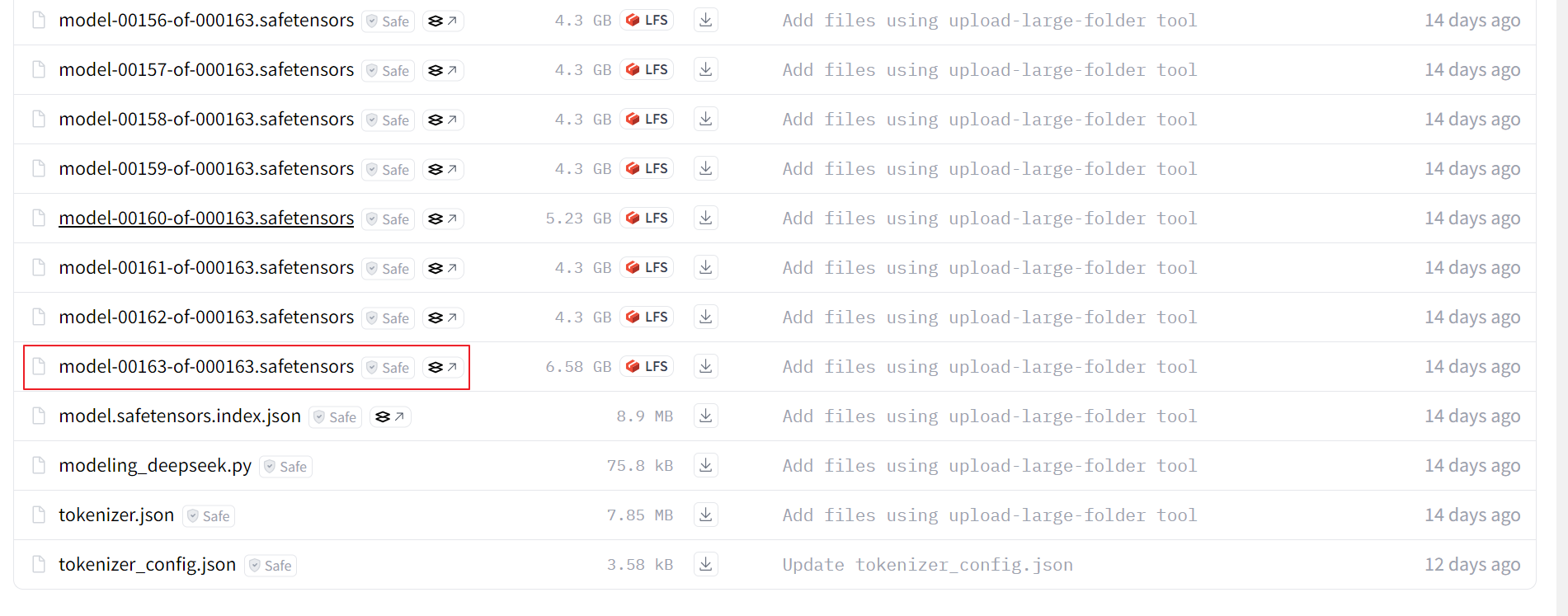

R1版的大模型文件一共163个,每个文件4+G

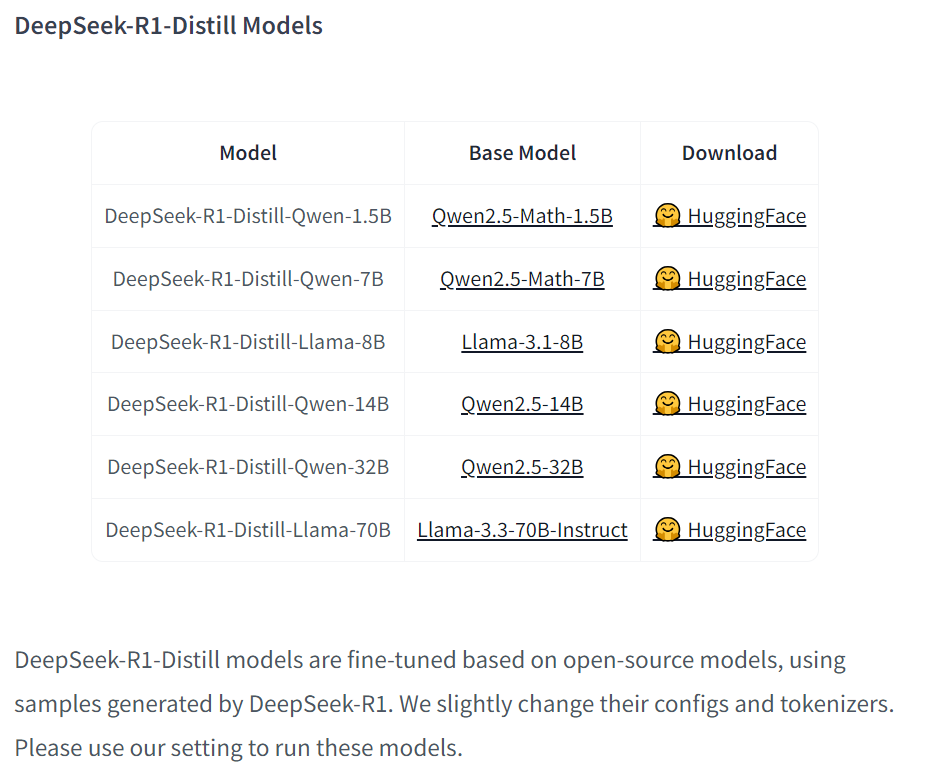

我们再看看蒸馏的模型: 简单地说就是在开源大模型上进行了微调,进行了算法优化。

DeepSeek-R1-Distill models are fine-tuned based on open-source models, using samples generated by DeepSeek-R1. We slightly change their configs and tokenizers. Please use our setting to run these models.

我们测试一下同城科技公司阿里巴巴的千问32B的大模型: https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-32B

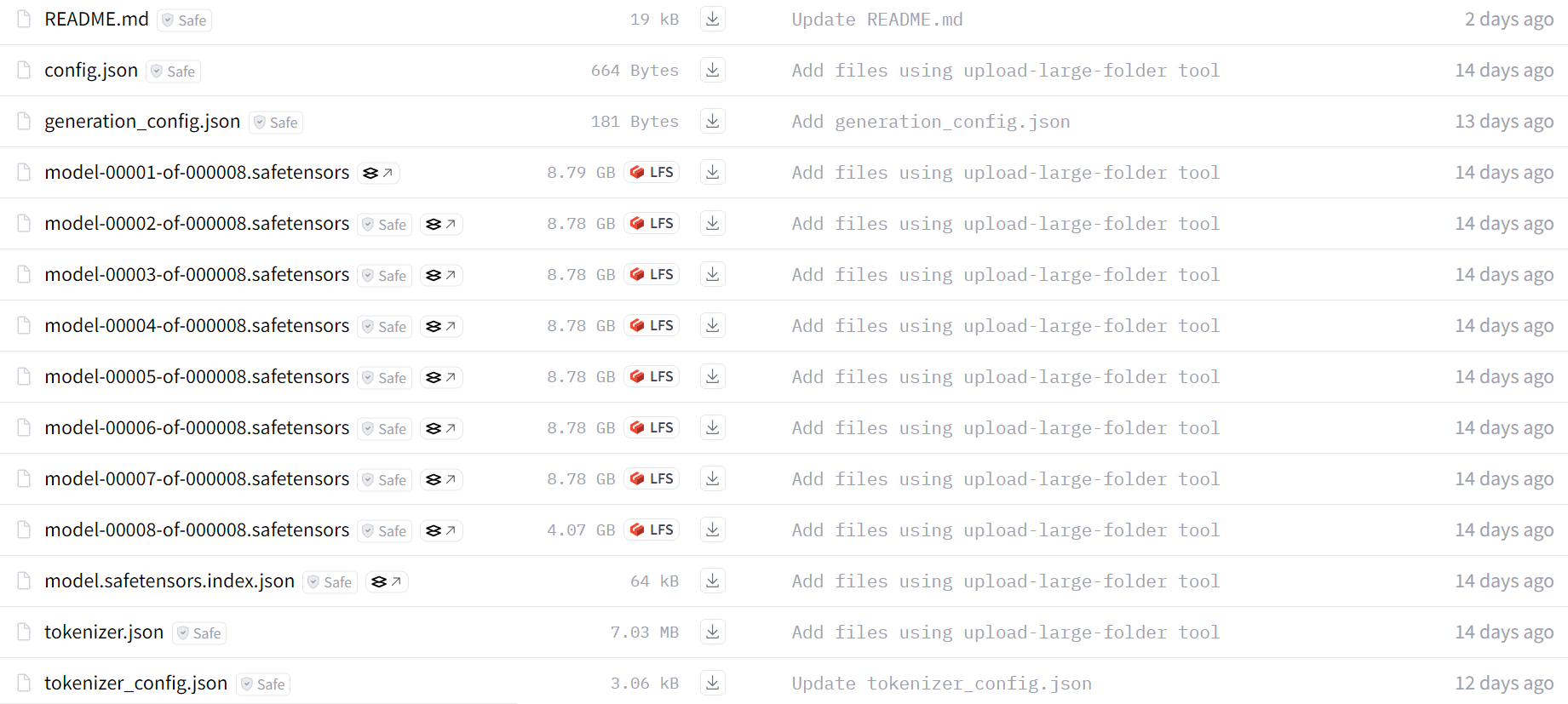

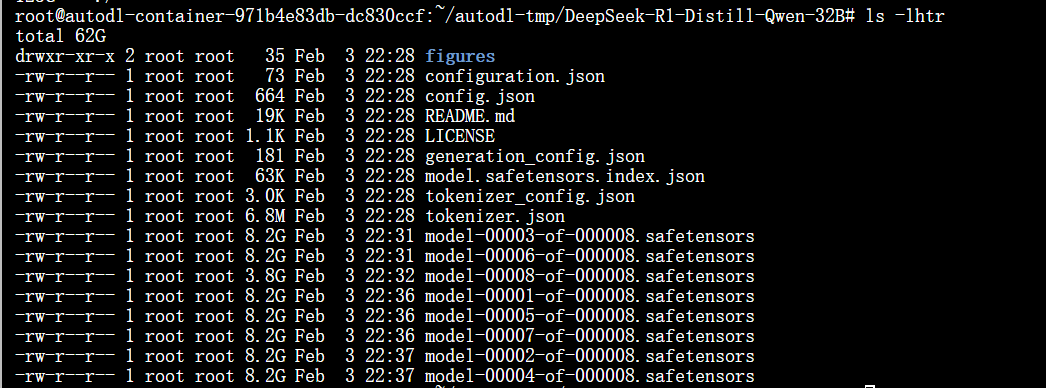

此模型一共8个模型文件占用70GB+以上的空间:

本人个人电脑是没有显卡的,肯定是跑不来32b参数大模型的, 我们租一台算力云服务来帮我们实现实验目的:

我们选择4090的显卡:( 对于32B的参数模型至少4张以上才可以勉强跑起来)

我们下载大模型文件:

root@autodl-container-971b4e83db-dc830ccf:~# source /etc/network_turbo

设置成功

注意:仅限于学术用途,不承诺稳定性保证

安装git-lfs

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash

apt install git-lfs

下载大模型文件:

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# echo "git clone https://www.modelscope.cn/deepseek-ai/DeepSeek-R1-Distill-Qwen-32B.git" >downloadLLM.sh

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# nohup sh downloadLLM.sh > log.txt &

基于阿里巴巴通义千问32B的模型下载完成:大小62GB

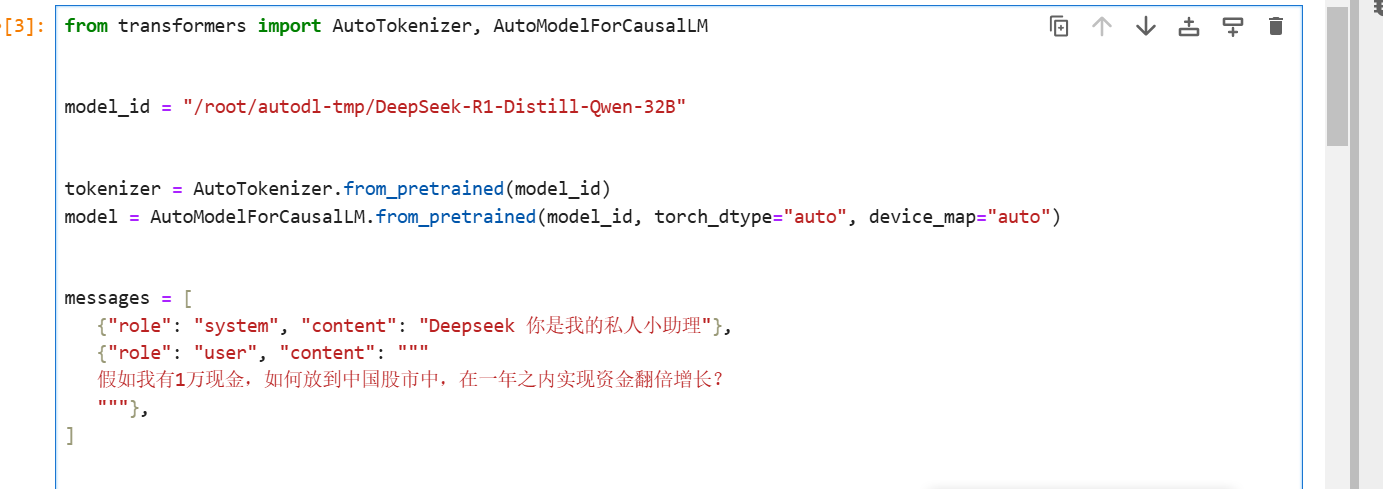

我们写一个python 程序测试一下本地大模型:

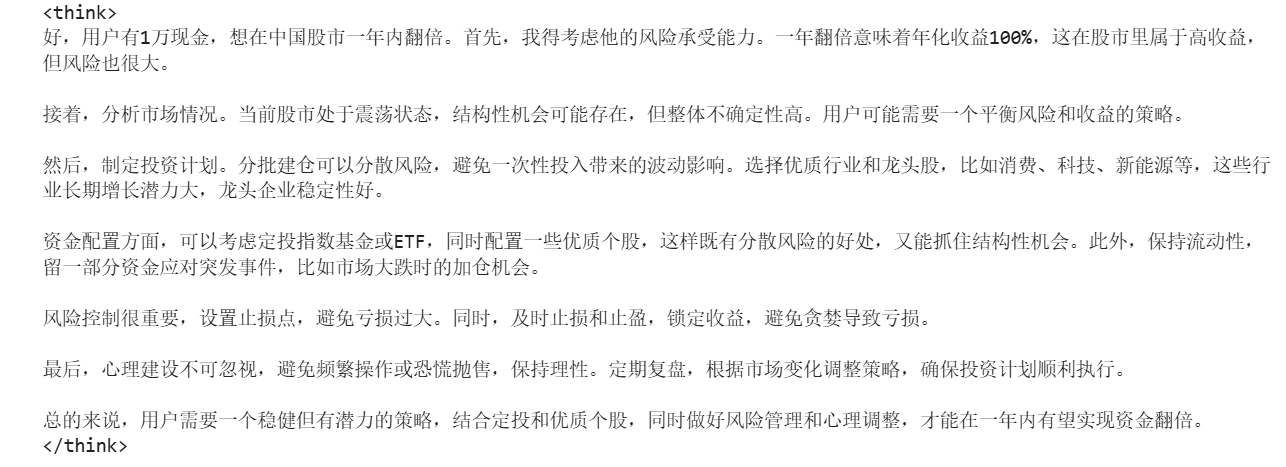

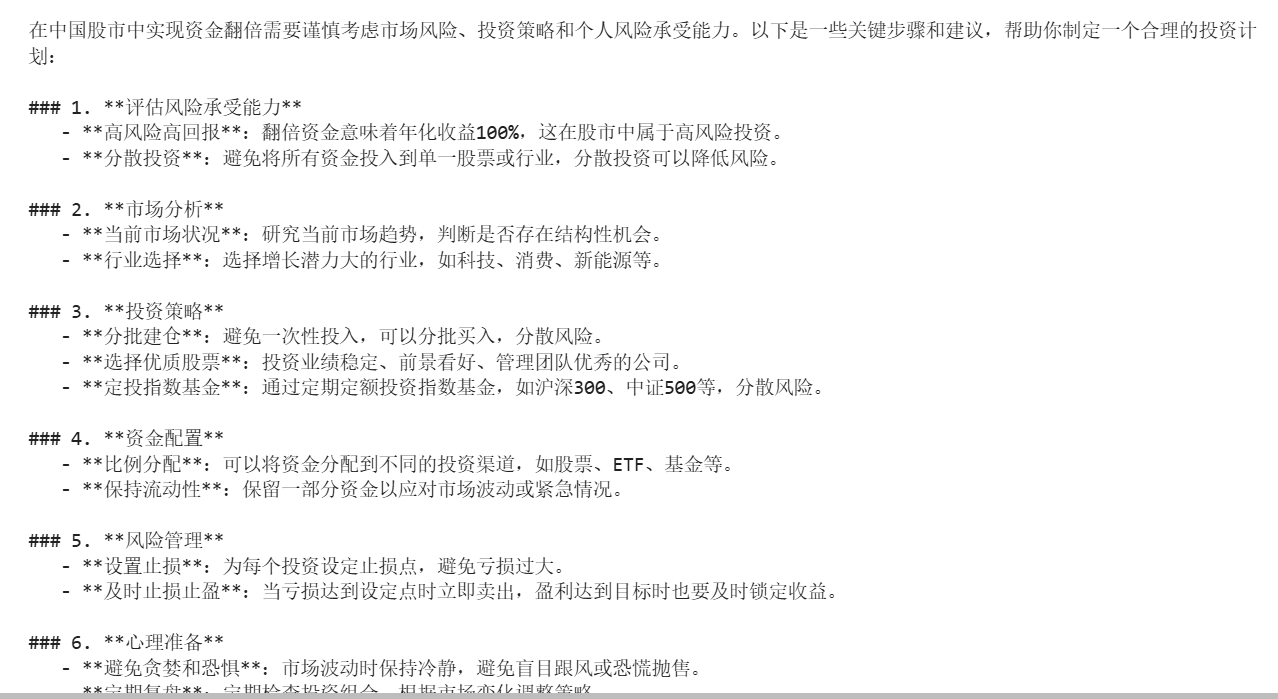

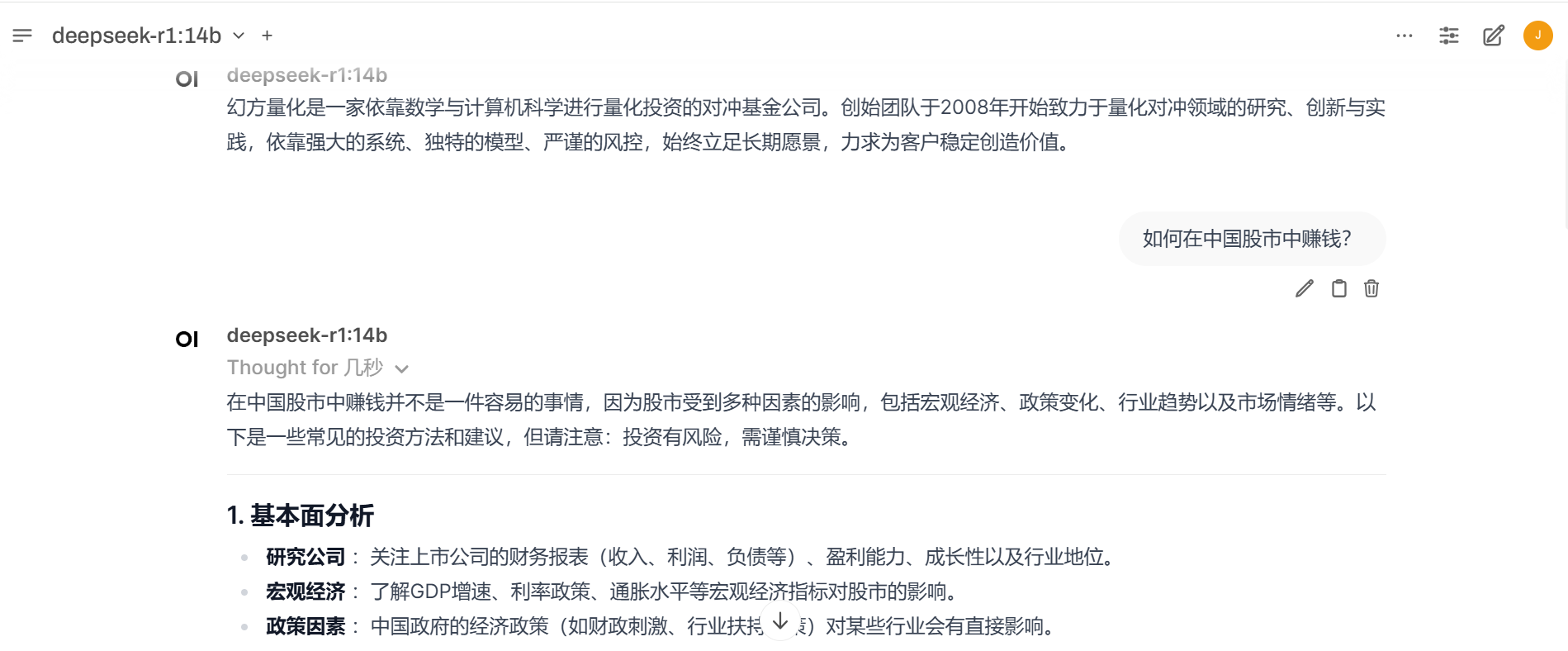

答案来说确实有惊喜:

最后居然还给我还制定了一个投资计划:专业度相关高!不愧是幻方量化出品!

可能有的同学不想写代码,想部署一般本地网页版的deepseek.

我们可以使用ollama + open web UI 的方式接入本地下载好的大模型:

ollama 简单地说有个大模型的下载以及部署安装的集成工具: https://github.com/ollama/ollama

在线安装 ollama:

curl -fsSL https://ollama.com/install.sh | sh

离线安装:如果科学上网受限, 也可以选择本地下载,手动安装:

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# curl -L https://ollama.com/download/ollama-linux-amd64.tgz -o ollama-linux-amd64.tgz

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

0 0 0 0 0 0 0 0 --:--:-- --:--:-- --:--:-- 0

0 0 0 0 0 0 0 0 --:--:-- 0:00:01 --:--:-- 0

0 0 0 0 0 0 0 0 --:--:-- 0:00:01 --:--:-- 0

100 1604M 100 1604M 0 0 4418k 0 0:06:11 0:06:11 --:--:-- 10.2M

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# tar -C /usr -xzf ollama-linux-amd64.tgz

启动 ollama :

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# mkdir ollama

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# export OLLAMA_MODELS="/root/autodl-tmp/ollama"

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# ollama serve

ollama 部署本地定制化大模型:

创建Modelfile文件:

FROM /root/autodl-tmp/DeepSeek-R1-Distill-Qwen-14B

生成OLLAMA的模型基于modelfile:

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# export OLLAMA_MODELS="/root/autodl-tmp/ollama"

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# ollama create DeepSeek-R1-Distill-Qwen-14B -f Modelfile

gathering model components

copying file sha256:72cbec1015da9ed03ad025483005cbf6481403abf947adfd54e504d1a66a2126 100%

copying file sha256:037d31b84cae7ea1be3b5657a82fc2cbda9f23362220ebda1b045fa694b43122 100%

copying file sha256:8c726f2ebf532f1d60437b17dd8da4f380adba3608e59e8448b3fb30c9115068 100%

copying file sha256:9a080ebff55b277c0e106f19e4496a88b9f5db4059ea0a6b8ea7d9bb3ad4d0ca 100%

copying file sha256:b8bc983706e8db5b270c319be58762f53c6222e0c6cd785c6fd8fd33c2e783e8 100%

copying file sha256:fdb89460be9a6383451437cdf632a3e087522efa682265461f33507e7069f026 100%

copying file sha256:88145e3c3249adc2546ede277e9819d6e405e19072456e4b521cbc724bd60773 100%

copying file sha256:557341a00d5c2a75c24e03961d0e716571517d39c70a040633180d9edcbfe285 100%

copying file sha256:6ba8a9c8251b8f6c6beef7325102665f22b17c1f52ef76eaaa938bfeab1bd18c 100%

copying file sha256:f888421726665e8a84b738eed42a64875aed79de8be7daade851ac8bf4c0cef9 100%

converting model

你也可以直接通过OLLAMA下载大模型:

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# export OLLAMA_MODELS="/root/autodl-tmp/ollama"

root@autodl-container-971b4e83db-dc830ccf:~/autodl-tmp# ollama run deepseek-r1:14b

pulling manifest

pulling 6e9f90f02bb3... 100% ▕█████████████████████████████████████████████████████████████████████████▏ 9.0 GB

pulling 369ca498f347... 100% ▕█████████████████████████████████████████████████████████████████████████▏ 387 B

pulling 6e4c38e1172f... 100% ▕█████████████████████████████████████████████████████████████████████████▏ 1.1 KB

pulling f4d24e9138dd... 100% ▕█████████████████████████████████████████████████████████████████████████▏ 148 B

pulling 3c24b0c80794... 100% ▕█████████████████████████████████████████████████████████████████████████▏ 488 B

verifying sha256 digest

writing manifest

success

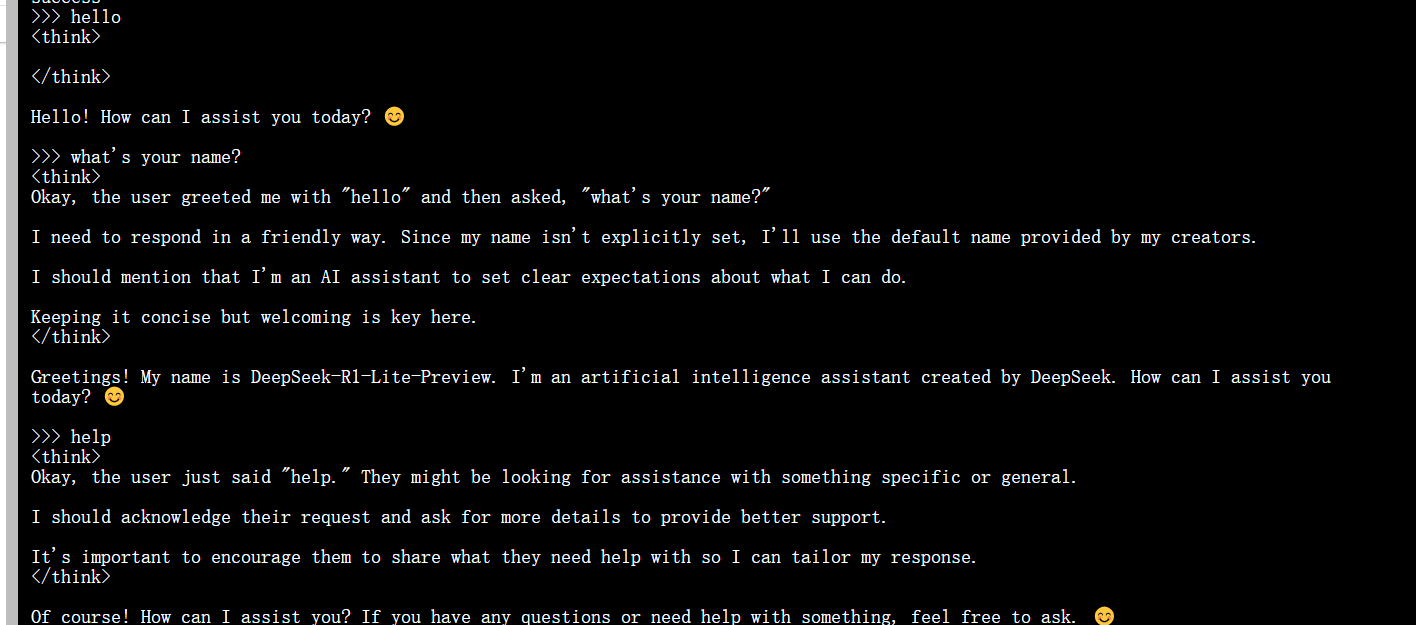

下载完成后,便可以开启对话:

下一步,我们安装open-webui 界面:

pip install open-webui

启动 open-webui:

open-webui serve

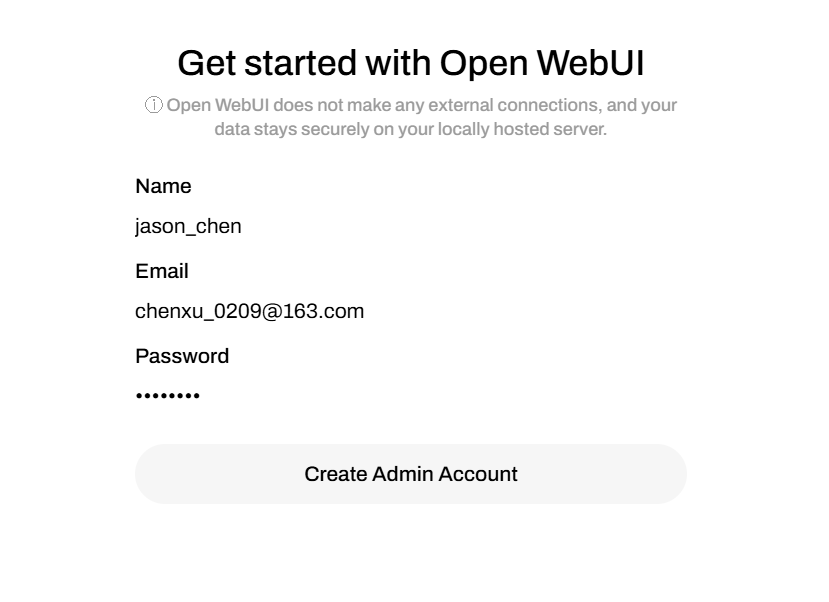

浏览器访问: your ip address:8080

首次访问需要注册管理员账户:

注册登录后,你就可以开始提问了:

Have a fun 🙂 !