如果你长期投身在 AI 领域,或者是本公众号的长期读者,对于「AI 智能体」概念,可能你并不陌生。

2025 年伊始,谷歌团队最新发布《AI 智能体白皮书》,给出了他们自己的定义:将推理、逻辑和访问外部信息的结合,并与生成式 AI 模型相联系,就是所谓的「AI 智能体」。

在这份白皮书当中,作者 Julia Wiesinger、Patrick Marlow 和 Vladimir Vuskovic 详细阐述了 AI 智能体的原理与应用。他们更是表示,AI 智能体不单单是前沿 AI 技术的简单集合,更是对大语言模型的一次「颠覆性飞跃」。它的广泛应用将带来全新的运作模式,能够帮助企业实现自动化任务、解决问题,最终完成人类需要处理的工作。

从今天起,淼翰实验室将分三期介绍《谷歌 AI 智能体白皮书》的详细内容,并邀请来自 AI 领域资深专家对文章进行详细解析,尽情期待。

导言

人类在处理复杂的模式识别任务方面具有非凡的能力。然而,他们往往需要依赖工具——例如书籍、Google搜索或计算器——来补充已有的知识,然后得出结论。同样,生成式AI模型也可以通过训练使用工具来访问实时信息或建议现实世界中的操作。例如,一个模型可以利用数据库检索工具访问特定信息(如客户的购买历史),从而生成个性化的购物推荐。或者,根据用户的查询,模型可以调用各种API,代表用户发送邮件回复同事或完成一笔金融交易。

为了实现这些功能,模型不仅需要能够访问一组外部工具,还需要具备计划和执行任务的自我驱动能力。这种结合了推理、逻辑以及对外部信息的访问能力的生成式 AI 模型引出了「智能体」(Agent)的概念,即一种超越生成式 AI 模型独立功能的程序。本白皮书将更加详细地探讨这些相关的内容。

什么是智能体?

从最基本的形式来看,生成式 AI 智能体可以定义为一种通过观察世界和使用其可用工具采取行动来实现目标的应用程序。智能体是自主的,可以在没有人为干预的情况下独立行动,尤其是在明确提供了需要实现的目标或任务时。智能体在实现目标的过程中还可以表现出一定的主动性。即使在没有明确的人类指令的情况下,智能体也能推理出下一步应该做什么来实现其最终目标。

尽管 AI 中的智能体概念非常广泛且强大,但本白皮书的重点是生成式 AI 模型能够构建的特定类型的智能体。在理解智能体的内部工作原理之前,我们首先需要介绍驱动智能体行为、行动和决策的基础组成部分。这些组成部分的组合可以描述为一种「认知架构」(Cognitive Architecture),通过不同组件的混合搭配可以实现多种架构。

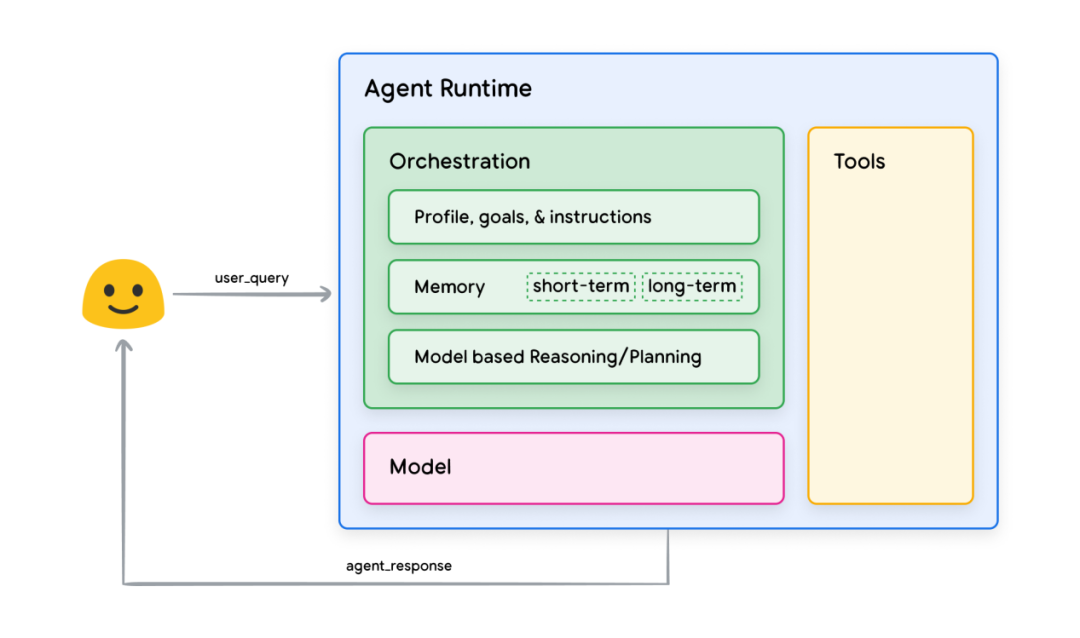

聚焦核心功能,智能体的认知架构中有三个关键组成部分,如图 1 所示:

图 1:通用智能体的设计架构与组件

模型

在智能体的范围内,「模型」是指作为智能体过程核心决策者的语言模型(Language Model,LM)。智能体使用的模型可以是一个或多个具备指令跟随能力和推理逻辑框架(如 ReAct、Chain-of-Thought 或 Tree-of-Thoughts)的语言模型,且其规模可以是小或者大的。根据具体的智能体架构需求,模型可以是通用的、多模态的,或经过针对性微调的。

为了取得最佳的实际应用效果,应该选择最适合目标应用的模型,并且该模型理想情况下已经在与计划使用的工具相关的数据特征上进行了训练。需要注意的是,模型通常并未针对智能体的具体配置(如工具选择、编排/推理设置)进行训练。然而,可以通过提供展示智能体能力的示例(包括智能体在不同上下文中使用特定工具或推理步骤的实例)进一步优化模型以完成智能体的任务。

工具

尽管基础模型在文本和图像生成方面表现出色,但它们依然受限于无法与外界交互的缺陷。工具则弥补了这一缺陷,使智能体能够与外部数据和服务交互,并解锁超越模型本身能力范围的更广泛的操作。工具可以有多种形式,其复杂程度各不相同,但通常与常见的 Web API 方法(如 GET、POST、PATCH 和 DELETE)一致。例如,一个工具可以更新数据库中的客户信息,或者获取天气数据以影响智能体提供的旅行建议。

通过工具,智能体可以访问和处理现实世界中的信息,从而支持更专业的系统(如增强检索生成,Retrieval-Augmented Generation,RAG),显著扩展智能体超越基础模型的能力。我们将在后续部分更详细地讨论工具,但最重要的是要理解:工具是连接智能体内部能力与外部世界的桥梁,解锁了更广泛的可能性。

编排层

编排层(The orchestration layer)描述了一种循环过程,该过程控制智能体如何接收信息、进行内部推理,并利用推理结果来指导下一步行动或决策。一般来说,这一循环会持续进行,直到智能体达成其目标或到达某个停止点。根据智能体及其执行的任务,编排层的复杂性差异可能非常大。一些循环可能仅涉及简单的规则计算,而另一些循环可能包括链式逻辑、额外的机器学习算法或其他概率推理技术。

我们将在认知架构章节中更详细地讨论智能体编排层的具体实现。

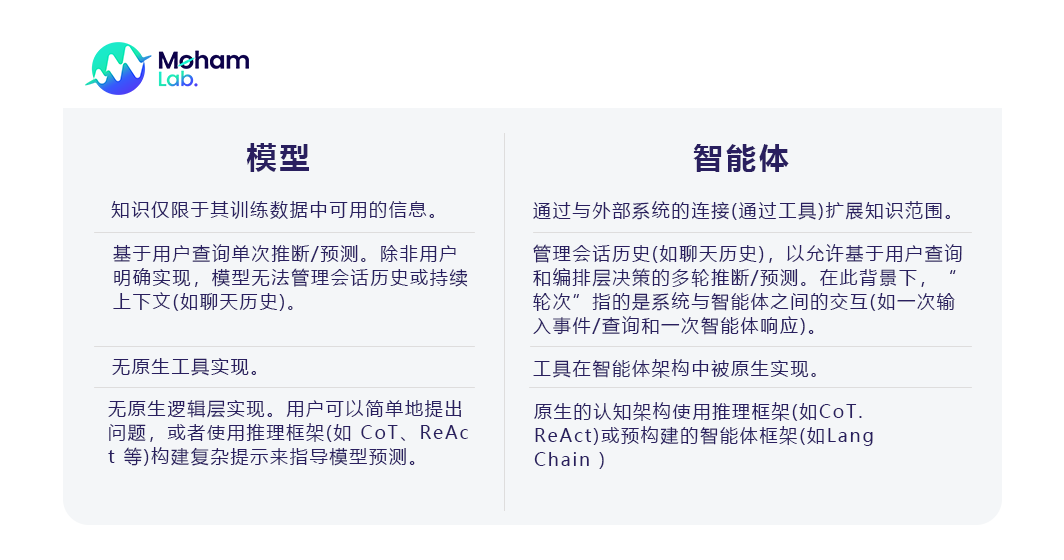

智能体与模型的区别

为了更清楚地理解智能体与模型之间的区别,请参考以下对比表:

认知架构:智能体如何运作

想象一位忙碌的厨师。他们的目标是为餐厅顾客制作美味的菜肴,这涉及一系列的计划、执行和调整循环。

他们收集信息,例如顾客的订单和储藏室及冰箱中的食材。

他们对所收集的信息进行内部推理,思考可以基于现有食材制作哪些菜肴和口味组合。

他们采取行动制作菜肴:切蔬菜、混合香料、煎制肉类。

在这一过程中,厨师会根据需要进行调整,例如当食材耗尽或收到顾客反馈时,他们会调整计划,并根据先前的结果决定下一步行动。这种信息获取、计划、执行和调整的循环描述了一种独特的认知架构,厨师通过这种架构达成目标。

与厨师类似,智能体可以使用认知架构,通过迭代处理信息、做出明智决策并基于先前的输出调整下一步行动来实现其最终目标。在智能体认知架构的核心是编排层,它负责维护记忆、状态、推理和计划。编排层使用迅速发展的提示工程及相关框架来指导推理和计划,从而使智能体能够更有效地与环境交互并完成任务。

当前在语言模型的提示工程框架和任务规划领域的研究迅速发展,产生了许多有前景的方法。以下是一些在本白皮书发布时较为流行的框架和推理技术(并非完整列表):

ReAct:一种提示工程框架,为语言模型提供了一种在用户查询上进行推理并采取行动的思路策略,无论是否有上下文示例。ReAct提示已被证明优于多个SOTA基线,并提高了LLM的人机交互性和可信度。

Chain-of-Thought (CoT):一种通过中间步骤启用推理能力的提示工程框架。CoT有多种子技术,包括自一致性(self-consistency)、主动提示(active-prompt)和多模态CoT(multimodal CoT),每种技术在具体应用中各有优劣。

Tree-of-Thoughts (ToT):一种适合探索或战略前瞻任务的提示工程框架。它是对CoT提示的泛化,允许模型探索多个作为中间步骤的推理链,以解决语言模型的通用问题。

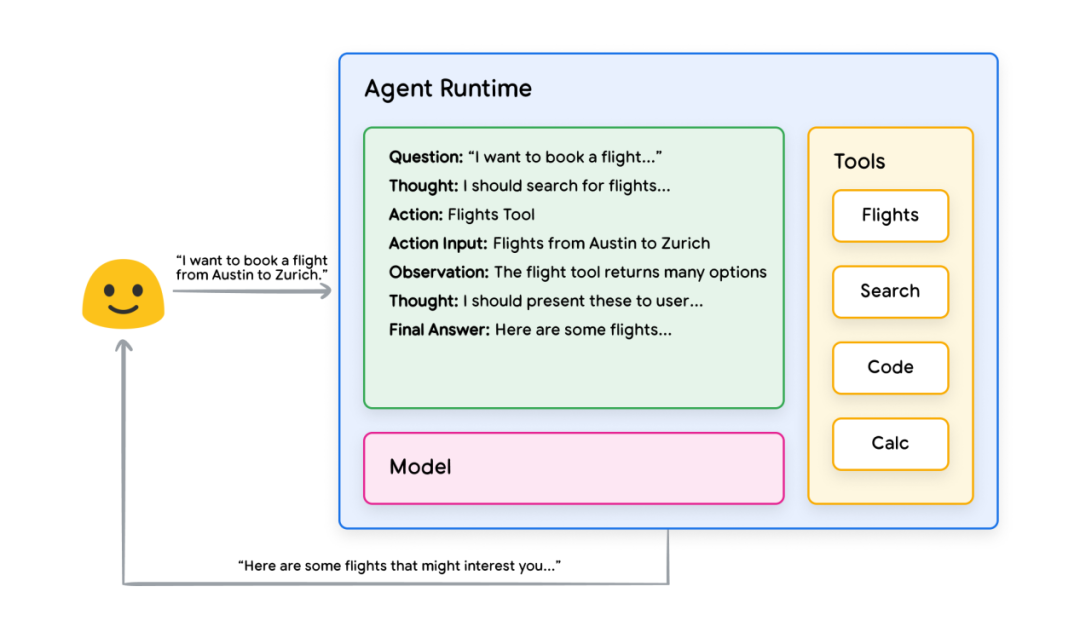

智能体可以使用上述任意一种推理技术,也可以结合多种技术,以选择针对用户请求的最佳下一步行动。例如,假设一个智能体被编程为使用 ReAct 框架选择正确的操作和工具以响应用户查询,其事件序列可能如下:

1. 用户向智能体发送查询。

2. 智能体启动 ReAct 序列。

3. 智能体向模型提供提示,要求其生成 ReAct 步骤之一及其对应的输出:

a. 问题:来自用户查询的输入问题,包含在提示中。

b. 思考:模型关于下一步应采取何种行动的思考。

c. 行动:模型决定下一步采取的行动。

i. 此时可能涉及工具选择。

ii.例如,一个行动可能是[Flights, Search, Code, None] 中的一种,其中前三者代表模型可选择的已知工具,最后一个代表「无工具选择」。

d. 行动输入:模型决定向工具提供的输入(如果有)。

e. 观察:行动/行动输入序列的结果。

i. 这种「思考/行动/行动输入/观察」可能根据需要重复 N 次。

f. 最终答案:模型为最初的用户查询提供的最终答案。

4. ReAct 循环结束,最终答案返回给用户。

图 2:在编排层中具有 ReAct 推理的智能体示例

通过这种方式,模型、工具和智能体配置协同工作,根据用户的原始查询提供有依据且简洁的响应。尽管模型可能基于其已有知识猜测答案(即产生幻觉),但它通过使用工具(如 Flights)搜索实时外部信息,获取了额外的信息,从而基于真实的事实数据做出更明智的决策并将此信息总结反馈给用户。

总结

智能体响应的质量与模型在处理任务时的推理和行动能力直接相关,包括选择正确工具的能力以及工具定义的质量。正如厨师利用新鲜食材并关注顾客反馈来精心制作菜肴一样,智能体依赖于合理的推理和可靠的信息以提供最佳结果。在接下来的章节中,我们将深入探讨智能体如何与实时数据连接。

未完待续…

编译:刘嘉禾

审核:Flora

视觉设计:Luna

责任编辑:刘嘉禾

推荐阅读: