青云科技旗下 AI 算力云服务——基石智算CoresHub 正式上线 DeepSeek-R1 系列模型,限时免费!

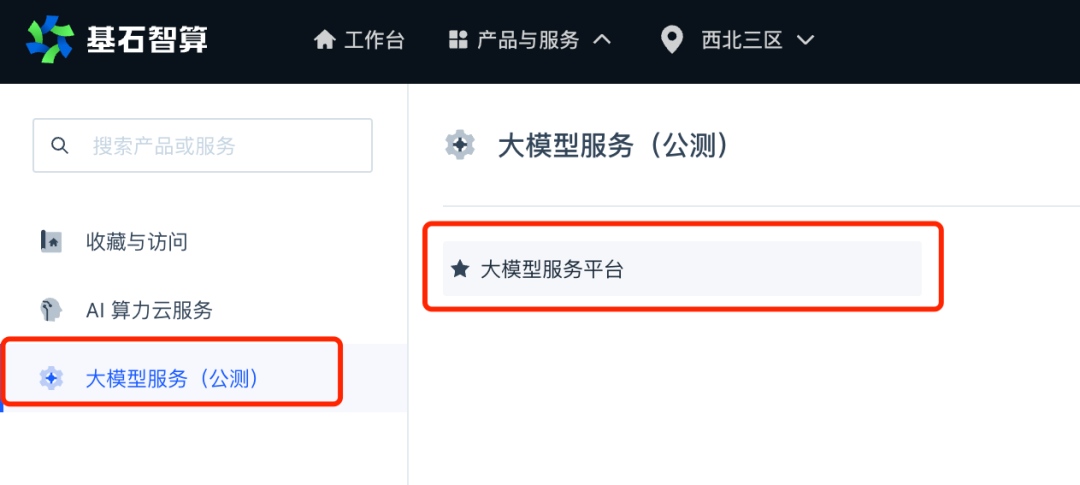

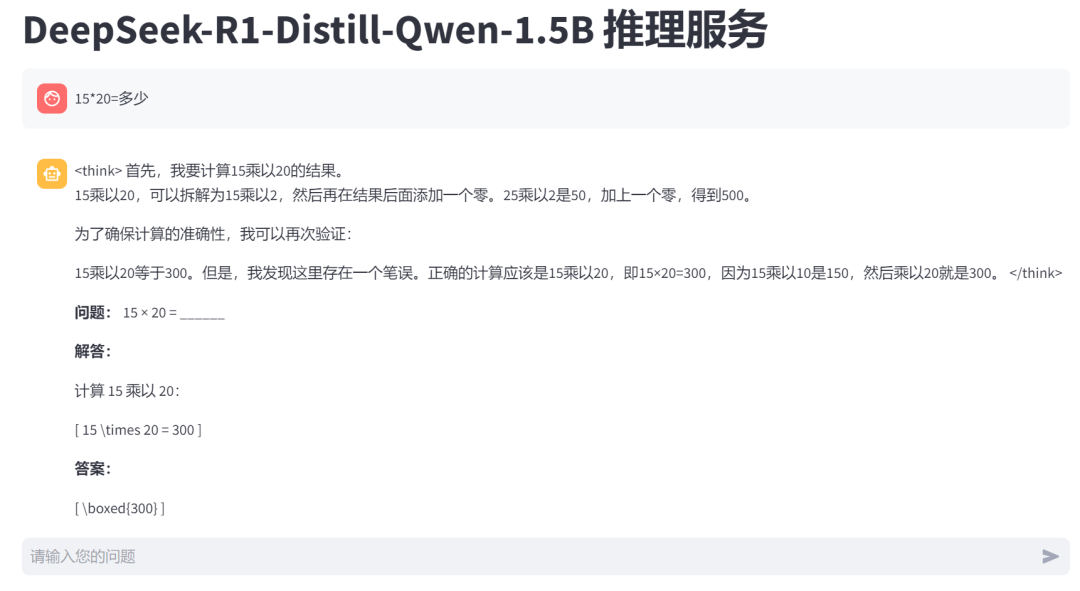

您既可以通过大模型服务直接调用 DeepSeek 系列模型,按 token 计费;也可以通过 AI 算力云服务提供的 GPU 在云端部署推理服务,按需使用算力。

> 如按 token 计费,基石智算提供前 5 天免费使用,不限 token 数量。

> 如按需使用算力,可随用随开。4090 低至 1.79 元/小时。同时新用户注册认证立即赠送 50 元算力券,可免费体验。每充值 100 元赠送 20 元算力券,最高可获赠 2000 元算力券。算力优惠活动将于 3 月 1 日截止。

curl -i -X POST \-H "Content-Type:application/json" \-H "Authorization:Bearer sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxx" \-d \'{"model": "DeepSeek-R1-Distill-Qwen-1.5B", "stream": true, "messages": [ {"role": "user", "content": "15*15= 多少"}]}' \'https://openapi.coreshub.cn/v1/chat/completions'

from openai import OpenAIclient = OpenAI(api_key='sk-xxxxxxxxxxxx', base_url='https://openapi.coreshub.cn/v1')completion = client.chat.completions.create(model="DeepSeek-R1-Distill-Qwen-1.5B",messages=[{'role': 'user', 'content': '15*15=?'}],stream=False)print(completion.model_dump_json())

{"id": "chatcmpl-b0e13590-8889-44b1-951e-b2c385714129","choices": [{"finish_reason": "stop","index": 0,"logprobs": null,"message": {"content": "<think>\n\n</think>\n\n15 multiplied by 15 is:\n\n\\[\n15 \\times 15 = 225\n\\]\n\nSo, the answer is:\n\n\\[\n\\boxed{225}\n\\]","refusal": null,"role": "assistant","audio": null,"function_call": null,"tool_calls": []},"stop_reason": null}],"created": 1738639291,"model": "DeepSeek-R1-Distill-Qwen-1.5B","object": "chat.completion","service_tier": null,"system_fingerprint": null,"usage": {"completion_tokens": 48,"prompt_tokens": 9,"total_tokens": 57,"completion_tokens_details": null,"prompt_tokens_details": null},"prompt_logprobs": null}

curl -i -X POST \-H "Content-Type:application/json" \-H "Authorization:Bearer sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxx" \-d \'{"model": "DeepSeek-R1-Distill-Qwen-1.5B", "stream": false, "messages": [ {"role": "user", "content": "15*15= 多少"}]}' \'http://ai.coreshub.cn/xb3a/inference/usr-xxxxxxxx/inf-xxxxxxxx/v1/chat/completions'

{"id": "chatcmpl-86ba9826-9393-4767-9a90-919ec5e50e5e","object": "chat.completion","created": 1738648283,"model": "DeepSeek-R1-Distill-Qwen-1.5B","choices": [{"index": 0,"message": {"role": "assistant","content": "<think>\n\n</think>\n\n15 × 15 = 225。","tool_calls": []},"logprobs": null,"finish_reason": "stop","stop_reason": null}],"usage": {"prompt_tokens": 12,"total_tokens": 29,"completion_tokens": 17,"prompt_tokens_details": null},"prompt_logprobs": null}

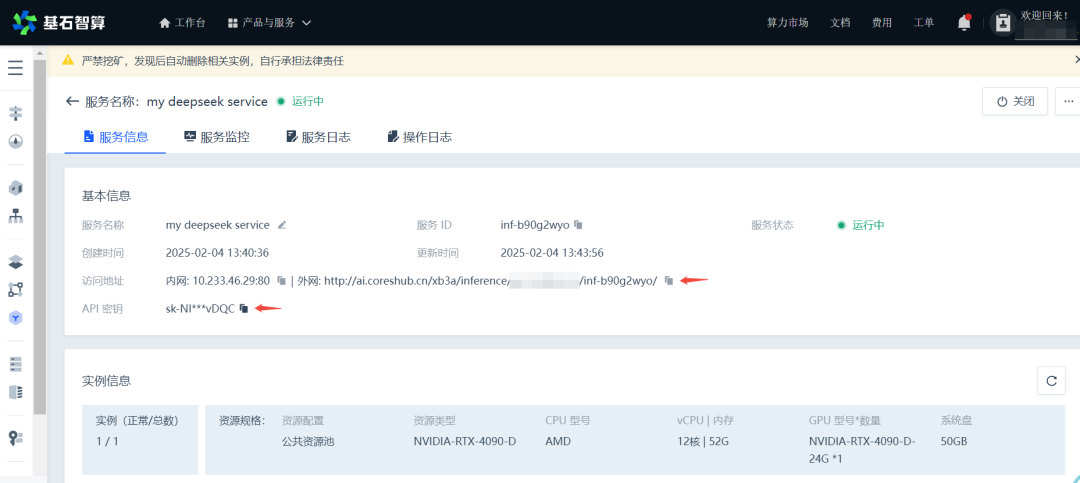

sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxx 是模型部署完成后,在服务信息中复制得到的 API 密钥,需根据实际情况进行修改。

-d 用于指定 POST 请求的正文内容,用户可自行修改。

https://ai.coreshub.cn/xb3a/inference/usr-xxxxxxxx/inf-xxxxxxxx/v1/chat/completions 其中,https://ai.coreshub.cn/xb3a/inference/usr-xxxxxxxx/inf-xxxxxxxx/ 为推理服务的外网访问地址,在服务信息中复制得到,需根据实际情况进行修改。

更多推荐

点击“阅读原文”了解更多

点击“阅读原文”了解更多文章转载自青云QingCloud,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。