我们看看DeepSeek是如何谈Deepseek和OpenAI有什么不同的:

DeepSeek R1: 专注于特定领域的定制化AI解决方案,在垂直领域展示了AI的强大能力,推动了行业智能化。

OpenAI: 致力于通用人工智能,产品应用广泛,研究范围全面,通过广泛的技术应用和AGI愿景,展示了AI的深远影响。

关于DeepSeek R1、DeepSeek V2 和 DeepSeek V3的关系和区别,此前一直以为是不同时期的版本演进,后来才知道是同一系列的不同版本,主要区别在于性能、功能和优化。简而言之是:

R1:入门级,适合小型项目。

V2:中级,适合中型项目。

V3:高级,适合大型项目。

模型大小 | 参数量 | 显存需求 (GPU) | CPU 和内存需求 | 硬盘 | 适用场景 |

1.5B | 15亿 | 2-4 GB | 8 GB 内存 | 3GB+(1.5-2GB) | 低资源设备部署(如树莓派、旧款笔记本) 实时文本生成(聊天机器人、简单问答) 嵌入式系统或物联网设备 |

7B | 70亿 | 8-12 GB | 16 GB 内存 | 8GB+(4-5GB) | 本地开发测试(中小型企业) 中等复杂度 NLP 任务(文本摘要、翻译) |

8B | 80亿 | 10-16 GB | 16-32 GB 内存 | 15GB+ | 需更高精度的轻量级任务(如代码生成、逻辑推理) |

14B | 140亿 | 16-24 GB | 32 GB 内存 | 15GB+ | 企业级复杂任务(合同分析、报告生成) 长文本理解与生成(书籍/论文辅助写作) |

32B | 320亿 | 32-48 GB | 64 GB 内存 | 30GB+ | 高精度专业领域任务(医疗/法律咨询) 多模态任务预处理(需结合其他框架) |

70B | 700亿 | 64 GB+ | 128 GB 内存 | 70GB+ | 科研机构/大型企业(金融预测、大规模数据分析) 高复杂度生成任务(创意写作、算法设计) |

671B | 6710亿 | 多 GPU (80 GB+) | 256 GB+ 内存 | 300GB+ | 国家级/超大规模 AI 研究(如气候建模、基因组分析) 通用人工智能(AGI)探索 |

第二步,选择安装部署工具,一般推荐Ollama

Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型。

官网地址是:https://ollama.com/

1、点击Download下载ollama

2、安装ollama即可,这个会默认安装在C盘上的,没法选择的。

3、点击DeepSeek-R1链接找到对deepseek-r1的支持情况

可以往下看看,其实不同大小的模型已经对应了不同下载和运行命令了

DeepSeek-R1-Distill-Qwen-1.5B

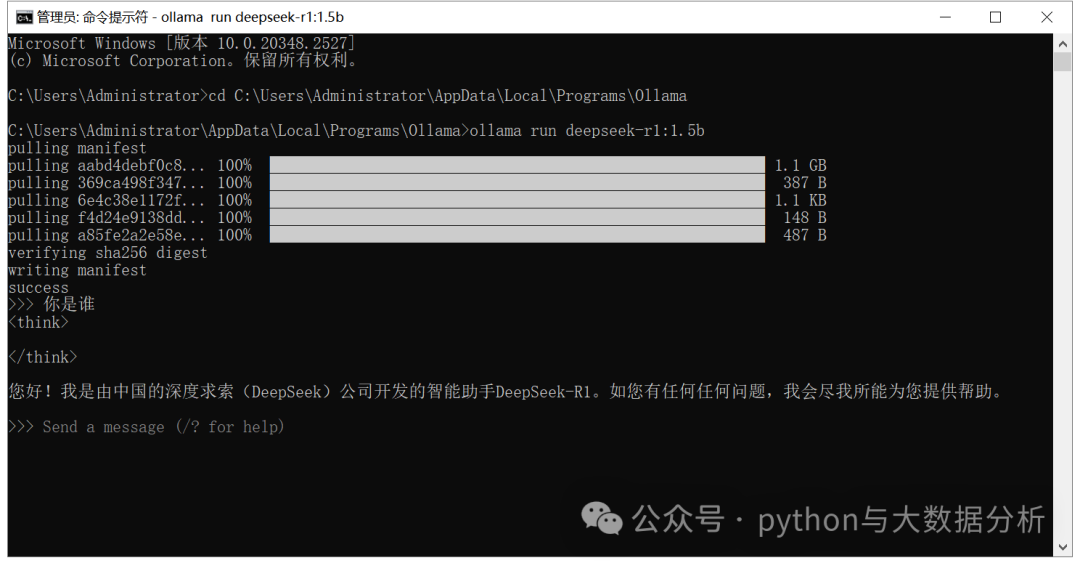

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

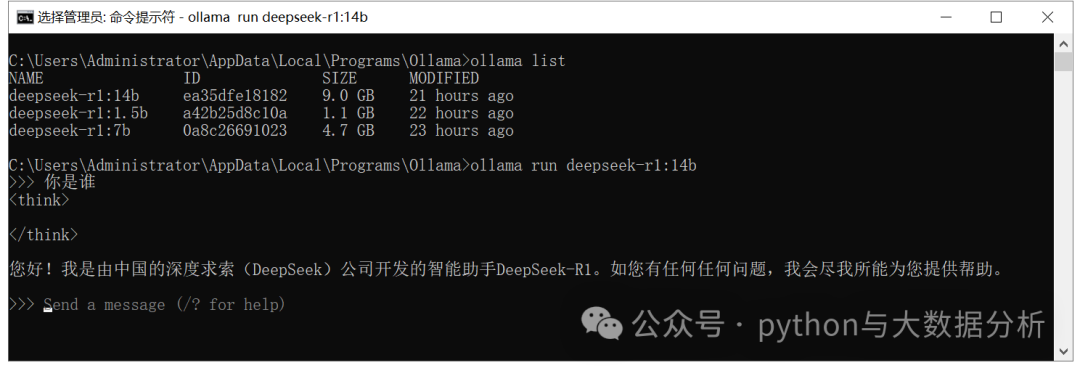

4、下载完成后会自动运行相关模型文件

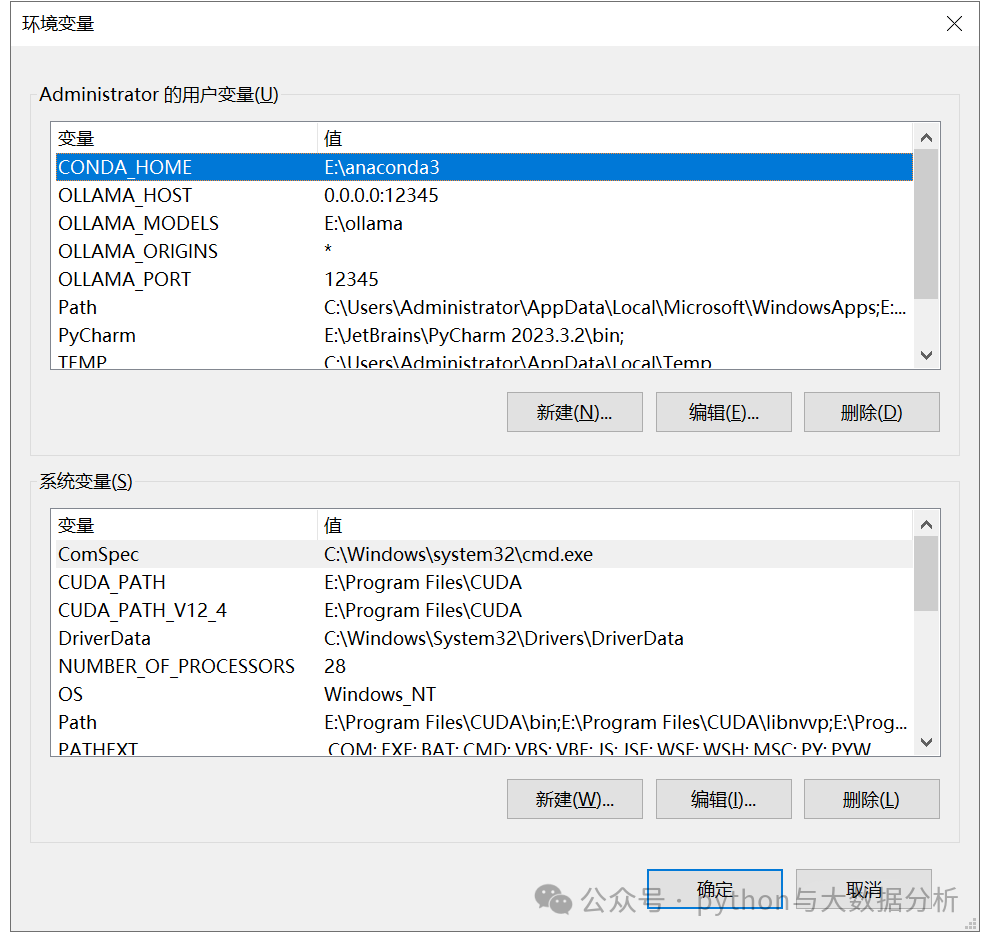

第三步,更改ollama默认参数

Windows系统,Ollama下载的模型默认存储位置在C:\Users\<USERNAME>\.ollama\models,目录下包括manifests和blobs两个子目录。对于C盘不足恐惧症的人来说,是必须要修改的,毕竟动辄几个G的文件。

我们先来看一下ollama的配置参数有哪些:

常用的几个参数如下:

OLLAMA_MODELS是配置ollama的模型存储路径,默认是C盘的C:\Users\<USERNAME>\.ollama\models,这里我们更改ollama的模型存储为D盘

变量名:OLLAMA_MODELS

变量值:E:\ollama

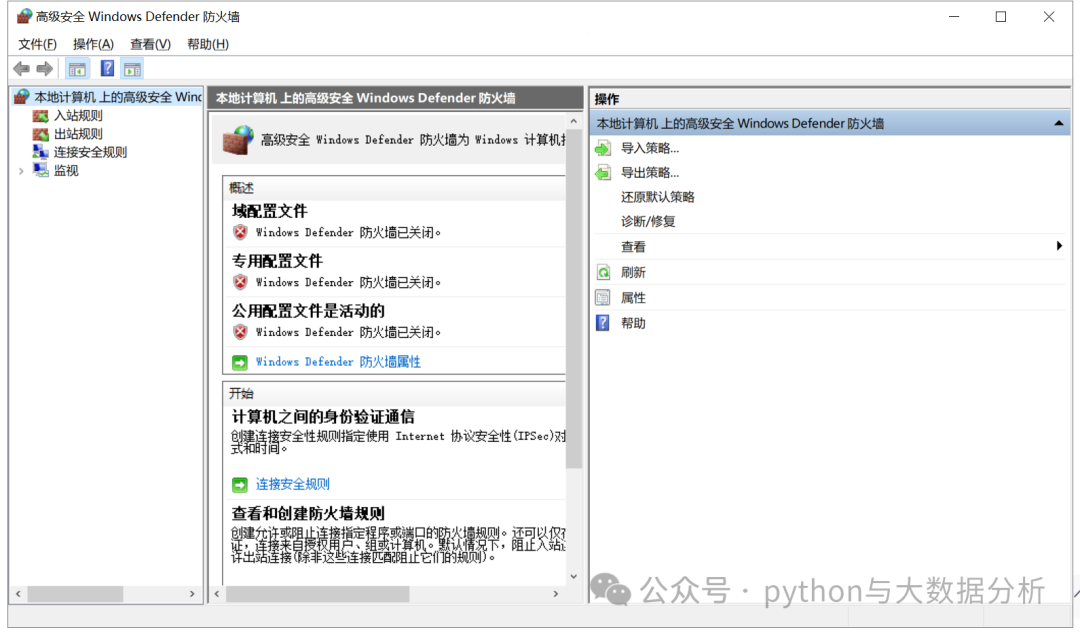

OLLAMA_HOST为ollama监听地址,默认是127.0.0.1(仅限本机访问),这里设置为设置为0.0.0.0,即可远程访问

变量名:OLLAMA_HOST

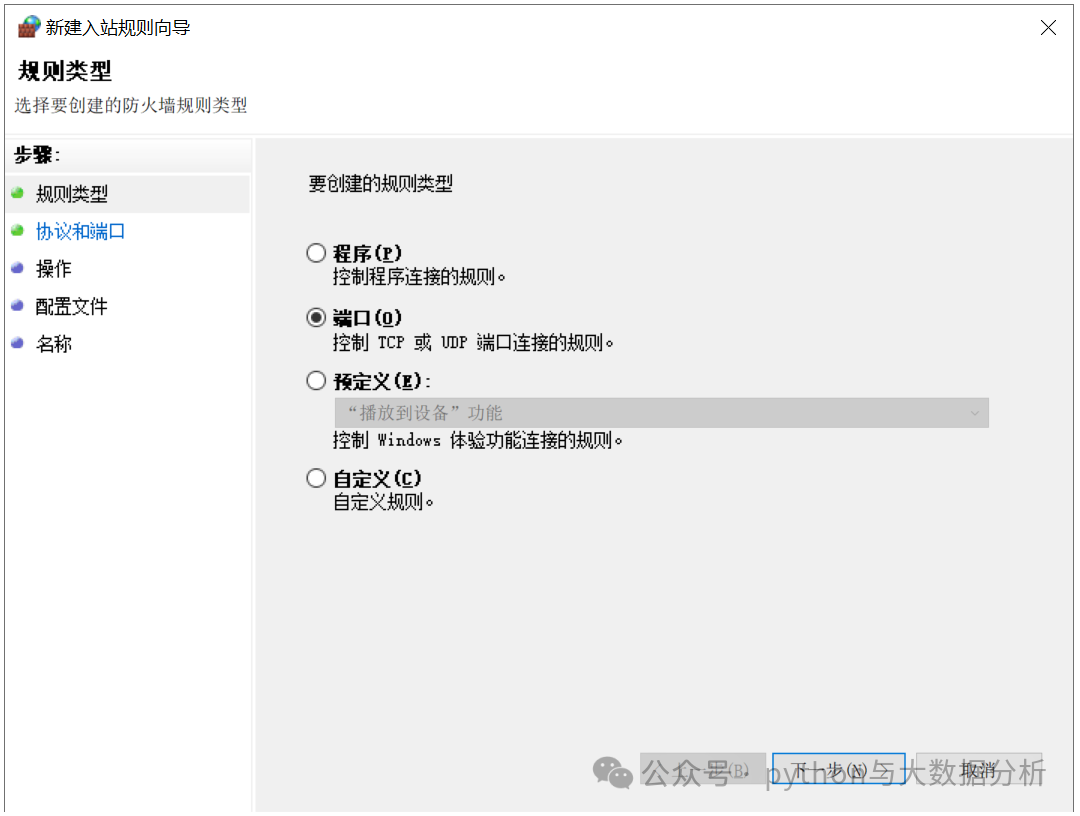

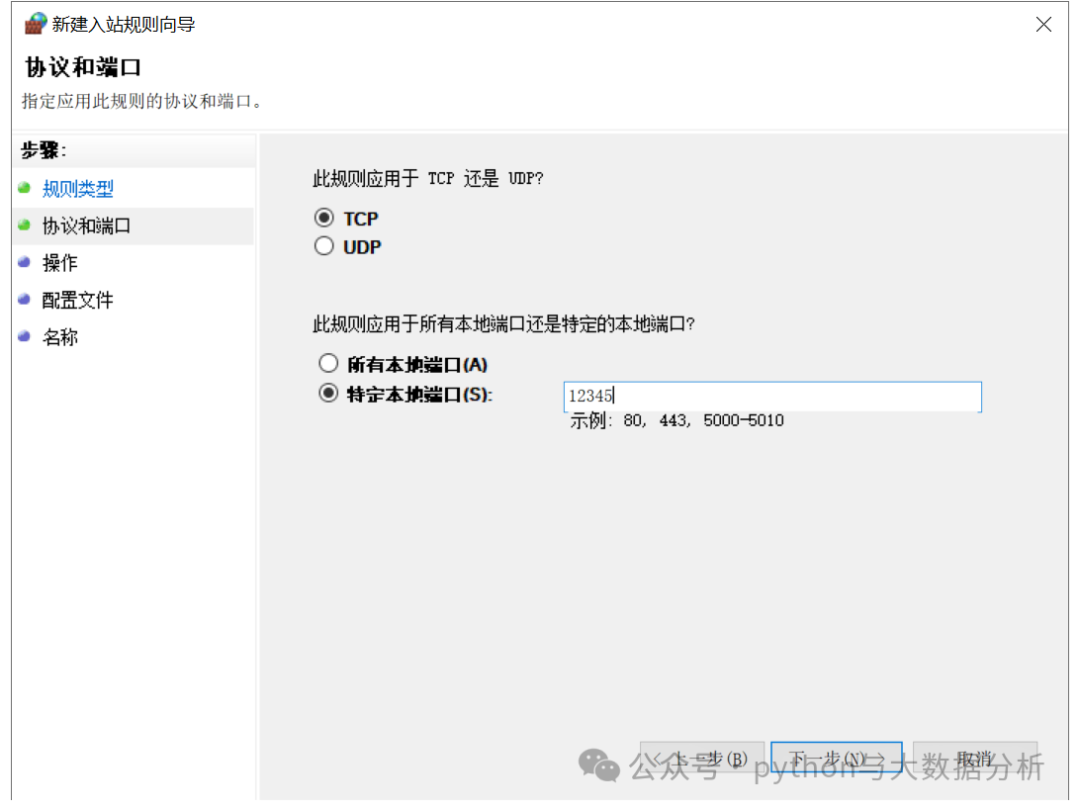

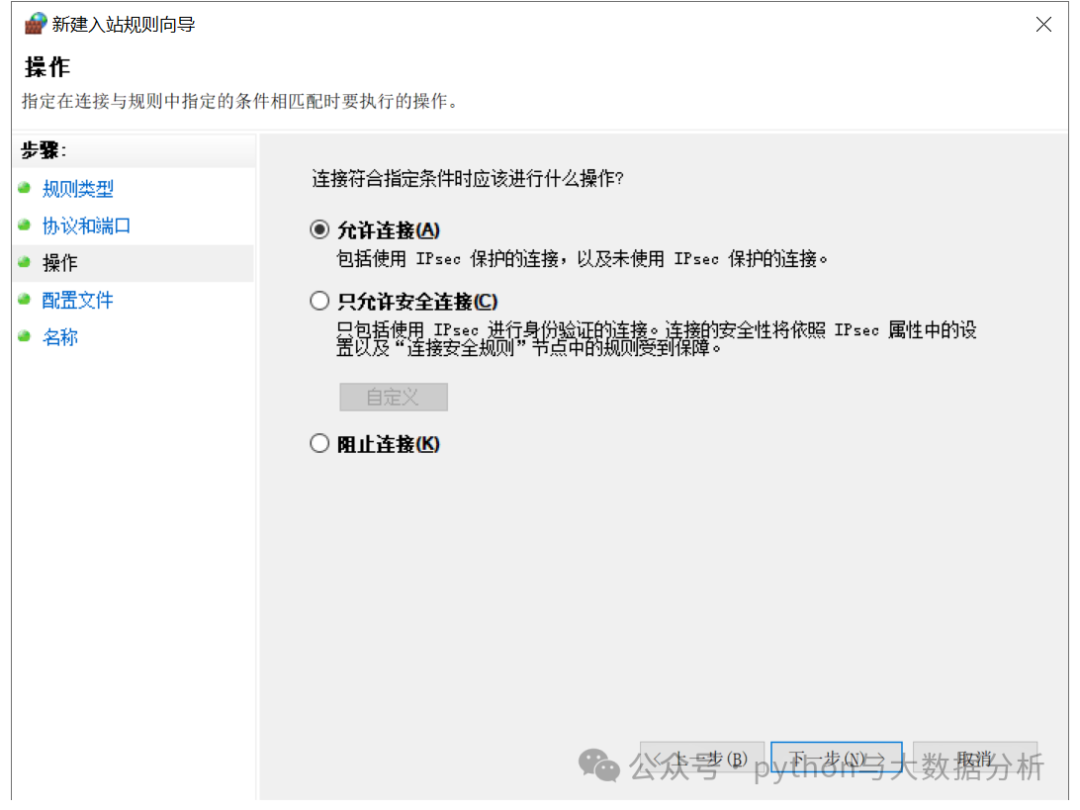

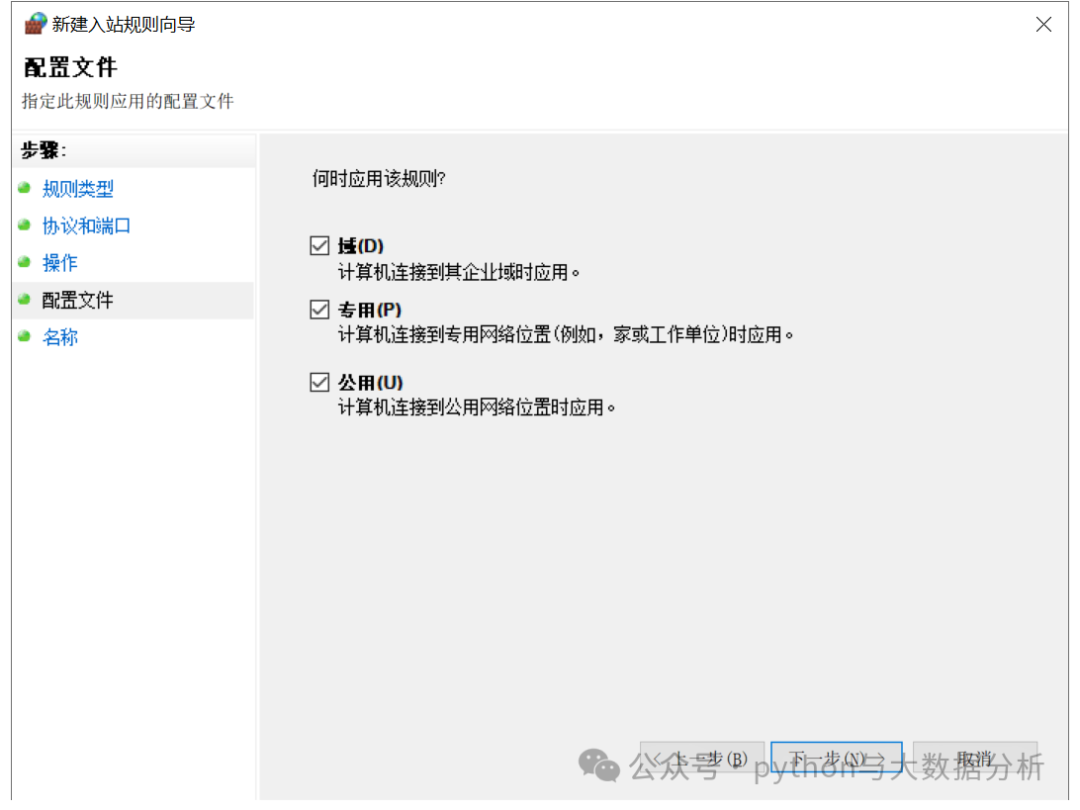

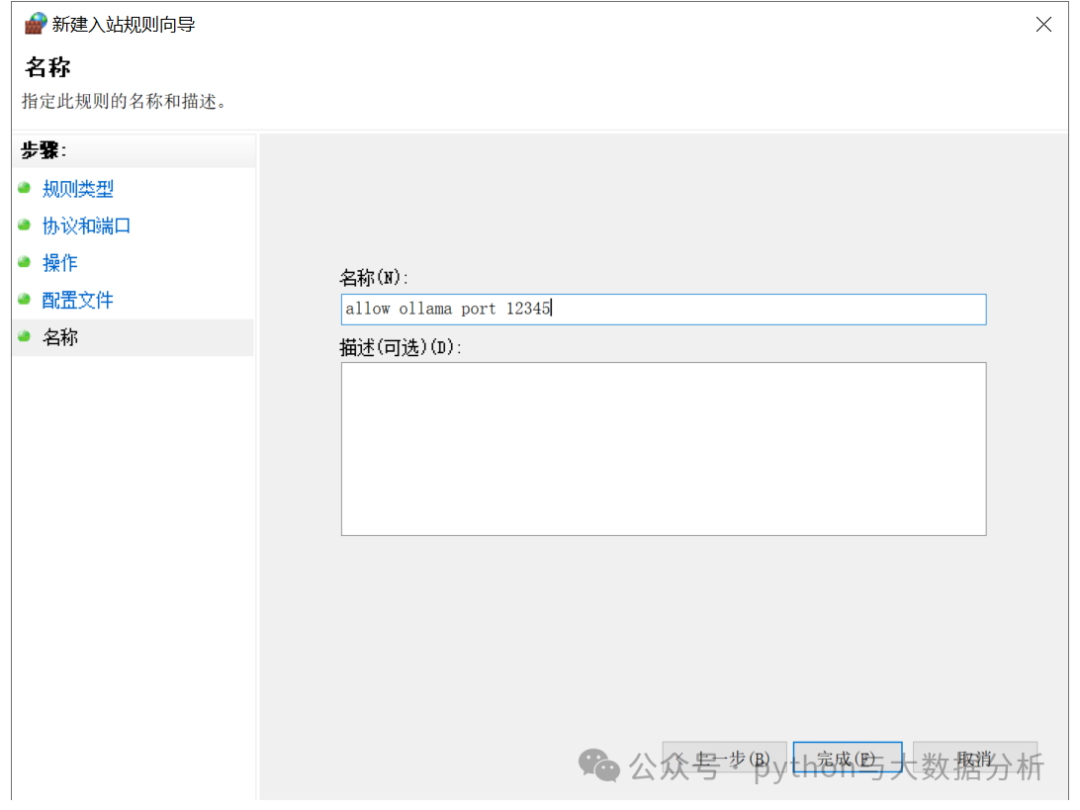

变量值:0.0.0.0:12345

OLLAMA_PORT为ollama默认端口号,默认为11434端口

变量名:OLLAMA_PORT

变量值:12345

OLLAMA_ORIGINS为http开放请求

变量名:OLLAMA_ORIGINS

变量值:*

修改后的环境变量见以下截图:

一般重启后才能起作用

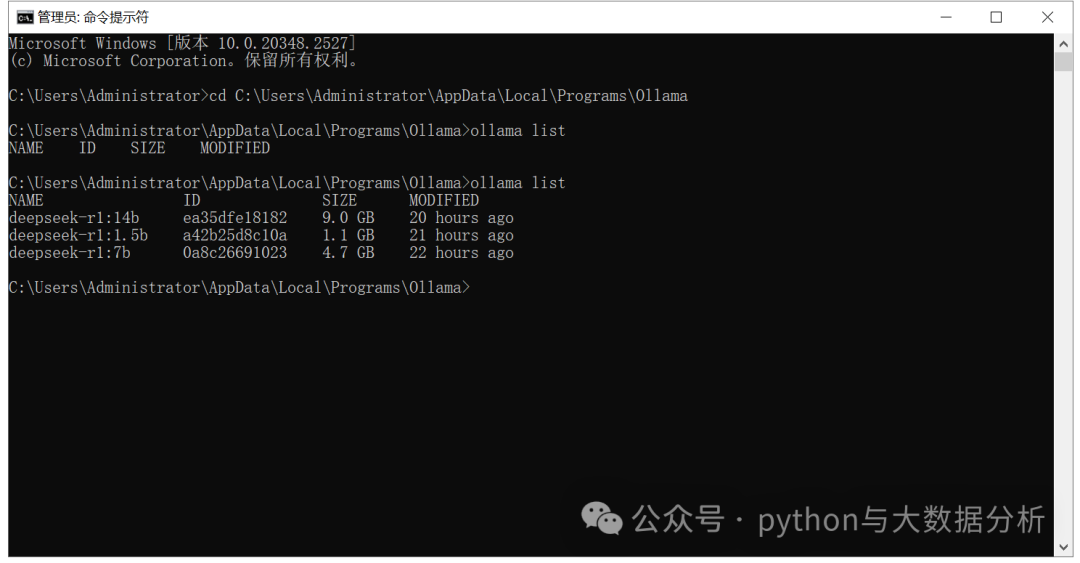

然后把这两个目录剪切到OLLAMA_MODELS目录下,对比前后两次执行的数据情况

第五步,重启ollama,查看相关情况

1、建议重启服务器,或者重启ollama

2、再用command命令打开ollama

写在最后的话,作为AI小白,去尝试看懂DeepSeek是有点不现实的,后续可能会考虑如何尝试更加友好的应用DeepSeek,或者利用DeepSeek解决一些工作上的问题,或者在垂直行业做一些微调吧。

顺便吐槽一下DeepSeek在线版的稳定性,基本上几个问答就报“服务器繁忙,请稍后再试”了。

最后欢迎关注公众号:python与大数据分析