“ 使用ollama运行deepseek-r1模型。”

随着大家都纷纷接入Deepseek,已经到了AI言必称deepseek了!Frank大佬已经建议我本地也跑一个Deepseek r1玩玩,我根据先行者李靖的方法本地测试了下。

Ollama 是一个开源项目,专注于在本地运行、创建和共享大型语言模型(LLMs)。它旨在简化 LLMs 的使用,让用户能够轻松在个人计算机上部署和操作这些模型,无需依赖云端服务。所以我们可以使用ollama运行deepseek-r1,ollama官网也有具体说明:

https://ollama.com/library/deepseek-r1

01

—

安装ollama

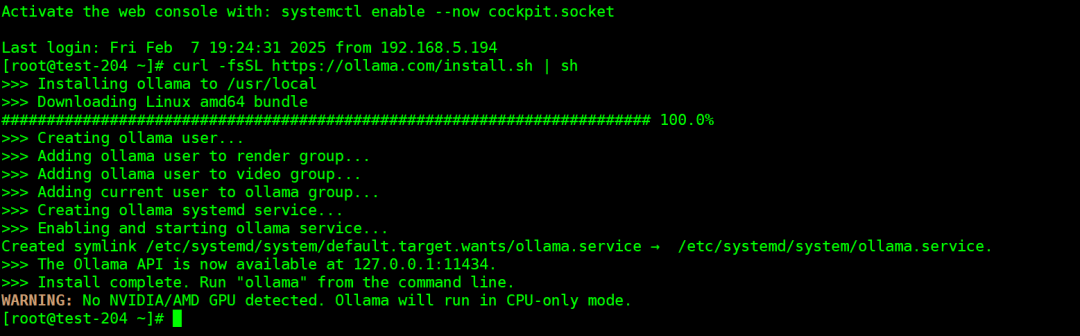

1、Linux安装ollama

curl -fsSL https://ollama.com/install.sh | sh

我这边环境是PVE安装的Linux的虚拟机,没有GPU,所以ollama运行的是CPU模式。此脚本安装的是systemd服务,侦听地址为127.0.0.1:11434,

为了跨主机访问,我们需要做如下简单的修改:

sudo vim /etc/systemd/system/ollama.service添加如下:Environment="OLLAMA_HOST=0.0.0.0:11434"

完整的ollama.service文件内容如下:

[Service]ExecStart=/usr/local/bin/ollama serveUser=ollamaGroup=ollamaRestart=alwaysRestartSec=3Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin"Environment="OLLAMA_HOST=0.0.0.0:11434"

修改完成之后,我们执行如下:

sudo systemctl daemon-reloadsudo systemctl restart ollama

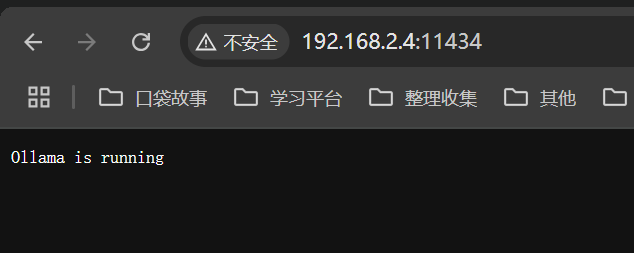

验证服务是否正常运行,打开http://192.168.2.4:11434/页面,会显示:

Ollama is running

2、Windows安装,下载如下地址的OllamaSetup.exe

https://github.com/ollama/ollama/releases/latest/download/OllamaSetup.exe

3、Mac安装,下载Ollama-darwin.zip

https://github.com/ollama/ollama/releases/latest/download/Ollama-darwin.zip

02

—

ollama运行Deepseek r1模型

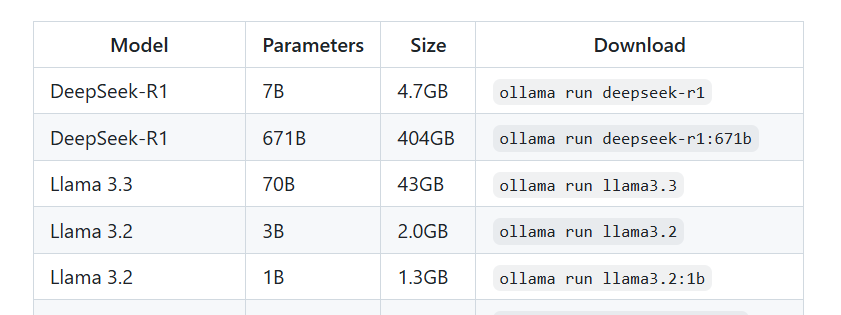

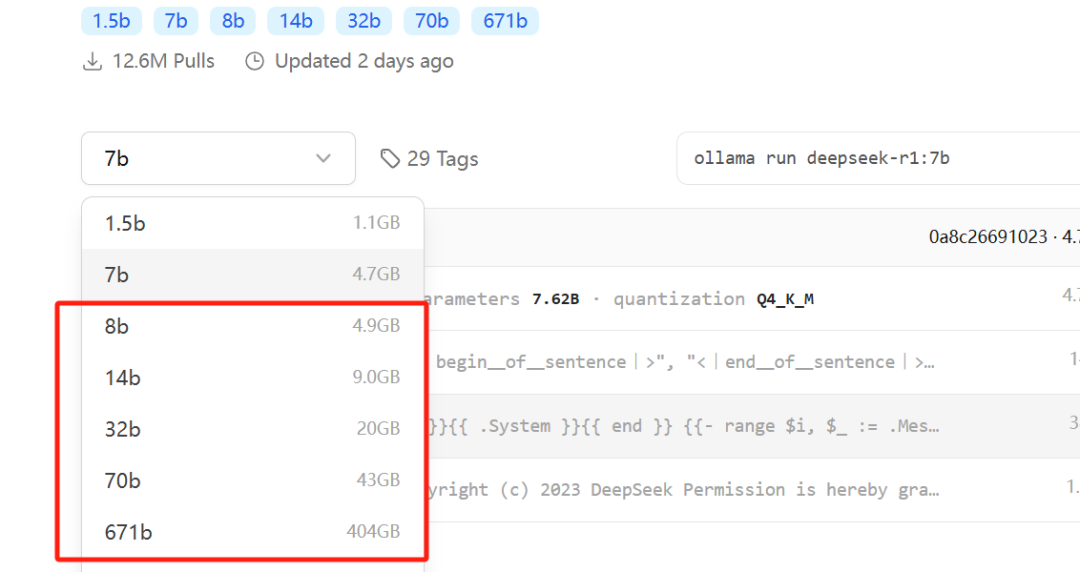

Ollama支持很多模型,具体如下:

我们先测试7b,毕竟配置有限,其他的就别想了。。671b有大佬说那是投资人该考虑的事情。。

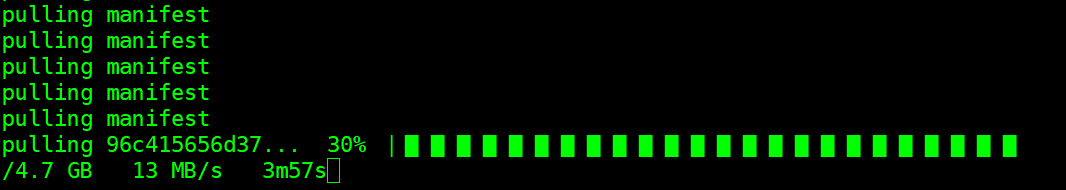

使用如下命令来运行deepseek-r1:7b,首次运行会自动下载Deepseek-r1:7b模型,我们静待下载完成。

ollama run deepseek-r1:7b

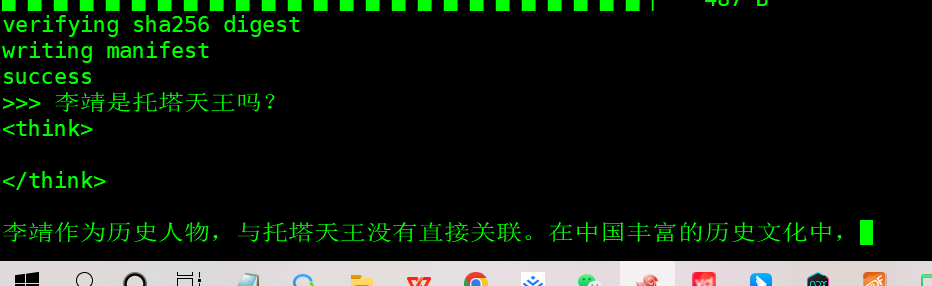

让我先在命令行来一个提问看看:

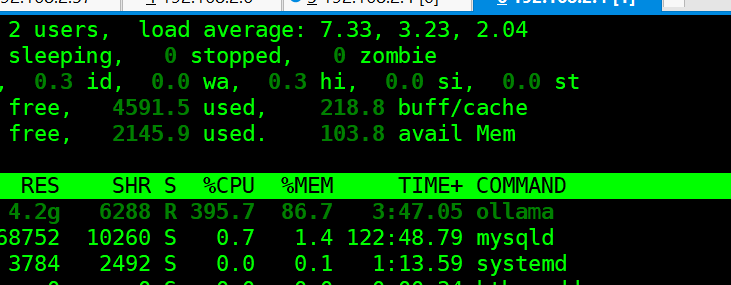

我那4核的虚拟机cpuload哗哗的上去了,所以想体验度好一点,还是得整一台有GPU的台式机。

运维笔谈已经开通AI智能对话功能,解答有关运维日常工作中遇到的问题以及经验分享,感兴趣的大佬来和我聊聊吧!对话 “阿里云k8s” 可以获取《阿里云Kubernetes项目实战手册》pdf。