“ 通过 Open WebUI 为 Ollama 提供一个基于网页的交互界面。”

前面我们使用了ollama运行deepseek-r1 使用ollama运行deepseek-r1 。但是每次都登录到服务器命令行输入提问,体验感很差,所以我们想要一个基于网页的提问回答方式。Open WebUI就是一个功能丰富且用户友好的自托管 AI 平台,支持 Ollama和OpenAI兼容的API,并且可以完全离线运行。

01

—

使用docker compose运行Open WebUI

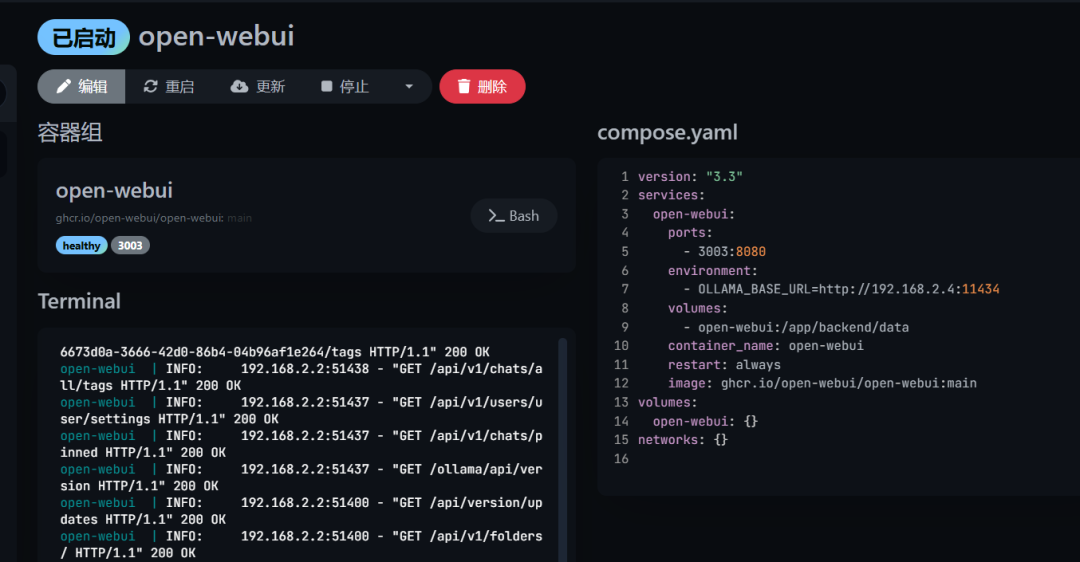

我们可以使用docker compose来快速运行一个 Open WebUI。我们需要设置environment为ollama的实际远程地址。我们可以通过Dockge来管理docker-compose.yaml,我们也可以通过docker run xxx来快速生成一个docker compose.yaml文件。

version: "3.3"services:open-webui:ports:- 8080:8080environment:- OLLAMA_BASE_URL=http://192.168.2.4:11434volumes:- open-webui:/app/backend/datacontainer_name: open-webuirestart: alwaysimage: ghcr.io/open-webui/open-webui:mainvolumes:open-webui: {}

02

—

使用Open WebUI

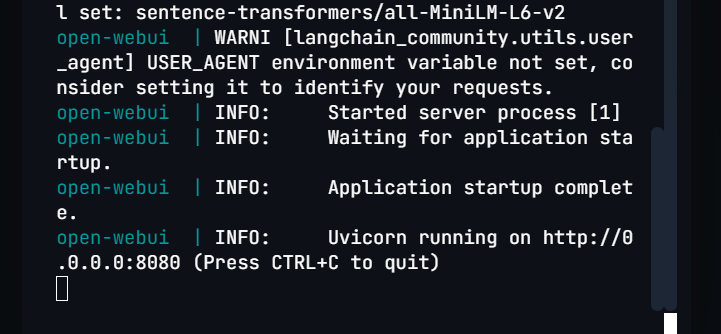

日志出现 open-webui | INFO: Uvicorn running on http://0.0.0.0:8080 (Press CTRL+C to quit) 说明已经启动成功了。我们可以打开 http://xx.xx.xx.xx:8080

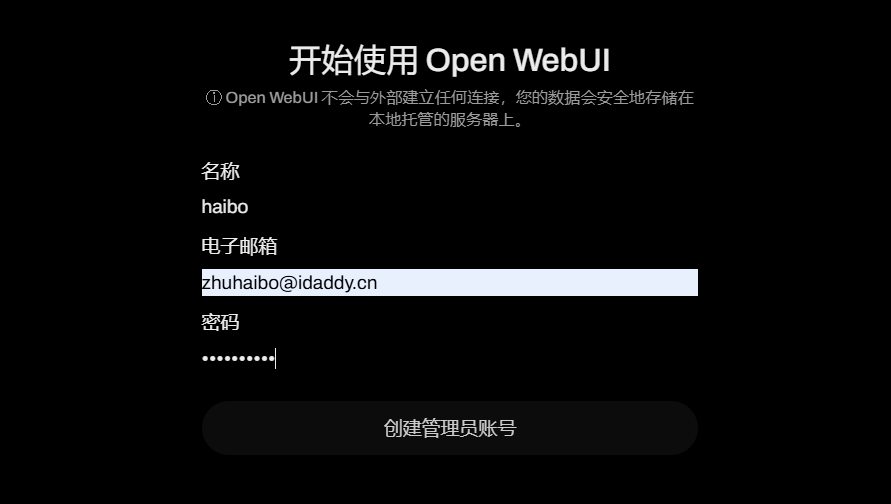

1、首次登录使用,需要先创建管理员账户

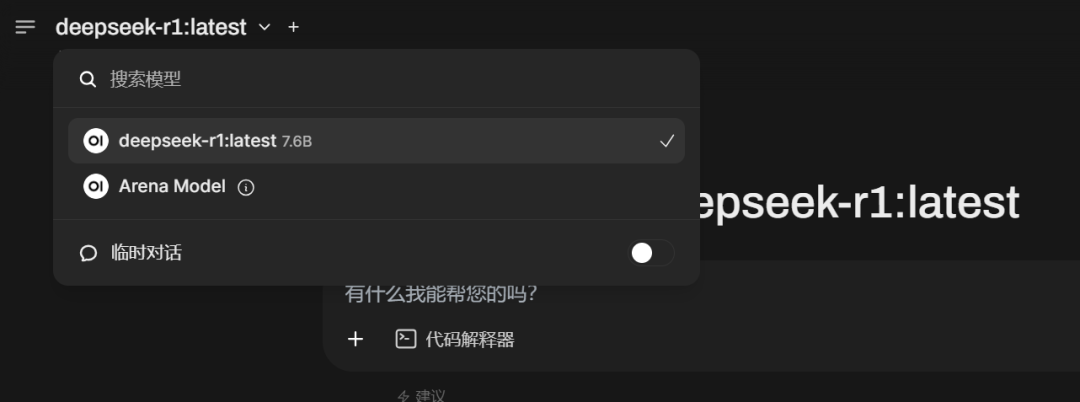

2、创建好管理员,然后可能需要花一点时间,我是等待了一分钟左右。看日志有加载openai失败“open-webui | ERROR [open_webui.routers.openai] Connection error: Cannot connect to host api.openai.com:443 ssl:default [Connect call failed ('108.160.166.61', 443)]”,然后如下图,我们默认的模型就是deepseek-r1 7.6B

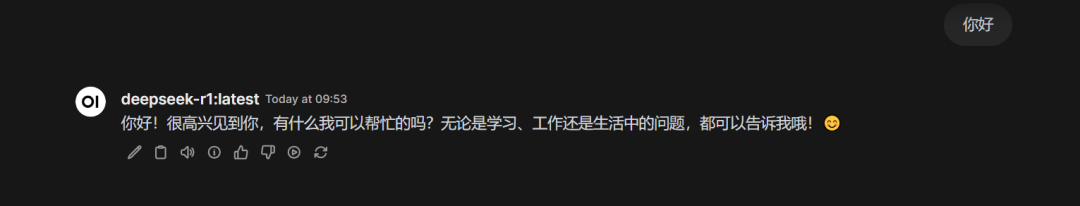

3、我们提问一个看看

4、有点失望,很卡顿,出来的速度也没有命令行界面快,具体原因还未知 。我下午试试在我们笔记本安装一个ollama Windows版本看看,毕竟笔记本还是有个入门级的显卡的

。我下午试试在我们笔记本安装一个ollama Windows版本看看,毕竟笔记本还是有个入门级的显卡的 。

。

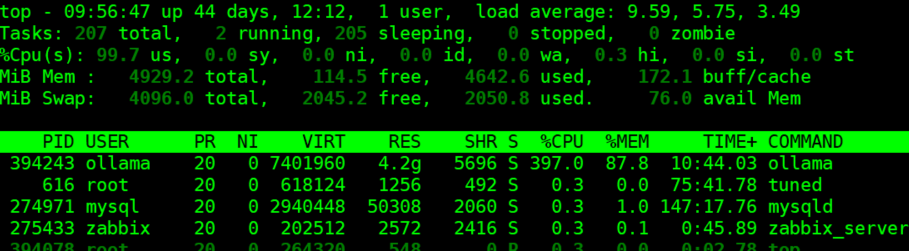

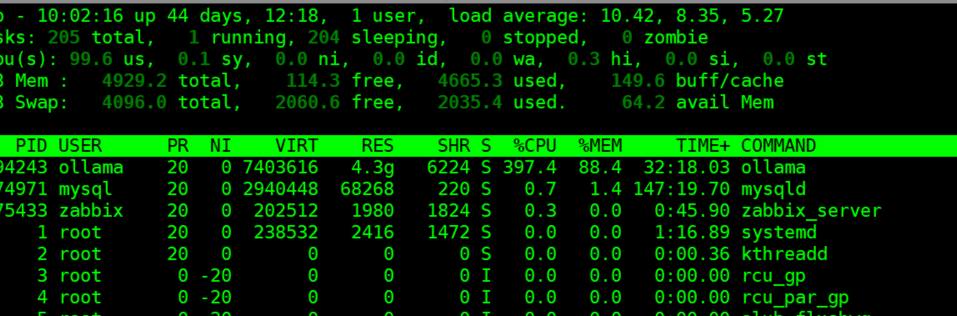

5、等待了7分钟,才出来第一个对话结果,cpuload也飙到10以上了。

还是看看下午笔记本上跑的效果吧。

运维笔谈已经开通AI智能对话功能,解答有关运维日常工作中遇到的问题以及经验分享,感兴趣的大佬来和我聊聊吧!对话 “阿里云k8s” 可以获取《阿里云Kubernetes项目实战手册》pdf。