Whoami:5年+金融、政府、医疗领域工作经验的DBACertificate:PGCM、OCP、YCPSkill:Oracle、Mysql、PostgreSQL、国产数据库Platform:CSDN、墨天轮、公众号(呆呆的私房菜)

Ollama 是一个开源的本地大语言模型运行框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。 地址:https://ollama.com/

简化部署:Ollama 通过 Docker 容器简化了大型语言模型的部署过程,即使是非专业用户也能轻松上手; 支持多种模型:它支持多种流行的大型语言模型,如 LLaMA 2、Mistral、Gemma 等; 跨平台支持:Ollama 支持 Windows、macOS 和 Linux 等多个操作系统; 资源占用低:Ollama 优化了资源使用,使得在普通硬件上也能高效运行。

地址:https://ollama.com/search

选择 deepseek-r1 对应的模型进行下载,目前有 1.5b、7b、8b、14b、32b、70b和671b 共7个版本可以选择。

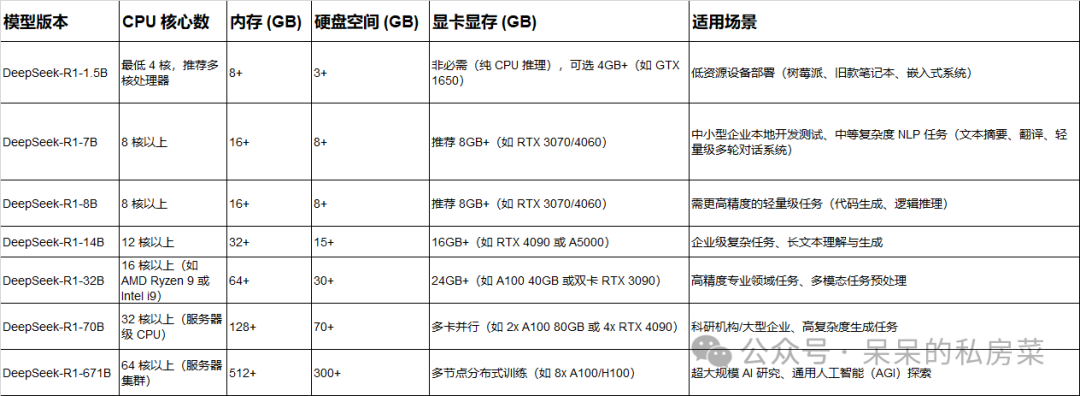

以下是 DeepSeek-R1 不同模型对电脑配置的要求,整理成表格如下:

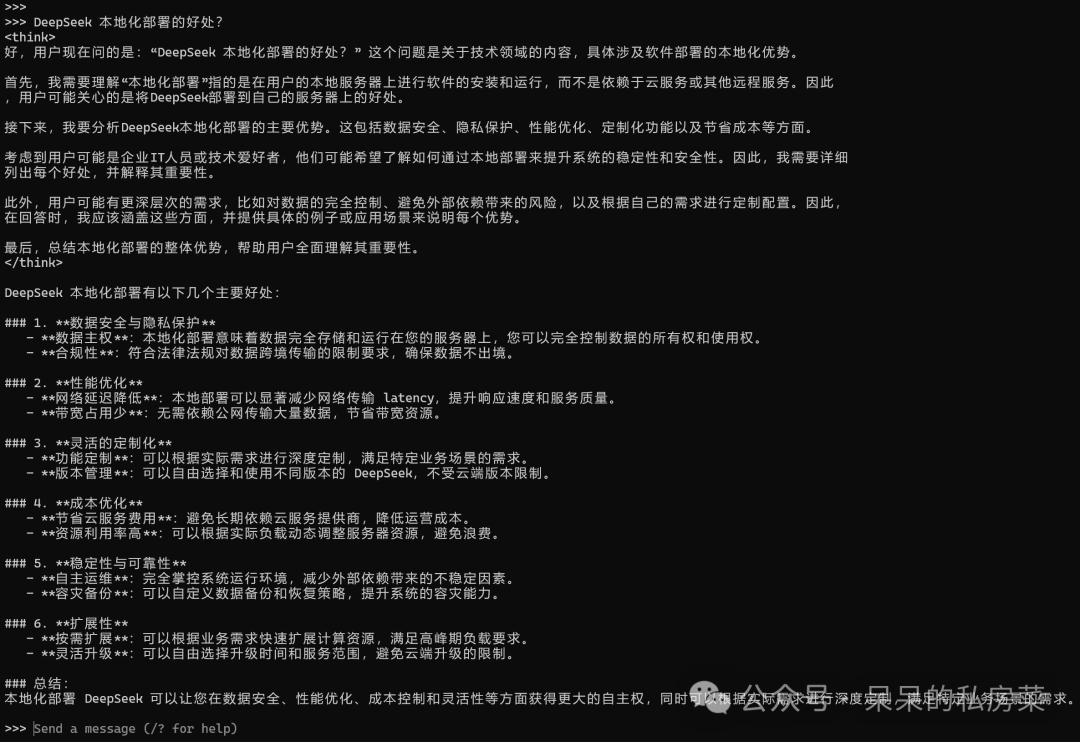

# 以安装deepseek-r1 70b模型为例:# 打开cmd终端,执行如下命令,然后等待下载完成即可:ollama run deepseek-r1:14b

# 查看已下载的模型ollama list# 运行模型ollama run deepseek-r1:14b

本文内容就到这啦,阅读完本篇,相信你也了解如何本地化部署deepseek模型啦!赶紧本地部署一个试试吧!

文章转载自呆呆的私房菜,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。