点击下方卡片,关注“慢慢学AIGC”

摘要

这是一篇关于人工智能训练方法的文章,重点介绍监督微调(SFT)和基于人类反馈的强化学习(RLHF)。以下为正文(内容由 AI 生成)。

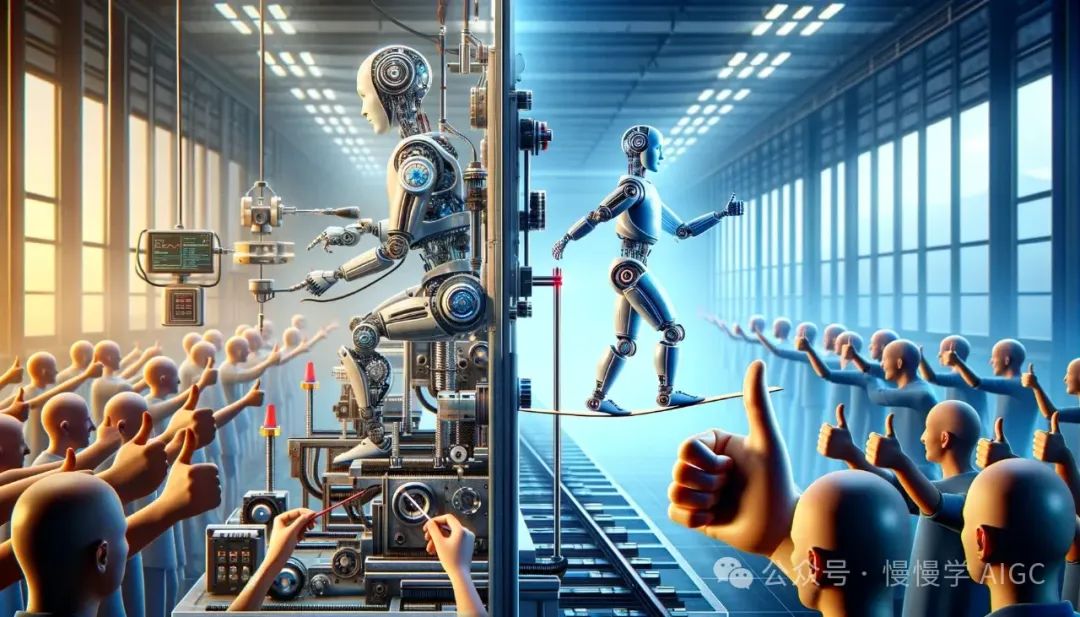

在复杂多面的人工智能(AI)世界中,理解训练方法的细微差别对任何想要深入这个领域的人来说都至关重要。监督微调(SFT)和基于人类反馈的强化学习(RLHF)是两种最受关注的训练方法。每种方法都为AI模型如何学习、适应和进化提供了独特的视角,使它们适用于各种应用。

监督微调(SFT)

想象一下教一个孩子如何识别不同类型的水果。你给他们看一个苹果并说:"这是苹果",然后给他们看一根香蕉并告诉他们:"这是香蕉"。监督微调的工作原理类似。在这里,AI 模型就像那个孩子,从明确标记的例子中学习。例如,在图像识别中,模型通过成千上万张图像进行训练,每张图像都标有其代表的内容,如"猫"、"狗"或"汽车"。模型通过将其预测与这些标签进行比较来学习,并调整其参数以减少其猜测和实际标签之间的差异。

这种方法对于答案明确的任务特别有效。例如,在电子邮件过滤中,AI 通过数千封电子邮件进行训练,每封邮件都标记为"垃圾邮件"或"非垃圾邮件"。模型学会识别区分垃圾邮件和常规邮件的模式。然而,SFT 的局限性在于需要大量且标记良好的数据集。创建这样的数据集可能需要大量资源和时间。此外,如果训练数据没有涵盖特定场景,模型可能难以正确响应,突显了泛化能力的潜在问题。

基于人类反馈的强化学习(RLHF)

现在,想象一下教一个孩子下棋。你不会给他们列出每种可能情况下的正确和错误走法,相反,你会引导他们完成游戏,表扬好的走法并阻止坏的走法。RLHF 的运作原理与此类似。AI 模型通过与环境互动并接收反馈来学习,这种反馈不是来自静态数据集,而是来自真实世界的经验和人类引导的奖励或惩罚。

RLHF 的一个典型例子是训练 AI 玩复杂游戏,如围棋或国际象棋。AI 做出移动,接收关于这些移动的反馈,并逐渐学习改进其游戏策略。另一个应用是在自动驾驶车辆中,AI 从各种驾驶场景中学习。它对安全操作获得正面反馈,对危险或错误操作获得负面反馈。RLHF 的灵活性使其在预定义每种可能情况和正确响应不切实际的任务中变得强大。然而,设计有效的奖励系统具有挑战性且至关重要,设计不当的系统可能导致 AI 养成不良行为。此外,提供一致、无偏见的人类反馈的过程是劳动密集型的,并可能引入自身的一系列偏见。

深入比较:SFT vs RLHF

虽然 SFT 为 AI 训练提供了一种结构化方法,适用于答案明确且数据丰富的问题,但它可能受到训练数据范围和质量的限制。相比之下,RLHF 虽然更灵活,更适应复杂和不可预测的场景,但需要仔细设计奖励系统并需要大量人工参与。

在 SFT 中,风险在于训练数据中的潜在偏见。例如,如果图像识别模型主要在白天拍摄的动物图片上训练,它可能难以识别夜间拍摄的同样动物。在 RLHF 中,挑战在于奖励设计,例如,如果训练玩游戏的 AI 对防守动作的奖励多于进攻动作,它可能过度关注防守,忽视游戏的其他方面。

SFT 和 RLHF 的选择取决于任务的性质。SFT 适用于环境可预测且数据丰富的场景,如手写识别,模型从大量手写文本及其转录中学习。另一方面,RLHF 更适合动态、不可预测的环境,如机器人导航,机器人必须学会在不同地形和障碍物中导航,这种场景下预标记的数据是不够的。

结论

掌握监督微调和基于人类反馈的强化学习的复杂性对于任何深入 AI 领域的人来说都至关重要。这些方法各有优缺点,适用于 AI 学习和问题解决的不同方面。在实践中,方法的选择通常取决于任务的具体需求和复杂性。有时,结合 SFT 和 RLHF 元素的混合方法可能提供最有效的解决方案。无论你是初涉 AI 的爱好者还是经验丰富的专业人士,全面了解这些方法对于驾驭复杂的 AI 训练和开发领域至关重要。

作者简介

权俊范(Joonbeom Kwon),初级全栈开发工程师,目前就读于加州大学伯克利分校。电子邮箱:joonbeom@berkeley.edu

自我介绍:凭借对创新和卓越的天然倾向,我已成功设计、开发并推出了多种项目,范围从金融应用到宝可梦搜索引擎。我卓越的快速掌握新技术的能力,结合我的热情、知识和毅力,使我能够自信地处理各种项目,并轻松适应新的挑战。作为一名初级全栈开发者,我渴望利用我的技能和经验,为任何组织显著推动成功、增长和创新。