点击下方卡片,关注“慢慢学AIGC”

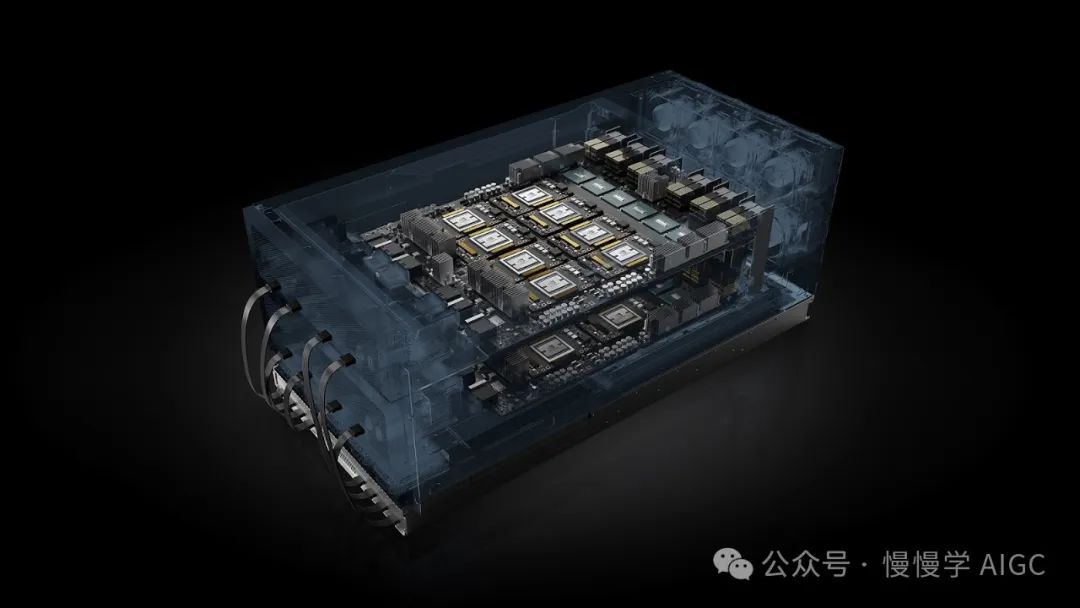

续上一篇《英伟达 DGX 产品:十年谋划,步步为营》。本文将回顾英伟达 HGX 历代产品的详细参数,分析 DGX 和 HGX 的区别和联系。

HGX 1 & 2

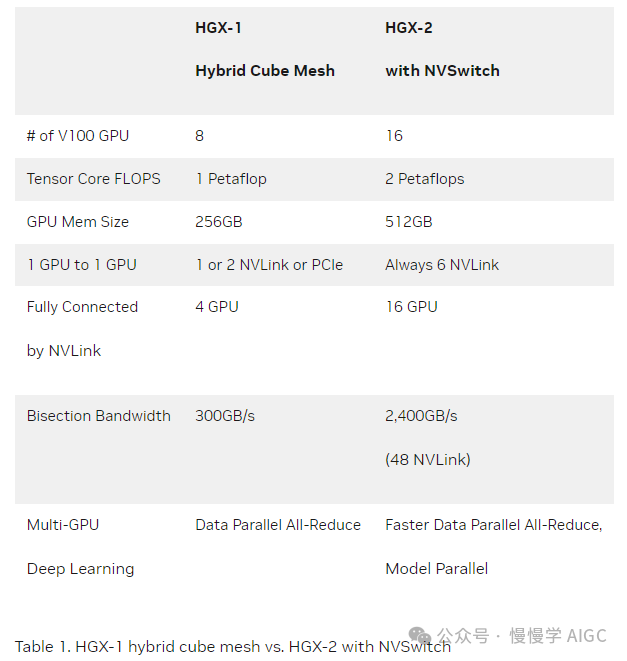

HGX-1 和 HGX-2 均采用 V100 加速器。详细参数如下表:

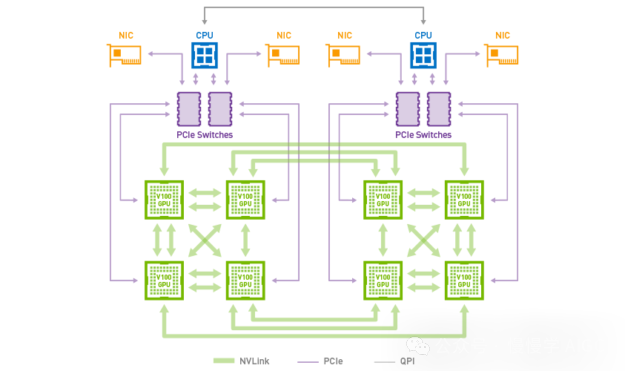

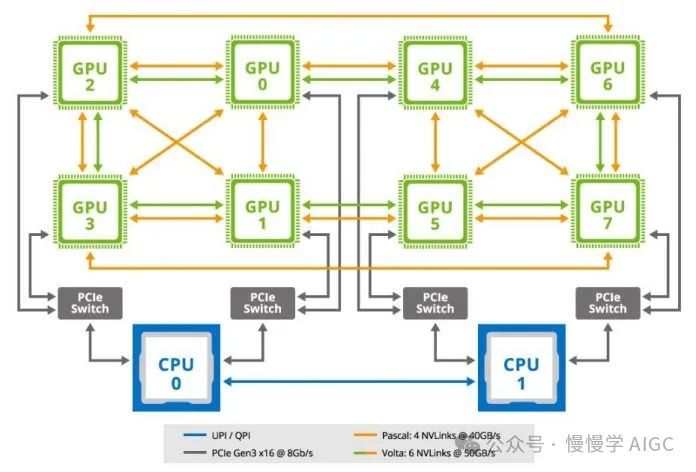

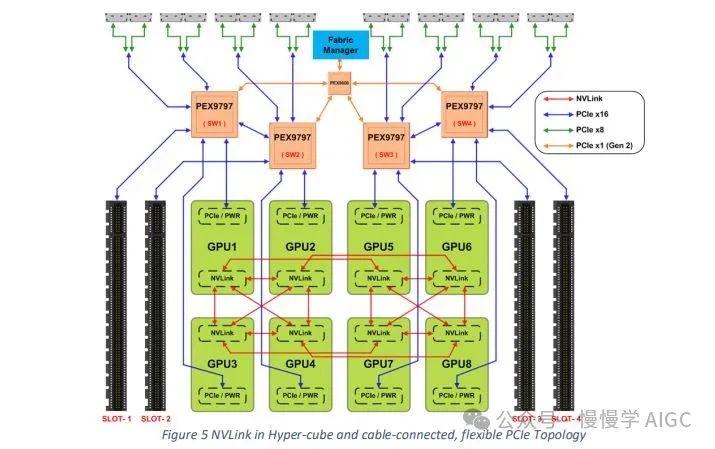

除了 V100 数量区别(8 vs 16),在 GPU 互联上也有较大差异。HGX-1 采用混合立方体网格(hybrid cube mesh)拓扑,和 DGX-1 类似,架构如下图所示。

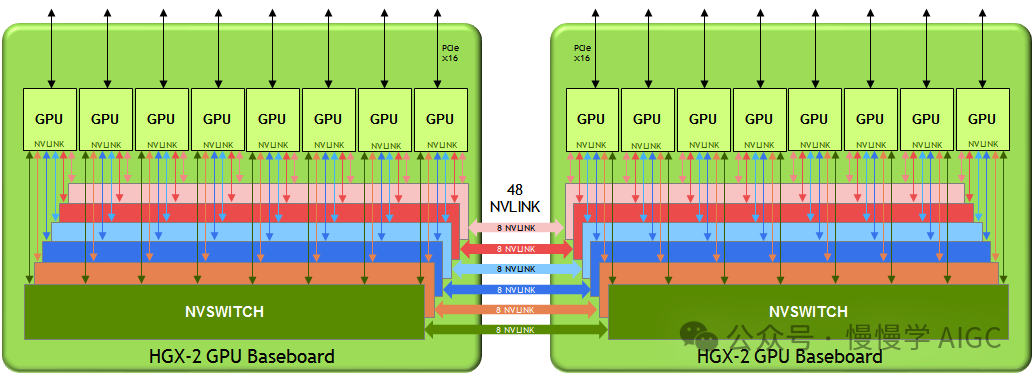

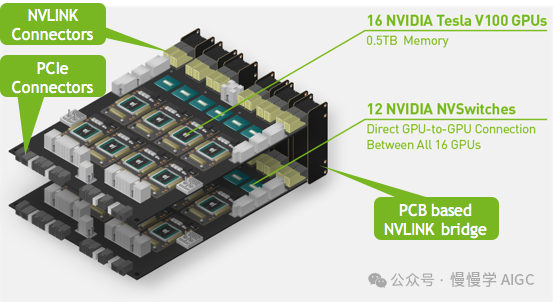

而 HGX-2 则采用 NVSwitch 实现全互联拓扑。该拓扑结构使得所有 16 个 V100 Tensor Core GPU 都可以完全连接,每个 GPU 都可以同时以 300 GB/s 的全 NVLink 速度与任何其他 GPU 通信。

信息来源:Nvidia 博客[3]

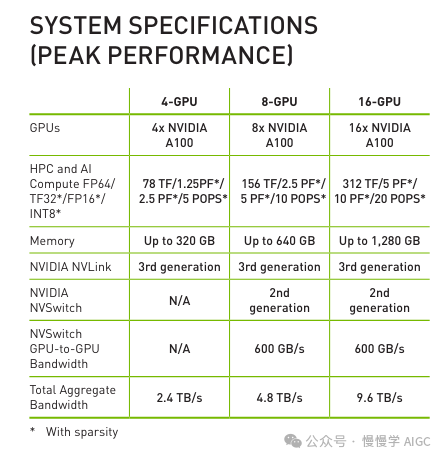

HGX A100

Nvidia 和全球合作伙伴于 2021 年推出 HGX A100 系统,增加了三项关键技术:A100 80GB PCIe GPU、NVIDIA NDR 400G InfiniBand 网络和 NVIDIA Magnum IO GPUDirect Storage 软件。Atos、戴尔科技、惠普企业(HPE)、联想、微软 Azure 和 NetApp 等数十家合作伙伴正在使用 NVIDIA HGX 平台开发下一代系统和解决方案。

信息来源:Nvidia 博客[2]。

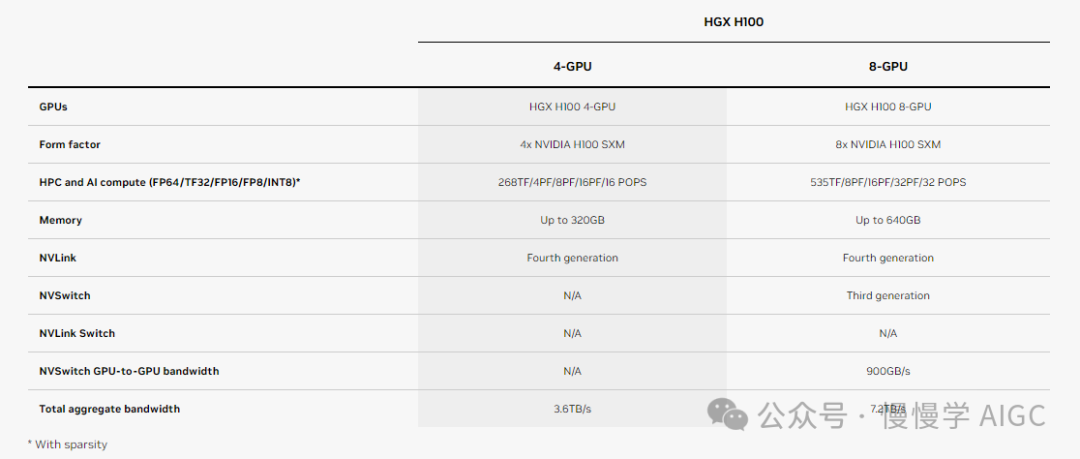

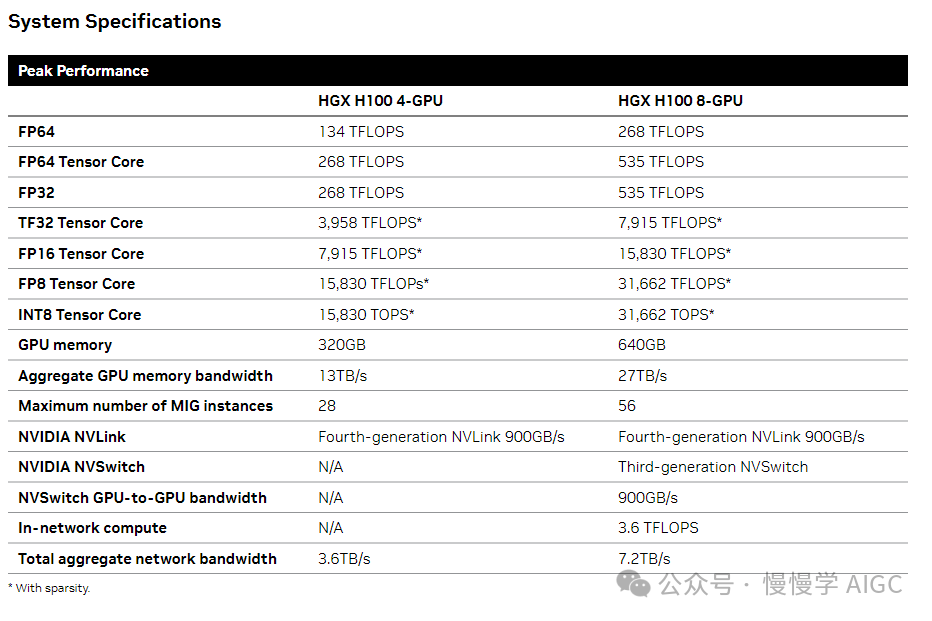

HGX H100

HGX H100 发布于 2022 年。H100 支持 FP8 精度,相比上一代 A100 性能提升 6 倍。

信息来源:Nvidia 官网[1]。

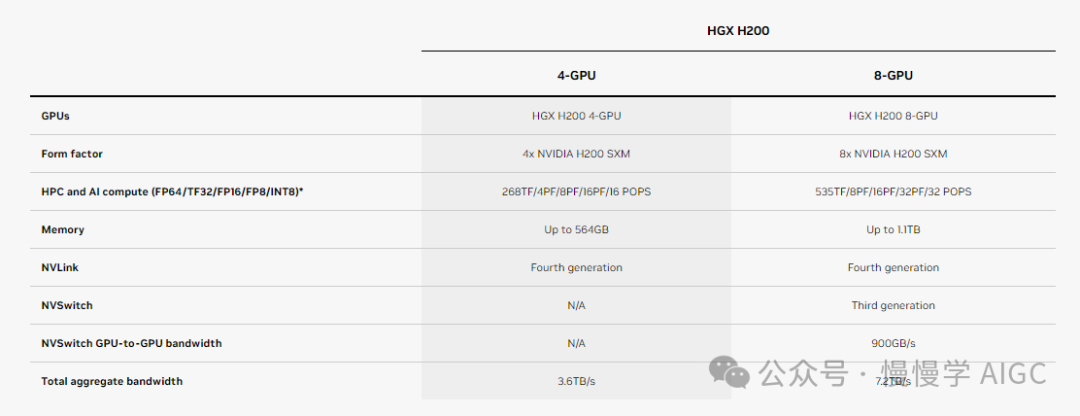

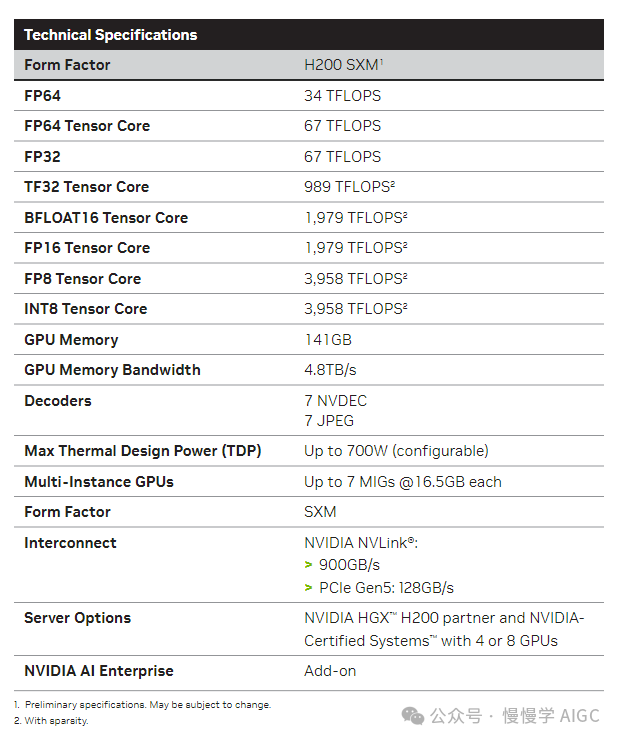

HGX H200

HGX H200 和 H100 最大的区别在于显存容量。单卡容量从 80 GB 升级到 141 GB,整机容量(8 卡为例)从 640 GB 升级到 1128 GB。

信息来源:Nvidia 官网[1]。

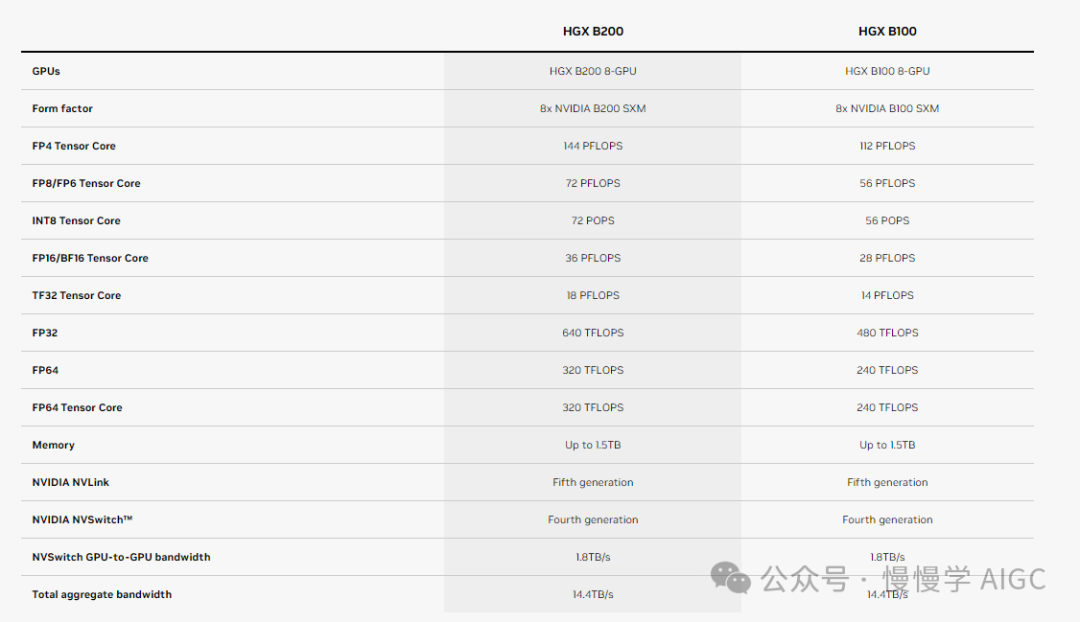

HGX B200 & B100

2024 年 GTC 上 Nvidia 发布了 Blackwell 架构 GPU 和相应的服务器级、数据中心级产品。

信息来源:Nvidia 官网[1]。

NVIDIA DGX 与 NVIDIA HGX 有何不同

信息来源:STH 博客[5]。

NVIDIA DGX 与 NVIDIA HGX 的区别是什么?这是我们经常被问到的一个问题。虽然名字听起来相似,但它们是 NVIDIA 销售其配备 NVLink 的 8 GPU 系统的不同方式。NVIDIA 的商业模式在 NVIDIA P100 "Pascal"和V100 "Volta" 代产品间发生了变化,那时 HGX 模式真正兴起,以至于在A100 "Ampere" 和 H100 "Hopper" 代产品中占据一席之地。

首先,当前的 NVIDIA DGX 和 HGX 产品线都是通过 NVLink 连接的 8 GPU 平台。NVIDIA 还有其他板卡,如称为 Redstone 和 Restone Next 的 4 GPU 组件,但主要的 DGX/HGX(Next) 平台都是采用 SXM 的 8 GPU 平台。

回顾过去,我们需要看看组装一个 NVIDIA Tesla P100 8x SXM2 GPU 系统的过程。这是我们为 "DeepLearning12" 项目准备时在会议室桌子上的场景。

组装过程是,每个制造商都会为 GPU 构建自己的主板。然后 NVIDIA 会出售 SXM 版本的 GPU,再由服务器制造商(或 STH)将 GPU 安装到服务器中。

这个过程并不容易。据说有一家位于德克萨斯州的大型服务器制造商在散热器上涂抹了过厚的导热膏,导致许多托盘上的 GPU 损坏。我们将视频标题命名为"为什么 SXM2 安装太烂?"是有充分理由的。由于扭矩要求,安装 GPU 是件艰难的工作。

转到 Volta 代系列的 NVIDIA Tesla V100 时,NVIDIA 增加了更多的 NVLink。

作为这一过程的一部分,NVIDIA 对整个 8x SXM GPU 平台进行了标准化,包括 Broadcom PCIe 交换机用于主机连接(后来还包括 Infiniband 连接)。

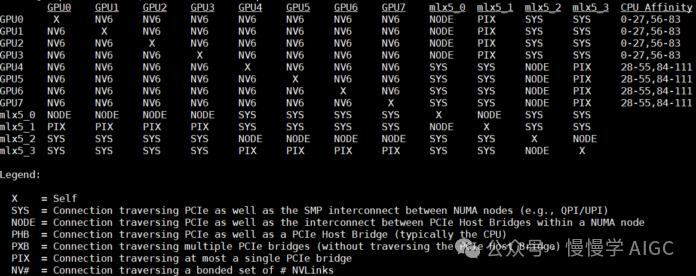

它还增加了 NVSwitch。NVSwitch 是 NVLink 架构的一个交换机,允许 GPU 之间更高性能的通信。最初,NVIDIA 的想法是将这两块标准化的主板放在一起,使用更大的交换机架构。但影响是,现在 NVIDIA GPU 到 GPU 的通信将发生在 NVIDIA NVSwitch 芯片上,而 PCIe 将采用标准化的拓扑结构。于是 HGX 诞生了。

这里是 2020 年左右一篇服务器评测中 8 个 NVIDIA V100 的样子。那也是 NVIDIA SXM 冷却器最好的配色方案。如果你看看上面的 P100 版本,你会发现 Gigabyte 服务器上使用的是无品牌的 SXM2 散热器。这是因为 NVIDIA 走得更远了一步。它不仅制作了带 SXM3 插座的 NVSwitch 主板,还会安装 GPU 和冷却器。

这产生了巨大的影响。现在,服务器供应商可以直接从 NVIDIA 购买 8 GPU 组件,而不用冒被过厚导热膏层毁坏 GPU 的风险。这也意味着 NVIDIA HGX 拓扑诞生了。服务器供应商可以在其周围放置任何金属机箱。它们可以配置 RAM、CPU、存储等。这一切都建立在这样的理解上:GPU 部分采用固定的 NVIDIA HGX 主板拓扑。

这种模式非常成功。在下一代产品中,NVSwitch 的散热器变大了,GPU 失去了出色的油漆工艺,但我们得到了 NVIDIA A100。

这块主板的代号是 "Delta"。

官方上,这款主板被称为 NVIDIA HGX。

在这一点上,NVIDIA、其 OEM 厂商和客户意识到,通过增加功耗,相同数量的 GPU 可以完成更多工作。但也有一个陷阱,更高的功耗意味着更多的热量。这就是为什么我们开始看到液冷式 NVIDIA HGX A100"Delta" 平台的原因。

这确实是一个挑战,因为 NVIDIA HGX A100 组件最初是采用"NVIDIA"风冷散热器推出的。

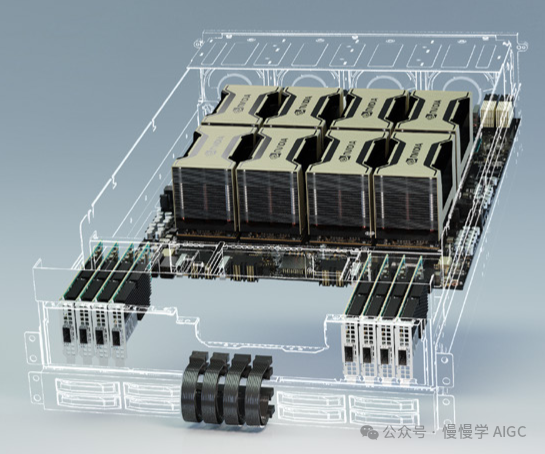

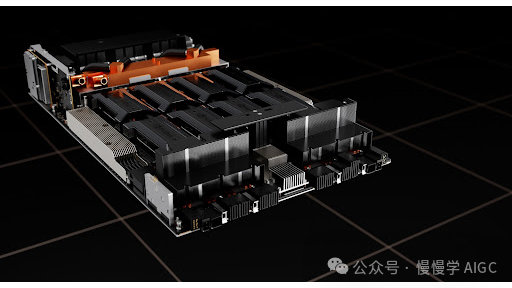

在最新的"Hopper"代系列中,为了容纳更高功率的 GPU 以及更高性能的 NVSwitch 架构,散热器的高度不得不增加。这就是 NVIDIA HGX H100 平台"Delta Next"。

NVIDIA 还为 HGX H100 提供液冷选项。

到这里,我们已经介绍了许多不同 NVIDIA HGX 平台和不同供应商。在这一点上,值得指出 NVIDIA DGX 究竟是什么。自 P100 时代以来,NVIDIA 就一直有 DGX 版本,但 NVIDIA DGX V100 和 DGX A100 代系列使用的是 HGX 主板,然后 NVIDIA 围绕 DGX 构建了整个服务器。NVIDIA 一直在更换每一代 DGX 所使用的 OEM,但它们大多是固定配置。

随着 NVIDIA DGX H100 的推出,NVIDIA 又向前迈进了一步。它有新的 NVIDIA Cedar 1.6Tbps Infiniband 模块,每个模块都配备了四个 NVIDIA ConnectX-7 控制器。在收购 Mellanox 之后,NVIDIA 正在加大对 Infiniband 的支持力度,这正是一个很好的例子。

虽然 NVIDIA DGX H100 可以说是 GPU 设计的黄金标准,但有些客户还想要更多。这就是为什么 NVIDIA 除了提供一个可以捆绑专业服务的平台之外,还推出了 HGX H100 平台,以便 OEM 厂商可以定制。我们已经看到了许多不同的设计,其中包括更密集的解决方案、基于 AMD 或 ARM 的 CPU 解决方案(提供更多核心)、不同的 Xeon SKU 级别、不同的 RAM 配置、不同的存储配置,甚至不同的 NIC。

也许最简单的理解方式是,NVIDIA DGX 系列是 NVIDIA 的标准产品。它仍然是围绕 NVIDIA HGX 8 GPU 和 NVSwitch 主板构建的,但它是一种 NVIDIA 专门设计。DGX 的发展趋势是 NVIDIA 在网络层面提供更高级别的集成,以便将 DGX 系统安装到 DGX SuperPOD 等集群中。

通过 HGX 主板,NVIDIA 消除了在高速 NVLink 和 PCIe 交换机架构上连接 8 GPU 所需的大量工程工作。然后它允许 OEM 合作伙伴构建定制配置,同时 NVIDIA 可以以更高的利润定价销售 HGX 主板。NVIDIA 推出 DGX 的目标与其许多 OEM 合作伙伴不同,因为 DGX 被用于针对高价值 AI 集群和围绕这些集群的生态系统。

希望这有助于理解,但最简单的概念是:

NVIDIA HGX 是 8 个 GPU 和 NVSwitch 主板

NVIDIA DGX 是 NVIDIA 的系统品牌(这里不讨论 DGX Station)

自从 OpenAI 和 ChatGPT 使用这些平台的消息曝光后,NVIDIA HGX A100 和 HGX H100 一直是热门商品。

作者简介

Patrick Kennedy

Patrick 自 2009 年以来一直在运营 STH(ServethehHome),涵盖广泛的中小企业和家庭办公IT主题。Patrick 是技术行业的顾问,曾与硅谷的众多大型硬件和存储供应商合作。STH 的目标很简单,就是帮助用户找到一些有关服务器、存储和网络构建模块的信息。

参考文献

[1] https://www.nvidia.com/en-us/data-center/hgx/

[2] https://nvidianews.nvidia.com/news/nvidia-and-global-partners-launch-new-hgx-a100-systems-to-accelerate-industrial-ai-and-hpc

[3] https://developer.nvidia.com/blog/hgx-2-fuses-ai-computing/

[4] https://developer.nvidia.com/blog/introducing-nvidia-hgx-h100-an-accelerated-server-platform-for-ai-and-high-performance-computing/

[5] https://www.servethehome.com/nvidia-dgx-versus-nvidia-hgx-what-is-the-difference/

点击下方卡片,关注“慢慢学AIGC”