随着deepseek的爆火,deepseek的访问量剧增,经常出现服务器繁忙的情况,受不了怎么办,小编给大家分享在本地部署deepseek的方法,告别服务器繁忙的问题。过程简单,点点鼠标就部署好了,快来试试吧!

1.安装Ollama

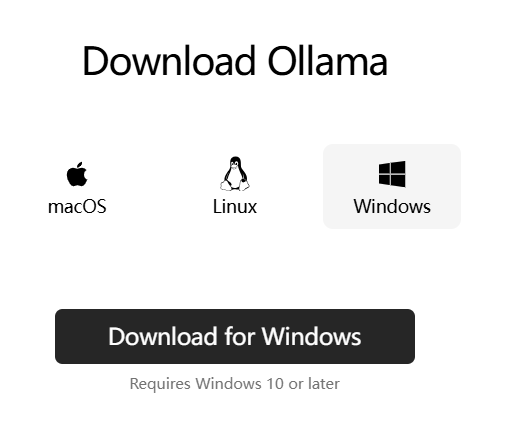

在Ollama官方网站(https://ollama.com/)下载并安装ollama工具,这是一个为快速部署和运行大型语言模型而设计的免费的工具。

根据不同的操作系统,下载Ollama安装包。

下载下来的安装包打开并安装,安装界面很简单,安装完成后,接下来我们就可以通过Ollama来安装Deepseek了。

2.安装Deepseek

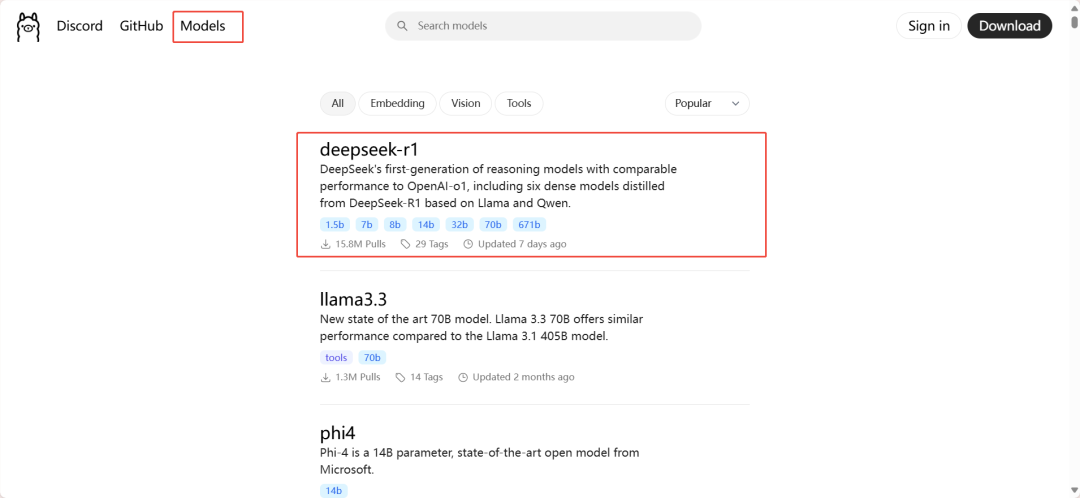

再次进入Ollama官网,点击左上角的Models,然后选择deepseek-r1

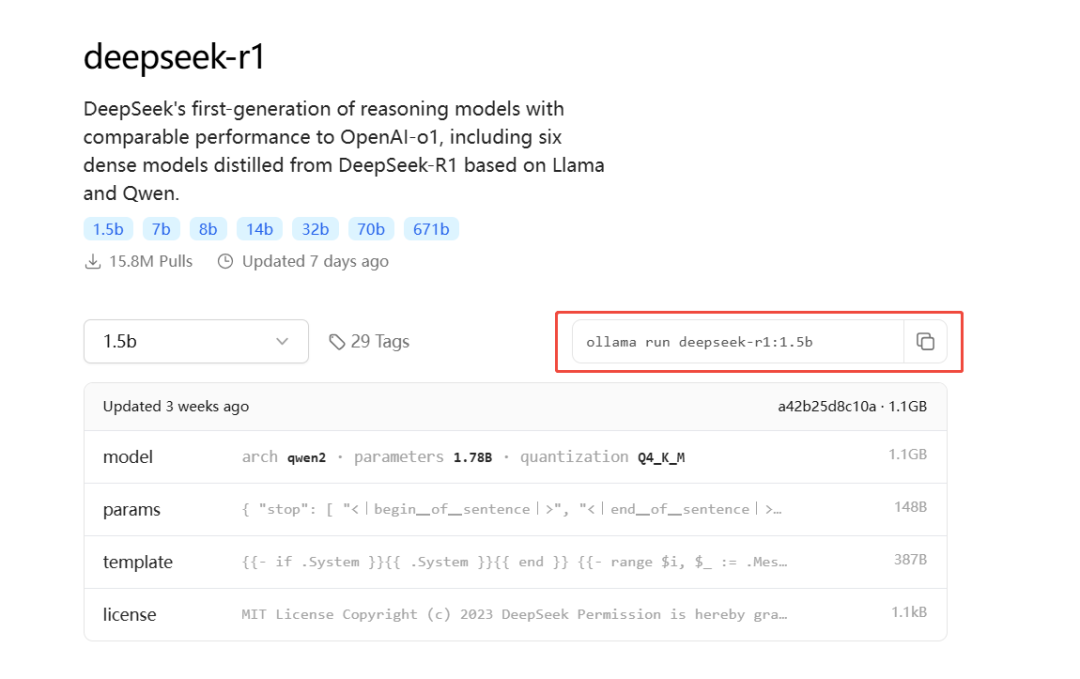

可以看到deepseek-r1的模型大小提供了7个选择,小编这里选择的是1.5b大小的模型,大家可以根据自己硬件情况来选择合适大小的模型,模型越大,模型的理解和生成能力越强。

选择模型大小后,可复制生成的命令到命令行界面执行,小编安装1.5b大小的模型的命令如下:

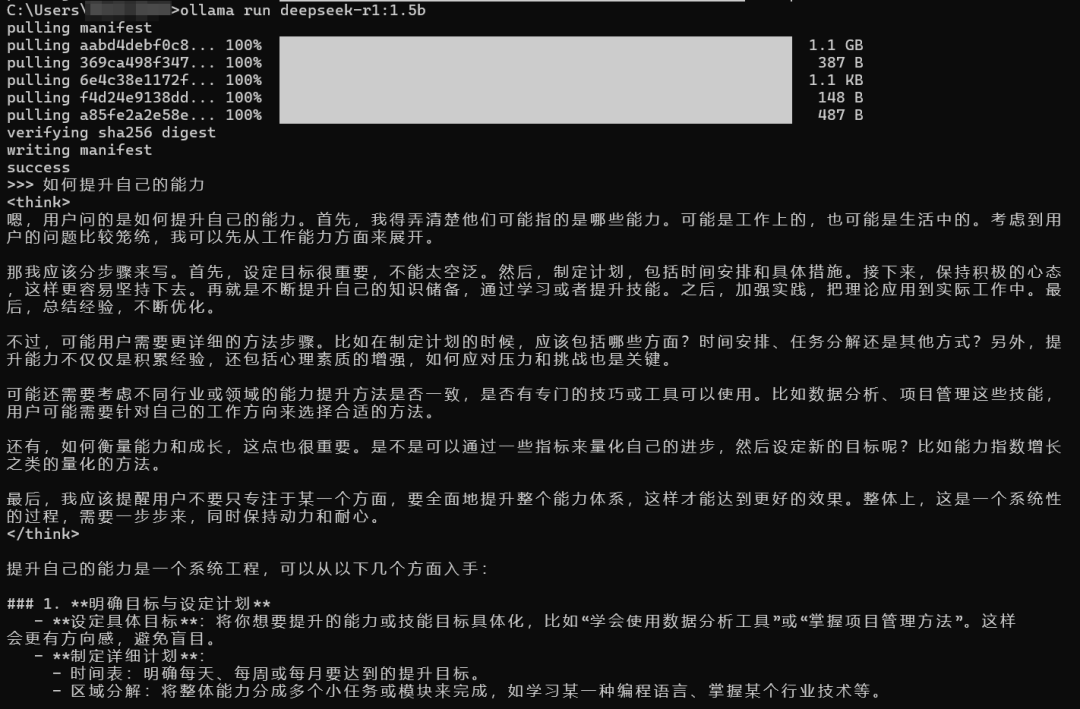

ollama run deepseek-r1:1.5b

安装后即可在命令行界面和deepseek-r1对话了。

3.安装chatbox

虽然已经可以和deepseek在命令行中对话了,但这个页面显然不够友好,我们需要一个美观的聊天窗口,这里我们使用chatbox来与本地的deepseek对话。

访问chatbox官网:https://chatboxai.app/zh,

下载对应操作系统的chatbox安装包,进行安装。

安装后打开chatbox,会提示选择AI模型提供方,我们这里选择“使用自己的API Key或本地模型”

然后选择Ollama API,在模型处选择我们刚才下载的deepseek-r1:1.5b

设置好后点击保存,就可以在chatbox上与本地部署的deepseek大模型对话了。

END

点击关注乘数科技

点击关注乘数科技

扫码添加乘数小助手微信号

邀您进入《PostgreSQL修炼之道:从小工到专家》

读者技术交流群

加入我们