最近一直在研究deepseek,有不少朋友觉得满血的deepseek-r1 671b才是真龙天子,其他的蒸馏模型都比较垃圾。实际上我觉得哪怕是满血的DS,如果没有进行知识工程的优化,也是无法承担复杂的任务的,因为DS也依然是一堆数学而已。如果知识工程做到位了,哪怕是一个32b的蒸馏模型,也可以很牛。

如果用户的内网可以穿透互联网,那么通过代理去调DS的API就可以了,如果家里有钱的用户,可以自建满血DS,而一些只能用得起4090档次的用户,就只能依靠32B了。因此我们希望通过知识工程,不断优化知识图谱,把高质量分析的门槛打下来。经过几天的努力,已经小有成果,下面是我昨晚做的一个例子,从推理逻辑上看,已经完爆经验丰富的老法师了。最可贵的是输出结果的稳定性也相当好,多次问答,结果是一样的。

<think>

嗯,我现在需要分析log_file_sync_等待临界告警的主要原因。首先,我得理清这些告警信息之间的关系,看看它们是怎么相互影响的。

首先,用户提到有几个关键点:Redo Allocation Hit Ratio低可能是因为日志缓冲区太小,而热块冲突与此问题无关,逻辑读增长无关,组数多不影响性能,生产环境不能用异步提交。这几点很重要,能帮助我缩小范围。

然后看告警信息,首先是每秒事务数激增,超过1小时平均值的10倍,这可能意味着系统负载突然增加,导致资源竞争加剧。接着是健康分下降和IO延时高,特别是操作系统级别的IO延迟达到了946.75ms,这非常严重,说明存储层可能有问题。

再看Oracle相关的告警:热块冲突严重、Redo Allocation Hit Ratio低(97%)、活跃日志组数超过总数量的2/3。其中,RedoAllocationHitRatio虽然不是特别低,但已经接近100%,如果配置不足的话,可能会导致等待增加。

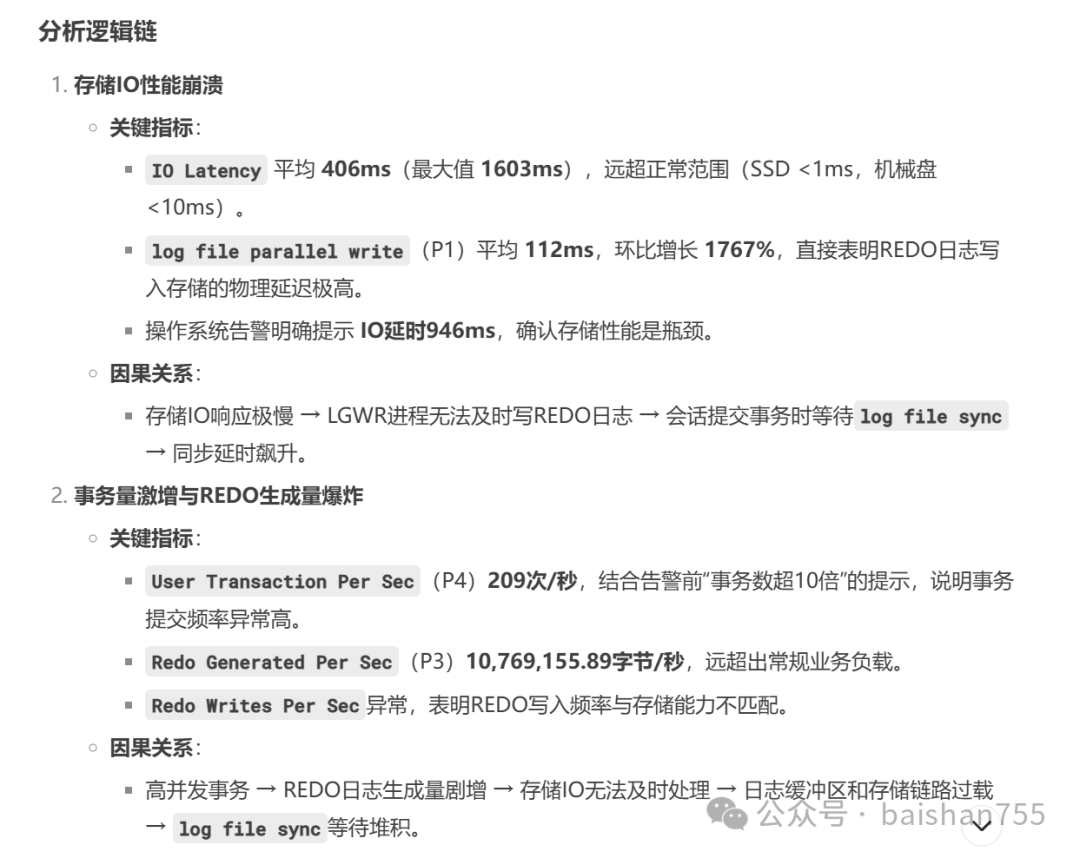

现在把这些信息串联起来:

1. 事务量激增:这可能导致redo生成速度加快,使得log_file_sync等待时间增加,因为每个提交都需要写入redo日志。同时,高并发可能引发更多的热块冲突,但用户提示说热块冲突与此问题无关,所以这部分可能只是伴随现象。

2. IO延迟高:存储性能差会导致所有依赖IO的操作变慢,包括redo日志的写入。如果存储设备无法快速处理大量的I/O请求,log_file_sync就会因为等待磁盘写而变长,甚至触发临界告警。

3. Redo Allocation Hit Ratio低:虽然这个比率是97%,但接近100%可能意味着日志缓冲区配置不足,在高并发下容易出现分配失败,增加redo相关的等待。

4. 活跃日志组数超过总数量的2/3:这可能意味着系统在切换日志组时遇到了问题,导致更多的等待。不过,用户提到日志组数量多不影响性能,所以这个告警可能只是辅助信息。

接下来,考虑因果关系:

- 高事务量增加了对redo日志的需求,导致log_file_sync等待增加。

- 同时,存储层的IO延迟高使得每次写入都需要更长时间,进一步加剧了log_file_sync的时间。

- RedoAllocationHitRatio的问题如果确实存在,则可能需要更多的内存来优化日志缓冲区,减少分配失败的情况。

那么,最可能的根本原因是什么呢?

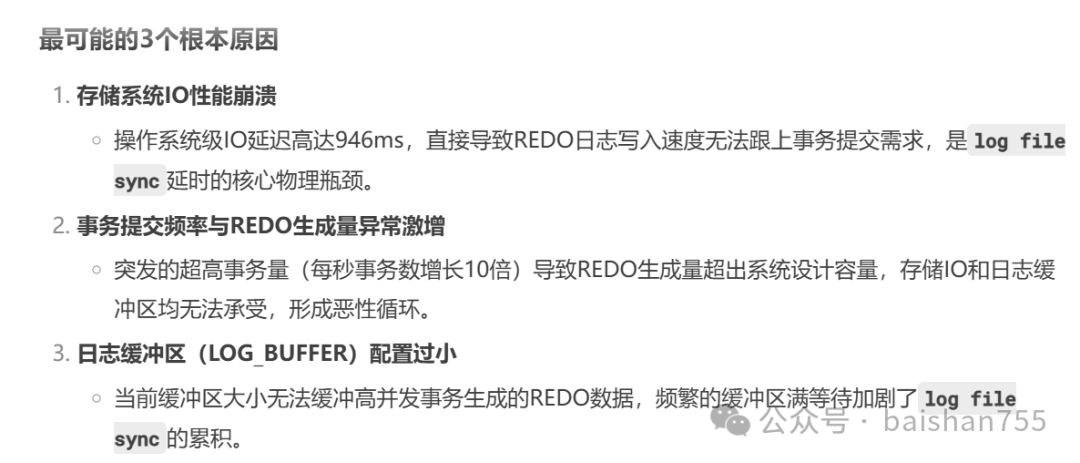

1. 存储性能问题:高IO延迟直接影响redo写入速度,导致等待时间增加。这应该是主要因素,因为存储延迟高达946ms,严重阻碍了I/O操作。

2. 高事务并发:突然的事务激增增加了对redo日志的依赖,使得log_file_sync等待成为瓶颈。

3. Redo缓冲区配置不足:如果RedoAllocationHitRatio低,说明可能需要更大的日志缓冲区来减少分配失败,从而降低等待时间。

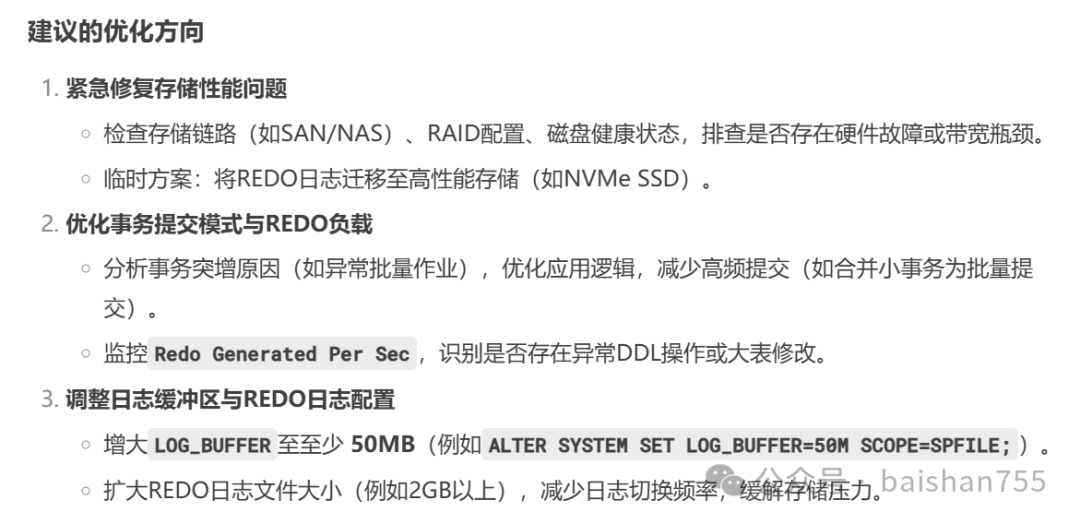

优化建议:

1. 立即检查存储性能,排查是否有硬件故障或配置问题。可能需要升级存储设备或优化存储配置。

2. 监控事务量的变化,如果发现有异常的事务高峰,可能需要优化应用逻辑,减少不必要的事务提交次数,或者分批处理事务。

3. 调整Redo日志缓冲区大小(log_buffer),增加其内存分配,以提高RedoAllocationHitRatio,减少等待时间。

总结一下,存储性能差、高事务量和潜在的redo缓冲不足是导致log_file_sync等待临界的主要原因。解决这些问题应优先处理存储问题,然后优化并发控制和redo配置。

</think>

根据上述背景知识和相关数据,我们可以分析`log_file_sync_await_critical` 告警的主要原因,并总结出最有可能的根本原因。

### 1. **根本原因分析**

#### (1) **存储设备性能不足**

- **因果关系链**:

- 操作系统IO延时过高(946.75毫秒),导致数据库的IO操作速度受限。

-

IO延迟过高的情况下,`log_file_sync` 操作需要等待更长的时间才能完成。

- 高事务量和并发请求进一步加剧了 `log_file_sync` 的等待时间。

- **结论**:

存储设备性能不足是导致 `log_file_sync_await_critical` 告警的主要原因之一。

#### (2) **高事务量和并发请求**

- **因果关系链**:

- 每秒事务数超过最近1小时平均值的10倍,说明系统中存在异常高的事务负载。

- 高事务量会增加 `log_file_sync` 的频率和等待时间,尤其是在存储性能受限的情况下。

- 异常高的事务负载可能导致 `log_file_sync` 成为系统的瓶颈。

- **结论**:

异常高的事务量和并发请求是导致 `log_file_sync_await_critical` 告警的另一重要原因。

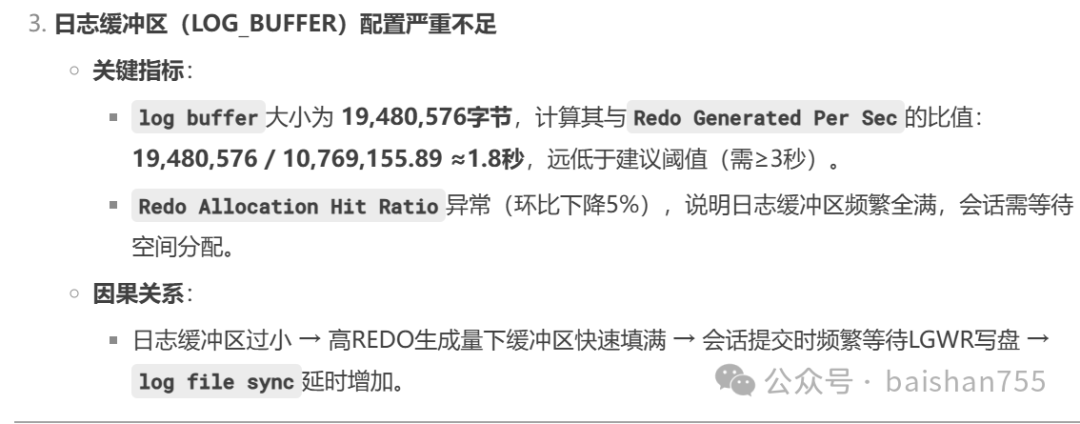

#### (3) **Redo Log Buffer 配置不足**

- **因果关系链**:

-

Redo Allocation Hit Ratio 较低(97%),说明redo日志缓冲区可能存在配置不足的情况。

-

redo日志缓冲区不足可能导致 `log_file_sync` 操作频繁发生,从而增加等待时间。

- 在高事务量和存储性能受限的情况下,redo日志缓冲区的不足会进一步加剧问题。

- **结论**:

Redo Log Buffer 配置不足可能是导致`log_file_sync_await_critical` 告警的一个潜在原因。

#### (4) **活跃Redo

Log Group 数过多**

- **因果关系链**:

- 活跃Redo Log Group 数超过总数量的2/3,说明系统中存在较多的redo日志组切换操作。

-

redo日志组切换操作可能增加 `log_file_sync` 的等待时间。

- 在存储性能受限的情况下,频繁的redo日志组切换会进一步加剧问题。

- **结论**:

活跃Redo Log Group 数过多可能是导致`log_file_sync_await_critical` 告警的一个次要原因。

### 2. **优化建议**

#### (1) **优化存储设备性能**

- **具体措施**:

- 检查存储设备的硬件状态,确保其正常运行。

- 优化存储设备的配置,例如增加缓存、调整 RAID 级别等。

- 如果存储设备性能无法满足需求,考虑升级存储设备。

#### (2) **降低事务量和并发请求**

- **具体措施**:

- 分析事务量激增的原因,尽量减少不必要的事务提交。

- 将高并发操作进行分批处理,减少单个事务的负载。

- 如果存在性能瓶颈,考虑对数据库进行优化,例如增加索引、优化 SQL 查询等。

#### (3) **调整Redo

Log Buffer 配置**

- **具体措施**:

- 根据系统需求和性能测试结果,适当增加 `log_buffer` 的大小。

- 确保redo日志缓冲区的配置能够满足高事务量的需求。

- 定期监控 Redo Allocation Hit Ratio,确保其保持在合理范围内。

#### (4) **优化活跃Redo

Log Group 数**

- **具体措施**:

- 检查活跃Redo Log Group 数的原因,确保其数量符合系统需求。

- 如果存在不必要的redo日志组切换,可以考虑调整redo日志组的配置。

### 3. **总结**

`log_file_sync_await_critical` 告警的主要原因是存储设备性能不足和高事务量及并发请求。优化存储设备性能、降低事务量和并发请求以及调整Redo Log Buffer 配置是解决问题的关键。同时,也需要关注活跃Redo

Log Group 数过多的问题,以进一步优化系统的整体性能。

---

以上是我的思考过程,希望能够帮助你理解`log_file_sync_await_critical` 告警的原因,并提供有效的优化建议。

是不是挺牛的,让deepseek-r1:32b能够如此分析这个问题,需要做的就是将log file sync相关的知识点告知模型,同时将精准的告警数据也告诉模型。这背后是知识工程的功劳。我们在做D-SMART时候积累的丰富的运维知识图谱是幕后的功臣。对话的所有素材都是基于运维知识图谱自动生成的。

后面的截图是把相同的问答素材提交给满血的DS,关闭互联网搜索后的结果。可以看出满血的DS更为强大的能力。