Ollama 大模型部署工具,可以让本地部署大模型变得简单又轻松。

Ollama介绍

Ollama 是一个轻量级开源的大型语言模型(LLM)服务工具,可以快速下载、运行大语言模型,并提供 API 供其他程序调用。它的目标就是简化在本地运行大语言模型的过程。不管你有没有GPU,只要你的电脑满足基本配置,就能用Ollama轻松部署像deepseek-r1系列、qwen2.5,Llama3、Phi4等很火的模型。

爆火程度

真的难以想象这么受欢迎,six。six。six~~~~~~

安装

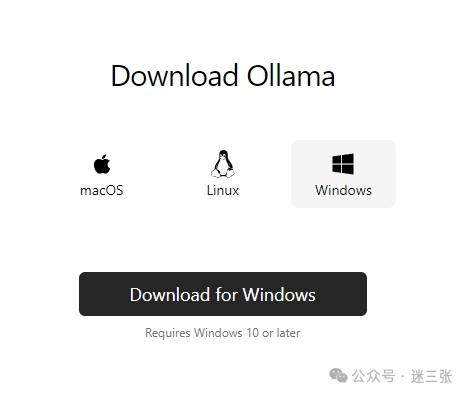

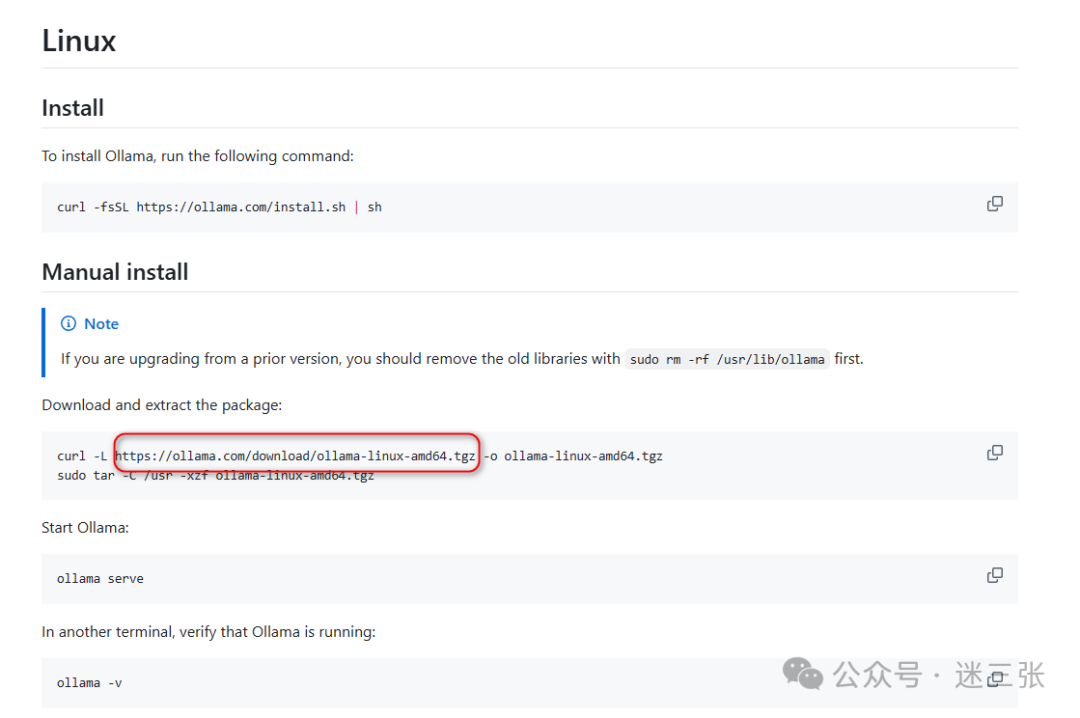

提供了三种安装方式 macOS、Linux、Windows,都是只需要几步,就能轻松上手,简直太简单!Linux/macOS:在终端输入

curl -fsSL https://ollama.com/install.sh | sh

,一键安装超简单。有时候因为网络原因一键安装太慢,可以采用半自动方式安装,先下载 https://ollama.com/download/ollama-linux-amd64.tgz

然后修改https://ollama.com/install.sh脚本中一小段

curl -o ollama_install.sh https://ollama.com/install.sh

vim ollama_install.sh将如下三行改为#curl --fail --show-error --location --progress-bar \#"https://ollama.com/download/ollama-linux-${ARCH}.tgz${VER_PARAM}" | \$SUDO tar -xzf ollama-linux-amd64.tgz -C "$OLLAMA_INSTALL_DIR"

Windows:去下载 Ollama Windows 版安装包,然后双击运行安装程序就行。

常用命令

启动 Ollama 服务:

ollama serve

(默认端口 11434 )。

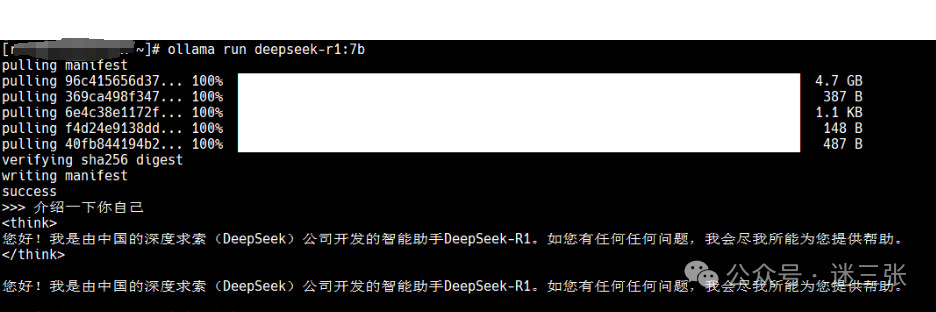

下载模型:

ollama pull <模型名>

,如下载 Deepseek,就输入ollama pull Deepseek

。

运行模型:

ollama run <模型名>

,之后开启对话模式。

管理模型:

ollama list

查看已下载模型;ollama rm <模型名>

删除模型;ollama help

查看所有命令。

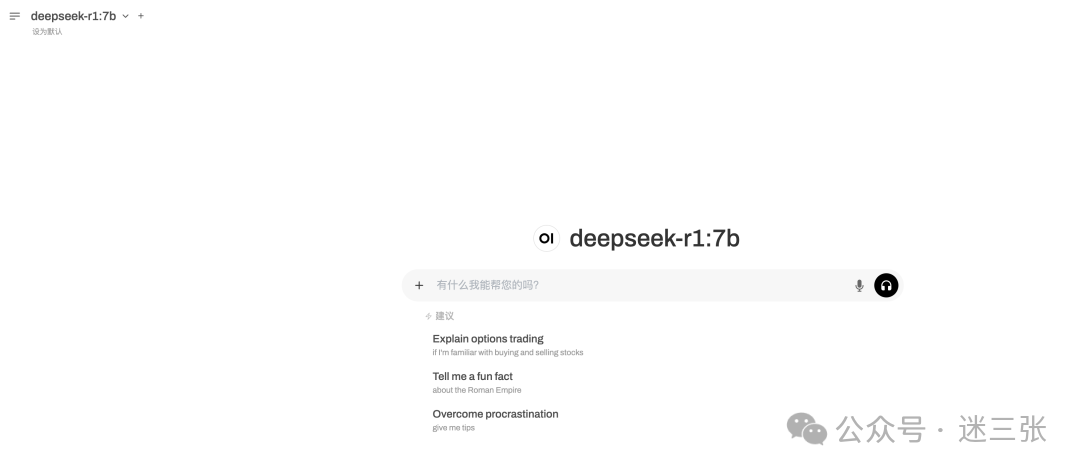

本地AI模型web-ui

open-webui Ollama标配图形化界面,进行docker安装,如果镜像下载不了可私信小编~~ docker run -d -p 80:8080 -e OLLAMA_BASE_URL=http://192.168.xx.xx:11434 -v /data/open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:maindocker logs -f open-webui安装后开始使用:

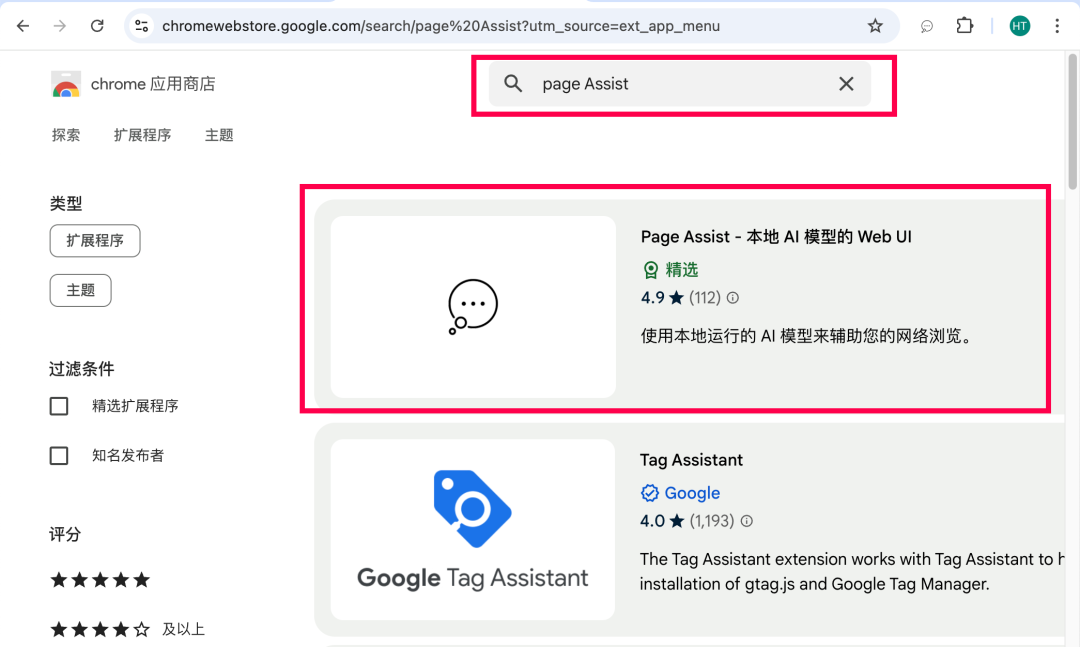

Page Assist 一款Chrome本地模型图形化插件,直接去Google应用商店进行搜索安装即可

欢迎微信扫描二维码,关注我的公众号~~

探索 AGI 的路上并不孤单,让我们一起携手并进,逐日摘星。

最后修改时间:2025-02-17 13:10:18

文章转载自迷三张,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。