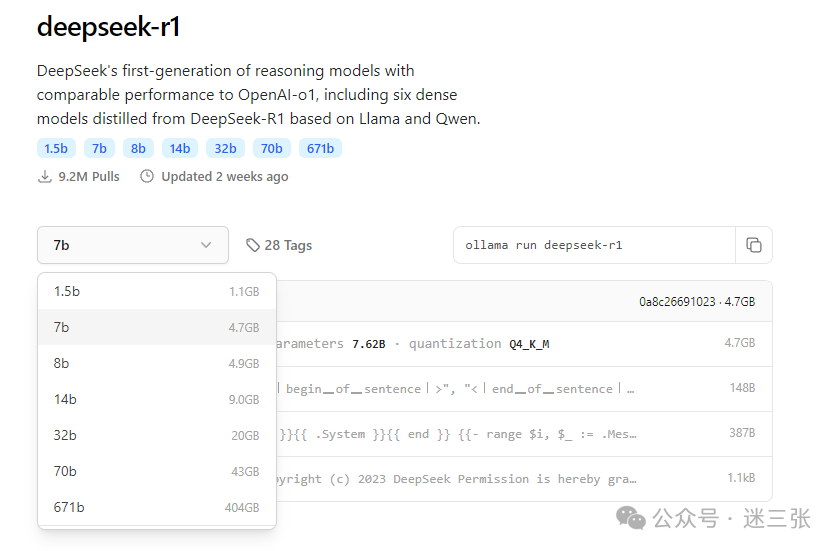

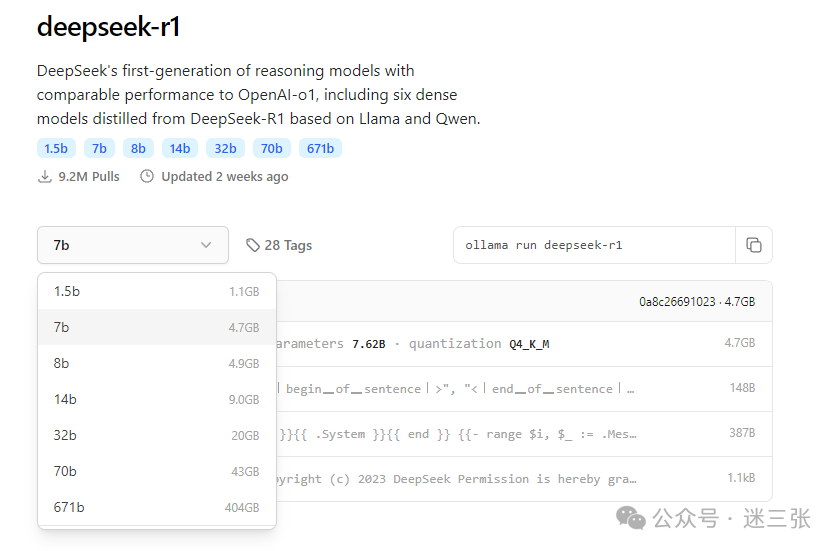

自从deepSeek-r1发布后,铺天盖地的从bilibili、公众号、各大网站推荐视频教程和文章来教学本地化部署。 但是我建议除非你能够部署671b版本的实力,其他的就不要再部署了,会和你期待的不一样。 deepSeek-r1 以ollama为例,提供的版本如下:相当于70b 大概需要用到 43G显存,671b大概需要用到404G显存~~~ 如果说你只是想搭建本地的个人知识库、个人翻译、个人文档内容总结集合可以选择 7b,8b,14b,32b(会经常忘记以前的内容);但是在深度思考和推理的过程中还是没有deepseek在线给力。 但是个人感觉真的没必要做这样的资源消耗,不是说AI-模型出来就替代了所有东西,市面上还是有很多好用的各个类型的办公软件或者知识管理平台~~~~不要盲目跟风。 当然如果说企业内部使用或者个人有足够的钱,部署全量的671b版本呢?可以从HuggingFace上获取原版,大概700G文件,为了能够使用,建议购买10张H100或者8张H200,差不多是200W+。 因此,用deepseek在线或者硅基流动提供的API进行对接,这难道不比ollama运行本地模型的方法还省事,省力,关键是省钱吗?

最后修改时间:2025-02-17 13:06:38

文章转载自

迷三张,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。