点击蓝色字关注“SQL数据库运维”,回复“SQL”获取2TB学习资源!

点击蓝色字关注“SQL数据库运维”,回复“SQL”获取2TB学习资源!

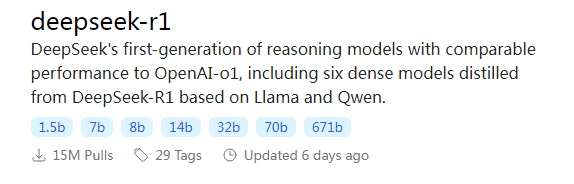

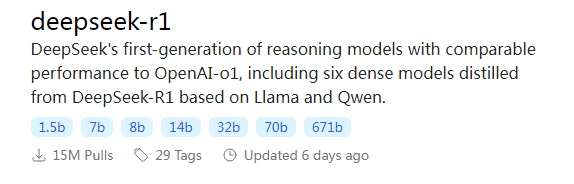

在人工智能(AI)的领域中,"大模型"是指参数量和数据量都非常庞大的深度学习模型。这些模型的参数数量通常达到数百万乃至数十亿,需要海量的数据和强大的计算资源来训练和推理。人工智能(AI)领域近年来取得了飞速的发展,各种技术不断突破,为我们的生活和工作带来了前所未有的便利。在众多前沿技术中,大型语言模型(Large Language Model,简称LLM)无疑是最引人注目的之一。你可能听说过一些以“B”结尾的术语,如6B、34B、70B和671B,这些数字到底是什么意思呢?具体来说,这里的“B”代表的是模型参数的数量级别,即“十亿”(Billion)的缩写,而前面的数字则表示具体的参数量。例如:这些参数是模型在训练过程中学习和调整的变量,它们决定了模型的复杂度和性能。参数越多,模型能够表示更复杂的关系,从而在任务上取得更好的效果。但与此同时,更多的参数也意味着需要更多的训练数据和计算资源。以GPT-3为例,它拥有1750亿个参数,而WuDao 2.0(悟道2.0)的参数数量更是高达1.75万亿。最近爆火国内外的DeepSeek大模型最高有6710亿个参数。这意味着后者可以学习更加复杂的数据模式,并在自然语言处理、机器翻译等任务上展现出更强的能力。然而,参数数量并不是衡量AI大模型性能的唯一指标。训练数据的质量、模型架构等因素也至关重要。大模型的训练和推理需要强大的算力支持。例如,使用GPU(图形处理单元)进行训练时,往往需要多个高端GPU甚至专门的硬件加速器来进行大规模的并行计算。此外,存储和读取这些海量参数也需要高效的内存管理和I/O优化。除了参数数量之外,其他一些技术细节如神经网络的层数、激活函数、优化器和学习率等也是影响模型性能的重要因素。例如,增加神经网络的层数可以增强模型的理解能力,但也会提高训练难度;不同的激活函数则提供了非线性变换的能力,使网络能更好地理解和学习复杂模式。在实际应用中,选择适合的模型参数量和其他超参数配置是一个权衡的过程。更高的参数量虽然可能带来更好的性能,但也会增加计算成本和时间开销。因此,研究人员通常会根据具体任务需求和资源限制,选择最合适的参数规模。AI大模型中的6B、34B、70B、671B等参数量代表了模型的规模和复杂度。随着技术的不断进步,我们期待看到更多创新且实用的大模型涌现,为人工智能领域的发展注入新的活力。

点击关注“SQL数据库运维”,后台或浏览至公众号文章底部点击“发消息”回复关键字:进群,带你进入高手如云的技术交流群。后台回复关键字:SQL,获取学习资料。

动动小手点击加关注呦☟☟☟

点击蓝色字关注“SQL数据库运维”,回复“SQL”获取2TB学习资源!

点击蓝色字关注“SQL数据库运维”,回复“SQL”获取2TB学习资源!

点击蓝色字关注“SQL数据库运维”,回复“SQL”获取2TB学习资源!

点击蓝色字关注“SQL数据库运维”,回复“SQL”获取2TB学习资源!