前言

上一篇文章,讲了DeepSeek-R1部署到本地的方法。这一篇文章,我们让DeepSeek再一次升级,通过图形化界面来交互,从而变成我们的AI助理,让DeepSeek R1发挥最大实力!

首选需要借助硅基流动的API接口,体验满血复活版的R1!还没有注册的去注册一下:

# 硅基流动API接口

https://cloud.siliconflow.cn/i/2Gy74qB6文档目的

当前文档主要目的是构建本地化AI助理,实现无网络和有网络也能够使用本地AI,并训练成为你的私人助理。由于当前文档仅作为演示,在最后本地化知识库搭建时,只需要上传文档后,再根据不同的文档进行提问进行训练。为提高DeepSeek响应速度,最好使用RTX 4060及以上显卡进行训练。

不同类型DeepSeek需求类型

注意:虽然此处写着不同级别的模型对应着不同的CPU、内存、硬盘核显卡等需求。但个人部署时不一定需要这个,硬件设备过低会影响计算效果,但偏差不会很大。可用于本地知识库搭建。

| 模型 | CPU | 内存 | 硬盘 | 显卡 |

| DeepSeek-R1-1.5B | 4核 | 8G | 50G | 非必须,可堆加CPU |

| DeepSeek-R1-7B | 8核 | 16G | 100G | RTX 3070 及以上 |

| DeepSeek-R1-8B | 8核 | 16G | 100G | RTX 3070 及以上 |

| DeepSeek-R1-14B | 12核 | 32G | 100G | RTX 4090 及以上 |

| DeepSeek-R1-32B | 16核 | 64G | 100G | 双RTX 3070或 A100 40GB |

| DeepSeek-R1-70B | 32核 | 128G | 150G | 多卡并行(4x RTX 4090或 2x A100 80GB) |

| DeepSeek-R1-671B | 64核 | 512G | 500G | 多节点分布式训练(8x A100/H100) |

当前环境配置信息

| 产品 | DeepSeek |

| 版本 | Deepseek-r1:14b |

| OS | Oracle Linux 7.8 |

| 内存 | 24G |

| 磁盘 | 100G |

| 显卡 | RTX 4060 |

智能助理来时的路

1、Linux安装 DeepSeek

注意:当前文档将不再演示Linux安装DeepSeek,请参照我之前的文档进行配置。

# Linux安装DeepSeek步骤

https://www.modb.pro/db/1887709942350622720联网配置

注意:目前本地化DeepSeek需要联网,必须安装DeepSeek:14b大模型,通过使用火狐+Page Assist插件完成本地化Deekseek访问互联网。

1、下载火狐浏览器

# 火狐浏览器下载地址

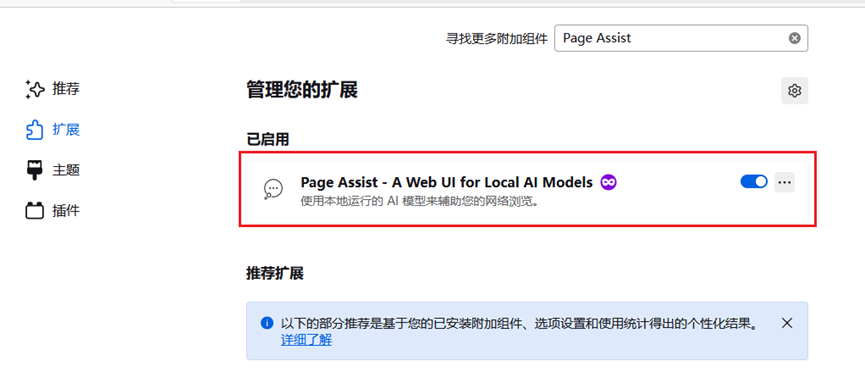

https://www.firefox.com.cn/2、火狐下载Page Assist – A Web UI for Local AI Models插件

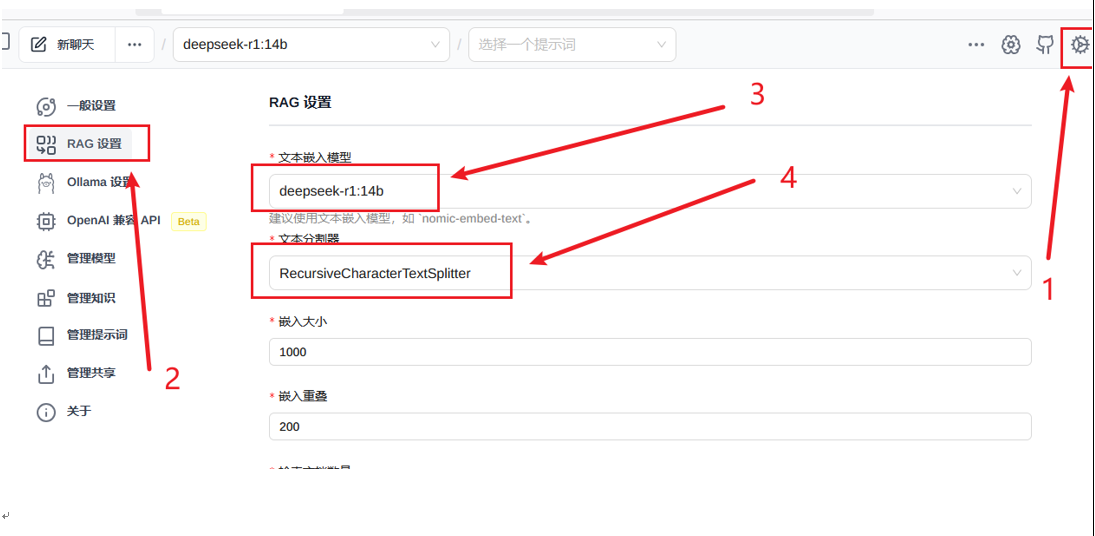

3、插件配置

注意:此处的插件配置请按照图片中数字指定步骤执行

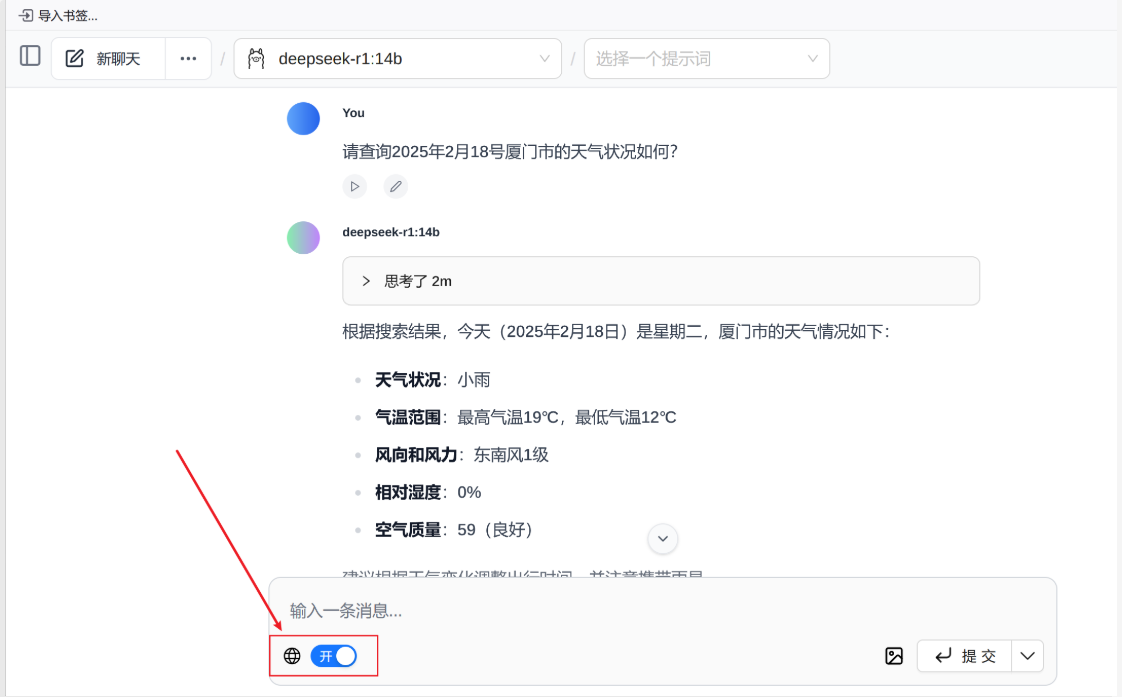

4、联网查询

注意:在联网查询时,输入问题后请将网络开关打开,根据不同的服务器配置,响应时间则不一样。敬候佳音即可。

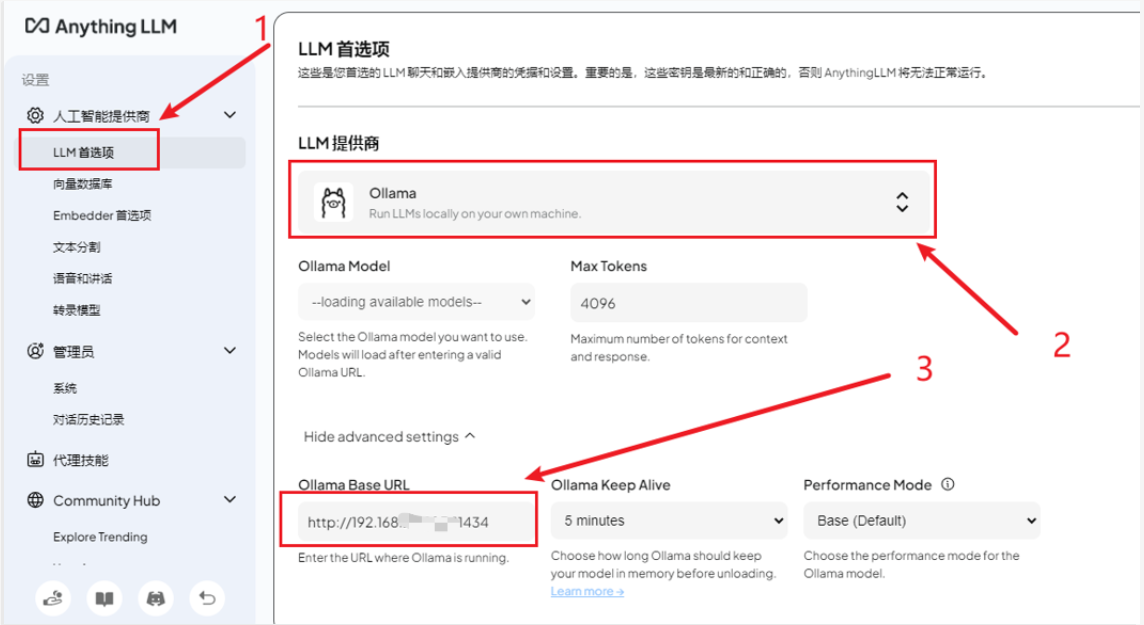

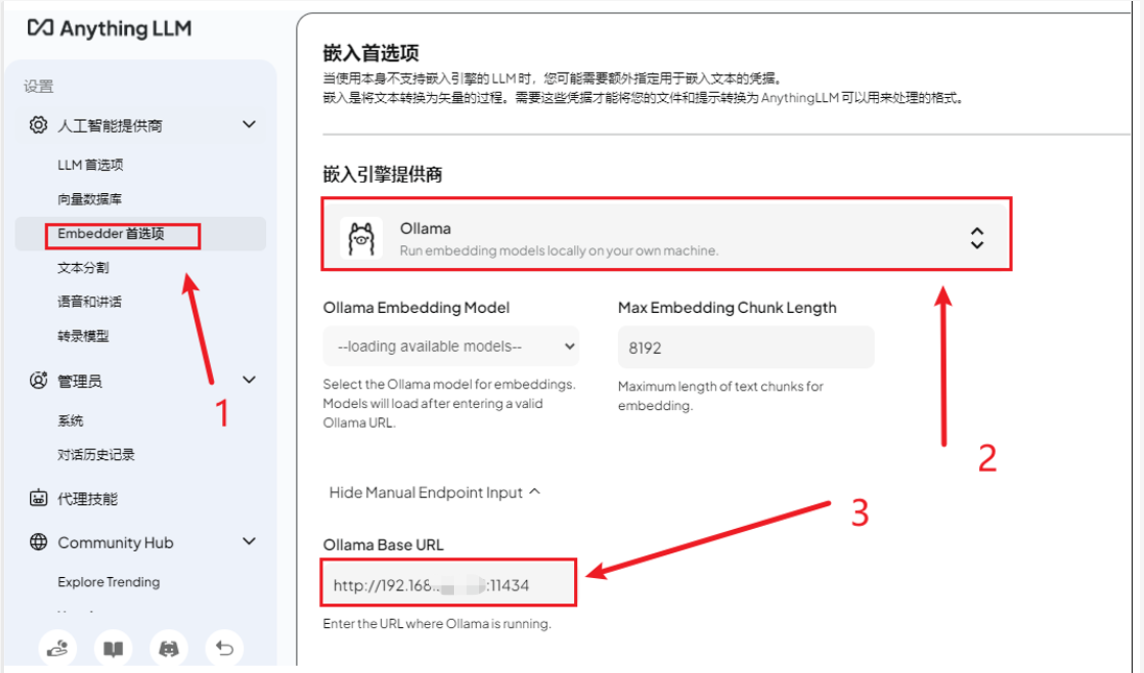

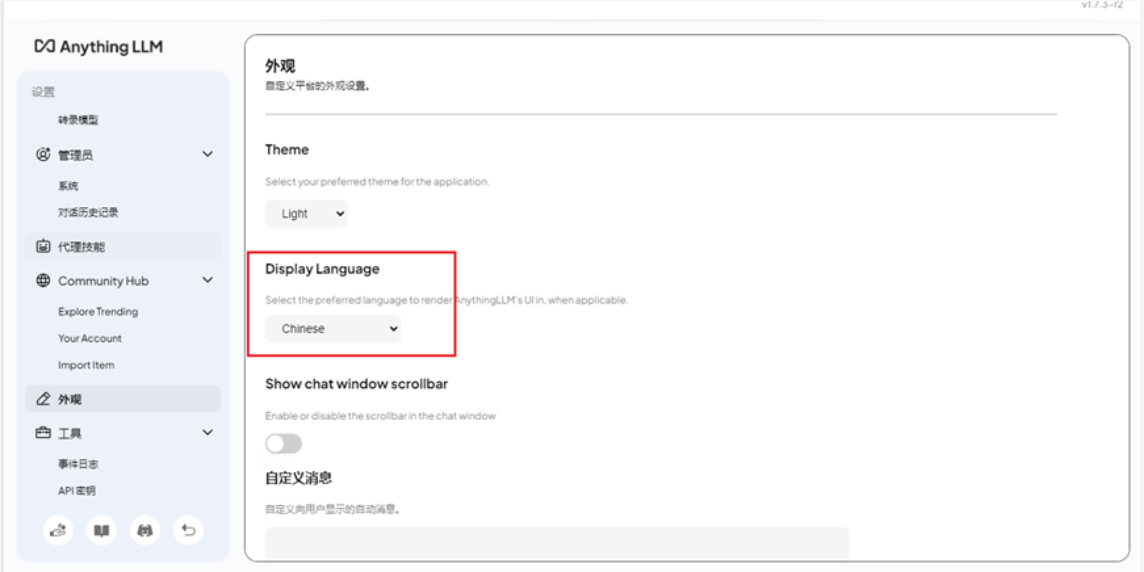

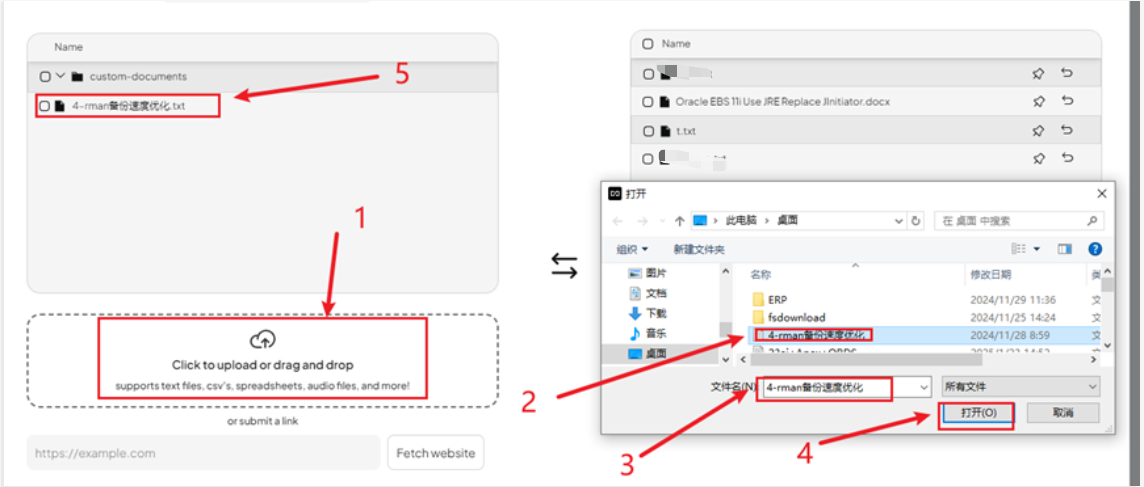

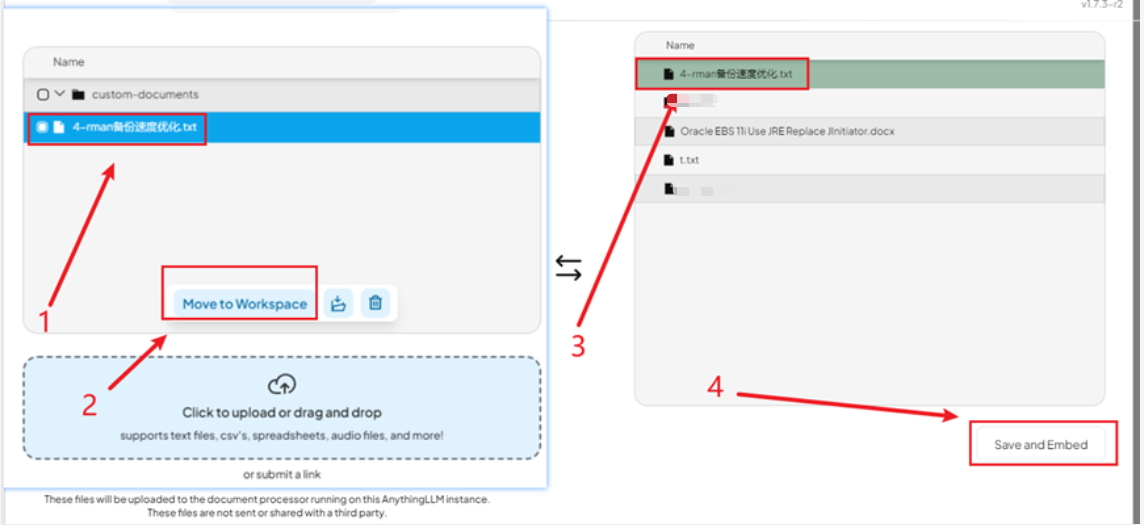

本地化知识库搭建

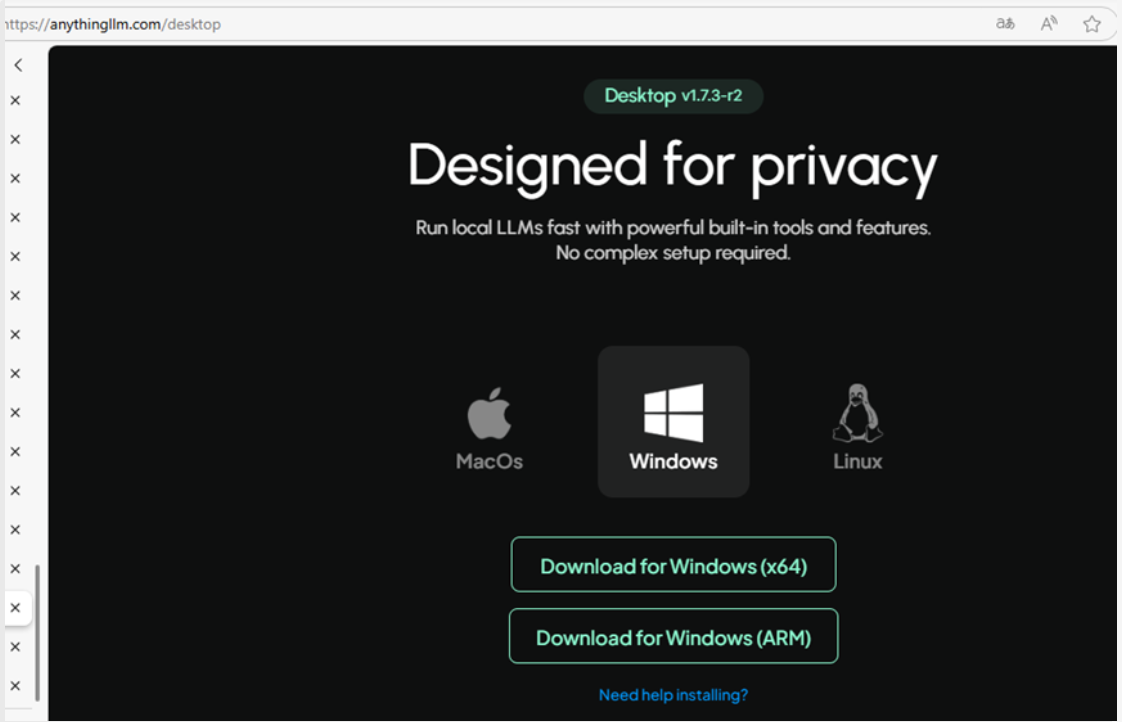

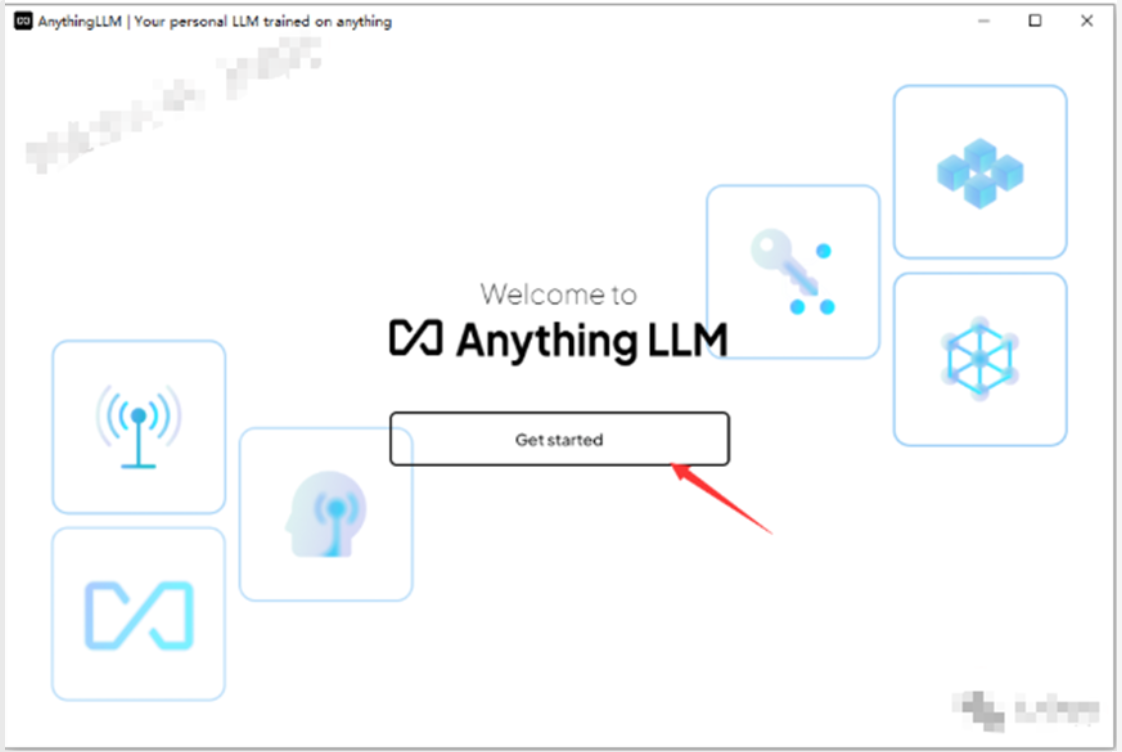

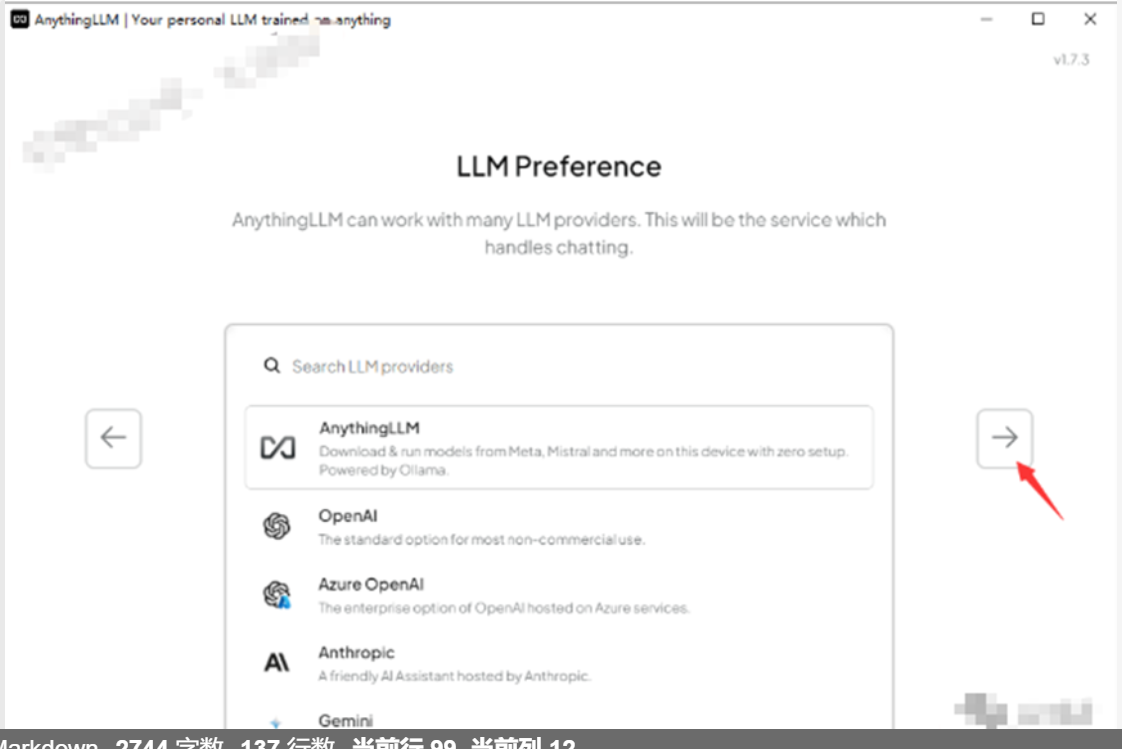

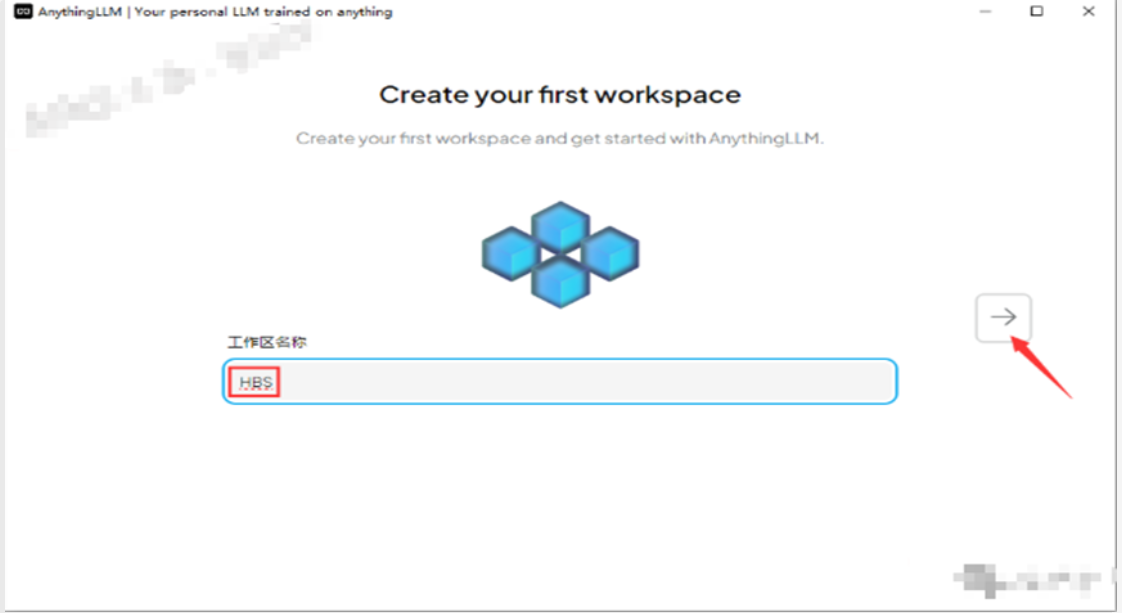

1、下载AnythingLLM

# 下载网址

https://anythingllm.com/desktop2、安装流程

注意:根据不同的平台选择不同的架构即可

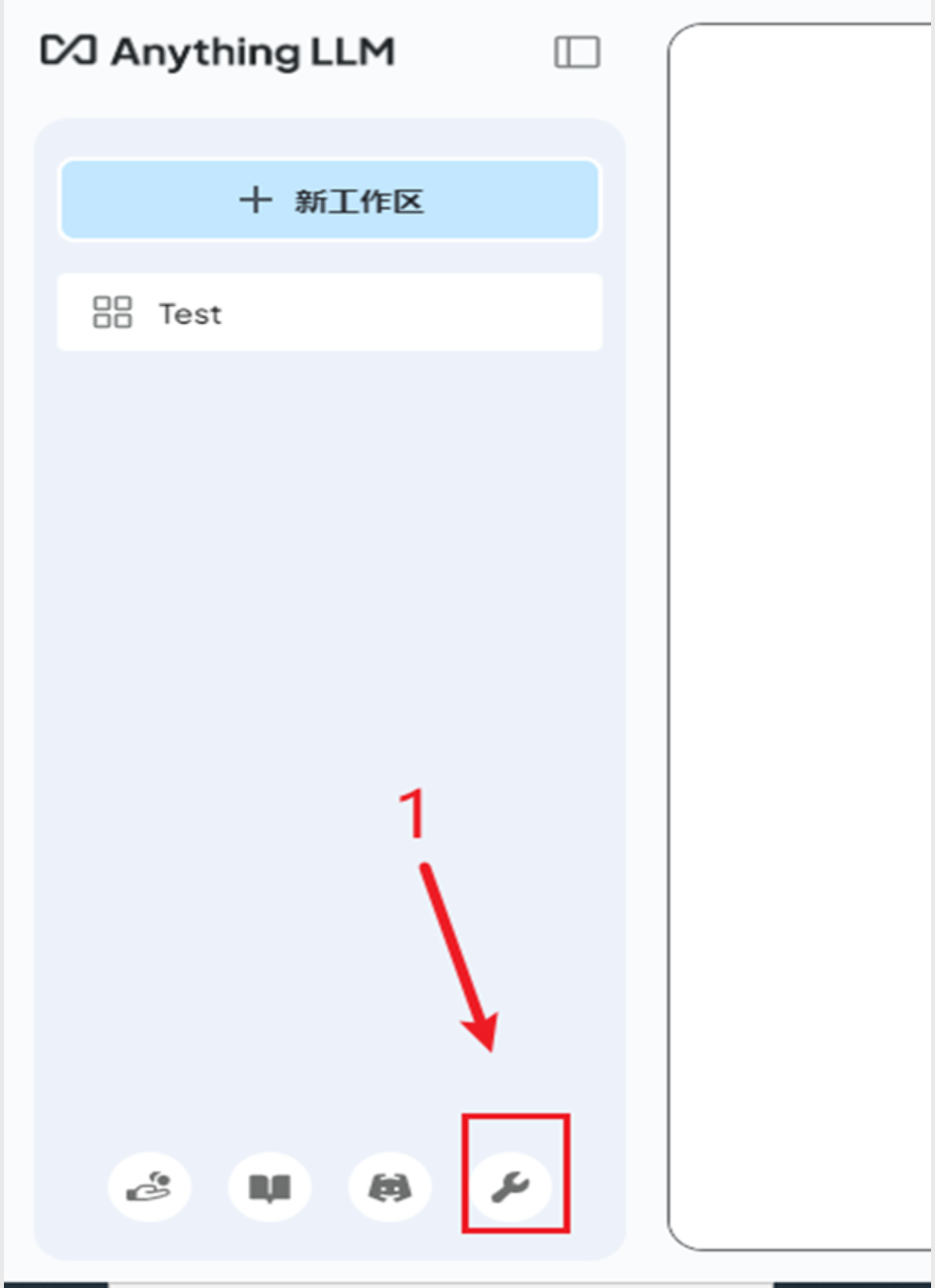

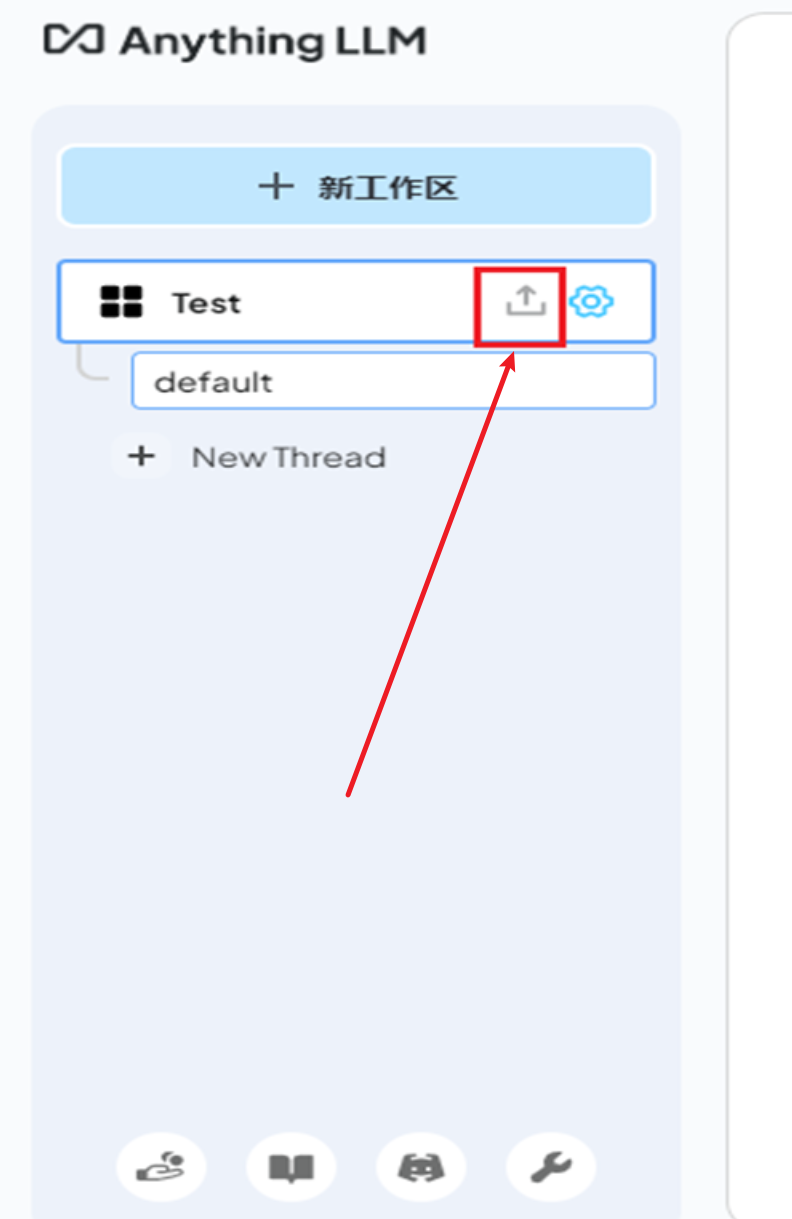

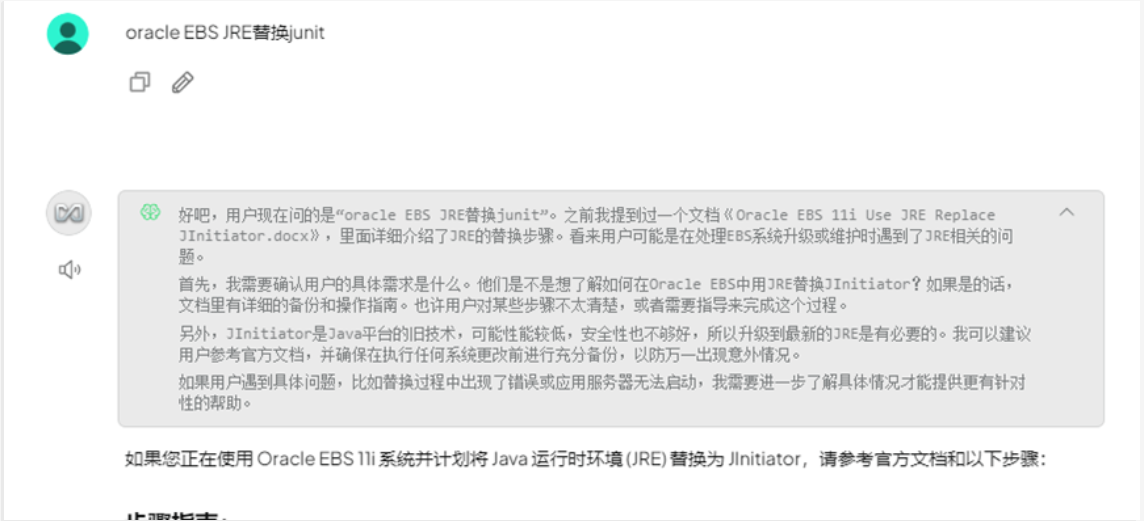

2、训练测试

注意:在上传完文档后,根据文档内容进行提问即可

最后修改时间:2025-02-18 17:26:45

「喜欢这篇文章,您的关注和赞赏是给作者最好的鼓励」

关注作者

【版权声明】本文为墨天轮用户原创内容,转载时必须标注文章的来源(墨天轮),文章链接,文章作者等基本信息,否则作者和墨天轮有权追究责任。如果您发现墨天轮中有涉嫌抄袭或者侵权的内容,欢迎发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。