利用DeepSeek-R1与RAG(Retrieval-Augmented Generation,检索增强生成)技术可以快速搭建本地知识库。

为确保本地知识库的高效搭建,需先准备DeepSeek-R1模型、相关文档/数据集及部署工具(如Ollama),随后安装Ollama并部署DeepSeek-R1,同时选择并配置文本嵌入模型,最后收集/整理文档并确保其唯一标识符和文本内容,利用文本嵌入模型转换文档为向量以构建快速检索的索引。

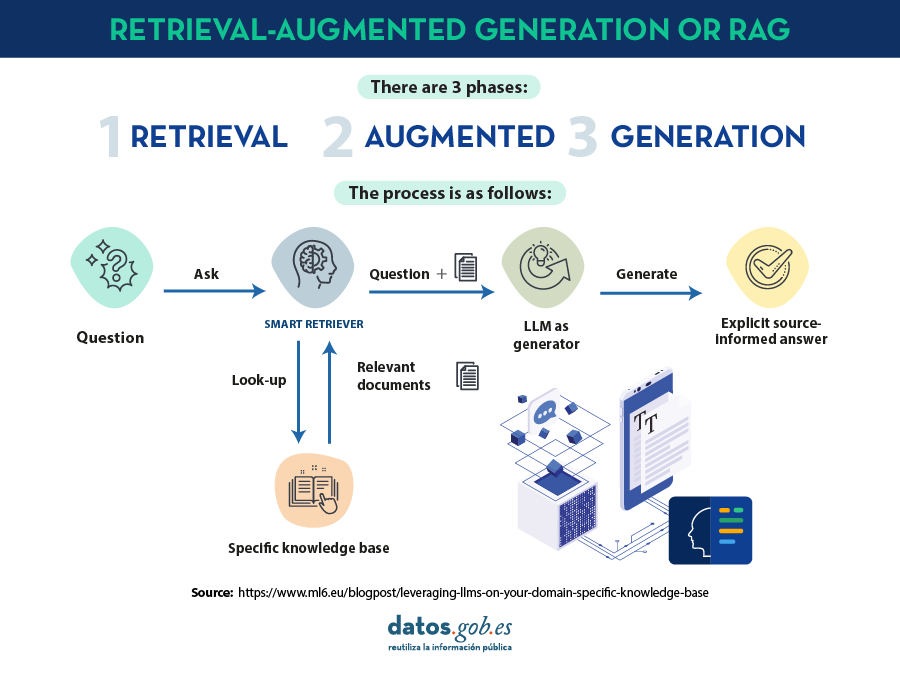

一、RAG(检索增强生成)

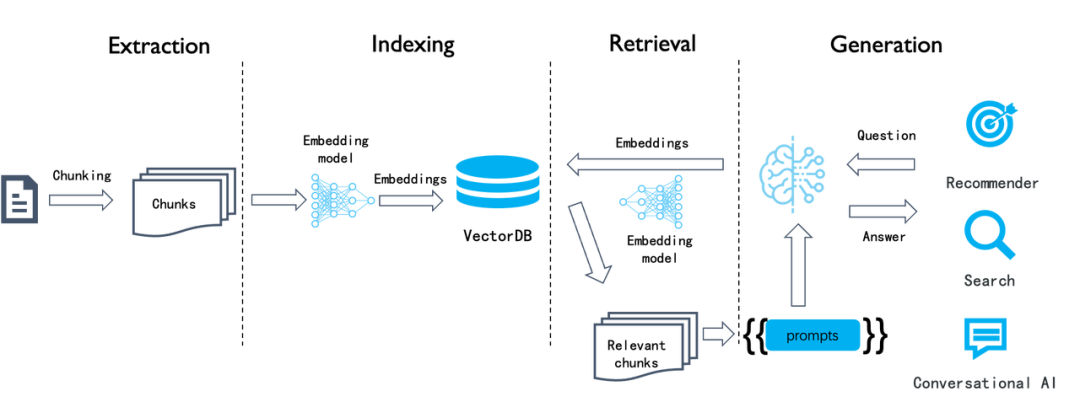

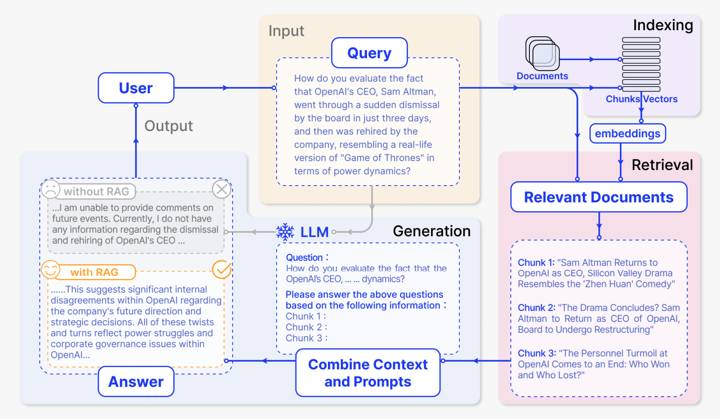

RAG的核心技术是什么?检索、生成和增强是RAG框架中的三个核心组件,它们相互协作、共同作用于整个框架中,以实现高效、准确、多样化的信息生成和处理。

检索负责从知识库中快速准确获取信息,生成根据检索结果和用户输入生成期望输出,增强则对信息进行额外处理以提高输出质量和多样性。

检索(Retrieval):负责从知识库中快速准确找到与输入查询相关的信息,通过关键词、向量或深度学习等方法提高检索效率。

生成(Generation):根据检索到的信息和用户输入生成符合期望的输出,采用模板、序列到序列模型或大型语言模型等技术,并进行后处理和微调以提高生成质量。

增强(Augmentation):在生成前后对信息进行额外处理或补充,通过知识增强、多样性增强和后处理增强等手段提高输出的质量和多样性。

二、Ollama + RAGFlow搭建知识库

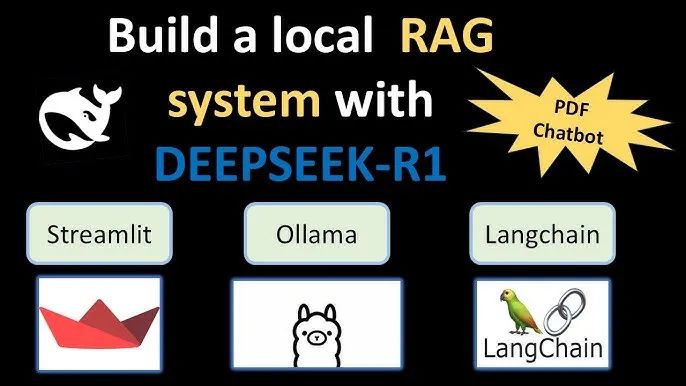

如何使用DeepSeek-R1 + RAG搭建本地知识库?利用DeepSeek-R1与RAG技术搭建本地知识库,需准备模型、部署工具,安装Ollama并配置嵌入模型,整理文档并转换为向量索引,以实现高效检索与生成。

一、Ollama本地化部署DeepSeek-R1

Ollama是一款开源的本地化大模型部署工具,用户可以通过Ollama轻松安装、配置和运行各种开源大模型(DeepSeek-R1)。

通过Ollama官网下载并安装软件,准备DeepSeek-R1模型后,在模型详情页复制运行命令并在终端中执行,完成模型在本地的部署与配置,以便进行交互使用。

下载并安装Ollama: 访问Ollama的官方网站(https://ollama.com/download),根据电脑系统(macOS、Linux、Windows)选择对应的版本下载。 双击安装程序并按照提示完成安装。安装完成后,如果在顶部菜单栏中看到Ollama的图标,即表示Ollama正在运行状态。 准备DeepSeek-R1模型: 在Ollama的官网中,找到并点击“Models”选项。

在搜索框中输入“deepseek-r1”,找到并点击进入DeepSeek-R1的详情页。

选择合适的模型参数版本(如1.5B、7B、14B等),这些参数与模型的复杂度和处理能力相关。

运行DeepSeek-R1模型:

在Ollama的模型详情页中,复制运行模型的命令(如“ollama run deepseek-r1:7b”)。

打开电脑的终端(或命令提示符),将命令粘贴到终端窗口中,并按下回车键。等待安装完成后,DeepSeek-R1模型即可在本地运行。

在RAGFlow系统中,点击上传按钮,选择本地要上传到知识库的文件。

支持的文件格式可能包括常见的文档格式(如PDF、DOCX等)、文本文件等。上传时请注意文件格式的支持情况。

上传完成后,系统将显示文件的相关信息,如分块数、上传日期、解析方法和解析状态等。

在模型提供商配置区域,选择使用的模型提供商(使用DeepSeek模型服务),并将对应的API key粘贴到指定位置。

如果选择搭建本地大模型(DeepSeek),也需要在此处进行相应的配置,确保RAGFlow能够与本地模型进行通信和交互。

等待知识库文件解析完成后,进入聊天界面。