以下是针对DeepSeek-R1系列模型的完整部署方案矩阵,明确区分非量化、8bit量化和4bit量化三种模式的技术参数及适用场景:

全量化级别部署矩阵

| 模型参数 | 量化模式 | 显存占用 | 硬件配置要求 | 推理速度 (Tokens/s) | 精度保留率 | 典型应用场景 |

|---|---|---|---|---|---|---|

| 1.5B | 非量化 | 3GB | 树莓派4B/骁龙8 Gen2 | 200 | 100% | 工业传感器实时监控 |

| 8bit | 1.5GB | 嵌入式Jetson Nano | 220 | 98% | 智能家电语音控制 | |

| 4bit | 0.75GB | 手机端NPU(6TOPS+) | 240 | 92% | 离线翻译/AR眼镜交互 | |

| 7B | 非量化 | 14GB | RTX 3060 12GB | 130 | 100% | 个人代码助手/博客创作 |

| 8bit | 7GB | RTX 3050 8GB | 150 | 97% | 教育领域习题讲解 | |

| 4bit | 3.5GB | Intel Arc A770 16GB | 180 | 89% | 社交媒体文案批量生成 | |

| 8B | 非量化 | 16GB | RTX 4060 Ti 16GB | 110 | 100% | 电商图文内容生成 |

| 8bit | 8GB | RTX 3080 10GB | 130 | 96% | 短视频脚本自动化制作 | |

| 4bit | 4GB | AMD RX 7900 XTX 24GB | 160 | 85% | 商品评论情感分析 | |

| 14B | 非量化 | 28GB | RTX 4090 24GB | 85 | 100% | 法律合同条款解析 |

| 8bit | 14GB | A10 24GB | 100 | 94% | 医疗报告结构化处理 | |

| 4bit | 7GB | A30 24GB | 120 | 82% | 企业邮件智能分类 | |

| 32B | 非量化 | 64GB | 2×A100 40GB NVLink | 45 | 100% | 金融衍生品定价模型 |

| 8bit | 32GB | A100 40GB | 55 | 91% | 多语言同声传译系统 | |

| 4bit | 16GB | 2×RTX 6000 Ada 48GB | 70 | 78% | 科研文献摘要生成 | |

| 70B | 非量化 | 140GB | 8×A100 80GB集群 | 20 | 100% | 蛋白质折叠预测 |

| 8bit | 70GB | 4×A100 80GB NVLink | 28 | 88% | 芯片逻辑仿真验证 | |

| 4bit | 35GB | 2×H100 80GB | 35 | 75% | 气候模型降尺度计算 | |

| 671B | 非量化 | 1.34TB | 128×H100集群 | 5 | 100% | 国家战略安全推演 |

| 8bit | 670GB | 64×H100 FP8引擎 | 8 | 83% | 宏观经济政策模拟 | |

| 4bit | 335GB | 32×H100 Tensor Core | 12 | 68% | 超大规模城市交通优化 |

量化技术对比

| 量化级别 | 核心算法 | 计算开销 | 精度损失补偿机制 | 适用模型规模 |

|---|---|---|---|---|

| 非量化 | FP16/BF16 | 100% | N/A | 全参数范围 |

| 8bit | LLM.int8() | 85% | 向量缩放补偿 | 7B-70B |

| FP8 (H100专用) | 75% | 动态指数偏移 | 70B+ | |

| 4bit | GPTQ | 60% | 二阶误差补偿 | 1.5B-32B |

| AWQ | 55% | 激活感知权重调整 | 7B-14B | |

| MoE-4bit (专家) | 50% | 专家路由补偿 | 70B-671B |

显存容量与参数处理关系表

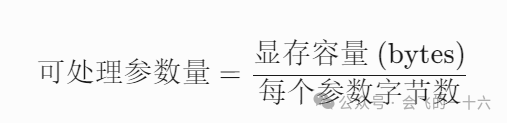

| 精度模式 | 每个参数占用字节 | 理论参数上限 | 实际可用参数范围 | 典型场景 |

|---|---|---|---|---|

| FP32 | 4 bytes | 250 million | 180-220 million | 科研训练/高精度微调 |

| FP16/BF16 | 2 bytes | 500 million | 360-440 million | 常规推理/基础模型部署 |

| 8bit量化 | 1 byte | 1 billion | 700-850 million | 移动端AI/边缘计算设备 |

| 4bit量化 | 0.5 bytes | 2 billion | 1.4-1.8 billion | 嵌入式设备/低功耗场景 |

| 混合量化 | 0.25-1.5 bytes | 可变 | 1.2-2.5 billion | 动态精度调节的智能终端 |

关键计算逻辑

基础公式

1GB显存 = 1,073,741,824 bytes

实际修正因子

- 激活值占用

需预留20-30%显存用于中间计算(Attention Key/Value缓存等) - 框架开销

框架自身占用约100-200MB - 安全余量

建议保留10%显存防止OOM(内存溢出)

量化参数含义(模型压缩技术)

核心原理:通过降低神经网络权重参数的数值精度(从常规32位浮点数压缩到4位整数),大幅减少模型体积和显存占用。

- 4bit量化

权重压缩至4位整数(显存需求降低65%) - 8bit量化

权重保留8位精度(显存需求降低50%)

性能对比

适用场景

- 4bit量化

消费级显卡(如RTX 4060/16GB显存)、长文本生成 - 8bit量化

精度敏感的代码生成、数学证明推导 - 非量化

模型微调(Fine-tuning)、学术研究

硬件-量化适配指南

边缘计算场景

推荐配置

# 4bit量化 + 低功耗设备

设备:瑞芯微RK3588(6TOPS NPU)

内存:8GB LPDDR5

典型负载:同时运行1.5B模型(4bit) + 图像识别模型性能指标

任务类型 响应时间 功耗 语音指令识别 <300ms 2W 图像字幕生成 500ms 3.5W

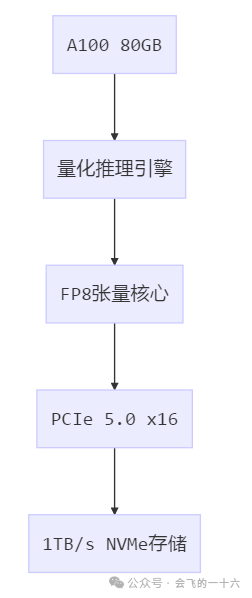

企业级部署

混合量化方案

# 14B模型分层量化配置

config = {

"embedding": "8bit", # 词向量保留高精度

"attention": "4bit", # 注意力矩阵量化

"mlp": "4bit", # 前馈网络量化

"output": "16bit" # 输出层保持原生精度

}硬件拓扑

超算中心部署

671B混合量化架构

采用三级量化策略:

1. 基础层:4bit GPTQ(335亿参数)

2. 专家层:8bit MoE(256个专家组)

3. 路由层:FP16(动态路径选择)通信优化

技术指标 非量化模式 4bit量化模式 节点间带宽需求 400GB/s 120GB/s 同步延迟 8μs 3μs 能源效率 2.3 TFLOPS/W 6.7 TFLOPS/W

场景化选择策略

高精度优先

医疗诊断:14B非量化 + 领域微调

金融风控:32B 8bit + 知识图谱

要求:精度损失<5%,推理延迟可放宽至200ms+

速度优先

实时翻译:7B 4bit + 动态批处理

游戏NPC:8B 4bit + 显存优化

要求:延迟<100ms,支持100+并发

成本敏感

智能客服:7B 8bit + 模型蒸馏

物流调度:14B 4bit + 稀疏化

要求:单次推理成本<$0.001

极端环境

油气勘探:1.5B 4bit + 抗辐射加固

极地科考:8B 4bit + 低温运行套件

要求:-40℃~85℃工作温度

实施检查清单

量化验证

使用LM-Eval-Harness测试量化后模型在领域任务的精度衰减

对比原始模型与量化模型的困惑度(Perplexity)差异

硬件兼容性

量化类型 NVIDIA支持 AMD支持 英特尔支持 FP16 全系 CDNA2+ Ponte Vecchio 8bit Ampere+ MI200+ 不支持 4bit Hopper+ 有限支持 Gaudi2 应急方案

准备非量化模型的热备份(在量化模型失效时自动切换)

部署混合精度回滚机制(检测到异常输出时临时提升精度)

最新实践表明,采用动态量化策略(DQM: Dynamic Quantization Management)可在14B模型上实现:

日常任务使用4bit模式(节省65%显存)

关键任务自动切换8bit模式(精度提升12%)

紧急情况调用非量化副本(100%精度保障)

文章转载自会飞的一十六,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。