这个公式是反向传播算法的核心公式。

它描述了如何将第 l+1 层的误差逐层传递回第 l 层,是神经网络反向传播算法的核心之一。

如果不会推导这个公式,也不影响神经网络的学习,直接记住它就行。但如果想更深入地进行理解,那就请继续往下看,我们一起来推导这个公式。

要推导这个,我们需要从神经网络的前向传播和反向传播的基本公式开始。(这里只推导这个数学公式,不对神经网络反向传播算法作介绍。)

另外《学习神经网络时绕不过的那些数学概念(5) - 导数的链式法则和在反向传播算法中的应用》看这里可以复习一下导数的链式法则。

前向传播公式

在第 l 层的前向传播中:

1.加权输入:

•: 第 层的加权输入。

•: 第 层的权重矩阵。

•: 第 层的激活(输出)。

•: 第 层的偏置。

2.激活函数:

•: 第 层的输出。

•: 激活函数(如 Sigmoid、ReLU)。

反向传播中的目标

反向传播的核心任务是计算误差,即损失函数 对第 层加权输入 的偏导数:

这个公式将用于更新权重和偏置:

•权重更新公式:

•偏置更新公式:

(这二个公式的推导比较简单,可自行尝试推导。)

我们需要通过层与层之间的关系,将 传递到 。

损失函数的偏导数传播

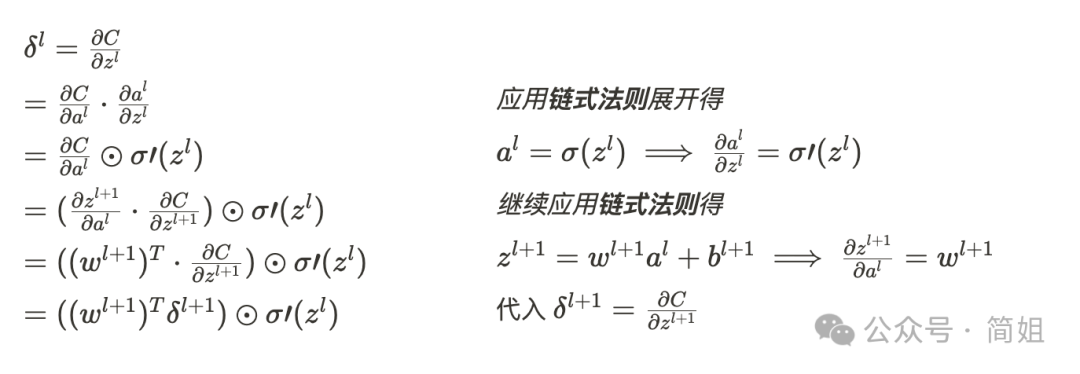

(1)链式法则

为了计算 ,我们使用链式法则:

(2)激活函数的导数

对于第 层:

因此:

误差从第 层传递到第 层

1. 前向传播关系

根据向前传播公式:

并且:

2.损失函数 对 的偏导数

这里的 是第 层的误差。

3.损失函数 对 的偏导数

通过链式法则:

将偏导数的计算分解为两部分:

•:加权输入 对 的偏导数。

•:损失函数对加权输入 的偏导数。

4.继续计算

根据前向传播公式:

将 视为 的线性函数,然后求偏导得:

5.代入链式法则

将 和 代入:

由于:

所以:

6.合并公式

将上述结果代入到 中:

推导完毕。

7.完整计算过程

公式解释

:

• 第 层的误差 通过权重矩阵的转置传递到第 层。

• 转置操作逆转了前向传播中权重的方向。

:

• 激活函数的导数修正了误差信号,使其符合第 层的激活特性。

:

• 表示逐元素相乘(哈达玛积),用于逐神经元地调整误差大小。

总结

通过前向传播公式、链式法则和矩阵运算的结合,可以推导出:

这个公式描述了如何将第 层的误差逐层传递回第 层,是神经网络反向传播算法的核心公式之一。