点击👆:Linux技术宅,关注我!!!

“jhao104/proxy_pool”是一个基于Python的自建代理IP池服务,它可以从多个来源收集免费代理,并通过内置的验证机制筛选出可用的高匿名代理。

一、项目概述

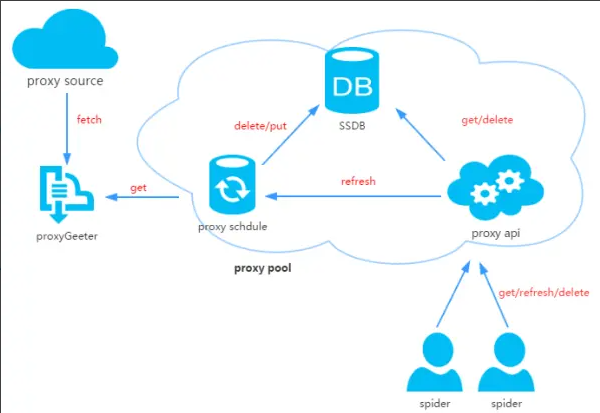

“jhao104/proxy_pool”是一个开源的Python项目,它提供了一个自动更新和验证的HTTP/HTTPS代理池系统。该系统支持多种编程语言和框架,如Python、Java、Node.js等,可以方便地为网络爬虫、数据抓取和自动化任务等提供稳定高效的代理服务。

二、主要功能

1.代理采集:项目中的采集器(Scraper)负责从多个公开的免费代理网站定期抓取新的代理信息。2.代理验证:验证器(Validator)对采集到的代理进行有效性测试,包括连接速度和匿名性检查,确保只有高质量的代理被添加到池中。3.代理存储:将验证通过的代理存储在内存或数据库中,提供快速访问。项目默认使用Redis作为内存存储,提供高效的数据存取。4.API服务:对外提供接口,允许其他应用程序获取代理。项目提供了简单的RESTful API,供其他应用调用以获取代理IP。

三、技术特点

1.模块化设计:项目采用了模块化的设计,使得各个部分可以独立开发和维护,提高了代码的可读性和可维护性。2.实时更新:定时从多个源获取新代理并更新池子,确保代理池中的代理始终是最新的和可用的。3.智能验证:自动检测代理的连通性和匿名等级,确保只有高质量的代理被添加到池中。4.易于集成:提供了简单的RESTful API,使得其他应用可以方便地集成和使用代理池服务。5.灵活配置:可以自定义代理来源、存储方式、验证策略等,以满足不同用户的需求。

四、使用指南

1.下载代码:可以从GitHub上下载“jhao104/proxy_pool”项目的代码。下载地址为:https://github.com/jhao104/proxy_pool。2.安装依赖:在解压后的文件夹中,找到requirements.txt

文件,并使用pip安装所需的依赖包。命令为:“pip install -r requirements.txt”。3.配置项目:根据项目需求,修改Config/setting.py

文件中的配置项,如API服务地址、监听端口、数据库连接等。4.启动服务:在命令行中进入项目目录,并运行“python proxyPool.py server”启动API服务,或者运行“python proxyPool.py schedule”启动调度程序以定时采集和验证代理。5.使用API:启动服务后,可以通过访问默认的API接口地址(如“http://127.0.0.1:5010/get/”)来获取代理IP。API提供了多种方法,如随机获取一个代理、获取并删除一个代理、获取所有代理等。

五、应用场景

“jhao104/proxy_pool”项目适用于各种需要代理服务的场景,如:

1.网络爬虫:在爬取网页数据时,使用代理IP可以避免因频繁请求同一网站而被封禁IP。2.数据抓取:在抓取大量数据时,使用代理IP可以分散请求,提高数据抓取的效率和稳定性。3.自动化任务:在执行自动化测试、自动化采集等任务时,使用代理IP可以避免因IP被封禁而导致任务失败。

总之,“jhao104/proxy_pool”项目是一个功能强大、易于使用的自建代理IP池服务,它可以为各种网络应用提供稳定高效的代理服务。

往期 · 推荐

期待你的

分享

点赞

在看