英伟达的 Tesla 系列 GPU,是专门用在服务器或者数据中心进行严格计算与深度学习的芯片。“从能源探测到深度学习等应用场合,数据科学家和研究者可以处理千兆字节级别的数据,且处理速度比使用传统 CPU 快了一个数量级”。这是官方给出的一段介绍,所以应该可以理解这一系列的 GPU 有多么强大,但是价格也是非常不菲,Tesla K80 官方售价是 2599 美元,对于个人来说只能望洋兴叹了。不过,借助于 Google 的 Colaboratory(简称:Colab) 项目,你也能用上这样高大上的 GPU 来进行深度学习。

准备

准备

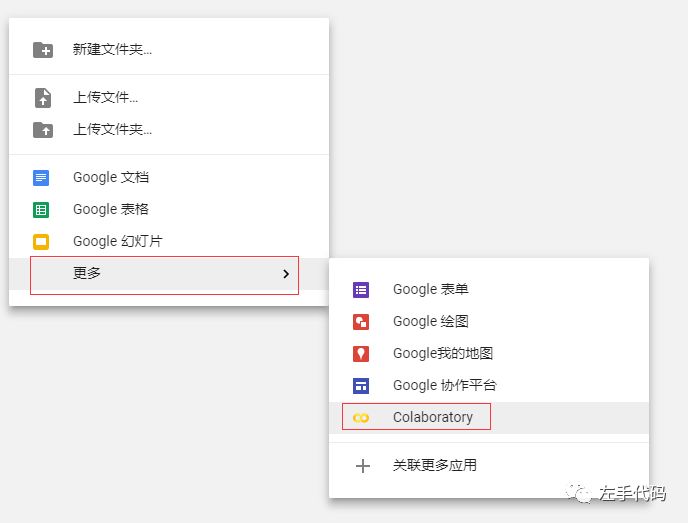

Colab 的所有服务都是用 Google Driver 来储存数据的,所以我们首先在 Google 的云端硬盘上新建一个文件夹,用来存储深度学习会用到的一系列文件,文件夹的名字随意。进入文件夹后右键新建一个 Colaboratory 支持的文件:

设置 Tesla GPU

设置 Tesla GPU

新建好文件后双击选择使用 Colaboratory 打开,不过在使用 Colab 的时候,默认是不启用 GPU 的,所以我们要设置一下:

菜单栏 --> 修改 --> 笔记本设置 --> 硬件加速器 GPU

然后你就能用上高大上的 Tesla K80 GPU 了。

Hello World

Hello World

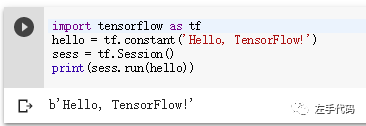

我们先来通过 TensorFlow 的官方文档运行一个简单的 HelloWorld:

import tensorflow as tf

hello = tf.constant('Hello, TensorFlow!')

sess = tf.Session()

print(sess.run(hello))

点击代码左边的运行按钮,你应该可以看到 HelloWorld。

简单的 MNIST CNN

简单的 MNIST CNN

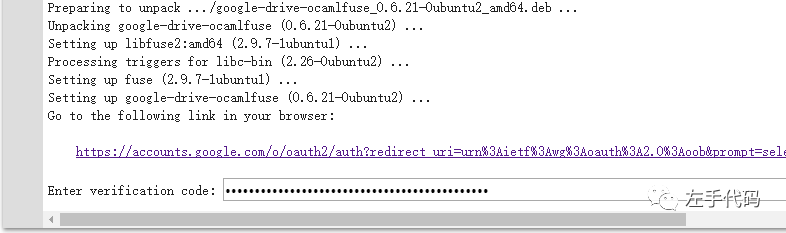

我们来用 MNIST 数据集训练一个简单的卷积神经网络,Colab 默认只能通过输入代码来运行,但是 Web 编辑有诸多不便之处,上文也说到了我们可以用 Google Driver 来储存文件,不过首先要执行一段授权代码 (代码太长,公众号后台发送 colab-auth 获取),然后会让你打开一个授权的 URL,打开之后把一串授权码复制粘贴进来即可,如图:

授权完了之后就可以创建文件夹,并且安装 Keras:

!mkdir -p drive

!google-drive-ocamlfuse drive

!pip install -q keras

然后我们就可以把 mnist_cnn.py 文件上传到 Google Driver 中并且运行:

!python3 drive/app/mnist_cnn.py

运行结果:

用上 Tesla K80 了吗?

用上 Tesla K80 了吗?

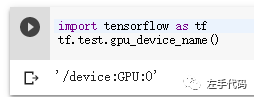

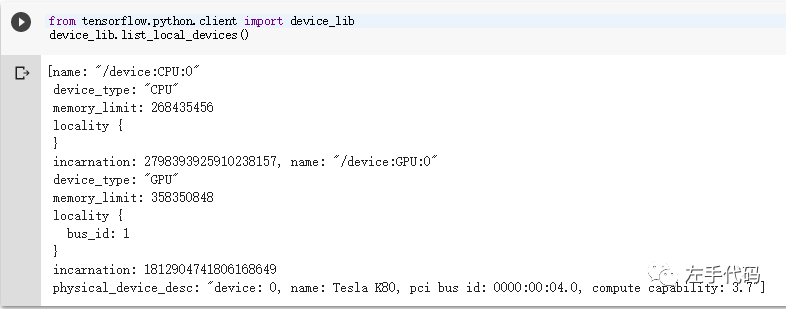

我们来确认一下是否用上了高大上的 Tesla,先来看看是否用到了 GPU:

import tensorflow as tf

tf.test.gpu_device_name()

可以看到用上了 GPU,那么是什么型号呢?

from tensorflow.python.client import device_lib

device_lib.list_local_devices()

那么,有了这么高大上的 GPU 是不是也得有个得力的 IDE 来助阵呢?公众号后台发送 jetbrains,你懂的。

开始玩吧~