Dify 作为一款开源的大语言模型(LLM) 应用开发平台,融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。目前已提供了诸如聊天助手、Agent、文本生成应用、chatflow、工作流等多种类型的应用。 同样,在mac上搭建下dify的环境,首先把代码库下载下来https://github.com/langgenius/dify,然后运行下列命令就可以启动一套完整的dify环境cd dify

cd docker

cp .env.example .env

docker compose up -d

[+] Running 10/10

⠿ Container docker-sandbox-1 Started 16.7s

⠿ Container docker-ssrf_proxy-1 Started 16.9s

⠿ Container docker-web-1 Started 16.7s

⠿ Container docker-worker-1 Started 50.2s

⠿ Container docker-plugin_daemon-1 Started 49.7s

⠿ Container docker-api-1 Started 50.2s

⠿ Container docker-nginx-1 Started 48.1s

⠿ Container docker-redis-1 Started 2.0s

⠿ Container docker-db-1 Healthy 33.8s

⠿ Container docker-weaviate-1 Started 2.1s

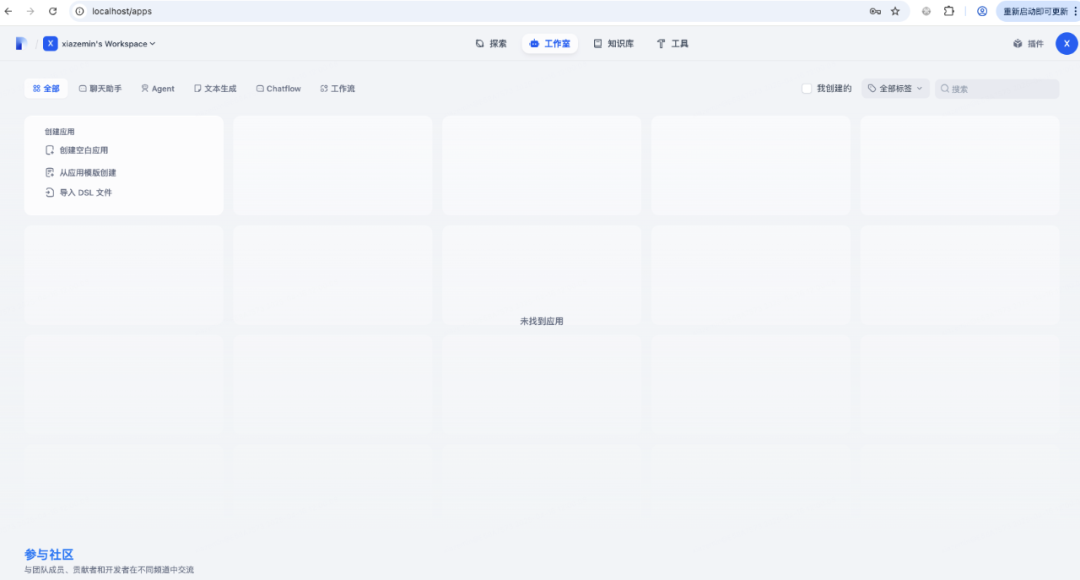

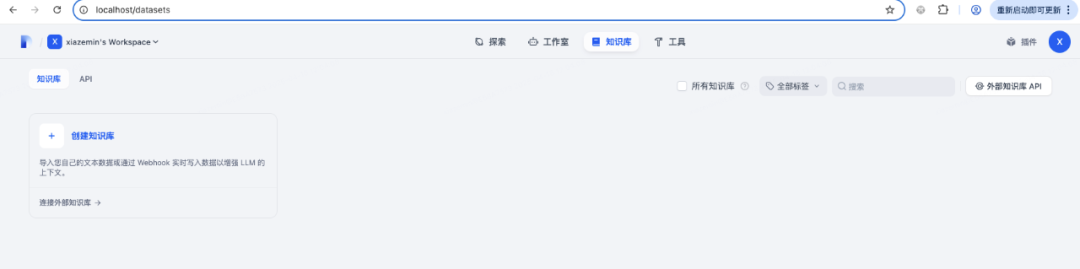

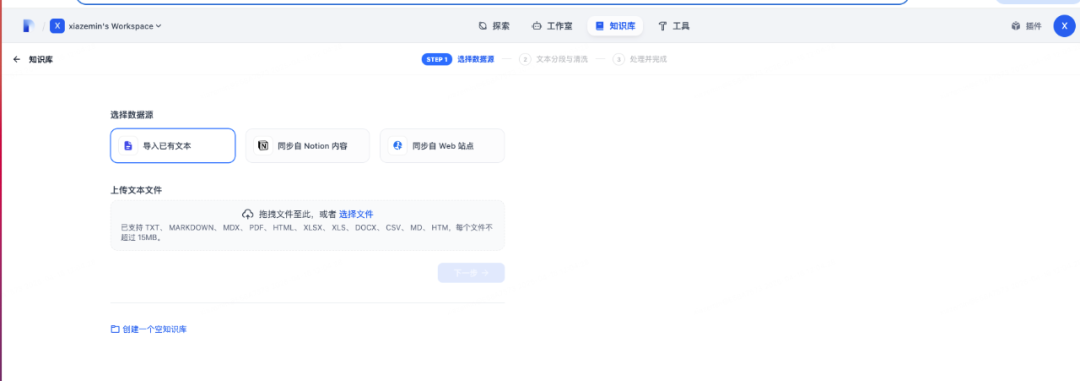

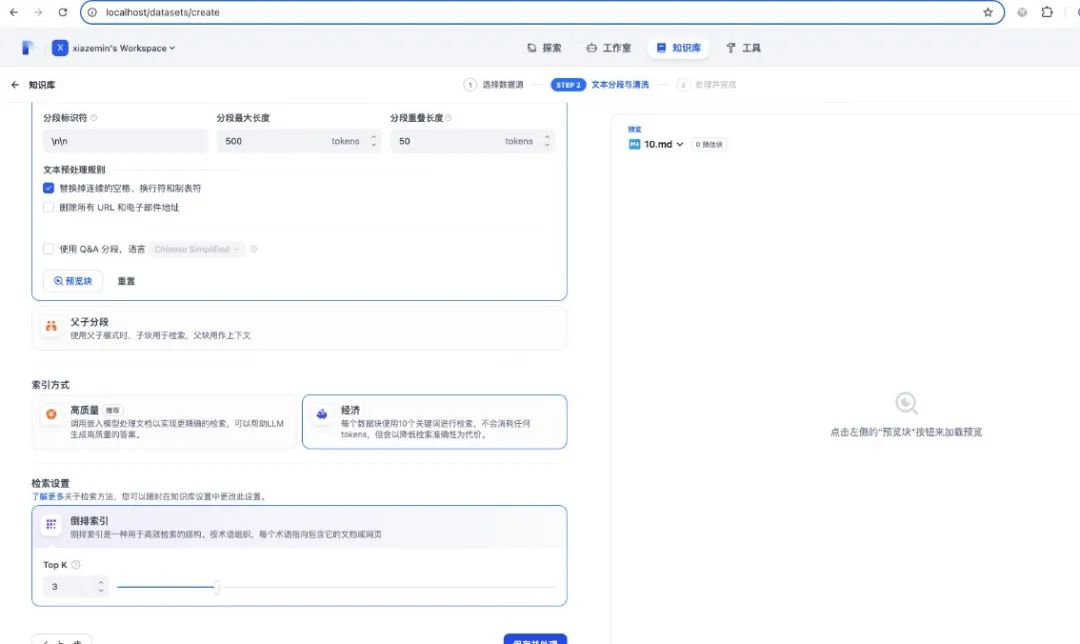

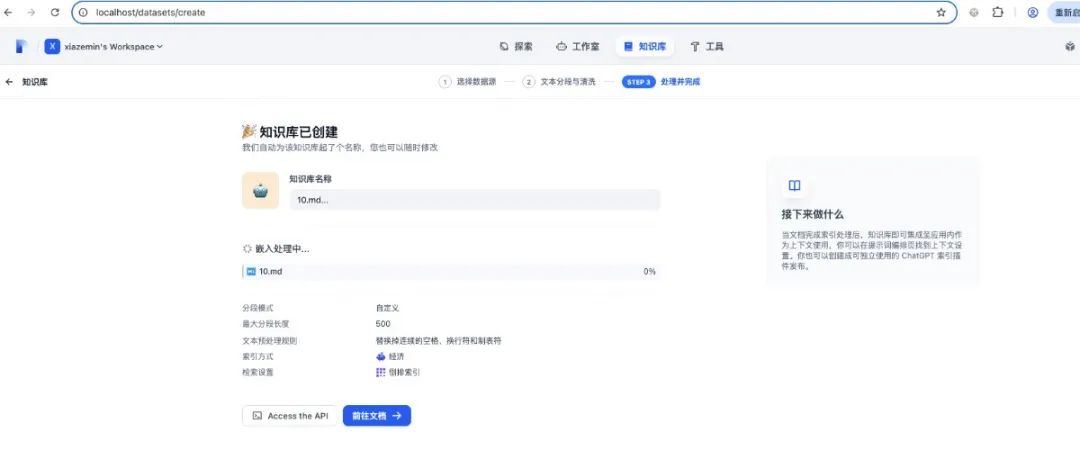

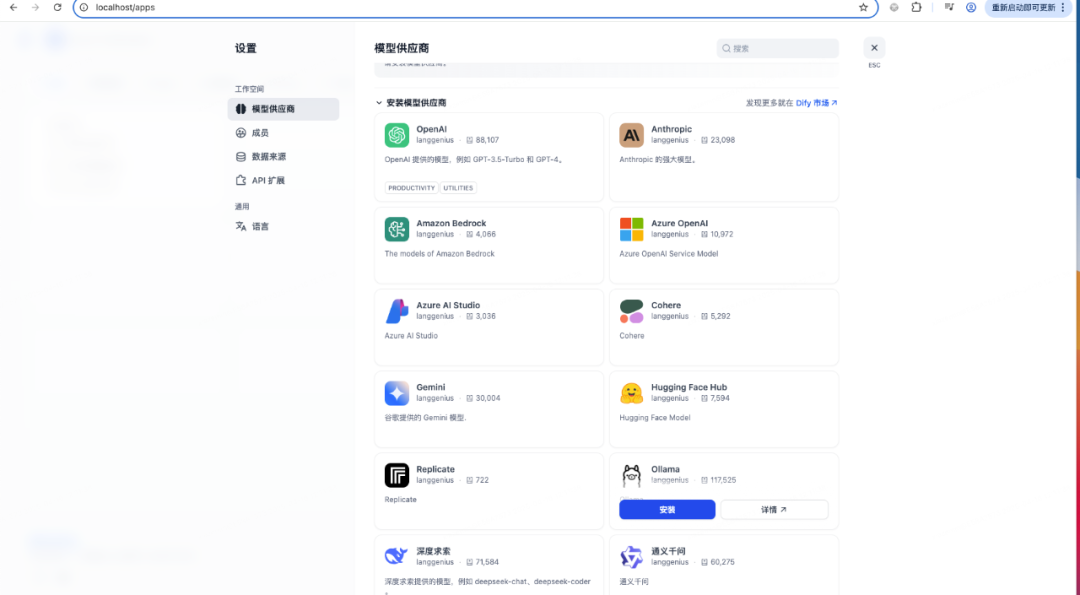

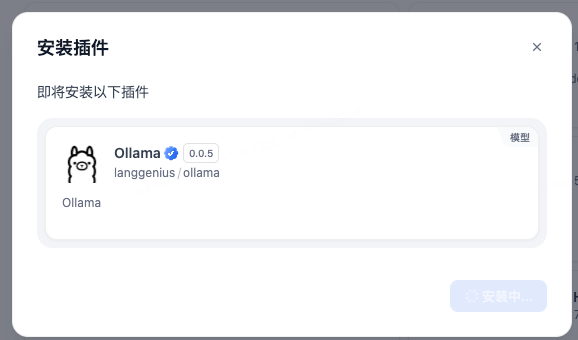

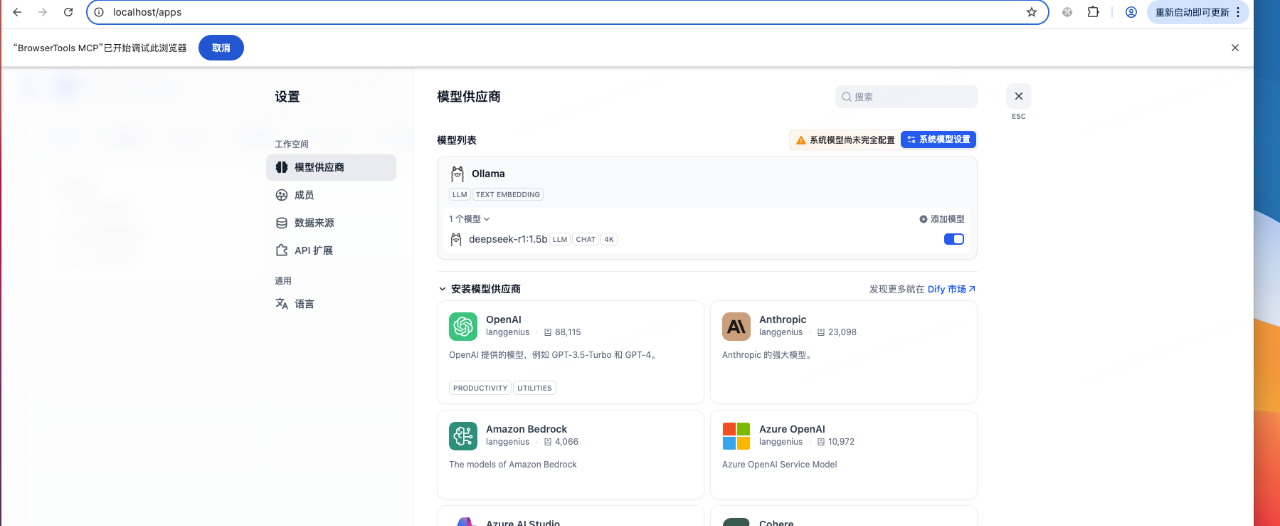

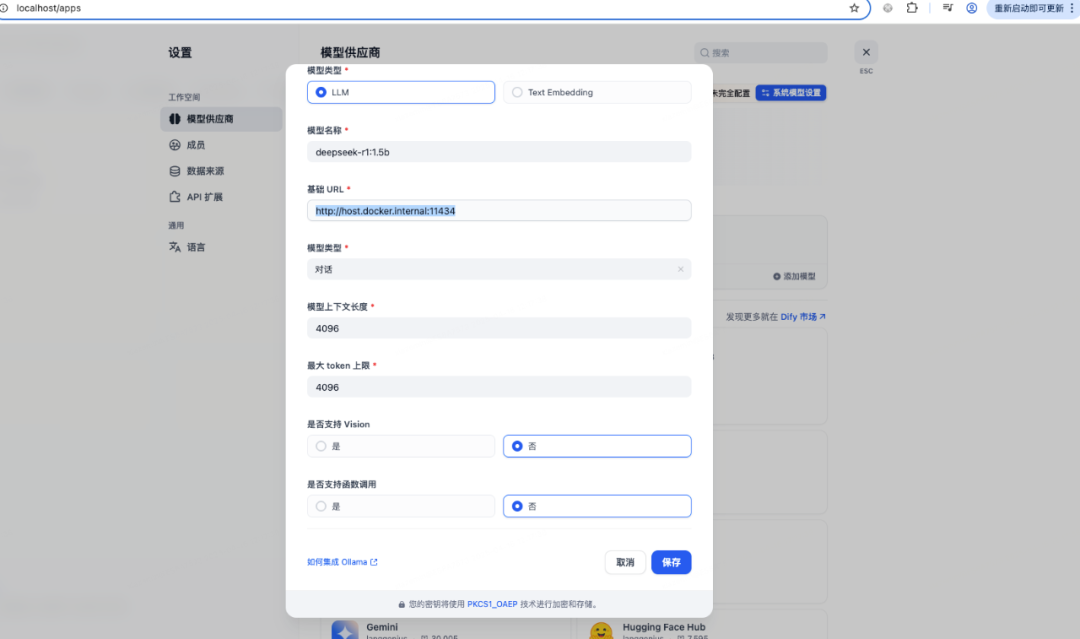

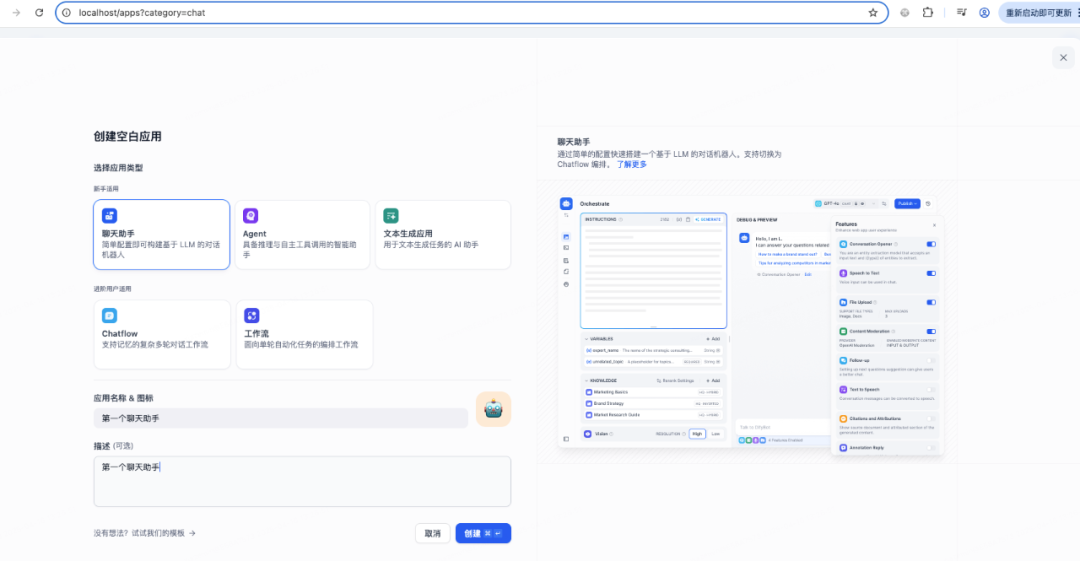

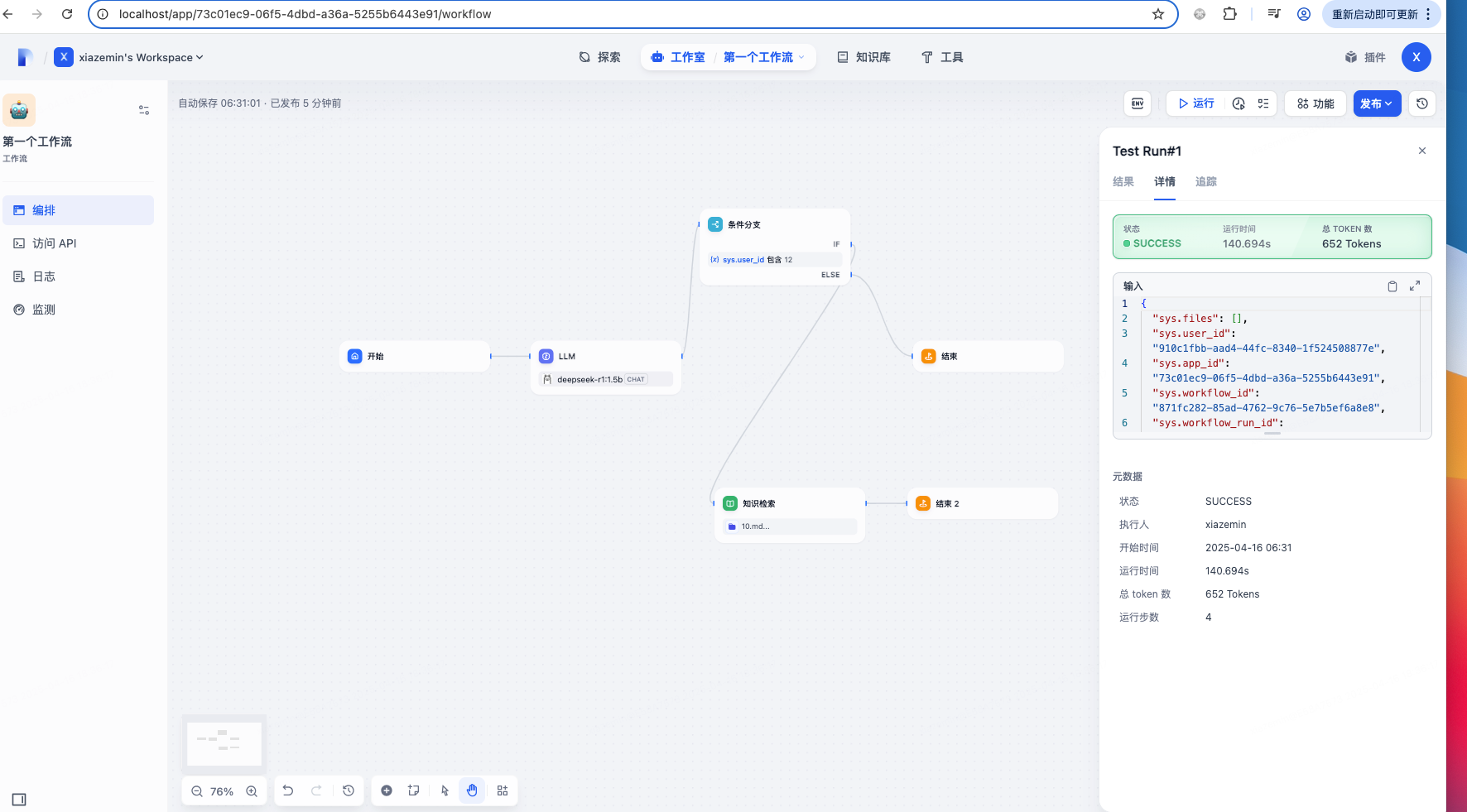

然后我们登录网页http://localhost/install设置用户名和密码登录进去就可以看到工作室,接着就可以在工作室里创建应用了有了知识库之后,我们需要介入大模型来实现聊天功能。点击右上角的头像,在下拉列表里选择设置:选择模型供应商,这里有目前市面上大量的模型供应商,为了使用deekseek,模型供应商选择ollama,使用之前需要安装ollama插件模型供应商插件安装好后,进入详细设置,这里模型名称就选deepseek-r1:1.5b, 基础URL选择http://host.docker.internal:11434测试完成后发布,点运行,就可以看到一个用户视角的应用至此一个机遇deepseek的rag聊天应用就发布完成了。 当然,如果除了聊天还需要执行一系列动作,可以创建agent应用,过程类似的。整体还是比较简单的,按照官方文档点击按钮就可以了。 比如我们要实现一个翻译专家,可以在左上角填写prompt模板,并且支持参数如果应用比较复杂,需要执行多个步骤,可以编辑工作流,通过线将多个流程连接成一个整体,具体如下:整体来说,dify使用起来是比较方便的,文档也比较完备,通过拖拽就可以完成我们的需求,搭建自己的ai应用。