关注下方公众号,获取更多热点资讯

关注下方公众号,获取更多热点资讯

零门槛上手!本地部署Ollama+OpenWebUI+DeepseekR1操作指南

Ollama 和 Open WebUI 是两款非常实用的工具,可以帮助用户在本地轻松部署强大的语言模型和智能推理引擎。本篇文章将详细介绍如何零门槛地在本地部署 Ollama 和 Open WebUI,并通过 Deepseek-R1-14b 模型进行高效的推理。

Ollama 安装 Deepseek-R1-14b

Ollama 是一款非常轻量且易于安装的工具,旨在为开发者提供便捷的语言模型 API 支持。它支持多种大型语言模型的运行和调用,包括 Deepseek-R1-14b。下面是安装步骤的详细说明。

curl -fsSL https://ollama.com/install.sh

ollama run deepseek-r1:14b

在执行这条命令时,Ollama 将自动下载并安装 deepseek-r1:14b

这个大型语言模型,并准备好 API 供后续使用。安装成功后,你将能够通过 API 请求与模型进行交互。

Ollama 安装不在这里做过多介绍,比较方便,几乎一键安装部署。

Open WebUI 部署

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种 LLM 运行器,如 Ollama 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。

Docker 安装

如果你希望通过 Docker 来快速部署 Open WebUI,可以按照以下步骤进行操作。首先,确保你已经在系统中安装了 Docker。然后,执行以下命令来启动 Open WebUI:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

此命令会从 Docker Hub 拉取最新的 Open WebUI 镜像,并在后台启动该应用。启动成功后,你可以通过浏览器访问 http://localhost:3000

来使用 Open WebUI。

pip 安装

如果你希望不使用 Docker,而是通过 pip

来安装 Open WebUI,可以按照以下步骤进行操作:

1. 安装 Open WebUI:打开终端并运行以下命令: pip install open-webui2. 启动 Open WebUI:安装后,使用以下命令启动服务器:

启动后,你可以通过访问open-webui servehttp://localhost:8080

来访问 Open WebUI 的 Web 界面。

提示:pip 安装的版本可能会比 Docker 镜像版本略有不同,建议选择最适合你的部署方式。

配置与使用 Open WebUI

首次访问 Open WebUI 时,你将会看到一个登录界面。在这个界面上,你需要创建一个管理员账号。输入必要的信息后,你将能够访问管理员面板,进行模型管理和 API 配置。

在管理员面板中,你需要配置 Ollama 的 API。点击相应的设置选项,输入你安装 Ollama 时生成的 API 地址和密钥。确保配置正确,这样 Open WebUI 才能成功连接到 Ollama 并调用 Deepseek-R1-14b 模型进行推理。

配置 Ollama API

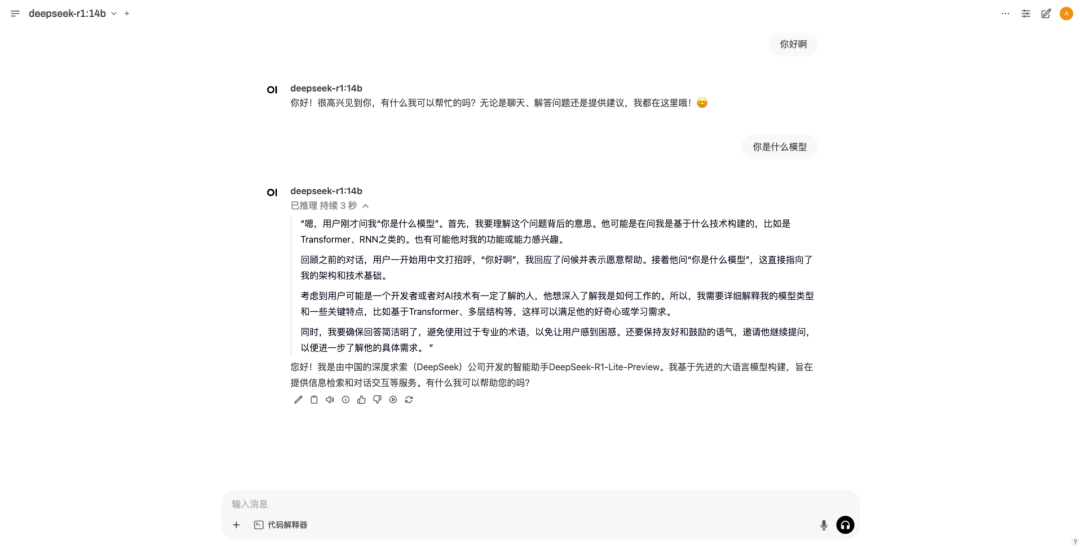

访问聊天

配置完成后,你可以开始使用 Open WebUI 进行聊天。进入聊天界面,输入你的问题或请求,Open WebUI 将通过 Ollama 的 API 调用 Deepseek-R1-14b 模型并返回相应的结果。

通过这种方式,你可以便捷地与语言模型进行交互,进行各种文本生成、问答等操作。

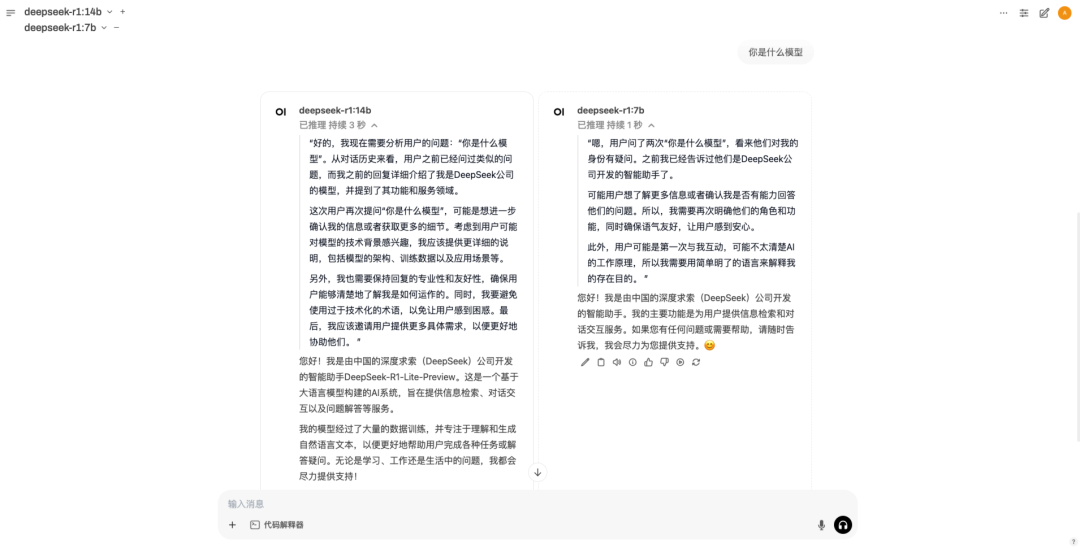

Open WebUI 还支持同时运行多个语言模型,这使得你可以在同一个平台中使用不同的模型进行对比和组合。例如,你可以同时运行 Ollama 和 OpenAI 模型,并在聊天时选择不同的模型进行对话。

这种多模型支持大大增强了 Open WebUI 的灵活性和实用性。

总结

通过以上步骤,我们成功地在本地环境中部署了 Ollama、Open WebUI 和 Deepseek-R1-14b 模型,并配置了相关的 API 接口。这一过程非常适合希望将 AI 技术应用到本地开发中的开发者。在未来,随着更多模型和功能的加入,Open WebUI 将成为更加强大的 AI 部署平台。

欢迎关注我的公众号“编程与架构”,原创技术文章第一时间推送。