❝开头还是介绍一下群,如果感兴趣PolarDB ,MongoDB ,MySQL ,PostgreSQL ,Redis, OceanBase, Sql Server等有问题,有需求都可以加群群内有各大数据库行业大咖,可以解决你的问题。加群请联系 liuaustin3 ,(共2800人左右 1 + 2 + 3 + 4 +5 + 6 + 7 + 8 +9)(1 2 3 4 5 6 7群均已爆满,开8群300+ 9群 100+)

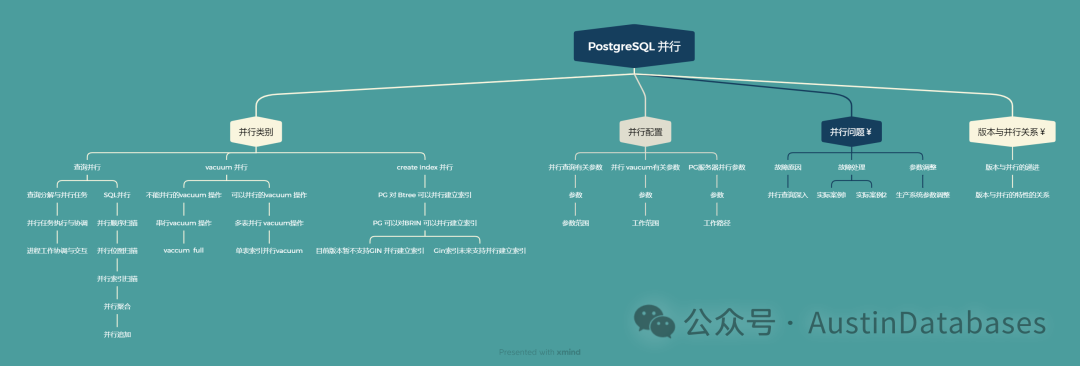

上个月,接了一个活,鸿门宴讲PostgreSQL -- 被拉去央企救场一天去给人家讲一下PostgreSQL的并行,本着给谁讲不是讲,他们花钱这里免费的原则。我总结了一下PostgreSQL并行的知识点。

今天这么多的内容是写不完的,本期只针对SQL查询的部分进行内容的撰写和分析。随着主机的CPU核心的数量增多,对于SQL的并行的支持一直是各种商业数据库要考量的部分,作为开源的数据库PostgreSQL在SQL并行方面相对于其他的一些开源数据库是很良心的。

基于开源的POSTGRESQL数据库在QUERY并行参数的部分,给出了甚多的自由调整的参数,

说到这里,其实最让人困扰的是这些参数的关系,单独拿出一个参数都明白是什么意思,把这堆参数放一块,很多人就开始晕,咱们今天来去把这些参数之间的关系来梳理一下。

max_worker_processes,这个参数最容易被理解错误,这个参数主要的意义是限制除了你query session外的后台程序在POSTGRESQL中运行的数量,那么这些后台程序包含什么?

一句话和客户无关的后台进程都要收到这个参数的限制,那么到底那些进程受到他的限制:

1 并行的查询工作进程(由系统发起的并行) 2 逻辑复制进程 3 自动清理进程 4 后台维护进程

那么max_worker_processes 的意义何在这是我们应该对自己管理的数据库应该提出的问题,一句话解释,防止你滥用和其他参数配置错误,导致系统无法处理这些工作而最终资源耗尽而宕机。

举例比如你进来30个查询,每个查询都要触发进行并行操作,你并行操作设置的是4,也就是会产生 30 * 4 = 并行的查询的后台进程。

我们按照每个进程可以获得 8MB的内存 120 * 8 = 8160MB 的内存使用的量,此时如果你的系统仅仅就16G的内存,那么你这里设置 max_worker_processes 合适吗? 显然是不合适的。

2 max_parallel_workers

这个参数是控制QUERY并行的时候到底可以产生多少个并行的works,这里就要考虑另一个问题,你要留下多少固定的processes 给非query的进程,一般情况下你要考虑你有没有逻辑复制,以及你的autovacuum的工作时的进程数是多少

max_parallel_workers = max_worker_processes - 固定的backgroud processes

具体多少,你就要看你的具体情况了,比如你有大量的逻辑复制,那么你这个部分就不能太多了,或者你系统的vacuum就是一个大问题,且你设置的autovacuum的工作进程数量较多,那么你也不能给max_parallel_workers 太多的数量,具体的情况就要具体的分析了,这也是和学生们要讨论和给出方案的部分。

那么如果设置不好会造成什么问题

1 查询挤压 2 内存耗尽系统OOM 3 逻辑复制挤压 4 autovacuum 无法分配进程导致dead tuple无法有效的被清理,系统性能下降。

而不足的max_parallel_workers,会导致并行查询无法获得足够的进程而无法进行并行查询。

3 max_parallel_workers_per_gather,这是今天要说的最后一个和查询有关的并行参数,这个参数是每个SQL可以使用的最大的并行度。

这三个参数是三级跳,max_worker_processes > max_parallel_workers > max_parallel_workers_per_gather

说到这里曾经有些同学认为 max_parallel_workers_per_gather 这个数量越大越好,他们认为更大的max_parallel_workers_per_gather 会然给一个SQL可以使用更多的CPU来处理一个SQL的数据,但在实际的应用中,

我们需要分清一些信息,三种典型的JOIN,并行是怎么进行应用的。

1 Hash join ,hash_join 的并行是从PG11引入的,并行的部分包含了构建hash表的工作,和后续的探查阶段的工作进程的数据量,从而加速hash join 的操作。

2 Merge_join,Merge_john 最大的需求是表和表之间的排序问题,通过对两个要进行john的表进行排序来进行比对,那么并行主要要用在表的排序中,通过在排序阶段加速来加快merge join的工作

3 Nested loop : 外表,内表,驱动表和被驱动表,或者称之为小表的大表,其实这也是一个数据的比对过程,而并行在这里进行使用的主要作用是通过对大表的并行扫描和小表的比对来加快数据的处理。

写到这里,为什么说并行太多会影响性能,我们想一个问题,并行的资源来自于数据索取后的归并,那么归并分为有序归并和无序归并,有序的归并消耗会更多,这里每个tumple在 gather merge的时候都要消耗,越多的 works并行,就会导致越多的CPU消耗,且长时间霸占,这样会导致其他的查询无法获得有效的并行,所以在有序需求场景多的地方,合理配置并行查询参数是一门功课!

如果这篇文章对您有帮助,且不麻烦的话,谢谢帮我投一票,二维码或连接进入,给Austindatabases 投上您宝贵的 10票 (一次可以投10票),不胜欣喜,您的支持是我最大的动力。

https://zt.itpub.net/topic/peanit/

置顶

和架构师沟通那种“一坨”的系统,推荐只能是OceanBase,Why ?MongoDB “升级项目” 大型连续剧(4)-- 与开发和架构沟通与扫尾

MongoDB “升级项目” 大型连续剧(3)-- 自动校对代码与注意事项

MongoDB “升级项目” 大型连续剧(2)-- 到底谁是"der"

MongoDB “升级项目” 大型连续剧(1)-- 可“生”可不升

MongoDB 大俗大雅,上来问分片真三俗 -- 4 分什么分

MongoDB 大俗大雅,高端知识讲“庸俗” --3 奇葩数据更新方法

MongoDB 大俗大雅,高端的知识讲“通俗” -- 2 嵌套和引用

MongoDB 大俗大雅,高端的知识讲“低俗” -- 1 什么叫多模

MongoDB 合作考试报销活动 贴附属,MongoDB基础知识速通

MongoDB 使用网上妙招,直接DOWN机---清理表碎片导致的灾祸 (送书活动结束)

MongoDB 2023年度纽约 MongoDB 年度大会话题 -- MongoDB 数据模式与建模

跟我学OceanBase4.0 --阅读白皮书 (OB分布式优化哪里了提高了速度)

跟我学OceanBase4.0 --阅读白皮书 (4.0优化的核心点是什么)

跟我学OceanBase4.0 --阅读白皮书 (0.5-4.0的架构与之前架构特点)

跟我学OceanBase4.0 --阅读白皮书 (旧的概念害死人呀,更新知识和理念)

“PostgreSQL” 高性能主从强一致读写分离,我行,你没戏!

POLARDB 添加字段 “卡” 住---这锅Polar不背

PolarDB 版本差异分析--外人不知道的秘密(谁是绵羊,谁是怪兽)

PolarDB 答题拿-- 飞刀总的书、同款卫衣、T恤,来自杭州的Package(活动结束了)

PolarDB for MySQL 三大核心之一POLARFS 今天扒开它--- 嘛是火

PostgreSQL 无服务 Neon and Aurora 新技术下的新经济模式 (翻译)

“PostgreSQL” 高性能主从强一致读写分离,我行,你没戏!

全世界都在“搞” PostgreSQL ,从Oracle 得到一个“馊主意”开始

PostgreSQL 加索引系统OOM 怨我了--- 不怨你怨谁

PostgreSQL “我怎么就连个数据库都不会建?” --- 你还真不会!

PostgreSQL 稳定性平台 PG中文社区大会--杭州来去匆匆

PostgreSQL 分组查询可以不进行全表扫描吗?速度提高上千倍?

POSTGRESQL --Austindatabaes 历年文章整理

PostgreSQL 查询语句开发写不好是必然,不是PG的锅

MySQL相关文章