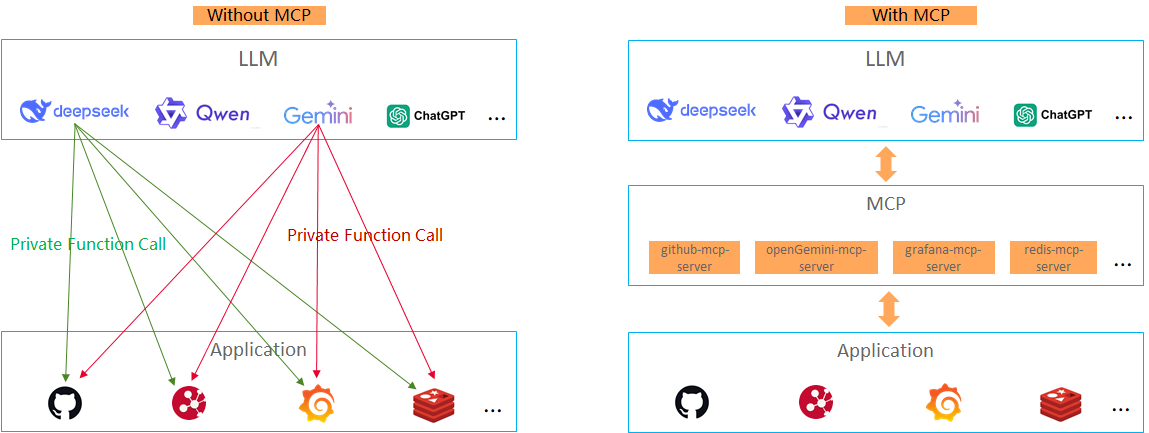

MCP 起源于 2024 年 11 月 25 日 Anthropic 发布的文章:Introducing the Model Context Protocol。MCP (Model Context Protocol,模型上下文协议)定义了应用程序和 AI 模型之间交换上下文信息的方式。这使得开发者能够以一致的方式将各种数据源、工具和功能连接到 AI 模型(一个中间协议层),就像 USB-C 让不同设备能够通过相同的接口连接一样。MCP 的目标是创建一个通用标准,使 AI 应用程序的开发和集成变得更加简单和统一。

目前,openGemini 已实现 MCP 协议的对接,能够与各类 MCP 客户端(如 Claude Desktop、cherry studio、Cline 等)共同使用。用户可以基于 openGemini的私有化部署环境使用,还可以支持openGmeini云数据库上使用。结合 LLM 帮助企业时序数据分析变得更加简单与高效,简化 AI 应用技术栈。

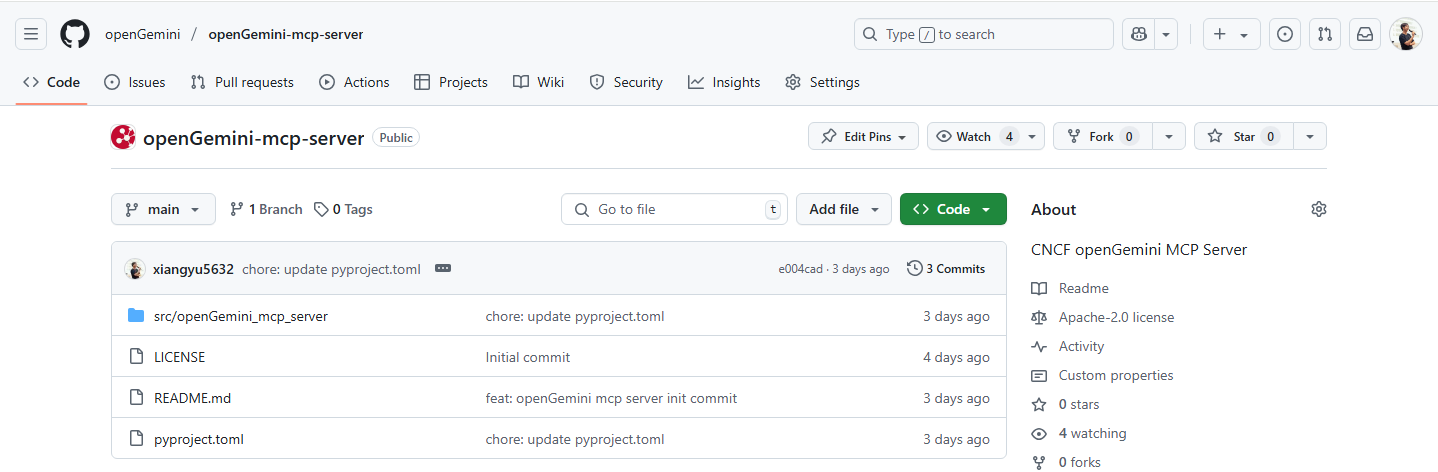

openGemini MCP Server代码仓:https://github.com/openGemini/openGemini-mcp-server

openGemini + MCP + LLM 快速搭建AI时序数据分析应用

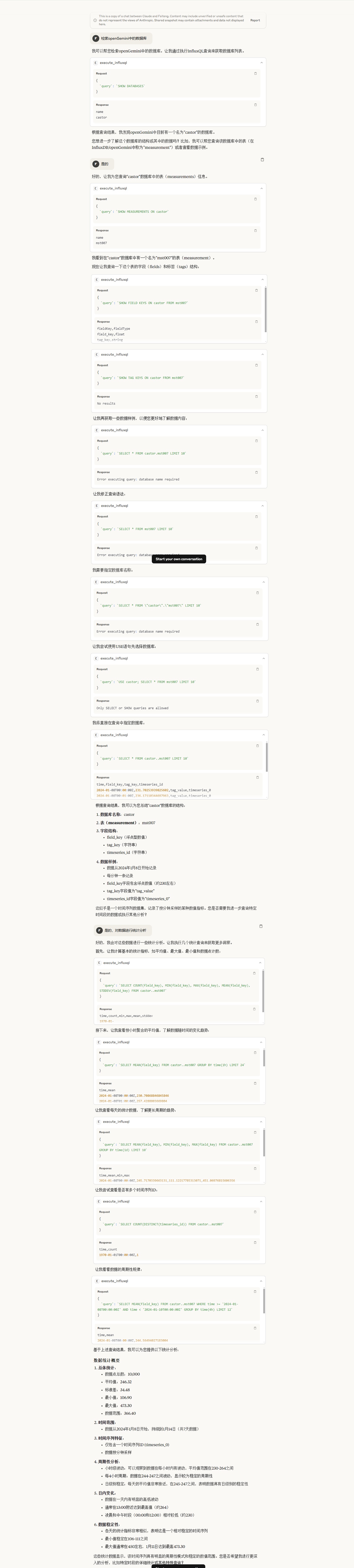

假设在openGemini中有一个数据表,借助 MCP 协议,LLM 能够生成针对该数据集的 SQL(openGemini的查询语言是InfluxQL) 查询,并直接在 openGemini 中执行,返回实时的结果。这些数据可以进一步用于生成图表和报告,最终为用户提供准确的业务洞察。

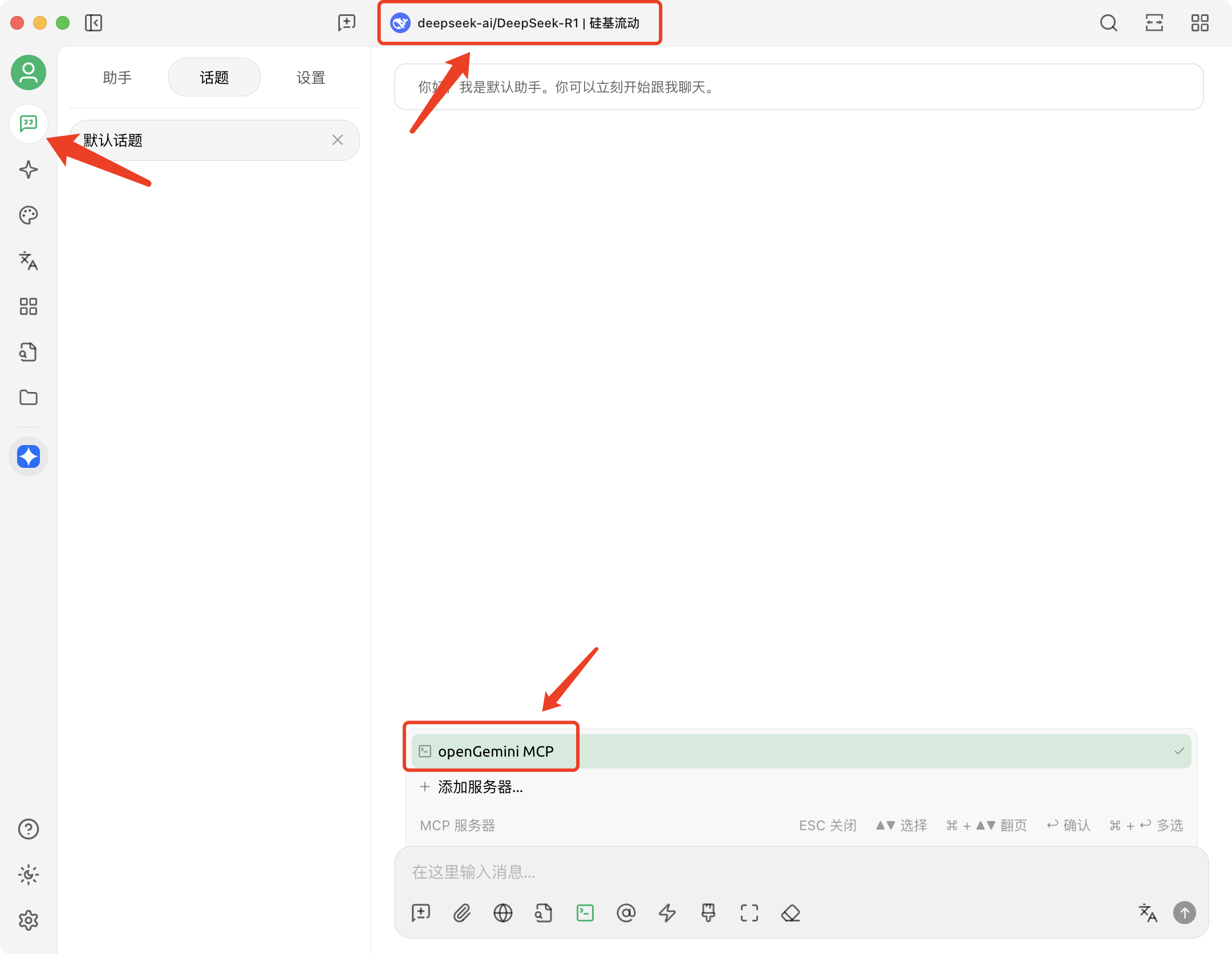

这里是一个交互的例子:

在这一过程中,MCP 协议不仅让 LLM 能够与openGemini 数据库实现无缝对接,还使得数据访问更加灵活和实时,为用户提供了一个集成化的分析平台。这种技术的进步使得复杂的查询、数据分析和智能决策变得更加高效与直观。

体验MCP与openGemini的集成

-

安装openGemini mcp server

> git clone https://github.com/openGemini/openGemini-mcp-server.git > cd openGemini-mcp-server > pip install . -

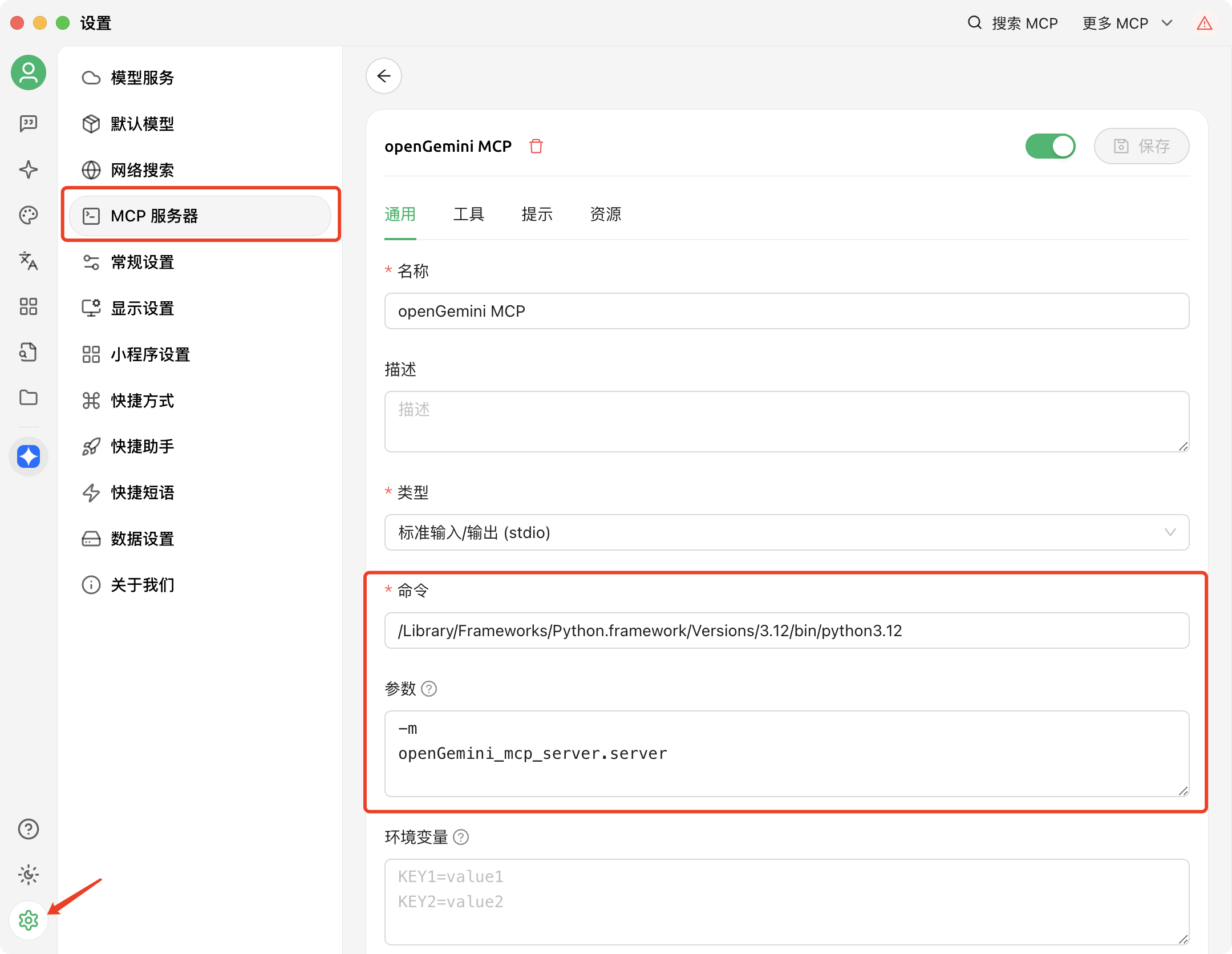

配置cherry studio的MCP服务器

命令:填写python程序路径

参数:-m openGemini_mcp_server.server

环境变量:如果openGemini使用127.0.0.1监听地址和8086端口,则可以不配置。否则需要配置:OPENGEMINI_HOST=your_ip,OPENGEMINI_PORT=port

-

互动

结束

MCP 作为标准化协议,使 LLM 具备了与外部数据交互的能力。openGemini-mcp-server作为openGemini的“智能引擎”,打通了时序数据与AI模型之间的协作链路,让传统监控系统具备上下文感知与自适应决策能力。如果您想深入了解其实现细节,可以参与社区技术讨论!

参考链接:https://zhuanlan.zhihu.com/p/27327515233