“引言:在云原生数据库加速渗透金融、电商等核心场景的今天,存算分离架构正以资源池化、弹性扩展的优势重塑数据基础设施。然而,这场架构革命的背后,一场更为隐秘的“网络暗战”正在打响——当数据访问路径从本地磁盘转向分布式网络,传统协议与硬件性能的瓶颈如影随形,成为制约云原生数据库突破的关键枷锁。”

网络发展背景:云原生与存算分离推动网络演进

在云原生数据库和分布式存储迅猛发展的背景下,数据中心网络正面临着前所未有的挑战。随着各厂商云原生架构的深化落地(包括微服务化、容器化部署等),各厂商对网络性能的要求呈现出指数级跃升态势。具体而言,金融交易系统要求实现微秒级时延的稳定控制以保障高频交易执行,电商平台在促销季需承载万级并发连接的瞬时流量峰值。

云原生数据库的存算分离架构使得数据访问路径从本地磁盘转向网络,进而促使高速网络成为架构发展的基石。云原生存算分离架构的演进,其本质是通过资源解耦和池化提升效率,然而这一演进也使得系统性能对网络的依赖越来越深:从微服务通信到分布式事务,以及从内存池化到存储扩展等关键场景中,高速网络已成为支撑云原生架构的核心基础设施。

面对协议复杂性、硬件成本攀升等挑战,各厂商通过技术创新(例如RDMA、智能网卡)和架构优化(例如网存协同、资源池化)双路径突破瓶颈,持续推动数据中心网络向更高性能、更低延迟、更智能化的方向演进。

传统网络协议的困境

传统TCP协议栈因内核处理存在瓶颈,在高吞吐量场景下,CPU利用率往往飙升至80%以上。作为网络性能提升的重要技术,RDMA虽然通过零拷贝机制实现了性能突破,但其固有问题(包括接口复杂性、连接数量限制以及拥塞控制能力不足等)导致在通用数据库应用中出现“理论性能优越,但实际落地困难”的困境。

困境1:TCP协议难以适应新的性能需求

由于内核协议栈处理效率较低,TCP协议存在显著的时延抖动问题。同时,TCP协议对多路径的利用不充分,无法充分发挥智能网卡的全部性能潜力。

困境2:RDMA技术理想与现实的差距

单网卡1.6万连接的硬件限制,在数据库服务现网超过2万连接的场景中,会导致内存溢出问题频发,需要频繁重建连接。同时,RDMA硬件资源(网卡Cache)有限,连接数激增时触发“Cache Ping-Pong”,导致性能急剧下降,难以支撑大规模数据库集群,扩展性受到的限制较大。除此以外,在网络拥塞时,RDMA无法快速调整发送窗口,当接收端过载导致连接中断后,业务恢复时间长达3 - 5秒,其故障恢复能力的不足导致OLTP交易成功率下降。

RDMA技术在硬件与开发层面也存在显著局限性。硬件方面,其对专用网卡存在强依赖,曾出现某新型网卡因驱动适配问题,延迟3个月才投入使用,极大阻碍了云基础设施的更新迭代。开发层面,异步连接的建立与关闭逻辑深度受制于硬件底层机制,并且业务代码稳定性完全依赖第三方库更新,一旦第三方库变动,便可能引发代码运行异常问题。

解决方案:HARP协议的创新突破助力冲出困境

腾讯云自研的HARP协议(Highly Available and Reliable Protocol,简称HARP)通过多路径冗余、共享连接架构与用户态协议栈的协同创新,构建了兼顾易用性、耐久性与运维效率的新型生态体系。

HARP 协议

在目前公开的传输协议中,HARP是首个可同时提供高可用和高扩展性的高性能传输协议,其重新定义了数据库网络传输模式:

高可用性

采用独创的确定性多路径技术,在交换机故障场景下可实现接近100%的业务存活率,故障恢复时间缩短至百微秒级别,同时,自研的拥塞控制算法PEAD可将时延P99降低90%,实现极小幅度的带宽波动控制,保障数据流公平性和超低网络排队。

高性能

通过软硬件协同架构实现全链路零拷贝,在大IO场景下,性能相比RDMA最高可提升50% - 70%,同时CPU利用率降低40%。

高扩展性

通过连接复用技术将应用层多进程通信复用到主机级/IP对级共享连接,有效避免了传统协议(如TCP/RDMA)因Fullmesh连接导致的连接数爆炸(如百万级 → 千级),从而突破硬件资源瓶颈;同时采用协议栈卸载设计,通过智能网卡硬件卸载传输层逻辑(如重传、拥塞控制),显著降低CPU负载,使单节点可支持10K+并发连接,适配超大规模数据库集群需求;确定性多路径的设计不仅天然支持横向扩容,新增节点时无需重构连接拓扑,还能保障系统性能的线性增长;此外,HARP兼具优秀的易运维特性,其采用类Socket API设计显著降低开发成本,配备全链路监控工具实现故障快速定位,在实际应用中长期稳定运行并展现出极高的可靠性。

自主可控性

协议栈的自主可控,能够摆脱第三方闭源协议栈限制,提升架构灵活性。掌握功能迭代主动权,可针对数据库场景定制协议逻辑。同时,凭借全链路可见性,能够快速解决现网问题,无需对厂商的依赖。通过驱动层与用户态库解耦,也可实现协议栈热升级,避免服务中断。

HARP 协议架构解析

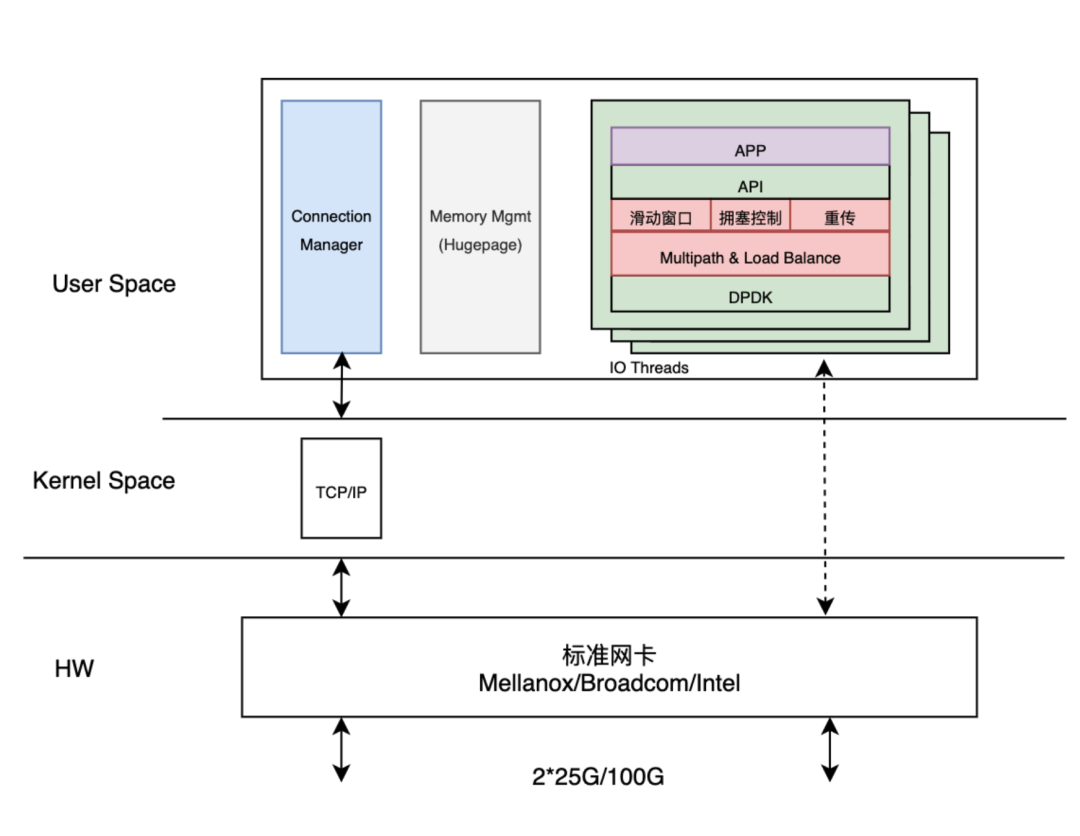

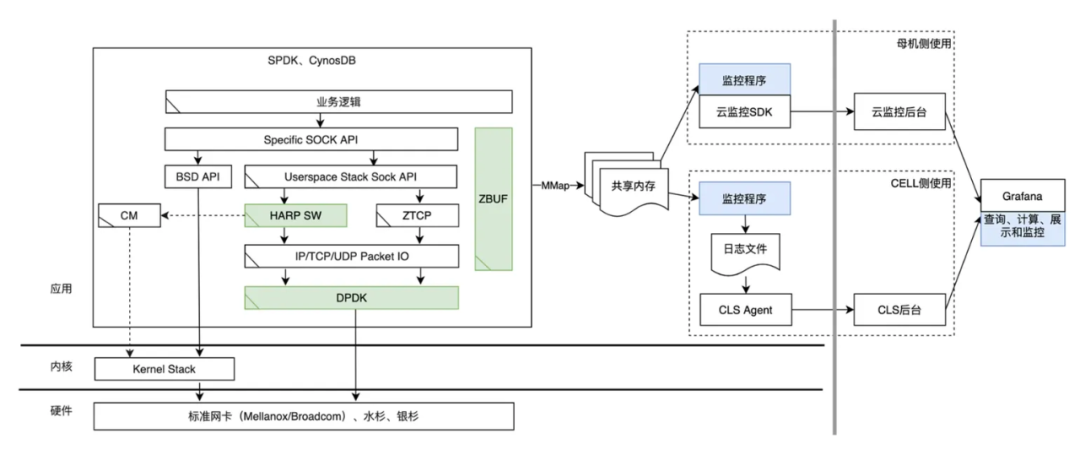

HARP 协议采用软件和硬件分层的架构 ,在事务层(软件),提供类Socket API,简化开发流程,支持灵活的业务逻辑处理;在可靠传输层(硬件),协议栈卸载至智能网卡,可实现高效数据处理。

其关键技术包括确定性多路径传输、自研拥塞控制算法和共享连接机制。其中确定性多路径传输通过优化路径选择机制,有效规避传统ECMP哈希路径的物理重叠问题,在单交换机故障情况下仍能保持100%的连接存活率;自研拥塞控制算法能够动态感知网络状态,优化带宽利用率与公平性,同时降低时延波动;共享连接机制则采用主机或VM级的复用连接,大幅减少连接数,有效提升资源利用率。

HARP在数据库场景中的全面优势

HARP测试说明

测试环境

网络:云服务器CVM和TDSQL-C MySQL 版集群网络类型均为私有网络(VPC)且在同一子网下。

测试集群规格:2核8GB。

测试集群形态:预置资源。

测试工具

SysBench 是一个跨平台且支持多线程的模块化基准测试工具,用于评估系统在运行高负载的数据库时相关核心参数的性能表现。

测试场景

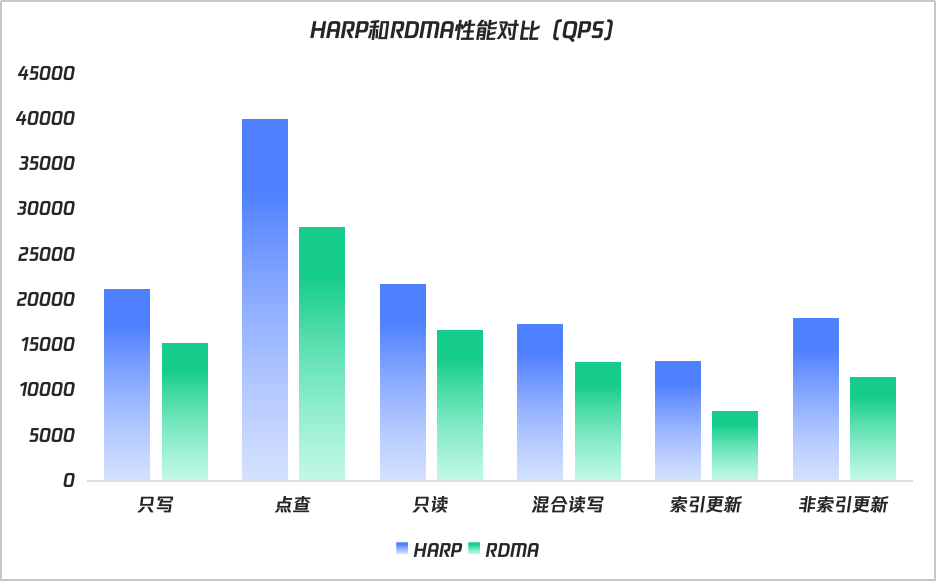

本次压测从6个场景进行测试,分别是:只写场景、点查场景、只读场景、混合读写场景、索引更新场景以及非索引更新场景,每个场景并发线程为128,数据量约100GB,取压测下的QPS值作为性能结果指标。

测试结果

写操作全面领先:HARP在索引更新场景性能提升72%,非索引更新提升56%,验证其对写密集型OLTP负载(如订单状态变更、库存扣减)的深度优化能力。

高频点查优势突出:点查性能提升42%,表明HARP的低时延特性可有效支撑金融实时交易、社交Feed流等高并发查询场景。

复杂操作稳定性:混合读写场景提升32%,体现HARP在资源隔离与优先级调度上的设计价值,避免OLTP与OLAP混合负载的相互干扰。

锁竞争大幅缓解:索引更新场景的72%提升,源于HARP协议层原子操作与存储引擎锁机制的协同优化,减少全局锁争用导致的性能塌陷。

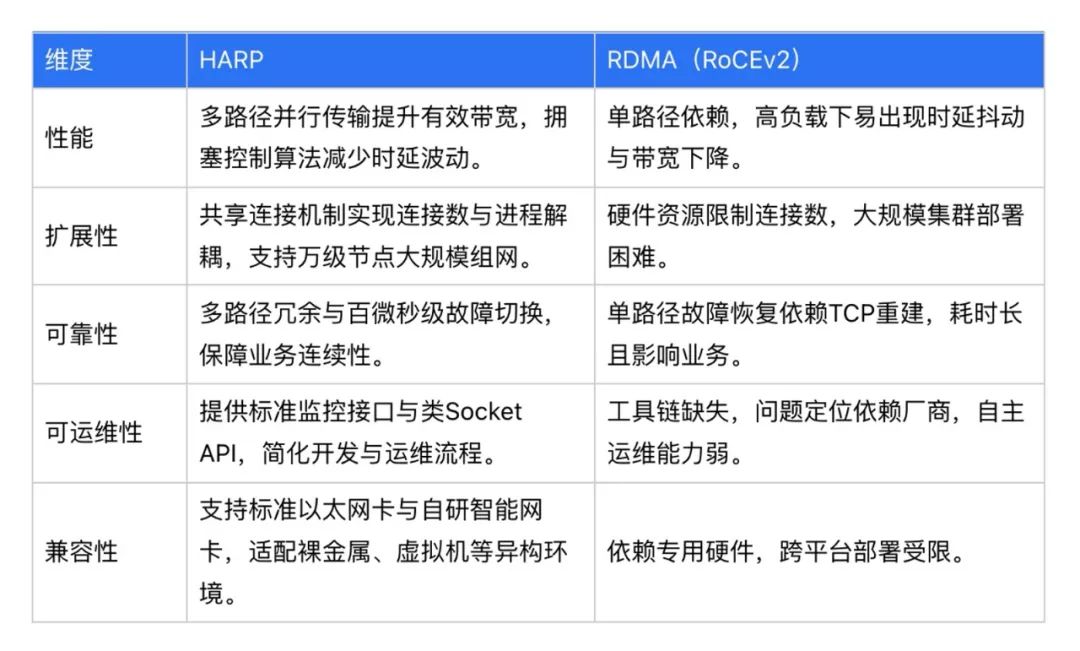

数据库作为承载核心数据资产的关键基础设施,其重要性日益凸显,同时也面临着日益复杂且严峻的挑战。传统TCP协议栈和RDMA技术在高吞吐量场景下存在性能瓶颈,难以满足现代数据中心对网络传输的高要求。腾讯云自研的HARP协议通过多路径冗余、共享连接架构与用户态协议栈的协同创新,构建了兼顾易用性、耐久性与运维效率的新型生态体系。HARP协议在性能、扩展性、可靠性、可运维性和兼容性等方面均具有显著优势,能够有效解决传统网络协议面临的困境,为数据安全与业务连续性提供保障。随着云计算和分布式计算的不断发展,HARP协议有望在更多领域发挥作用,推动数据中心网络向更高性能、更低延迟、更智能化的方向演进,为企业提供坚实的网络基础。