数据中心正常运转需要满足三个基本条件。首先是建筑设施,能够保护服务器免受雨雪侵袭,甚至把风滚草挡在门外的场所。其次是电力供应,即维持所有服务器持续运转的动力之源。第三是制冷系统,这是服务器防宕机的关键保障,缺失将导致数分钟内过热停机。

目前,亚马逊云科技乃至整个数据中心行业,正在经历从气冷向液冷解决方案的转型。这种转变已在亚马逊云科技部分业务领域展开,其重要性在于数据中心实际上还需要第四个要素:持续进化能力。去年,亚马逊云科技宣布将推出新的数据中心组件,以支持下一代人工智能创新和客户不断发展的需求。气冷向液冷的转型,在此过程中扮演着关键作用。

气冷已近极限

数据中心寻求新散热之道

数据中心的制冷系统与家庭或办公室的空调系统大不相同。

亚马逊云科技数据中心制冷系统高级经理Dave Klusas表示:“虽然称之为制冷,但并非维持在20摄氏度的舒适环境。而是让足够的空气流经服务器以防止过热,同时尽可能减少能源和水资源的使用。实际上,这意味着夏季数据机房温度会相当高。”

截止目前,气冷系统始终在亚马逊云科技数据中心承担着散热使命。其基本原理可概括为:引入外部空气,使其流经服务器机架阵列进行循环。当气流穿过电子元件时吸收热量,随后排出室外,同时新鲜冷空气持续补充进入,如此往复完成热交换过程。但现在,单靠气冷已经不够了。

就当今的AI芯片而言,训练大语言模型等工作负载需要在尽可能小的物理空间内集中尽可能多的芯片。这样做可以减少通信延迟,从而提高性能,进而降低成本和能源消耗。

每颗AI芯片每秒执行万亿级数学运算。为此其功耗远超传统芯片,同时产生更多热量。这需要更多的气流来散热,单靠空气冷却这些芯片既不实际也不经济。

Klusas说:“我们已经跨过了一个门槛,使用液冷来散热变得更加经济。”

液冷高效降温

定制芯片直冷新方案

液冷技术较气冷方案更为复杂,但由于液体的密度是空气的900多倍,可以吸收更多的热量。这就像在炎热的海滩上,跳入海中会比吹海风更让人清爽的道理一样。

Klusas团队评估了多家供应商的液冷解决方案,发现均无法满足亚马逊云科技的技术需求,这促使他们走上了设计和交付完全定制系统的道路。

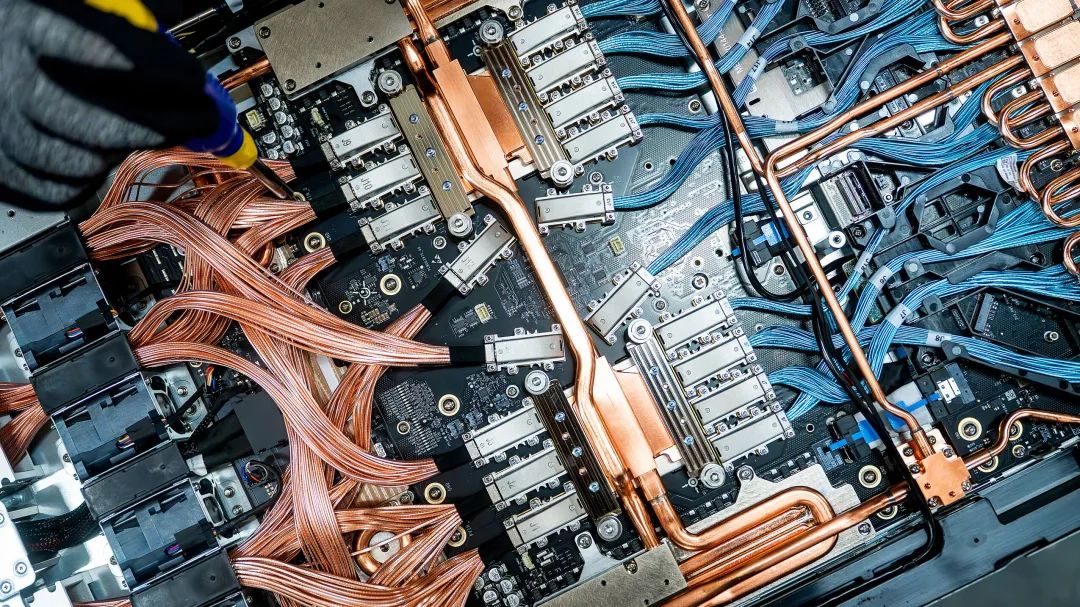

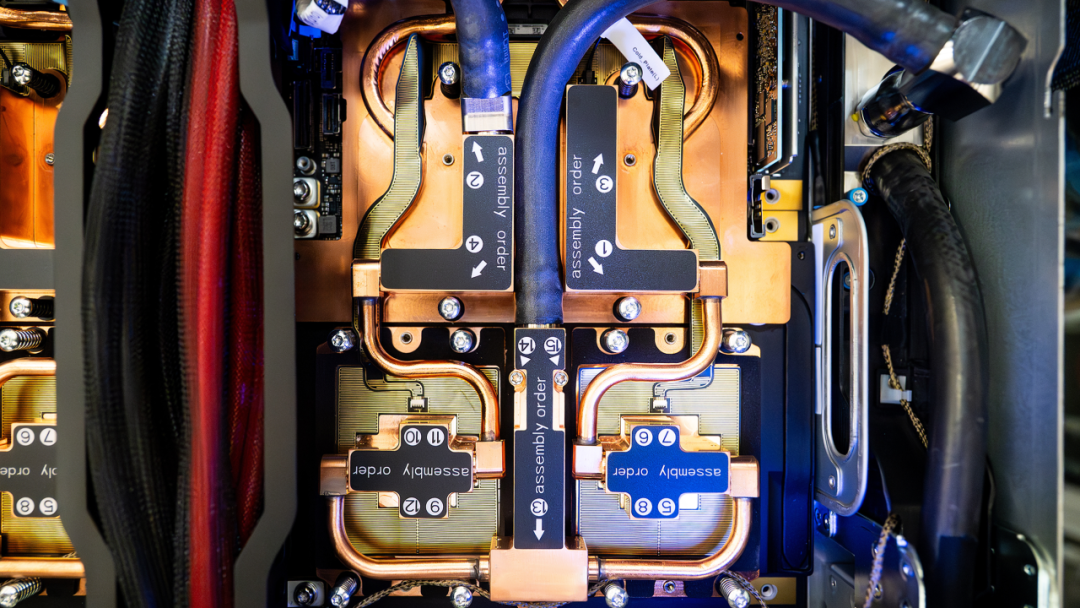

亚马逊云科技采用了直接芯片冷却方式,即在芯片顶部直接安装“冷却板”。液体在密封板内的管道中流动,吸收热量并将其带出服务器机架。

随后,冷却液流经热交换系统(这种液体是专门为了散热设计的),经降温处理后,重新循环回冷却板。这个过程是完全“闭环”的系统,液体会持续循环使用,不会增加数据中心的用水量。

与空气冷却系统同理,其目标是仅使用刚好够用的液体,防止服务器过热,同时尽可能减少额外的能源消耗。

15个月极速量产

模块化液冷按需精准启用

亚马逊云科技仅耗时4个月便完成从设计图纸定稿到原型机验证,再经11个月实现首套生产系统交付。该周期涵盖设计开发、供应链建设、控制软件编写、全系统测试及量产部署全流程。

灵活性至关重要。建造一个数据中心需要很长时间,在这个过程中,市场需求的波动,技术的进步,都会让人重新衡量液冷和气冷的使用。

亚马逊云科技的设计理念是适应不断变化的需求。Klusas表示:“我们设计的液冷系统可以在需要时轻松地添加到数据中心,同时避免在不需要的地方增加额外支出。”

另一关键创新在于定制化冷却液分配装置,它比现成的同类产品更强大、更高效。Klusas说:“这是针对自身需求发明的系统。通过专注于解决特定问题,能够优化成本、提高效率并增加容量。”

推广部署

拓展数据中心制冷力

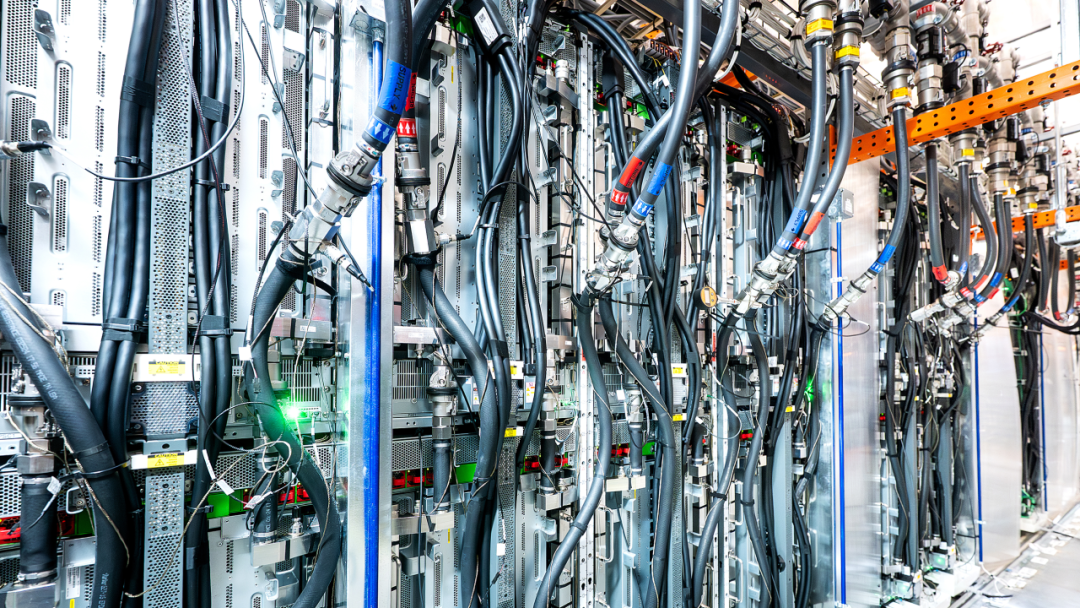

Klusas的团队在亚马逊云科技研发中心完成系统首次验证,该实验室用于测试所有将进入数据中心的设备。随后,团队在生产数据中心部署了测试单元。如今该系统已经具备了规模化应用的条件,并将逐步扩大制冷工作负载,以便在其他数据中心推广。

期待你的分享 收藏 在看 点赞!

亚马逊的一小步,云计算的一大步!

点击阅读原文,获取更多精彩内容!