想象一下:你给一个从未见过猫的孩子两张图——一张是2D卡通猫,另一张是3D毛绒玩具。哪个更容易让他理解“猫”的真实形态?毫无疑问,立体的触觉和视觉体验,远胜于平面图像。

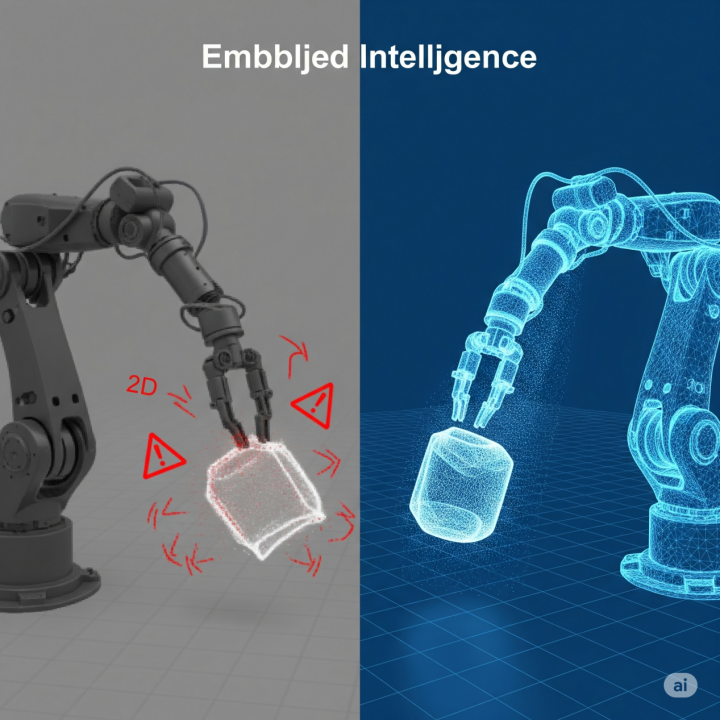

AI的学习过程类似。今天的计算机视觉系统,大多像“只看图画书的孩子”——它们通过数百万张2D照片学习“猫”的概念,但永远无法真正理解猫的立体结构、毛发质感,或者它跳上桌子时的空间轨迹。

人工智能的发展正经历着从二维平面到三维立体的认知跃迁,这就像人类从学会看图识字到掌握空间思维能力的进化过程。当前,全球AI技术已经突破了简单的图像识别阶段,正在向更高级的空间智能迈进。视觉-语言-空间(Visual-Language-Spatial,简称VLS)大模型作为这一变革的核心载体,不再满足于识别图片中的物体,而是致力于实现"具身智能"——让AI系统具备类似人类的立体感知和空间理解能力。

当我们走进一个陌生的房间,能立即感知房间的大小、家具的摆放位置、门窗的朝向,甚至能预估不同物体之间的距离。这种看似简单的空间认知能力,对AI系统而言却是一个巨大的挑战。传统的二维AI就像通过钥匙孔看世界,只能获得有限的平面信息;而三维AI则是打开大门,直接观察和理解整个立体空间。

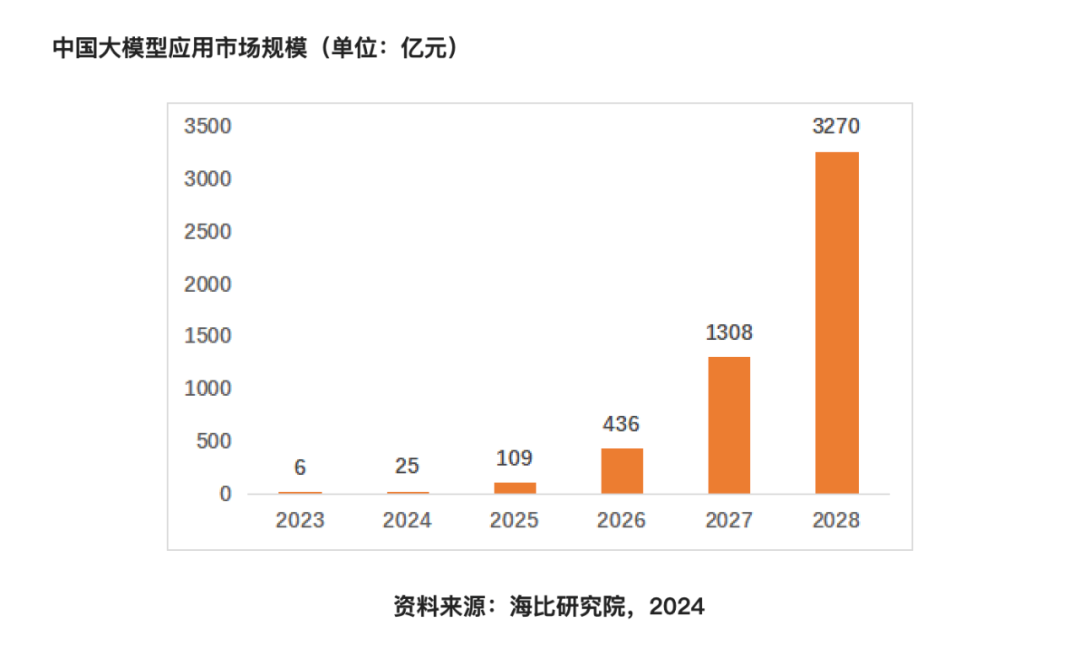

这种维度跃迁带来的变革是革命性的。在自动驾驶领域,三维感知能力意味着车辆不仅能识别前方障碍物,还能精确计算其距离和运动轨迹;在工业机器人应用中,机械臂可以更精准地抓取和操作物体;在医疗影像分析中,医生可以获得器官的立体模型而非简单的切片图像。海比研究院数据表明,我国大模型应用市场2027年将突破1000亿元,达到1308亿元。主要类别包括AIGC、智能助理、AI Agent、具身智能、行业应用等。

三维合成数据技术正在重塑AI发展的轨迹,为机器理解物理世界提供关键支持。天云数据通过创新的技术体系和规模化生产能力,使高质量三维训练数据变得可及、可用、可靠。从自动驾驶到工业4.0,从医疗健康到元宇宙,基于三维理解的空间智能将开启AI应用的新篇章。

本篇我们将重点诠释:当前AI的"平面困境"——当智能遇上维度的枷锁

<一>

互联网时代的"平面盛宴"

我们正处在一个奇特的AI发展悖论中:最先进的视觉AI系统,却被迫用"独眼龙"的方式看世界。当前主流的视觉-语言大模型(VLS)就像被喂养了大量"平面食物"——互联网上数以百亿计的二维图像和视频构成了它们的"主食"。OpenAI的CLIP模型吃下了4亿多张带文字描述的图片,Google的PaLI-3模型更是消化了超过10亿张图像。这种数据盛宴造就了令人惊艳的二维图像理解能力,却也埋下了认知局限的种子。

这种对二维数据的依赖,本质上是一场"数据饥荒"下的妥协。想象一位画家只能用黑白两色作画——不是因为他偏好单色,而是彩色颜料太过昂贵。同样,AI研究者选择二维数据,不是因为它们更好,而是因为三维数据实在太难获取。制作一个高质量的三维扫描数据集,成本可能是同等规模二维数据集的100倍以上。著名的三维数据集ScanNet花费数年时间才收集了1500多个室内场景,而二维的COCO数据集轻松就包含了30多万张标注图像。

<二>

一个主流且务实的工程路径

先利用海量二维数据预训练出一个强大的视觉-语言基础模型,然后通过各种“桥接”技术,试图将二维知识“提升”或“迁移”到三维任务中 。这种方法在一定程度上推动了VLS模型的发展,但其上限被二维数据本身的维度所限制。

这种二维依赖造成了AI系统的"先天性近视"。在自动驾驶场景中,基于纯视觉的系统常常犯下令人啼笑皆非的错误:把夕阳下的刹车灯误认为交通信号灯,将卡车侧面的广告画误认为真实场景。特斯拉的自动驾驶系统就曾因为这种"平面思维",把横挂的卡车车厢误判为道路上的标志牌,导致致命事故。

工业检测领域同样深受其害。传统的2D视觉检测系统可能会漏掉这些关键缺陷:

零件侧面的裂纹(因为只拍摄了顶部视图)

微小的深度凹陷(在平面图像中几乎不可见)

复杂的装配错位(需要三维视角才能判断)

医疗诊断中的局限更为严峻。X光片只能提供器官的"扁平投影",医生需要像解谜一样在重叠的阴影中寻找病灶。而三维CT重建则能让肿瘤"浮出画面",精确显示其与周围组织的空间关系。研究表明,使用三维影像可使肺癌早期诊断准确率提升35%。

<四>

三维数据:打开认知枷锁的钥匙

当AI获得真正的三维数据时,其能力提升就像近视者第一次戴上合适的眼镜。

在建筑领域,采用BIM(建筑信息模型)后,工人可以在虚拟空间中"走进"未建成的建筑,检查每一根管线的走向,这是平面图纸永远无法提供的体验。

在电商平台,消费者可以旋转查看商品的每个细节,就像把实物拿在手中把玩。

在医疗培训中,三维解剖模型让学习效率翻倍。医学生可以像"拆积木"一样分离器官层,观察肌肉纤维的走向,这是传统解剖图谱难以企及的教学效果。

未完待续~