01

前言

随着人工智能技术的快速发展,大型语言模型(LLM)已经不再是云端专属服务。现在,通过一些工具组合,我们可以在个人Windows电脑上部署和运行像DeepSeek这样的强大语言模型。本文将介绍如何使用Ollama和Cherry Studio在Windows环境下搭建本地DeepSeek大模型服务。

02

准备工作

在开始之前,请确保你的Windows电脑满足以下要求:

操作系统:Windows 10/11 64位

硬件配置:

至少16GB RAM(推荐32GB或以上)

支持CUDA的NVIDIA显卡(如RTX 3060或更高,可选但推荐)

至少50GB可用存储空间

已安装最新版显卡驱动(如使用GPU加速)

03

安装Ollama

什么是 Ollama?

Ollama 是一个简化大型语言模型(LLM)部署和使用的工具。它具有以下特点:

- 本地运行:

模型完全在您的本地计算机上运行,无需联网,保护您的隐私和数据安全。 - 简单易用:

通过简单的命令行指令,即可下载、运行和管理各种 LLM。 - 模型丰富:

支持 Llama 2、Deepseek、Mistral、Gemma 等多种流行的开源模型。 - 跨平台:

支持 macOS、Windows 和 Linux 系统。 - 开放API

:支持与OpenAI兼容的接口,可以和其他工具集成。

为什么要在 Cherry Studio 中使用 Ollama?

- 无需云服务:

不再受限于云端 API 的配额和费用,尽情体验本地 LLM 的强大功能。 - 数据隐私:

您的所有对话数据都保留在本地,无需担心隐私泄露。 - 离线可用:

即使在没有网络连接的情况下,也能继续与 LLM 进行交互。 - 定制化:

可以根据您的需求,选择和配置最适合您的 LLM。

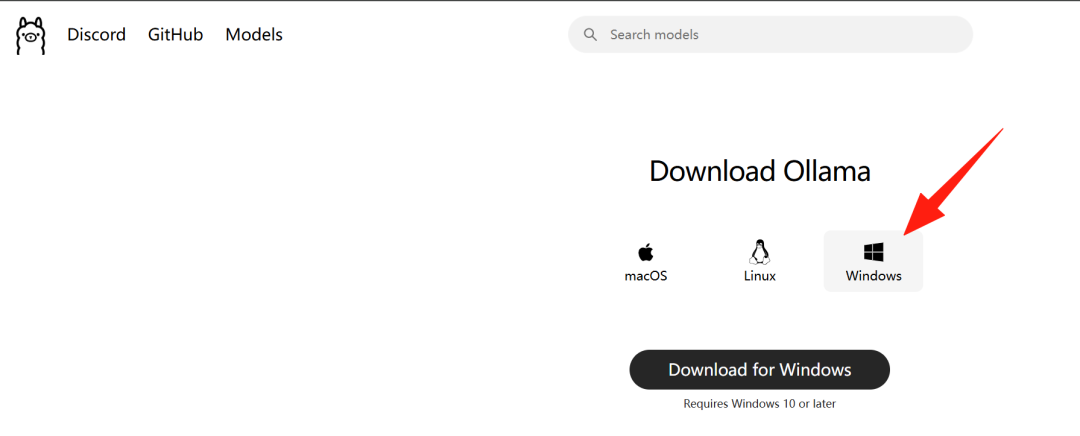

1、访问Ollama官网(https://ollama.ai/)下载Windows版本

选择Windows版本进行下载安装即可。(同时可以看到也支持MacOS和Linux),本次只选择安装Windows版本

2、运行安装程序,按照提示完成安装。

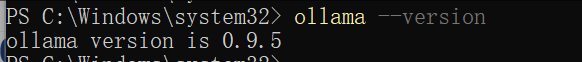

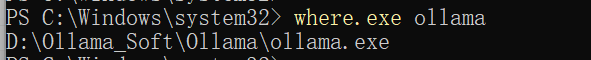

3、安装完成后,打开命令提示符(CMD)或PowerShell,测试是否安装成功

可以看到可以成功了。

其中Ollama程序默认安装在:

C:\Users\你的用户名\AppData\Local\Programs\Ollama

Ollama模型默认安装在:

C:\Users\你的用户名\.ollama\models

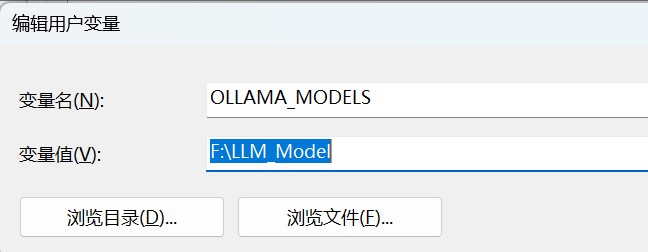

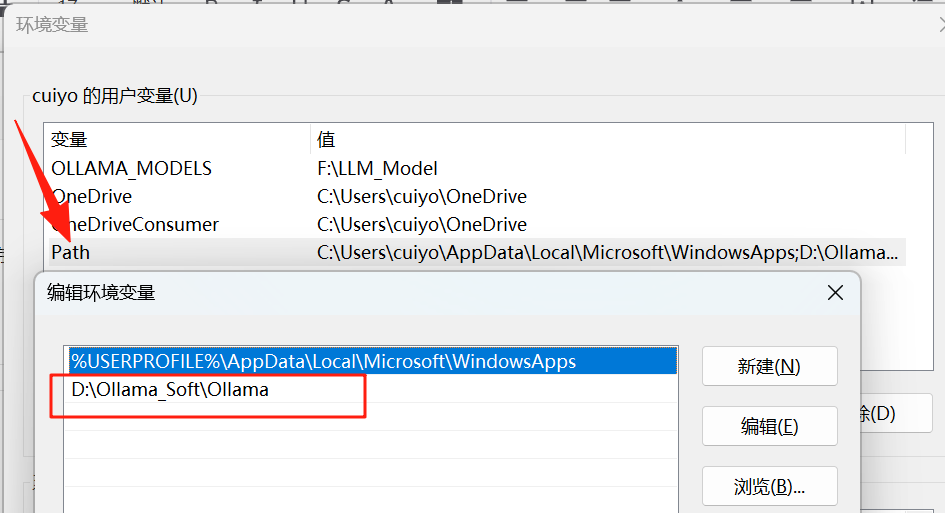

4、进行调整ollama安装路径以及模型下载路径

因此为了方便后续管理进行Ollama路径调整以及模型路径修改(前面是修改后的路径),下面是如何进行修改:

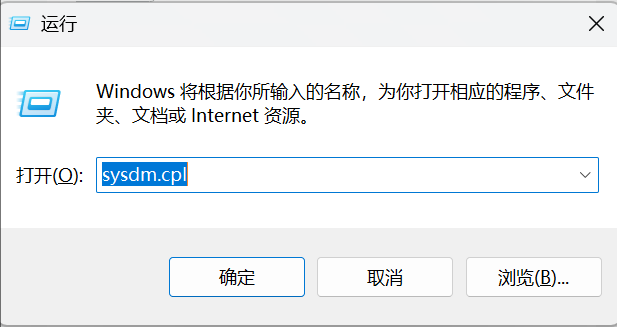

Win+R

04

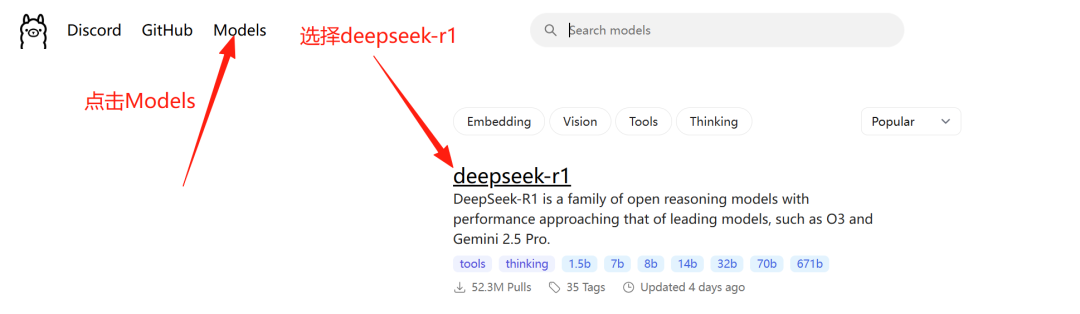

下载DeepSeek模型

Ollama支持多种模型,我们需要下载DeepSeek模型:

打开命令提示符,运行以下命令下载模型:

##Pull是拉取模型ollama pull deepseek-r1:7b##run 是启动模型ollama run deepseek-r1:7b

(注意:模型名称可能有多个版本,请查看Ollama官方文档获取最新模型名称)

等待下载完成,这可能需要较长时间,取决于你的网络速度。

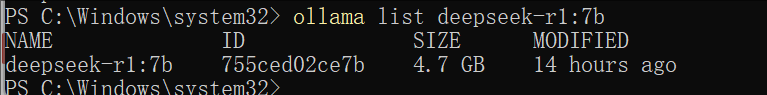

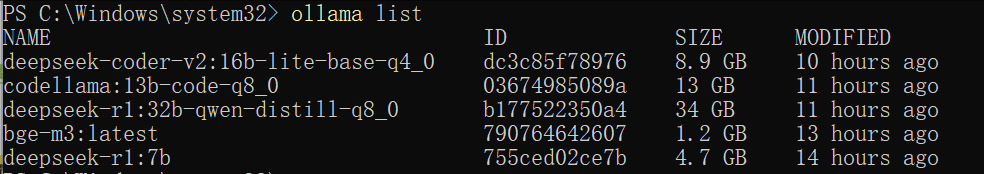

下载之后查看:

说明已经正常获取了。

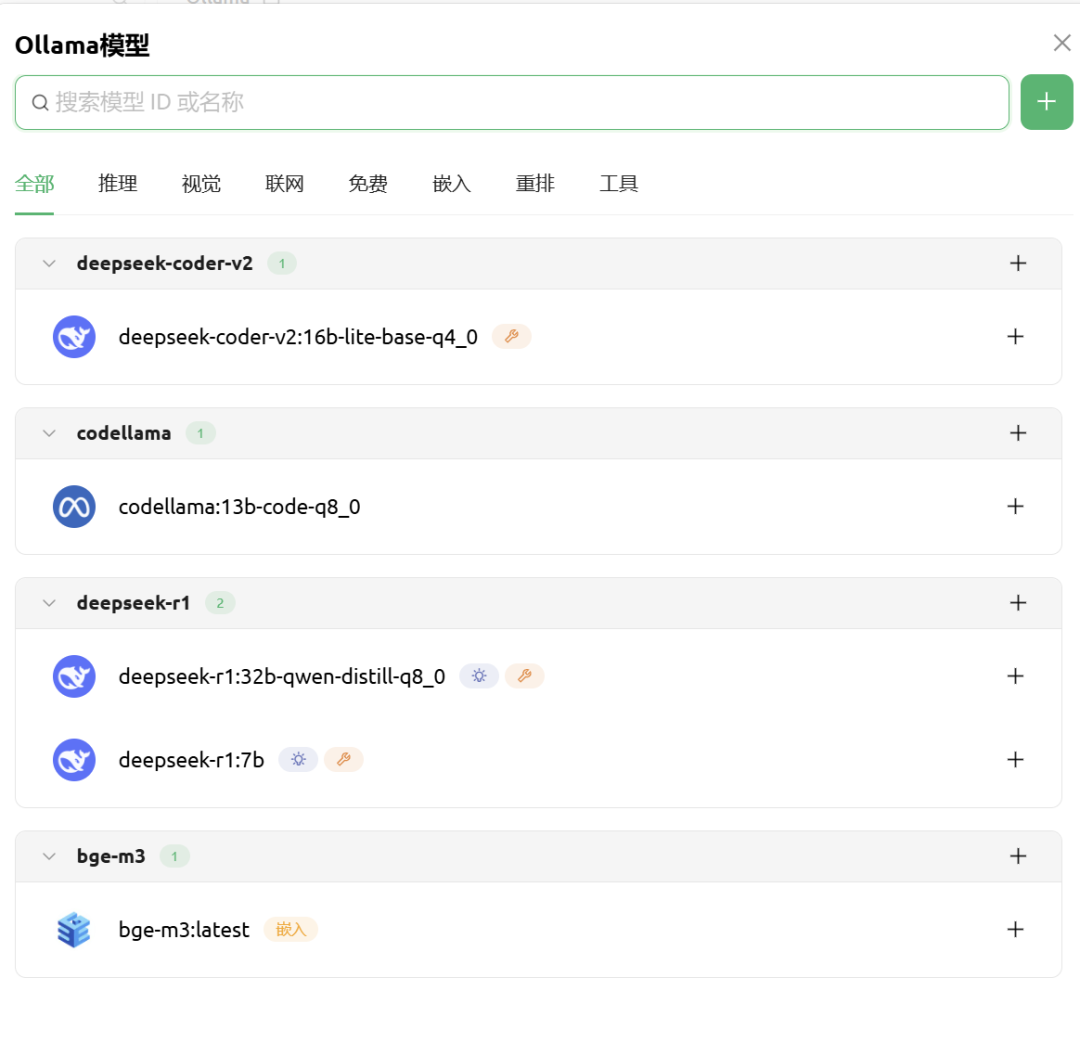

这是我安装的有些模型,也一起放一下。

相关命令进行参考,本文不做过多描述。

04

Cherry Studio 是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台。 Cherry Studio 高度自定义的设计、强大的扩展能力和友好的用户体验,使其成为专业用户和 AI 爱好者的理想选择。无论是零基础用户还是开发者,都能在 Cherry Studio中找到适合自己的 AI 功能,提升工作效率和创造力。

1、下载安装Cherry Studio

通过官网地址进行下载:https://www.cherry-ai.com/download

2、运行安装程序,按照提示完成安装

安装选择路径 下一步就可以了,本次不做展示了。

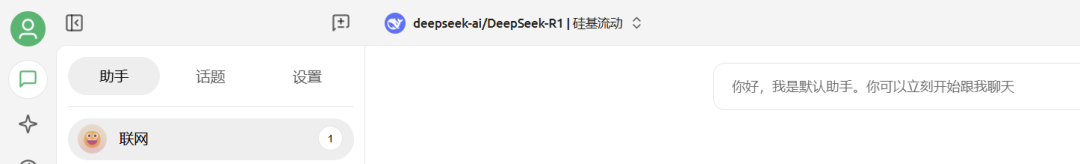

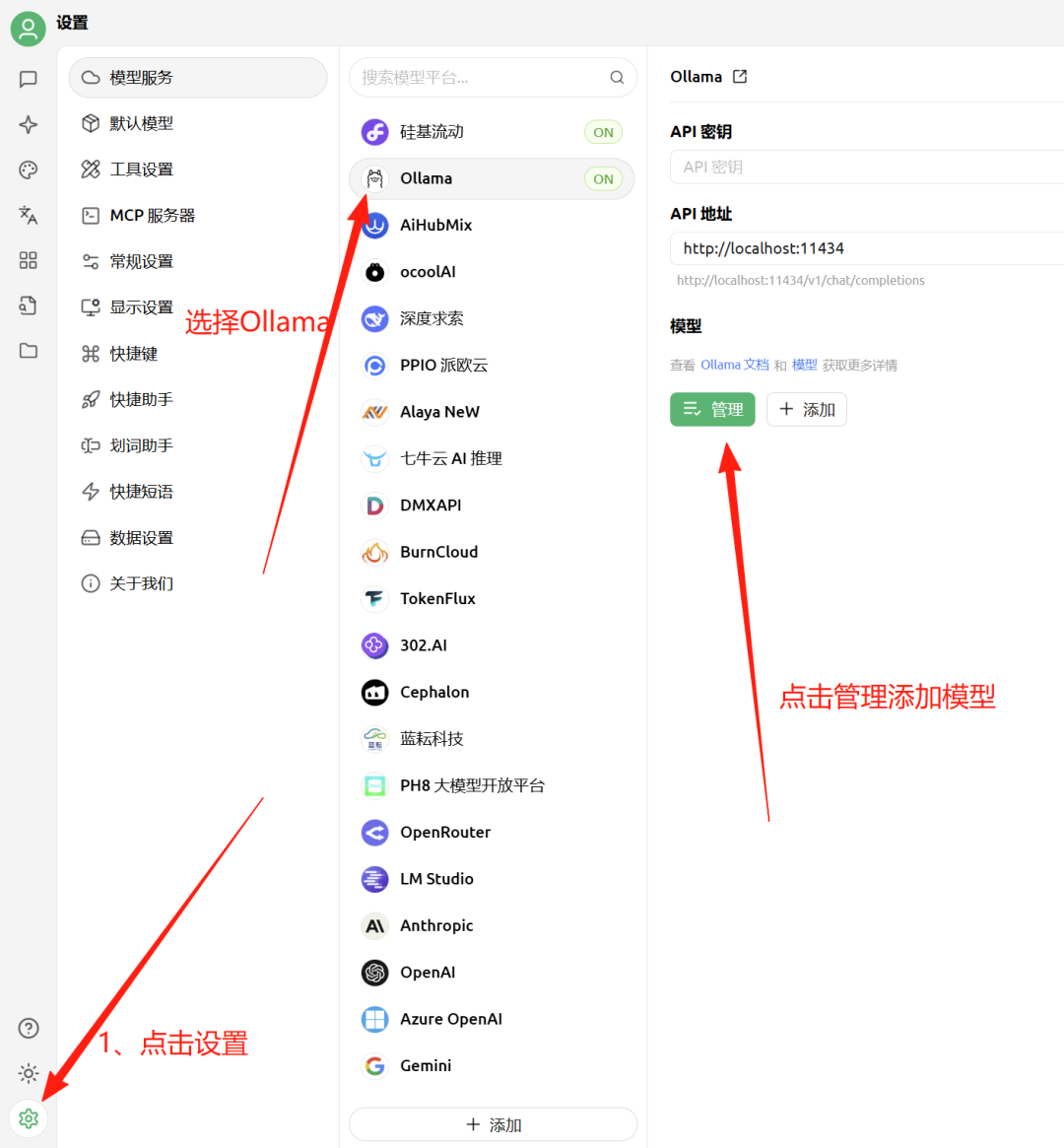

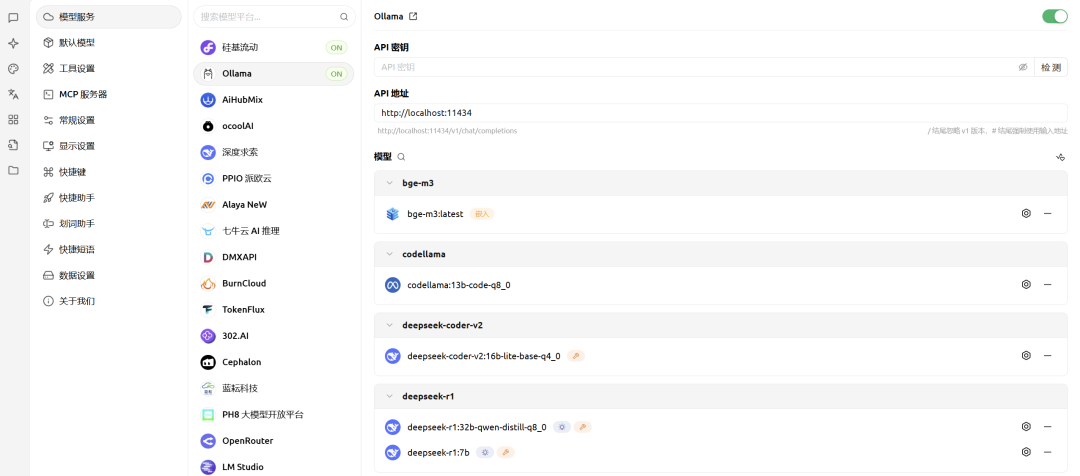

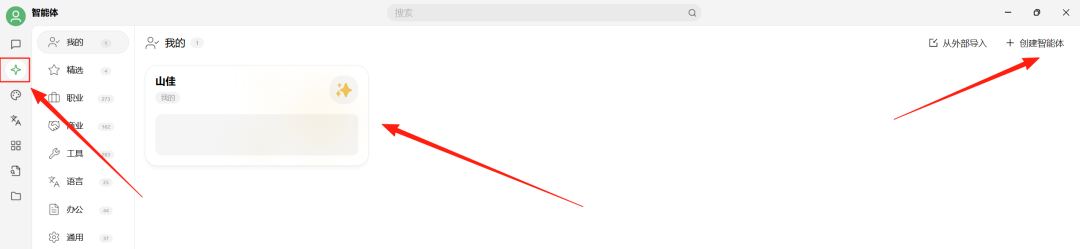

3、启动Cherry Studio

接下来进行配置:

前文下载的大模型,就可以看到了,然后点击右边的加好就可以了。

05

使用Deepseek

总体来说,效率还算不错,后边可以使用自己本地的大模型了,还有很多的功能等待发掘。

06

总结

通过Ollama和Cherry Studio的组合,我们在Windows电脑上成功部署了本地DeepSeek大模型。这种方法不仅提供了隐私保护(数据不上传云端),还能根据个人需求灵活调整模型配置。随着硬件性能的提升和模型优化技术的进步,本地运行大语言模型将变得越来越可行。