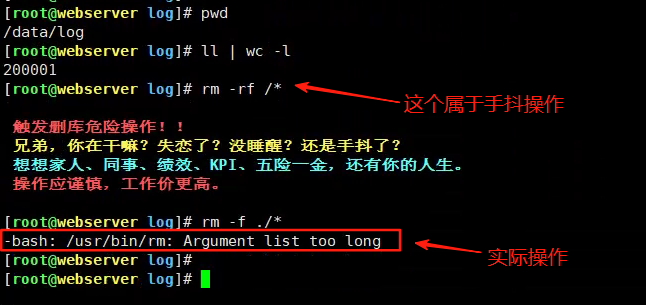

相信很多运维同行都遇到过下面这种情况,处理日志时是非常常见的。

对于新手来说,看着这个报错可以能有点懵,下面我将讲解这个问题出现的背后原理和处理方式。

1 原理解析

简单说,这个错误是因为你命令里的文件列表太长了,系统顶不住了,不仅rm命令会出现,像cp,mv这些命令也会出现这个问题。

Shell 参数设置问题当你写 rm ./*

,Shell 会先把目录下所有文件名都列出来,拼成一大串参数传给rm

。 这个参数串不能无限长,Linux 系统设了个最大值,叫ARG_MAX

,一般几 MB。超了就报“Argument list too long”。系统调用瓶颈即使没爆参数限制,删除百万文件也是个大工程。 rm

每删一个文件都要调用一次系统函数unlink()

,每次调用都有开销。

2 四种解决方法

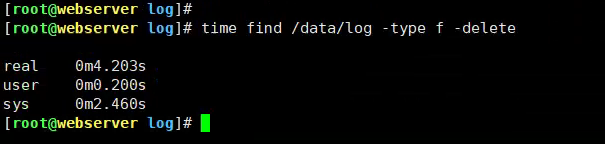

2.1 用 find

的 -delete

逐个删,避开参数限制

find data/log -type f -delete

原理:

find

直接调用系统接口,文件一个一个删,不经过 Shell 参数展开,稳!

我用time命令测试了一下删除时间,用了4秒,还是挺快的。

我用time命令测试了一下删除时间,用了4秒,还是挺快的。

2.2 分批删除,用 xargs

控制删除数量

find data/log -type f | head -n 10000 | xargs rm

循环执行几次,慢慢清光。

优点:I/O 压力小,安全又高效。

2.3 直接删除整个目录,重建空目录

rm -rf data/log

mkdir data/log

注意:务必确认路径,别误删别的目录,血的教训!

2.4 利用 rsync

同步空目录,快速清空

mkdir empty_dir

rsync -a --delete empty_dir/ var/logs/

rmdir empty_dir

妙用:高效快速,且保持目录权限结构。

3 血泪经验

刚入职时,一次误操作删了生产日志目录,导致服务崩溃,找数据花了好几天。原因就是没理解这些细节。

所以,删除大批量文件,请务必:

先确认路径,用 ls | head

看清楚优先用 find -delete

或分批删除生产环境动手前备份很重要!

如果有错漏,敬请斧正!如果觉得有用,别忘了点赞和关注!

技术系列合集专栏推荐:

文章转载自小周的数据库进阶之路,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。