摘要:本文基于 Apache Flink PMC 成员宋辛童在 Community Over Code Asia 2025 Streaming 专题技术分享中的演讲内容整理而成,详细介绍了 Flink Agents 项目的技术背景、架构设计和应用前景。

Tips:关注「公众号」回复 FFA 2025 查看会后资料~

在人工智能技术快速发展的今天,AI 应用从简单的对话交互正在向更加复杂和智能化的方向演进。Apache Flink 社区最近推出了一个全新的项目 —— Flink Agents,这是一个专门为事件驱动场景设计的智能体框架。本文将深入探讨 Flink Agents 的技术架构、应用场景以及它在 AI 工程化道路上的重要意义。

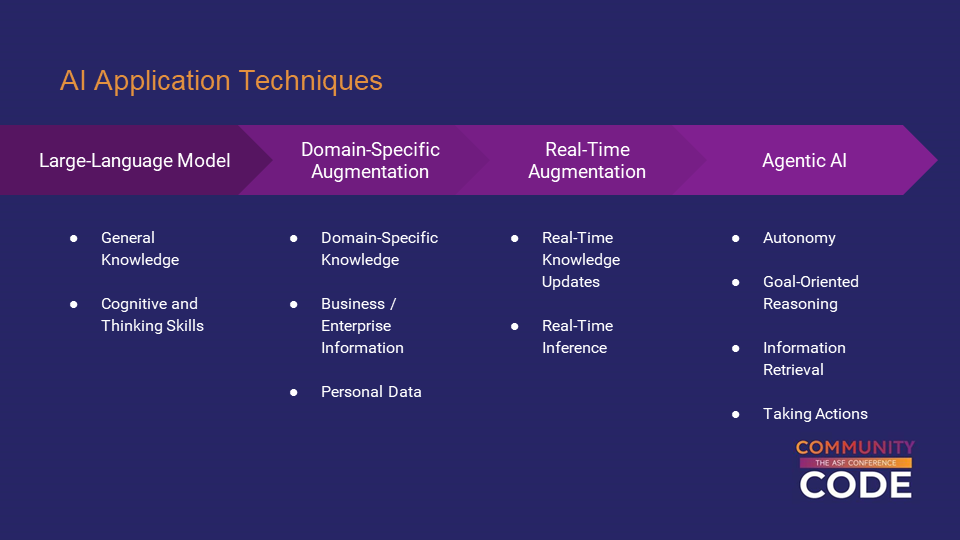

AI应用技术的四个发展层次

当前 AI 应用技术的发展可以分为四个主要层次。第一层是基础的模型调用能力,这是所有 AI 应用的基础。第二层是领域增强技术,通过专业知识的注入让 AI 在特定领域具备更强的专业能力,而不再是一个通用的智能系统。

第三层是实时增强能力,这是一个至关重要的发展方向。在传统的 AI 应用中,上下文信息往往是静态的,而实时增强技术能够让 AI 访问到最新鲜、最及时的上下文信息。举例来说,当用户向客服机器人求助时,如果系统能够实时获知这个用户在一分钟前刚刚使用产品时遇到了什么错误,以及用户的历史使用记录,就能够提供更加精准和个性化的服务。

第四层是智能体 AI,这个层面就像给AI的"大脑"配上了"身体"。AI 不仅能够思考和分析,还能够像人一样以特定目标为导向,自主分析应该采取什么行动。在这个过程中,AI 可以主动获取所需的信息,查阅相关资料,甚至使用各种工具来真正对外界产生影响。

事件驱动智能体的独特价值

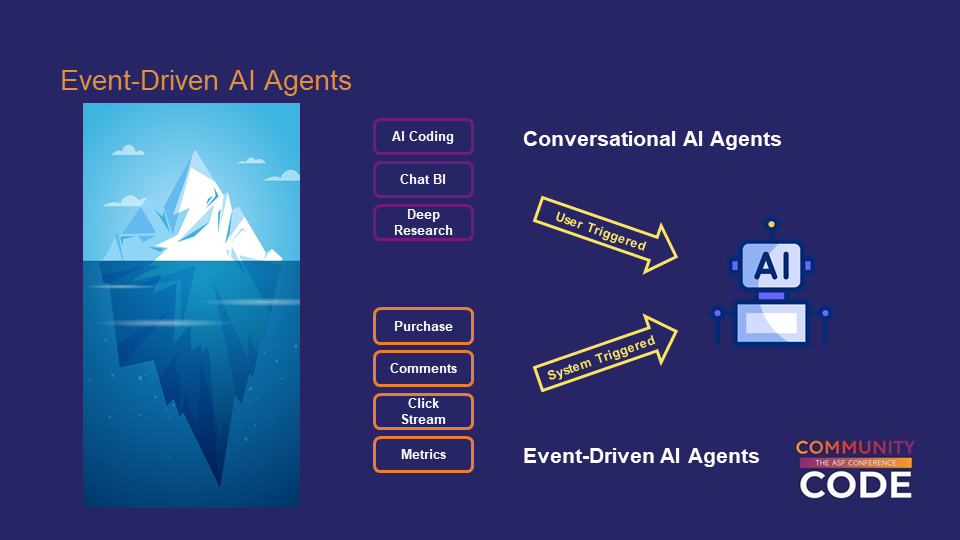

市面上已经存在众多 AI 智能体框架,那么为什么 Apache Flink 社区还要开发一个新的框架呢?答案在于 Flink Agents 专注于一个特殊的应用场景——事件驱动的智能体。

传统的 AI 应用大多属于对话式(Conversational)智能体,这种模式下用户通过对话框用自然语言描述问题或任务,然后让 AI 去执行。这是一种用户主动触发的交互模式,比如常见的 AI Coding、ChatBI、DeepResearch 等产品都属于这一类型。

典型应用场景解析

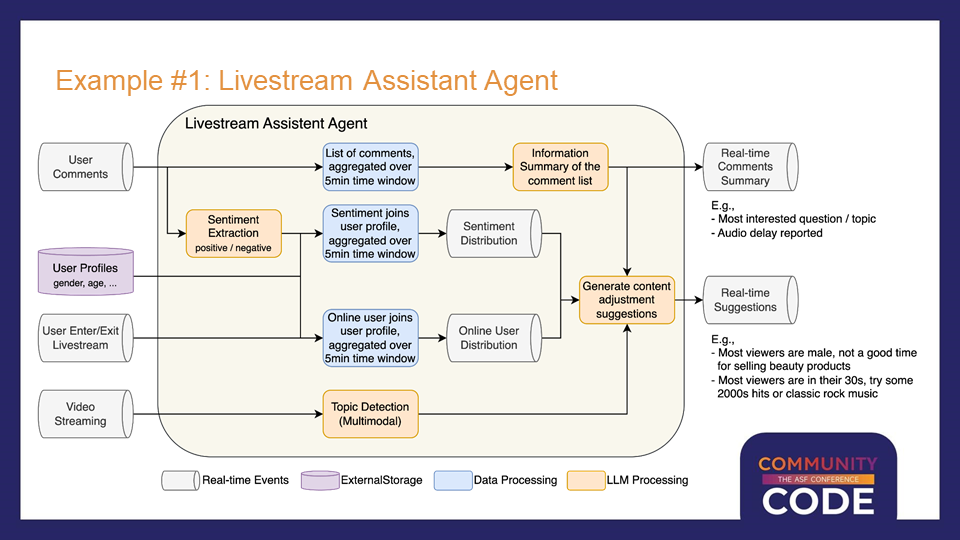

实时直播分析智能助手

第一个典型应用场景是实时直播分析。在网络直播或直播带货过程中,热门直播间会产生大量的观众评论和弹幕。主播无法实时逐条阅读和分析所有内容,传统做法需要配备后台分析团队和导播来完成这项工作。

通过事件驱动的 AI 智能体,系统可以实时分析最近几分钟内的所有弹幕评论,进行信息提取和汇总。比如识别出观众询问最多的问题,或者及时发现技术问题(如音画不同步、声音延迟等),让主播能够及时响应和解决。

更进一步,结合多模态 AI 模型,系统还可以识别当前直播的主题和商品,分析观众的用户画像。基于这些分析结果,AI 可以提供有价值的建议,比如根据观众的性别和年龄分布来调整商品推荐策略,或者根据观众的年龄特征来选择合适的背景音乐。

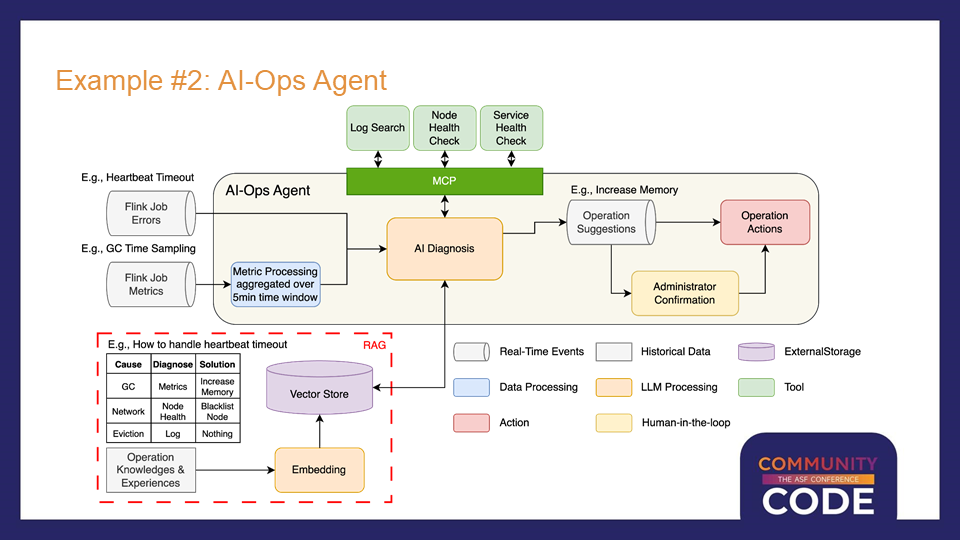

智能运维系统

第二个应用场景是智能运维。以阿里云的 Flink 云产品为例,目前已经有一些基于规则的自动化运维能力,比如订阅作业运行过程中的实时指标和异常事件,然后基于预设规则进行相应处理。

但是这种基于规则的方式存在局限性,很多复杂问题无法有效解决。以心跳超时这个常见错误为例,它可能由多种不同原因引起:JVM 内存问题导致的长时间 GC、节点网络问题,或者仅仅是底层资源集群的正常调度。不同原因需要不同的诊断方法和解决方案,传统的规则化编程很难覆盖所有情况。

事件驱动智能体的技术要求

通过上述应用场景分析,我们可以总结出事件驱动智能体的几个关键技术特点。首先是实时性要求,事件产生后通常需要实时处理。其次是规模处理能力,系统自动触发的事件数量和频率远大于人工触发的请求,需要大规模分布式计算能力支撑。

稳定性是另一个重要要求。与对话式智能体不同,事件驱动的智能体需要7×24小时长时间运行,没有人能够持续监控,因此必须具备强大的容错和自我恢复能力。数据处理能力也必不可少,因为在整个应用的端到端流程中,往往伴随着AI模型的非结构化处理和传统的结构化数据处理。

最后是连接能力,需要能够从不同系统中消费各种实时事件。这五个技术要求恰好与 Apache Flink 的核心能力高度吻合:毫秒级实时性、大规模分布式处理、状态管理和容错能力、丰富的数据处理功能,以及对主流存储系统的广泛支持。

Flink Agents项目架构设计

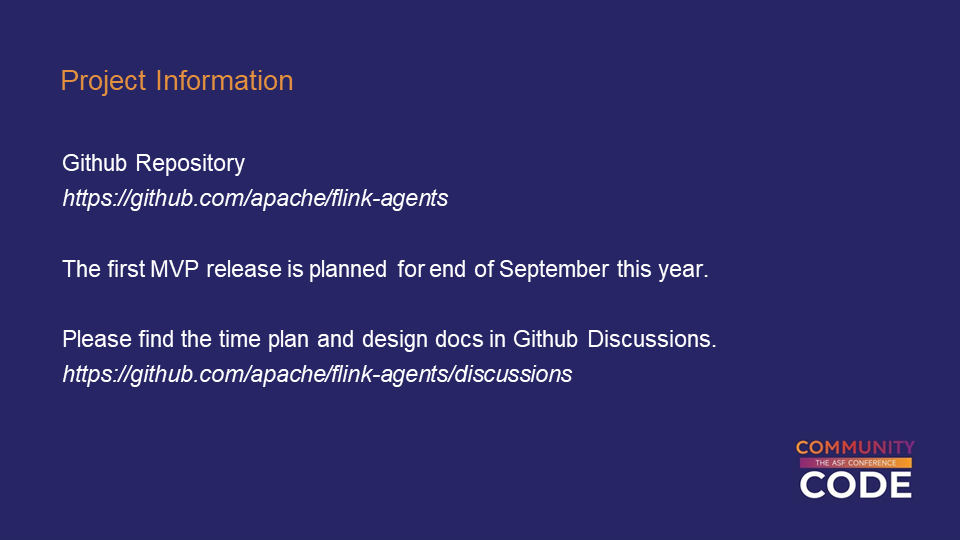

基于上述技术背景,Apache Flink 社区在 2025 年发起了 Flink Agents 项目。这个项目非常年轻,5月份提出提案,6月份正式投票通过,到目前为止只有几个月的时间。有趣的是,这个项目是真正从零开始在社区中全新搭建的,而不是某个公司内部项目的开源版本。

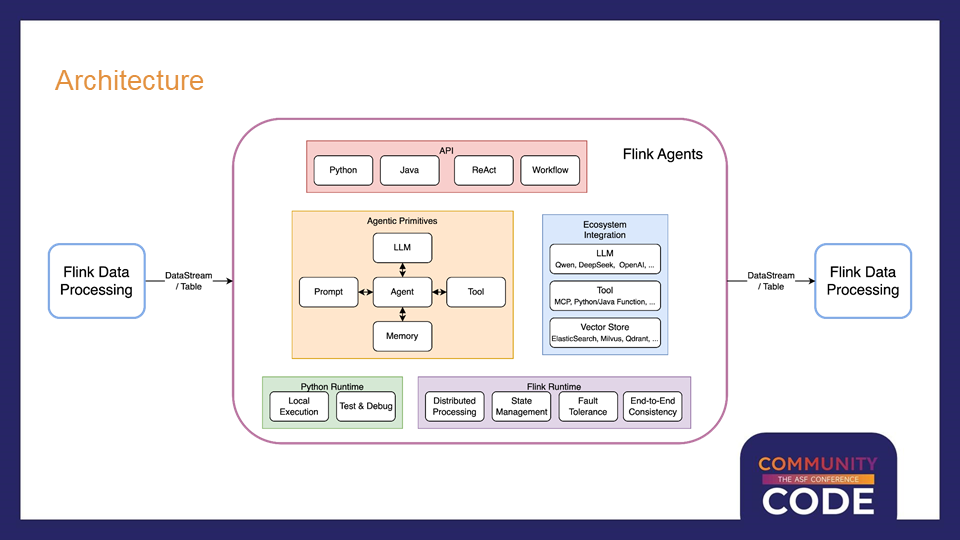

Flink Agents 的架构设计体现了几个核心设计理念。在智能体核心概念方面,沿用 AI Agent 的核心概念,对熟悉 Agent 的开发者没有额外学习成本。在 API 层面,项目支持 Python 和 Java 两种编程语言,同时提供不同接口来支持 Workflow 和 ReAct 两种编程模式。

在生态系统方面,项目集成了市面上主流的模型提供商,支持 MCP 协议兼容以及 Java、Python 函数直接作为工具使用。对于向量存储等常用组件,也提供了相应的抽象和标准实现,同时支持用户自定义扩展。

事件驱动编排架构

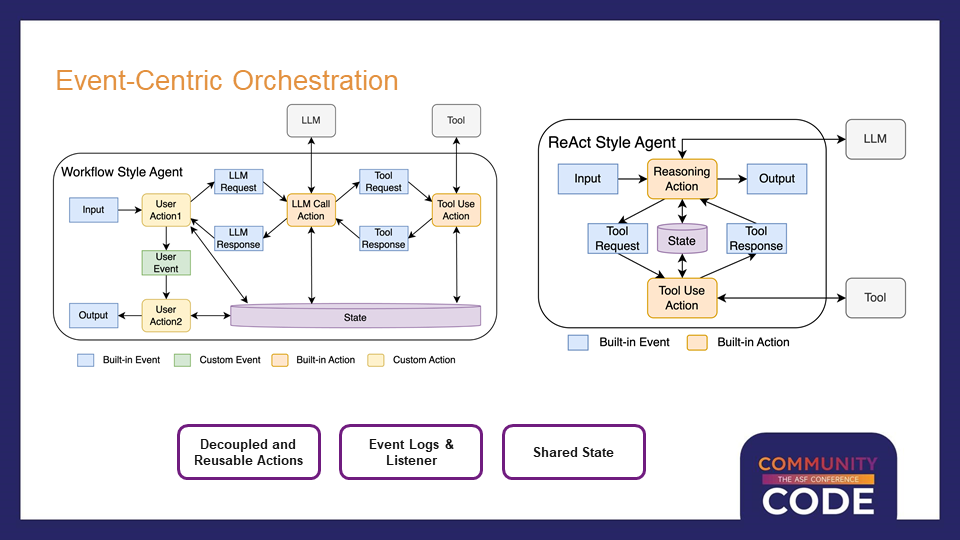

在智能体内部,Flink Agents 采用了以事件为中心的编排方式。每个 Agent 由一系列 Action 组成,每个 Action 由特定的事件触发,同时在执行过程中也可以通过发出新的事件来触发其他 Action 的执行。

这种架构提供了足够的灵活性,能够同时支持 Workflow 和 ReAct 两种主流的智能体开发方式。Workflow 模式允许用户对智能体行为进行精细化控制,明确定义先做什么、后做什么,但编程复杂度相对较高。ReAct 模式则将更多控制权交给AI模型,用户只需要指定模型版本、提示词和可用工具,其余工作交给 AI 自动处理。

项目中提到的 Action 和事件既可以是框架内置的,也可以是用户自定义的,还支持两者混合使用。这种设计既支持框架本身的开发扩展,也满足了企业级应用中平台型部门提供通用库供业务部门使用的需求。

所有智能体内部发生的事情都以事件为载体进行传递,框架甚至可以提供关于事件更新、Action 执行开始和结束等元事件。结合这些事件信息,系统能够提供详细的事件日志来帮助用户理解智能体的执行过程,同时支持在线回调机制进行运行时监控。

技术展望与总结

Flink Agents 项目的推出标志着 Apache Flink 社区在 AI 领域的重要布局。通过将 Flink 强大的流处理能力与 AI 智能体技术相结合,为事件驱动的AI应用提供了一个工业级的解决方案。

项目目前还处于早期开发阶段,但其设计理念和技术架构已经展现出巨大的潜力。随着AI技术的不断发展和工业化应用的深入,事件驱动的智能体将成为 AI 应用的重要发展方向。Flink Agents 项目为这个领域的发展提供了一个强有力的技术基础,值得持续关注和深入研究。

对于希望构建大规模、高可靠性 AI 应用的开发者和企业来说,Flink Agents 提供了一个全新的技术选择。它不仅继承了 Apache Flink 在流处理领域的技术优势,还针对 AI 应用的特殊需求进行了专门的设计和优化,有望成为下一代 AI 应用开发的重要工具。

点击「阅读原文

点击「阅读原文