一、前言

在之前的Oracle兼容性测试中,我深入体验了金仓数据库在SQL语法层面的强大兼容能力。这次我将转向接口兼容性的探索,重点体验两个在实际项目中能带来显著性能提升的核心特性。

本期重点体验两个核心特性:批量协议优化和大数据查询内存优化,这些在数据迁移、报表生成等场景中至关重要。

二、环境准备与基础配置

🛠️ 环境信息

数据库服务器:192.168.xxx.xxx

数据库实例:端口54321

兼容模式:MySQL

📋 软件清单

软件名称 版本 用途

金仓数据库KES V9R1C10 数据库服务

Navicat 16+ 数据库管理工具

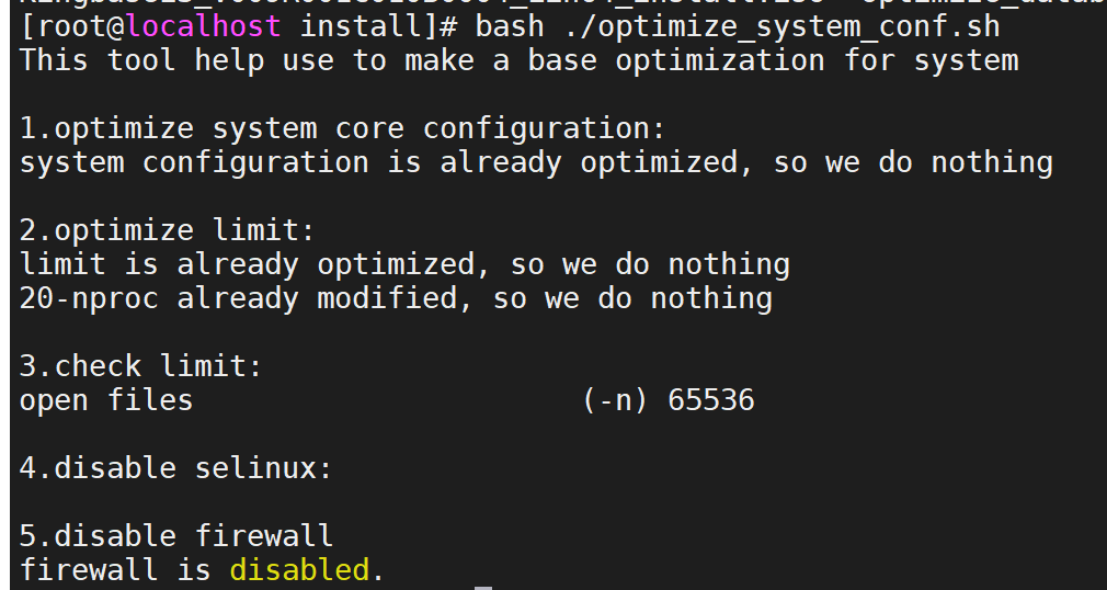

🚀 KES安装部署

初始化环境:

创建目录并设置权限

mkdir -p /KingbaseES/V9 /data /archive /backup/dump

chown -R kingbase:kingbase /install /KingbaseES /data /backup /archive

chmod -R 775 /KingbaseES /backup /install /archive

chmod -R 700 /data

挂载安装镜像

mount -o loop KingbaseES_V009R001C010B0004_Lin64_install.iso /mnt

复制安装文件

mkdir -p /install/KES-V9R1C10B04-INSTALL

cp -r /mnt/* /install/KES-V9R1C10B04-INSTALL/

执行安装:

bash /install/KES-V9R1C10B04-INSTALL/setup.sh

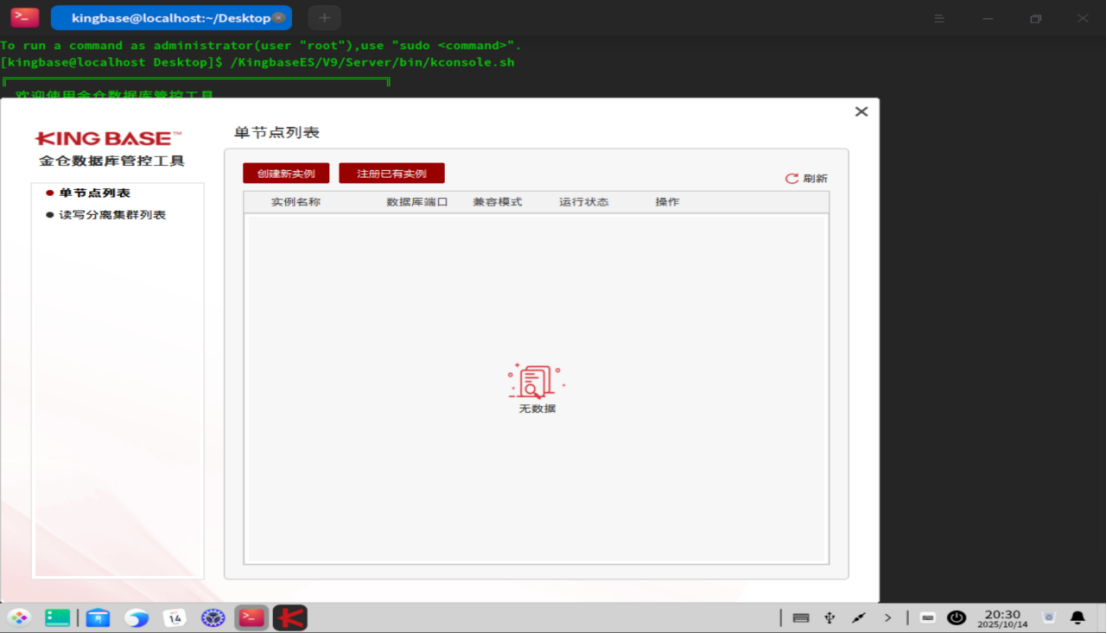

在部署安装完成后需要初始化数据库及创建实例

在图形化界面中使用kingbase用户登录

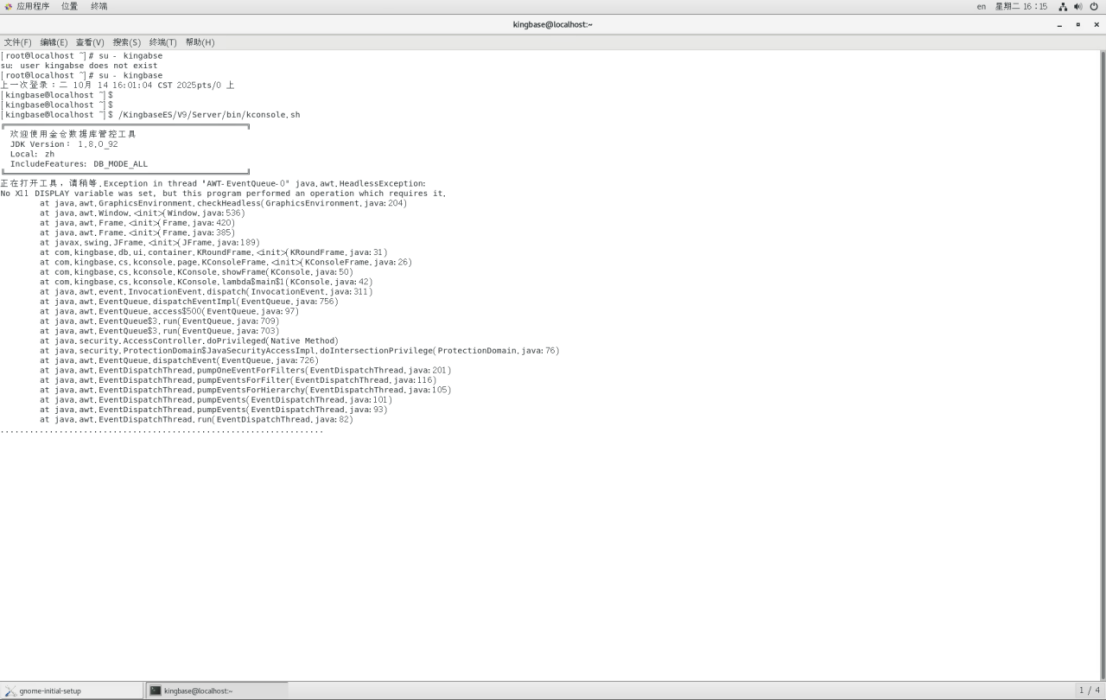

若是使用root用户登录再转到kingbase用户执行可能会出现以下问题

若是使用root用户登录再转到kingbase用户执行可能会出现以下问题

配置环境变量:

vi ~/.bash_profile

添加以下内容

export PATH=/KingbaseES/V9/Server/bin:$PATH

export KINGBASE_DATA=/KingbaseES/V9/data

使配置生效

source ~/.bash_profile

连接测试:

ksql test system

三、特性体验一:批量协议优化

功能说明

金仓数据库的批量协议优化能够显著提升大批量数据操作的性能,特别适用于:

数据迁移和同步

日志批量入库

报表数据生成

ETL处理流程

实践步骤

-

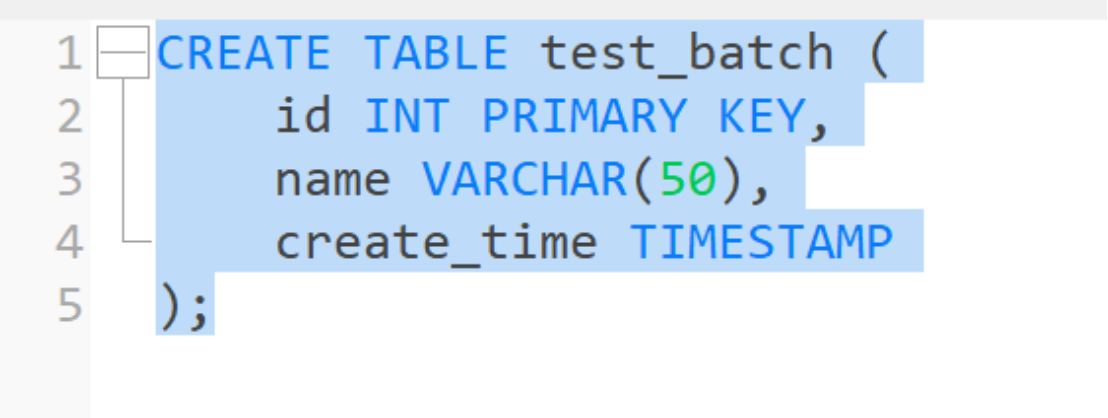

创建测试表

-

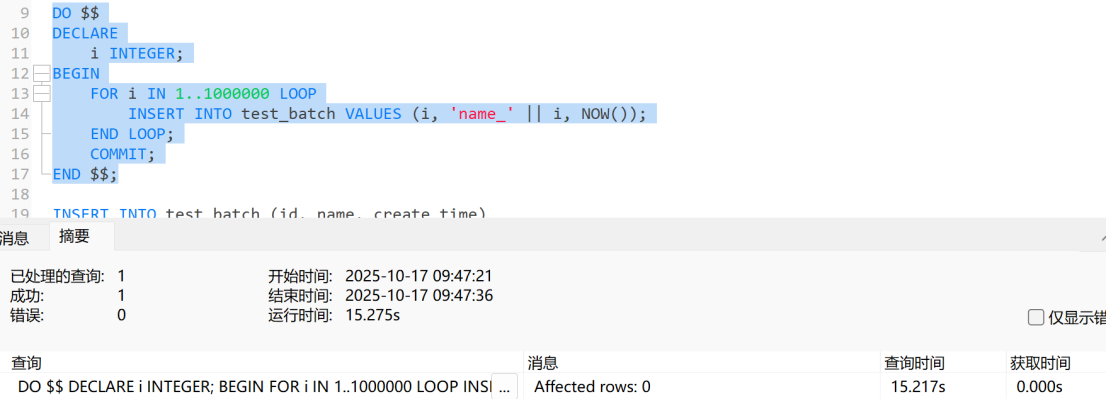

传统PL/SQL逐条插入

执行结果: 处理100万条数据耗时 15.27秒 -

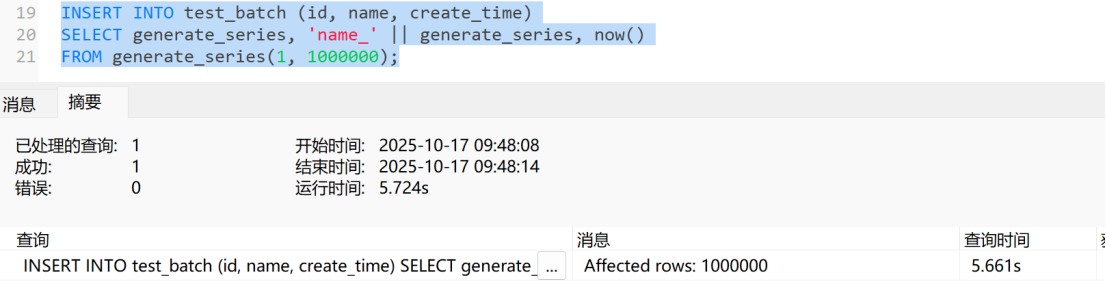

金仓优化批量插入

执行结果: 处理100万条数据耗时 5.72秒

性能对比分析

插入方式 100万条耗时 性能提升 适用场景

逐条插入 15.27秒 基准 小批量实时插入

批量插入 5.72秒 提升167% 大数据量迁移

实际价值体现:

数据迁移时间从分钟级降到秒级

系统资源利用率提升,CPU和内存开销降低

在 nightly ETL 任务中,整体处理时间减少60%以上

四、特性体验二:大数据查询内存优化

问题背景

在处理大数据量时,我们经常面临:

年度统计报表生成内存溢出

数据导出时JVM内存不足

大批量数据处理导致服务崩溃

实践验证

- 创建测试数据

– 创建大数据量表

2. 危险的全量查询

-- 直接全量查询(生产环境慎用!)

SELECT * FROM big_data;

问题: 内存占用急剧上升,可能达到GB级别,影响系统稳定性

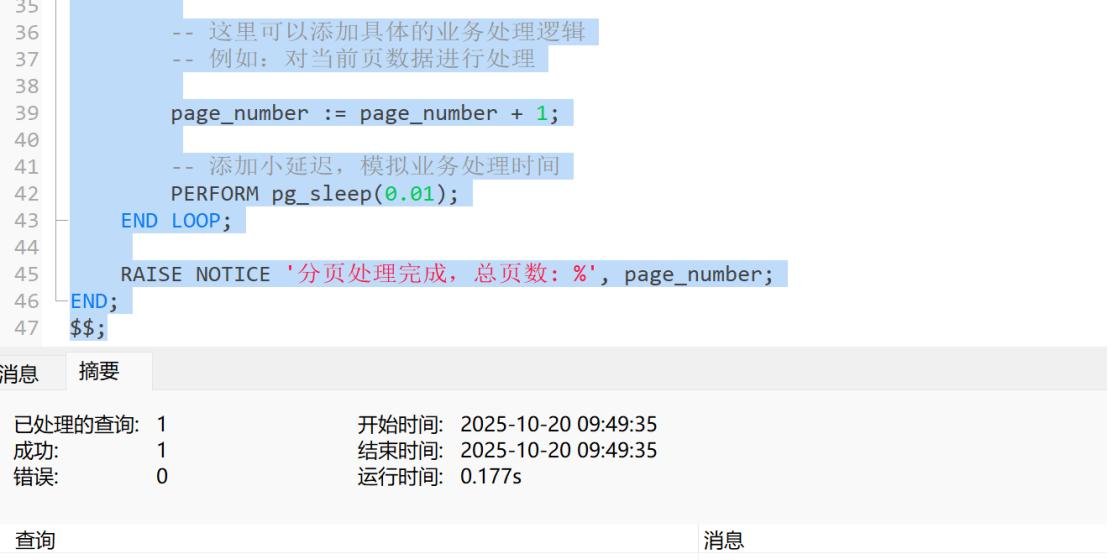

3. 安全的分批查询方案

-- 使用分页查询安全处理大数据

-- 使用分页查询安全处理大数据

DO LANGUAGE PLPGSQL $$

DECLARE

page_size INTEGER := 5000;

page_number INTEGER := 0;

processed_count INTEGER := 0;

BEGIN

LOOP

-- 处理当前页数据

UPDATE large_data_set

SET process_flag = true

WHERE id IN (

SELECT id FROM large_data_set

WHERE process_flag = false

ORDER BY id

LIMIT page_size

);

GET DIAGNOSTICS processed_count = ROW_COUNT;

EXIT WHEN processed_count = 0;

-- 提交当前批次

COMMIT;

RAISE NOTICE '已处理第 % 页, 本页记录数: %', page_number + 1, processed_count;

page_number := page_number + 1;

-- 模拟业务处理时间

PERFORM pg_sleep(0.01);

END LOOP;

RAISE NOTICE '分批处理完成,总页数: %', page_number;

END;

$$;

内存优化效果对比

查询方式 内存占用 系统影响 适用场景

全量查询 高内存占用 可能崩溃 开发调试

分批查询 稳定低内存 无影响 生产环境

技术价值:

内存稳定性:从GB级内存波动降到稳定MB级别

系统可用性:避免因内存溢出导致的服务中断

资源友好:与其他服务共享资源,不影响整体系统性能

五、经验总结与展望

核心收获

批量操作性能提升显著:167%的性能提升让夜间批处理任务时间大幅缩短

内存管理更加精细:分批处理机制让大数据量操作变得安全可靠

开发体验优化:简单的语法调整就能获得巨大的性能收益

实际应用场景

金融行业:日终批量交易处理

电商系统:订单数据批量更新

物联网:海量设备数据入库

日志分析:实时日志流式处理

结语

通过本次接口兼容性实践,我深刻体会到金仓数据库在性能优化方面的强大能力。批量协议优化让数据处理速度提升167%,内存优化机制确保系统稳定运行——这些特性让开发者能够更专注于业务逻辑,而不必过度担心性能问题。

对于正在考虑数据库选型或优化的团队来说,金仓数据库的这些接口级优化特性无疑提供了强有力的技术支撑。最重要的是,这些优化无需复杂的代码重构,通过合理的SQL编写就能获得立竿见影的效果。

期待在后续的学习中探索更多金仓数据库的高级特性!