海牛学院的 | 第 570 期

本文预计阅读 | 8 分钟

大数据的重要性:

大数据在全世界变得越来越流行。零售,媒体,制药等所有垂直行业的公司都在追求这一IT概念。大数据Hadoop工具和技术可帮助公司更快地说明大量数据。这有助于提高生产效率并改善新的数据驱动产品和服务。

Hadoop在大数据中的使用:

大数据开发人员应对Hadoop应用程序的实际编码/编程负责。下面提到的是有关Hadoop架构的一些信息

它包括各种最新的Hadoop功能和工具

Apache Hadoop使您可以使用简单的编程模型为计算机集群上的任何分布式处理系统简化过多的数据。

Hadoop有两个主要部分–数据处理框架和用于数据存储的分布式文件系统。

它在不同的计算机上存储千兆字节到TB的大型文件。

Hadoop使在具有大量商品硬件节点的系统上运行应用程序变得更加容易。

9种最受欢迎的大数据Hadoop工具:

为了节省您的时间并帮助您选择合适的工具,我们在数据提取、存储、清理、挖掘、可视化、分析和集成领域构建了一系列顶级大数据Hadoop工具。

数据提取工具

-Talend ,Pentaho 数据存储工具-Hive,Sqoop,MongoDB

数据挖掘工具-Oracle

数据分析工具-HBase ,Pig

数据集成工具-Zookeeper

Talend

Talend是一家专门从事大数据集成的软件供应商。Talend Open Studio for Data Integration可帮助您使用其ETL系统来高效地管理数据提取,数据转换和数据加载的所有方面。

如何运作:

在计算中提取、转换、加载(ETL)是指数据库使用中的过程,尤其是数据仓库中的过程。数据提取是从数据源中提取数据的地方;数据转换,将数据转换为以适当格式存储的数据;数据加载,将数据加载到最终目标数据库中。

Talend的特点:

ETL工具具有丰富的功能集,可提高开发人员的生产力,其中包括:

它的图形化集成开发环境

拖放作业设计

超过900个组件和内置连接器

强大的ETL功能:字符串处理,自动查找处理

Pentaho

Pentaho数据集成也称为Kettle,是Pentaho的组件,负责提取,转换和加载(ETL)过程。PDI是使用图形工具创建的,您可以在其中指定要执行的操作而无需编写代码来指示操作方法。

如何运作:

PDI可以用作独立应用程序,也可以用作较大的Pentaho Suite的一部分。作为ETL工具,它是最流行的开源工具。PDI支持各种各样的输入和输出格式,包括文本文件,数据表以及商业和免费数据库引擎。

Pentaho 的重要特征

图形提取-转换-负载(ETL)设计系统

强大的编排功能

完整的可视化大数据集成工具

MongoDB

MongoDB是使用面向文档的数据模型的开源数据库。

如何运作:

MongoDB使用类似于JSON的灵活文档数据模型存储数据。文档包含一个或多个字段,包括数组,二进制数据和子文档。字段可能因文档而异。

MongoDB工具的某些功能

MongoDB可用作具有负载平衡和跨多台机器进行数据复制功能的文件系统,用于存储文件。以下是MongoDB的主要功能。

临时查询

索引编制

复写

负载均衡

聚合

服务器端JavaScript执行

上限集合

Hive

Apache Hive是建立在Hadoop之上的数据仓库基础架构,用于提供数据汇总,查询和分析。Hive提供了一个类似于SQL的界面来查询存储在与Hadoop集成的各种数据库和文件系统中的数据。

如何运作:

Hive具有数据摘要,查询和分析的三个主要功能,它支持以HiveQL语言表示的查询,该语言可将类似SQL的查询自动转换为在Hadoop上执行的MapReduce作业。

特点的Apache Hive

Apache Hive支持分析存储在Hadoop HDFS和兼容文件系统(例如Amazon S3文件系统)中的大型数据集。Hive的其他功能包括:

索引类型,包括压缩和从0.10开始的Bitmap索引

各种存储类型,例如纯文本,RCFile,HBase,ORC等

在包括DEFLATE,BWT,snappy等的算法上运行

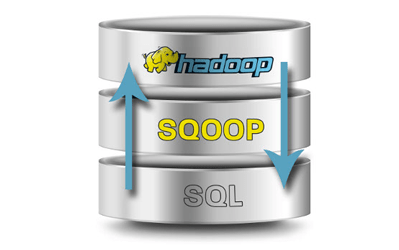

Sqoop

Sqoop(SQL到Hadoop)是一种大数据工具,具有从非Hadoop数据存储中提取数据,将数据转换为Hadoop可用的形式,然后将数据加载到HDFS的功能。

如何运作:

Sqoop的名称来自SQL + Hadoop,它支持单个表或自由格式SQL查询的增量加载以及保存的作业,这些作业可以运行多次以导入自上次导入以来对数据库所做的更新。

这是Sqoop的一些重要且可用的功能

并行导入/导出

导入SQL查询结果

所有主要RDBMS数据库的连接器

Kerberos安全集成

支持积累

Oracle数据挖掘

Oracle数据挖掘(ODM)是Oracle Advanced Analytics数据库选件的一部分,它提供了强大的数据挖掘算法,使数据分析师能够发现见解,做出预测并利用其Oracle数据和投资

如何运作:

Oracle Corporation在Oracle关系数据库中实现了各种数据挖掘算法。借助Oracle Data Mining系统,您可以在Oracle数据库内部构建和应用预测模型,以帮助您预测客户行为,开发客户资料,识别交叉销售机会并检测潜在的欺诈行为。

Oracle Data Mining的功能

Oracle Data Miner工具是Oracle SQL Developer的扩展,可使用以下方法直接处理数据库内部的数据

图形化的“拖放”工作流程和组件托盘

Oracle Data Miner工作流程捕获并记录用户的分析方法

Oracle Data Miner可以生成SQL和PL SQL脚本

HBase

HBase是一个开放源代码、非关系、分布式数据库,并使用Java编写。它是Apache Software Foundation的Apache Hadoop项目的一部分,在HDFS(Hadoop分布式文件系统)之上运行,为Hadoop提供类似于Bigtable的功能。

如何运作:

Apache HBase是一个NoSQL数据库,它作为分布式和可伸缩的大数据存储在Hadoop之上运行。HBase可以利用Hadoop分布式文件系统的分布式处理。它的目的是承载具有数十亿行和潜在数百万列的大型表,并跨一系列商品硬件运行

在Apache的HBase的是包括以下功能:

线性和模块化可扩展性

方便的基类支持Hadoop

易于使用的Java API用于客户端访问

块缓存和布隆过滤器用于实时查询

通过服务器端过滤器查询谓词下推

支持导出指标

Pig

Apache Pig是用于创建在Apache Hadoop上运行的程序的高级平台。Pig已完成,因此您可以使用Pig在Apache Hadoop中进行所有必需的数据操作。

如何运作:

Pig使数据工作人员无需了解Java就可以编写复杂的数据转换。Pig被称为Pig Latin,吸引了已经熟悉脚本语言和SQL的开发人员。

pig的特点:

Pig Tool具有以下关键属性:

实现简单的并行执行是微不足道的

允许系统自动优化其执行

用户可以创建自己的功能来进行特殊处理。

Zookeeper

Apache Zookeeper是针对分布式应用程序的协调服务,可跨集群进行同步。Hadoop中的Zookeeper可以看作是集中式存储库,分布式应用程序可以在其中存储数据并从中获取数据。

如何运作:

Zookeeper提供了跨节点同步的基础结构,应用程序可以使用Zookeeper来确保跨集群的任务被序列化或同步。ZooKeeper允许开发人员专注于核心应用程序逻辑,而不必担心应用程序的分布式性质。

Zookeeper的功能

ZooKeeper将帮助您在Hadoop节点之间进行协调。以下提到它的重要功能

节点管理和配置

实施可靠的消息传递

实施冗余服务

同步流程执行

备注 “ 进群 ” (广告勿扰)

【海牛大数据交流群】

唔~要这个 ↓↓↓

唔~要这个 ↓↓↓